Rumah >Peranti teknologi >AI >Kajian sejarah selama 30 tahun, Jeff Dean: Kami menyusun kajian semula penyelidikan 'model pakar jarang'

Kajian sejarah selama 30 tahun, Jeff Dean: Kami menyusun kajian semula penyelidikan 'model pakar jarang'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 23:01:041537semak imbas

Model pakar jarang ialah konsep berusia 30 tahun yang masih digunakan secara meluas hari ini dan merupakan seni bina popular dalam pembelajaran mendalam. Seni bina tersebut termasuk sistem pakar hibrid (MoE), Switch Transformers, rangkaian penghalaan, lapisan BASE, dsb. Model pakar yang jarang menunjukkan prestasi yang baik dalam banyak bidang seperti pemprosesan bahasa semula jadi, penglihatan komputer dan pengecaman pertuturan.

Baru-baru ini, ketua AI Google Jeff Dean dan yang lain menulis ulasan model pakar jarang, menyemak konsep model pakar jarang, memberikan penerangan asas algoritma umum dan akhirnya menantikan hala tuju penyelidikan masa hadapan.

Alamat kertas: https://arxiv.org/pdf/2209.01667.pdf

Pembelajaran mesin, terutamanya bahasa semula jadi, telah mencapai kemajuan yang ketara dengan meningkatkan belanjawan pengiraan, data latihan dan saiz model. Model bahasa penting yang terkenal termasuk GPT-2 (Radford et al., 2018), BERT (Devlin et al., 2018), T5 (Raffel et al., 2019), GPT-3 (Brown et al., 2020) , Gopher (Rae et al., 2021), Chinchilla (Hoffmann et al., 2022) dan PaLM (Chowdhery et al., 2022).

Walau bagaimanapun, model terkini kini memerlukan beribu-ribu pemecut saling berkait khusus dan mengambil masa beberapa minggu atau bulan untuk dilatih, menjadikan model ini mahal untuk dihasilkan (Patterson et al. al. , 2021). Sebagai skala sistem pembelajaran mesin, bidang ini mencari latihan yang lebih cekap dan paradigma penyampaian. Model pakar jarang telah muncul sebagai penyelesaian yang menjanjikan.

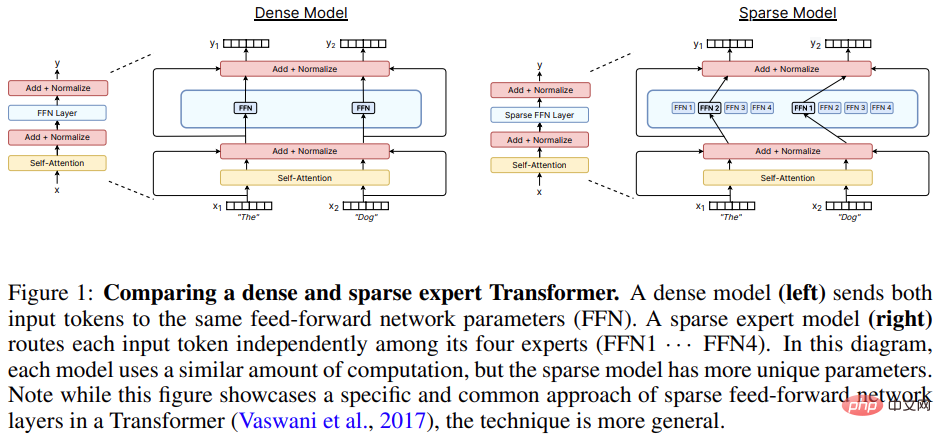

Model pakar yang jarang (yang mana Sistem Pakar Campuran (MoE) ialah varian paling popular) ialah jenis rangkaian neural khas di mana Parameter kumpulan dibahagikan kepada "pakar", masing-masing dengan berat yang unik.

Semasa latihan dan inferens, model memberikan sampel input kepada pemberat pakar tertentu, membenarkan setiap sampel berinteraksi dengan hanya subset parameter rangkaian, berbanding menggunakan keseluruhan rangkaian untuk setiap Kaedah input konvensional adalah berbeza. Memandangkan hanya sebilangan kecil pakar digunakan untuk setiap sampel, usaha pengiraan dikurangkan dengan ketara berbanding dengan jumlah model.

Banyak model pakar jarang moden mendapat inspirasi daripada Shazeer et al (2017). Penyelidikan itu melatih model terbesar pada masa itu dan mencapai hasil pemodelan dan terjemahan bahasa terkini. Populariti model pakar jarang semakin meningkat apabila digunakan bersama dengan model bahasa Transformer (Lepikhin et al., 2020; Fedus et al., 2021). Walaupun kebanyakan kerja adalah dalam pemprosesan bahasa semula jadi, model pakar yang jarang juga telah berjaya digunakan dalam pelbagai bidang, termasuk penglihatan komputer (Puigcerver et al., 2020), pengecaman pertuturan (You et al., 2021), dan pembelajaran pelbagai mod. (Mustafa et al., 2022). Clark et al. (2022) mengkaji sifat penskalaan model pakar jarang di bawah saiz model dan bilangan pakar yang berbeza. Tambahan pula, hasil terkini pada banyak penanda aras kini dipegang oleh model pakar yang jarang seperti ST-MoE (Zoph et al., 2022). Bidang ini berkembang pesat dengan kemajuan dalam penyelidikan dan kejuruteraan. |

Model Pakar Jarang

Konsep KPM dalam pembelajaran mesin boleh dikesan kembali ke sekurang-kurangnya 30 tahun yang lalu Dalam konsep awal, pakar mentakrifkan rangkaian saraf yang lengkap ,KPM adalah serupa dengan pendekatan ensemble.Eigen et al (2013) mencadangkan menggunakan seni bina hibrid pakar lapisan bertindan pada MNIST yang bergelora ini meletakkan asas untuk pelaksanaan model berikutnya.

Shazeer et al (2017) mencadangkan memasukkan lapisan MoE antara dua lapisan LSTM, dan model jarang yang terhasil mencapai prestasi SOTA dalam terjemahan mesin. Walau bagaimanapun, walaupun kaedah ini berjaya, penyelidikan seterusnya adalah seperti hibernasi dan terbantut, dan kebanyakan penyelidikan beralih kepada Transformer.

Antara 2020 dan 2021, GShard dan Switch Transformer telah dikeluarkan, kedua-duanya menggantikan lapisan suapan ke hadapan dalam Transformer dengan lapisan pakar.

Walaupun pendekatan menggunakan lapisan pakar telah menjadi paradigma yang dominan, penyelidikan dalam dua tahun kebelakangan ini telah mengkaji semula konsep model pakar sebagai model bebas sepenuhnya untuk mencapai modulariti dan kebolehkomposisian seks .

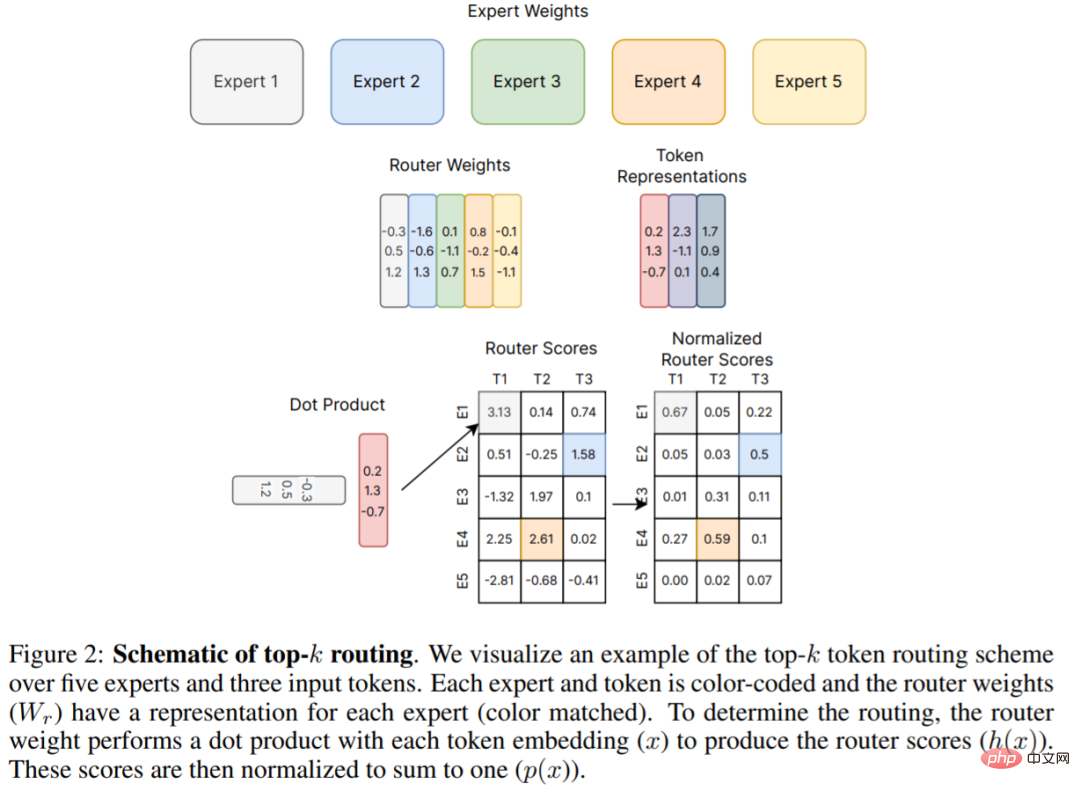

Rajah 2 di bawah ialah mekanisme penghalaan top-k asal yang dicadangkan oleh Shazeer et al (2017), yang merupakan asas untuk banyak kerja seterusnya. Kertas ulasan ini menerangkan secara terperinci perkembangan baharu dalam algoritma penghalaan dalam Bab 4.

Perkakasan

Model pakar jarang moden telah dibangunkan dengan yang terbesar Reka bentuk bersama sistem teragih bagi rangkaian saraf.

Penyelidikan mengenai rangkaian neural yang besar (Brown et al., 2020; Rae et al., 2021; Chowdhery et al., 2022) menunjukkan bahawa rangkaian saraf telah jauh melebihi ingatan sebuah Kapasiti pemecut tunggal, oleh itu tensor seperti pemberat, fungsi pengaktifan, pembolehubah pengoptimum, dll. perlu dipecahkan menggunakan pelbagai strategi selari.

Tiga kaedah selari biasa termasuk: selari data (menyalin berat model, data sharding), selari model tensor (data dan tensor berat dipecahkan merentas peranti), dan selari saluran paip (seluruh lapisan atau kumpulan lapisan dipecahkan merentas peranti), model pakar hibrid selalunya dapat menampung senario penyejajaran ini.

Dari segi latihan dan penggunaan model MoE, Jaszczur et al (2021) mengecilkan semua lapisan model Transformer, dengan itu mencapai 37 kali pecutan inferens; 2022) Menyelesaikan kekangan saiz kelompok pakar statik melalui perpustakaan RECOMPILE.

Selain keselarian data, keselarian model dan keselarian pakar, Rajbhandari et al (2022) mencadangkan perpustakaan DeepSpeed-MoE untuk menyokong pembahagian ZeRO dan ZeRO-Offload, mencapai 10x inferens. dan prestasi terjemahan SOTA, dengan itu meningkatkan kegunaan model dalam perkhidmatan pengeluaran.

Sifat penskalaan model pakar yang jarang

Kehilangan entropi silang model bahasa saraf padat menunjukkan dirinya sebagai fungsi kiraan parameter model, volum data dan belanjawan pengiraan (Kaplan et al., 2020) undang-undang kuasa. Pekali undang-undang kuasa kemudiannya diperbetulkan dalam Hoffmann et al (2022), mencadangkan bahawa pengiraan model optimum memerlukan keseimbangan data dan pengembangan parameter yang lebih rapat. Sebaliknya, kajian awal model pakar jarang yang berkembang secara heuristik memperoleh hasil empirikal yang kukuh tetapi tidak menerangkan dengan teliti undang-undang pengembangan. Tambahan pula, beberapa karya telah menyerlahkan perbezaan antara tindakan huluan (cth. pra-latihan) dan hiliran (cth. penalaan halus) (Fedus et al., 2021; Artetxe et al., 2021), merumitkan lagi pemahaman model pakar yang jarang.

Pelanjutan huluan

Model pakar jarang berprestasi baik apabila dilatih pada set data yang besar. Corak biasa dalam pemprosesan bahasa semula jadi ialah melakukan latihan huluan (cth. pra-latihan) diikuti dengan latihan hiliran (cth. penalaan halus) pada pengagihan data tertentu yang diminati. Di peringkat huluan, model pakar yang jarang secara konsisten menghasilkan keuntungan yang lebih tinggi daripada model rakan sejawat yang padat. Shazeer et al. (2017) mencadangkan lengkung penskalaan berkenaan dengan parameter model dan belanjawan pengiraan pada penanda aras pemodelan bahasa 1 bilion perkataan (Chelba et al., 2013), mencapai keuntungan yang ketara berbanding versi padat. Lepikhin et al. (2020) mencadangkan versi yang dipertingkatkan bagi fungsi pengembangan model dan mencapai keuntungan skor BLEU sebanyak 13.5 pada model jarang parameter 600B terbesar mereka. Transformer Suis (Fedus et al., 2021) mengukur 4-7x kelajuan masa dinding pada model T5 menggunakan sumber pengiraan yang sama. Kerja ini juga menyiasat penskalaan kehilangan entropi silang sebagai fungsi kiraan parameter, tetapi memerhatikan bahawa keuntungan berkurangan melebihi 256 pakar.

Peluasan hiliran

Walau bagaimanapun, penskalaan huluan yang boleh dipercayai tidak serta-merta menghasilkan keuntungan yang konsisten pada tugas hiliran. Dalam kerja yang mengetengahkan cabaran pemindahan, Fedus et al (2021) memerhatikan 4x pra-latihan menggunakan Transformer pengekod-pengekod berkomputer rendah (parameter 1.6T, 2048 pakar setiap lapisan jarang), tetapi ia berfungsi. tidak memperhalusi tugas inferens intensif seperti SuperGLUE. Penemuan ini membayangkan penyelidikan lanjut yang diperlukan dan keseimbangan yang mungkin diperlukan antara pengiraan dan parameter.

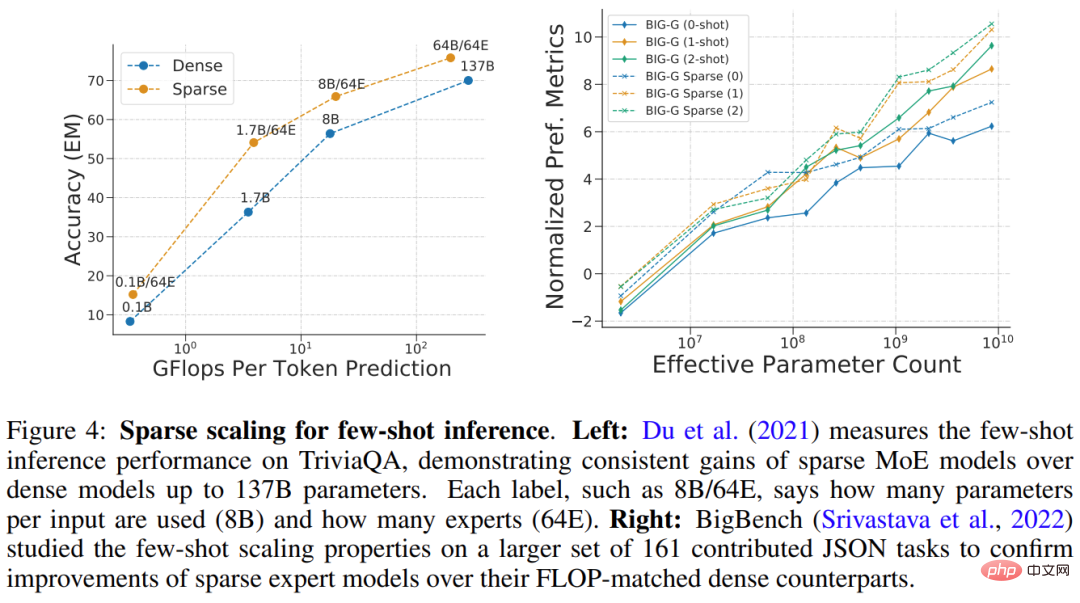

Du et al (2021) menunjukkan lanjutan model GLaM jarang daripada FLOP 1B-64B menggunakan 64 pakar setiap lapisan jarang. GLaM mencapai keputusan SOTA, mengatasi prestasi model GPT-3 parameter 175B (Brown et al., 2020) dari segi prestasi sifar pukulan dan satu pukulan Pada masa yang sama, FLOP yang digunakan oleh setiap token semasa inferens dikurangkan sebanyak 49 %. Penggunaan dikurangkan sebanyak 65% (seperti yang ditunjukkan dalam Rajah 4 (kiri) di bawah). Rajah 4 di bawah (kanan) ialah satu lagi contoh model jarang berprestasi baik pada inferens beberapa pukulan.

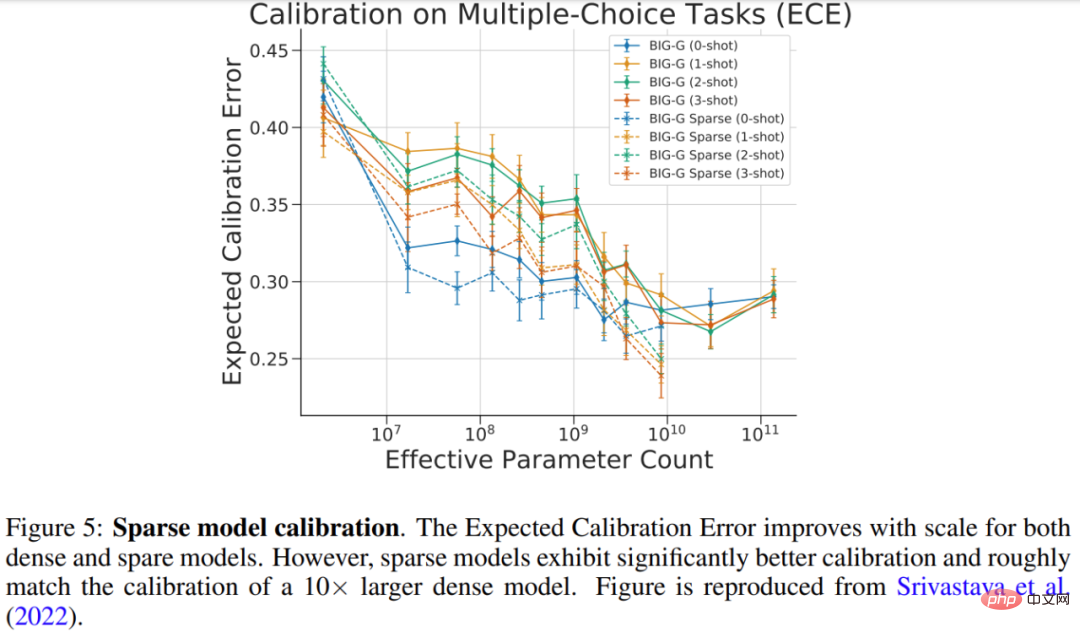

Srivastava et al (2022) mengkaji penentukuran model jarang pada tugas BIG-Bench pilihan ganda, iaitu mengukur ramalan. kebarangkalian dan ketepatan Tahap padanan kebarangkalian. Keputusan kajian ditunjukkan dalam Rajah 5 di bawah, dan sementara penentukuran bertambah baik untuk kedua-dua model padat dan jarang yang lebih besar, penentukuran model jarang adalah setanding dengan model padat menggunakan 10x lebih FLOP.

Kembangkan bilangan, saiz dan kekerapan peringkat pakar

Bagaimana banyak Beberapa hiperparameter penting mengawal penskalaan model pakar yang jarang, termasuk: 1) bilangan pakar, 2) saiz setiap pakar, dan 3) kekerapan lapisan pakar. Keputusan ini boleh memberi impak yang ketara ke atas pengembangan huluan dan hiliran.

Banyak karya awal yang dipertingkatkan kepada ribuan pakar yang agak kecil setiap lapisan, menghasilkan kualiti pra-latihan dan terjemahan yang sangat baik (Shazeer et al., 2017; Lepikhin et al. ., 2020; Fedus et al., 2021). Walau bagaimanapun, kualiti model jarang merosot secara tidak seimbang apabila peralihan domain (Artetxe et al., 2021) atau penalaan halus untuk pengagihan tugas yang berbeza (Fedus et al., 2021). Untuk mencapai keseimbangan pengiraan dan parameter yang lebih baik, model jarang SOTA untuk inferens beberapa pukulan (GLaM (Du et al., 2021)) dan penalaan halus (ST-MoE (Zoph et al., 2022)) hanya boleh digunakan paling banyak 64 pakar yang lebih besar. Disebabkan oleh peningkatan dimensi pakar, model ini memerlukan strategi perpecahan peringkat sistem khusus untuk pemecut berjalan dengan berkesan (Du et al., 2021; Rajbhandari et al., 2022).

Algoritma penghalaan

Algoritma penghalaan ialah ciri utama semua seni bina pakar yang jarang dan menentukan tempat untuk menghantar sampel. Bidang ini telah dikaji secara meluas, termasuk pendekatan kontra-intuitif menggunakan corak penghalaan tetap dan tidak dipelajari (Roller et al., 2021). Memandangkan keputusan diskret dibuat tentang pakar yang hendak dipilih, keputusan penghalaan selalunya tidak boleh dibezakan.

Masalah pemilihan pakar kemudiannya ditakrifkan semula sebagai masalah Bandit, dan terdapat beberapa karya menggunakan pembelajaran pengukuhan untuk mempelajari pemilihan pakar (Bengio et al., 2016; Rosenbaum et al., 2017; 2019; Clark et al., 2022). Shazeer et al. (2017) mencadangkan algoritma heuristik yang boleh dibezakan untuk mengelakkan kesukaran pembelajaran pengukuhan.

Kertas kerja ini menghuraikan klasifikasi algoritma penghalaan dan seterusnya menerangkan isu utama dalam bidang ini - pengimbangan beban.

Pembangunan Pantas Model Pakar Jarang

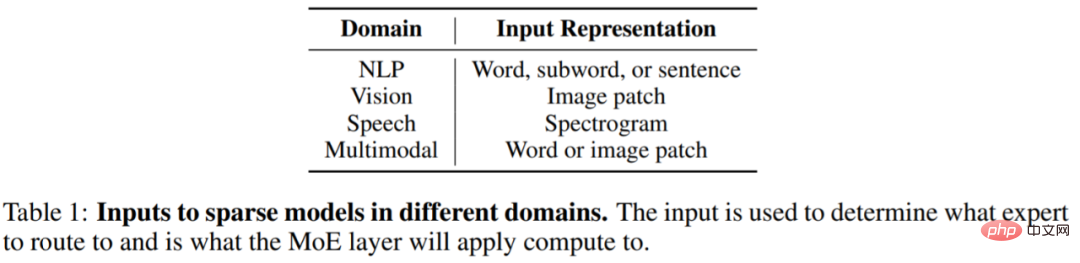

Pengaruh model pakar jarang merebak dengan pantas ke bidang lain di luar NLP, termasuk penglihatan komputer, pengecaman pertuturan dan aplikasi pelbagai mod . Walaupun domain berbeza, seni bina dan algoritma model adalah lebih kurang sama, dan Jadual 1 di bawah menunjukkan perwakilan input lapisan jarang untuk domain yang berbeza.

Model pakar jarang telah berkembang dengan sangat pesat dalam beberapa tahun kebelakangan ini. Mengambil bidang NLP sebagai contoh, Shazeer et al (2017) memperkenalkan lapisan pakar hibrid untuk pemodelan bahasa LSTM dan terjemahan mesin, yang diselitkan di antara lapisan standard model LSTM.

Pada tahun 2020, Lepikhin et al. (2020) memperkenalkan lapisan MoE kepada Transformer untuk pertama kalinya Apabila penyelidik mengembangkan setiap lapisan pakar kepada 2048 pakar, model tersebut mencapai hasil terjemahan SOTA pada 100 bahasa.

Fedus et al. (2021) mencipta model bahasa parameter 1.6T yang jarang mencapai kualiti pra-latihan SOTA.

Penyelidikan baharu memacu pembangunan inferens pembelajaran beberapa pukulan dan penanda aras penalaan halus. Du et al. (2021) melatih model bahasa penyahkod MoE tulen, mencapai keputusan SOTA pada sampel kecil dan hanya memerlukan 1/3 daripada pengiraan yang diperlukan untuk melatih GPT-3. Zoph et al. (2022) mencadangkan ST-MoE, model penyahkod pengekod jarang yang mencapai SOTA pada pelbagai tugas inferens dan penjanaan. Apabila diperhalusi pada SuperGLUE, ST-MoE mengatasi prestasi PaLM-540B sambil menggunakan hanya kira-kira 1/20 FLOP pralatihan dan 1/40 FLOP inferens.

Bila menggunakan model jarang

Soalan biasa ialah jika anda diberi pengiraan tetap atau belanjawan FLOP (cth. 100 GPU selama 20 jam), anda harus Apa jenis model perlu dilatih untuk prestasi terbaik?

Pada asasnya, model jarang membolehkan untuk meningkatkan bilangan parameter dalam model secara drastik dengan menambah bilangan pakar, sambil mengekalkan FLOP setiap sampel secara kasarnya tetap. Pendekatan ini boleh menjadi baik atau buruk, bergantung pada tujuan model.

Sparsity berfaedah apabila anda mempunyai banyak pemecut (cth. GPU/TPU) untuk membawa semua parameter tambahan yang disertakan dengan penggunaan sparsity.

Menggunakan sparsity juga memerlukan pertimbangan yang teliti terhadap tugas hiliran. Jika anda mempunyai banyak mesin untuk pralatihan, tetapi sedikit untuk penalaan halus atau penyajian, maka jarang (cth. bilangan pakar) harus dilaraskan berdasarkan jumlah memori yang tersedia dalam kes penggunaan hiliran.

Dalam sesetengah kes, model jarang sentiasa kelihatan lebih teruk daripada model padat. Sebagai contoh, apabila semua parameter disimpan dalam memori pemecut, model jarang adalah lebih rendah daripada model padat. Model jarang sesuai apabila anda mempunyai keupayaan untuk melatih atau berkhidmat secara selari pada berbilang mesin untuk mengehoskan parameter model tambahan daripada pakar.

Selain itu, kertas ulasan ini juga memperkenalkan penambahbaikan latihan model jarang, kebolehtafsiran dan hala tuju penyelidikan masa hadapan.

Atas ialah kandungan terperinci Kajian sejarah selama 30 tahun, Jeff Dean: Kami menyusun kajian semula penyelidikan 'model pakar jarang'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI