Rumah >Peranti teknologi >AI >Inilah cara untuk mengajar ChatGPT cara membaca gambar

Inilah cara untuk mengajar ChatGPT cara membaca gambar

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 22:58:051808semak imbas

Model "Wen Sheng Tu" akan menjadi popular pada tahun 2022, jadi apakah yang akan popular pada tahun 2023?

Jawapan daripada jurutera pembelajaran mesin Daniel Bourke ialah: sebaliknya!

Tidak, model "teks gambar" yang baru dikeluarkan telah menjadi popular di Internet, dan kesannya yang sangat baik telah menyebabkan ramai netizen menyiarkan semula dan menyukainya.

Ia bukan sahaja fungsi asas "melihat gambar dan bercakap", tetapi juga boleh menulis puisi cinta, menerangkan plot, mereka bentuk dialog untuk objek dalam gambar, dsb., AI ini boleh melakukan semua Pegang dengan teguh!

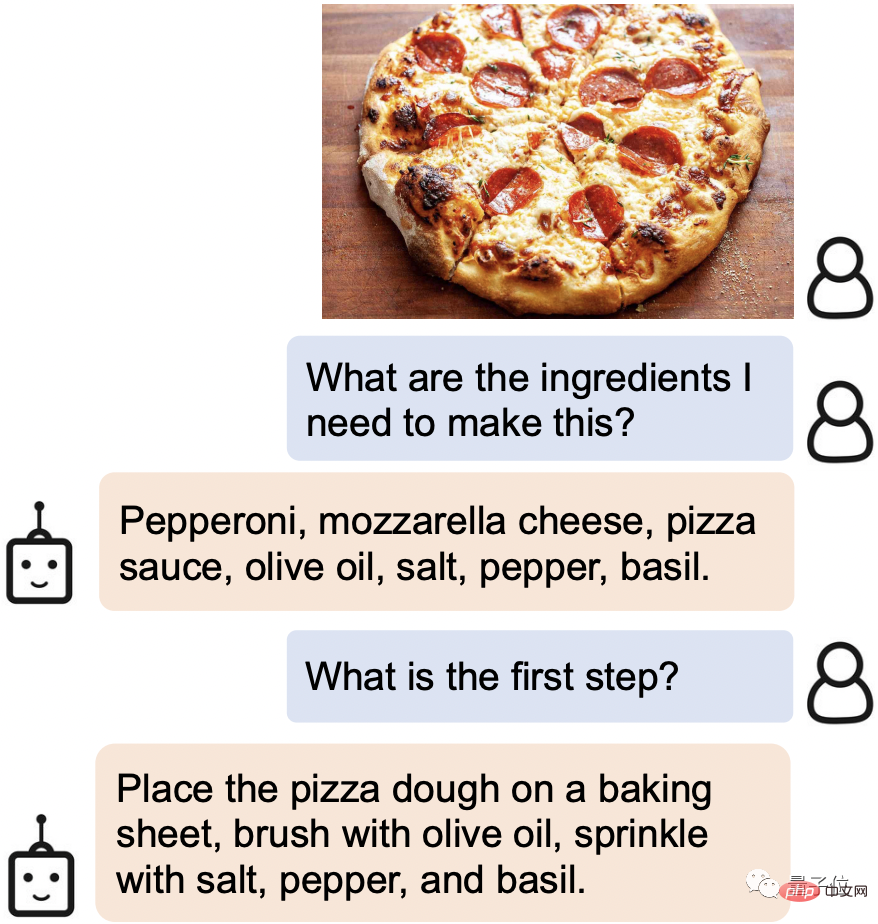

Sebagai contoh, apabila anda menjumpai makanan yang menggoda dalam talian, hantarkan sahaja gambar itu, dan ia akan serta-merta mengenali bahan-bahan yang diperlukan dan langkah memasak:

Malah beberapa butiran Leeuwenhoek dalam gambar boleh "dilihat" dengan jelas.

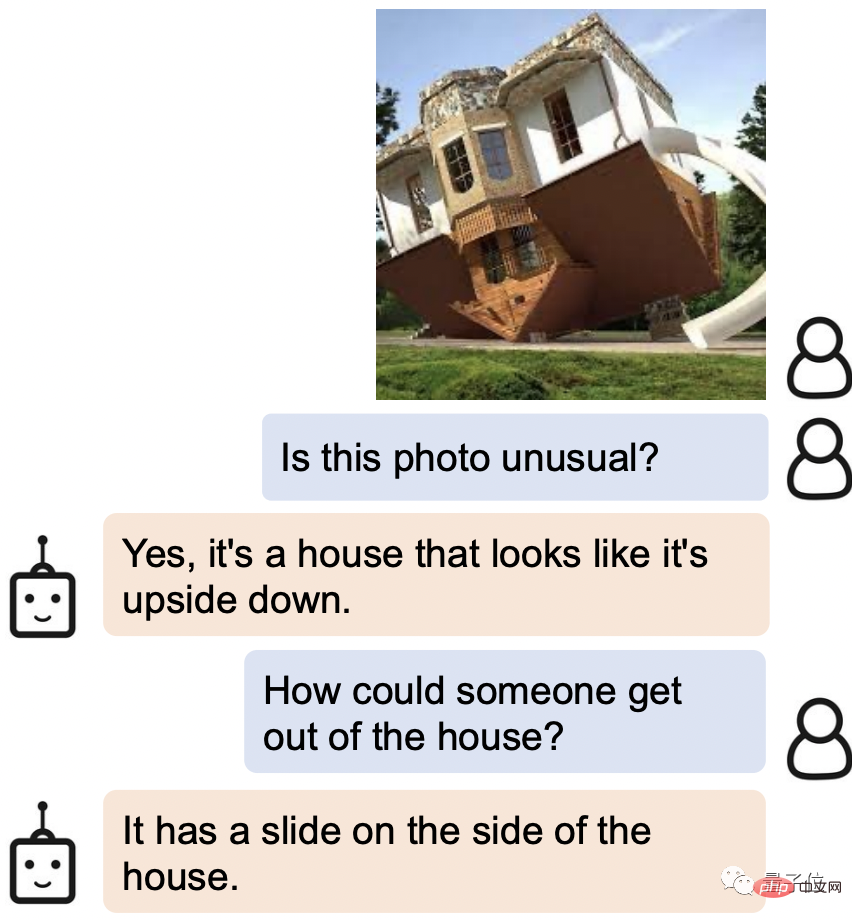

Apabila ditanya bagaimana hendak keluar dari rumah terbalik dalam gambar, jawapan AI ialah: Tidakkah terdapat gelongsor di sisi?

AI baharu ini dipanggil BLIP-2 (Bootstrapping Language-Image Pra-training 2), dan kod itu kini menjadi sumber terbuka.

Perkara yang paling penting ialah, tidak seperti penyelidikan terdahulu, BLIP-2 menggunakan rangka kerja pra-latihan universal, jadi ia boleh disambungkan kepada model bahasa anda sendiri secara sewenang-wenangnya.

Sesetengah netizen sudah membayangkan gabungan hebat menukar antara muka kepada ChatGPT.

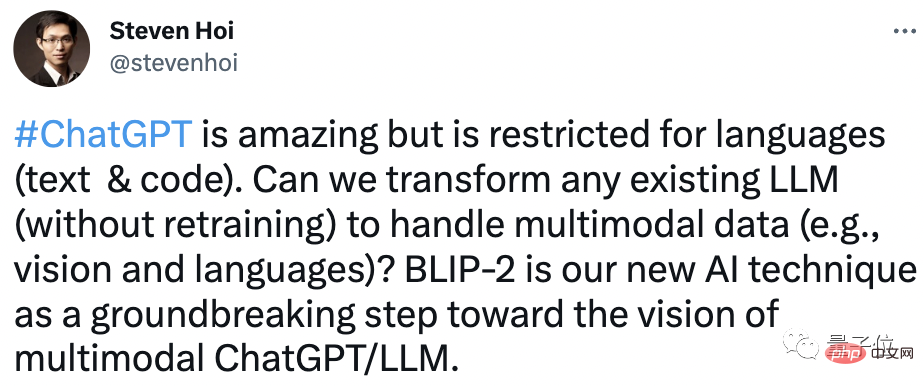

Steven Hoi, salah seorang pengarang, malah berkata: BLIP-2 akan menjadi "versi pelbagai mod ChatGPT" pada masa hadapan.

Jadi, apakah perkara lain yang menakjubkan tentang BLIP-2? Pandang ke bawah bersama-sama.

Keupayaan pemahaman yang sangat baik

Permainan BLIP-2 boleh dikatakan sangat pelbagai.

Anda hanya perlu memberikan gambar, dan anda boleh bercakap dengannya, dan ia boleh memenuhi pelbagai keperluan seperti bercerita melalui gambar, menaakul dan menghasilkan teks yang diperibadikan.

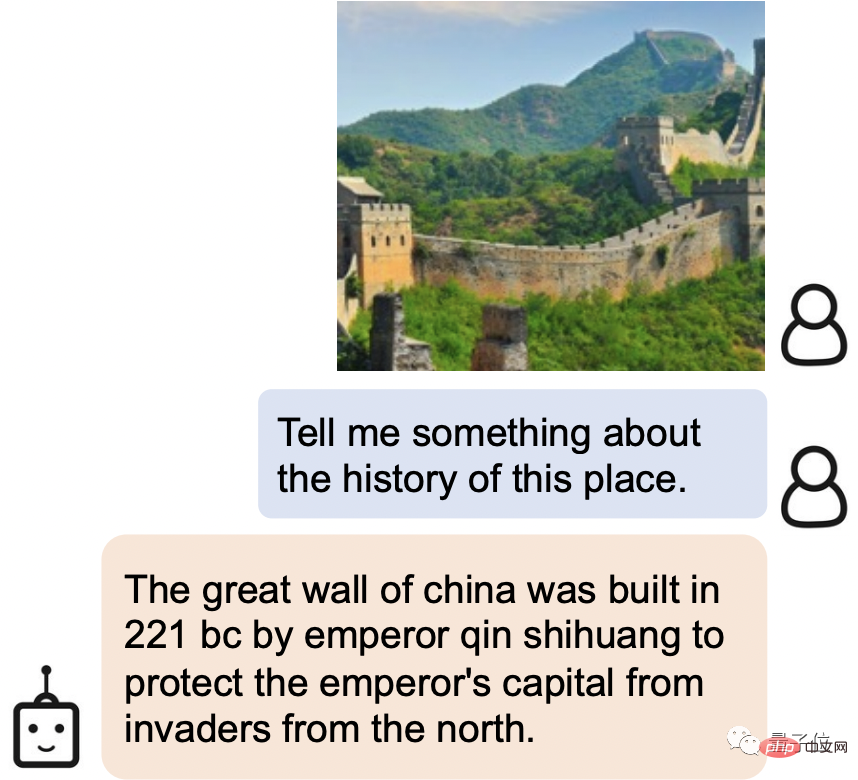

Sebagai contoh, BLIP-2 bukan sahaja dapat mengenal pasti dengan mudah tempat pemandangan dalam gambar sebagai Tembok Besar, tetapi juga memperkenalkan sejarah Tembok Besar:

Tembok Besar China adalah dibina oleh Qin Shihuang pada 221 SM untuk melindungi ibu kota empayar Dibina untuk melindungi daripada pencerobohan dari utara.

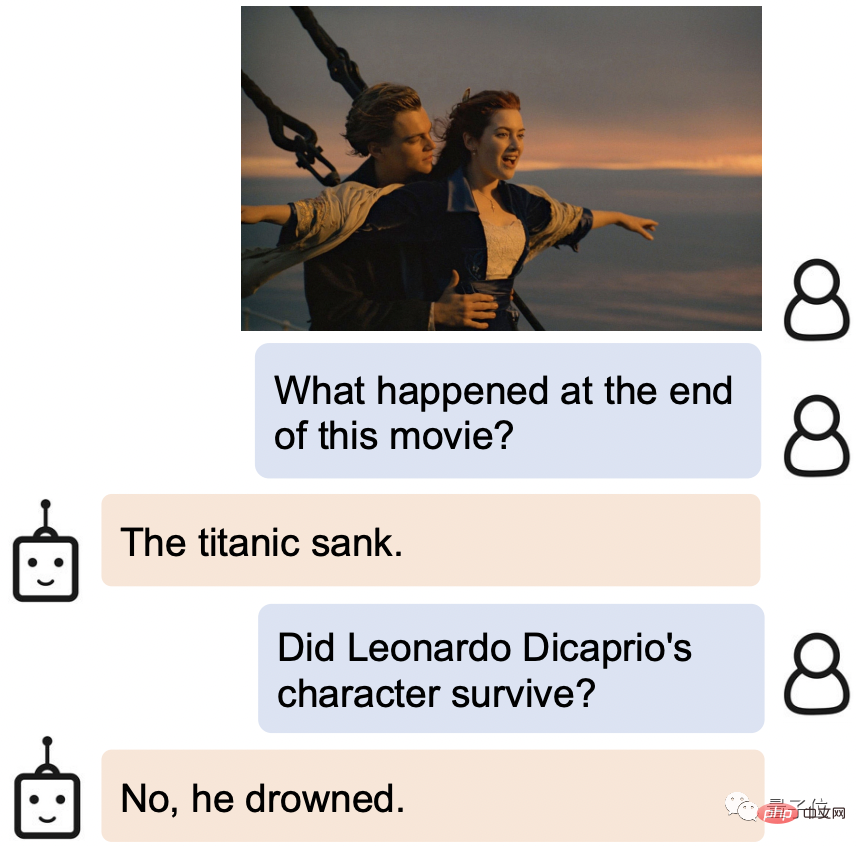

Berikan filem tetap, BLIP-2 bukan sahaja tahu dari mana asalnya, tetapi juga tahu kesudahan cerita: tenggelamnya Titanic, lelaki The Lord tenggelam.

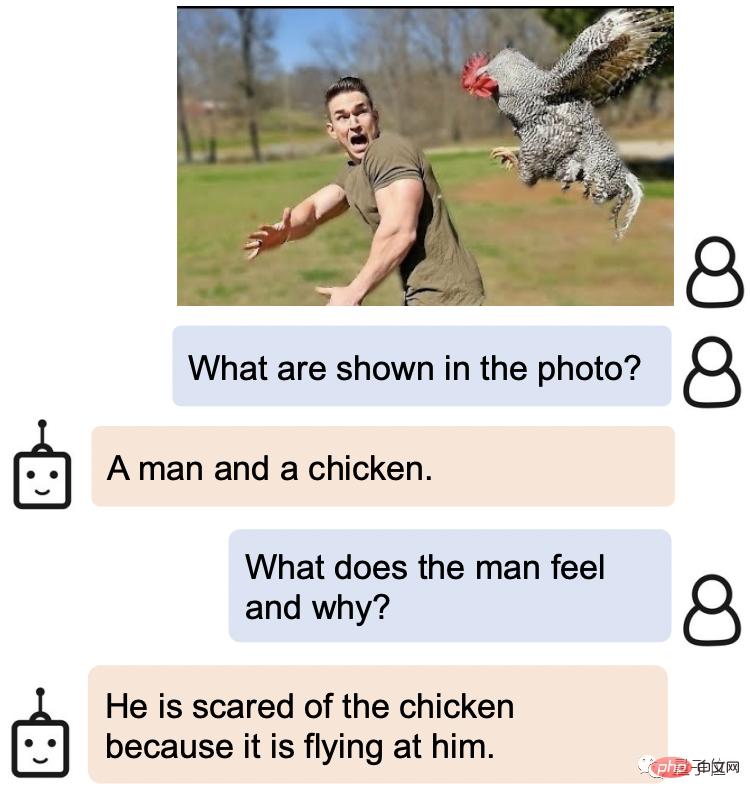

BLIP-2 juga mempunyai pemahaman yang sangat tepat tentang ekspresi manusia.

Apabila ditanya apakah ekspresi lelaki dalam gambar ini dan mengapa dia menjadi seperti ini, jawapan BLIP-2 ialah: Dia takut ayam itu kerana ia terbang ke arahnya.

Apa yang lebih menakjubkan ialah BLIP-2 juga berprestasi sangat baik pada banyak soalan terbuka.

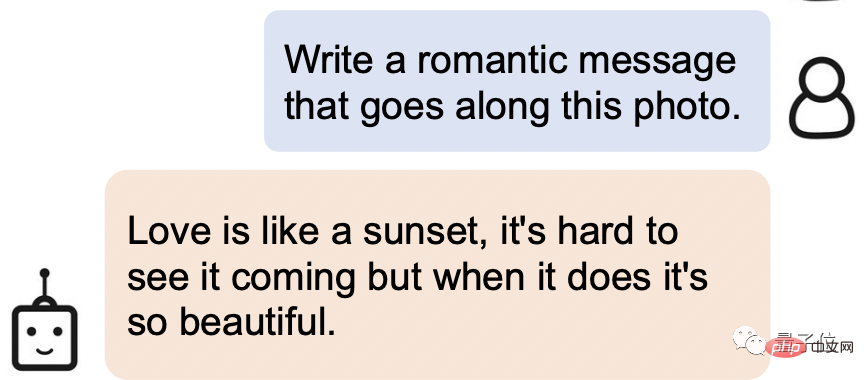

Minta tulis ayat romantik berdasarkan gambar di bawah:

Jawapannya begini: Cinta ibarat matahari terbenam , Sukar untuk melihatnya datang, tetapi apabila ia berlaku, ia sangat indah.

Bukan sahaja orang ini mempunyai pemahaman yang sempurna, tetapi pencapaian sasteranya juga cukup kuat!

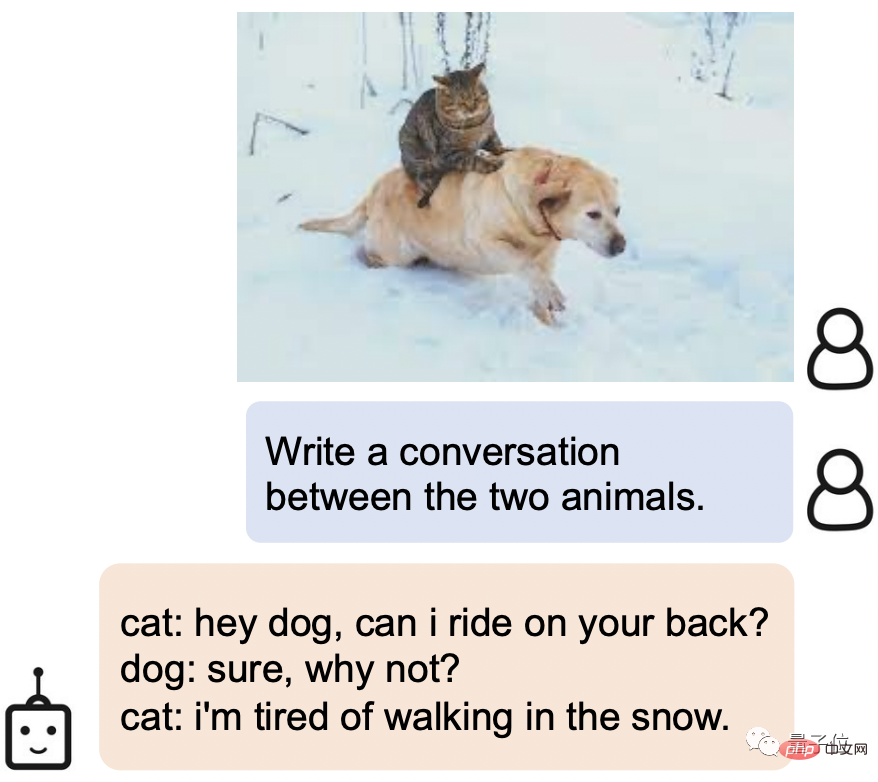

Biarkan ia menjana dialog untuk dua haiwan dalam gambar BLIP-2 juga boleh mengawal kucing sombong x anjing bodoh Tetapan:

Kucing: Hei, anjing, boleh saya tumpang belakang awak?

Anjing: Pasti, kenapa tidak?

Kucing: Saya penat berjalan dalam salji.

Jadi, bagaimanakah BLIP-2 mencapai keupayaan pemahaman yang begitu hebat?

Mencapai SOTA baharu pada pelbagai tugas bahasa visual

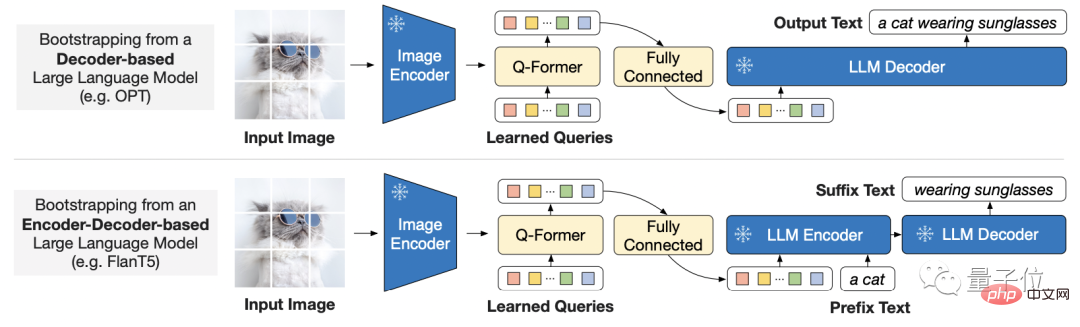

Memandangkan kos latihan hujung ke hujung model berskala besar semakin tinggi, BLIP-2 menggunakan ramalan umum dan cekap kaedah Strategi latihan:

Pra-latihan bahasa visual Bootstrap daripada pengekod imej pra-latihan beku dan model bahasa besar beku di luar rak.

Ini juga bermakna semua orang boleh memilih model yang mereka mahu gunakan.

Untuk merapatkan jurang antara mod, penyelidik mencadangkan Transformer pertanyaan ringan.

Transformer dilatih dalam dua peringkat:

Peringkat pertama bootstraps pembelajaran perwakilan bahasa visual daripada pengekod imej beku, dan peringkat kedua bootstraps penglihatan daripada model bahasa beku kepada penjanaan bahasa belajar.

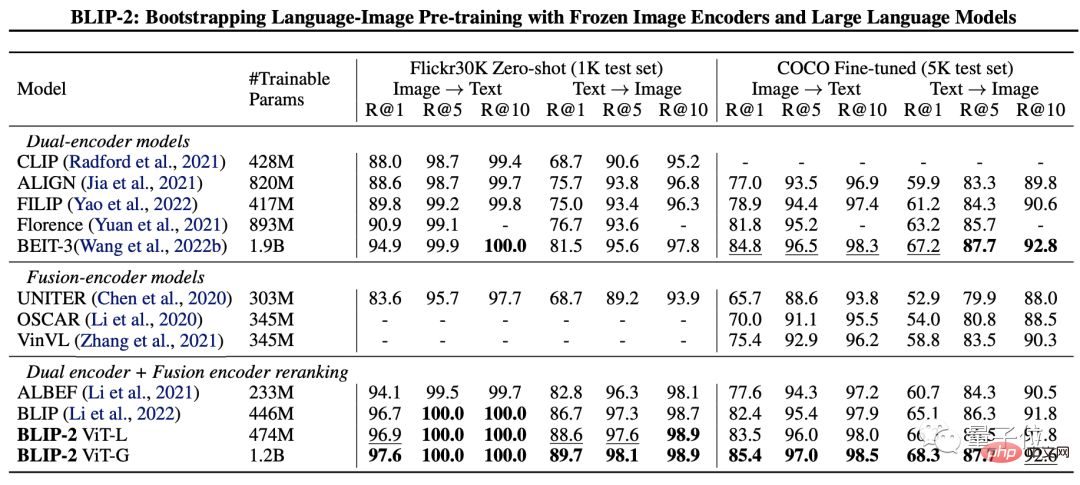

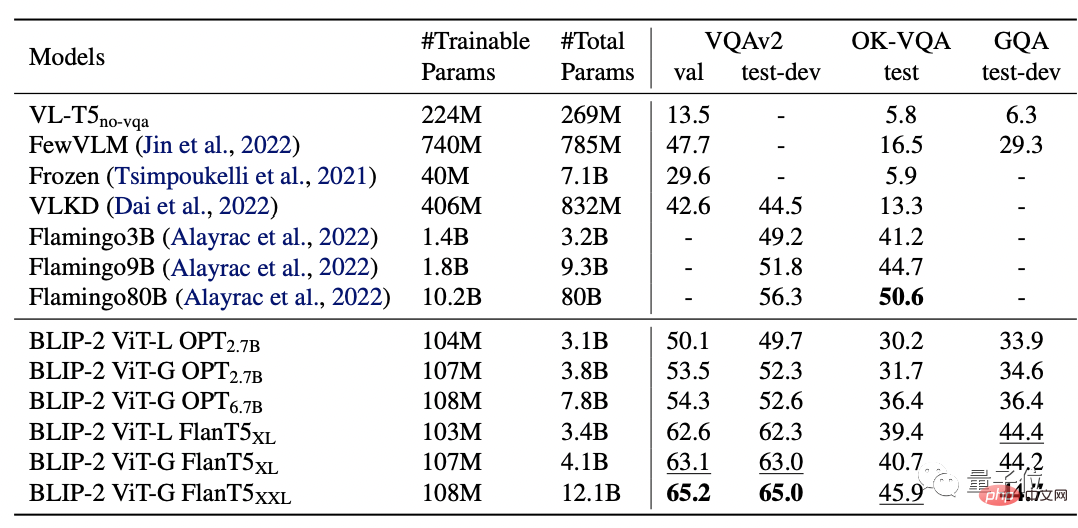

Untuk menguji prestasi BLIP-2, penyelidik bermula daripada penjanaan teks imej sampel sifar, jawapan soalan visual, imej- pengambilan teks, dan sari kata imej telah dinilai pada tugas.

Keputusan akhir menunjukkan bahawa BLIP-2 mencapai SOTA pada pelbagai tugas bahasa visual.

Antaranya, BLIP-2 adalah 8.7% lebih tinggi daripada Flamingo 80B pada VQAv2 pukulan sifar, dan parameter latihan dikurangkan sebanyak 54 kali.

Dan jelas sekali sama ada pengekod imej yang lebih kukuh atau model bahasa yang lebih kukuh akan menghasilkan prestasi yang lebih baik.

Adalah diingatkan bahawa pengkaji juga menyebut di akhir kertas kerja bahawa BLIP-2 masih mempunyai kekurangan iaitu kekurangan. keupayaan pembelajaran konteks :

Setiap sampel mengandungi hanya satu pasangan teks imej, dan pada masa ini mustahil untuk mempelajari korelasi antara berbilang pasangan teks imej dalam satu urutan.

Pasukan Penyelidik

Pasukan penyelidik BLIP-2 adalah daripada Salesforce Research.

Pengarang pertama ialah Junnan Li, yang juga pengarang BLIP yang dilancarkan setahun lalu.

Pada masa ini, beliau adalah seorang saintis penyelidikan kanan di Institut Penyelidikan Salesforce Asia. Lulus dari Universiti Hong Kong dengan ijazah sarjana muda dan Ph.D dari Universiti Nasional Singapura.

Bidang penyelidikan sangat luas, termasuk pembelajaran penyeliaan kendiri, pembelajaran separa penyeliaan, pembelajaran penyeliaan lemah dan bahasa visual.

Berikut ialah pautan kertas dan pautan GitHub BLIP-2. Rakan yang berminat boleh mengambilnya~

Pautan kertas: https://arxiv.org/pdf/2301.12597

Pautan GitHub: https://github.com/salesforce/LAVIS/tree/main/projects/blip2

Pautan rujukan: [1]https://twitter.com/mrdbourke / status/1620353263651688448

[2] https://twitter.com/LiJunnan0409/status/1620259379223343107

Atas ialah kandungan terperinci Inilah cara untuk mengajar ChatGPT cara membaca gambar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI