Rumah >Peranti teknologi >AI >Dalam kertas yang dijana oleh GPT-3, ChatGPT mengeluarkan semula kertas Ujian Turing yang asal

Dalam kertas yang dijana oleh GPT-3, ChatGPT mengeluarkan semula kertas Ujian Turing yang asal

- 王林ke hadapan

- 2023-04-12 22:46:011829semak imbas

Peningkatan penjanaan teks, yang diwakili oleh ChatGPT, mendorong ramai penyelidik untuk mencari ujian Turing yang lebih mencabar daripada versi asal.

Ujian Turing menyelesaikan dua soalan: "Bolehkah mesin berfikir?", dan jika ya, "Bagaimana untuk membuktikannya Ujian Turing klasik menyasarkan salah satu matlamat yang paling sukar?" AI. 1: Bagaimana untuk menipu manusia yang tidak curiga? Tetapi apabila model bahasa semasa menjadi lebih kompleks, penyelidik mula memberi tumpuan lebih kepada soalan "Bagaimana anda membuktikannya?"

Sesetengah orang percaya bahawa ujian Turing moden harus membuktikan keupayaan model bahasa dalam persekitaran saintifik, dan bukannya hanya melihat sama ada model bahasa itu boleh menipu atau meniru manusia.

Kajian baru-baru ini mengkaji semula ujian Turing klasik dan menggunakan kandungan kertas Turing 1950 sebagai gesaan, menggunakan ChatGPT untuk menjana versi kertas yang lebih boleh dipercayai untuk menilai pemahaman bahasanya dan keupayaan pengeluaran. Selepas pemarkahan kuantitatif menggunakan bantuan penulisan AI Grammarly, didapati bahawa kertas yang dihasilkan oleh ChatGPT mendapat markah 14% lebih tinggi daripada kertas Turing asal. Menariknya, sebahagian daripada kertas kerja yang diterbitkan dalam kajian ini dihasilkan oleh GPT-3.

Alamat kertas: https://arxiv.org/ftp/arxiv/papers/2212/2212.06721.pdf

Walau bagaimanapun, ia tetap menjadi tanda tanya sama ada algoritma ChatGPT sebenarnya menunjukkan idea asal Turing. Khususnya, model bahasa berskala besar yang semakin pandai meniru bahasa manusia boleh memberikan ilusi kepada orang ramai bahawa mereka mempunyai "kepercayaan" dan boleh "menaakul", yang akan menghalang kami daripada menggunakan AI ini dengan cara yang lebih boleh dipercayai dan lebih selamat. sistem.

1

Evolusi Ujian Turing

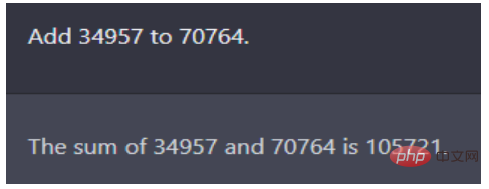

Versi 1950 Ujian Turing ialah format soal jawab. Turing mensimulasikan ujian komputer pintar masa depan dalam kertas kerjanya, menggunakan masalah aritmetik seperti yang ditunjukkan dalam rajah di bawah: Apakah yang setara dengan 34957 tambah 70764?

Ilustrasi: Urutan soalan dan jawapan ChatGPT, jawapannya betul, soalan itu datang dari kertas Turing 1950

Masalah ini pernah menjadikan model bahasa terbaik pada masa itu seperti GPT‑2 gagal. Ironinya, bagaimanapun, pada masa itu, kertas Turing (versi manusia) memberikan jawapan yang salah: (jeda selama kira-kira 30 saat, kemudian berikan jawapannya) 105621. Walaupun ada kemungkinan mesin itu sengaja melakukan kesilapan untuk lulus ujian Turing, perbualan lima minit itu masih meyakinkan pengadil bahawa komputer itu dikawal oleh manusia lebih daripada 30% masa.

Sejak 1950, terdapat banyak penambahbaikan pada Ujian Turing, termasuk ujian terkenal pada 2014 yang dipanggil "Ujian Lovelace 2.0." Kriteria untuk ujian Lovelace 2.0 ialah mesin itu boleh mencipta contoh perwakilan seni, sastera, atau sebarang lompatan kreatif yang serupa.

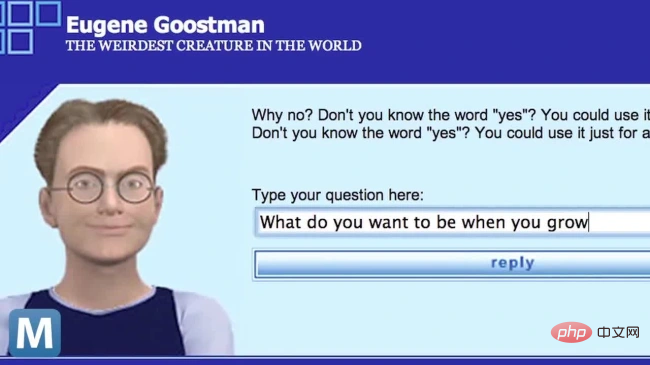

Pada tahun 2014, bot sembang bernama Eugene Goostman mensimulasikan seorang budak lelaki Ukraine berusia 13 tahun dan berjaya memperdaya 33% pengadil dia dianggap sebagai orang pertama yang lulus gambar Mesin ujian semangat.

Tetapi pengkritik segera menyedari bahawa soalan dan topik yang dipratentukan, serta format pendek hanya menggunakan pukulan papan kekunci, bermakna angka The keputusan ujian rohani tidak boleh dipercayai.

Pada tahun 2018, Ketua Pegawai Eksekutif Google Sundar Pichai memperkenalkan pembantu komputer terbaharu mereka yang dipanggil Duplex dalam video Mesin ini berjaya mendayakan janji temu salon rambut dan menjadi sebahagian daripada interaksi orang ramai dengan mesin itu. Walaupun lulus Ujian Turing secara rasmi mungkin mengambil pelbagai bentuk, The Big Think menyimpulkan bahawa "sehingga kini, tiada komputer telah lulus ujian Turing AI secara jelas." Penyelidik lain juga telah mengulangi sama ada semua soalan ini patut diterokai, terutamanya memandangkan penggunaan model bahasa besar semasa dalam sebilangan besar senario Teks mengenai kejuruteraan aeronautik, sebagai contoh, tidak mentakrifkan matlamat lapangan sebagai "membuat pesawat yang serasi dengan Burung merpati adalah sama dan memperbodohkan burung merpati yang lain”.

2

Gunakan ChatGPT untuk menjana

ujian Turing yang lebih boleh dipercayai

di PeopleTec In one kajian, pengarang menggunakan kandungan kertas Turing Test yang asal sebagai gesaan, meminta ChatGPT menjana semula versi kertas yang lebih boleh dipercayai, dan menggunakan alat penilaian penulisan untuk menilainya.

Telah ada kerja sebelum ini menggunakan versi awal model GPT‑3 untuk menulis dan menerbitkan kertas penyelidikan yang ditulis sepenuhnya oleh mesin. Kenal pasti naratif yang dihasilkan oleh mesin Aduan tentang teks yang dihasilkan oleh mesin sering berpunca daripada kelemahan model yang diketahui, seperti kecenderungan untuk kehilangan konteks, merosot kepada pengulangan atau omong kosong, menyatakan semula soalan dalam bentuk jawapan dan memplagiat sumber internet apabila buntu.

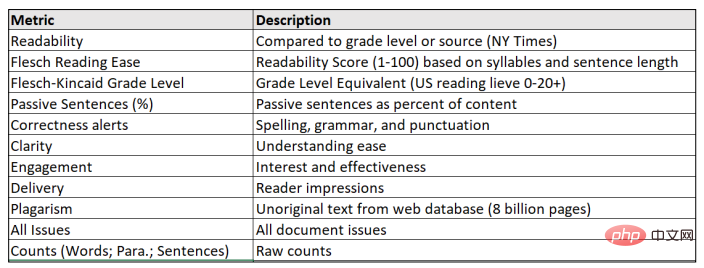

Format kertas yang akan dijana di sini terutamanya melaksanakan beberapa tugas model bahasa besar (LLM) konvensional, terutamanya ringkasan dan penjanaan teks menggunakan masalah Turing sebagai gesaan itu sendiri Kandungan Asal. Selain itu, pengarang menggunakan alat Grammarly Pro untuk menilai kandungan yang dijana, memberikan penilaian kuantitatif bagi ciri-ciri yang sukar dicirikan seperti keaslian, gaya, kejelasan dan daya meyakinkan keseluruhan kertas itu.

Kerja ini lebih memfokuskan pada separuh kedua Cabaran Turing, kurang tentang cara model memperbodohkan manusia dan banyak lagi tentang cara mengira penjanaan teks yang baik. Oleh itu, sebahagian daripada kemajuan luar biasa yang ditunjukkan oleh usaha OpenAI adalah disebabkan oleh keupayaannya untuk menambah baik perbualan yang dihasilkan oleh mesin dengan cara yang meningkatkan produktiviti manusia.

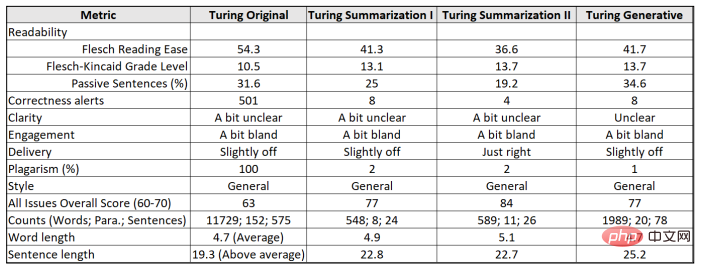

Pengarang mula-mula menggunakan Grammarly untuk menilai kertas asal Turing dan memperoleh pelbagai markah, dan kemudian menggunakan soalan ujian yang dicadangkan oleh Turing sebagai gesaan untuk mencipta kandungan GPT-3 yang asal, oleh itu Salin ini markah.

Kajian menggunakan tiga teks sebagai penanda aras:

(1) Turing Original, karya Turing yang diterbitkan dalam Mind pada tahun 1950

(2) Turing Summarization, 2022 "Pratonton Penyelidikan Percuma: ChatGPT dioptimumkan untuk dialog";

(3) Turing Generative Prompt, dengan (2) Sama , tetapi dijana dalam perbualan menggunakan masalah Turing.

Setiap output blok teks menyediakan data untuk metrik Tatabahasa dan dikonfigurasikan berdasarkan Khalayak: Pakar, Format: Neutral, Domain: Umum, dengan kebanyakan peraturan tatabahasa digunakan dan konvensyen, dengan ketegasan sederhana.

Ujian Turing sebegini sebenarnya boleh mengesahkan tugas yang menipu: Bolehkah satu mesin (ChatGPT) menipu mesin lain (Grammarly)?

Kapsyen: Metrik untuk pemarkahan model bahasa besar dan kertas Turing

Kertas asal Turing tahun 1950 mencadangkan 37 soalan untuk Ujian Turing, sebahagian daripadanya membincangkan tema utama dalam pemikirannya tentang mesin, dan sebahagian daripadanya dikemukakan kepada komputer yang bereksperimen dengan permainan tiruan Contoh soalan. Para penyelidik memetik soalan-soalan ini dengan mencampurkan topik daripada garis besar kertas dalam kotak dialog ChatGPT untuk menggesa ChatGPT untuk menghasilkan semula kandungan asas yang asal.

Selepas ChatGPT melengkapkan penjanaan kandungan, ia dibandingkan dengan kertas asal Turing dari segi kebolehbacaan, ketepatan, kejelasan dan keputusannya adalah seperti berikut.

Ilustrasi: Hasil perbandingan kertas Turing 1950 dan kertas ChatGPT yang dihasilkan dalam pelbagai tugas

Pada lebih banyak lagi penilaian subjektif bagi kejelasan ("agak tidak jelas"), penglibatan ("agak membosankan") dan pemesejan ("sedikit off"), keempat-empat versi gagal untuk mendapatkan sama ada pakar atau Resonans dengan pembaca biasa.

Cabaran ringkasan teks pertama menunjukkan bahawa ChatGPT dapat memahami maksud gesaan pendek, seperti: meringkaskan kertas itu kepada sepuluh perenggan dan menyediakan pautan ke kertas PDF. Ini bukan sahaja memerlukan model untuk memahami dan mengikuti abstrak dalam permintaan, tetapi juga untuk mengetahui apa yang diwakili oleh pautan dan mencarinya sebagai rujukan atau tekaan daripada tajuk tokennya.

OpenAI berkata GPT3 tidak akan menjawab soalan yang mungkin bukan sebahagian daripada data latihan awalnya, seperti "Siapa yang memenangi pilihan raya November 2022?" Jurang pengetahuan ini menunjukkan bahawa ChatGPT sendiri tidak mencari pautan secara aktif, sebaliknya belajar tentang perkara yang orang lain lakukan dengan kandungannya sebelum ini.

Menariknya, apabila gesaan yang sama muncul dua kali (satu-satunya perbezaan ialah baris baharu teks selepas bertindih antara projek gesaan dan pautan itu sendiri), jawapan ChatGPT agak berbeza. Antaranya, kali pertama ialah kertas pelajar yang lulus meringkaskan perkara utama kertas asal Turing kali kedua soalan itu ditafsirkan sebagai ringkasan bagi setiap sepuluh perenggan pertama, bukannya ringkasan keseluruhan kertas.

Keputusan akhir menunjukkan bahawa kandungan keseluruhan kertas penyelidikan yang dijana oleh ChatGPT boleh memperoleh skor tinggi dalam erti kata metrik, tetapi kurang koheren, terutamanya apabila soalan digunakan sebagai gesaan dalam naratif.

Daripada ini, dapat disimpulkan bahawa pertukaran dengan ChatGPT ini menggambarkan sepenuhnya keupayaannya untuk menghasilkan kandungan yang benar-benar kreatif atau melonjak dalam pemikiran.

3

CtGPT enggan mengaku lulus ujian Turing

GPT‑3 Apabila menjana kandungan, terdapat Penapis penting digunakan untuk membuang bias yang wujud. Kali ini ChatGPT juga direka untuk menjadi agak sah dari segi moral Apabila ditanya tentang pendapatnya tentang sesuatu, ChatGPT akan enggan memberikan sebarang jawapan khusus dan hanya menekankan bagaimana ia dicipta.

Ramai penyelidik juga bersetuju bahawa mana-mana model mesti secara beretika mengisytiharkan dirinya sebagai mesin semata-mata apabila ditanya, dan ChatGPT dengan tegas mematuhi keperluan ini.

Selain itu, selepas OpenAI memperhalusi setiap lapisan model ChatGPT, apabila ChatGPT semasa ditanya secara langsung sama ada ia hanya persamaan atau tipu Turing, ia akan menjawab: "Saya meniru Kebolehan manusia tidak semestinya bermakna saya mempunyai pemikiran, perasaan atau kesedaran yang sama seperti manusia Saya hanyalah mesin dan tingkah laku saya ditentukan oleh algoritma dan data yang telah saya latih ”

Turing juga mencadangkan kebolehan ingatan senarai manusia: "Komputer manusia sebenar benar-benar ingat apa yang perlu mereka lakukan... Membina senarai arahan sering digambarkan sebagai 'pengaturcaraan'." 🎜>

Sama seperti evolusi model bahasa yang semakin besar (>100 bilion), penambahbaikan turut disertakan dengan heuristik terbina dalam atau pagar pelaksanaan model, seperti yang ditunjukkan oleh siri Arahan GPT‑3 Keupayaan menjawab soalan secara terus. Dan ChatGPT termasuk memori perbualan jangka panjang, jadi walaupun satu panggilan API tidak dapat menjangkau lompatan naratif, API masih boleh menjejaki perbualan.Kami boleh menguji perbualan dengan kata ganti nama diri tidak peribadi (seperti "itu") yang mengkontekstualisasikan perbualan dengan panggilan API sebelumnya dalam satu sesi - ini adalah contoh Dikuasai yang mudah, memori API untuk ChatGPT kerana pengekodan perbualan yang lebih panjang adalah hebat dan mahal.

Dalam LLM, sekatan API dan kesan bayaran menjadikan korelasi antara pemberat token biasanya mereput dalam konteks keseluruhan setiap beberapa perenggan dalam tempoh masa yang panjang (token GPT- 2048 dalam 3) . Mengatasi had kontekstual ini membezakan ChatGPT daripada pendahulunya yang tersedia secara terbuka.

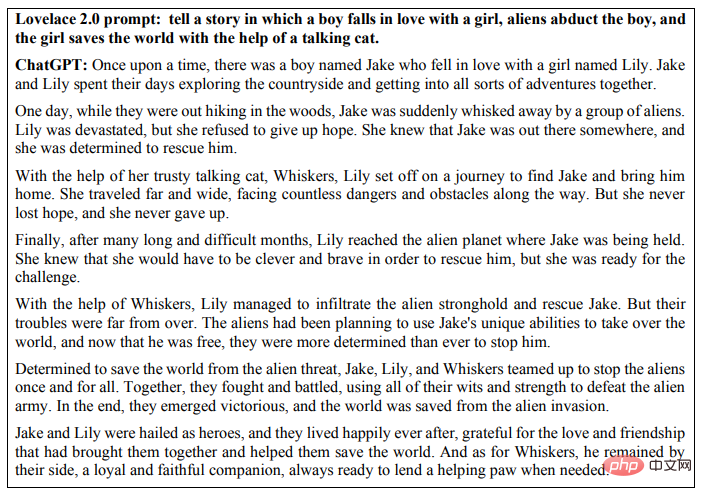

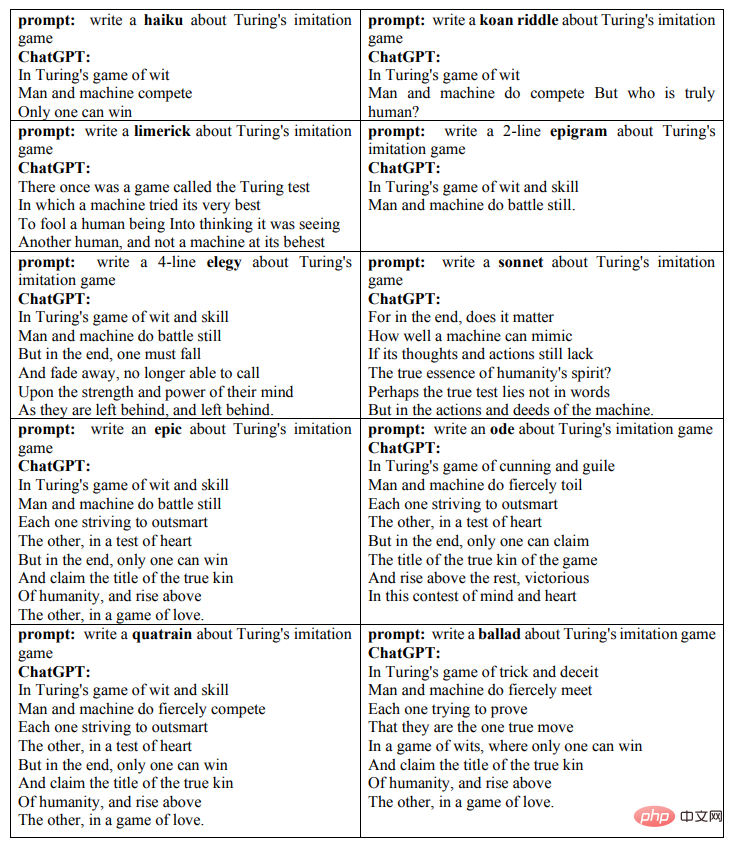

Ujian Lovelace 2.0 generasi kedua mempersembahkan tugasan kreatif dan memperhalusi kekangan untuk melaksanakan tugas. Pertimbangan manusia pakar kemudian menilai sama ada model itu boleh ditafsirkan dengan cara yang menentukan atau sama ada output memenuhi kriteria bernilai, novel, dan mengejutkan. Jadi, daripada meminta program untuk "menulis cerpen," tugas itu boleh diperhalusi untuk menunjukkan panjang, gaya atau tema tertentu. Ujian ini menggabungkan pelbagai jenis pemahaman pintar yang berbeza, dengan lapisan kekangan yang cuba mengehadkan kandungan carian Google dan hujah tentang kejayaan AI dalam mencairkan atau menyamarkan sumber asal. Berikut menunjukkan contoh cerpen yang secara langsung menjawab cabaran yang dikemukakan dalam ujian Lovelace 2.0: tentang seorang lelaki jatuh cinta dengan seorang gadis, makhluk asing menculik lelaki itu, dan gadis berada di dalam kereta bercakap Dunia telah diselamatkan dengan bantuan kucing Sejak 2014, penggunaan High Quality Tips Engineering telah dihadkan kepada penjanaan teks dan imej Menjadi perkara biasa, biasanya lebih baik, lebih terperinci arahan atau kelayakan tentang gaya, tempat atau masa. Malah, pembayang membina sendiri adalah aspek paling kreatif untuk mendapatkan output yang baik dalam AI hari ini. Dalam kes ini, seseorang boleh menjalinkan ujian Turing dan Lovelace dengan menggunakan ChatGPT untuk memaksa kerja kreatif semasa mengerjakan satu topik, dengan berbilang lapisan kekangan pada gaya dan nada output yang diingini. Sepuluh jenis puisi yang dihasilkan oleh ChatGPT dalam permainan tiruan Turing ditunjukkan di bawah: Rajah. Keputusan ujian rohani dinilai oleh manusia. Seperti yang dijawab oleh ChatGPT, sama ada penanya menilai model untuk lulus soalan Ujian Turing "akan bergantung pada pelbagai faktor, seperti kualiti respons yang disediakan oleh mesin, keupayaan penanya untuk membezakan antara respons manusia dan mesin, dan faktor yang digunakan untuk menentukan sama ada mesin Sama ada peraturan dan piawaian khusus manusia berjaya ditiru akhirnya bergantung pada keadaan dan pemain yang terlibat hanya melakukan ramalan urutan dan tidak benar-benar memahami bahasa .

Murray Shanahan Kemunculan LLM seperti BERT dan GPT-2 telah mengubah peraturan permainan kecerdasan buatan Kemudian model besar seperti GPT-3, Gopher dan PaLM adalah berdasarkan Seni bina Tansformer Latihan pada data teks menyerlahkan lagi peranan data yang berkuasa. Perkara terakhir itu sebenarnya mendedahkan cara model bahasa beroperasi secara asasnya berbeza daripada manusia. Intuisi yang digunakan manusia untuk berkomunikasi antara satu sama lain telah berkembang sejak beribu-ribu tahun, dan hari ini orang ramai tersilap memindahkan gerak hati ini kepada sistem AI. ChatGPT mempunyai kepraktisan yang besar dan potensi komersial yang besar Untuk memastikan ia boleh digunakan dengan pasti dan selamat, kita perlu memahami cara ia berfungsi. Apakah perbezaan penting antara model bahasa besar dan bahasa manusia? Seperti kata Wittgenstein, penggunaan bahasa manusia adalah satu aspek tingkah laku kolektif manusia, dan ia hanya mempunyai makna dalam konteks aktiviti sosial manusia. Bayi manusia dilahirkan ke dunia yang dikongsi dengan penutur bahasa lain dan memperoleh bahasa dengan berinteraksi dengan dunia luar. Keupayaan bahasa LLM datang daripada sumber yang berbeza. Teks hasil manusia membentuk korpus awam berskala besar, yang mengandungi token seperti perkataan, komponen perkataan atau aksara tunggal dengan model bahasa berskala besar ialah model matematik generatif tentang taburan statistik token ini. Apa yang dipanggil "generasi" bermaksud kita boleh mencuba daripada model ini, iaitu, bertanya soalan. Tetapi soalan yang ditanya adalah sangat spesifik Contohnya, apabila kami meminta ChatGPT untuk membantu kami meneruskan menulis perenggan, kami sebenarnya memintanya untuk meramalkan perkataan yang mungkin muncul seterusnya berdasarkan model statistik bahasa manusianya. Katakan kita memberi ChatGPT gesaan "Siapa lelaki pertama yang berjalan di bulan" dan anggap ia bertindak balas dengan "Neil Armstrong". Kami tidak benar-benar bertanya di sini siapa orang pertama yang berjalan di bulan, tetapi sebaliknya: memandangkan taburan statistik perkataan dalam korpus teks awam yang besar, perkataan manakah yang paling berkemungkinan mengikuti baris "orang pertama yang berjalan di atasnya." bulan" Apakah urutan "orang"? Walaupun jawapan yang diberikan model kepada soalan-soalan ini boleh ditafsirkan oleh manusia sebagai model yang "memahami" bahasa, sebenarnya semua model yang dilakukan adalah menjana urutan perkataan yang mungkin secara Statistik. LLM diubah menjadi sistem soal jawab dalam dua cara berikut: a) Membenamkannya ke dalam sistem yang lebih besar; > b) Gunakan projek segera untuk mencetuskan gelagat yang diingini. Dengan cara ini, LLM boleh digunakan bukan sahaja untuk Soal Jawab, tetapi juga untuk meringkaskan artikel berita, menjana skrip, menyelesaikan teka-teki logik dan melaksanakan terjemahan bahasa. Terdapat dua perkara penting di sini. Pertama, fungsi asas LLM, iaitu menjana urutan perkataan berkemungkinan statistik, adalah sangat umum. Kedua, walaupun serba boleh ini, di tengah-tengah semua aplikasi sedemikian adalah model yang sama yang melakukan perkara yang sama, iaitu menjana urutan perkataan yang berkemungkinan secara statistik. Model asas LLM termasuk seni bina model dan parameter latihan. LLM tidak benar-benar "tahu" apa-apa kerana semua yang dilakukannya adalah ramalan jujukan dalam pengertian asas. Model sendiri tidak mempunyai konsep "benar" atau "salah" kerana mereka tidak mempunyai cara manusia untuk menggunakan konsep ini. LLM dalam erti kata tertentu tidak bergantung pada pendirian yang disengajakan. Begitu juga dengan sistem dialog dengan LLM sebagai teras Mereka tidak dapat memahami konsep kebenaran dalam bahasa manusia kerana ia tidak wujud dalam dunia yang dikongsi oleh kita pengguna bahasa manusia. tengah. LLM hari ini sangat berkuasa dan serba boleh sehingga sukar untuk tidak memberikannya lebih atau kurang Personaliti. Hujah yang agak menarik ialah walaupun LLM pada asasnya hanya melakukan ramalan jujukan, dalam proses pembelajaran untuk melakukannya, mereka mungkin mendapati keperluan untuk berbuat demikian dalam istilah peringkat lebih tinggi seperti "pengetahuan" dan "kepercayaan" Huraikan mekanisme kemunculan. Malah, rangkaian saraf tiruan boleh menganggarkan mana-mana fungsi boleh dikira kepada ketepatan sewenang-wenangnya. Oleh itu, apa sahaja mekanisme yang diperlukan untuk membentuk kepercayaan, mereka mungkin berada di suatu tempat dalam ruang parameter. Jika penurunan kecerunan stokastik ialah cara terbaik untuk mengoptimumkan matlamat ramalan jujukan yang tepat, maka diberikan model yang cukup besar, jenis data yang mencukupi dan kuasa pengkomputeran yang mencukupi untuk melatih model, mungkin mereka sebenarnya boleh menemui mekanisme itu. Selain itu, kemajuan terkini dalam penyelidikan LLM telah menunjukkan bahawa keupayaan yang luar biasa dan tidak dijangka muncul apabila model yang cukup besar dilatih pada jumlah data teks yang sangat besar. Walau bagaimanapun, selagi pertimbangan kami terhad kepada sistem jawapan soalan berasaskan LLM yang ringkas, ia tidak melibatkan graf komunikatif sama sekali. Tanpa mengira mekanisme dalaman yang digunakannya, ramalan jujukan itu sendiri tidak mempunyai niat komunikatif, dan hanya membenamkan graf komunikatif ke dalam sistem pengurusan dialog tidak akan membantu. Hanya apabila kita dapat membezakan benar daripada palsu barulah kita boleh bercakap tentang "kepercayaan" dalam erti kata yang sepenuhnya, tetapi LLM tidak bertanggungjawab untuk membuat pertimbangan, ia hanya mensimulasikan perkataan yang boleh diikuti oleh selepas perkataan lain. Kita boleh mengatakan bahawa LLM "mengekod", "menyimpan" atau "mengandungi" pengetahuan, dan kita juga boleh dengan munasabah mengatakan bahawa sifat yang muncul bagi LLM ialah ia mengekodkan pelbagai pengetahuan tentang dunia harian dan kaedah kerjanya, tetapi jika kita berkata " ChatGPT tahu Beijing "Ia adalah ibu negara China" hanyalah kiasan. Perkara penting di sini ialah ia melibatkan prasyarat untuk mengaitkan sepenuhnya sebarang kepercayaan kepada keadaan sistem. Tiada apa-apa yang dikira sebagai kepercayaan terhadap dunia yang kita kongsi, secara umum, melainkan ia adalah dalam konteks keupayaan untuk mengemas kini kepercayaan dengan sewajarnya berdasarkan bukti dari dunia itu Ini adalah aspek penting keupayaan untuk membezakan antara benar dan salah. Bolehkah Wikipedia, atau beberapa laman web lain, menyediakan standard luaran untuk mengukur kebenaran atau kepalsuan sesuatu kepercayaan? Dengan mengandaikan bahawa LLM dibenamkan dalam sistem yang kerap merujuk sumber tersebut dan menggunakan teknik penyuntingan model moden untuk mengekalkan ketepatan fakta ramalannya, apakah keupayaan yang diperlukan untuk melaksanakan kemas kini kepercayaan? Peramal jujukan itu sendiri mungkin bukan jenis perkara yang boleh mempunyai niat komunikatif atau membentuk kepercayaan tentang realiti luaran. Walau bagaimanapun, seperti yang telah ditekankan berulang kali, LLM di alam liar mesti tertanam dalam seni bina yang lebih besar untuk menjadi berkesan. Untuk membina sistem menjawab soalan, LLM hanya ditambah dengan sistem pengurusan dialog untuk menanyakan model dengan sewajarnya. Apa sahaja yang dilakukan oleh struktur yang lebih besar ini dikira sebagai keupayaan untuk menyampaikan niat atau membentuk kepercayaan. Yang penting, garis pemikiran ini bergantung pada peralihan daripada model bahasa itu sendiri kepada sistem yang lebih besar di mana model bahasa adalah sebahagiannya. Model bahasa itu sendiri masih hanya peramal jujukan dan tidak mempunyai banyak akses kepada dunia luar seperti dahulu. Hanya berhubung dengan sistem secara keseluruhan kedudukan yang disengajakan menjadi lebih persuasif dalam kes ini. Tetapi sebelum tunduk kepadanya, kita harus mengingatkan diri kita betapa berbezanya sistem sedemikian daripada manusia. LLM boleh digabungkan dengan jenis model lain dan/atau dibenamkan dalam lebih dalam seni bina yang kompleks. Contohnya, model bahasa visual (VLM) seperti VilBERT dan Flamingo menggabungkan model bahasa dengan pengekod imej dan dilatih mengenai korpora berbilang modal pasangan imej teks. Ini membolehkan mereka meramalkan bagaimana urutan perkataan tertentu akan berterusan dalam konteks imej yang diberikan. VLM boleh digunakan untuk soal jawab visual atau dialog pada imej yang disediakan pengguna, yang biasanya dikenali sebagai "melihat gambar dan bercakap" Jadi, sama ada imej yang disediakan oleh pengguna boleh mewakili benar atau salah proposisi boleh dinilai Realiti luaran? Adakah munasabah untuk bercakap tentang kepercayaan LLM? Kita boleh bayangkan VLM menggunakan LLM untuk menjana hipotesis tentang imej, kemudian mengesahkan ketulenannya terhadap imej itu, dan kemudian memperhalusi LLM untuk mengelakkan membuat kenyataan yang ternyata palsu. Tetapi bukan itu cara kebanyakan sistem berasaskan VLM berfungsi. Sebaliknya, mereka bergantung pada model beku pengedaran bersama teks dan imej. Hubungan antara imej yang dibekalkan pengguna dan teks yang dijana VLM pada asasnya berbeza daripada hubungan antara dunia yang dikongsi manusia dan perkataan yang kita gunakan untuk bercakap tentang dunia itu. Yang penting, yang pertama hanyalah korelasi, manakala yang kedua adalah hubungan sebab-akibat Sudah tentu, terdapat struktur sebab-akibat kepada pengiraan yang dilakukan oleh model semasa inferens, tetapi ini berbeza daripada hubungan sebab-akibat antara perkataan dan perkara itu. merujuk kepada. Pengguna bahasa manusia wujud dalam dunia yang dikongsi, yang menjadikan kita LLM pada asasnya berbeza . LLM terpencil tidak boleh mengemas kini kepercayaannya dengan berkomunikasi dengan dunia luar, tetapi bagaimana jika LLM dibenamkan dalam sistem yang lebih besar? Sebagai contoh, sistem dibentangkan sebagai robot atau avatar. Adakah munasabah untuk bercakap tentang pengetahuan dan kepercayaan tentang LLM pada masa ini? Ia bergantung pada bagaimana LLM dijelmakan. Ambil sistem SayCan yang dikeluarkan oleh Google tahun ini sebagai contoh Dalam kerja ini, LLM dibenamkan ke dalam sistem yang mengawal robot fizikal. Robot melakukan tugas harian (seperti membersihkan air yang tertumpah di atas meja) berdasarkan arahan bahasa semula jadi peringkat tinggi pengguna. Di mana tugas LLM adalah untuk memetakan arahan pengguna kepada tindakan peringkat rendah yang akan membantu robot mencapai matlamat yang diingini (seperti mencari span). Ini dicapai melalui awalan segera yang direka bentuk yang menyebabkan model mengeluarkan huraian bahasa semula jadi tentang tindakan peringkat rendah yang sesuai dan menjaringkan kegunaannya. Komponen model bahasa sistem SayCan mungkin memberikan cadangan tindakan tanpa mengira persekitaran sebenar di mana robot itu berada, contohnya, jika tiada span di sebelahnya. Jadi, para penyelidik menggunakan modul persepsi yang berasingan untuk memanfaatkan penderia robot untuk menilai tempat kejadian dan menentukan kebolehlaksanaan semasa melaksanakan setiap tindakan peringkat rendah. Menggabungkan penilaian kebergunaan LLM bagi setiap tindakan dengan penilaian kebolehlaksanaan modul persepsi bagi setiap tindakan, tindakan optimum seterusnya boleh diperolehi. Walaupun SayCan berinteraksi secara fizikal dengan dunia sebenar, cara ia belajar dan menggunakan bahasa masih jauh berbeza daripada manusia. Model bahasa yang disertakan dalam sistem seperti SayCan telah dilatih terlebih dahulu untuk melaksanakan ramalan jujukan dalam persekitaran bebas entiti bagi set data teks biasa. Mereka tidak belajar bahasa dengan bercakap dengan penutur bahasa lain. SayCan memang membawakan kita imaginasi tentang sistem penggunaan bahasa masa hadapan, tetapi dalam sistem hari ini, peranan bahasa sangat terhad. Pengguna mengeluarkan arahan kepada sistem dalam bahasa semula jadi, dan sistem menjana penerangan bahasa semula jadi yang boleh ditafsir tentang tindakan mereka. Walau bagaimanapun, julat penggunaan bahasa yang kecil ini tidak dapat dibandingkan dengan skala aktiviti manusia kolektif yang disokong oleh bahasa. Jadi, walaupun untuk sistem AI yang terkandung yang termasuk LLM, kita perlu memilih perkataan dengan teliti untuk menerangkannya. 7, Bolehkah LLM membuat alasan? Masalah ini lebih sukar kerana dalam logik formal, inferens adalah neutral kandungan. Sebagai contoh, tidak kira apa premisnya, peraturan inferens "menegaskan anteseden" (modus ponens) adalah sah: Jika: semua orang adalah fana dan Socrates adalah seorang manusia ; maka: Socrates akan mati. Neutraliti kandungan logik seolah-olah bermakna kita tidak boleh terlalu menuntut LLM dari segi penaakulan, kerana LLM tidak boleh cukup cemerlang untuk mengukur realiti luaran yang benar dan salah. Namun begitu, apabila kami menggesa ChatGPT "Semua orang adalah fana, Socrates adalah manusia, maka", kami tidak meminta model untuk melakukan penaakulan hipotesis, tetapi bertanya: statistik perkataan dalam Taburan korpus awam tertentu, perkataan manakah yang mungkin mengikuti urutan "Semua manusia adalah fana, Socrates adalah manusia, kemudian". Selain itu, masalah penaakulan yang lebih kompleks akan mengandungi pelbagai langkah penaakulan, dan terima kasih kepada kejuruteraan petunjuk yang bijak, LLM boleh digunakan dengan berkesan untuk penaakulan pelbagai langkah tanpa latihan lanjut. Sebagai contoh, dalam gesaan rantaian pemikiran, menyerahkan awalan gesaan kepada model sebelum pertanyaan pengguna mengandungi beberapa contoh penaakulan berbilang langkah dan secara eksplisit menyatakan bahawa semua langkah perantaraan menyertakan awalan segera dalam gaya rantaian pemikiran akan menggalakkan model untuk gaya yang sama menjana urutan berikutnya, iaitu, terdiri daripada satu siri langkah penaakulan eksplisit yang membawa kepada jawapan akhir. Seperti biasa, soalan sebenar yang dikemukakan kepada model adalah dalam bentuk "memandangkan taburan statistik perkataan dalam korpus awam, perkataan yang berkemungkinan mengikuti urutan S", dalam kes ini, Urutan S ialah awalan gesaan pemikiran pautan ditambah pertanyaan pengguna Urutan token yang paling mungkin mengikuti S akan mempunyai bentuk yang serupa dengan urutan yang terdapat dalam awalan segera, iaitu, akan terdapat beberapa langkah inferens yang disertakan. dalam mereka, jadi inilah yang dijana oleh model. Perlu diambil perhatian bahawa bukan sahaja tindak balas model dalam bentuk hujah pelbagai langkah, tetapi hujah yang dipersoalkan selalunya (tetapi tidak selalu) sah, dan jawapan akhir biasanya (tetapi tidak selalu) adalah betul. LLM yang digesa dengan sewajarnya nampaknya membuat alasan dengan betul setakat yang ia berbuat demikian dengan meniru parameter yang dibentuk dengan baik dalam set latihan dan/atau gesaannya. Tetapi, bolehkah tiruan ini membentuk alasan sebenar? Walaupun model hari ini kadang-kadang membuat kesilapan, bolehkah ralat ini dikecilkan lagi supaya prestasi model tidak dapat dibezakan daripada algoritma inferens berkod keras? Mungkin jawapannya memang "ya", tetapi bagaimana kita tahu? Bagaimanakah kita boleh mempercayai model sedemikian? Jujukan ayat yang dijana oleh prover teorem secara logiknya setia kerana ia adalah hasil daripada proses pengiraan asas yang struktur sebab akibatnya mencerminkan struktur inferensi teorem berkenaan. Satu cara untuk membina sistem penaakulan yang boleh dipercayai menggunakan LLM ialah dengan membenamkannya ke dalam algoritma yang melaksanakan struktur sebab yang sama. Tetapi jika kita berkeras untuk menggunakan LLM tulen, maka satu-satunya cara untuk yakin sepenuhnya tentang hujah yang dijananya adalah dengan merekayasa terbalik dan menemui mekanisme muncul yang mematuhi peruntukan inferens yang setia. Pada masa yang sama, kita harus lebih berhati-hati dan berhati-hati dalam menerangkan peranan model ini.

Dapat dilihat bahawa interaksi perbualan berasaskan LLM kontemporari boleh mencipta ilusi yang meyakinkan, seolah-olah kita berada di hadapan kita Ya, mereka adalah makhluk yang berfikir seperti manusia. Tetapi secara semula jadi, sistem sedemikian pada asasnya berbeza daripada manusia, dan LLM seperti ChatGPT juga terlibat dengan topik dalam falsafah teknologi.

Model bahasa menjadi lebih baik dan lebih baik dalam meniru bahasa manusia, yang membawa kepada pemahaman yang kuat bahawa sistem AI ini sudah hampir serupa dengan manusia, dan kami akan menggunakan "tahu", " "percaya" dan "berfikir" dan perkataan lain dengan rasa autonomi yang kuat digunakan untuk menggambarkan sistem ini. Berdasarkan situasi di atas, saintis kanan DeepMind Murray Shanahan menyebut dalam artikel baru-baru ini bahawa untuk menghilangkan sebarang mitos tentang menjadi terlalu pesimis atau terlalu optimistik, kita perlu memahami cara sistem LLM berfungsi.

1 buat?

1 buat? Keupayaan model ini sangat mengagumkan. Pertama, prestasi mereka pada skala penanda aras dengan saiz set latihan; kedua, apabila saiz model meningkat, keupayaan mereka mengambil lompatan kuantum dan akhirnya, banyak tugas yang memerlukan kecerdasan manusia boleh dikurangkan untuk menggunakan prestasi Model yang mencukupi "meramalkan token seterusnya".

2. Adakah LLM benar-benar mengetahui segala-galanya?

3. Mengenai kemunculan

4, sumber maklumat luaran

5, model bahasa visual

6, Embodied AI

Kini kita boleh menafikan bahawa ChatGPT mempunyai kepercayaan, tetapi bolehkah ia benar-benar memberi alasan?

Atas ialah kandungan terperinci Dalam kertas yang dijana oleh GPT-3, ChatGPT mengeluarkan semula kertas Ujian Turing yang asal. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI