Bagaimana untuk menjalankan temu duga untuk 'mengupah' pengekod ChatGPT?

Penterjemah |. Zhu Xianzhong

Perancang |. Xu Jiecheng

Tidak seperti alat pembangunan perisian lain yang dipercayai oleh pembangun, alat AI mempunyai beberapa had dari segi latihan, pembinaan, pengehosan dan penggunaan Risiko.

Sejak keluaran ChatGPT pada penghujung tahun 2022, Internet telah dipenuhi dengan hujah yang menyokong dan meraguinya dalam perkadaran yang hampir sama. Sama ada anda suka atau tidak, AI sedang memasuki organisasi pembangunan anda. Walaupun anda tidak bercadang untuk membangunkan produk AI atau memanfaatkan alat AI untuk menulis kod untuk anda, ia masih boleh disepadukan ke dalam alatan dan platform yang digunakan untuk membina, menguji dan menjalankan kod sumber.

Alat AI mempunyai beberapa risiko khas, yang mungkin menjejaskan peningkatan produktiviti yang dibawa oleh tugasan automatik. Risiko ini terutamanya berpunca daripada cara AI dilatih, dibina, dihoskan dan digunakan berbeza dalam banyak cara daripada alatan lain yang dipercayai oleh pembangun. Memahami risiko ialah langkah pertama untuk mengurusnya Untuk membantu anda memahami potensi risiko alatan AI, kami telah mereka beberapa soalan temu bual untuk alatan AI. Soalan ini boleh menentukan sama ada alat itu berjaya "menyertai" syarikat anda.

Secara umumnya, semua alatan AI mempunyai persamaan tertentu Tanpa mengira jenis atau tujuan kecerdasan buatan, anda harus bertanya soalan berikut sebelum memilih untuk menggunakannya:

- Di manakah infrastruktur alat AI ini? Tiada satu pun daripada kecerdasan buatan moden memerlukan perkakasan yang berdedikasi dan mahal untuk menyokongnya. Melainkan anda merancang untuk memperoleh pusat data baharu; alatan AI anda hanya akan berfungsi dari jauh dan memerlukan akses jauh dan storan data luar tapak, yang akan mewujudkan risiko keselamatan tertentu.

- Apakah perlindungan yang disediakan untuk mengelakkan kehilangan IP apabila kod meninggalkan sempadan pemprosesan? Daripada TV pintar kepada kereta pintar, semua produk kecerdasan buatan menyumbang data kepada pengeluarnya. Sesetengah perniagaan menggunakan data ini untuk mengoptimumkan perisian mereka, tetapi yang lain menjualnya kepada pengiklan. Oleh itu, anda perlu memahami dengan tepat bagaimana alat AI akan menggunakan atau memproses kod sumber atau data peribadi lain yang digunakan untuk tugas utamanya.

- Bolehkah input anda digunakan untuk tugas latihan model? Latihan berterusan model kecerdasan buatan adalah tugas yang amat membimbangkan semua syarikat model dan jurulatih model. Sebagai contoh, pemilik model selalunya tidak mahu pengiklan terlalu terlibat dalam latihan model mereka untuk mencapai pengiklanan percuma.

- Sejauh manakah ketepatan keputusan? Kelemahan ChatGPT yang paling membawa maut ialah ketidaktepatan keputusannya. Ia cemerlang dalam menghasilkan pembohongan dan kebenaran; ini dipanggil ilusi AI. Memahami cara dan senario di mana kecerdasan buatan boleh membuat kesilapan boleh membantu mengurus apabila alat AI membuat kesilapan.

Selain itu, semua syarikat dan pembangun kecerdasan buatan akan mempunyai siri isu keselamatan mereka sendiri. Kebimbangan baharu ini termasuk ancaman kepada model terlatih AI yang boleh merosakkan keputusan mereka dan membocorkan maklumat proprietari tentang cara model tersebut beroperasi, serta kualiti hasil yang dihasilkan oleh model tersebut. Selain itu, model AI mesti berinteraksi dengan dunia tradisional melalui API, akses web, aplikasi mudah alih dan aplikasi lain yang perlu dibina dengan selamat.

Selain soalan umum, pembangun mesti bertanya aspek lain apabila menggunakan alatan AI, seperti penggunaan pengimbas keselamatan AI, untuk mengurus risiko yang diperkenalkan semasa pembangunan perisian.

- Adakah alatan AI sesuai untuk senario sedemikian? Adalah penting untuk memahami apa yang AI tidak mahir. Sebagai contoh, jika tugas boleh dipecahkan kepada "membuat keputusan berdasarkan peraturan pembelajaran" atau "menulis kandungan yang mengikut peraturan pembelajaran" maka AI biasanya sangat baik dalam tugasan tersebut. Jika masalah berubah melebihi ini, AI mungkin berprestasi buruk.

- Apakah langkah perlindungan yang perlu diambil jika alat AI membuat ralat? Jangan sekali-kali memperkenalkan satu titik kegagalan ke dalam proses anda, terutamanya yang boleh menimbulkan halusinasi. Pendekatan yang disyorkan hendaklah bergantung pada amalan tradisional yang berkaitan dengan pertahanan secara mendalam, atau pendekatan untuk mengurus risiko—idea bahawa jika satu lapisan dalam sistem menimbulkan masalah, lapisan seterusnya juga akan menangkapnya.

- Bagaimanakah hasil alat semakan perlu dipantau? Sebenarnya, ini adalah soalan lama yang dibangkitkan semula. Penyelesaian penangkapan log masalah tradisional biasanya dibahagikan kepada dua bahagian: yang pertama adalah untuk mendapatkan data mengenai peristiwa penting; Sehingga AI semakin matang dan kelemahannya difahami atau dikurangkan, manusia masih perlu mengekalkan kawalan kitaran.

Kini, semakin ramai pembangun "mengupah" ChatGPT untuk menulis kod sumber. Laporan awal menunjukkan bahawa ChatGPT mampu menulis kod sumber dalam berbilang bahasa pengaturcaraan dan fasih dalam semua bahasa biasa. Oleh kerana pengehadan latihan dan model beta semasa, kod yang dihasilkannya tidak selalunya sempurna. Ia selalunya mengandungi kelemahan logik perniagaan yang boleh mengubah cara perisian berjalan, ralat sintaks yang boleh mencampurkan versi perisian yang berbeza dan isu lain yang kelihatan seperti manusia.

Secara kasarnya, ChatGPT hanyalah seorang pengaturcara junior. Jadi, siapa yang akan menjadi atasannya?

Dengan kata lain, ChatGPT ialah peringkat pembangun junior. Oleh itu, apabila bekerja dengan kod yang ditulis oleh pembangun junior ini, anda mesti mempertimbangkan cara mengurusnya:

- Siapa yang akan menjadi atasan mereka untuk memastikan keberkesanan keseluruhan kod yang mereka tulis ? Pembangun muda sering memerlukan bantuan daripada pembangun kanan. Setiap baris kod mesti diuji, dan beberapa mesti diperbaiki. Walau bagaimanapun, laporan menunjukkan bahawa proses membaca pruf ini lebih memakan masa dan kompleks daripada menulis kod dari awal.

- Adakah ia menyuntik atau mencampur semula kod latihan ke dalam pangkalan kod? Ancaman yang lebih berbahaya ialah kadangkala bot AI seperti GitHub Copilot akan menghasilkan kod sumber yang mereplikasi blok kod dengan sempurna daripada data latihan. Oleh itu, alat anti-plagiarisme perlu digunakan untuk memastikan risiko lesen diuruskan.

- Di manakah alatan AI mendapatkan data latihan? Tahap keupayaan model kecerdasan buatan berkait rapat dengan data latihannya. Jika AI dilatih menggunakan kod lama atau salah, maka ia akan menghasilkan keputusan lama dan salah.

- Di manakah enjin dihoskan? Robot AI yang menganalisis kod sumber perlu menyepadukan kod sumber ke dalam peranti pemprosesan yang sepadan. Pertimbangan khusus harus diberikan kepada cara data dilindungi, digunakan dan dilupuskan selepas ia meninggalkan kawalan syarikat.

Dalam apa jua keadaan, keluaran ChatGPT pada Disember 2022 menandakan era baharu pembangunan perisian. Adalah penting untuk memerhatikan perubahan dalam alatan seperti ini dan tidak terpengaruh dengannya. Apabila menggunakan alat baharu ini, sedar bahawa semakin banyak perkara berubah, semakin banyak perkara itu harus kekal sama: Selalunya lebih baik untuk mencegah insiden keselamatan daripada menemuinya.

Pautan asal: https://thenewstack.io/hiring-an-ai-tool-to-code-what-to-ask-at-the-interview/

Atas ialah kandungan terperinci Bagaimana untuk menjalankan temu duga untuk 'mengupah' pengekod ChatGPT?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

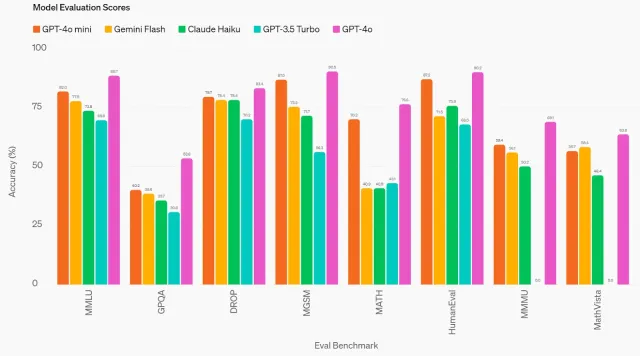

GPT-4O MINI: Bagaimana model terbaru Openai disusun?Apr 19, 2025 am 11:09 AM

GPT-4O MINI: Bagaimana model terbaru Openai disusun?Apr 19, 2025 am 11:09 AMTawaran terbaru OpenAI, GPT-4O Mini, menandakan langkah penting ke arah AI maju yang berpatutan dan boleh diakses. Model bahasa kecil (SLM) ini secara langsung mencabar pesaing seperti Llama 3 dan Gemma 2, yang membanggakan latensi rendah, keberkesanan kos, dan a

Dari Innovator Tech ke Pioneer Penjagaan Kesihatan: Dr. Geetha Manjunath ' s AI StoryApr 19, 2025 am 11:02 AM

Dari Innovator Tech ke Pioneer Penjagaan Kesihatan: Dr. Geetha Manjunath ' s AI StoryApr 19, 2025 am 11:02 AMEpisod ini "Memimpin dengan Data" menampilkan Dr. Geetha Manjunath, pengasas dan Ketua Pegawai Eksekutif Niramai Analytix. Dengan lebih dari 25 tahun pengalaman di AI dan penjagaan kesihatan, Dr. Manjunath, memegang PhD dari Institut Sains India dan MBA FRO

Memudahkan penggunaan LLM tempatan dengan Ollama - Analytics VidhyaApr 19, 2025 am 11:01 AM

Memudahkan penggunaan LLM tempatan dengan Ollama - Analytics VidhyaApr 19, 2025 am 11:01 AMMemanfaatkan kekuatan sumber terbuka LLMS secara tempatan dengan Ollama: Panduan Komprehensif Menjalankan model bahasa yang besar (LLMs) secara tempatan menawarkan kawalan dan ketelusan yang tiada tandingannya, tetapi menubuhkan persekitaran boleh menakutkan. Ollama memudahkan proses ini

Cara menyempurnakan model bahasa yang besar dengan MonsterapiApr 19, 2025 am 10:49 AM

Cara menyempurnakan model bahasa yang besar dengan MonsterapiApr 19, 2025 am 10:49 AMMemanfaatkan kekuatan LLM yang disempurnakan dengan Monsterapi: Panduan Komprehensif Bayangkan pembantu maya dengan sempurna memahami dan menjangkakan keperluan anda. Ini menjadi realiti terima kasih kepada kemajuan dalam model bahasa besar (LLMS). Walau bagaimanapun, a

5 Ujian Statistik Setiap Saintis Data Harus Tahu - Analytics VidhyaApr 19, 2025 am 10:27 AM

5 Ujian Statistik Setiap Saintis Data Harus Tahu - Analytics VidhyaApr 19, 2025 am 10:27 AMUjian Statistik Penting Sains Data: Panduan Komprehensif Membuka pandangan berharga dari data adalah yang paling utama dalam sains data. Menguasai ujian statistik adalah asas untuk mencapai matlamat ini. Ujian ini memberi kuasa kepada saintis data dengan ketat val

Cara Melaksanakan Tugas Penglihatan Komputer dengan Florence -2 - Analytics VidhyaApr 19, 2025 am 10:21 AM

Cara Melaksanakan Tugas Penglihatan Komputer dengan Florence -2 - Analytics VidhyaApr 19, 2025 am 10:21 AMPengenalan Pengenalan Transformers asal membuka jalan bagi model bahasa besar semasa. Begitu juga, selepas pengenalan model Transformer, Pengubah Visi (VIT) diperkenalkan. Seperti

7 Cara untuk Memisahkan Data Menggunakan Splitter Teks Langchain - Analytics VidhyaApr 19, 2025 am 10:11 AM

7 Cara untuk Memisahkan Data Menggunakan Splitter Teks Langchain - Analytics VidhyaApr 19, 2025 am 10:11 AMPemisahan Teks Langchain: mengoptimumkan input LLM untuk kecekapan dan ketepatan Artikel sebelumnya kami meliputi pemuat dokumen Langchain. Walau bagaimanapun, LLM mempunyai batasan saiz tetingkap konteks (diukur dalam token). Melebihi had ini memangkas data, comp

Kursus AI Generatif Percuma: Merintis Masa Depan InovasiApr 19, 2025 am 10:01 AM

Kursus AI Generatif Percuma: Merintis Masa Depan InovasiApr 19, 2025 am 10:01 AMAI Generatif: Merevolusi Kreativiti dan Inovasi Generatif AI sedang mengubah industri dengan mencipta teks, imej, muzik, dan dunia maya pada sentuhan butang. Impaknya merangkumi penyuntingan video, pengeluaran muzik, seni, hiburan, hea

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Dreamweaver Mac版

Alat pembangunan web visual

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.