Rumah >Peranti teknologi >AI >NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap

NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap

- 王林ke hadapan

- 2023-04-12 21:13:072106semak imbas

Serangkaian besar litar aritmetik menguatkan GPU NVIDIA untuk membolehkan pecutan AI, pengkomputeran berprestasi tinggi dan grafik komputer yang belum pernah terjadi sebelumnya. Oleh itu, menambah baik reka bentuk litar aritmetik ini adalah penting untuk meningkatkan prestasi dan kecekapan GPU. Bagaimana jika AI belajar untuk mereka bentuk litar ini? Dalam kertas kerja NVIDIA baru-baru ini, "PrefixRL: Pengoptimuman Litar Awalan Selari menggunakan Pembelajaran Pengukuhan Dalam," penyelidik menunjukkan bahawa AI bukan sahaja boleh mereka bentuk litar ini dari awal, tetapi juga litar yang direka oleh AI adalah lebih baik daripada yang direka oleh negara-of- alat automasi reka bentuk elektronik (EDA) yang paling canggih adalah lebih kecil dan lebih pantas.

Alamat kertas: https://arxiv.org/pdf/2205.07000.pdf

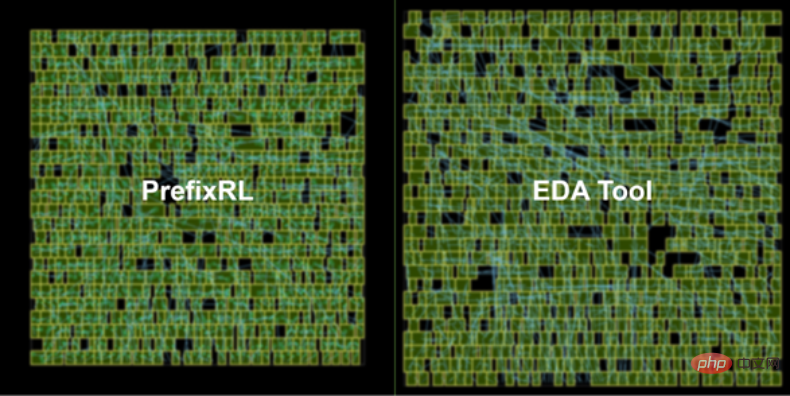

Seni bina GPU NVIDIA Hopper terkini mempunyai hampir 13,000 contoh litar rekaan AI. Rajah 1 di bawah: Litar penambah 64b yang direka oleh PrefixRL AI di sebelah kiri adalah 25% lebih kecil daripada litar yang direka oleh alat EDA paling canggih di sebelah kanan Rajah 1.

Gambaran Keseluruhan Reka Bentuk Litar

Litar aritmetik dalam cip komputer terdiri daripada rangkaian get logik seperti sebagai NAND, NOR dan XOR) dan wayar. Litar yang ideal harus mempunyai sifat berikut:

- Kecil: kawasan yang lebih kecil, lebih banyak litar boleh dibungkus pada cip; Cepat: kependaman rendah, prestasi cip dipertingkatkan;

- penggunaan kuasa yang lebih rendah.

- Dalam kajian NVIDIA ini, penyelidik menumpukan pada kawasan litar dan kependaman. Mereka mendapati bahawa penggunaan kuasa berkait rapat dengan kawasan litar yang diminati. Kawasan litar dan kelewatan selalunya merupakan hartanah yang bersaing, jadi adalah wajar untuk mencari sempadan Pareto untuk reka bentuk yang secara berkesan menukar hartanah ini. Ringkasnya, penyelidik berharap kawasan litar untuk setiap kelewatan dapat diminimumkan.

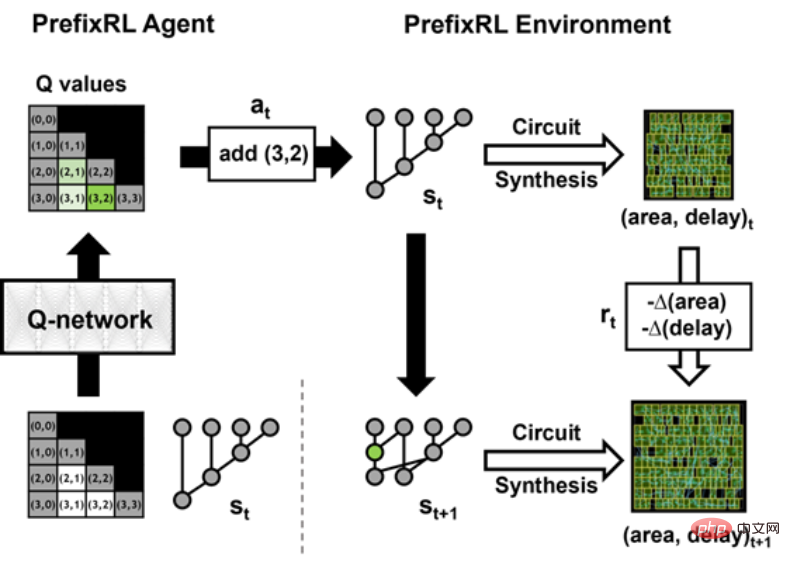

Maka persoalannya ialah: Bolehkah ejen AI mereka bentuk peta awalan yang baik? Ruang keadaan semua graf awalan adalah sangat besar O(2^n^n) dan tidak boleh diterokai menggunakan kaedah kekerasan. Rajah 2 di bawah menunjukkan lelaran PrefixRL dengan contoh litar 4b.

Para penyelidik menggunakan Penjana Litar untuk menukar rajah awalan kepada litar dengan wayar dan get logik. Seterusnya, litar yang dijana ini dioptimumkan melalui alat sintesis fizikal yang menggunakan pengoptimuman sintesis fizikal seperti saiz get, penduaan dan sisipan penimbal.

Disebabkan pengoptimuman sintesis fizik ini, sifat litar akhir (kelewatan, luas dan kuasa) tidak ditukar terus daripada sifat graf awalan asal (seperti tahap dan kiraan nod). Inilah sebabnya mengapa ejen AI belajar untuk mereka bentuk graf awalan tetapi mengoptimumkan sifat litar akhir yang dihasilkan daripada graf awalan.

Penyelidik menganggap aritmetik

reka bentuk litar sebagai tugas pembelajaran tetulang (RL), di mana ejen dilatih untuk mengoptimumkan Kawasan litararitmetik dan sifat kelewatan. Untuk litar awalan, mereka mereka bentuk persekitaran di mana ejen RL boleh menambah atau mengalih keluar nod dalam graf awalan, dan kemudian melakukan langkah berikut: Graf awalan dinormalisasi untuk sentiasa mengekalkan pengiraan jumlah awalan yang betul;

- Hasilkan litar daripada graf awalan ternormal;

- Ukur kawasan dan ciri kelewatan litar.

- Dalam animasi berikut, ejen RL membina graf awalan langkah demi langkah dengan menambah atau memadamkan nod. Pada setiap langkah, ejen diberi ganjaran dengan peningkatan dalam kawasan litar dan kependaman.

-

Imej asal ialah versi interaktif.

Ejen pembelajaran Q konvolusi penuh

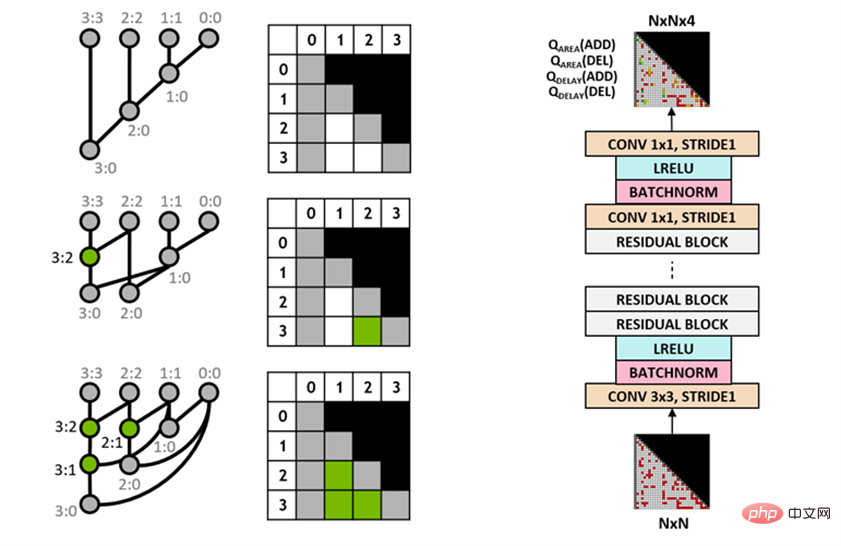

Penyelidik menggunakan algoritma Q-learning (Q-learning) untuk melatih reka bentuk litar ejen. Seperti yang ditunjukkan dalam Rajah 3 di bawah, mereka menguraikan graf awalan menjadi perwakilan grid, di mana setiap elemen dalam grid dipetakan secara unik kepada nod awalan. Grid ini mewakili input dan output yang digunakan untuk rangkaian Q. Setiap elemen dalam grid input mewakili sama ada nod itu wujud atau tidak. Setiap elemen dalam grid output mewakili nilai Q bagi nod yang ditambah atau dialih keluar.

Para penyelidik menggunakan seni bina rangkaian neural konvolusi sepenuhnya kerana input dan output ejen pembelajaran-Q ialah perwakilan grid. Ejen meramalkan nilai Q untuk kawasan dan atribut kelewatan secara berasingan kerana ganjaran untuk kawasan dan kelewatan boleh diperhatikan secara berasingan semasa latihan.

Rajah 3: Perwakilan graf awalan 4b (kiri) dan seni bina ejen pembelajaran Q konvolusi sepenuhnya (kanan).

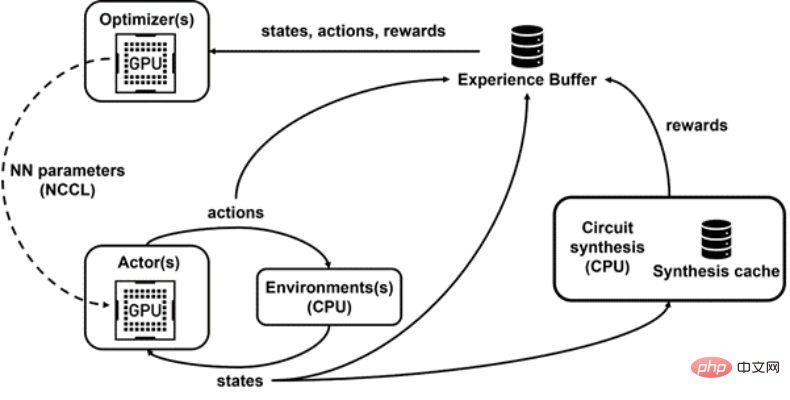

Raptor untuk latihan teragih

PrefixRL memerlukan banyak pengiraan, dalam simulasi fizik, 256 CPU setiap GPU diperlukan dan latihan 64b tugas Lebih 32,000 jam GPU. Kali ini, NVIDIA telah membangunkan platform pembelajaran tetulang teragih dalaman, Raptor, yang menggunakan sepenuhnya kelebihan perkakasan NVIDIA untuk melaksanakan pembelajaran pengukuhan peringkat industri seperti ini (Rajah 4 di bawah).

Raptor mempunyai ciri yang meningkatkan kebolehskalaan dan kelajuan model latihan, seperti penjadualan kerja, rangkaian tersuai dan struktur data sedar GPU. Dalam konteks PrefixRL, Raptor mendayakan peruntukan hibrid merentas CPU, GPU dan Instans Spot. Rangkaian dalam aplikasi pembelajaran pengukuhan ini adalah pelbagai dan mendapat manfaat daripada yang berikut:- Suis Raptor antara NCCL untuk pemindahan model peer-to-peer Parameter dipindahkan terus daripada pelajar GPU kepada GPU inferens;

- Redis untuk mesej tak segerak dan lebih kecil seperti ganjaran atau statistik; mengendalikan permintaan volum tinggi dan kependaman rendah, seperti memuat naik data pengalaman.

- Akhir sekali, Raptor menyediakan struktur data yang menyedari GPU seperti penimbal main semula dengan perkhidmatan berbilang benang untuk menerima pengalaman daripada berbilang pekerja, data kelompok secara selari dan Pramuat pada GPU .

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar. Pengiraan Ganjaran

Para penyelidik menggunakan wajaran tukar ganti w (julat [0,1]) untuk menggabungkan kawasan dan sasaran kelewatan. Mereka melatih pelbagai ejen dengan pemberat yang berbeza untuk mendapatkan sempadan Pareto, dengan itu mengimbangi pertukaran antara kawasan dan kependaman. Pengoptimuman yang disintesis secara fizikal dalam persekitaran RL boleh menjana pelbagai penyelesaian yang menukar kawasan dan kependaman. Penyelidik memacu alat sintesis fizikal menggunakan pemberat tukar ganti yang sama yang digunakan untuk melatih ejen tertentu.Melaksanakan pengoptimuman sintesis fizik dalam gelung pengiraan ganjaran mempunyai kelebihan berikut:

Ejen RL belajar untuk terus mengoptimumkan sifat litar akhir nod teknologi sasaran dan perpustakaan ;- Ejen RL termasuk logik persisian litar algoritma sasaran semasa proses sintesis fizikal, dengan itu mengoptimumkan prestasi litar algoritma sasaran dan logik persisiannya.

- Walau bagaimanapun, melakukan sintesis fizik adalah proses yang perlahan (~35 saat untuk 64b adder), yang boleh melambatkan latihan dan penerokaan RL dengan ketara.

Apabila pekerja CPU mengembalikan ganjaran, peralihan boleh dibenamkan dalam penimbal main semula. Ganjaran komprehensif dicache untuk mengelakkan pengiraan berlebihan apabila keadaan ditemui semula.

Keputusan dan Pandangan

Rajah 5 di bawah menunjukkan kawasan dan kelewatan litar penambah 64b yang direka bentuk menggunakan PrefixRL dan litar penambah yang dikuasai Pareto daripada alatan EDA yang paling canggih.

Penambah PrefixRL terbaik mencapai 25% kurang kawasan daripada penambah alat EDA pada kependaman yang sama. Graf awalan ini dipetakan kepada litar penambah optimum Pareto selepas pengoptimuman sintesis fizikal mempunyai struktur yang tidak teratur. Rajah 5: Litar aritmetik yang direka oleh PrefixRL adalah lebih kecil daripada litar yang direka oleh alat EDA yang canggih dan lebih pantas.

(kiri) seni bina litar; (kanan) sepadan rajah ciri litar penambah 64b Setakat ini seperti yang kita ketahui, ini adalah kaedah pertama untuk menggunakan agen pembelajaran tetulang dalam untuk mereka bentuk litar aritmetik. NVIDIA membayangkan pelan tindakan untuk menggunakan AI kepada masalah reka bentuk litar dunia sebenar, membina ruang tindakan, perwakilan negeri, model ejen RL, mengoptimumkan untuk berbilang matlamat bersaing dan mengatasi pengiraan ganjaran yang perlahan.

Atas ialah kandungan terperinci NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.