Rumah >Peranti teknologi >AI >Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL

Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 20:58:041174semak imbas

Model asas visual telah mencapai perkembangan yang luar biasa dalam tempoh dua tahun yang lalu. Di satu pihak, pra-latihan berdasarkan data Internet berskala besar telah menetapkan sejumlah besar konsep semantik untuk model, dengan itu mempunyai prestasi generalisasi yang baik tetapi sebaliknya, untuk menggunakan sepenuhnya saiz model yang dibawa; oleh set data berskala besar Pertumbuhan menjadikan model berkaitan menghadapi masalah ketidakcekapan apabila berhijrah ke tugas hiliran, terutamanya untuk model pemahaman video yang perlu memproses berbilang bingkai.

- Pautan kertas: https://arxiv.org/abs/2208.03550

- Pautan kod: https://github.com/OpenGVLab/efficient-video-recognition

Berdasarkan dua di atas ciri , penyelidik dari Universiti China Hong Kong, Makmal Kepintaran Buatan Shanghai dan institusi lain mencadangkan rangka kerja pembelajaran pemindahan pemahaman video yang cekap Dengan menetapkan berat model asas tulang belakang, ia menjimatkan pengiraan latihan dan penggunaan memori pada masa yang sama , dengan menggunakan ciri perantaraan berbilang peringkat, berbutir halus mengekalkan fleksibiliti penalaan halus hujung ke hujung tradisional sebanyak mungkin.

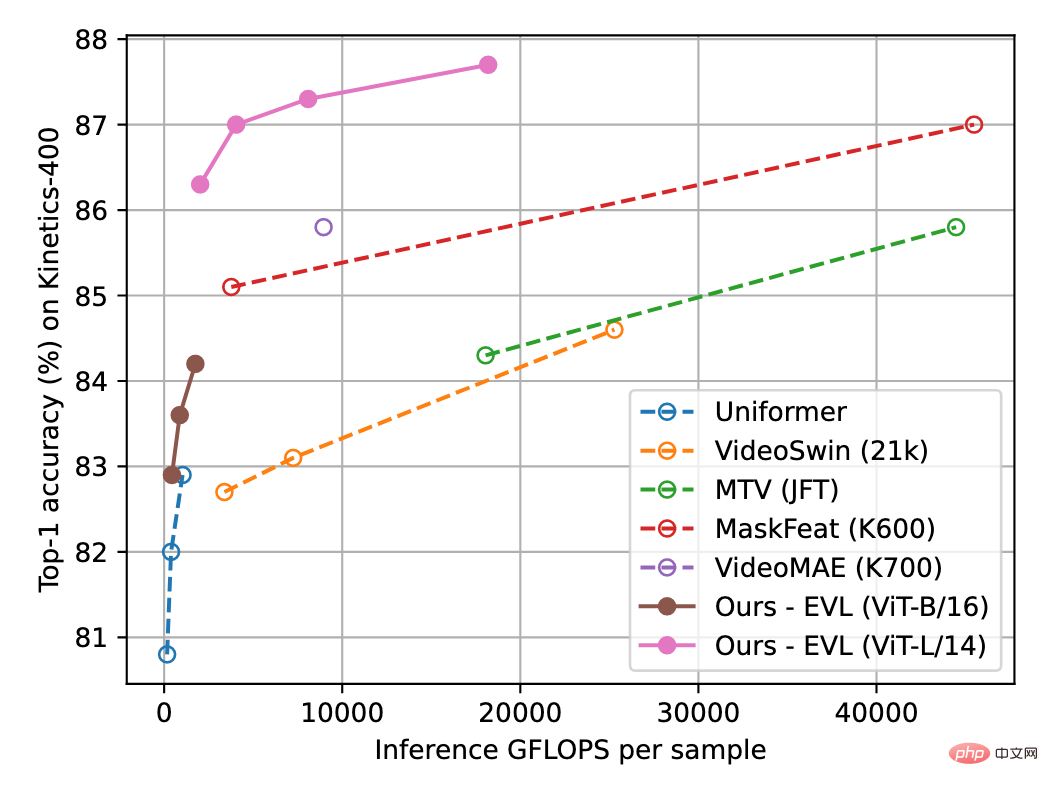

Rajah 1 di bawah menunjukkan keputusan kaedah EVL pada set data pemahaman video Kinetics-400. Eksperimen menunjukkan bahawa semasa menjimatkan overhed latihan, kaedah ini masih meneroka sepenuhnya potensi model visual asas dalam tugas pemahaman video.

Rajah 1: Perbandingan ketepatan pengecaman Kinetik-400 Paksi mendatar ialah jumlah pengiraan inferens dan paksi menegak ialah ketepatan.

Kaedah

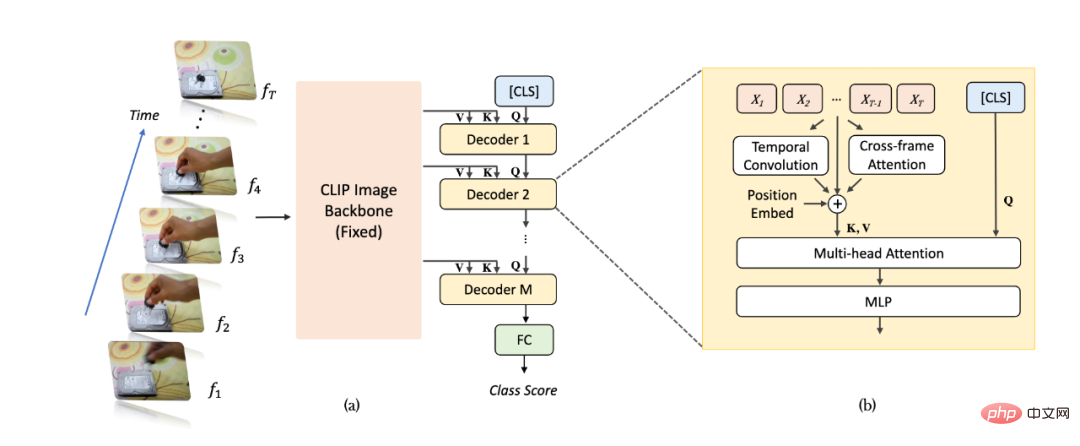

Rajah skematik keseluruhan algoritma ditunjukkan dalam Rajah 2(a). Untuk sampel video, kami mengambil bingkai T dan memasukkannya ke dalam rangkaian pengecaman imej (mengambil CLIP sebagai contoh) dan mengekstrak ciri. Berbanding dengan kaedah tradisional, kami mengekstrak ciri berbilang lapisan yang tidak disatukan daripada beberapa lapisan terakhir rangkaian pengecaman imej untuk mendapatkan maklumat imej yang lebih kaya dan lebih halus dan berat parameter rangkaian pengecaman imej sentiasa konsisten dalam pembelajaran video tetap. Selepas itu, peta ciri berbilang lapisan dimasukkan secara berurutan ke dalam penyahkod Transformer untuk pengagregatan maklumat peringkat video. Ciri [CLS] penyahkod berbilang lapisan digunakan untuk menjana ramalan pengelasan akhir.

Seperti yang ditunjukkan dalam Rajah 2(b), disebabkan gangguan apabila penyahkod Transformer mengagregat ciri, kami menambah modul pemodelan maklumat temporal tambahan pada rangkaian untuk mengekstrak halus berkaitan lokasi dengan lebih baik- maklumat masa berbutir. Khususnya, kami menambah tiga jenis maklumat pemasaan berkaitan kedudukan tambahan: yang pertama ialah benam kedudukan temporal (Pembenaman Kedudukan), yang kedua ialah lilitan boleh dipisahkan dalam dimensi temporal (Depthwise Convolution), dan yang ketiga ialah perhatian antara bingkai bersebelahan memaksa maklumat. Untuk maklumat perhatian antara bingkai, kami mengekstrak ciri Pertanyaan dan Utama lapisan yang sepadan daripada rangkaian pengecaman imej, dan mengira peta perhatian antara bingkai bersebelahan (berbeza daripada rangkaian pengecaman imej, peta perhatian terdiri daripada Pertanyaan daripada bingkai yang sama dan ciri utama diperolehi). Peta perhatian yang terhasil boleh menggambarkan secara eksplisit perubahan kedudukan objek antara bingkai bersebelahan. Selepas unjuran linear, peta perhatian memperoleh kumpulan vektor yang mencerminkan ciri anjakan objek, dan disepadukan ke dalam ciri imej dalam bentuk penambahan unsur demi unsur.

Rajah 2: Gambar rajah struktur algoritma EVL. (a) Struktur keseluruhan, (b) Modul pemodelan maklumat berjujukan. Rajah 3: Perhatian antara bingkai menampilkan ungkapan matematik.

Eksperimen

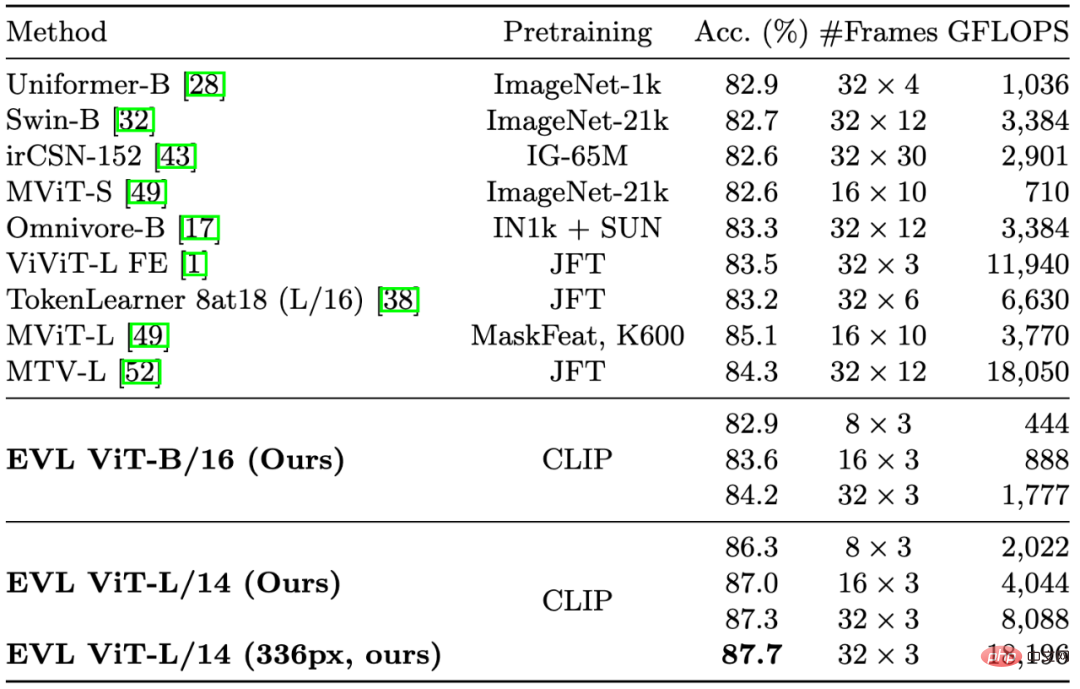

Dalam Rajah 1 dan Jadual 1, kami memetik beberapa kaedah penting dalam pemahaman video sebelumnya. Walaupun memberi tumpuan kepada mengurangkan overhed latihan, kaedah kami masih mengatasi kaedah sedia ada dari segi ketepatan (dengan jumlah pengiraan yang sama).

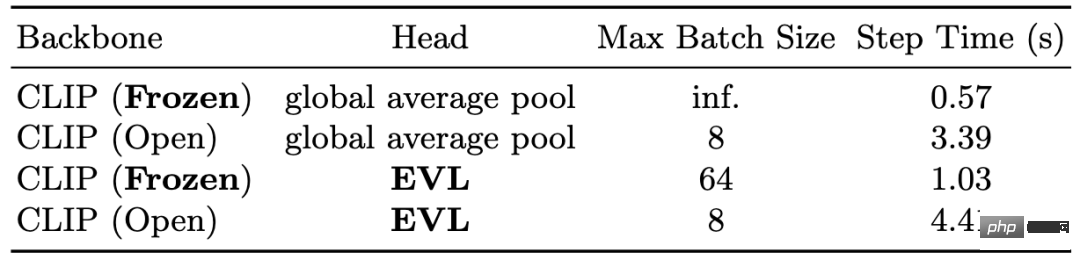

Dalam Jadual 2 kami menunjukkan pengurangan overhed latihan yang dibawa oleh rangkaian tulang belakang tetap. Dari segi memori, pada GPU V100 16GB, rangkaian tulang belakang tetap boleh membolehkan saiz kumpulan kad tunggal mencapai maksimum 64, manakala latihan hujung ke hujung hanya boleh mencapai 8 dari segi masa, tulang belakang tetap rangkaian boleh menjimatkan 3 hingga 4 kali masa latihan.

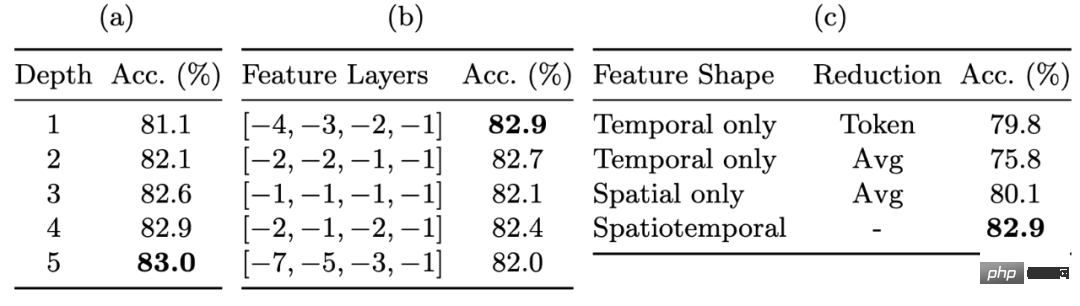

Dalam Jadual 3 kami menunjukkan peningkatan prestasi pengecaman oleh peta ciri berbutir halus. Ciri-ciri tidak terkumpul berbilang lapisan membolehkan kami mengekalkan tahap fleksibiliti yang cukup apabila membetulkan berat rangkaian tulang belakang. Menggunakan ciri yang tidak disatukan membawa peningkatan yang paling ketara (kira-kira 3%), diikuti dengan menggunakan penyahkod berbilang lapisan dan ciri lapisan pertengahan, yang juga membawa kira-kira 1% peningkatan prestasi setiap satu.

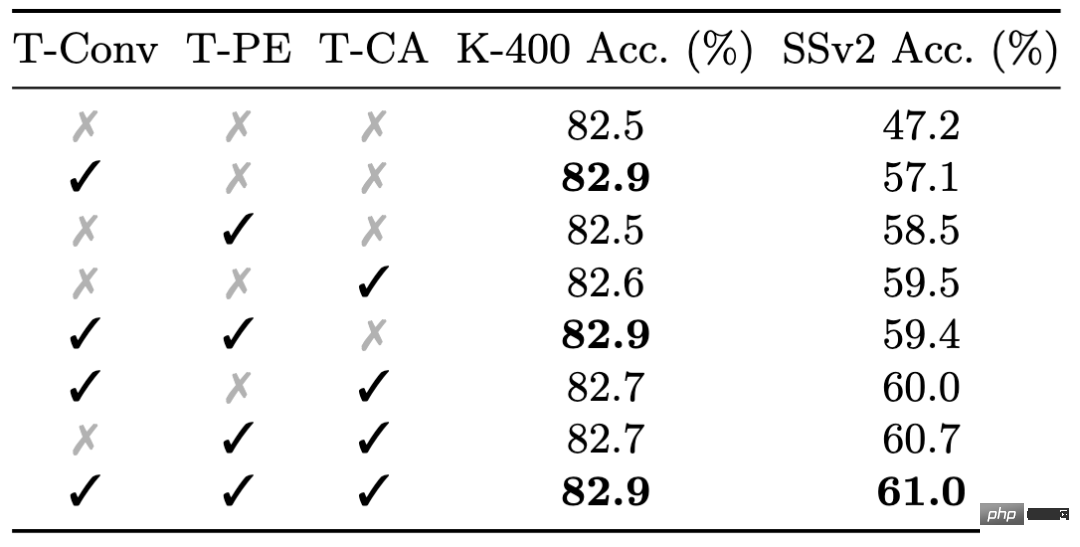

Akhir sekali kami menunjukkan kesan modul maklumat pemasaan yang terperinci dalam Jadual 4. Walaupun maklumat pemasaan yang terperinci mempunyai kesan terhad pada prestasi Kinetics-400, ia sangat penting untuk prestasi Something-Something-v2: tiga modul maklumat pemasaan yang terperinci membawa jumlah kira-kira 0.5% dan kira-kira 14 % peningkatan prestasi.

Jadual 1: Hasil perbandingan dengan kaedah sedia ada pada Kinetics-400

Jadual 2: Mengurangkan overhed latihan yang disebabkan oleh berat rangkaian tulang belakang tetap

Jadual 3: Kesan peta ciri berbutir halus pada ketepatan

Jadual 4: Kesan pemodelan maklumat siri masa yang terperinci pada set data yang berbeza

Ringkasan

Kertas kerja ini mencadangkan rangka kerja pembelajaran pemahaman video EVL, yang buat pertama kalinya menunjukkan potensi besar rangkaian tulang belakang imej tetap dalam masalah pemahaman video, dan juga menjadikan pemahaman video berprestasi tinggi lebih mesra kepada kumpulan penyelidik dengan pengkomputeran terhad sumber. Kami juga percaya bahawa apabila kualiti dan skala model visual asas bertambah baik, kaedah kami boleh memberikan rujukan untuk penyelidikan seterusnya tentang algoritma pembelajaran pemindahan ringan.

Atas ialah kandungan terperinci Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI