Rumah >Peranti teknologi >AI >Kejayaan baharu dalam makmal HCP Universiti Sun Yat-sen: menggunakan paradigma kausal untuk menaik taraf model besar berbilang modal

Kejayaan baharu dalam makmal HCP Universiti Sun Yat-sen: menggunakan paradigma kausal untuk menaik taraf model besar berbilang modal

- 王林ke hadapan

- 2023-04-12 20:49:021778semak imbas

Makmal Penumpuan Kecerdasan Manusia-Komputer (HCP) Universiti Sun Yat-sen telah membuat pencapaian yang memberangsangkan dalam AIGC dan model besar berbilang modal Dalam AAAAI 2023 dan CVPR 2023 baru-baru ini, ia telah dipilih untuk lebih daripada sepuluh. artikel, kedudukan dalam kalangan institusi penyelidikan global yang pertama.

Salah satu kerja melaksanakan penggunaan model kausal untuk meningkatkan dengan ketara kebolehkawalan dan generalisasi model besar berbilang mod dalam penalaan - "Imej Bertopeng Adalah Sampel Counterfaktual untuk" Teguh Halus- penalaan".

Pautan: https://arxiv.org/abs/2303.03052

Menggunakan model berskala besar yang telah dilatih untuk memperhalusi tugas hiliran ialah paradigma pembelajaran mendalam yang popular pada masa ini. Khususnya, prestasi cemerlang ChatGPT baru-baru ini, model bahasa pra-latihan yang besar, telah menjadikan paradigma teknikal ini diiktiraf secara meluas. Selepas pra-latihan dengan data besar-besaran, model pra-latihan besar ini boleh menyesuaikan diri dengan perubahan pengedaran data dalam persekitaran sebenar, dan oleh itu menunjukkan keteguhan yang kukuh dalam senario umum.

Walau bagaimanapun, apabila model besar yang telah dilatih diperhalusi dengan data pemandangan hiliran untuk menyesuaikan diri dengan tugas aplikasi tertentu, dalam kebanyakan kes, data ini adalah tunggal. Menggunakan data ini untuk memperhalusi model besar yang telah dilatih selalunya akan mengurangkan keteguhan model, menjadikannya sukar untuk digunakan berdasarkan model besar yang telah dilatih. Terutama dari segi model visual, memandangkan kepelbagaian imej jauh melebihi bahasa, masalah latihan penalaan halus hiliran yang membawa kepada penurunan keteguhan model besar pra-latihan berkaitan penglihatan amat ketara.

Kaedah penyelidikan terdahulu biasanya mengekalkan keteguhan model pra-latihan yang diperhalusi secara tersirat pada peringkat parameter model melalui penyepaduan model dan kaedah lain. Walau bagaimanapun, kerja-kerja ini tidak menganalisis sebab penting mengapa penalaan halus membawa kepada kemerosotan prestasi model di luar pengedaran, dan ia juga tidak menyelesaikan masalah kekukuhan yang dinyatakan di atas dengan jelas selepas penalaan halus model besar.

Kerja ini adalah berdasarkan model besar rentas modal, dan menganalisis sebab-sebab penting untuk kehilangan keteguhan model besar yang telah dilatih dari perspektif kausalitas, dan dengan itu mencadangkan kaedah yang boleh Kaedah latihan penalaan halus yang meningkatkan keteguhan model dengan ketara. Kaedah ini membolehkan model mengekalkan keteguhan yang kukuh sambil menyesuaikan diri dengan tugas hiliran, dan lebih memenuhi keperluan aplikasi praktikal.

Ambil model besar pralatihan silang CLIP (Pralatihan Bahasa–Imej Kontrastif) yang dikeluarkan oleh OpenAI pada tahun 2021 sebagai contoh: CLIP ialah teks imej berasaskan kontras kesatuan Model besar pra-latihan silang modal yang dipelajari adalah asas untuk model generatif seperti Resapan Stabil. Model ini dilatih mengenai data berbilang sumber besar-besaran yang mengandungi kira-kira 400 juta pasangan teks imej, dan mempelajari beberapa hubungan sebab akibat yang teguh kepada perubahan pengedaran pada tahap tertentu.

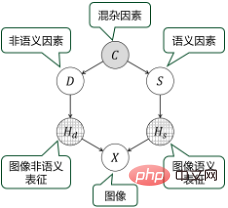

Walau bagaimanapun, apabila memperhalusi CLIP dengan data hiliran ciri tunggal, adalah mudah untuk memusnahkan pengetahuan sebab yang dipelajari oleh model, kerana perwakilan bukan semantik dan perwakilan semantik bagi imej latihan sangat terjerat. Contohnya, apabila menggunakan pemindahan model CLIP kepada senario hiliran "ladang", banyak imej latihan menunjukkan "lembu" di rumput. Pada ketika ini, latihan penalaan halus mungkin membenarkan model belajar bergantung pada perwakilan semantik bukan "lembu" rumput untuk meramalkan semantik imej. Walau bagaimanapun, korelasi ini tidak semestinya benar, contohnya "lembu" mungkin juga muncul di jalan raya. Oleh itu, selepas model diperhalusi dan dilatih, kekukuhannya akan berkurangan, dan hasil keluaran semasa aplikasi mungkin menjadi sangat tidak stabil dan kurang dikawal.

Berdasarkan pengalaman bertahun-tahun pasukan dalam membina dan melatih model besar, kerja ini mengkaji semula masalah pengurangan kekukuhan yang disebabkan oleh penalaan halus model pra-latihan dari perspektif sebab musabab. Berdasarkan pemodelan dan analisis sebab akibat, kerja ini mencadangkan kaedah latihan penalaan halus yang membina sampel kontrafaktual berdasarkan topeng imej dan meningkatkan keteguhan model melalui pembelajaran imej topeng.

Khususnya, untuk memecahkan korelasi palsu dalam imej latihan hiliran, kerja ini mencadangkan kaedah berasaskan peta pengaktifan kelas (CAM) untuk menutup dan menggantikan kandungan kawasan tertentu imej , digunakan untuk memanipulasi perwakilan bukan semantik atau perwakilan semantik imej untuk menjana sampel kontrafaktual. Model yang diperhalusi boleh belajar untuk meniru perwakilan sampel kontrafaktual ini oleh model pra-latihan melalui penyulingan, dengan itu menyahgandingkan pengaruh faktor semantik dan faktor bukan semantik dengan lebih baik, dan meningkatkan kebolehsuaian kepada anjakan pengedaran dalam bidang hiliran.

Eksperimen menunjukkan bahawa kaedah ini boleh meningkatkan prestasi model pra-latihan dengan ketara dalam tugas hiliran, sambil meningkatkan keteguhan berbanding dengan yang sedia ada. kaedah latihan penalaan untuk model besar mempunyai kelebihan yang ketara.

Kepentingan penting kerja ini adalah untuk membuka "kotak hitam" yang diwarisi oleh model besar yang telah dilatih daripada paradigma pembelajaran mendalam pada tahap tertentu, dan untuk menyelesaikan "kebolehtafsiran" model besar dan isu "kebolehkawalan", membawa kami lebih dekat dan lebih dekat kepada peningkatan produktiviti ketara yang diterajui oleh model besar yang telah dilatih.

Sejak kemunculan mekanisme Transformer, pasukan HCP Universiti Sun Yat-sen telah terlibat dalam penyelidikan tentang paradigma teknologi model besar selama bertahun-tahun. Ia komited untuk menambah baik latihan kecekapan model besar dan memperkenalkan model kausal untuk menyelesaikan "kebolehkawalan" isu "seks". Selama bertahun-tahun, pasukan itu telah menyelidik dan membangunkan berbilang model pra-latihan yang besar untuk penglihatan, bahasa, pertuturan dan rentas modal Model besar silang "Wukong" yang dibangunkan bersama dengan Makmal Noah's Ark Huawei (pautan: https:/. /arxiv .org/abs/2202.06767) ialah kes biasa.

Pengenalan Pasukan

Makmal Gabungan Perisikan Manusia-Komputer Universiti Sun Yat-sen (HCP Lab) terlibat dalam pengiktirafan pelbagai mod Ia menjalankan penyelidikan sistematik dalam bidang pengkomputeran pintar, robotik dan sistem terbenam, manusia metaverse dan digital, dan penjanaan kandungan yang boleh dikawal, dan menjalankan senario aplikasi yang mendalam untuk mencipta prototaip produk, mengeluarkan sejumlah besar teknologi asal, dan mengeram pasukan keusahawanan. Makmal ini diasaskan pada tahun 2010 oleh Profesor Lin Liang, Felo IAPR Ia telah memenangi hadiah pertama Anugerah Sains dan Teknologi Persatuan Imej dan Grafik China, Anugerah Sains Semula Jadi Wu Wenjun, hadiah pertama sains semula jadi wilayah dan penghormatan lain; ia telah melatih bakat muda peringkat kebangsaan seperti Liang Xiaodan dan Wang Keze.

Atas ialah kandungan terperinci Kejayaan baharu dalam makmal HCP Universiti Sun Yat-sen: menggunakan paradigma kausal untuk menaik taraf model besar berbilang modal. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI