Rumah >Peranti teknologi >AI >Google adalah yang pertama mengeluarkan AIGC generasi video, netizen: anda boleh menyesuaikan filem

Google adalah yang pertama mengeluarkan AIGC generasi video, netizen: anda boleh menyesuaikan filem

- PHPzke hadapan

- 2023-04-12 20:10:121629semak imbas

Kami tahu bahawa kemajuan dalam model generatif dan model bahasa visual multimodal telah membuka jalan kepada model teks-ke-imej berskala besar dengan realisme dan kepelbagaian generatif yang belum pernah berlaku sebelum ini. Model ini menawarkan proses kreatif baharu, tetapi terhad kepada penggubahan imej baharu dan bukannya mengedit imej sedia ada. Untuk merapatkan jurang ini, kaedah penyuntingan berasaskan teks intuitif membolehkan pengeditan berasaskan teks bagi imej yang dijana dan sebenar serta mengekalkan beberapa sifat asal imej ini. Sama seperti imej, banyak model teks-ke-video telah dicadangkan baru-baru ini, tetapi terdapat beberapa kaedah yang menggunakan model ini untuk penyuntingan video.

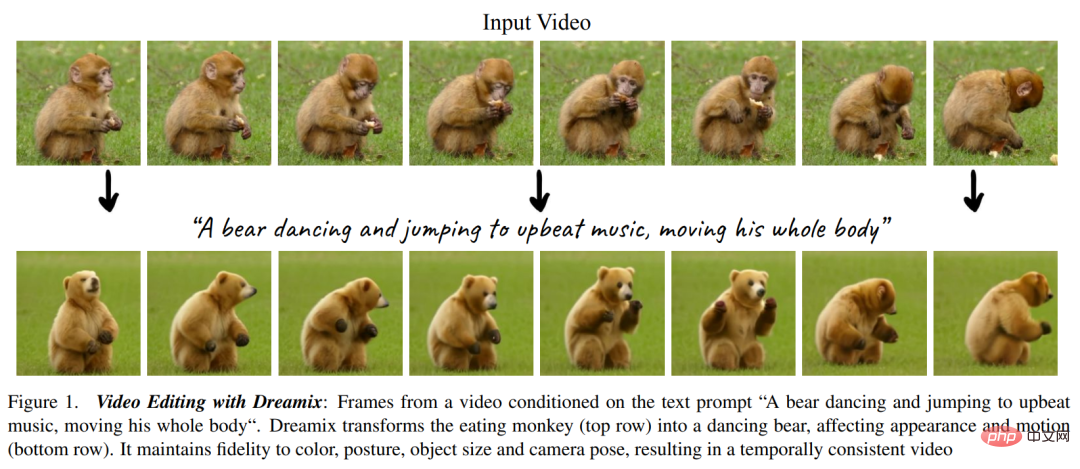

Dalam penyuntingan video berpandukan teks, pengguna menyediakan video input serta gesaan teks yang menerangkan sifat jangkaan video yang dijana, seperti ditunjukkan dalam Rajah 1 di bawah. Matlamat mempunyai tiga aspek berikut, 1) Penjajaran, video yang diedit harus mematuhi gesaan teks input 2) Kesetiaan, video yang diedit harus mengekalkan kandungan video asal, 3) Kualiti, video yang diedit harus mempunyai kualiti yang tinggi; .

Seperti yang anda lihat, Penyuntingan video adalah lebih mencabar daripada penyuntingan imej, ia memerlukan mensintesis tindakan baharu dan bukannya mengubah suai rupa visual . Terdapat juga keperluan untuk mengekalkan konsistensi temporal. Oleh itu, menggunakan kaedah penyuntingan peringkat imej seperti SDEdit dan Prompt-to-Prompt pada bingkai video tidak mencukupi untuk mencapai hasil yang baik.

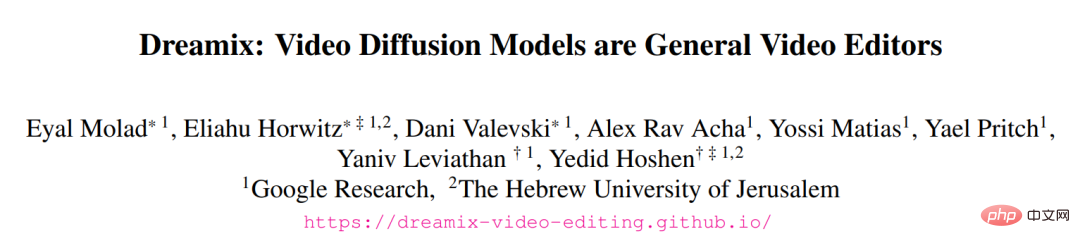

Dalam kertas kerja baru-baru ini yang diterbitkan oleh Google Research dan lain-lain di arXiv, Penyelidik mencadangkan kaedah baharu, Dreamix, yang diilhamkan oleh UniTune dan menggunakan model penyebaran video bersyarat (VDM) teks pada penyuntingan video.

- Alamat kertas: https://arxiv.org/ pdf/2302.01329.pdf

- Laman utama projek: https://dreamix-video-editing.github.io/

Inti kaedah dalam artikel ini adalah untuk menjadikan VDM bersyarat teks mengekalkan kesetiaan tinggi kepada video input melalui dua idea utama berikut . Seseorang tidak menggunakan hingar tulen sebagai permulaan model, tetapi menggunakan versi video asal yang diturunkan taraf untuk mengekalkan hanya maklumat spatiotemporal yang rendah dengan mengurangkan saiz dan menambah hingar yang lain adalah untuk meningkatkan lagi kesetiaan video asal dengan menala halus model generatif pada video asal Belanja.

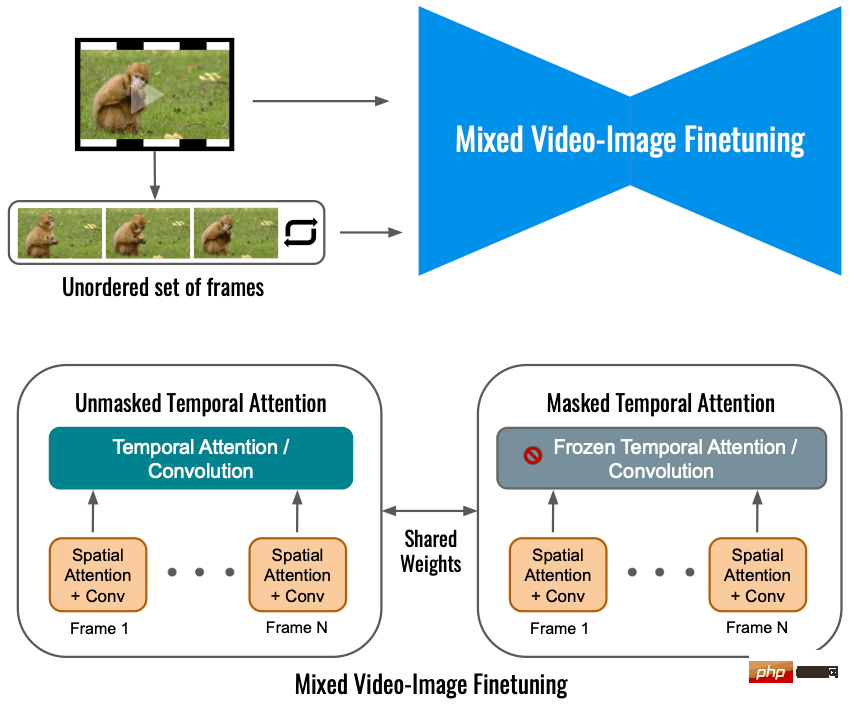

Penalaan halus memastikan model memahami sifat resolusi tinggi video asal. Penalaan halus mudah bagi video input menyumbang kepada kebolehsuntingan gerakan yang agak rendah kerana model belajar untuk memilih gerakan mentah dan bukannya mengikut gesaan teks. Kami mencadangkan kaedah penalaan halus hibrid baru yang mana VDM juga diperhalusi pada set bingkai individu video input dan membuang masanya. Campurkan penalaan halus meningkatkan kualiti penyuntingan gerakan dengan ketara.

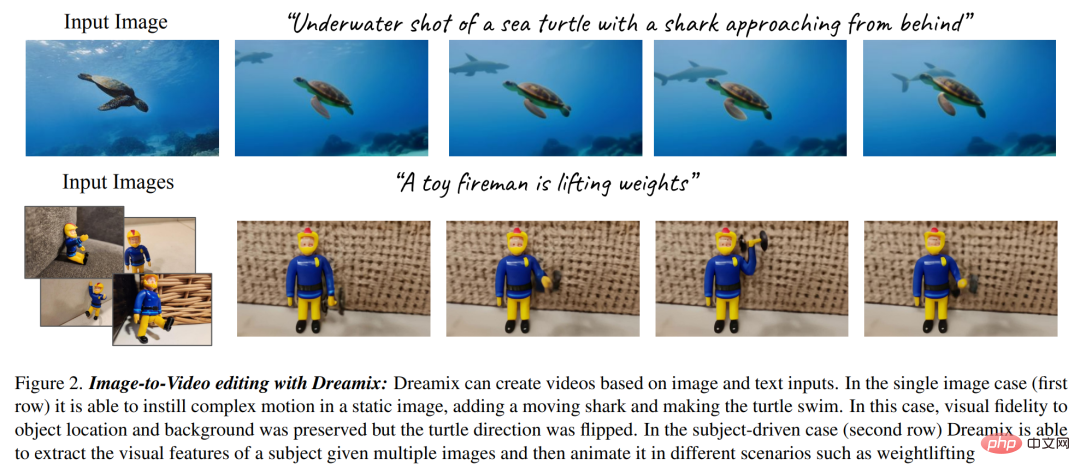

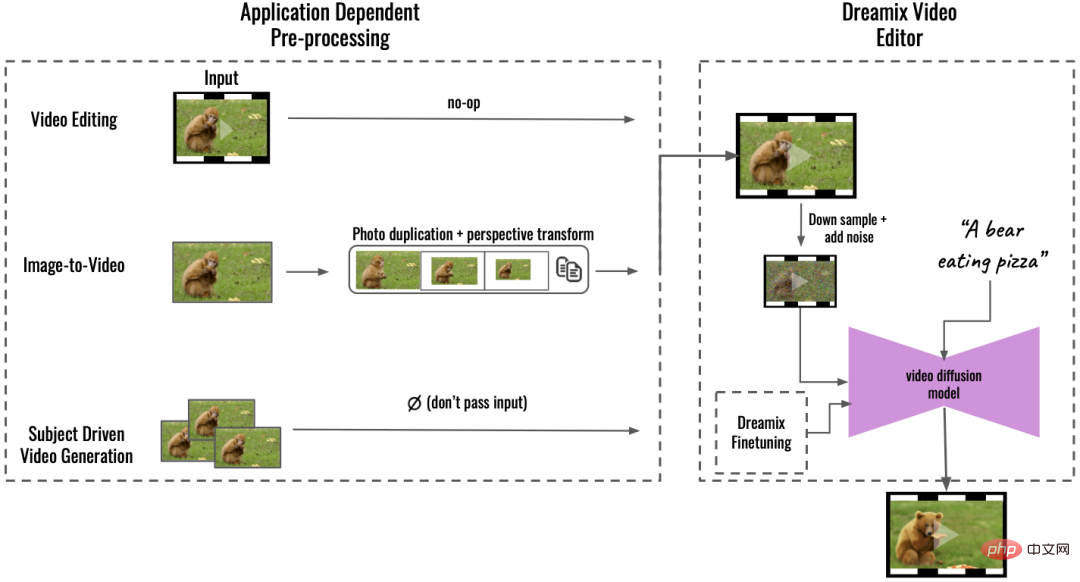

Para penyelidik selanjutnya menggunakan model penyuntingan video mereka untuk mencadangkan rangka kerja animasi imej baharu , seperti ditunjukkan dalam Rajah 2 di bawah. Rangka kerja ini terdiri daripada beberapa langkah, seperti menganimasikan objek dan latar belakang dalam imej, mencipta pergerakan kamera dinamik dan banyak lagi. Mereka melakukan ini melalui operasi pemprosesan imej mudah seperti penyalinan bingkai atau transformasi imej geometri, mencipta video kasar. Kemudian gunakan editor video Dreamix untuk mengedit video. Di samping itu, penyelidik juga menggunakan kaedah penalaan halus mereka untuk penjanaan video dipacu matlamat, iaitu versi video Dreambooth.

Dalam bahagian paparan eksperimen, penyelidik menjalankan penyelidikan kualitatif yang meluas dan penilaian manual, Menunjukkan keupayaan berkuasa kaedah mereka, sila rujuk animasi berikut untuk butiran.

Untuk kajian Google ini, sesetengah orang mengatakan bahawa 3D + gerakan dan penyuntingan Alat mungkin menjadi topik hangat untuk gelombang kertas seterusnya.

Orang lain berkata: Anda boleh membuat filem sendiri mengikut bajet tidak lama lagi, yang anda perlukan hanyalah skrin hijau dan teknologi ini:

Ikhtisar Kaedah

Artikel ini mencadangkan kaedah baharu untuk penyuntingan video, khususnya :

Penyuntingan video berpandukan teks oleh video yang dimusnahkan kejuruteraan terbalik

Mereka menggunakan VDM (Model Penyebaran Video) berlatarkan, mula-mula memusnahkan video input pada tahap tertentu melalui pensampelan rendah, dan kemudian tambah bunyi. Seterusnya model resapan lata digunakan untuk proses pensampelan dan bersyarat pada masa t untuk meningkatkan skala video kepada resolusi temporal-ruang terakhir.

Dalam proses memusnahkan video input, anda perlu melakukan operasi pensampelan turun dahulu untuk mendapatkan model asas (16 bingkai 24 × 40), dan kemudian tambahkan varians ialah  hingar Gaussian, seterusnya merosakkan video input.

hingar Gaussian, seterusnya merosakkan video input.

Untuk video yang diproses di atas, langkah seterusnya ialah menggunakan VDM berlatarkan untuk memetakan video resolusi rendah yang rosak kepada video resolusi tinggi yang sejajar dengan teks . Idea teras di sini ialah memandangkan video resolusi temporal dan spatial yang bising, sangat rendah, terdapat banyak video resolusi tinggi yang boleh dilaksanakan dengan sempurna yang sepadan dengannya. Model asas dalam kertas ini bermula daripada video yang rosak, yang mempunyai bunyi yang sama seperti proses resapan pada masa s. Kajian itu kemudiannya menggunakan VDM untuk membalikkan proses resapan sehingga masa 0. Akhirnya, video itu dinaik taraf melalui model resolusi super.

Penalaan halus imej video hibrid

Penalaan halus model penyebaran video menggunakan hanya video input akan mengehadkan pergerakan objek berubah, Sebaliknya, kajian ini menggunakan sasaran hibrid, iaitu, sebagai tambahan kepada sasaran asal (sudut kiri bawah), kertas ini juga melakukan penalaan halus pada set bingkai yang tidak teratur Ini dilakukan melalui "masked temporal perhatian" untuk mengelakkan perhatian temporal. Daya dan belitan ditala dengan halus (kanan bawah). Operasi ini membolehkan menambah gerakan pada video statik.

Penaakulan

dalam apl Berdasarkan pra-pemprosesan (Pra-pemprosesan Bergantung Aplikasi, ditinggalkan dalam rajah di bawah), penyelidikan ini menyokong pelbagai aplikasi dan boleh menukar kandungan input ke dalam format video bersatu. Untuk imej-ke-video, imej input disalin dan diubah, mensintesis video kasar dengan beberapa gerakan kamera untuk penjanaan video dipacu objek, inputnya ditinggalkan dan diperhalusi secara berasingan untuk mengekalkan kesetiaan. Video kasar ini kemudiannya disunting menggunakan Editor Video Dreamix (kanan): seperti yang dinyatakan sebelum ini, video pertama kali dimusnahkan dengan pensampelan rendah, menambah bunyi. Model penyebaran video berpandukan teks yang diperhalusi kemudiannya digunakan untuk meningkatkan skala video kepada resolusi temporal dan spatial terakhirnya.

Penyuntingan video: Dalam gambar di bawah, Dreamix menukar aksi kepada menari, dan penampilan berubah daripada monyet kepada beruang, Tetapi sifat asas subjek dalam video tidak berubah:

Imej ke video: Apabila input ialah imej, Dreamix boleh menambah objek bergerak baharu menggunakan videonya sebelum ini , seperti berikut Seekor unicorn muncul dalam hutan berkabus dan dizum masuk.

Penguin muncul di sebelah pondok:

Penjanaan video dipacu matlamat: Dreamix juga boleh mengambil koleksi imej yang menunjukkan subjek yang sama dan menjana video baharu dengan subjek itu sebagai objek bergerak. Gambar di bawah menunjukkan seekor ulat menggeliat di atas daun:

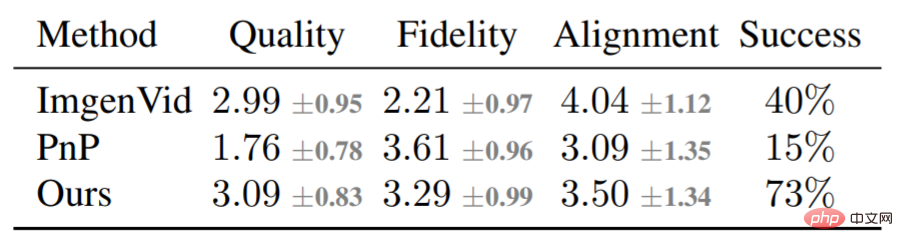

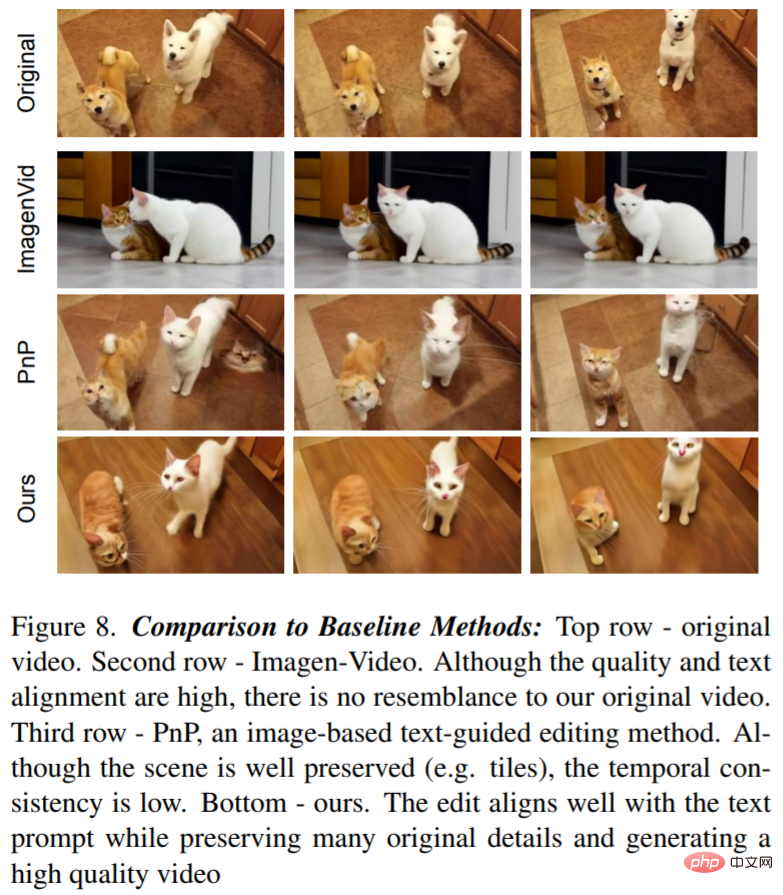

Selain analisis kualitatif, kajian itu juga menjalankan perbandingan garis dasar, terutamanya menggunakan Dreamix Compare with dua kaedah asas: Imagen-Video dan Plug-and-Play (PnP). Jadual berikut menunjukkan keputusan pemarkahan:

Rajah 8 menunjukkan video yang disunting oleh Dreamix dan dua contoh asas: teks kepada Model video mendayakan pengeditan kesetiaan rendah kerana ia tidak dikondisikan pada video asal. PnP mengekalkan pemandangan tetapi kurang konsisten dari bingkai ke bingkai Dreamix berprestasi baik pada ketiga-tiga gol.

Sila rujuk kertas asal untuk butiran lanjut teknikal.

Atas ialah kandungan terperinci Google adalah yang pertama mengeluarkan AIGC generasi video, netizen: anda boleh menyesuaikan filem. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI