Rumah >Peranti teknologi >AI >Berbanding dengan model generatif, mengapa penyelidikan robotik masih menggunakan kaedah lama yang sama dari beberapa tahun lalu?

Berbanding dengan model generatif, mengapa penyelidikan robotik masih menggunakan kaedah lama yang sama dari beberapa tahun lalu?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 19:04:22959semak imbas

Kemajuan yang luar biasa telah dicapai dalam bidang robotik, dan kemajuan ini menunjukkan bahawa robot boleh melakukan lebih banyak perkara pada masa hadapan. Tetapi ada juga perkara yang merisaukan, kerana jika dibandingkan dengan model generatif, kemajuan robot masih agak ketinggalan, terutamanya dengan kemunculan model seperti GPT-3, jurang ini lebih ketara.

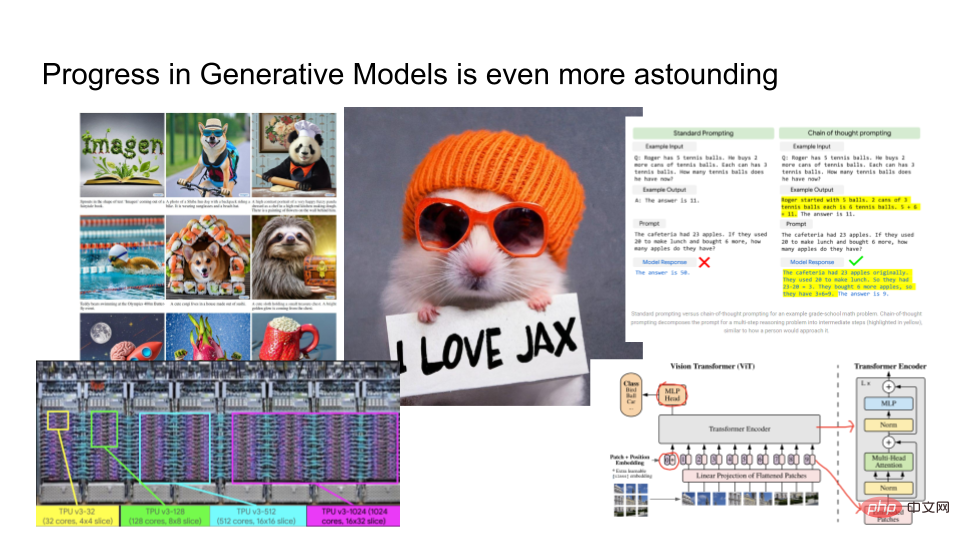

Hasil yang dihasilkan oleh model generatif adalah sangat baik. Bahagian kiri gambar di atas adalah hasil output Imagen yang dilancarkan oleh Google. Anda boleh menyediakannya dengan sekeping teks, seperti "Seekor hamster memakai topi oren dan memegang sehelai kertas mengatakan saya suka JAX Berdasarkan teks yang diberikan, Imagen akan menghasilkan imej yang munasabah. Di samping itu, Google juga melatih model bahasa besar PaLM, yang boleh digunakan untuk menjelaskan mengapa jenaka lucu dan sebagainya. Mereka melatih model dengan perkakasan canggih seperti TPUv4, dan dalam bidang penglihatan komputer, penyelidik sedang membangunkan beberapa seni bina yang sangat kompleks seperti Vision Transformers.

Model generatif berkembang dengan begitu pesat Berbanding dengan robotik, apakah kaitan antara kedua-duanya?

Dalam artikel ini, Eric Jang, Naib Presiden AI dari syarikat robotik Norway "Halodi Robotics" memperkenalkan "Bagaimanakah kita membuat robot lebih seperti model generatif?" 》. Berikut adalah kandungan utama artikel tersebut.

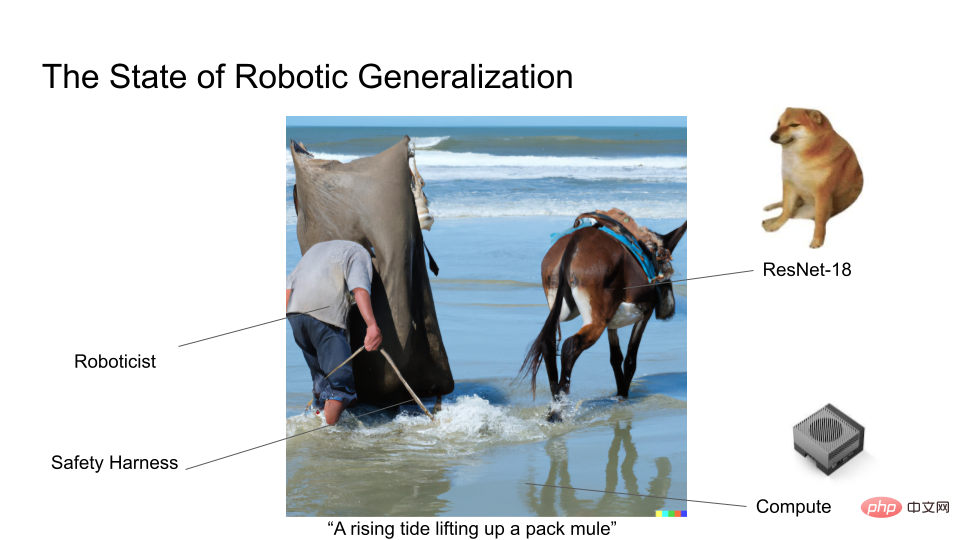

Sebagai pakar dalam bidang robotik, kemajuan dalam bidang model generatif agak dicemburui. Kerana dalam bidang robotik, kebanyakan penyelidik mungkin masih menggunakan ResNet18, seni bina pembelajaran mendalam berusia 7 tahun. Kami sememangnya tidak melatih model pada set data yang besar seperti model generatif, jadi sangat sedikit usaha penyelidikan robotik menjadi tajuk utama.

Kami tahu Moravec’s Paradox: Berbanding dengan tugasan kognitif, sukar untuk memanipulasi robot secara fleksibel Nampaknya operasi membenarkan robot mengambil dan mengangkut objek adalah sukar. t kelihatan mengagumkan seperti menukar perkataan menjadi imej atau menerangkan jenaka.

Mula-mula kita mentakrifkan model generatif. Model generatif adalah lebih daripada sekadar memaparkan imej atau menjana rim teks. Ia juga merupakan rangka kerja yang boleh kita gunakan untuk memahami semua pembelajaran mesin kebarangkalian. Terdapat dua soalan teras dalam model generatif:

1. Berapa bit terdapat dalam kategori data?

2. Sejauh manakah anda boleh membina model?

Pada tahun 2012, AlexNet mencapai kejayaan yang boleh meramalkan 1000 kategori, dan Log2 (1000 kelas) ialah kira-kira 10 bit kelas. Anda boleh menganggap AlexNet sebagai model generatif berasaskan imej yang mengandungi 10 bit maklumat. Jika anda menaik taraf kesukaran tugas pemodelan kepada tugas sari kata MS-CoCo, model tersebut mengandungi lebih kurang 100 bit maklumat. Jika anda melakukan penjanaan imej, contohnya dari teks ke imej menggunakan DALLE atau Imagen, ini mengandungi lebih kurang 1000bit maklumat.

Biasanya semakin banyak kategori yang dimodelkan, semakin banyak kuasa pengkomputeran diperlukan untuk mengira kebarangkalian bersyarat yang terkandung di dalamnya. Inilah sebabnya mengapa model akan berubah apabila bilangan kategori semakin besar. Semasa kami melatih model yang lebih besar dan lebih besar, anda boleh mengeksploitasi ciri dalam data supaya struktur yang lebih kaya boleh dipelajari. Inilah sebabnya mengapa model generatif dan pembelajaran penyeliaan kendiri telah menjadi kaedah popular untuk melaksanakan pembelajaran mendalam pada jumlah input yang besar tanpa memerlukan pelabelan manusia yang meluas.

Rich Sutton menegaskan dalam artikelnya "The Bitter Lesson": Kebanyakan kemajuan dalam kecerdasan buatan nampaknya telah dibuat dalam ledakan pengkomputeran ini, sementara terdapat sedikit perkembangan dalam aspek lain. Algoritma Vision, NLP, dan LeCake Yann LeCun semuanya mendapat manfaat daripada ledakan pengkomputeran ini.

Apakah pencerahan yang diberikan oleh aliran ini kepada kita? Jika anda mempunyai model terparameter yang boleh mengendalikan lebih banyak data, dan model itu boleh menangkap semua ciri dalam rangkaian, ditambah dengan kuasa pengkomputeran yang kuat dan matlamat latihan, pembelajaran mendalam hampir selalu boleh dilaksanakan.

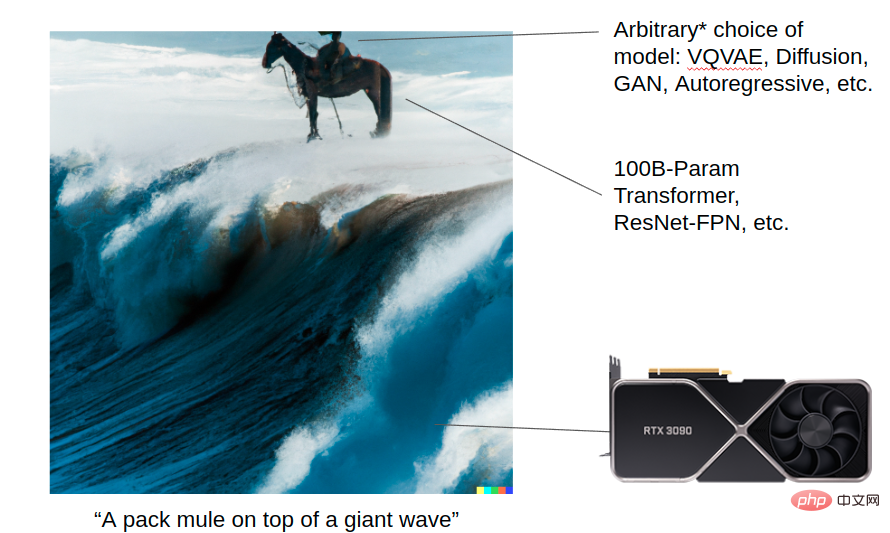

Biar DALL-E 2 menjana imej: keldai menunggang ombak besar Imej ini menunjukkan cara model generatif boleh mencapai hasil yang luar biasa dengan bantuan ledakan pengkomputeran. Anda mempunyai kuasa pengkomputeran yang berkuasa (transformer, Resnet, dll.), dan anda boleh memilih VQVAE, Diffusion, GAN, Autoregressive dan algoritma lain untuk pemodelan. Butiran setiap algoritma adalah penting hari ini, tetapi ia mungkin tidak penting pada masa hadapan apabila komputer menjadi cukup berkuasa. Tetapi dalam jangka panjang, skala model dan seni bina yang baik adalah asas untuk semua kemajuan ini.

Sebaliknya, rajah di bawah menunjukkan status semasa penyelidikan generalisasi dalam bidang robotik. Pada masa ini, ramai penyelidik robotik masih melatih model kecil dan belum lagi menggunakan Vision Transformer!

Bagi mereka yang terlibat dalam penyelidikan robot, mereka semua berharap robot dapat digunakan dengan lebih meluas di dunia nyata dan memainkan peranan yang lebih besar. Dalam bidang model generatif, penyelidik menghadapi masalah yang agak sedikit, manakala dalam bidang penyelidikan robotik, mereka sering menghadapi masalah seperti kesukaran dalam penggunaan robot dan data bising, yang tidak akan dihadapi oleh penyelidik yang terlibat dalam model generatif.

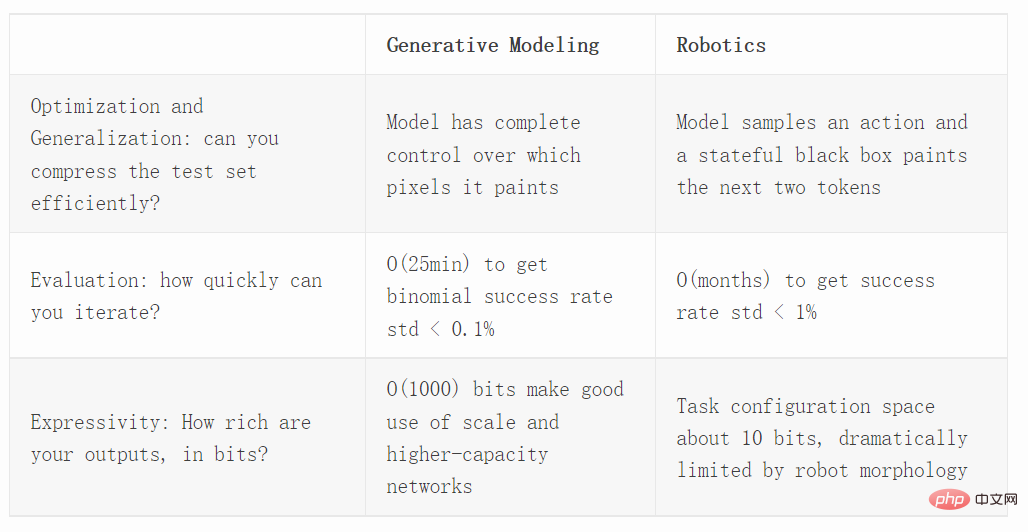

Seterusnya kami membandingkan model generatif dan robotik daripada tiga dimensi berbeza, termasuk pengoptimuman, penilaian dan keupayaan ekspresi.

Pengoptimuman

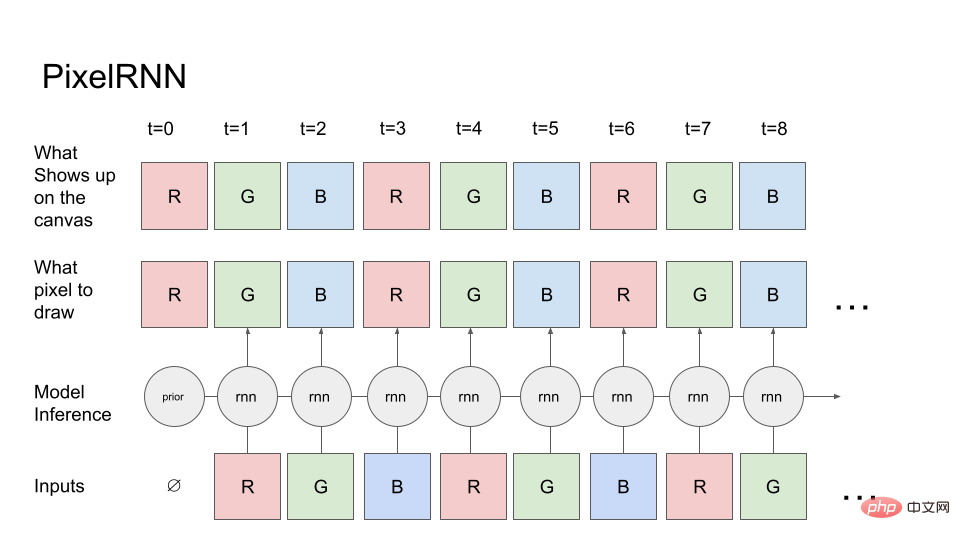

Mula-mula mari kita lihat model generatif ringkas: PixelRNN.

Bermula dari saluran merah piksel pertama (kebarangkalian a priori saluran merah diketahui), model memberitahu kanvas (baris atas) piksel mana yang dikehendakinya untuk melukis. Kanvas akan melukis dengan tepat seperti yang diarahkan, jadi ia menyalin nilai piksel ke atas kanvas dan kemudian membaca kanvas kembali ke dalam model untuk meramalkan saluran seterusnya iaitu saluran hijau. Kemudian nilai pada kanvas R dan G disalurkan semula ke RNN, dan seterusnya, akhirnya menghasilkan urutan RGBRGBRGB....

Dalam tugas penjanaan imej sebenar, resapan atau pengubah boleh digunakan. Tetapi untuk kesederhanaan, kami hanya menggunakan RNN pelaksanaan hadapan.

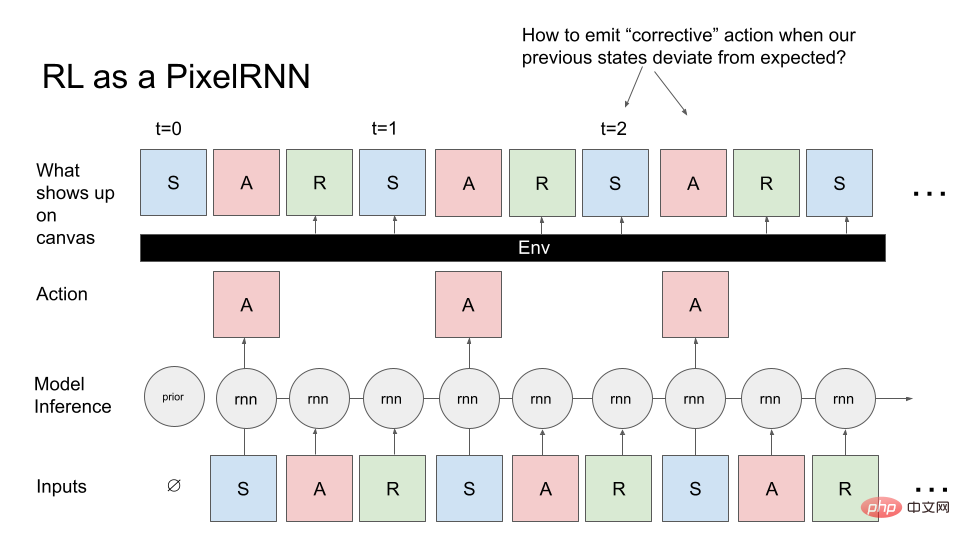

Sekarang mari tukar masalah kawalan am kepada PixelRNN. Daripada menjana imej, kami mahu menjana MDP (Proses Keputusan Markov): urutan keadaan, tindakan dan ganjaran. Kami ingin menjana MDP yang sepadan dengan ejen (seperti robot) yang melaksanakan beberapa tugas. Di sini juga kita bermula daripada pengetahuan sedia ada dan model itu mencontohi keadaan awal persekitaran pembelajaran pengukuhan (RL). Ini adalah input pertama kepada model, RNN sampel piksel pertama (A), dan kanvas menjana A tepat seperti yang diarahkan. Walau bagaimanapun, tidak seperti menjana imej, kanvas sentiasa mengembalikan output RNN sebelumnya dan operasi semasa ialah dua piksel seterusnya (R, S) ditentukan oleh persekitaran semasa: iaitu ia menerima tindakan dan semua keadaan sebelumnya, dan Kira R, S entah bagaimana.

Kita boleh menganggap persekitaran RL sebagai objek pelukis, yang melakukan tindakan RNN dan bukannya Lukis terus apa yang anda mahu pada kanvas, dan ia akan melukis piksel menggunakan fungsi kompleks yang sewenang-wenangnya.

Jika kita bandingkan dengan PixelRNN sebelum ini yang melukis imej, tugasan ini jelas lebih mencabar kerana apabila anda cuba sampel imej yang anda mahu, terdapat kotak hitam, ini kotak hitam akan menyukarkan untuk melukis kandungan.

Masalah biasa akan dihadapi semasa proses melukis: jika persekitaran melukis keadaan yang tidak dijangka, akan ada masalah, iaitu bagaimana untuk mengeluarkan arahan pembetulan supaya anda boleh kembali ke Imej yang kita cuba lukis. Selain itu, tidak seperti penjanaan imej, kita sebenarnya perlu menjana imej MDP secara berurutan dan tidak boleh kembali untuk mengedit, yang juga menimbulkan cabaran pengoptimuman.

Jika kita ingin memahami cara kaedah RL seperti PPO digeneralisasikan, kita harus menanda arasnya dalam persekitaran yang tidak terkawal, menerapkannya pada teknik penjanaan imej dan membandingkannya dengan model generatif moden . Dalam karya Hinton dan Nair 2006, mereka menggunakan sistem spring untuk memodelkan sintesis digital MNIST. DeepMind mereplikasi sebahagian daripada kerja sintesis imej ini menggunakan kaedah RL.

Penjanaan imej ialah penanda aras yang hebat untuk mengkaji pengoptimuman dan kawalan kerana ia benar-benar menekankan keperluan untuk membuat generalisasi merentas beribu-ribu senario yang berbeza.

Karya terbaharu seperti Decision Transformer, Trajectory Transformer dan Multi-Game Decision Transformer telah menunjukkan bahawa teknologi RL terbalik berfungsi dengan baik dalam generalisasi. Jadi bagaimanakah teknik RL terbalik berbanding dengan algoritma RL dalam talian (PPO) atau luar talian (CQL)? Ia juga mudah untuk dinilai, kita boleh menilai ketumpatan (model kemungkinan pemerhatian lengkap pakar) dan mengesahkan sama ada pilihan algoritma RL yang diberikan boleh digeneralisasikan kepada sejumlah besar imej apabila mengukur kemungkinan ujian.

Penilaian

Jika kita ingin menganggarkan kadar kejayaan robot pada tugas tertentu, kita boleh menggunakan taburan binomial.

Varian bagi taburan binomial ialah p(1−p)/N, p ialah min sampel (anggaran kadar kejayaan N ialah bilangan percubaan); Dalam kes yang paling teruk, jika p=50% (varians maksimum), maka 3000 sampel diperlukan untuk mendapatkan sisihan piawai kepada kurang daripada 1%!

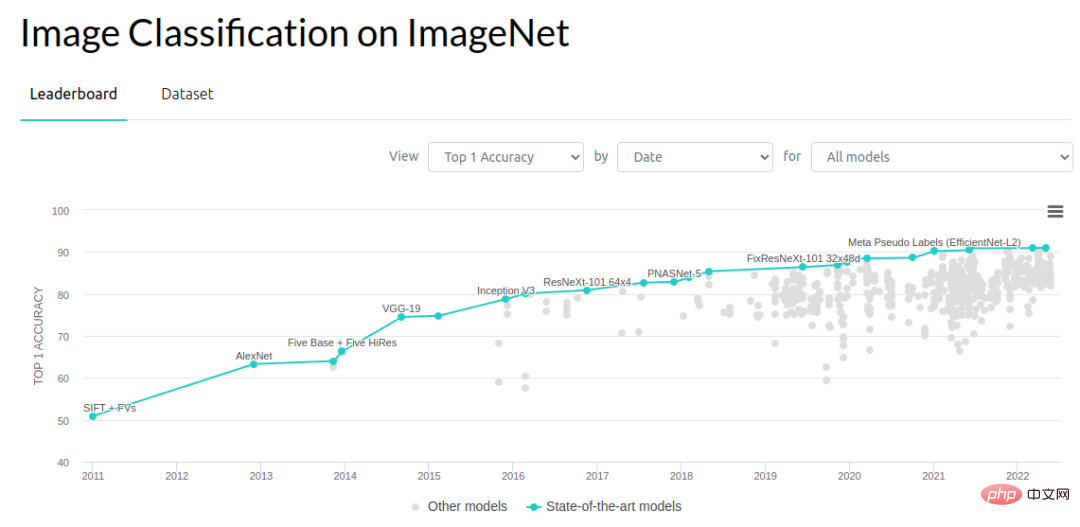

Jika kita melihatnya dari perspektif penglihatan komputer, peningkatan dalam julat 0.1-1% merupakan pemacu kemajuan yang penting. Masalah pengecaman objek ImageNet telah mencapai banyak kemajuan sejak tahun 2012. Kadar ralat menurun sebanyak 3% dari 2012 hingga 2014 dan kemudian sebanyak kira-kira 1% setiap tahun Terdapat ramai orang yang berusaha untuk membuat kerja ini. Mungkin tahun ini (2022) telah mencapai kesesakan dalam peningkatan penanda aras, tetapi dalam tempoh tujuh tahun dari 2012 hingga 2018, penyelidik telah membuat banyak kemajuan dan keputusan.

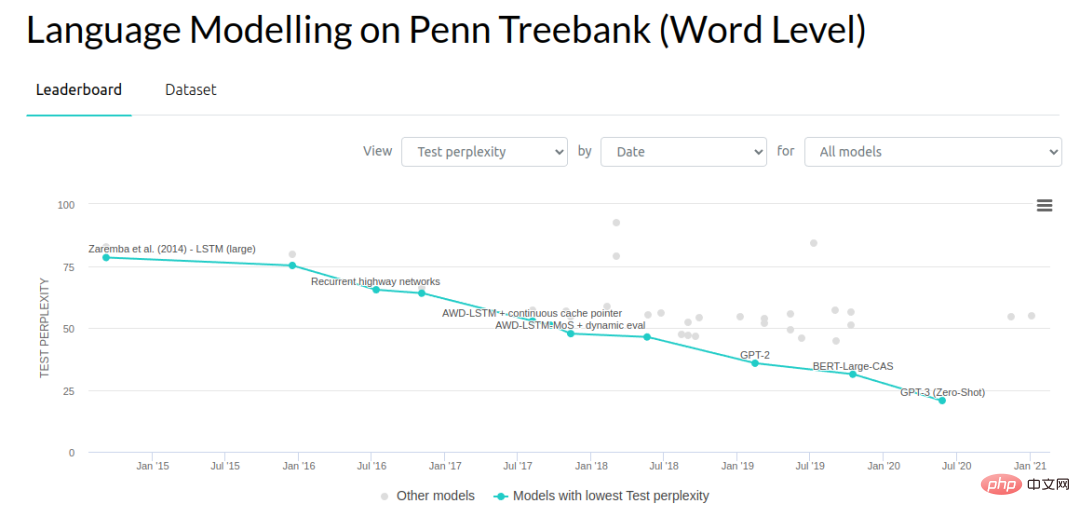

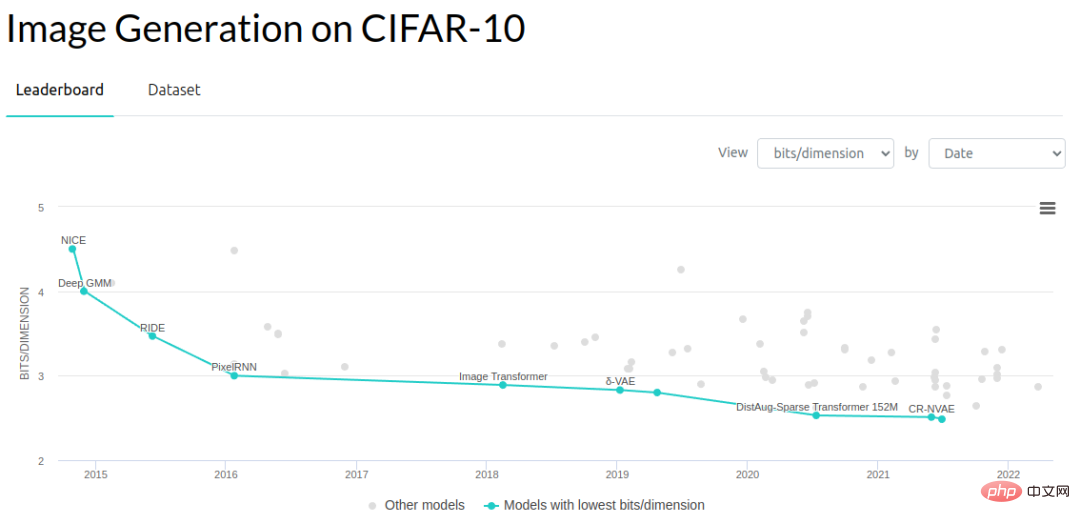

Dalam bidang pemodelan generatif yang lain, penyelidik telah mengurangkan kerumitan model bahasa dan bit setiap dimensi model generatif pada imej Nombor ( bit setiap dimensi).

Berikut ialah perbandingan kasar kelajuan penilaian penanda aras biasa. Set ujian pengecaman objek ImageNet 2012 mempunyai 150,000 imej. Dengan mengandaikan kelajuan inferens 10ms setiap imej, dan menilai setiap imej secara berturut-turut, ia akan mengambil masa kira-kira 25 minit untuk menilai setiap contoh ujian (sebenarnya penilaian adalah lebih pantas kerana pemprosesan kelompok mungkin). Tetapi di sini kami menganggap bahawa kami hanya mempunyai satu robot yang menjalankan operasi penilaian, dan imej mesti diproses secara berterusan.

Oleh kerana terdapat begitu banyak imej, kami boleh mendapatkan anggaran ralat standard dalam 0.1%. Kami sebenarnya tidak memerlukan ralat standard 0.1% untuk mencapai kemajuan dalam bidang ini, mungkin 1% sudah cukup.

Dari segi menilai kerumitan, prestasi hujung ke hujung juga merupakan bahagian penting. Mari kita lihat cara melaksanakan penilaian prestasi hujung ke hujung rangkaian saraf dalam tugasan simulasi. Habitat Sim ialah salah satu simulator terpantas yang tersedia dan direka bentuk untuk meminimumkan overhed antara inferens rangkaian saraf dan langkah persekitaran. Simulator boleh melakukan 10,000 langkah sesaat, tetapi memandangkan laluan hadapan rangkaian saraf adalah kira-kira 10ms, kesesakan ini mengakibatkan masa penilaian 2 saat setiap episod (dengan mengandaikan episod navigasi biasa sebanyak 200 langkah). Ini adalah lebih pantas daripada menjalankan robot sebenar, tetapi lebih perlahan daripada menilai satu sampel penglihatan komputer.

Jika seseorang menilai sistem robotik hujung ke hujung dengan tahap kepelbagaian yang serupa dengan apa yang kami lakukan dengan ImageNet, penilaian biasa akan mengambil masa 1 minggu untuk memproses ratusan ribu senario penilaian. Ini bukan perbandingan yang munasabah sepenuhnya, kerana setiap episod sebenarnya mempunyai kira-kira 200 pas inferens, tetapi kami tidak boleh menganggap imej dalam satu episod sebagai set pengesahan bebas. Tanpa sebarang metrik episod lain, kami hanya tahu sama ada tugas itu berjaya, jadi semua inferens dalam episod hanya menyumbang kepada satu sampel anggaran binomial. Kami perlu menganggarkan kadar kejayaan berdasarkan puluhan ribu episod dan bukannya gambar. Sudah tentu, kami boleh cuba menggunakan kaedah penilaian dasar lain, tetapi algoritma ini belum cukup dipercayai untuk berfungsi di luar kotak.

Pada peringkat seterusnya, kami menjalankan penilaian di tapak robot sebenar. Dalam dunia nyata setiap episod mengambil masa kira-kira 30 saat untuk menilai, jadi jika satu pasukan yang terdiri daripada 10 pengendali melakukan penilaian, dan setiap pengendali boleh melengkapkan 300 episod setiap hari, maka kira-kira 3000 penilaian boleh dilakukan setiap hari.

Jika mengambil masa sehari penuh untuk menilai model, ini meletakkan had yang besar pada produktiviti kerana anda hanya boleh mencuba satu idea setiap hari. Oleh itu, kita tidak boleh lagi mengusahakan idea kecil yang meningkatkan prestasi secara berperingkat sebanyak 0.1%, atau idea yang sangat melampau. Kami terpaksa mencari jalan untuk membuat lonjakan besar dalam prestasi. Walaupun ini kelihatan baik, ia sukar untuk dilakukan dalam amalan.

Apabila mempertimbangkan proses pembelajaran robot berulang, adalah mudah untuk mempunyai bilangan ujian penilaian yang jauh melebihi data latihan anda! Penilaian tanpa henti selama berbulan-bulan menghasilkan kira-kira puluhan ribu episod, yang sudah lebih besar daripada kebanyakan set data demonstrasi pembelajaran mendalam robotik.

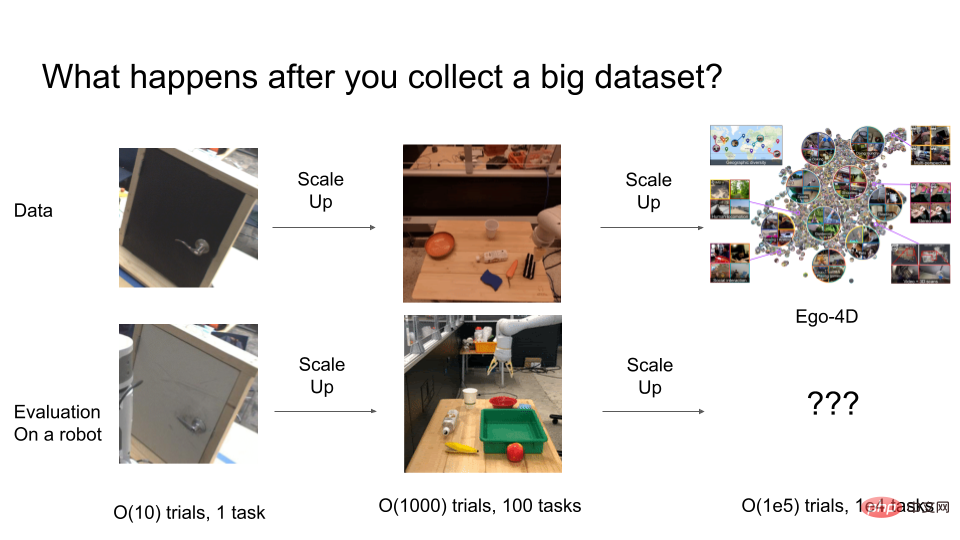

Beberapa tahun lalu, penyelidik masih menyelesaikan masalah seperti mendapatkan senjata robot untuk membuka pintu, tetapi strategi ini tidak t berfungsi dengan baik. Penyelidik biasanya menjalankan penilaian dalam urutan sekitar 10 episod. Tetapi 10-50 percubaan sebenarnya tidak mencukupi untuk menjamin keteguhan statistik. Untuk mencapai keputusan yang baik, lebih daripada 1000 percubaan sebenarnya boleh dilakukan untuk penilaian akhir.

Tetapi apakah yang berlaku apabila percubaan diperluaskan lagi? Jika kita akhirnya perlu melatih sistem robotik yang sangat umum dengan tingkah laku O(100,000), berapa banyak ujian yang kita perlukan untuk menilai sistem umum tersebut? Di sinilah kos penilaian menjadi sangat mahal.

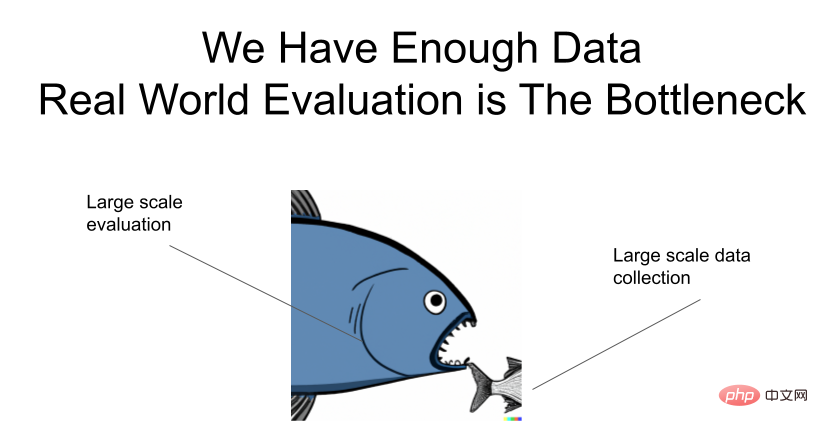

Saya menekankannya sekali lagi: data adalah mencukupi, tetapi terdapat kesesakan dalam penilaian!

Bagaimana untuk mempercepatkan penilaian?

Berikut ialah beberapa idea tentang cara mempercepatkan penilaian sistem robotik universal.

Salah satu cara ialah mengkaji masalah generalisasi dan robot secara berasingan. Malah, komuniti pembelajaran mendalam telah pun mencapai ini. Kebanyakan penyelidik visi komputer dan pemodelan generatif tidak secara langsung menguji idea mereka pada robot sebenar, tetapi menjangkakan bahawa sebaik sahaja model mereka mencapai keupayaan generalisasi yang kuat, mereka akan segera dipindahkan ke robot. ResNets, dibangunkan dalam bidang penglihatan komputer, sangat memudahkan banyak pilihan pemodelan gerakan visual robotik. Bayangkan jika seorang penyelidik terpaksa menguji idea mereka pada robot sebenar setiap kali mereka ingin mencuba seni bina rangkaian saraf yang berbeza! Satu lagi kisah kejayaan ialah CLIPort, yang mengasingkan keupayaan generalisasi multimodal yang berkuasa bagi model teks imej daripada penaakulan geometri asas untuk perancangan memahami.

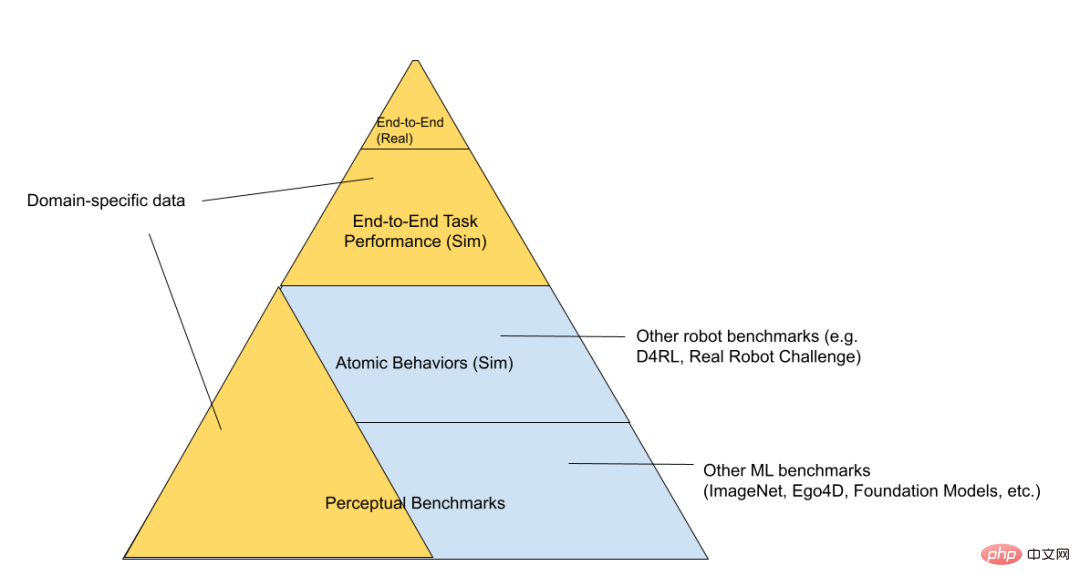

Kita boleh membahagikan lagi timbunan teknologi RL kepada tiga lapisan: "persekitaran mainan simulasi", "robot simulasi" dan "robot sebenar" (disusun mengikut peningkatan kesukaran penilaian).

Di bahagian bawah piramid terdapat tanda aras umum, seperti untuk pertandingan Kaggle. Naik, terdapat satu set "masalah kawalan mainan", yang mengkaji masalah dengan cara "logam kosong" Hanya simulator dan rangkaian saraf sedang berjalan, dan semua kod yang berkaitan dengan robot dunia sebenar, seperti pengurusan bateri , tidak wujud. Melangkah lebih jauh ke atas piramid membawa kepada kawasan yang lebih khusus, lebih berkaitan dengan masalah yang anda cuba selesaikan. Contohnya, "robot simulasi" dan "robot sebenar" boleh digunakan untuk tugas yang sama dan menggunakan semula kod robot asas yang sama. Persekitaran mainan simulasi boleh digunakan untuk mengkaji algoritma umum, tetapi mempunyai kurang pertindihan dengan bidang robotik akhir. Di bahagian atas "piramid penilaian" adalah tugas robotik sebenar yang kami cuba selesaikan. Mengulang proses ini secara langsung adalah sangat perlahan, jadi kita semua ingin meluangkan sedikit masa yang mungkin di sini. Kami berharap model asas yang dilatih dan dinilai di peringkat rendah akan membantu memahami idea yang berfungsi tanpa perlu melakukan setiap penilaian di peringkat atas.

Sekali lagi, medan sudah beroperasi dengan cara yang dipisahkan ini. Kebanyakan orang yang berminat untuk menyumbang kepada robot tidak semestinya mengendalikan robot. Mereka mungkin melatih perwakilan visual dan seni bina yang akhirnya mungkin berguna kepada robot. Sudah tentu, kelemahan penyahgandingan ialah penambahbaikan dalam garis dasar persepsi tidak selalu sepadan dengan peningkatan dalam keupayaan robot. Sebagai contoh, sementara metrik mAP sedang meningkatkan ketepatan segmentasi semantik atau klasifikasi video, atau malah penanda aras mampatan tanpa kerugian (yang secara teori akhirnya akan menyumbang), kami tidak tahu bagaimana peningkatan dalam matlamat perwakilan sebenarnya memetakan kepada peningkatan dalam tugas hiliran. Jadi akhirnya anda perlu menguji sistem hujung ke hujung untuk memahami di mana kesesakan sebenar.

Google pernah menerbitkan makalah hebat "Mencabar Andaian Biasa dalam Pembelajaran Tanpa Seliaan Perwakilan Terpisah". dalam tugas, melainkan kami melakukan penilaian dan pemilihan model menggunakan kriteria hiliran akhir yang kami ambil berat.

Alamat kertas: https://arxiv.org/pdf/1811.12359.pdf

Cara lain untuk mengurangkan kos penilaian Pendekatannya adalah untuk memastikan proses pengumpulan dan penilaian data adalah konsisten. Kami boleh mengumpul kedua-dua data penilaian dan data operasi pakar secara serentak. Kami boleh mengumpul data HG-dagger melalui campur tangan tertentu, supaya data latihan yang berguna dapat dikumpul. Pada masa yang sama, purata bilangan campur tangan setiap episod secara kasar boleh memberitahu kami sama ada strategi itu cukup baik. Kita juga boleh memerhatikan metrik skalar dan bukannya metrik binomial kerana setiap episod metrik ini menghasilkan lebih banyak maklumat daripada satu kejayaan/kegagalan.

Menggunakan algoritma RL untuk pengumpulan data autonomi ialah cara lain untuk menggabungkan penilaian dan pengumpulan data, tetapi kaedah ini memerlukan kami menjaringkan episod secara manual atau menggunakan fungsi ganjaran yang direka bentuk dengan teliti. Semua pendekatan ini memerlukan penggunaan sejumlah besar robot di dunia nyata, yang masih terperangkap dalam lelaran berterusan di dunia nyata.

Satu cara untuk menjadikan algoritma penilaian lebih pantas ialah dengan menambah baik algoritma migrasi sim-ke-sebenar. Kita boleh mensimulasikan banyak robot secara selari supaya tiada kekangan. Mohi Khansari, Daniel Ho, Yuqing Du dan lain-lain membangunkan teknik yang dipanggil "Kehilangan Konsistensi Tugasan", yang menyelaraskan perwakilan daripada sim dan nyata kepada invarian, jadi strategi adalah dalam sim Tingkah laku harus serupa dengan sebenar. Apabila kami memindahkan strategi yang dinilai dalam sim kepada sebenar, kami ingin memastikan bahawa metrik prestasi yang lebih tinggi dalam sim juga sememangnya sepadan dengan metrik prestasi yang lebih tinggi secara sebenar. Semakin kecil jurang sim2real, semakin dipercayai penunjuk dalam eksperimen simulasi.

Keekspresifan

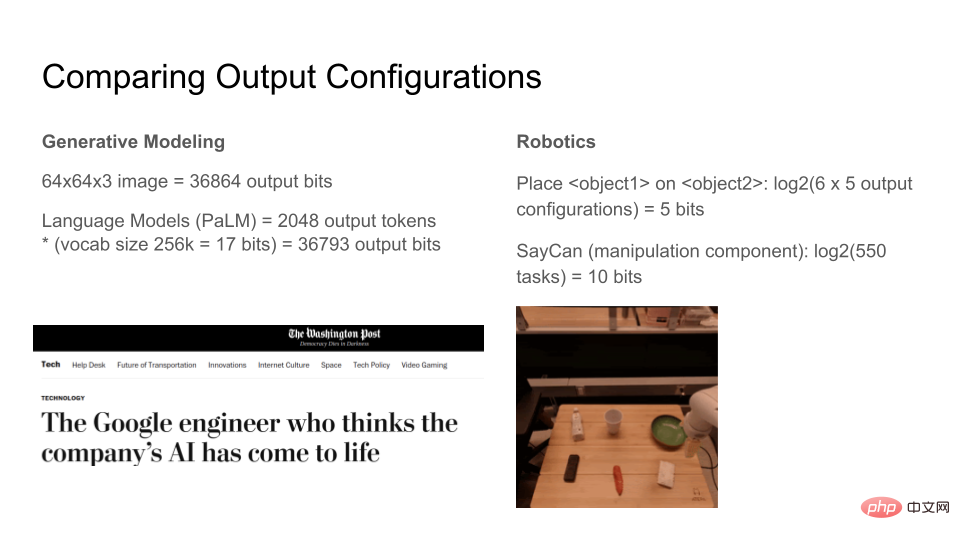

Mari kita lihat berapa bit yang boleh dikeluarkan oleh model generatif moden. Imej RGB 64x64x3 dengan 8 bit setiap saluran ialah 36864bit. Model bahasa boleh menjana sebarang bilangan token, tetapi jika kita menetapkan tetingkap output kepada 2048 token, setiap token mempunyai 17 bit, dengan jumlah 36793 bit. Oleh itu, kedua-dua model penjanaan imej dan teks boleh mensintesis kira-kira 37kbit. Apabila model menjadi lebih ekspresif, persepsi orang ramai terhadap model ini akan mengalami lonjakan kualitatif. Malah ada yang mula berfikir bahawa model bahasa separa sedar kerana ia sangat ekspresif!

Sebagai perbandingan, sejauh manakah ekspresif robot hari ini? Di sini kami mereka bentuk persekitaran dunia sebenar yang dipermudahkan Terdapat 6 item di atas meja Tugas robot adalah untuk memindahkan satu item ke bahagian atas item lain atau mengangkut item tertentu, untuk sejumlah 100 tugas. log2(100) ialah kira-kira 7 bit, yang bermaksud "memandangkan keadaan dunia, robot boleh memindahkan atom ke salah satu keadaan N, di mana N boleh digambarkan dengan 7 bit." Algoritma SayCan Google boleh melengkapkan kira-kira 550 operasi dengan rangkaian saraf, yang agak mengagumkan mengikut piawaian semasa pembelajaran mendalam untuk robotik, dalam hanya kira-kira 10 bit keseluruhannya.

Perbandingan ini tidak munasabah kerana definisi maklumat adalah berbeza antara kedua-duanya, ia hanya untuk memberikan intuisi kasar apabila seseorang mengukur satu set tugas berbanding kerumitan relatif set tugasan lain memerlukan memikirkan perkara yang penting.

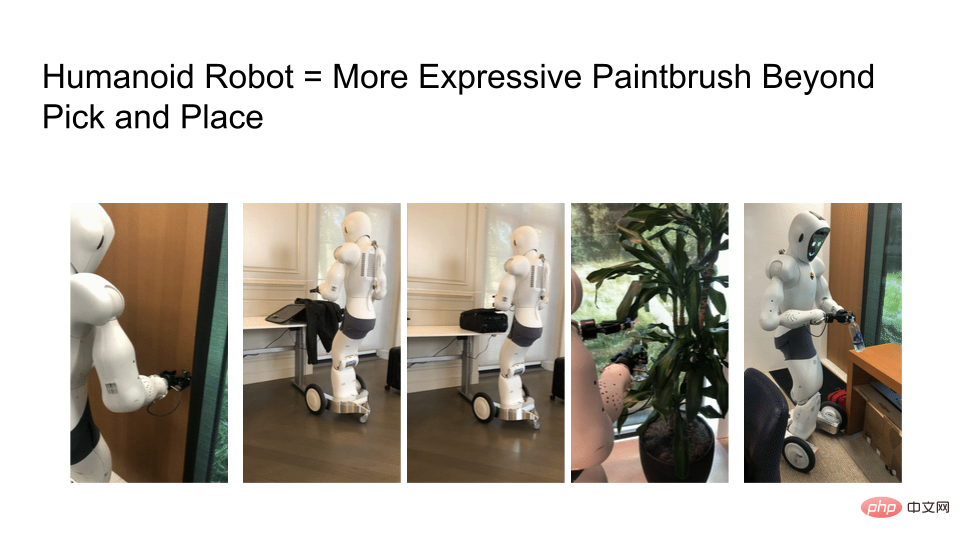

Salah satu cabaran yang kami hadapi ialah fungsi robot masih terhad. Jika anda melihat set data Ego4D, banyak tugas memerlukan dua tangan, tetapi kebanyakan robot hari ini masih menggunakan tapak beroda, manipulator mudah alih satu lengan. Mereka tidak boleh bergerak atau pergi ke mana-mana, dan jelas yang kita ada hanyalah "lengan robot", yang menolak banyak tugas yang menarik.

Kita perlu mengkaji robot yang lebih ekspresif, tetapi ekspresi algoritma pembelajaran robot dihadkan oleh perkakasan. Di bawah adalah gambar robot membuka pintu, mengemas beg pakaian, zip zip, menyiram tanaman dan menyelak penutup botol air. Memandangkan perkakasan robot semakin hampir dengan manusia sebenar, bilangan perkara yang boleh anda lakukan dalam dunia berpusatkan manusia bertambah dengan pesat.

Apabila robot menjadi lebih ekspresif, kami bukan sahaja memerlukan data latihan berskala internet, tetapi juga proses penilaian berskala internet. Jika anda melihat kemajuan model bahasa besar (LLM), kini terdapat banyak kertas kerja yang melihat penalaan dan perkara yang boleh dan tidak boleh dilakukan oleh model sedia ada.

Sebagai contoh, penanda aras BigBench menyusun satu siri tugasan dan bertanya apa yang boleh kita perolehi daripada model ini. OpenAI membolehkan pengguna Internet menilai model DALLE-2 dan GPT-3 mereka. Pasukan kejuruteraan dan produk mereka boleh belajar daripada eksperimen AI yang melibatkan pengguna kerana butiran model LLM sukar untuk dikuasai oleh mana-mana penyelidik.

Akhir sekali, soalan untuk pembaca, apakah teknologi yang setara dengan API GPT-3 atau DALLE-2 dalam bidang robotik? Melalui teknologi yang setara ini, bolehkah penyelidik dalam komuniti Internet mempersoalkan penyelidikan robot dan memahami apa yang sebenarnya boleh dilakukannya?

Akhir sekali, gunakan jadual untuk meringkaskan perbandingan antara pengoptimuman, penilaian dan ekspresitiviti:

Atas ialah kandungan terperinci Berbanding dengan model generatif, mengapa penyelidikan robotik masih menggunakan kaedah lama yang sama dari beberapa tahun lalu?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI