Rumah >Peranti teknologi >AI >Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?

Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 18:52:131483semak imbas

Beberapa hari lalu, pemenang Anugerah Turing akademik Yann LeCun mempersoalkan kajian Google.

Beberapa masa lalu, Google AI mencadangkan struktur kehilangan hierarki am untuk rangkaian saraf berbilang lapisan dalam penyelidikan baharunya "LocoProp: Meningkatkan BackProp melalui Pengoptimuman Kehilangan Setempat" Rangka Kerja LocoProp, yang mencapai prestasi hampir dengan kaedah tertib kedua sambil menggunakan pengoptimum tertib pertama sahaja.

Secara lebih khusus, rangka kerja itu membayangkan semula rangkaian saraf sebagai komposisi modular berbilang lapisan, di mana setiap lapisan menggunakan penyelaras berat, output sasaran dan fungsi kehilangannya sendiri, akhirnya mencapai Prestasi dan kecekapan secara serentak.

Google secara eksperimen mengesahkan keberkesanan pendekatannya pada model penanda aras dan set data, merapatkan jurang antara pengoptimum tertib pertama dan kedua. Di samping itu, penyelidik Google menyatakan bahawa kaedah pembinaan kerugian tempatan mereka adalah kali pertama kerugian kuasa dua digunakan sebagai kerugian tempatan.

Sumber imej: @Google AI

Untuk penyelidikan oleh Google ini, sesetengah orang telah mengulas bahawa ia hebat dan menarik. Walau bagaimanapun, sesetengah orang menyatakan pandangan berbeza, termasuk pemenang Anugerah Turing Yann LeCun.

Beliau percaya bahawa terdapat banyak versi apa yang kini kita panggil prop sasaran, beberapa telah wujud sejak tahun 1986. Jadi, apakah perbezaan antara LocoProp Google dan mereka?

Sumber foto: @Yann LeCun

Haohan Wang, yang bakal menjadi penolong profesor di UIUC, bersetuju dengan soalan LeCun. Beliau berkata kadangkala menghairankan mengapa sesetengah pengarang menganggap idea mudah seperti itu adalah yang pertama seumpamanya. Mungkin mereka melakukan sesuatu yang berbeza, tetapi pasukan publisiti tidak sabar untuk keluar dan menuntut segala-galanya...

Sumber foto: @HaohanWang

Namun , sesetengah orang "tidak dingin" kepada LeCun, memikirkan bahawa dia menimbulkan persoalan daripada pertimbangan persaingan atau bahkan "memulakan perang." LeCun menjawab, mendakwa bahawa soalannya tidak ada kaitan dengan persaingan, dan memberikan contoh bekas ahli makmalnya seperti Marc'Aurelio Ranzato, Karol Gregor, koray kavukcuoglu, dll., yang semuanya telah menggunakan beberapa versi penyebaran sasaran, dan kini mereka semua bekerja di Google DeepMind .

Sumber gambar: @Gabriel Jimenez@Yann LeCun

Sesetengah orang mengejek Yann LeCun, "Apabila anda tidak dapat mengalahkan Jürgen Schmidhuber, jadilah dia. ”

Betul ke Yann LeCun? Mari kita lihat dahulu tentang kajian Google ini. Adakah terdapat sebarang inovasi yang cemerlang?

Google LocoProp: Penyebaran balik yang dipertingkatkan dengan pengoptimuman kerugian tempatan

Penyelidikan ini telah disiapkan oleh tiga penyelidik dari Google: Ehsan Amid, Rohan Anil dan Manfred K. Warmuth.

Alamat kertas: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

Artikel ini percaya bahawa rangkaian saraf dalam (DNN ) Terdapat dua faktor utama untuk berjaya: reka bentuk model dan data latihan, tetapi beberapa penyelidik membincangkan kaedah pengoptimuman untuk mengemas kini parameter model. Latihan DNN kami melibatkan meminimumkan fungsi kehilangan, yang digunakan untuk meramalkan perbezaan antara nilai sebenar dan nilai ramalan model, dan menggunakan perambatan belakang untuk mengemas kini parameter.

Kaedah kemas kini berat yang paling mudah ialah keturunan kecerunan stokastik, iaitu, dalam setiap langkah, berat bergerak secara relatif kepada arah negatif kecerunan. Selain itu, terdapat kaedah pengoptimuman lanjutan, seperti pengoptimum momentum, AdaGrad, dsb. Pengoptimum ini sering dipanggil kaedah tertib pertama kerana mereka biasanya hanya menggunakan maklumat daripada derivatif tertib pertama untuk mengubah suai arah kemas kini.

Terdapat juga kaedah pengoptimuman yang lebih maju seperti Syampu, K-FAC, dsb., yang telah terbukti meningkatkan penumpuan dan mengurangkan bilangan lelaran. Menggunakan maklumat tambahan ini, pengoptimum tertib tinggi boleh menemui arah kemas kini yang lebih cekap untuk model terlatih dengan mengambil kira korelasi antara kumpulan parameter yang berbeza. Kelemahannya ialah pengiraan arah kemas kini tertib lebih tinggi secara pengiraan lebih mahal daripada kemas kini pesanan pertama.

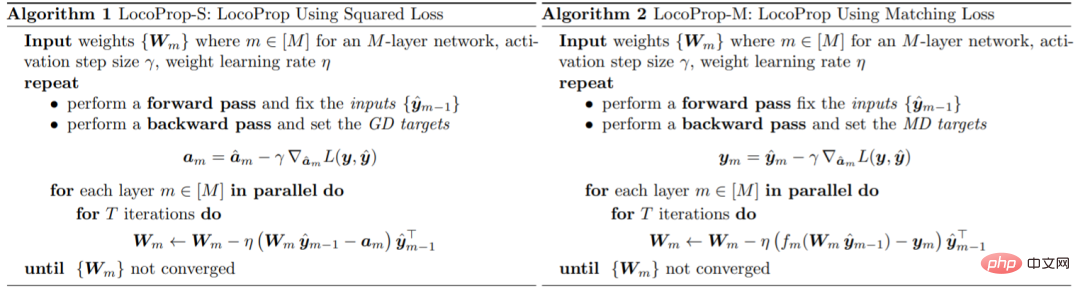

Google memperkenalkan rangka kerja untuk melatih model DNN dalam kertas kerja: LocoProp, yang menganggap rangkaian saraf sebagai gabungan modular lapisan. Secara umumnya, setiap lapisan rangkaian saraf melakukan transformasi linear pada input, diikuti dengan fungsi pengaktifan bukan linear. Dalam kajian ini, setiap lapisan rangkaian diberikan penyelaras berat, sasaran keluaran dan fungsi kehilangannya sendiri. Fungsi kehilangan setiap lapisan direka untuk memadankan fungsi pengaktifan lapisan tersebut. Menggunakan borang ini, melatih sekumpulan kecil kerugian tempatan yang diberikan boleh diminimumkan, berulang antara lapisan secara selari.

Google menggunakan pengoptimum tertib pertama ini untuk kemas kini parameter, sekali gus mengelakkan kos pengiraan yang diperlukan oleh pengoptimum tertib lebih tinggi.

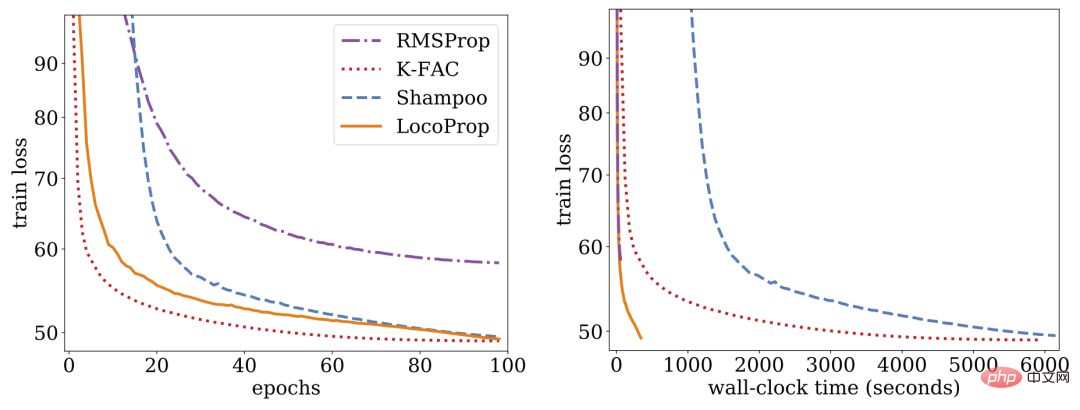

Penyelidikan menunjukkan bahawa LocoProp mengatasi kaedah tertib pertama pada penanda aras autoenkoder mendalam dan berprestasi setanding dengan pengoptimum tertib tinggi seperti Syampu dan K-FAC tanpa keperluan memori dan pengiraan yang tinggi.

LocoProp: Penyebaran balik yang dipertingkatkan melalui pengoptimuman kehilangan setempat

Biasanya rangkaian saraf dilihat sebagai fungsi komposit yang menukar input setiap lapisan kepada ekspres keluaran. LocoProp mengguna pakai perspektif ini apabila menguraikan rangkaian menjadi lapisan. Khususnya, bukannya mengemas kini pemberat lapisan untuk meminimumkan fungsi kehilangan pada output, LocoProp menggunakan fungsi kehilangan setempat yang dipratentukan khusus untuk setiap lapisan. Untuk lapisan tertentu, fungsi kehilangan dipilih untuk memadankan fungsi pengaktifan, contohnya, kehilangan tanh akan dipilih untuk lapisan dengan pengaktifan tanh. Selain itu, istilah penyelarasan memastikan bahawa pemberat yang dikemas kini tidak menyimpang terlalu jauh daripada nilai semasanya.

Sama seperti perambatan belakang, LocoProp menggunakan pas hadapan untuk mengira pengaktifan. Dalam hantaran ke belakang, LocoProp menetapkan sasaran untuk neuron dalam setiap lapisan. Akhir sekali, LocoProp menguraikan latihan model kepada masalah bebas merentas lapisan, di mana pelbagai kemas kini tempatan boleh digunakan pada pemberat setiap lapisan secara selari.

Google menjalankan eksperimen pada model autoenkoder dalam, penanda aras biasa untuk menilai prestasi algoritma pengoptimuman. Mereka melakukan pengoptimuman yang meluas pada berbilang pengoptimum tertib pertama yang biasa digunakan, termasuk SGD, SGD dengan momentum, AdaGrad, RMSProp, Adam dan pengoptimum tertib tinggi termasuk Syampu, K-FAC dan membandingkan hasilnya dengan LocoProp. Hasilnya menunjukkan bahawa kaedah LocoProp menunjukkan prestasi yang lebih baik daripada pengoptimum tertib pertama dan setanding dengan pengoptimum tertib tinggi, sambil jauh lebih pantas apabila dijalankan pada satu GPU.

Atas ialah kandungan terperinci Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI