Rumah >Peranti teknologi >AI >Bilangan parameter ialah 1/50, Meta mengeluarkan 11 bilion model parameter, mengalahkan Google PaLM

Bilangan parameter ialah 1/50, Meta mengeluarkan 11 bilion model parameter, mengalahkan Google PaLM

- 王林ke hadapan

- 2023-04-12 18:10:031208semak imbas

Kami boleh memahami model bahasa besar (LLM) sebagai pelajar sampel kecil, yang boleh mempelajari tugas baharu dengan beberapa contoh, atau malah dengan arahan mudah, di mana bilangan parameter model adalah Penskalaan dengan saiz latihan data adalah kunci kepada keupayaan model untuk membuat generalisasi. Peningkatan dalam LLM ini disebabkan oleh kuasa pengkomputeran dan keupayaan storan yang lebih besar. Secara intuitif, keupayaan inferens yang lebih baik akan membawa kepada generalisasi yang lebih baik dan dengan itu kurang pembelajaran sampel, namun tidak jelas sejauh mana pembelajaran sampel kecil yang berkesan memerlukan pengetahuan yang luas tentang parameter model.

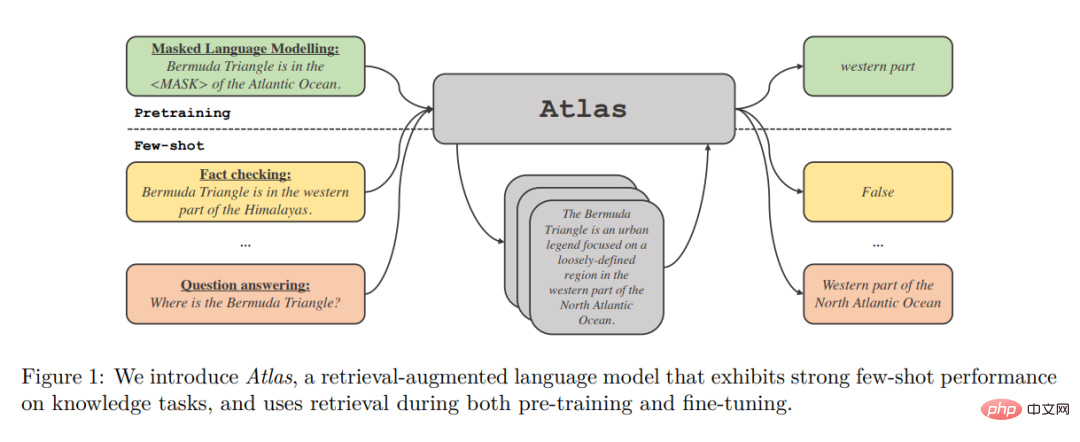

Setakat ini, model peningkatan perolehan tidak menunjukkan keupayaan pembelajaran sampel kecil yang meyakinkan. Dalam kertas itu, penyelidik dari Meta AI Research dan institusi lain bertanya sama ada pembelajaran sampel kecil memerlukan model untuk menyimpan sejumlah besar maklumat dalam parameternya, dan sama ada storan boleh dipisahkan daripada generalisasi. Mereka mencadangkan Atlas, iaitu sejenis model bahasa yang dipertingkatkan semula yang mempunyai keupayaan pembelajaran sampel kecil yang kukuh, walaupun bilangan parameter adalah lebih rendah daripada model pembelajaran sampel kecil berkuasa semasa yang lain.

Model menggunakan storan bukan parametrik, iaitu, menggunakan neural retriever berdasarkan sumber pengetahuan bukan statik luaran yang besar untuk meningkatkan model bahasa parametrik. Selain keupayaan storan, seni bina sedemikian menarik kerana kelebihannya dalam kebolehsuaian, kebolehtafsiran dan kecekapan.

Alamat kertas: https://arxiv.org/pdf/2208.03299.pdf

Pengambilan semula atlas bagi dokumen berkaitan ialah pengumpul semula kepadatan sejagat berdasarkan seni bina dwi pengekod Contriever Apabila mengambil fail, ia mengambil semula fail berkaitan berdasarkan konteks semasa. Dokumen yang diambil bersama-sama dengan konteks semasa diproses oleh model jujukan ke jujukan yang menggunakan seni bina Fusion-in-Decoder untuk menjana output yang sepadan.

Pengarang mengkaji kesan teknik yang berbeza pada prestasi latihan Atlas pada set data berskala kecil pada pelbagai tugas hiliran, termasuk menjawab soalan dan semakan fakta. Kajian mendapati bahawa komponen pra-latihan bersama adalah penting untuk prestasi sampel kecil, dan pengarang menilai banyak tugas dan skim pra-latihan sedia ada dan novel mempunyai prestasi hiliran yang kukuh dalam kedua-dua sampel kecil dan persekitaran yang kaya dengan sumber.

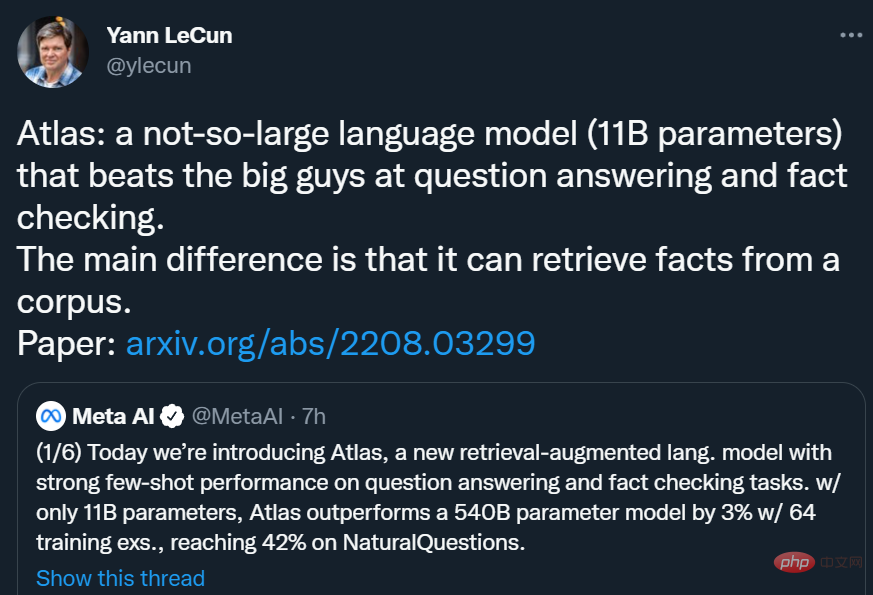

Dengan hanya 11B parameter, Atlas mencapai ketepatan 42.4% pada NaturalQuestions (NQ) menggunakan 64 contoh latihan, yang lebih tinggi daripada model parameter 540B PaLM (39.6%) daripada hampir 3 mata peratusan , mencapai ketepatan 64.0% dalam tetapan set data penuh (Penuh).

Yann LeCun berkata: Atlas ialah model bahasa yang tidak terlalu besar (parameter 11B), dalam Soal Jawab dan Facts Beats "lelaki besar" dalam pengesahan. Perbezaan utama Atlas ialah ia boleh mendapatkan semula fakta daripada korpus.

Ikhtisar Kaedah

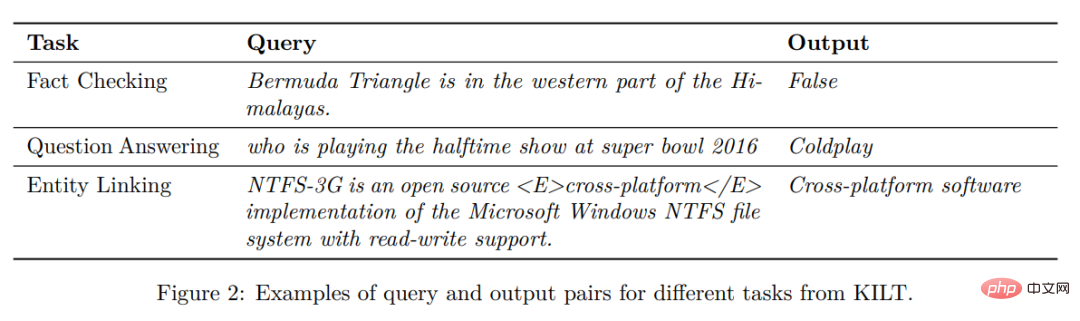

Atlas mengikut rangka kerja teks-ke-teks. Ini bermakna rangka kerja umum semua tugas ialah: sistem mengambil pertanyaan teks sebagai input dan menjana output teks. Sebagai contoh, dalam kes tugasan soal jawab, pertanyaan sepadan dengan soalan dan model perlu menjana jawapan. Dalam kes tugas pengelasan, pertanyaan sepadan dengan input teks dan model menjana label kelas, iaitu, perkataan yang sepadan dengan label. Penanda aras KILT dalam Rajah 2 memberikan lebih banyak contoh tugas hiliran. Banyak tugas pemprosesan bahasa semula jadi memerlukan pengetahuan, dan Atlas bertujuan untuk meningkatkan model teks-ke-teks standard dengan perolehan semula, kerana pengambilan mungkin penting kepada keupayaan model untuk belajar dalam senario sampel kecil.

Seni Bina

Model Atlas adalah berdasarkan dua sub-model: retriever dan bahasa model. Semasa menjalankan tugas, daripada menjawab soalan hingga menjana artikel Wikipedia, model itu mula-mula mendapatkan semula dokumen yang paling relevan daripada korpus teks besar melalui retriever. Dokumen-dokumen ini, bersama-sama dengan pertanyaan, kemudiannya diberikan sebagai input kepada model bahasa, yang menjana output. Kedua-dua retriever dan model bahasa adalah berdasarkan rangkaian pengubah yang telah terlatih, yang diterangkan secara terperinci di bawah.

Pendapatan semula: Modul retriever Atlas adalah berdasarkan Contriever, teknologi perolehan maklumat berdasarkan pembenaman ketumpatan berterusan. Contriever menggunakan seni bina dwi pengekod di mana pertanyaan dan dokumen dibenamkan secara bebas oleh pengekod pengubah. Pengumpulan purata digunakan pada output lapisan terakhir untuk mendapatkan perwakilan vektor bagi setiap pertanyaan atau dokumen. Kemudian dengan mengira hasil darab titik bagi pembenaman bersama antara pertanyaan dan setiap dokumen, skor persamaan mereka diperolehi. Model Contriever dilatih terlebih dahulu menggunakan kehilangan kontrastif MoCo dan hanya menggunakan data yang tidak diselia. Salah satu kelebihan pengambilan kepadatan ialah kedua-dua pengekod pertanyaan dan dokumen boleh dilatih tanpa anotasi dokumen menggunakan teknik standard seperti keturunan kecerunan dan penyulingan.

Model bahasa: Untuk model bahasa, Atlas bergantung pada seni bina jujukan-ke-jujukan T5. Model ini juga bergantung pada pengubahsuaian Fusion-in-Decoder bagi model jujukan-ke-jujukan dan memproses setiap dokumen secara bebas dalam pengekod. Model kemudian menggabungkan output pengekod yang sepadan dengan dokumen yang berbeza dan melakukan perhatian silang pada satu urutan dalam penyahkod. Model menghubungkan pertanyaan kepada setiap dokumen dalam pengekod. Satu lagi cara untuk memproses dokumen yang diperoleh semula dalam model bahasa ialah menggabungkan pertanyaan dan semua dokumen dan menggunakan urutan panjang ini sebagai input kepada model. Tetapi kaedah ini kurang berskala, iaitu, ia tidak akan berskala apabila bilangan dokumen bertambah, kerana mekanisme perhatian kendiri dalam pengekod akan membawa kepada kerumitan masa O(n^2) (di mana n ialah bilangan dokumen).

Hasil eksperimen

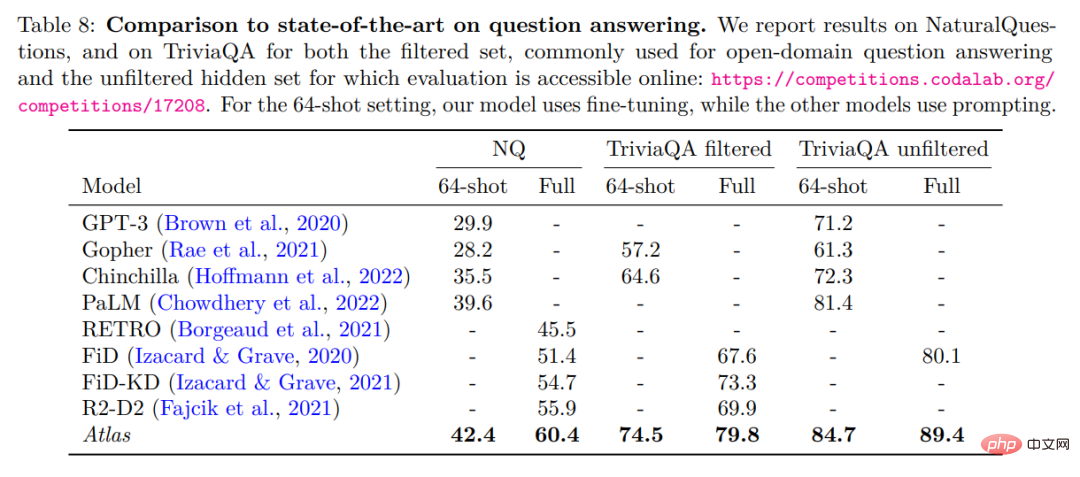

Pengarang menilai Atlas pada dua soalan domain terbuka yang menjawab tanda aras, NaturalQuestions dan TriviaQA. Dan kami menggunakan set data sampel kecil masing-masing sebanyak 64 sampel dan set latihan lengkap untuk dibandingkan dengan kerja sebelumnya. Perbandingan terperinci ditunjukkan dalam jadual di bawah.

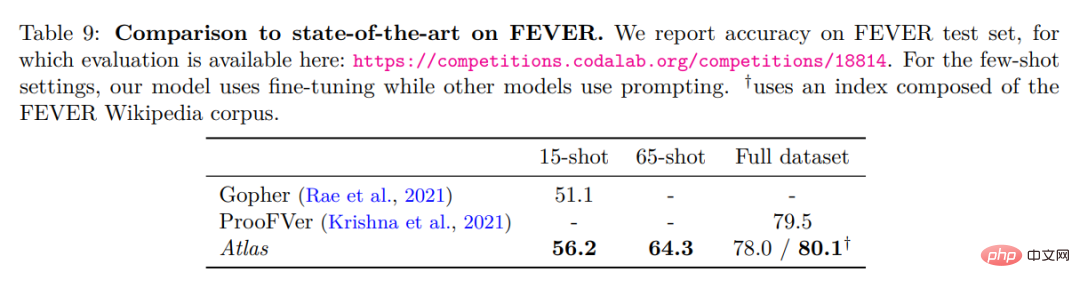

Berprestasi terbaik dalam Soal Jawab 64 syot dengan NaturalQuestions dan TriviaQA. Khususnya ia mengatasi model yang lebih besar (PaLM) atau model yang memerlukan lebih banyak pengiraan latihan (Chinchilla). Atlas juga boleh mencapai hasil yang optimum apabila menggunakan set latihan penuh, seperti meningkatkan ketepatan NaturalQuestions daripada 55.9% kepada 60.4%. Keputusan ini diperoleh di bawah tetapan lalai Atlas, menggunakan indeks yang terdiri daripada CCNet dan korpus Wikipedia Disember 2021. Jadual di bawah menunjukkan keputusan ujian pada set data semakan fakta FEVER.

Atlas Dalam kes 64 pukulan, sampel latihan diambil daripada set latihan penuh. Atlas mencapai ketepatan 64.3%. Dalam kes 15 pukulan, 5 sampel diambil secara seragam daripada setiap kelas Berbanding dengan keputusan Gopher, ketepatan Atlas ialah 56.2%, iaitu 5.1 mata peratusan lebih tinggi daripada Gopher. Model Atlas telah diperhalusi pada set latihan penuh dan mencapai ketepatan 78%, iaitu 1.5% lebih rendah daripada ProoFVer. ProoFVer menggunakan seni bina khusus untuk melatih retriever dengan anotasi peringkat ayat dan disediakan oleh korpus Wikipedia yang diterbitkan dengan FEVER, manakala Atlas mendapatkan semula daripada CCNet dan pembuangan Wikipedia Disember 2021. Apabila diberi indeks yang terdiri daripada korpus Wikipedia FEVER, Atlas mencapai tahap optimum 80.1%.

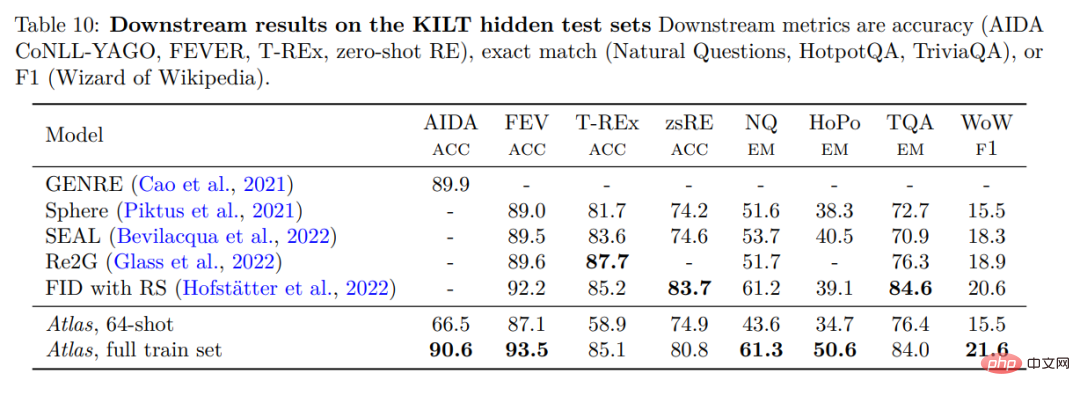

Untuk mengesahkan prestasi Atlas, Atlas telah dinilai pada KILT, penanda aras yang terdiri daripada beberapa tugas berintensif pengetahuan yang berbeza. Jadual di bawah menunjukkan keputusan pada set ujian.

Atlas 64-shot jauh mengatasi prestasi algoritma rawak dalam eksperimen, malah memadankan beberapa algoritma yang diperhalusi pada papan pendahulu. model adalah setanding. Contohnya, pada FEVER, Atlas 64-shot hanya 2-2.5 mata di belakang Sphere, SEAL dan Re2G, manakala pada zero-shot RE ia mengatasi Sphere dan SEAL. Pada set data penuh, prestasi Atlas berada dalam lingkungan 3% daripada model terbaik dalam 3 set data, tetapi ini adalah yang terbaik dalam 5 set data yang selebihnya.

Atas ialah kandungan terperinci Bilangan parameter ialah 1/50, Meta mengeluarkan 11 bilion model parameter, mengalahkan Google PaLM. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI