Rumah >Peranti teknologi >AI >Ralat label ImageNet dialih keluar, kedudukan model berubah dengan ketara

Ralat label ImageNet dialih keluar, kedudukan model berubah dengan ketara

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 17:46:111217semak imbas

Sebelum ini, ImageNet menjadi topik hangat kerana masalah ralat label Anda mungkin terkejut mendengar nombor ini sekurang-kurangnya 100,000 label bermasalah. Kajian berdasarkan label yang salah mungkin perlu dibatalkan dan diulang.

Dari sudut pandangan ini, mengurus kualiti set data masih sangat penting.

Ramai orang akan menggunakan set data ImageNet sebagai penanda aras, tetapi berdasarkan model pra-latihan ImageNet, keputusan akhir mungkin berbeza-beza disebabkan kualiti data.

Dalam artikel ini, Kenichi Higuchi, seorang jurutera dari Syarikat Adansons, mengkaji semula set data ImageNet dalam artikel "Are we done with ImageNet?" Selepas mengalih keluar data label yang salah dinilai semula dan diterbitkan pada model torchvision.

Alih keluar data yang salah daripada ImageNet dan nilai semula model

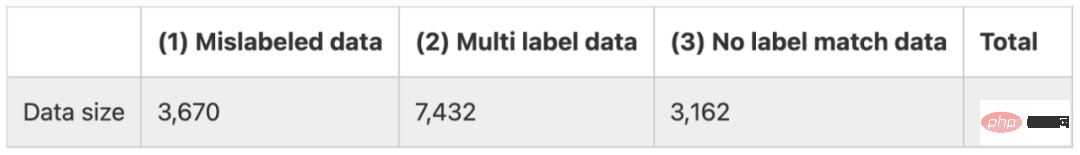

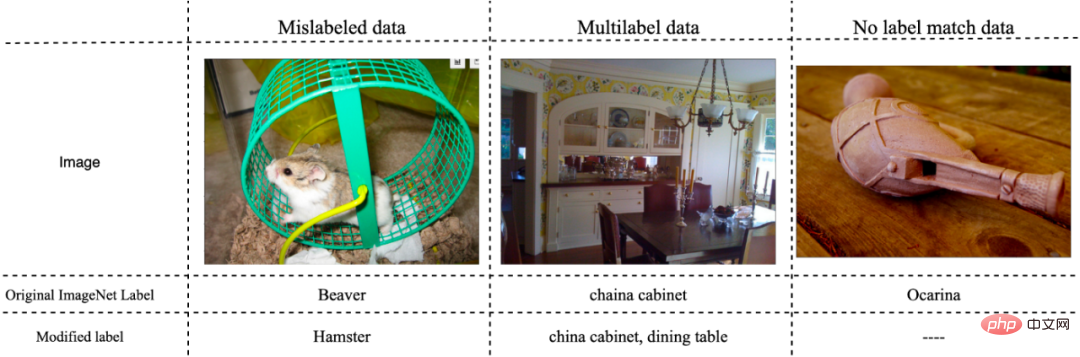

Kertas ini membahagikan ralat pelabelan dalam ImageNet kepada tiga kategori, seperti yang ditunjukkan di bawah.

(1) Data dengan pelabelan yang salah

(2) Data yang sepadan dengan berbilang teg

(3) Data yang bukan milik mana-mana teg

Ringkasnya, terdapat lebih kurang 14,000 data yang tersilap memandangkan bilangan data penilaian ialah 50,000, dapat dilihat bahawa nisbah data yang salah adalah sangat tinggi. . Rajah di bawah menunjukkan beberapa data ralat yang mewakili.

Kaedah

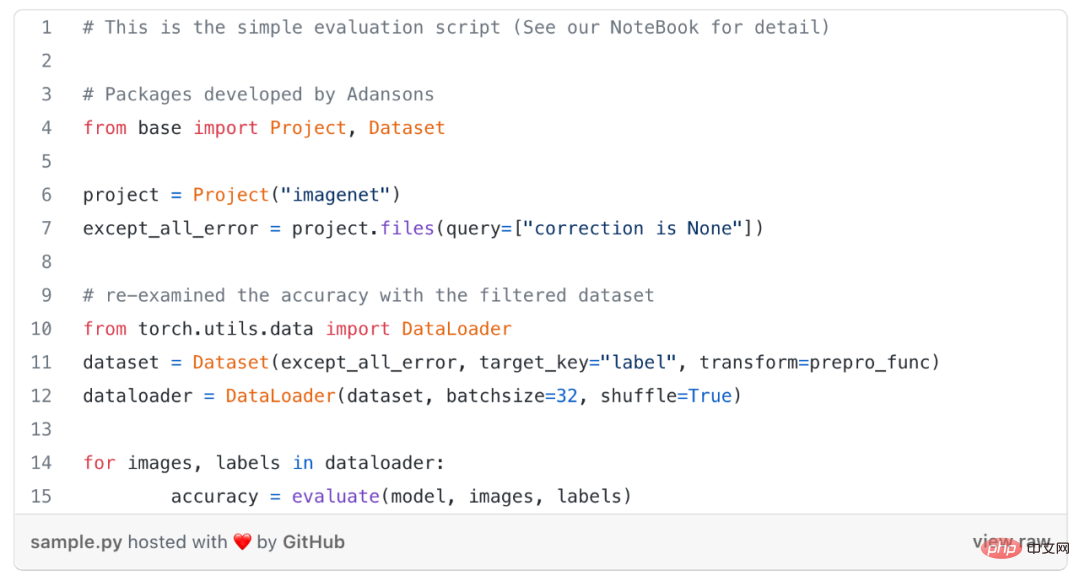

Tanpa melatih semula model, kajian ini hanya mengecualikan data yang dilabelkan secara salah, iaitu di atas- jenis (1) data yang salah, dan tidak termasuk semua data yang salah daripada data penilaian, iaitu, (1)-(3) data yang salah, untuk menyemak semula ketepatan model.

Untuk mengalih keluar data yang salah, fail metadata yang menerangkan maklumat ralat teg diperlukan. Dalam fail metadata ini, jika ia mengandungi ralat jenis (1)-(3), maklumat akan diterangkan dalam atribut "pembetulan".

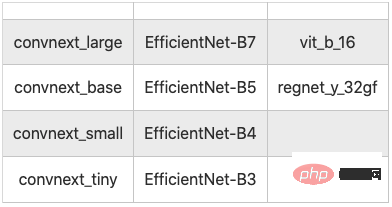

Kajian ini menggunakan alat yang dipanggil Adansons Base, yang menapis data dengan memautkan set data kepada metadata. 10 model telah diuji di sini seperti yang ditunjukkan di bawah.

10 model klasifikasi imej untuk ujian

Keputusan

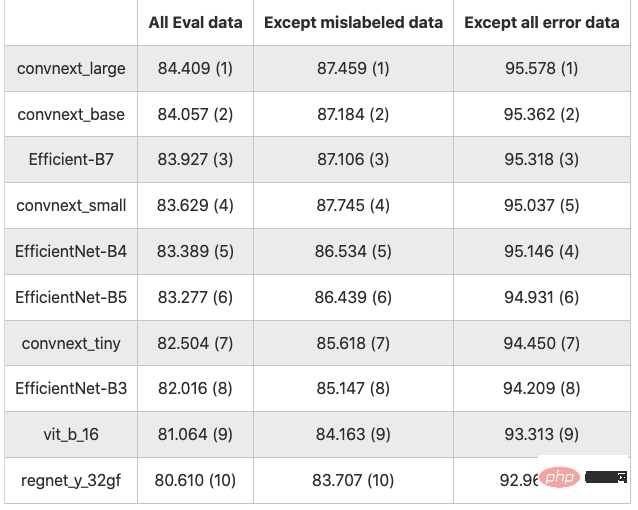

Keputusan ditunjukkan dalam jadual di bawah (angka nilai ialah ketepatan dalam %, nombor dalam kurungan ialah kedudukan)

Hasil 10 model klasifikasi

Dengan Semua Data eval ialah garis asas. Tidak termasuk jenis data yang salah (1), ketepatan meningkat sebanyak purata 3.122 mata. Tidak termasuk semua data yang salah (1) hingga (3), ketepatan meningkat sebanyak purata 11.743 mata.

Seperti yang dijangka, tidak termasuk data yang salah, kadar ketepatan dipertingkatkan secara menyeluruh. Tidak dinafikan bahawa berbanding dengan data bersih, data yang salah terdedah kepada ralat.

Kedudukan ketepatan model berubah apabila penilaian dilakukan tanpa mengecualikan data yang salah dan apabila data yang salah (1)~(3) semuanya dikecualikan.

Dalam artikel ini, terdapat 3,670 data yang salah (1), menyumbang 7.34% daripada jumlah 50,000 keping data Selepas dialih keluar, kadar ketepatan meningkat kira-kira 3.22 mata secara purata. Apabila data yang salah dialih keluar, skala data berubah dan perbandingan mudah kadar ketepatan mungkin berat sebelah.

Kesimpulan

Walaupun tidak begitu ditekankan, adalah penting untuk menggunakan data yang dilabel dengan tepat semasa melakukan latihan penilaian.

Kajian terdahulu mungkin telah membuat kesimpulan yang salah apabila membandingkan ketepatan antara model. Jadi data harus dinilai terlebih dahulu, tetapi bolehkah ini benar-benar digunakan untuk menilai prestasi model?

Banyak model yang menggunakan pembelajaran mendalam sering meremehkan data, tetapi tidak sabar-sabar untuk meningkatkan ketepatan dan metrik penilaian lain melalui prestasi model, walaupun data penilaian mengandungi data yang salah dengan tepat.

Apabila mencipta set data anda sendiri, seperti semasa menggunakan AI dalam perniagaan, mencipta set data berkualiti tinggi secara langsung berkaitan dengan meningkatkan ketepatan dan kebolehpercayaan AI. Keputusan eksperimen kertas ini menunjukkan bahawa hanya meningkatkan kualiti data boleh meningkatkan ketepatan kira-kira 10 mata peratusan, yang menunjukkan kepentingan untuk menambah baik bukan sahaja model tetapi juga set data semasa membangunkan sistem AI.

Walau bagaimanapun, memastikan kualiti set data bukanlah mudah. Walaupun meningkatkan jumlah metadata adalah penting untuk menilai kualiti model dan data AI dengan betul, ia boleh menyusahkan untuk diurus, terutamanya dengan data tidak berstruktur.

Atas ialah kandungan terperinci Ralat label ImageNet dialih keluar, kedudukan model berubah dengan ketara. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI