Rumah >Peranti teknologi >AI >Kertas kerja yang sangat dipuji oleh pengulas semasa peringkat semakan buta ICLR: Adakah ia akan menjadi inovasi utama dalam seni bina Transformer?

Kertas kerja yang sangat dipuji oleh pengulas semasa peringkat semakan buta ICLR: Adakah ia akan menjadi inovasi utama dalam seni bina Transformer?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 17:31:03892semak imbas

Walaupun banyak pencapaian yang ketara, kemajuan praktikal dalam melatih rangkaian saraf dalam (DNN) sebahagian besarnya tidak bergantung pada asas teori. Kebanyakan DNN moden yang berjaya bergantung pada susunan khusus sambungan baki dan lapisan normalisasi, tetapi prinsip umum cara menggunakan komponen ini dalam seni bina baharu masih tidak diketahui, dan peranannya dalam seni bina sedia ada masih belum difahami sepenuhnya.

Seni bina sisa adalah yang paling popular dan berjaya, pada asalnya dibangunkan dalam konteks rangkaian neural konvolusi (CNN) dan kemudiannya muncul di mana-mana daripada seni bina pengubah rangkaian perhatian. Satu sebab kejayaan seni bina sisa adalah perambatan isyarat yang lebih baik berbanding DNN biasa, di mana perambatan isyarat merujuk kepada penghantaran maklumat geometri melalui lapisan DNN dan diwakili oleh fungsi kernel.

Baru-baru ini, menggunakan prinsip perambatan isyarat untuk melatih DNN yang lebih mendalam tanpa penglibatan sambungan baki dan/atau lapisan normalisasi dalam seni bina sisa telah menjadi bidang kepentingan masyarakat. Sebabnya adalah dua kali ganda: pertama ia mengesahkan hipotesis penyebaran isyarat untuk keberkesanan seni bina sisa, sekali gus menjelaskan pemahaman kebolehtafsiran DNN, kedua ini mungkin membolehkan prinsip dan kaedah am untuk kebolehlatihan DNN di luar paradigma sisa.

Bagi CNN, hasil kerja Xiao et al (2018) menunjukkan bahawa perambatan isyarat yang lebih baik melalui permulaan yang lebih baik boleh melatih rangkaian dalam biasa dengan cekap, walaupun. jauh lebih perlahan daripada rangkaian sisa. Kerja Martens et al. (2021) mencadangkan Deep Kernel Shaping (DKS), yang menggunakan transformasi fungsi pengaktifan untuk mengawal perambatan isyarat, dan menggunakan pengoptimum tertib kedua yang kuat seperti K-FAC untuk melaksanakan latihan rangkaian biasa dan rangkaian sisa pada ImageNet. Kelajuan adalah sama. Hasil kerja Zhang et al (2022) memanjangkan DKS kepada kelas fungsi pengaktifan yang lebih besar dan mencapai kesamaan hampir dalam generalisasi.

Kuantiti utama untuk dianalisis dalam perambatan isyarat ialah kernel masa permulaan DNN, atau lebih tepat lagi, anggaran kernel di bawah had lebar tak terhingga. Untuk perceptron berbilang lapisan (MLP) dan CNN yang menggunakan permulaan delta, kernel boleh ditulis sebagai rekursi lapisan mudah yang mengandungi hanya fungsi 2D untuk memudahkan analisis mudah. Evolusi kernel transformer rentas lapisan adalah lebih kompleks, jadi kaedah sedia ada seperti DKS tidak sesuai untuk transformer atau sememangnya mana-mana seni bina yang mengandungi lapisan perhatian kendiri.

Dalam MLP, perambatan isyarat dinilai dengan melihat tingkah laku kernel (satu dimensi), manakala perambatan isyarat dalam transformer boleh dinilai dengan melihat (dimensi tinggi ) matriks kernel pada lapisan rangkaian Berdasarkan evolusi dalam .

Kajian ini mesti mengelakkan situasi di mana unsur pepenjuru tumbuh atau mengecut dengan cepat dengan kedalaman yang semakin meningkat, yang berkaitan dengan norma pengaktifan yang tidak terkawal dan boleh menyebabkan kehilangan ketepuan atau masalah berangka . Mengelakkan keruntuhan pangkat adalah perlu untuk kebolehlatihan transformer dalam, dan sama ada transformer bebas sisa dalam boleh dilatih masih menjadi persoalan terbuka.

Kertas kerja dari peringkat semakan buta ICLR 2023 ini menyelesaikan masalah ini dan menunjukkan buat kali pertama bahawa adalah mungkin untuk berjaya melatih transformer dalam tanpa sambungan baki atau lapisan normalisasi. Untuk tujuan ini, mereka mengkaji perambatan isyarat dan masalah keruntuhan kedudukan dalam transformer bebas sisa dalam dan memperoleh tiga kaedah untuk menghalangnya. Khususnya, pendekatan ini menggunakan gabungan pemulaan parameter, matriks pincang dan penskalaan semula bergantung kepada kedudukan, dan menyerlahkan beberapa kerumitan khusus untuk perambatan isyarat dalam transformer, termasuk interaksi dengan pengekodan kedudukan dan penyekat sebab. Para penyelidik secara empirik menunjukkan bahawa kaedah mereka boleh menjana transformer bebas sisa yang boleh dilatih dalam.

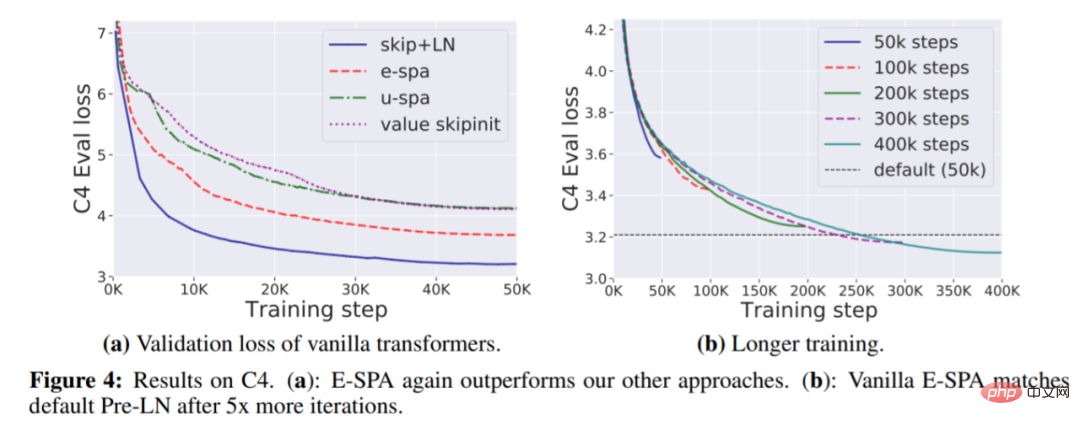

Dalam bahagian percubaan, pada set data WikiText-103 dan C4, para penyelidik menunjukkan penggunaan kaedah utama mereka - Exponential Signal Preserving Attention (E- SPA), boleh membuat kehilangan latihan pengubah piawai yang setanding dengan pengubah sisa dalam kertas dengan memanjangkan masa latihan kira-kira lima kali. Di samping itu, dengan menggabungkan kaedah ini dengan sambungan baki, penyelidik juga menunjukkan bahawa transformer tanpa lapisan normalisasi boleh mencapai kelajuan latihan yang setanding dengan transformer standard.

Alamat kertas: https://openreview.net/pdf?id=NPrsUQgMjKK

Berkenaan kertas kerja ini, Rohan Anil, ketua jurutera Google AI, percaya bahawa ia adalah satu langkah besar ke hadapan untuk seni bina Transformer dan peningkatan asas.

Membina Transformer dalam yang boleh dilatih tanpa pintasan

Setakat ini, satu-satunya strategi untuk membetulkan keruntuhan pangkat Transformer bergantung pada sambungan baki, yang Pendekatan ini dilangkau isu kebolehlatihan yang wujud pada lapisan perhatian diri. Sebaliknya, kajian ini secara langsung menjawab persoalan ini. Mula-mula lebih memahami perambatan isyarat melalui lapisan perhatian, dan kemudian ubah suai berdasarkan cerapan untuk mencapai penghantaran isyarat yang setia dalam transformer dalam, yang boleh dilatih dengan atau tanpa sambungan baki.

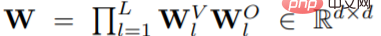

Secara khusus, pertama, kajian menjalankan tetapan mudah pengubah vanila dalam dengan hanya perhatian, dan kemudian mereka menganggap bahawa pengubah mempunyai tetapan kepala tunggal (h = 1) atau Dengan persediaan berbilang kepala, di mana matriks perhatian A tidak berubah antara kepala yang berbeza. Jika blok l≤L mempunyai matriks perhatian A_l apabila dimulakan, perwakilan blok akhir ialah

dan

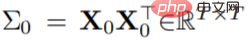

mengguna pakai pemulaan ortogon, kemudian  boleh berbentuk ortogon semasa pemulaan.

boleh berbentuk ortogon semasa pemulaan.  Di bawah andaian di atas, jika

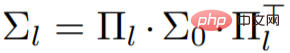

Di bawah andaian di atas, jika  digunakan untuk mewakili matriks isirong input kedudukan silang, selepas beberapa penyederhanaan, formula berikut boleh diperolehi:

digunakan untuk mewakili matriks isirong input kedudukan silang, selepas beberapa penyederhanaan, formula berikut boleh diperolehi:

Daripada formula yang dipermudahkan ini (matriks kernel dalam pengubah perhatian-sahaja dalam), tiga keperluan untuk (A_l)_l boleh ditentukan:

Daripada formula yang dipermudahkan ini (matriks kernel dalam pengubah perhatian-sahaja dalam), tiga keperluan untuk (A_l)_l boleh ditentukan:

A_l hendaklah segi tiga lebih rendah ∀l agar serasi dengan perhatian topeng sebab.

A_l hendaklah segi tiga lebih rendah ∀l agar serasi dengan perhatian topeng sebab.

Dalam bahagian 3.1 dan 3.2 seterusnya, penyelidikan memberi tumpuan kepada mencari matriks perhatian yang memenuhi keperluan di atas, dan mereka mencadangkan 3 kaedah E-SPA, U- SPA dan Nilai-Skipinit, setiap kaedah digunakan untuk mengawal matriks perhatian pengubah, membolehkan perambatan isyarat setia walaupun pada kedalaman yang dalam. Tambahan pula, Bahagian 3.3 menunjukkan bagaimana perhatian softmax boleh diubah suai untuk melaksanakan matriks perhatian ini.

-

Dalam rajah di bawah, kajian itu mengesahkan dua cadangan skim SPA, U-SPA dan E-SPA Hasilnya menunjukkan bahawa ia berjaya mengelak walaupun rangkaian Pay perhatian hanya kepada fenomena kejatuhan pangkat dalam transformer vanila.

Dalam rajah di bawah, kajian itu mengesahkan dua cadangan skim SPA, U-SPA dan E-SPA Hasilnya menunjukkan bahawa ia berjaya mengelak walaupun rangkaian Pay perhatian hanya kepada fenomena kejatuhan pangkat dalam transformer vanila.

-

Eksperimen

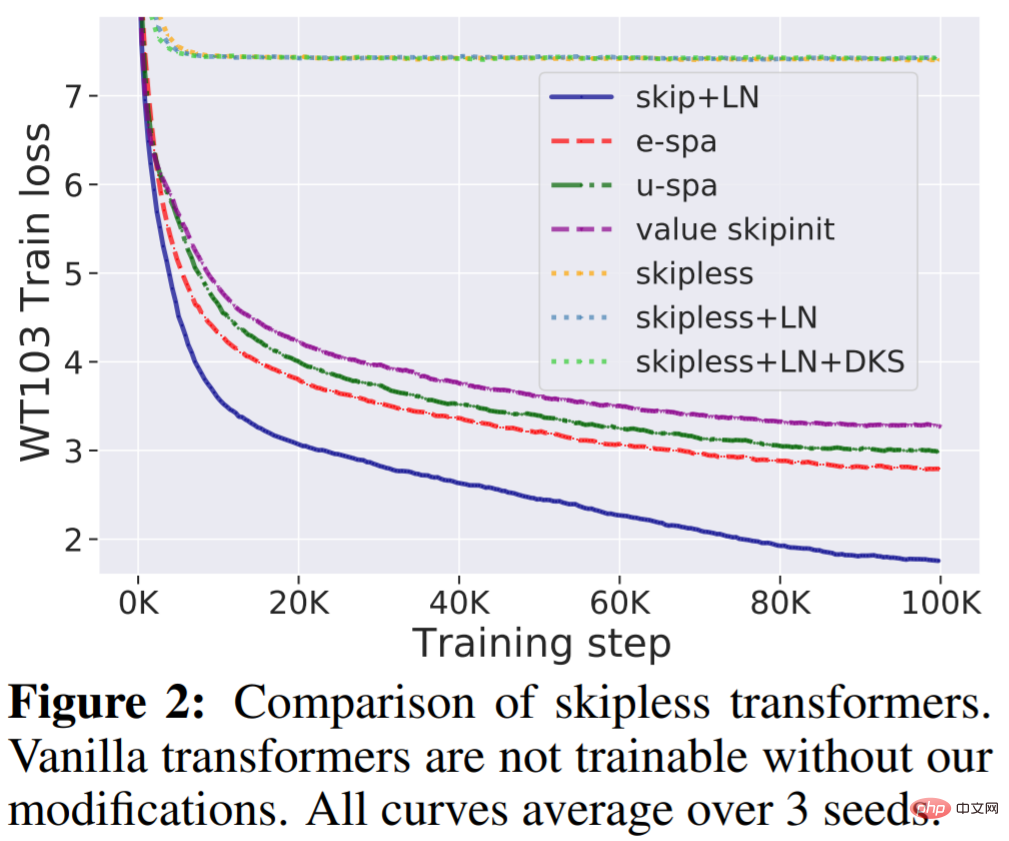

WikiText-103 Baseline: Pertama, kajian ini mengesahkan bahawa transformer dalam standard tanpa sambungan baki tidak boleh dilatih, walaupun ia mempunyai lapisan normalisasi (LN) dan pengaktifan berubah, tetapi kaedahnya dalam artikel ini boleh menyelesaikan masalah ini. Seperti yang ditunjukkan dalam Rajah 2, dapat dilihat dengan jelas bahawa mengalihkan sambungan baki daripada pengubah standard menjadikannya tidak boleh dilatih, dan kehilangan latihan menjadi stabil pada sekitar 7.5. Seperti yang ditunjukkan dalam Rajah 1, pengubah piawai mengalami keruntuhan pangkat.

Sebaliknya, kaedah E-SPA yang dicadangkan dalam kajian ini mengatasi prestasi U-SPA dan Value-Skipinit. Walau bagaimanapun, pengubah lalai dengan baki dan LN masih mengekalkan kelebihan kelajuan latihan berbanding kaedah bebas baki kami.

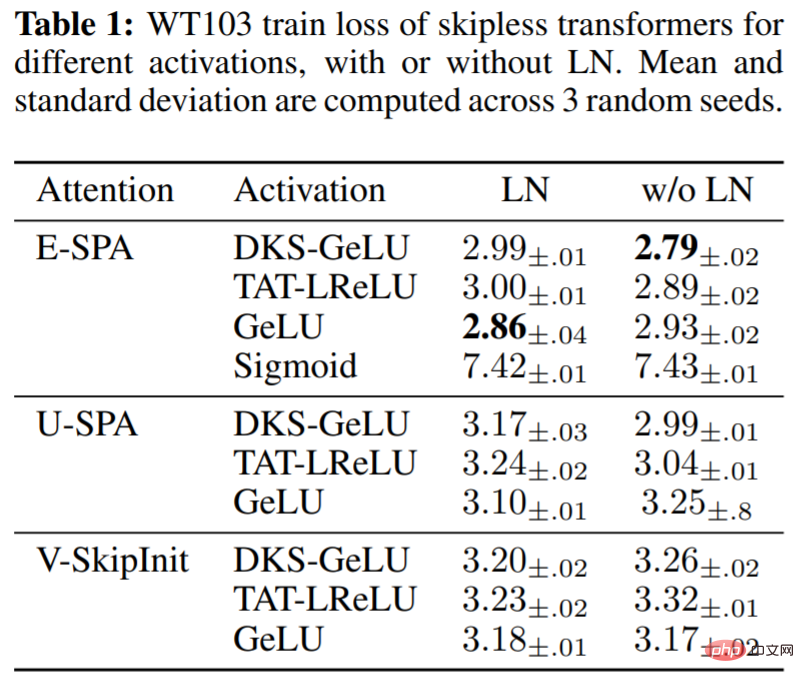

Dalam Jadual 1, kajian menilai kesan fungsi pengaktifan yang berbeza dalam blok MLP menggunakan kaedah yang dicadangkan, serta penggunaan LN dalam pengubah bebas sisa. Dapat dilihat bahawa pada kedalaman 36, kaedah kami mencapai prestasi latihan yang baik untuk satu siri pengaktifan: GeLU yang diubah DKS, ReLU Bocor yang diubah TAT dan GeLU yang tidak diubah, tetapi bukan Sigmoid yang tidak diubah. Ia juga telah dilihat secara eksperimen bahawa normalisasi lapisan adalah agak tidak penting untuk kelajuan latihan dan bahkan boleh memudaratkan pengaktifan berubah apabila menggunakan SPA, yang sudah mempunyai mekanisme terbina dalam untuk mengawal spesifikasi pengaktifan.

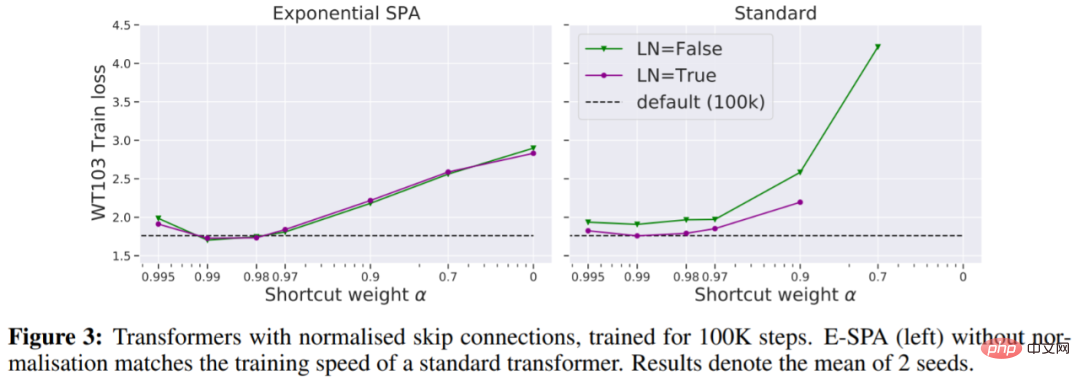

Dalam Rajah 3, kita melihat bahawa satu cara untuk memadankan kehilangan latihan pengubah lalai tanpa memerlukan lebih banyak lelaran ialah menggunakan sambungan baki normalisasi.

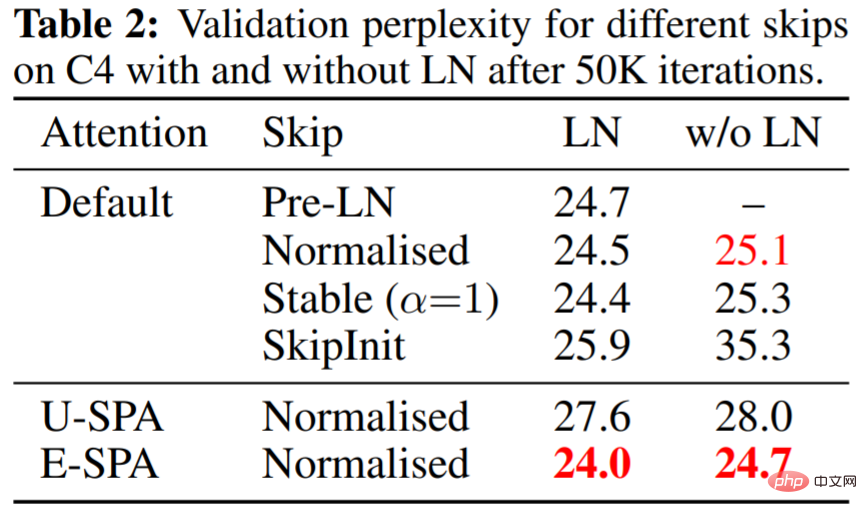

Jadual 2 menunjukkan bahawa E-SPA dengan sisa ternormal dan LN mengatasi prestasi pengubah PreLN lalai.

Rajah 4(a) di bawah menunjukkan bahawa E-SPA sekali lagi mengatasi kaedah lain 4(b) menunjukkan bahawa jurang kehilangan latihan boleh ditingkatkan dengan hanya masa Latihan untuk menghapuskan.

Atas ialah kandungan terperinci Kertas kerja yang sangat dipuji oleh pengulas semasa peringkat semakan buta ICLR: Adakah ia akan menjadi inovasi utama dalam seni bina Transformer?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI