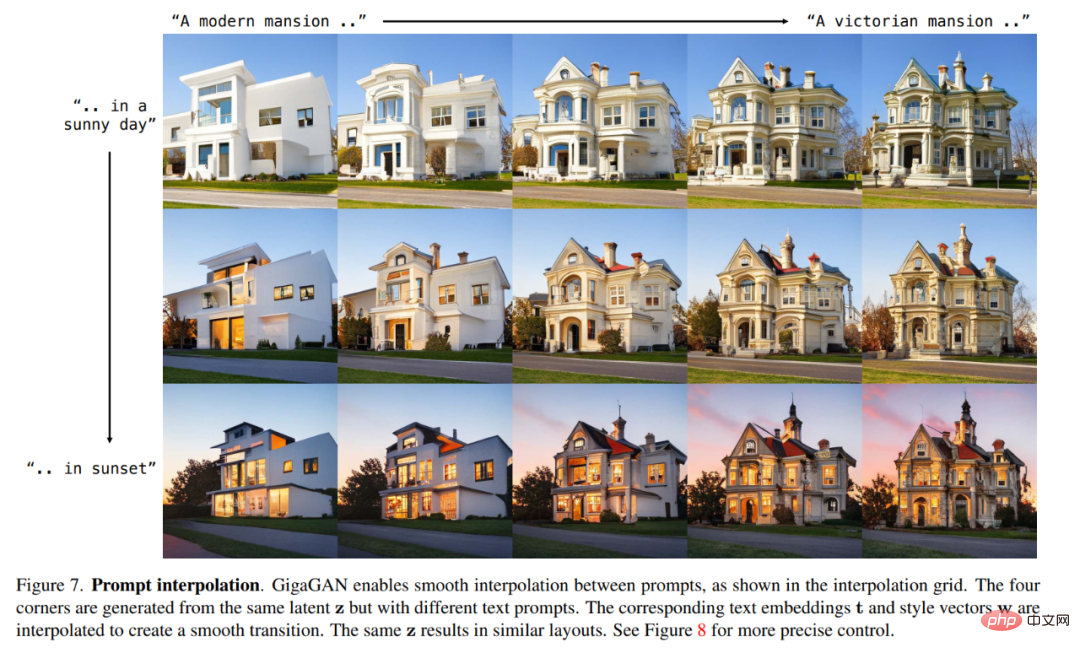

Rumah >Peranti teknologi >AI >Serangan balas GAN: Kerja CVPR baharu Zhu Junyan GigaGAN, kelajuan output imej mengatasi Stable Diffusion

Serangan balas GAN: Kerja CVPR baharu Zhu Junyan GigaGAN, kelajuan output imej mengatasi Stable Diffusion

- PHPzke hadapan

- 2023-04-12 15:43:031523semak imbas

Penjanaan imej ialah salah satu arah paling popular dalam medan AIGC. Model penjanaan imej yang dikeluarkan baru-baru ini seperti DALL・E 2, Imagen, Stable Diffusion, dsb. telah memulakan era baharu penjanaan imej, mencapai tahap kualiti imej dan fleksibiliti model yang belum pernah terjadi sebelumnya. Model resapan juga telah menjadi paradigma yang dominan pada masa kini. Walau bagaimanapun, model resapan bergantung pada inferens berulang, yang merupakan pedang bermata dua kerana kaedah lelaran boleh mencapai latihan yang stabil dengan objektif mudah, tetapi proses inferens memerlukan kos pengiraan yang tinggi.

Sebelum model penyebaran, rangkaian adversarial generatif (GAN) ialah infrastruktur yang biasa digunakan dalam model penjanaan imej. Berbanding dengan model resapan, GAN menjana imej melalui satu pas ke hadapan dan oleh itu sememangnya lebih cekap, tetapi disebabkan ketidakstabilan proses latihan, penskalaan GAN memerlukan penalaan teliti seni bina rangkaian dan faktor latihan. Oleh itu, GAN pandai memodelkan kelas objek tunggal atau berbilang, tetapi sangat mencabar untuk skala kepada set data yang kompleks (apatah lagi dunia nyata). Akibatnya, model, data dan sumber pengiraan yang sangat besar kini didedikasikan untuk model penyebaran dan autoregresif.

Tetapi sebagai kaedah penjanaan yang cekap, ramai penyelidik tidak meninggalkan sepenuhnya kaedah GAN. Sebagai contoh, NVIDIA baru-baru ini mencadangkan model StyleGAN-T Cina dan lain-lain menggunakan kaedah berasaskan GAN untuk menjana video lancar Ini adalah percubaan lanjut oleh penyelidik CV pada GAN.

Kini, dalam kertas kerja CVPR 2023, penyelidik dari POSTECH, Carnegie Mellon University dan Adobe Research bersama-sama meneroka beberapa isu penting tentang GAN, termasuk:

- Bolehkah GAN terus meningkat dan mendapat manfaat daripada sumber yang besar Adakah GAN menghadapi masalah?

- Apakah yang menghalang pengembangan GAN selanjutnya, dan bolehkah kita mengatasi halangan ini?

- Pautan kertas: https://arxiv.org/abs/2303.05511

- Pautan projek: https://mingukkang.github.io/GigaGAN/

Perlu diingat bahawa Zhu Junyan, pengarang utama CycleGAN dan pemenang Anugerah Tesis Kedoktoran Terbaik ACM SIGGRAPH 2018, ialah pengarang kedua kertas CVPR ini.

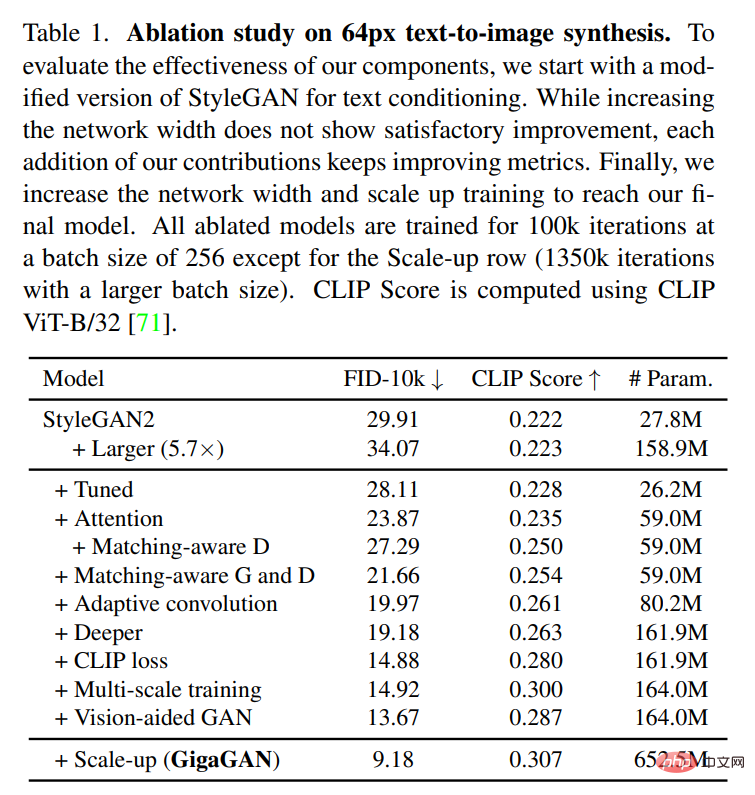

Kajian itu mula-mula menjalankan eksperimen menggunakan StyleGAN2 dan mendapati bahawa hanya memanjangkan rangkaian tulang belakang mengakibatkan latihan yang tidak stabil. Berdasarkan ini, para penyelidik mengenal pasti beberapa isu utama dan mencadangkan teknik untuk menstabilkan latihan sambil meningkatkan kapasiti model.

Pertama, kajian ini secara berkesan mengembangkan kapasiti penjana dengan mengekalkan set penapis dan menggunakan kombinasi linear khusus sampel. Kajian itu juga menggunakan beberapa teknik yang biasa digunakan dalam konteks penyebaran dan mengesahkan bahawa ia membawa faedah yang sama kepada GAN. Contohnya, jalinan perhatian diri (imej sahaja) dan perhatian silang (teks imej) dengan lapisan konvolusi boleh meningkatkan prestasi model.

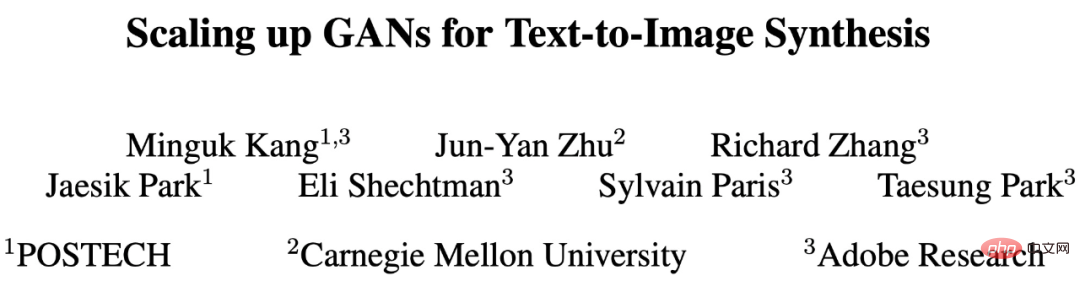

Penyelidikan ini juga memperkenalkan semula latihan berskala dan mencadangkan skema baharu untuk menambah baik penjajaran teks imej dan menjana butiran output frekuensi rendah. Latihan berbilang skala membolehkan penjana berasaskan GAN menggunakan parameter dalam blok resolusi rendah dengan lebih cekap, menghasilkan penjajaran teks imej dan kualiti imej yang lebih baik. Selepas pelarasan yang teliti, kajian ini mencadangkan model GigaGAN baharu dengan satu bilion parameter dan mencapai latihan yang stabil dan berskala pada set data yang besar (seperti LAION2B-en Keputusan eksperimen ditunjukkan dalam Rajah 1 di bawah).

Selain itu, kajian ini juga menggunakan kaedah berbilang peringkat [14, 104], pertama menggunakan kaedah rendah- tahap 64 × 64 Imej dijana pada resolusi 512 × 512 dan kemudian ditingkatkan kepada resolusi 512 × 512. Kedua-dua rangkaian adalah modular dan cukup berkuasa untuk digunakan secara plug-and-play.

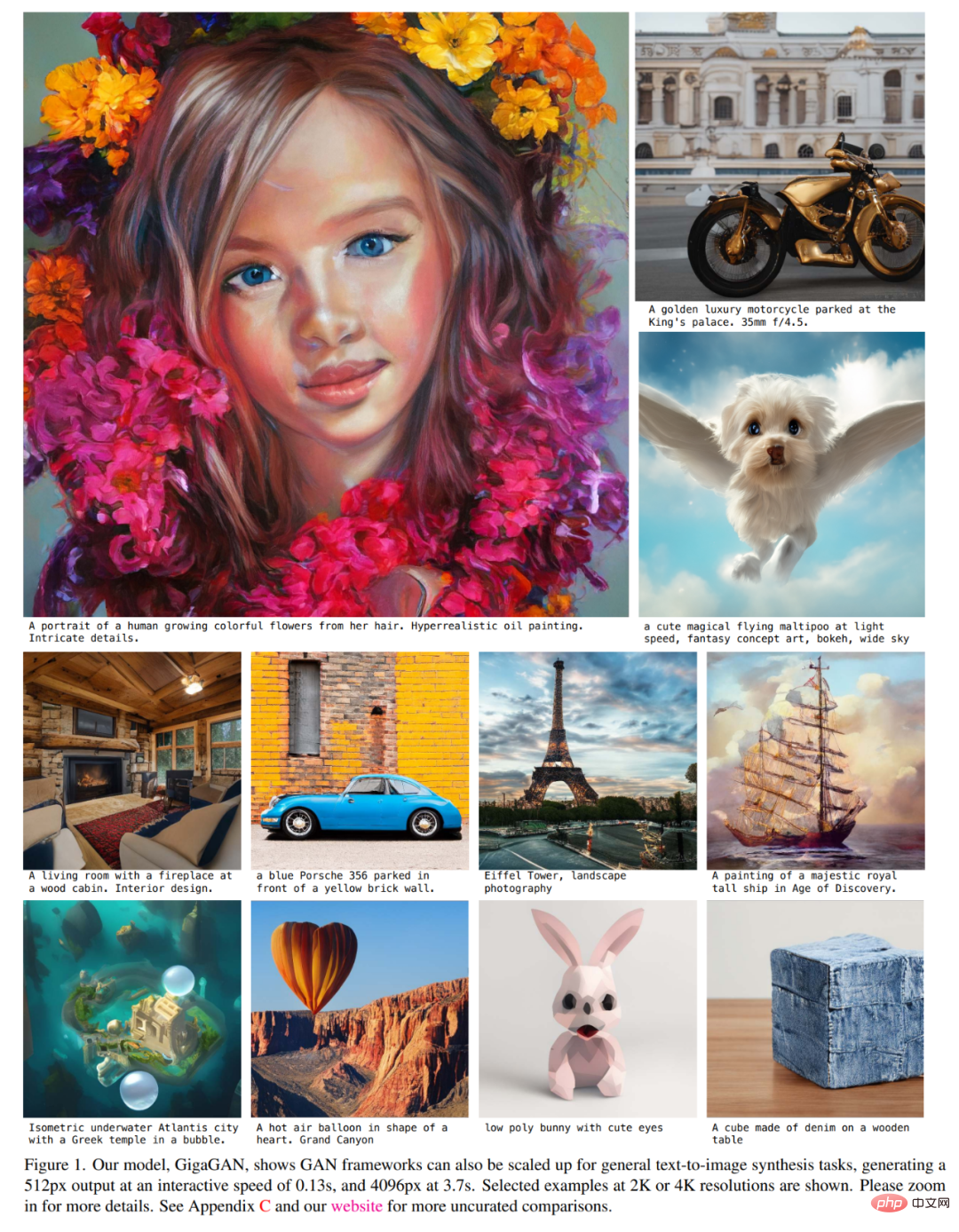

Kajian ini menunjukkan bahawa rangkaian pensampelan GAN berkondisi teks boleh digunakan sebagai pensampel naik yang cekap dan berkualiti tinggi untuk model resapan asas, seperti yang ditunjukkan dalam Rajah 2 dan 3 di bawah.

Peningkatan di atas menjadikan GigaGAN jauh melebihi GAN sebelumnya: 36 kali lebih besar daripada StyleGAN2 dan 6 kali lebih besar daripada StyleGAN-XL dan XMC-GAN . Walaupun kiraan parameter GigaGAN sebanyak satu bilion (1B) masih lebih rendah daripada model sintetik besar baru-baru ini seperti Imagen (3.0B), DALL・E 2 (5.5B) dan Parti (20B), para penyelidik mengatakan bahawa mereka masih belum melakukannya. diperhatikan sebarang perubahan ketara dalam model Kualiti saiz adalah tepu.

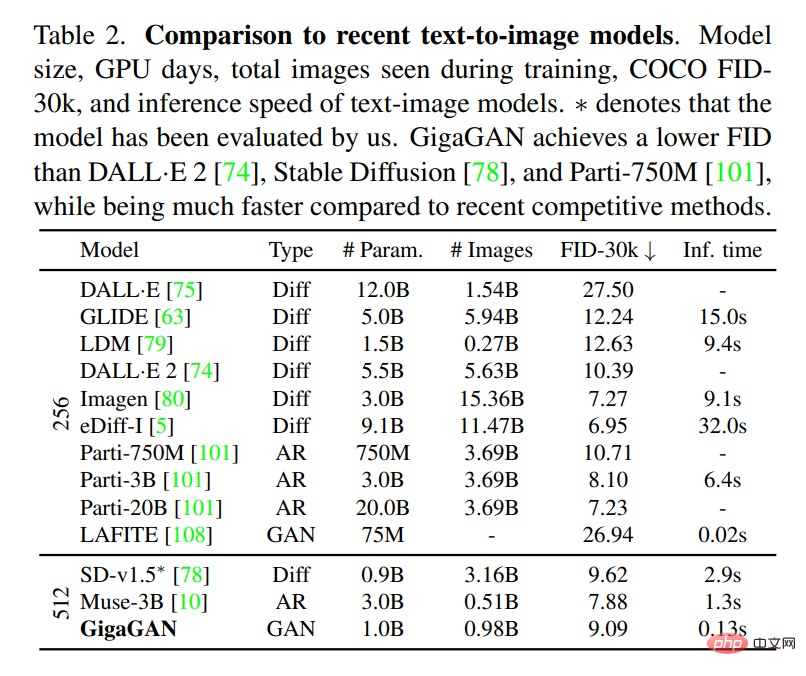

GigaGAN mencapai FID sampel sifar sebanyak 9.09 pada set data COCO2014, yang lebih rendah daripada DALL・E 2, Parti-750M dan Stable Diffusion.

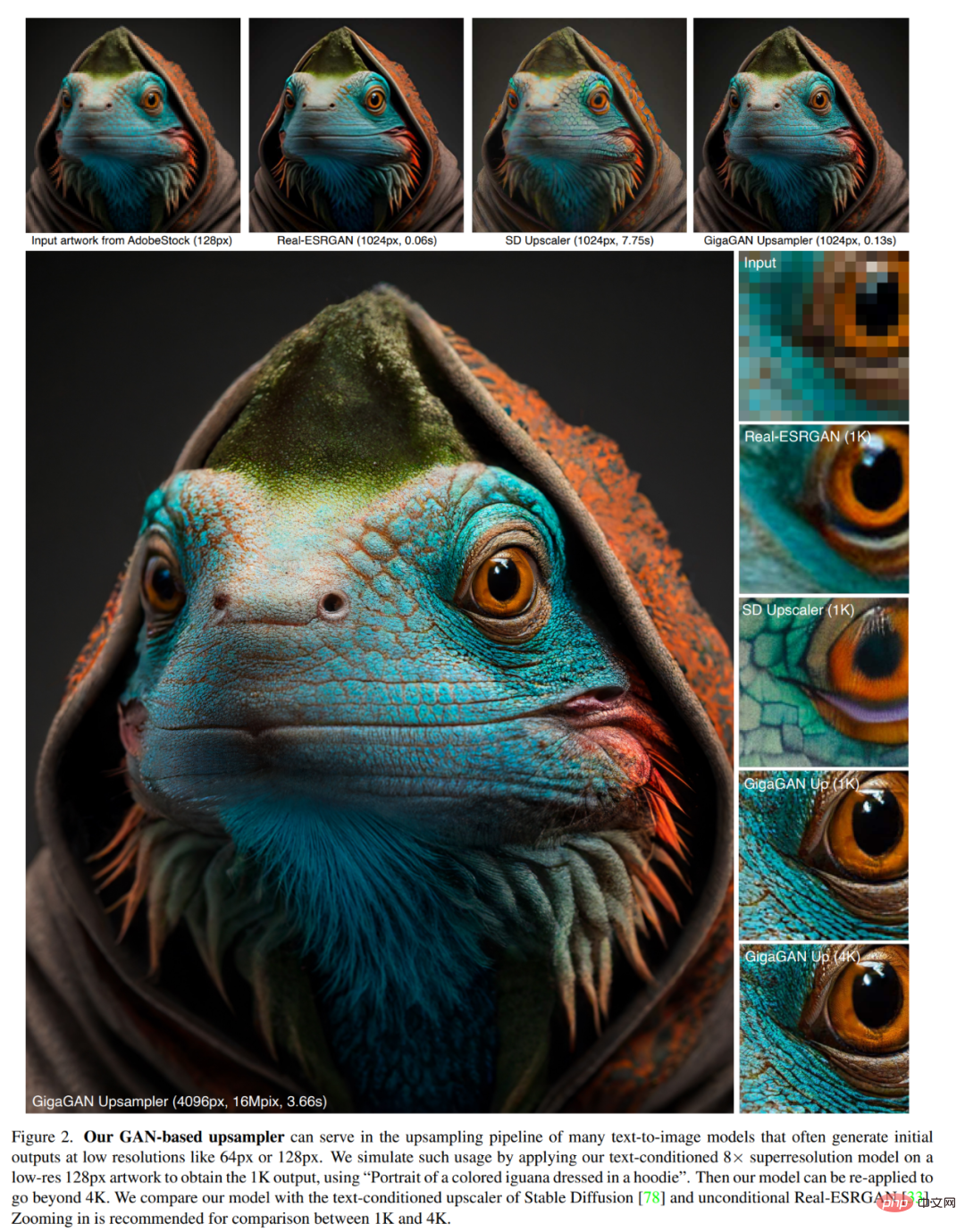

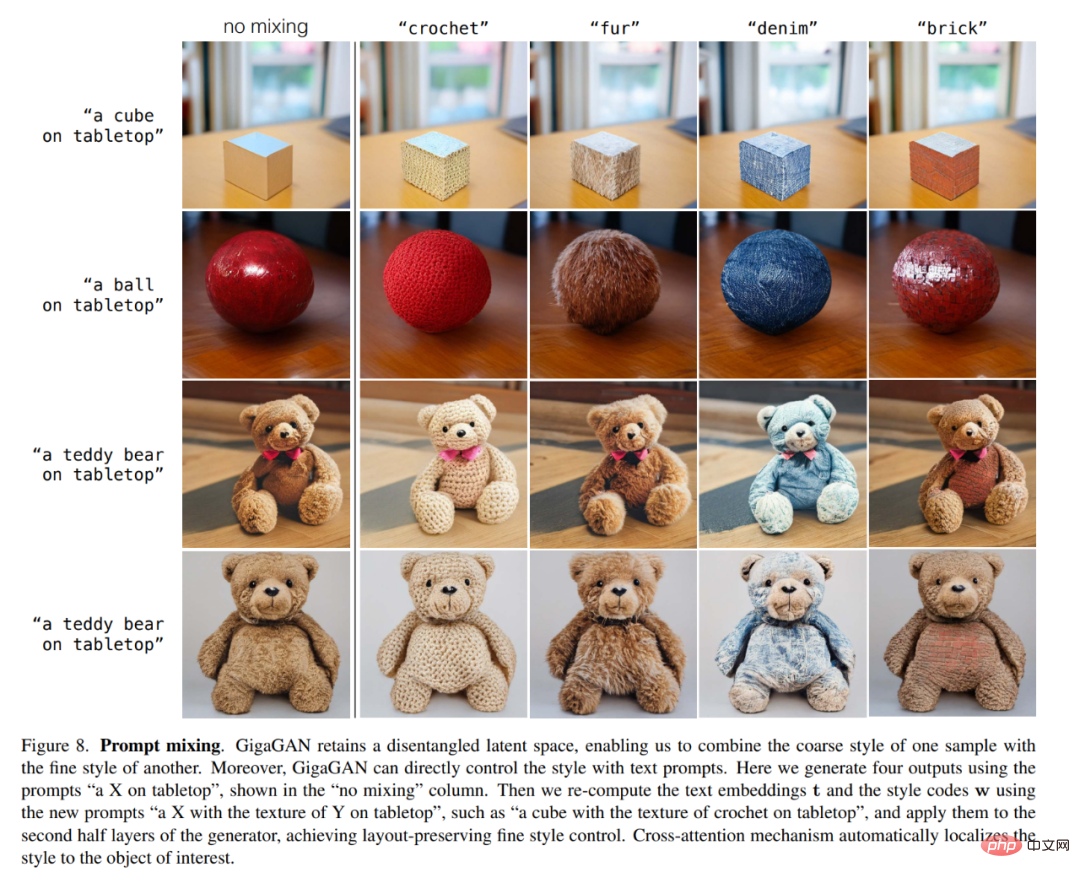

Selain itu, GigaGAN mempunyai tiga kelebihan praktikal utama berbanding dengan model resapan dan model autoregresif. Pertama, ia berpuluh-puluh kali lebih pantas, menghasilkan imej 512 piksel dalam 0.13 saat (Rajah 1). Kedua, ia boleh mensintesis imej resolusi ultra tinggi pada resolusi 4k dalam masa 3.66 saat sahaja. Ketiga, ia mempunyai ruang vektor pendam terkawal yang sesuai untuk aplikasi sintesis imej terkawal yang dikaji dengan baik, seperti pengadunan gaya (Rajah 6), interpolasi segera (Rajah 7), dan pengadunan segera (Rajah 8).

Penyelidikan ini berjaya melatih model skala bilion parameter berasaskan GAN GigaGAN pada berbilion imej dunia sebenar. Ini menunjukkan bahawa GAN kekal sebagai pilihan yang berdaya maju untuk sintesis teks ke imej dan penyelidik harus mempertimbangkannya untuk pengembangan masa depan yang agresif.

Tinjauan Keseluruhan Kaedah

Penyelidik melatih penjana G (z, c), diberi pengekodan terpendam z∼N (0, 1)∈R ^128 dan teks isyarat pelaziman c, ramalkan imej x∈R^(H×W×3). Mereka menggunakan diskriminator D(x, c) untuk menilai ketulenan imej yang dijana berbanding sampel dalam pangkalan data latihan D, yang mengandungi pasangan teks imej.

Walaupun GAN berjaya menjana imej realistik pada set data tunggal dan berbilang kelas, sintesis bersyarat teks terbuka pada imej Internet masih menghadapi cabaran. Para penyelidik membuat hipotesis bahawa batasan semasa berpunca daripada pergantungannya pada lapisan konvolusi. Iaitu, penapis konvolusi yang sama digunakan untuk memodelkan fungsi sintesis imej universal untuk semua keadaan teks di semua lokasi dalam imej, yang merupakan satu cabaran. Memandangkan perkara ini, penyelidik cuba menyuntik lebih ekspresif ke dalam parameterisasi dengan memilih penapis lilitan secara dinamik berdasarkan keadaan input dan menangkap kebergantungan jarak jauh melalui mekanisme perhatian.

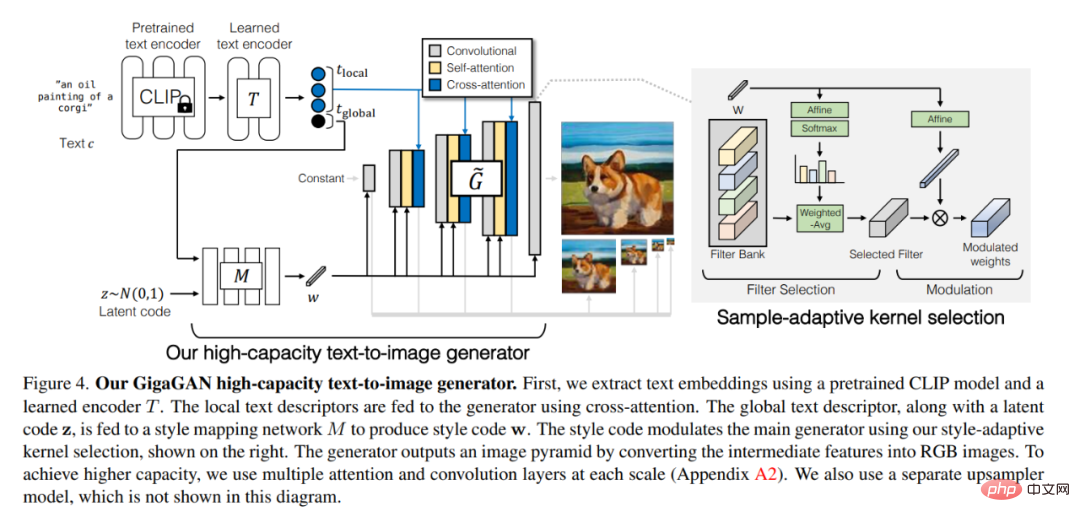

Penjana Imej Teks Berkapasiti Tinggi GigaGAN ditunjukkan dalam Rajah 4 di bawah. Pertama, kami menggunakan model CLIP terlatih dan pengekod T yang dipelajari untuk mengekstrak pembenaman teks. Suapkan deskriptor teks tempatan kepada penjana menggunakan perhatian silang. Deskriptor teks global, bersama-sama dengan kod terpendam z, dimasukkan ke dalam rangkaian pemetaan gaya M untuk menghasilkan kod gaya w. Kod gaya melaraskan penjana utama menggunakan gaya daripada kertas - pemilihan kernel adaptif, ditunjukkan di sebelah kanan.

Penjana mengeluarkan piramid imej dengan menukar ciri perantaraan kepada imej RGB. Untuk mencapai kapasiti yang lebih tinggi, kami menggunakan pelbagai perhatian dan lapisan konvolusi pada setiap skala (Lampiran A2). Mereka juga menggunakan model upsampler yang berasingan, yang tidak ditunjukkan dalam angka ini.

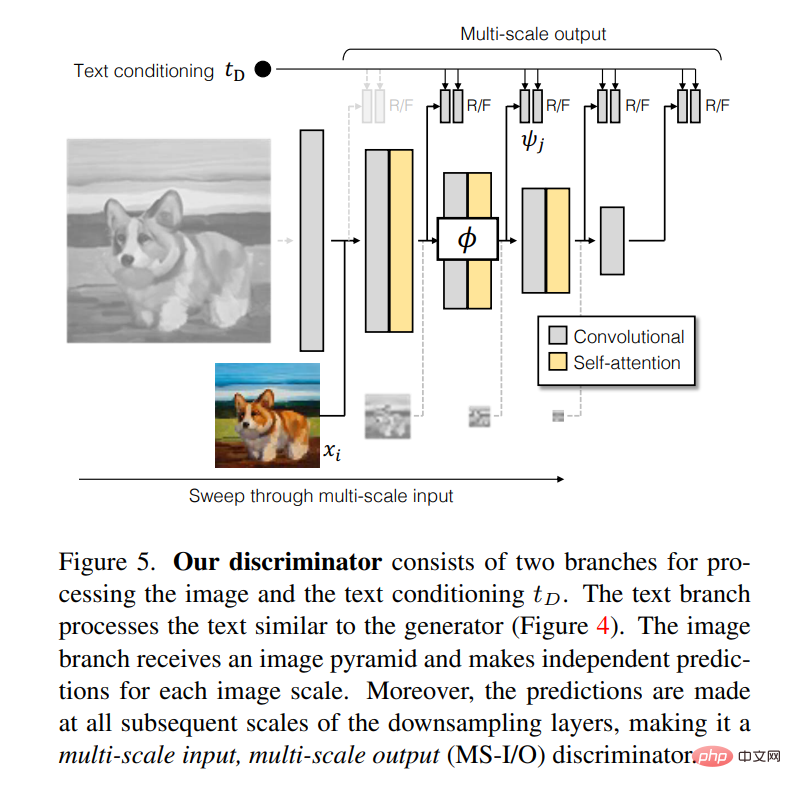

Pendiskriminasi terdiri daripada dua cabang untuk memproses penyesuaian imej dan teks t_D. Cawangan teks mengendalikan teks sama seperti penjana (Rajah 4). Cawangan imej menerima piramid imej dan membuat ramalan bebas untuk setiap skala imej. Tambahan pula, ramalan dibuat pada semua skala lapisan pensampelan ke bawah, menjadikannya input berbilang skala, diskriminator keluaran berbilang skala (MS-I/O).

Dalam kertas itu, penulis merekodkan lima eksperimen berbeza.

Dalam percubaan pertama, mereka menunjukkan keberkesanan kaedah yang dicadangkan dengan menggabungkan setiap komponen teknikal satu demi satu.

Dalam percubaan kedua, mereka menguji keupayaan model untuk menjana graf, dan keputusan menunjukkan bahawa GigaGAN berprestasi lebih baik daripada Resapan Stabil (SD-v1.5) adalah setanding dengan FID sambil menghasilkan hasil lebih cepat daripada model resapan atau autoregresif.

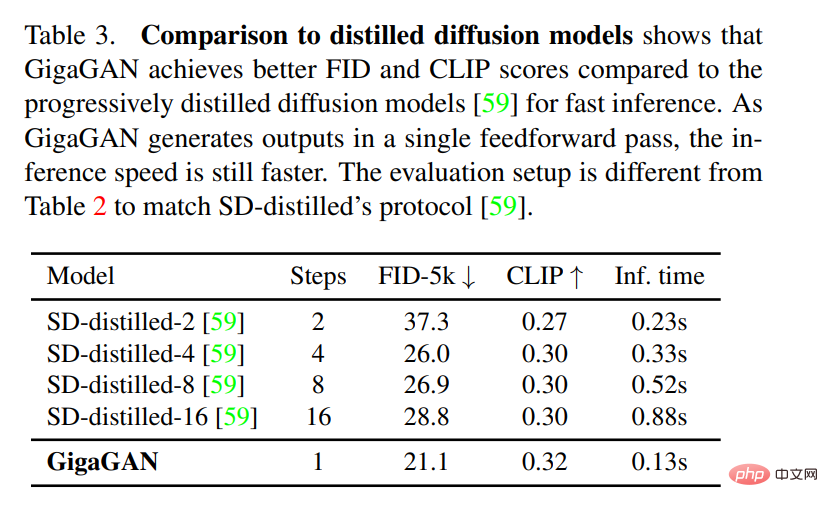

Dalam percubaan ketiga, mereka membandingkan GigaGAN dengan model resapan berasaskan penyulingan, dan keputusan menunjukkan bahawa GigaGAN lebih cekap daripada berasaskan penyulingan penyebaran. Model mensintesis imej berkualiti tinggi dengan lebih cepat.

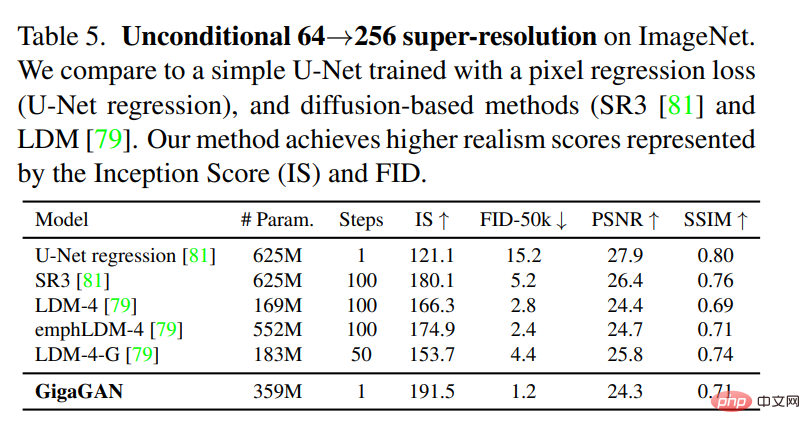

Dalam percubaan keempat, mereka mengesahkan resolusi super bersyarat dan tanpa syarat Kelebihan upsampler GigaGAN yang lain menilai tugas.

Akhir sekali, mereka membentangkan cadangan Large- model GAN berskala masih menikmati operasi ruang terpendam GAN yang berterusan dan terurai, sekali gus membolehkan mod pengeditan imej baharu. Lihat Rajah 6 dan 8 di atas untuk gambar rajah.

Atas ialah kandungan terperinci Serangan balas GAN: Kerja CVPR baharu Zhu Junyan GigaGAN, kelajuan output imej mengatasi Stable Diffusion. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI