Rumah >Peranti teknologi >AI >Di luar PaLM! Peking University Master mencadangkan DiVeRSe, menyegarkan sepenuhnya kedudukan penaakulan NLP

Di luar PaLM! Peking University Master mencadangkan DiVeRSe, menyegarkan sepenuhnya kedudukan penaakulan NLP

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 15:37:091177semak imbas

Model bahasa berskala besar boleh dikatakan sebagai asas kepada teknologi pemprosesan bahasa semula jadi moden, seperti GPT-3 dengan 175 bilion parameter dan PaLM dengan 540 bilion parameter pra-latihan menyediakan pembelajaran beberapa pukulan yang sangat berkuasa untuk tugas hiliran.

Tetapi tugas penaakulan masih menjadi masalah yang sukar, terutamanya soalan yang memerlukan penaakulan pelbagai langkah untuk mendapatkan jawapan yang betul.

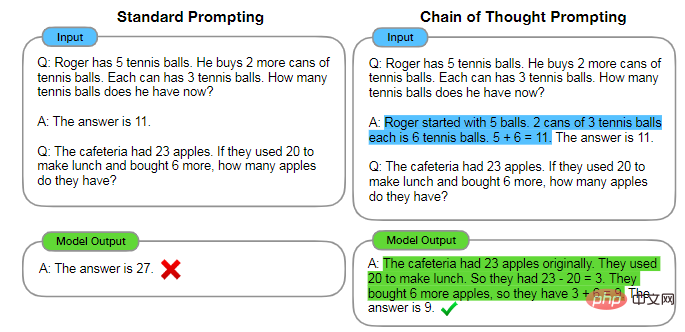

Baru-baru ini, penyelidik telah mendapati bahawa selagi gesaan yang direka bentuk dengan betul boleh membimbing model untuk melakukan penaakulan berbilang langkah untuk menjana jawapan akhir, kaedah ini juga dipanggil penaakulan rantaian pemikiran.

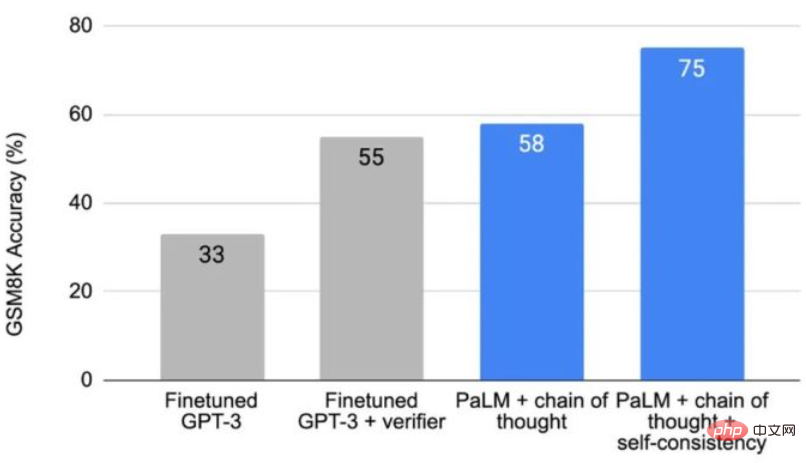

Teknologi rantaian pemikiran meningkatkan ketepatan daripada 17.9% kepada 58.1% pada penanda aras aritmetik GSM8K Mekanisme ketekalan diri yang diperkenalkan kemudian meningkatkan lagi ketepatan %

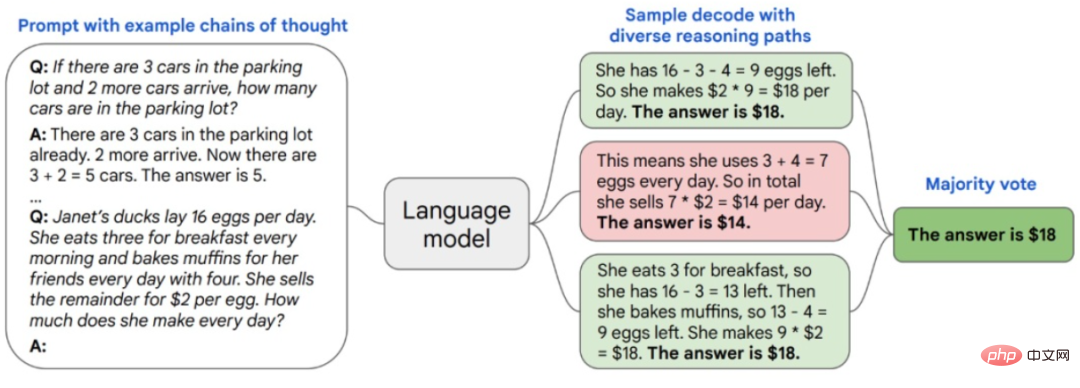

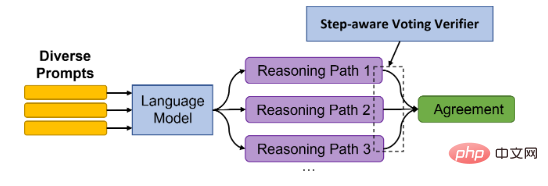

Ringkasnya, tugas penaakulan yang kompleks biasanya mempunyai berbilang laluan penaakulan yang boleh mendapatkan jawapan yang betul sampel kaedah konsisten diri daripada model bahasa melalui set rantai pemikiran A laluan penaakulan yang berbeza, dan kemudian jawapan yang paling konsisten di antara mereka dikembalikan.

Baru-baru ini, penyelidik dari Universiti Peking dan Microsoft berdasarkan kaedah baharu DiVeRSe yang konsisten sendiri, yang mengandungi tiga inovasi utama dan meningkatkan lagi keupayaan penaakulan model.

Pautan kertas: https://arxiv.org/abs/2206.02336

Pautan kod: https://github.com/microsoft/DiVeRSe

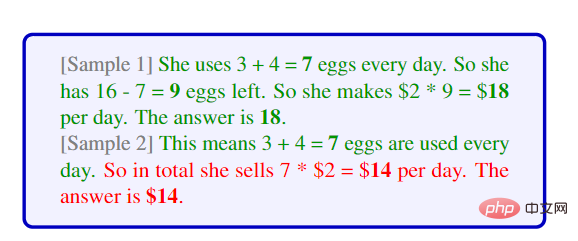

Pertama, diilhamkan oleh pendekatan konsisten kendiri "idea yang berbeza, jawapan yang sama", iaitu, mengambil sampel laluan penaakulan yang berbeza daripada model bahasa, DiVeRSe melangkah lebih jauh dalam kepelbagaian, mengikut prinsip "semua jalan membawa ke Rom" Ideanya ialah menggunakan berbilang gesaan untuk menjana jawapan boleh menjana jawapan yang lebih lengkap dan saling melengkapi.

Para penyelidik mula-mula menyediakan 5 gesaan berbeza untuk setiap soalan, kemudian sampel 20 laluan penaakulan untuk setiap gesaan, dan akhirnya Hasilkan 100 laluan penaakulan penyelesaian untuk setiap soalan soalan.

Isu utama ialah cara mendapatkan gesaan yang berbeza Andaikan bahawa selepas mendapatkan pustaka sampel, kita boleh mencuba sampel K daripadanya untuk membina gesaan, dan kemudian mengulanginya 5 kali

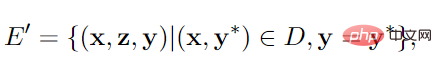

Jika ada. sampel tidak mencukupi, pengajaran kendiri digunakan untuk meningkatkan kepelbagaian segera, iaitu, laluan inferens pseudo dan pasangan dijana daripada sebahagian daripada sampel.

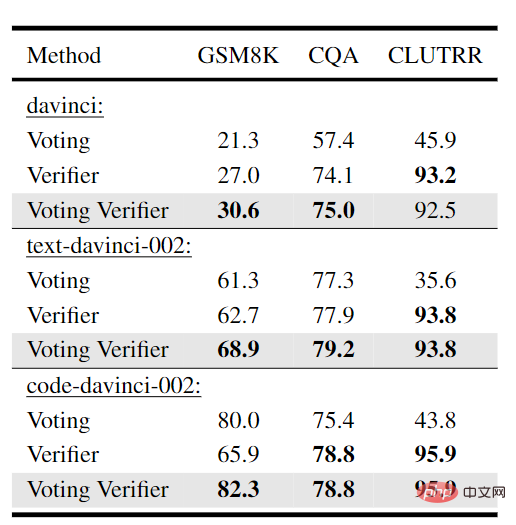

Kedua, apabila menjana laluan inferens, tiada mekanisme dalam model bahasa untuk membetulkan ralat dalam langkah sebelumnya, yang boleh menyebabkan kekeliruan dalam keputusan ramalan akhir. DiVeRSe menggunakan idea pengesah untuk mengesahkan ketepatan setiap laluan penaakulan untuk membimbing mekanisme pengundian. Maksudnya, tidak semua mekanisme penaakulan adalah sama penting atau baik.

Andaikan kita mempunyai 100 laluan penaakulan untuk sesuatu soalan, 60 daripadanya menghasilkan "jawapan ialah 110", dan 40 daripadanya menghasilkan "jawapan ialah 150". Tanpa pengesah (iaitu kaedah konsisten diri asal), "jawapan ialah 110" ialah undian majoriti, jadi kita boleh menganggap 110 sebagai jawapan akhir dan memadamkan 40 laluan penaakulan yang menghasilkan 150.

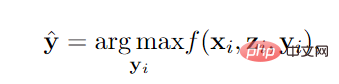

pengesah menjaringkan laluan penaakulan Fungsi f dilatih oleh pengelas dua Input ialah soalan x, laluan z dan jawapan y, dan output ialah kebarangkalian positif.

Dengan pengesah, andaikan bahawa skor purata bagi 60 laluan penaakulan "Jawapannya ialah 110" ialah 0.3 skor purata bagi 40 laluan penaakulan "Jawapan itu ialah 150" ialah 0.8. Maka jawapan akhir hendaklah 150, kerana 40*0.8>60*0.3

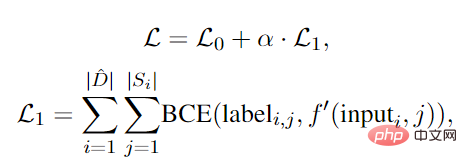

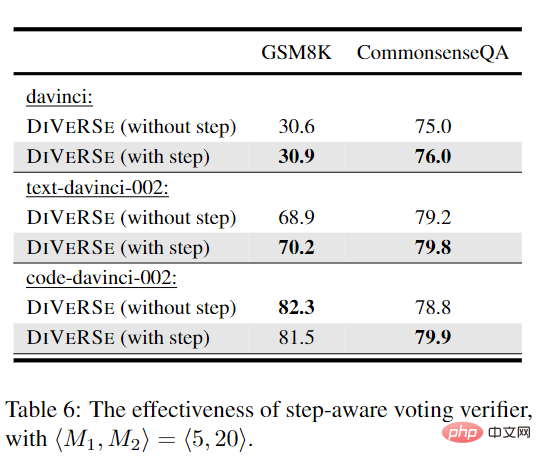

Ketiga, memandangkan jawapan dijana berdasarkan beberapa langkah penaakulan, apabila laluan menjana jawapan yang betul, ia boleh dianggap Semua langkah menyumbang kepada ketepatan akhir. Walau bagaimanapun, apabila jawapan yang salah dijana, ini tidak bermakna bahawa semua langkah adalah salah atau menyumbang kepada ralat.

Dalam erti kata lain, walaupun keputusannya salah, beberapa langkah perantaraan mungkin masih betul, tetapi beberapa langkah sisihan seterusnya membawa kepada jawapan salah terakhir. DiVeRSe mereka bentuk mekanisme untuk memberikan label yang terperinci kepada setiap langkah dan mencadangkan pengesah yang sedar langkah, dan memberikan ketepatan kepada alasan setiap langkah dan bukannya hanya melihat jawapan akhir.

Badan utama masih merupakan pengelas dua, tetapi persoalan utama ialah bagaimana untuk mendapatkan label negatif peringkat langkah, kerana jika jawapan akhir salah, tanpa manusia penyertaan, kami Saya tidak tahu langkah mana yang salah, tetapi jawapan yang betul ialah proses itu sepatutnya betul.

Pengkaji mencadangkan konsep sokongan Contohnya, dalam tugasan aritmetik, perlu ada hasil perantaraan contoh lain yang sama dengan hasil langkah perantaraan.

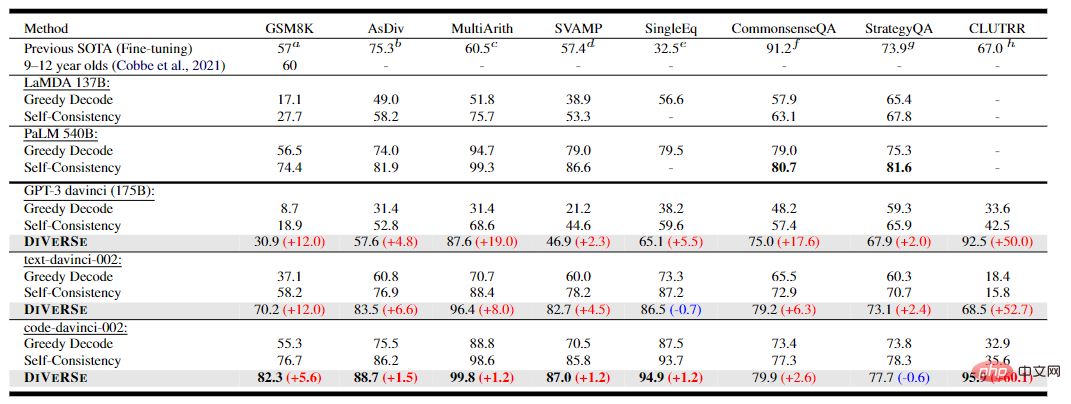

Berdasarkan tiga penambahbaikan ini, penyelidik menjalankan eksperimen ke atas 5 set data penaakulan aritmetik Dapat dilihat bahawa kaedah DiVeRSe berdasarkan kod-davinci-002 telah mencapai The algoritma SOTA baharu mempunyai kadar peningkatan purata 6.2% ), diduga sebabnya mungkin tugas penaakulan akal adalah tugas pilihan berganda dan bukannya tugas penjanaan terbuka, menghasilkan lebih banyak pseudo positif palsu -contoh.

Pada tugas penaakulan induktif, DiVeRSe mencapai skor 95.9% pada tugasan CLUTRR, melebihi hasil penalaan halus SOTA sebelumnya (+28.9%)

Dalam kebanyakan eksperimen, melanjutkan pengesah undian kepada versi yang sedar langkah boleh meningkatkan prestasi. Untuk kod-davinci-002 pada GSM8K, versi pengesah yang sedar langkah akan menyebabkan sedikit penurunan dalam prestasi.

Sebab yang mungkin ialah kod-davinci-002 lebih berkuasa dan boleh menghasilkan laluan inferens berkualiti tinggi untuk GSM8K, sekali gus mengurangkan keperluan maklumat peringkat langkah, iaitu teks-davinci lebih berkemungkinan menghasilkan pendek/tidak lengkap laluan inferens, manakala code-davinci lebih mesra untuk menjana kandungan yang semakin meningkat.

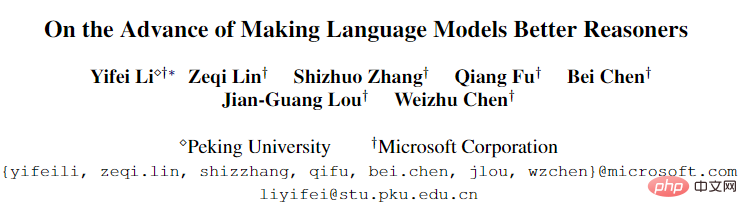

Penulis pertama kertas kerja ialah Yifei Li Dia lulus dari Universiti Timur Laut dengan ijazah sarjana muda dalam bidang kejuruteraan perisian pada tahun 2020. Dia kini sedang belajar untuk ijazah sarjana di Peking. Universiti hala tuju penyelidikannya ialah pemprosesan bahasa semula jadi , terutamanya penalaan segera dan inferens dalam model bahasa berskala besar.

Penulis kedua artikel itu ialah Zeqi Lin, seorang penyelidik DKI di Microsoft Research Asia. Beliau menerima ijazah sarjana muda dan ijazah kedoktoran dari Universiti Peking masing-masing pada tahun 2014 dan 2019 aplikasi dalam analisis perisian dan aplikasi dalam analisis data.

Atas ialah kandungan terperinci Di luar PaLM! Peking University Master mencadangkan DiVeRSe, menyegarkan sepenuhnya kedudukan penaakulan NLP. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI