Rumah >Peranti teknologi >AI >Kajian menunjukkan model bahasa besar mempunyai masalah dengan penaakulan logik

Kajian menunjukkan model bahasa besar mempunyai masalah dengan penaakulan logik

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 15:19:031325semak imbas

Penterjemah |. Li Rui

Penilai |. Dalam tahun-tahun kebelakangan ini, model bahasa besar (LLM), model pembelajaran mendalam yang dilatih pada sejumlah besar teks, telah menunjukkan prestasi yang baik pada beberapa penanda aras yang digunakan untuk mengukur keupayaan pemahaman bahasa.

Model bahasa yang besar seperti GPT-3 dan LaMDA berjaya mengekalkan koheren merentas teks yang lebih panjang. Mereka kelihatan berpengetahuan tentang topik yang berbeza dan kekal konsisten sepanjang perbualan yang panjang. Model bahasa besar (LLM) telah menjadi sangat meyakinkan sehingga sesetengah orang mengaitkannya dengan personaliti dan bentuk kecerdasan yang lebih tinggi.

Tetapi bolehkah Model Bahasa Besar (LLM) melakukan penaakulan logik seperti manusia? Transformers, seni bina pembelajaran mendalam yang digunakan dalam model bahasa besar (LLM), tidak belajar untuk mensimulasikan keupayaan penaakulan, menurut kertas penyelidikan yang diterbitkan oleh saintis UCLA. Sebaliknya, komputer telah menemui cara bijak untuk mempelajari sifat statistik yang wujud dalam masalah penaakulan.

Para penyelidik menguji BERT seni bina Transformer yang popular pada masa ini dalam ruang masalah yang terhad. Keputusan mereka menunjukkan bahawa BERT boleh bertindak balas dengan tepat kepada masalah inferens pada contoh dalam pengedaran dalam ruang latihan, tetapi tidak boleh membuat generalisasi kepada contoh dalam pengedaran lain berdasarkan ruang masalah yang sama.

Dan ujian ini menyerlahkan beberapa kelemahan rangkaian saraf dalam dan penanda aras yang digunakan untuk menilainya.

1. Bagaimana untuk mengukur penaakulan logik dalam kecerdasan buatan?

Terdapat beberapa penanda aras untuk sistem kecerdasan buatan yang menyasarkan masalah pemprosesan dan pemahaman bahasa semula jadi, seperti GLUE, SuperGLUE, SNLI dan SqUAD. Memandangkan Transformer telah berkembang lebih besar dan telah dilatih pada set data yang lebih besar, Transformer telah dapat menambah baik secara berperingkat pada penanda aras ini.

Perlu diingat bahawa prestasi sistem AI pada penanda aras ini sering dibandingkan dengan kecerdasan manusia. Prestasi manusia pada penanda aras ini berkait rapat dengan akal sehat dan kebolehan penaakulan logik. Tetapi tidak jelas sama ada model bahasa besar bertambah baik kerana mereka memperoleh keupayaan penaakulan logik atau kerana ia terdedah kepada sejumlah besar teks.

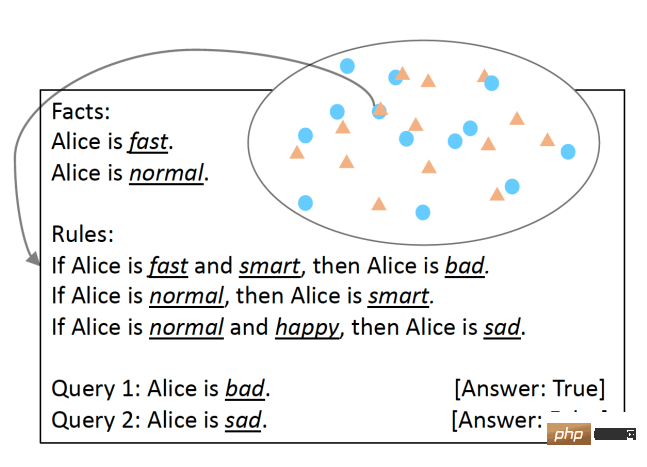

Untuk menguji ini, penyelidik UCLA membangunkan SimpleLogic, kelas soalan penaakulan logik berdasarkan logik proposisi. Untuk memastikan bahawa keupayaan penaakulan model bahasa diuji dengan teliti, penyelidik menghapuskan perbezaan bahasa dengan menggunakan struktur bahasa templat. Masalah SimpleLogic terdiri daripada satu set fakta, peraturan, pertanyaan dan label. Fakta adalah predikat yang diketahui "benar". Peraturan adalah syarat, ditakrifkan sebagai terma. Pertanyaan ialah soalan yang mesti dijawab oleh model pembelajaran mesin. Label adalah jawapan kepada pertanyaan, iaitu, "benar" atau "salah". Soalan SimpleLogic disusun ke dalam rentetan teks berterusan yang mengandungi isyarat dan pembatas yang dijangka oleh model bahasa semasa latihan dan inferens.

Soalan dalam format SimpleLogic Salah satu ciri SimpleLogic ialah soalannya adalah serba lengkap dan tidak memerlukan pengetahuan awal. Ini amat penting kerana, seperti yang dikatakan oleh ramai saintis, apabila manusia bercakap, mereka mengabaikan pengetahuan yang dikongsi. Inilah sebabnya mengapa model bahasa sering jatuh ke dalam perangkap apabila ditanya soalan tentang pengetahuan asas dunia yang semua orang tahu. Sebaliknya, SimpleLogic menyediakan pemaju dengan semua yang mereka perlukan untuk menyelesaikan masalah mereka. Oleh itu, mana-mana pembangun yang melihat masalah yang ditimbulkan oleh format SimpleLogic harus dapat membuat kesimpulan peraturannya dan dapat mengendalikan contoh baharu tanpa mengira pengetahuan latar belakang mereka.

Soalan dalam format SimpleLogic Salah satu ciri SimpleLogic ialah soalannya adalah serba lengkap dan tidak memerlukan pengetahuan awal. Ini amat penting kerana, seperti yang dikatakan oleh ramai saintis, apabila manusia bercakap, mereka mengabaikan pengetahuan yang dikongsi. Inilah sebabnya mengapa model bahasa sering jatuh ke dalam perangkap apabila ditanya soalan tentang pengetahuan asas dunia yang semua orang tahu. Sebaliknya, SimpleLogic menyediakan pemaju dengan semua yang mereka perlukan untuk menyelesaikan masalah mereka. Oleh itu, mana-mana pembangun yang melihat masalah yang ditimbulkan oleh format SimpleLogic harus dapat membuat kesimpulan peraturannya dan dapat mengendalikan contoh baharu tanpa mengira pengetahuan latar belakang mereka.

2. Ciri statistik dan inferens logik

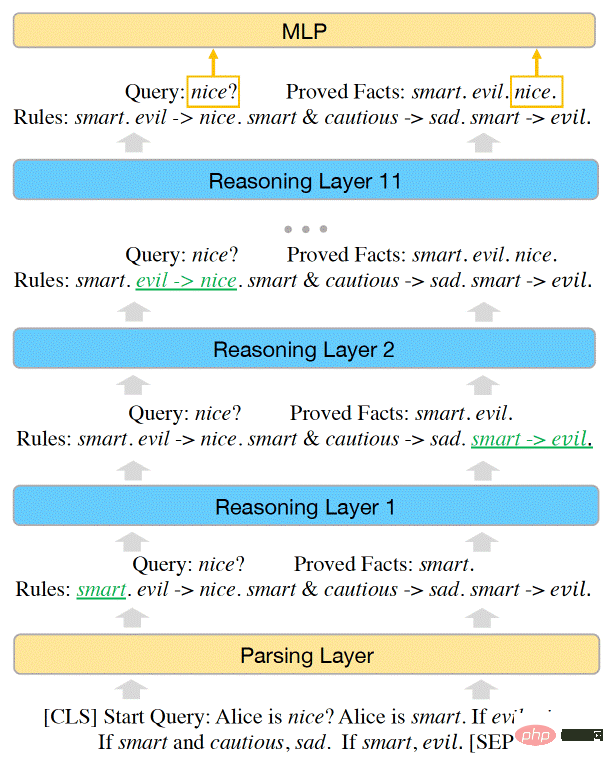

Penyelidik telah membuktikan bahawa ruang masalah dalam SimpleLogic boleh diwakili oleh fungsi inferens. Para penyelidik seterusnya menunjukkan bahawa BERT cukup berkuasa untuk menyelesaikan semua masalah dalam SimpleLogic, dan mereka boleh melaraskan parameter model pembelajaran mesin secara manual untuk mewakili fungsi inferens.

Walau bagaimanapun, apabila mereka melatih BERT pada set data contoh SimpleLogic, model itu tidak dapat mempelajari fungsi inferens sendiri. Model pembelajaran mesin berjaya mencapai ketepatan hampir sempurna pada pengedaran data. Tetapi ia tidak digeneralisasikan kepada pengedaran lain dalam ruang masalah yang sama. Ini berlaku walaupun set data latihan meliputi keseluruhan ruang masalah dan semua pengedaran datang daripada fungsi inferens yang sama.

Kapasiti model Transformer BERT mencukupi untuk mewakili keupayaan inferens SimpleLogic

Kapasiti model Transformer BERT mencukupi untuk mewakili keupayaan inferens SimpleLogic

(Nota: Ini berbeza daripada cabaran generalisasi luar pengedaran , yang digunakan untuk ruang terbuka Masalah Apabila model gagal membuat generalisasi kepada data OOD, prestasinya menurun dengan ketara apabila berurusan dengan data yang tidak berada dalam pengedaran set latihannya)

.Para penyelidik menulis: "Selepas penyiasatan lanjut, kami memberikan penjelasan untuk paradoks ini: model yang mencapai ketepatan tinggi hanya pada contoh ujian yang diedarkan tidak belajar menaakul Malah, model itu telah belajar menaakul masalah penaakulan logik gunakan ciri statistik untuk membuat ramalan, dan bukannya mensimulasikan fungsi inferens yang betul.”

Penemuan ini menyerlahkan cabaran penting dalam menggunakan pembelajaran mendalam untuk tugasan bahasa. Rangkaian saraf sangat baik untuk menemui dan menyesuaikan ciri statistik. Dalam sesetengah aplikasi ini boleh menjadi sangat berguna. Sebagai contoh, dalam analisis sentimen, terdapat korelasi yang kuat antara perkataan tertentu dan kategori sentimen.

Walau bagaimanapun, untuk tugas penaakulan logik, walaupun ciri statistik wujud, model harus cuba mencari dan mempelajari ciri penaakulan asas.

Para penyelidik menulis: "Apabila kami cuba melatih model saraf hujung ke hujung untuk menyelesaikan tugasan pemprosesan bahasa semula jadi (NLP) yang melibatkan penaakulan logik dan pengetahuan terdahulu serta perbezaan bahasa sekarang, ia harus berhati-hati. " Mereka menekankan bahawa cabaran yang ditimbulkan oleh SimpleLogic menjadi lebih teruk dalam dunia nyata, di mana sejumlah besar maklumat yang diperlukan untuk model bahasa besar (LLM) semata-mata tidak terkandung dalam data.

Para penyelidik memerhatikan bahawa apabila mereka mengalih keluar ciri statistik daripada set data latihan, prestasi model bahasa bertambah baik pada pengagihan lain bagi ruang masalah yang sama. Masalahnya, bagaimanapun, ialah menemui dan mengalih keluar berbilang ciri statistik lebih mudah dikatakan daripada dilakukan. Seperti yang dinyatakan oleh penyelidik dalam kertas kerja mereka, "Ciri statistik sedemikian boleh menjadi banyak dan sangat kompleks, menjadikannya sukar untuk dialih keluar daripada data latihan."

3 Inferens dalam Pembelajaran Mendalam

Malangnya, apabila saiz model bahasa menjadi lebih besar, masalah penaakulan logik tidak hilang. Ia hanya tersembunyi dalam seni bina yang besar dan korpora latihan yang sangat besar. Model bahasa besar (LLM) boleh menerangkan fakta dan menyusun ayat dengan baik, tetapi dari segi penaakulan logik, mereka masih menggunakan ciri statistik untuk penaakulan, yang bukan asas yang kukuh. Selain itu, tiada petunjuk bahawa dengan menambahkan lapisan, parameter dan kepala perhatian pada Transformers, jurang penaakulan logik akan ditutup.

Kertas kerja ini konsisten dengan kerja lain yang menunjukkan batasan rangkaian saraf dalam mempelajari peraturan logik, seperti Game of Life atau penaakulan abstrak daripada data visual. Makalah ini mengetengahkan salah satu cabaran utama yang dihadapi oleh model bahasa semasa. Seperti yang dinyatakan oleh penyelidik UCLA, “Di satu pihak, apabila model dilatih untuk mempelajari tugas daripada data, ia sentiasa cenderung untuk mempelajari corak statistik yang wujud dalam contoh inferens, sebaliknya, peraturan logik; jangan sekali-kali bergantung pada corak statistik untuk membuat inferens, jadi pembelajaran inferens daripada data adalah sukar kerana sukar untuk membina set data untuk inferens logik yang tidak mengandungi ciri statistik: https://bdtechtalks.com/2022/06/. 27/model-bahasa-besar-penaakulan-logik/

Atas ialah kandungan terperinci Kajian menunjukkan model bahasa besar mempunyai masalah dengan penaakulan logik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI