Rumah >Peranti teknologi >AI >GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A

GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 14:55:031243semak imbas

Selepas populariti model penyebaran, ramai orang telah menumpukan pada cara menggunakan gesaan yang lebih berkesan untuk menjana imej yang mereka inginkan. Dalam percubaan berterusan beberapa model lukisan AI, orang ramai telah meringkaskan pengalaman kata kunci untuk membuat lukisan AI dengan baik:

Dalam erti kata lain, jika anda menguasai kemahiran AI yang betul, kesan peningkatan kualiti lukisan akan menjadi sangat jelas (lihat: "Bagaimana untuk melukis "Alpaca Playing Basketball"? Seseorang membelanjakan 13 dolar AS untuk memaksa DALL· E 2 Tunjukkan kemahiran sebenar anda 》).

Selain itu, sesetengah penyelidik sedang berusaha ke arah lain: cara menukar lukisan kepada apa yang kita mahu dengan hanya beberapa perkataan.

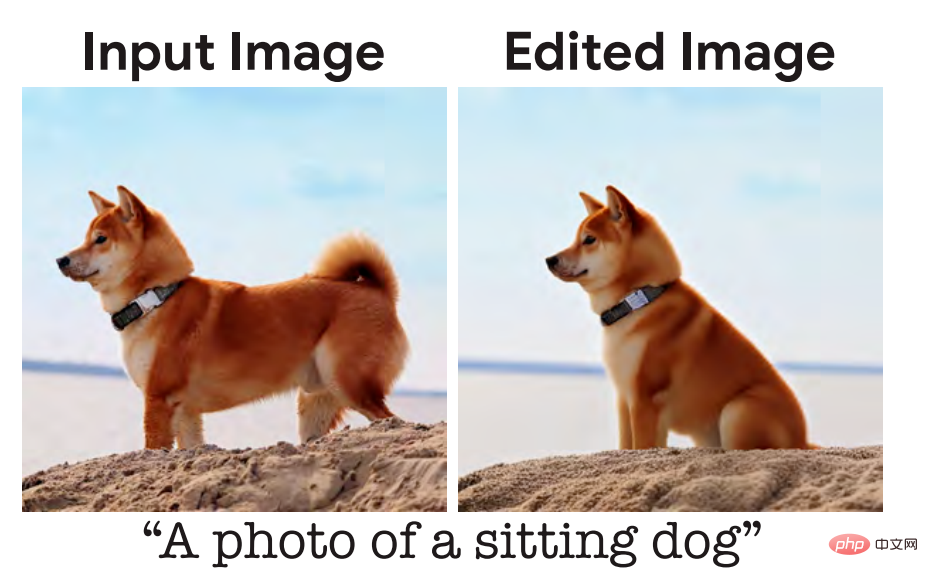

Beberapa masa lalu, kami melaporkan tentang penyelidikan daripada Google Research dan institusi lain . Sebut sahaja rupa imej yang anda mahukan dan ia pada asasnya akan melakukan apa yang anda mahu, menghasilkan imej fotorealistik, seperti anak anjing duduk:

Penerangan input yang diberikan kepada model di sini ialah "anjing duduk", tetapi mengikut tabiat komunikasi harian manusia, penerangan yang paling semula jadi adalah "biar anjing ini duduk". Sesetengah penyelidik percaya bahawa ini adalah masalah yang harus dioptimumkan, dan modelnya harus lebih sejajar dengan tabiat bahasa manusia.

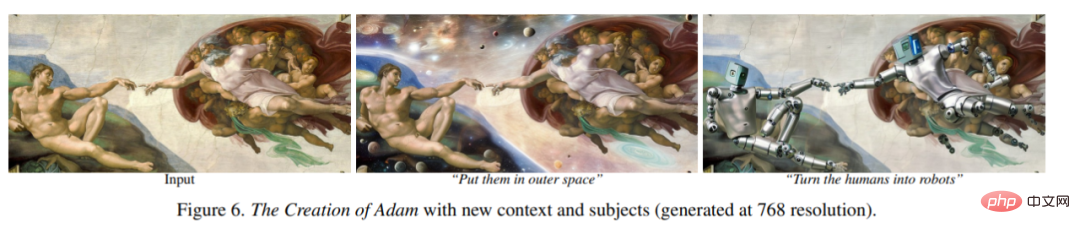

Baru-baru ini, pasukan penyelidik dari UC Berkeley mencadangkan kaedah baharu untuk mengedit imej berdasarkan arahan manusia: InstructPix2Pix: Memandangkan imej input dan penerangan teks yang memberitahu model apa yang perlu dilakukan, model Keupayaan untuk mengikuti arahan penerangan untuk mengedit imej.

Alamat kertas: https://arxiv.org/pdf/2211.09800.pdf

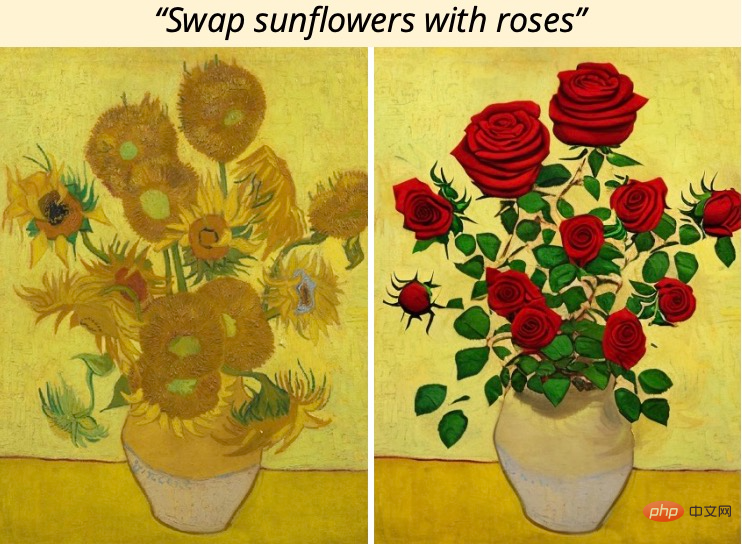

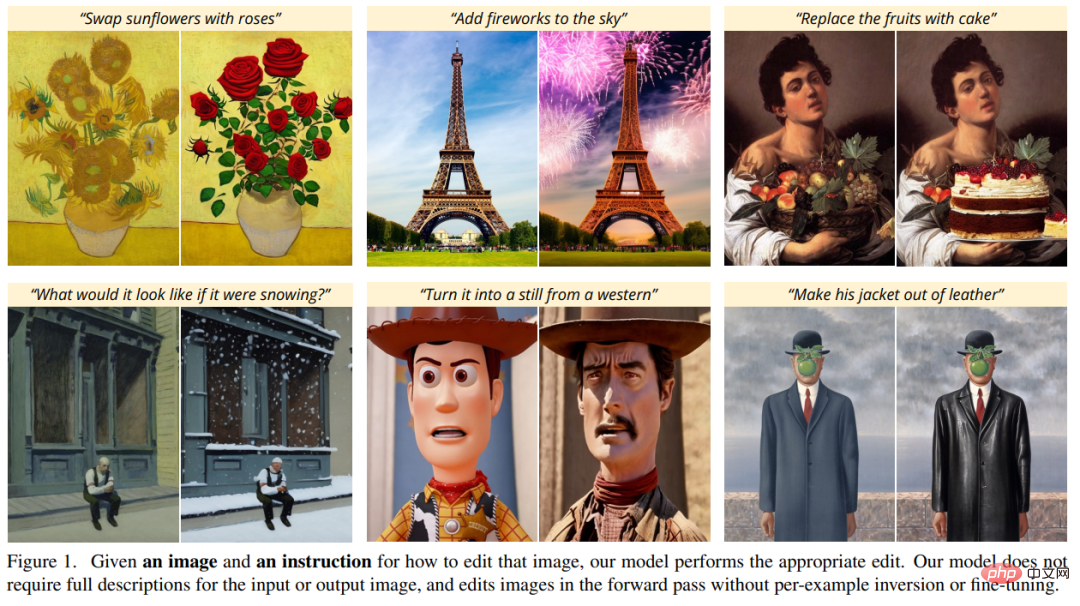

Sebagai contoh, untuk menukar bunga matahari dalam lukisan kepada mawar, anda hanya perlu mengatakan terus kepada model "Tukar bunga matahari kepada mawar":

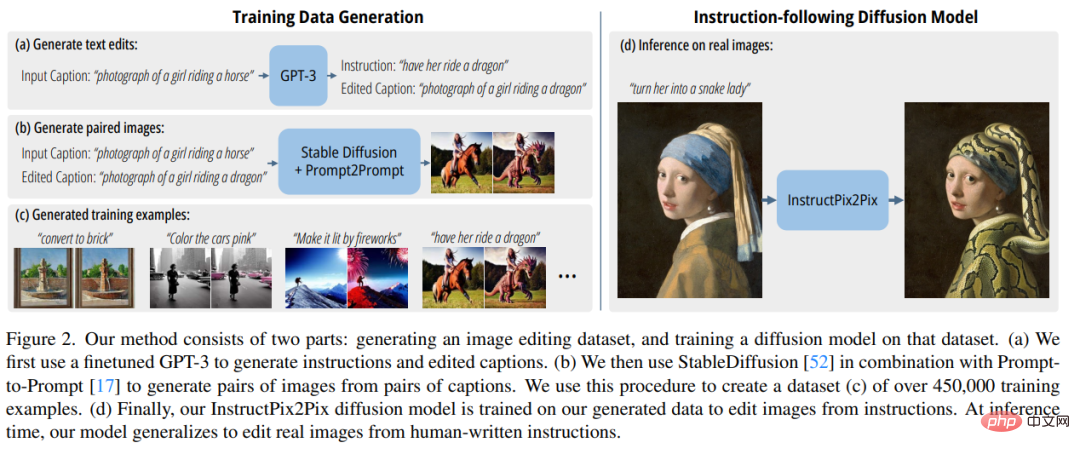

Untuk mendapatkan data latihan, kajian ini menggabungkan dua model pra-latihan besar - model bahasa (GPT-3) dan model generatif teks-ke-imej (Stable Diffusion) untuk menjana set data latihan berpasangan yang besar contoh penyuntingan imej. Para penyelidik melatih model baharu, InstructPix2Pix, pada dataset besar ini dan digeneralisasikan kepada imej sebenar dan arahan bertulis pengguna pada masa inferens.

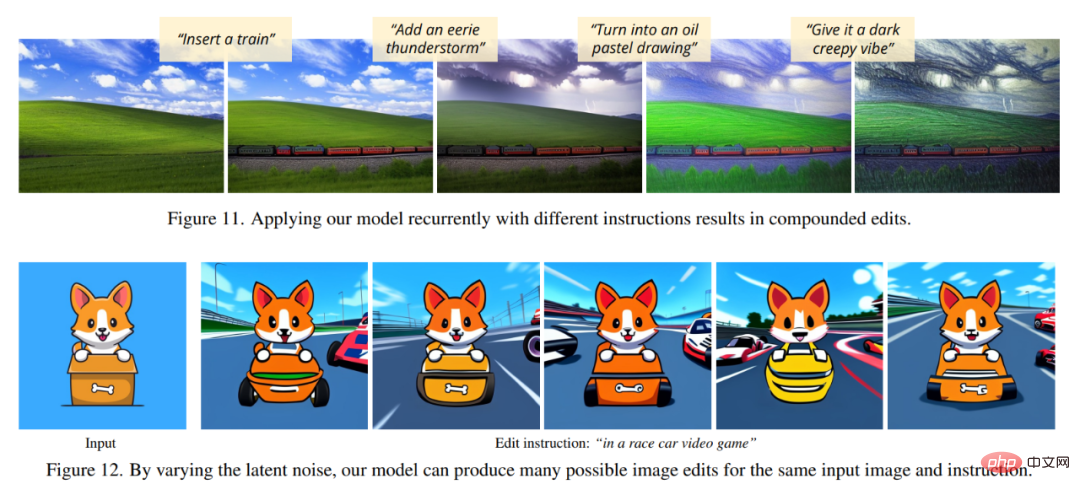

InstructPix2Pix ialah model resapan bersyarat yang menjana imej yang diedit diberikan imej input dan arahan teks untuk mengedit imej. Model melakukan pengeditan imej secara terus dalam pas ke hadapan dan tidak memerlukan sebarang imej contoh tambahan, penerangan penuh imej input/output atau penalaan halus setiap contoh, jadi model boleh mengedit imej dengan cepat dalam beberapa saat sahaja.

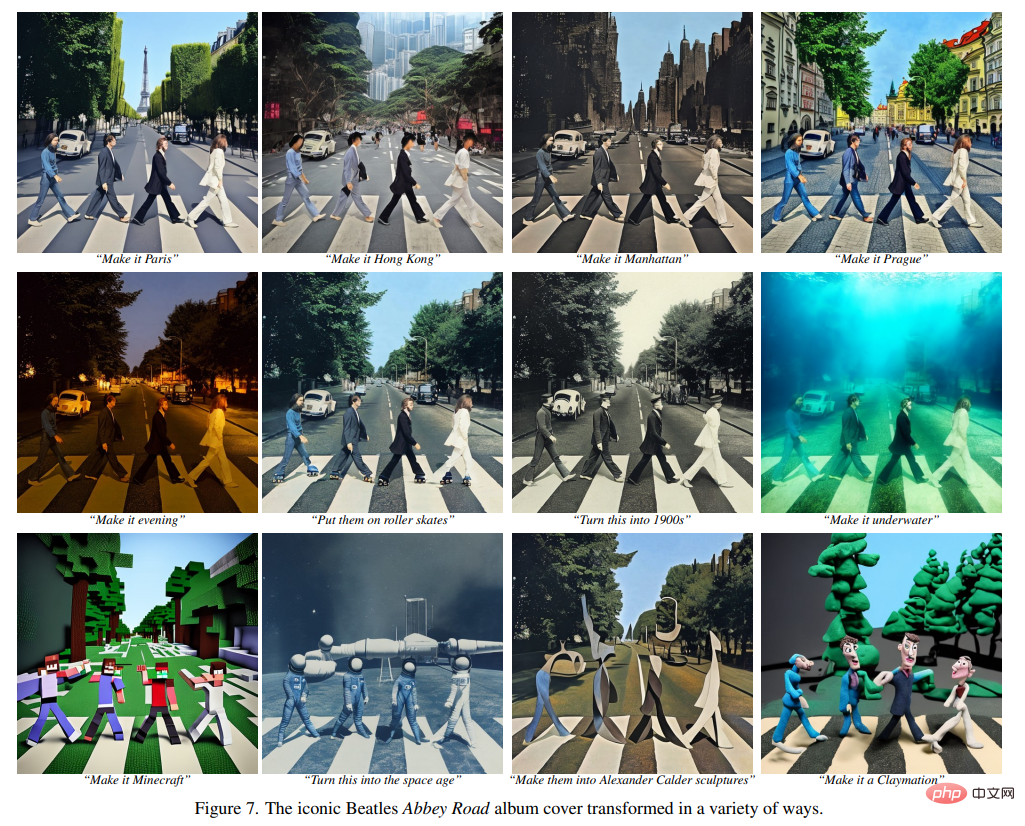

Walaupun InstructPix2Pix dilatih sepenuhnya pada contoh sintetik (iaitu, penerangan teks yang dihasilkan oleh GPT-3 dan imej yang dijana oleh Stable Diffusion), model ini mencapai ketepatan pada imej sebenar arbitrari dan Zero generalisasi -shot kepada teks tulisan manusia. Mockup menyokong penyuntingan imej intuitif, termasuk menggantikan objek, menukar gaya imej dan banyak lagi.

Tinjauan Keseluruhan Kaedah

Para penyelidik menganggap penyuntingan imej berasaskan arahan sebagai masalah pembelajaran yang diselia: Pertama, mereka menjana set data latihan berpasangan yang mengandungi arahan penyuntingan teks dan imej sebelum dan selepas penyuntingan (Rajah 2a- c), dan kemudian melatih model penyebaran penyuntingan imej pada set data yang dihasilkan ini (Rajah 2d). Walaupun dilatih menggunakan imej yang dihasilkan dan arahan penyuntingan, model tersebut masih mampu menyunting imej sebenar menggunakan arahan sewenang-wenangnya yang ditulis oleh manusia. Rajah 2 di bawah ialah gambaran keseluruhan kaedah.

Hasilkan set data latihan pelbagai mod

dalam data Dalam peringkat penjanaan yang ditetapkan, penyelidik menggabungkan keupayaan model bahasa besar (GPT-3) dan model teks-ke-imej (Stable Diffusion) untuk menjana set data latihan pelbagai mod yang mengandungi arahan penyuntingan teks dan imej yang sepadan sebelum ini. dan selepas diedit. Proses ini terdiri daripada langkah berikut:

- Perhalus GPT-3 untuk menjana koleksi kandungan penyuntingan teks: Memandangkan gesaan menerangkan imej, hasilkan teks yang menerangkan perintah perubahan yang perlu dibuat dan gesaan yang menerangkan imej yang telah diubah (Rajah 2a); ) ke dalam imej pasangan yang sepadan (Rajah 2b).

- InstructPix2Pix

Para penyelidik menggunakan data latihan yang dijana untuk melatih model resapan bersyarat model Stable Diffusion, imej boleh diedit berdasarkan arahan bertulis.

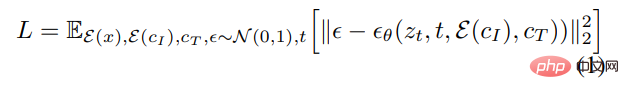

Pembelajaran model resapan menjana sampel data melalui satu siri pengekod auto denosing yang menganggarkan pecahan pengedaran data (menunjuk ke arah data berketumpatan tinggi). Resapan terpendam dipertingkatkan dengan beroperasi dalam ruang terpendam autopengekod variasi terlatih dengan pengekod

dan penyahkod Kecekapan dan kualiti model resapan. Untuk imej x, proses resapan menambahkan hingar pada pendam yang dikodkan

, yang menghasilkan z_t pendam yang bising, di mana bunyi tahap meningkat dengan langkah masa t∈T. Kami mempelajari rangkaian yang meramalkan hingar yang ditambahkan pada z_t terpendam bising diberi penyaman imej C_I dan pengatur arahan teks C_T. Para penyelidik meminimumkan objektif resapan terpendam berikut:

Kajian terdahulu (Wang et al.) telah menunjukkan bahawa untuk tugas terjemahan imej (terjemahan imej), terutamanya apabila data latihan berpasangan adalah terhad, penalaan halus model penyebaran imej yang besar adalah lebih baik daripada melatihnya dari awal. Oleh itu, dalam penyelidikan baharu, pengarang menggunakan pusat pemeriksaan Stable Diffusion yang telah terlatih untuk memulakan pemberat model, mengambil kesempatan daripada keupayaan penjanaan teks-ke-imej yang berkuasa.

Untuk menyokong penyaman imej, penyelidik menambah saluran input tambahan pada lapisan konvolusi pertama, menyambungkan z_t dan

. Semua pemberat yang tersedia bagi model resapan dimulakan dari pusat pemeriksaan pralatihan, manakala pemberat yang beroperasi pada saluran input yang baru ditambah dimulakan kepada sifar. Penulis di sini menggunakan semula mekanisme pelarasan teks yang sama yang asalnya digunakan untuk kapsyen tanpa mengambil arahan penyuntingan teks c_T sebagai input.  Hasil eksperimen

Hasil eksperimen

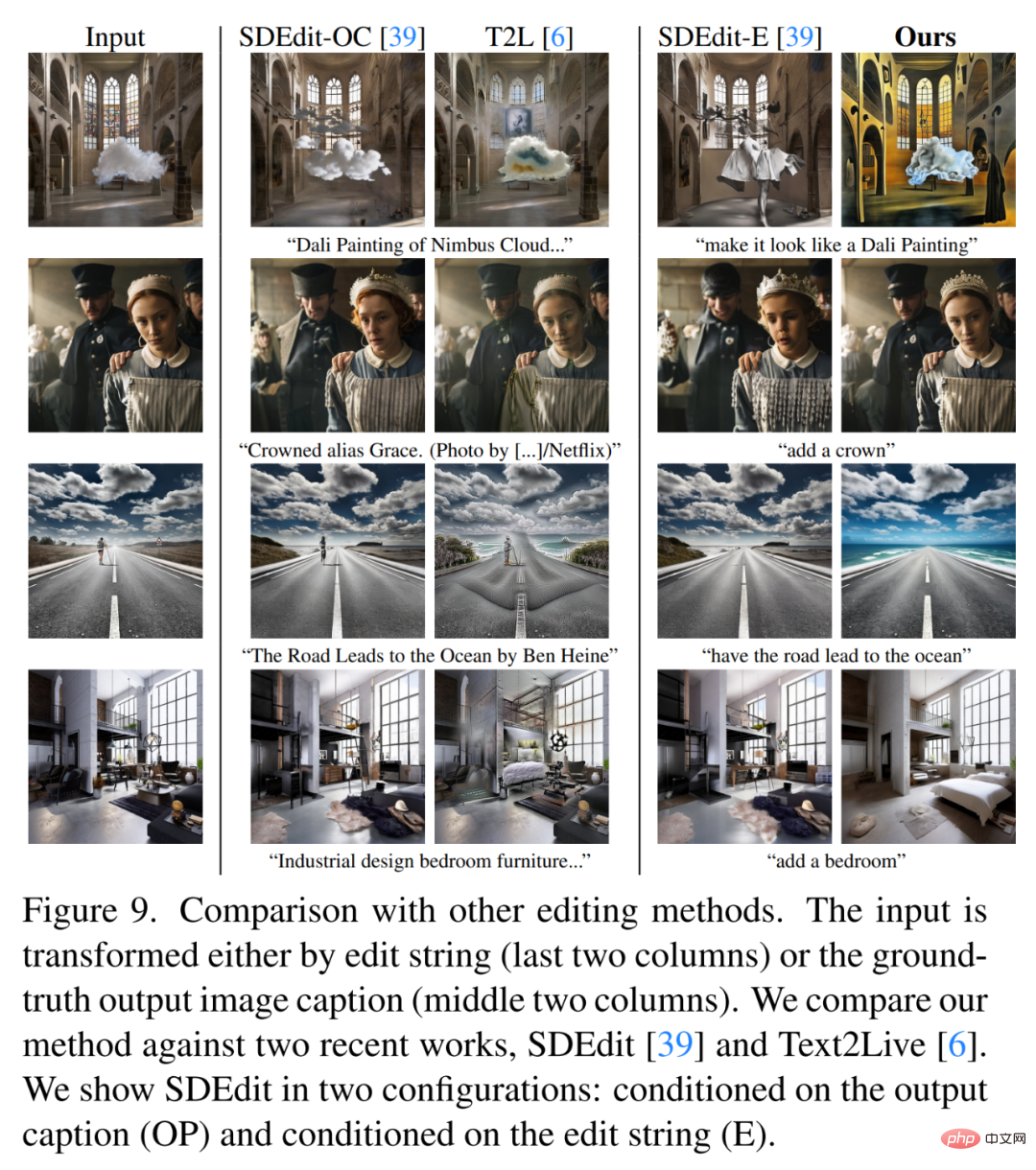

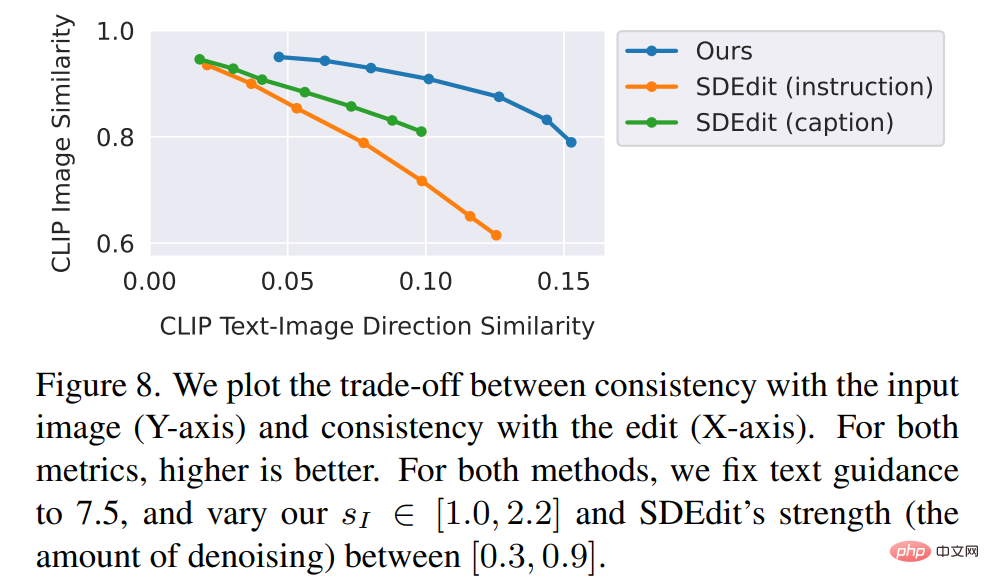

Para penyelidik membandingkan kaedah baharu dengan kaedah terkini Sesetengah teknologi seperti SDEdit, Text2Live, dsb. dibandingkan. Model baharu mengikut arahan untuk mengedit imej, manakala kaedah lain, termasuk kaedah garis dasar, memerlukan penerangan imej atau lapisan penyuntingan. Oleh itu, apabila membandingkan, pengarang menyediakan anotasi teks "diedit" untuk yang terakhir dan bukannya arahan mengedit. Penulis juga secara kuantitatif membandingkan kaedah baharu dengan SDEdit, menggunakan dua metrik yang mengukur ketekalan imej dan kualiti penyuntingan. Akhir sekali, penulis menunjukkan bagaimana saiz dan kualiti data latihan yang dihasilkan mempengaruhi keputusan ablasi dalam prestasi model.

Atas ialah kandungan terperinci GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI