Rumah >Peranti teknologi >AI >Satu baris teks untuk mencapai perubahan wajah 3D! UC Berkeley mencadangkan 'Chat-NeRF' untuk melengkapkan rendering peringkat blockbuster hanya dalam satu ayat

Satu baris teks untuk mencapai perubahan wajah 3D! UC Berkeley mencadangkan 'Chat-NeRF' untuk melengkapkan rendering peringkat blockbuster hanya dalam satu ayat

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 14:37:031070semak imbas

Terima kasih kepada pembangunan teknologi pembinaan semula 3D saraf, menangkap perwakilan ciri pemandangan 3D dunia sebenar tidak pernah semudah ini.

Walau bagaimanapun, tidak pernah ada penyelesaian yang mudah dan berkesan untuk pengeditan pemandangan 3D di atas ini.

Baru-baru ini, penyelidik dari UC Berkeley mencadangkan kaedah menyunting adegan NeRF menggunakan arahan teks - Instruct-NeRF2NeRF, berdasarkan kerja sebelumnya InstructPix2Pix.

Alamat kertas: https://arxiv.org/abs/2303.12789

Menggunakan Instruct-NeRF2NeRF, kami boleh mengedit adegan dunia sebenar berskala besar dengan hanya satu ayat, dan menjadikannya lebih realistik dan disasarkan daripada kerja sebelumnya.

Contohnya, jika anda mahu dia berjanggut, seberkas janggut akan muncul di mukanya!

Atau tukar kepala anda dan jadi Einstein dalam beberapa saat.

Selain itu, memandangkan model boleh mengemas kini set data secara berterusan dengan imej baharu yang diedit, kesan pembinaan semula pemandangan akan bertambah baik secara beransur-ansur.

NeRF + InstructPix2Pix = Instruct-NeRF2NeRF

Secara khusus, manusia diberikan imej input, dan arahan bertulis yang memberitahu model apa yang perlu dilakukan, dan model kemudian Ikut arahan ini untuk mengedit imej.

Langkah pelaksanaan adalah seperti berikut:

- Memberikan imej dari tempat kejadian dalam perspektif latihan.

- Gunakan model InstructPix2Pix untuk mengedit imej ini berdasarkan arahan teks global.

- Gantikan imej asal dalam set data latihan dengan imej yang diedit.

- Model NeRF terus berlatih seperti biasa.

Kaedah pelaksanaan

Berbanding dengan pengeditan 3D tradisional, NeRF2NeRF ialah kaedah pengeditan pemandangan 3D baharu Sorotan terbesarnya ialah penggunaan teknologi "kemas kini set data berulang".

Walaupun pengeditan dilakukan pada pemandangan 3D, model resapan 2D dan bukannya 3D digunakan untuk mengekstrak bentuk dan penampilan prior dalam kertas kerana data yang digunakan untuk melatih model generatif 3D adalah sangat terhad.

Model penyebaran 2D ini ialah InstructPix2Pix yang dibangunkan oleh pasukan penyelidik tidak lama dahulu - model penyuntingan imej 2D berdasarkan teks arahan Apabila anda memasukkan arahan imej dan teks, ia boleh menghasilkan pengeditan imej selepas.

Walau bagaimanapun, model 2D ini akan menyebabkan perubahan tidak sekata pada sudut pemandangan yang berbeza Oleh itu, "kemas kini set data berulang" wujud secara bergilir-gilir. . Set" dan kemas kini perwakilan 3D yang mendasari.

Ini bermakna model resapan berpandukan teks (InstructPix2Pix) akan menjana variasi imej baharu mengikut arahan dan menggunakan imej baharu ini sebagai input untuk latihan model NeRF. Oleh itu, adegan 3D yang dibina semula akan berdasarkan pengeditan berpandukan teks baharu.

Dalam lelaran awal, InstructPix2Pix selalunya gagal melakukan pengeditan yang konsisten merentas sudut tontonan yang berbeza, namun, semasa proses pemaparan semula dan pengemaskinian NeRF, mereka akan menumpu kepada pemandangan yang konsisten di peringkat global.

Ringkasnya, kaedah NeRF2NeRF meningkatkan kecekapan pengeditan adegan 3D dengan mengemas kini kandungan imej secara berulang dan menyepadukan kandungan yang dikemas kini ini ke dalam pemandangan 3D, sambil mengekalkan koheren dan realisme Pemandangan.

Boleh dikatakan bahawa kerja pasukan penyelidik UC Berkeley ini ialah versi lanjutan daripada InstructPix2Pix sebelumnya Dengan menggabungkan NeRF dengan InstructPix2Pix dan bekerja dengan "kemas kini set data berulang ", pengeditan Utama masih boleh dimainkan dengan adegan 3D!

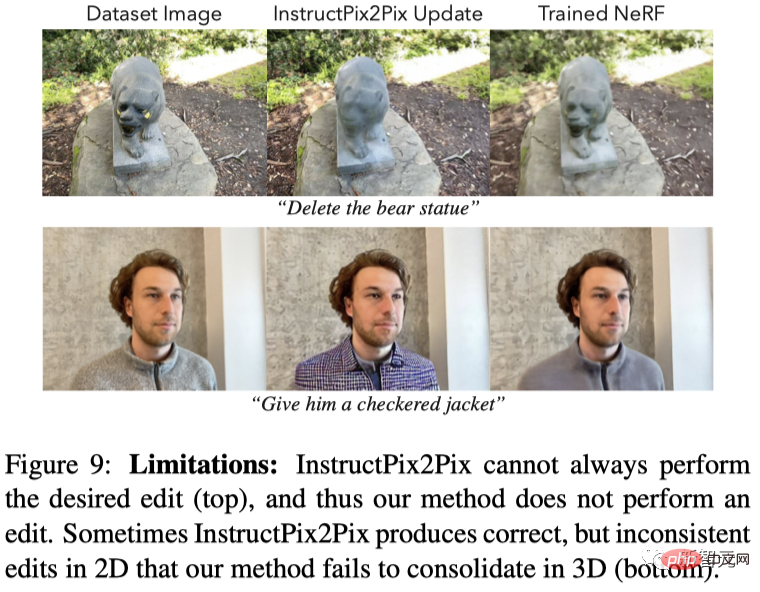

Masih ada had, tetapi kelemahannya tidak disembunyikan

Namun, memandangkan Instruct-NeRF2NeRF adalah berdasarkan InstructPix2Pix sebelumnya, ia mewarisi banyak batasan yang terakhir, seperti ketidakupayaan untuk menjalankan operasi ruang berskala besar.

Selain itu, seperti DreamFusion, Instruct-NeRF2NeRF hanya boleh menggunakan model resapan pada satu paparan pada satu masa, jadi anda mungkin menghadapi masalah artifak yang serupa.

Rajah berikut menunjukkan dua jenis kes kegagalan:

(1) Pix2Pix tidak boleh melakukan penyuntingan dalam 2D, jadi NeRF2NeRF dalam 3D Ia juga gagal;

(2) Pix2Pix boleh menyelesaikan penyuntingan dalam 2D, tetapi terdapat ketidakkonsistenan yang besar dalam 3D, jadi NeRF2NeRF juga gagal.

Contoh lain ialah "panda" di bawah, yang bukan sahaja kelihatan sangat garang (patung prototaip itu sangat garang) , dan warna bulunya agak pelik, dan mata jelas "tidak berbentuk" apabila bergerak dalam skrin.

Memandangkan ChatGPT, Diffusion, dan NeRF telah ditarik ke dalam perhatian, artikel ini boleh dikatakan memberikan permainan penuh kepada kelebihan ketiga-tiga , daripada "Ayat AI "Lukisan perkataan" telah maju kepada "AI pengeditan satu ayat adegan 3D".

Walaupun kaedah ini mempunyai beberapa batasan, ia masih mempunyai kelemahannya dan menyediakan penyelesaian yang mudah dan boleh dilaksanakan untuk penyuntingan ciri 3D, yang dijangka menjadi peristiwa penting dalam pembangunan NeRF.

Mengedit adegan 3D dalam satu ayat

Akhir sekali, mari kita lihat kesan yang dikeluarkan oleh pengarang.

Tidak sukar untuk melihat artifak pengeditan adegan 3D PS satu klik ini lebih sesuai dengan jangkaan dari segi keupayaan memahami perintah dan realisme imej Pada masa hadapan, ia mungkin menjadi pilihan popular di kalangan ahli akademik dan "kegemaran baru" di kalangan netizen telah mencipta Chat-NeRF selepas ChatGPT.

Walaupun anda menukar latar belakang, ciri bermusim dan cuaca gambar sesuka hati, Imej baru yang diberikan juga benar-benar konsisten dengan logik realiti.

Imej asal:

Musim luruh:

Salji:

Guru pasir:

Ribut:

Rujukan: https://www . php.cn/link/ebeb300882677f350ea818c8f333f5b9

Atas ialah kandungan terperinci Satu baris teks untuk mencapai perubahan wajah 3D! UC Berkeley mencadangkan 'Chat-NeRF' untuk melengkapkan rendering peringkat blockbuster hanya dalam satu ayat. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI