Rumah >Peranti teknologi >AI >Ensiklopedia AI: Cara ChatGPT berfungsi

Ensiklopedia AI: Cara ChatGPT berfungsi

- 王林ke hadapan

- 2023-04-12 13:31:034638semak imbas

ChatGPT dengan cepat mendapat perhatian berjuta-juta orang, tetapi ramai yang berhati-hati kerana mereka tidak memahami cara ia berfungsi. Dan artikel ini adalah percubaan untuk memecahkannya supaya lebih mudah difahami.

Pada asasnya, bagaimanapun, ChatGPT ialah sistem yang sangat kompleks. Jika anda ingin bermain dengan ChatGPT atau mengetahui apakah itu, antara muka teras ialah tetingkap sembang di mana anda boleh bertanya soalan atau memberikan pertanyaan dan AI akan bertindak balas. Butiran penting untuk diingat ialah dalam sembang, konteks dikekalkan, bermakna mesej boleh merujuk maklumat sebelumnya dan ChatGPT akan dapat memahami perkara ini secara kontekstual.

Apa yang berlaku apabila pertanyaan dimasukkan dalam kotak sembang

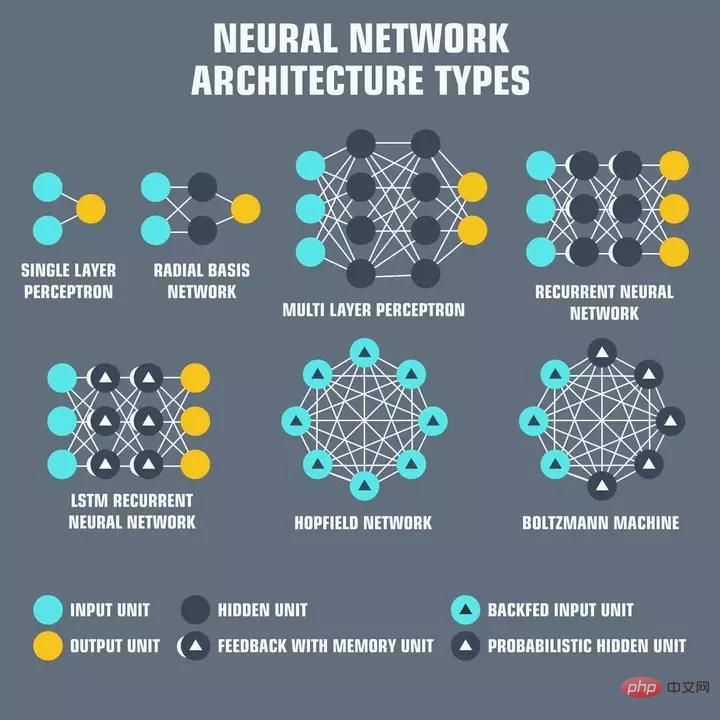

Rangkaian Neural

Pertama sekali, terdapat banyak perkara yang boleh ditemui dalam rangka kerja ChatGPT. Pembelajaran mesin telah berkembang pesat sejak 10 tahun yang lalu, dan ChatGPT menggunakan banyak teknologi terkini untuk mencapai keputusannya.

Rangkaian saraf ialah lapisan "neuron" yang saling berkaitan, setiap neuron bertanggungjawab untuk menerima input, memproses input dan menghantarnya ke rangkaian neuron seterusnya dalam . Rangkaian saraf membentuk tulang belakang kecerdasan buatan hari ini. Input biasanya satu set nilai berangka yang dipanggil "ciri" yang mewakili beberapa aspek data yang sedang diproses. Sebagai contoh, dalam kes pemprosesan bahasa, ciri-ciri tersebut mungkin merupakan penyusunan perkataan yang mewakili makna setiap perkataan dalam ayat.

Pembenaman perkataan hanyalah perwakilan berangka teks yang akan digunakan oleh rangkaian saraf untuk memahami semantik teks, yang kemudiannya boleh digunakan untuk tujuan lain seperti membalas dalam cara yang logik semantik! >Jadi selepas menekan enter dalam ChatGPT, teks itu mula-mula ditukar menjadi pembenaman perkataan, yang dilatih mengenai teks dari seluruh internet. Kemudian terdapat rangkaian saraf yang dilatih untuk mengeluarkan satu set pemasukan kata respons yang sesuai diberikan pemasukan kata input. Pembenaman ini kemudiannya diterjemahkan ke dalam perkataan yang boleh dibaca manusia menggunakan operasi songsang yang digunakan pada pertanyaan input. Output yang dinyahkod ini ialah apa yang dicetak oleh ChatGPT.

Saiz model ChatGPT

Penukaran dan penjanaan output adalah sangat mahal dari segi pengiraan. ChatGPT berada di atas GPT-3, model bahasa yang besar dengan 175 bilion parameter. Ini bermakna terdapat 175 bilion pemberat dalam rangkaian saraf meluas OpenAI yang ditala menggunakan set datanya yang besar.

Jadi setiap pertanyaan memerlukan sekurang-kurangnya dua 175 bilion pengiraan, yang menjumlahkan dengan cepat. OpenAI mungkin telah menemui cara untuk menyimpan cache pengiraan ini untuk mengurangkan kos pengiraan, tetapi tidak diketahui jika maklumat ini telah diterbitkan di mana-mana sahaja. Selain itu, GPT-4, yang dijangka dikeluarkan awal tahun ini, dikatakan mempunyai 1000 kali lebih parameter

Kerumitan pengiraan akan mengakibatkan kos sebenar Jangan terkejut jika ChatGPT menjadi produk berbayar tidak lama lagi! sebagai OpenAI pada masa ini Berjuta-juta dolar dibelanjakan untuk menjalankannya secara percuma.

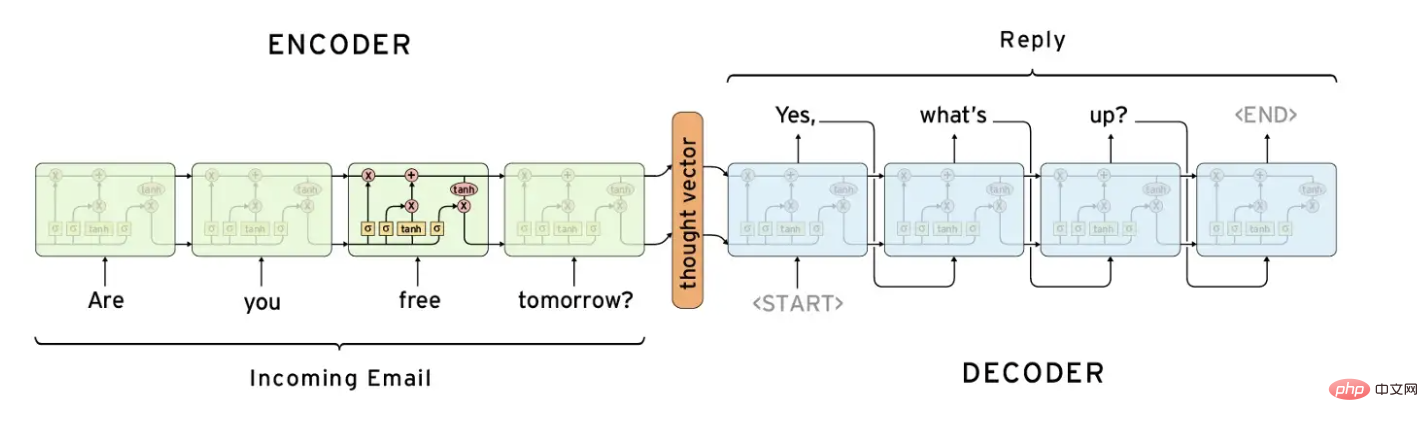

Pengekod, Penyahkod dan RNN

Struktur rangkaian saraf yang biasa digunakan dalam pemprosesan bahasa semula jadi ialah rangkaian penyahkod-pengekod. Rangkaian ini direka bentuk untuk "mengekodkan" urutan input ke dalam perwakilan padat dan kemudian "menyahkod" perwakilan itu ke dalam urutan output.

Secara tradisinya, rangkaian penyahkod pengekod telah dipasangkan dengan Rangkaian Neural Berulang (RNN) untuk memproses data berjujukan. Pengekod memproses jujukan input dan menghasilkan perwakilan vektor panjang tetap, yang kemudiannya dihantar kepada penyahkod. Penyahkod memproses vektor ini dan menghasilkan urutan keluaran.

Rangkaian penyahkod-pengekod telah digunakan secara meluas dalam tugas seperti terjemahan mesin, di mana input ialah ayat dalam satu bahasa dan output ialah terjemahan ayat tersebut ke bahasa lain. Ia juga telah digunakan untuk tugasan ringkasan dan penjanaan kapsyen imej.

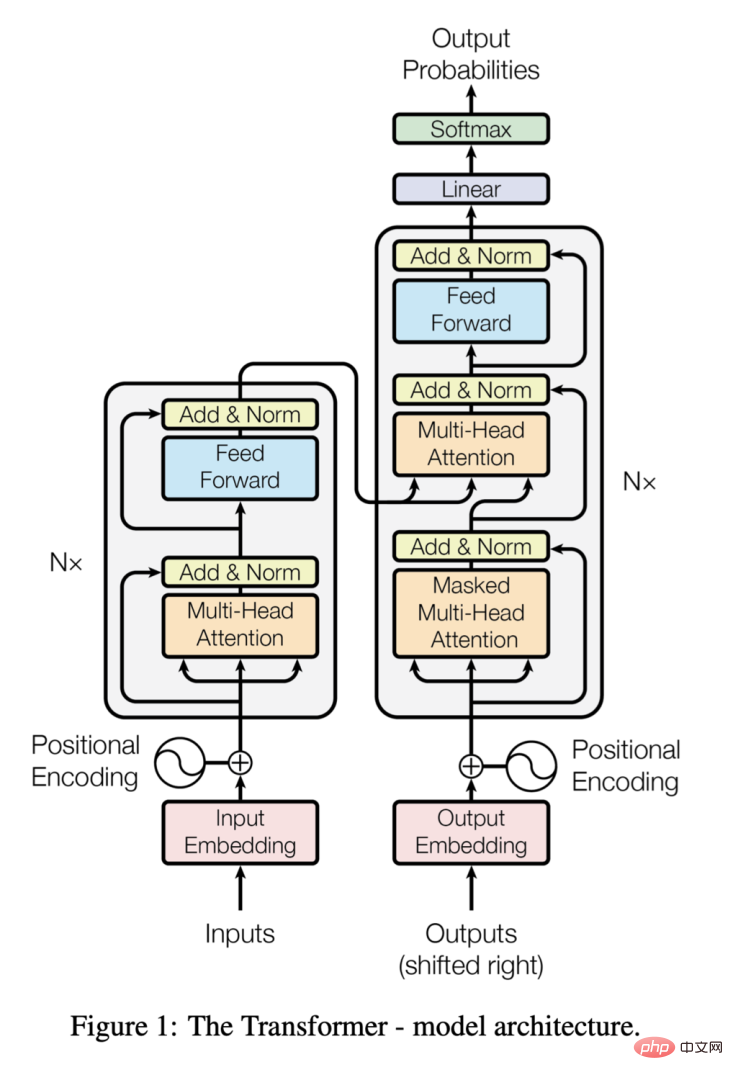

Sama seperti struktur pengekod-penyahkod, pengubah terdiri daripada dua komponen, bagaimanapun, penukar adalah berbeza kerana ia menggunakan mekanisme perhatian kendiri yang membolehkan setiap elemen input memfokus pada semua elemen lain, membolehkan ia menangkap hubungan antara elemen tanpa mengira jarak antara satu sama lain.

Transformer juga menggunakan perhatian berbilang kepala, membolehkannya memfokus pada berbilang bahagian input secara serentak. Ini membolehkannya menangkap perhubungan yang kompleks dalam teks input dan menghasilkan keputusan yang sangat tepat.

Apabila kertas "Attention is All You Need" diterbitkan pada 2017, transformer menggantikan seni bina penyahkod pengekod sebagai model terkini untuk pemprosesan bahasa semula jadi kerana ia boleh mencapai prestasi yang lebih baik pada teks yang lebih panjang.

Seni bina Transformer, daripada https://arxiv.org/pdf/1706.03762.pdf

Pralatihan generatif

Pralatihan generatif adalah teknik yang telah berjaya terutamanya dalam bidang pemprosesan bahasa semula jadi. Ia melibatkan latihan rangkaian saraf yang meluas pada set data besar-besaran dengan cara tanpa pengawasan untuk mempelajari perwakilan universal data. Rangkaian pra-latihan ini boleh diperhalusi untuk tugasan tertentu, seperti terjemahan bahasa atau menjawab soalan, dengan itu meningkatkan prestasi.

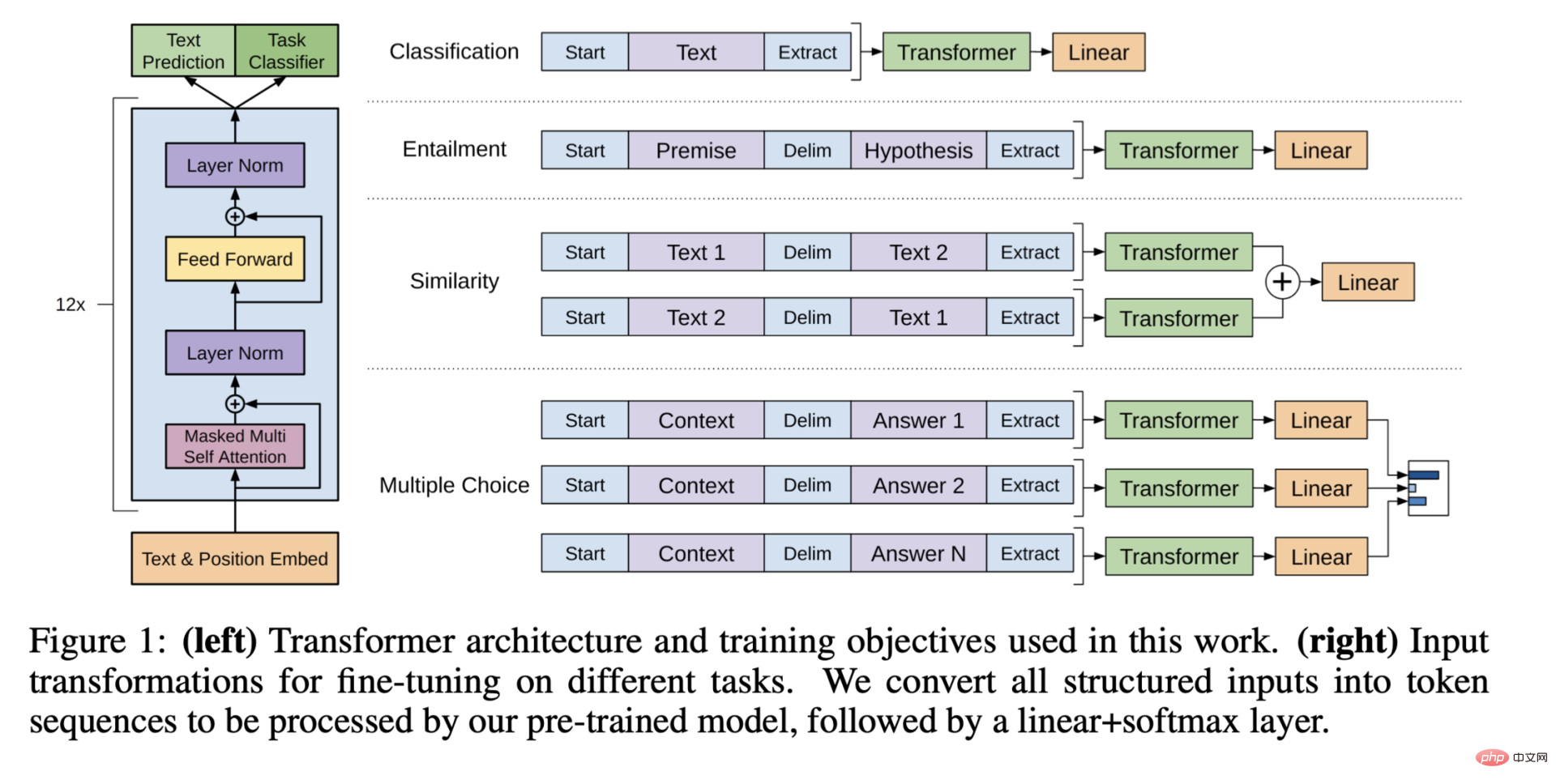

Seni bina pra-latihan generatif, dipetik daripada "Meningkatkan Pemahaman Bahasa Melalui Pra-latihan Generatif"

Dalam contoh ChatGPT , yang bermaksud memperhalusi lapisan terakhir model GPT-3 agar sesuai dengan kes penggunaan menjawab soalan dalam sembang, yang turut memanfaatkan pengetegan manusia. Rajah berikut boleh memberikan pemahaman yang lebih terperinci tentang penalaan halus ChatGPT:

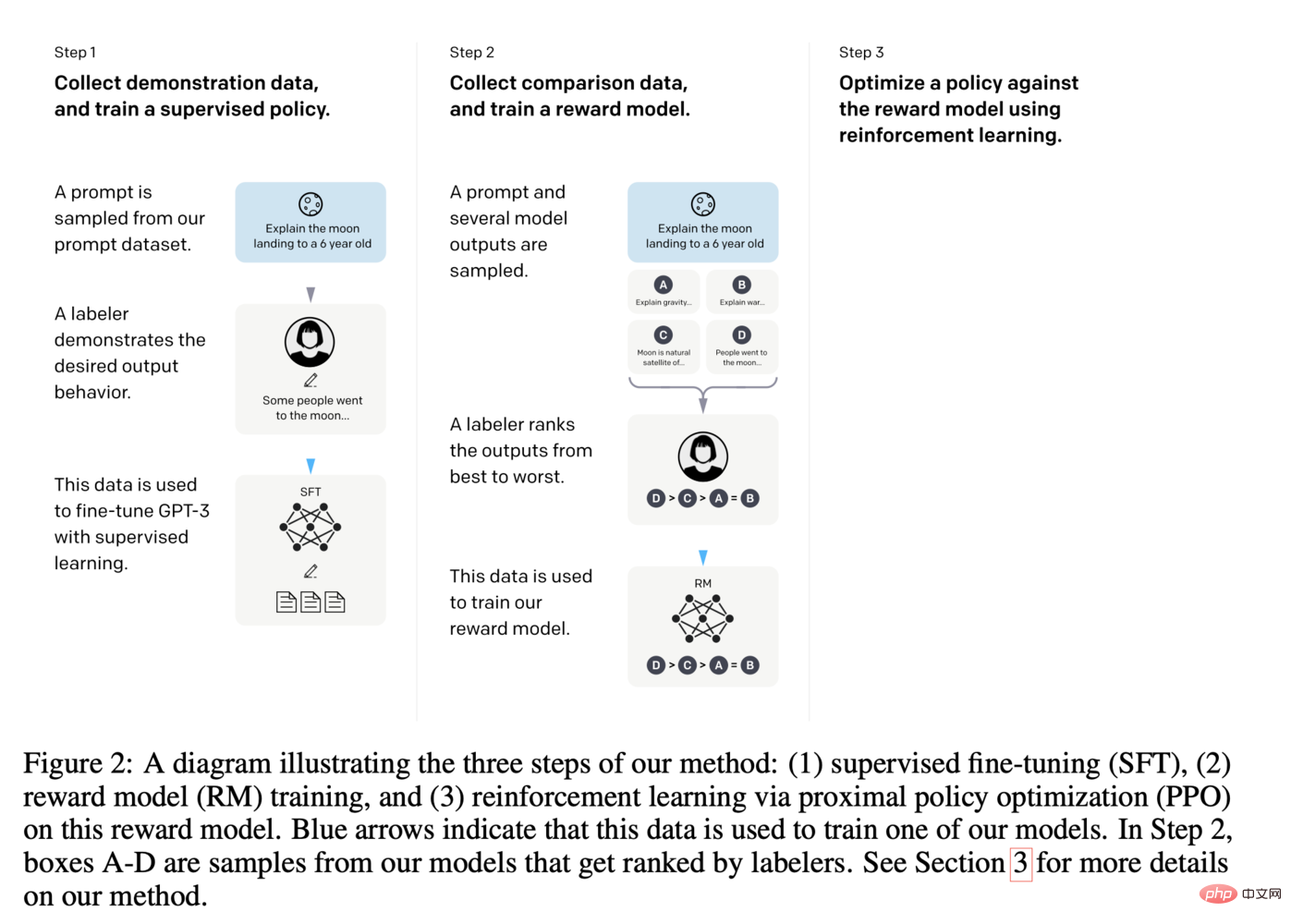

langkah penalaan halus ChatGPT, daripada https://arxiv.org /pdf/2203.02155.pdf

Menyatukan semuanya

Jadi terdapat banyak bahagian yang bergerak di bawah naungan ChatGPT yang hanya akan berkembang. Ia akan menjadi sangat menarik untuk melihat bagaimana ia terus berkembang, kerana kemajuan dalam banyak bidang yang berbeza akan membantu model seperti GPT mendapat penggunaan selanjutnya.

Dalam satu atau dua tahun akan datang, kita mungkin melihat gangguan yang ketara daripada teknologi pemboleh baharu ini.

Atas ialah kandungan terperinci Ensiklopedia AI: Cara ChatGPT berfungsi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI