Rumah >Peranti teknologi >AI >Kadar kemenangan terhadap manusia ialah 84%. AI DeepMind mencapai tahap pakar manusia dalam catur Barat untuk kali pertama

Kadar kemenangan terhadap manusia ialah 84%. AI DeepMind mencapai tahap pakar manusia dalam catur Barat untuk kali pertama

- PHPzke hadapan

- 2023-04-12 13:10:081271semak imbas

DeepMind telah membuat pencapaian baharu dalam bidang permainan AI, kali ini dalam catur Barat.

Dalam bidang permainan AI, kemajuan kecerdasan buatan sering ditunjukkan melalui permainan papan. Permainan papan boleh mengukur dan menilai cara manusia dan mesin membangun dan melaksanakan strategi dalam persekitaran terkawal. Selama beberapa dekad, keupayaan untuk merancang lebih awal telah menjadi kunci kejayaan AI dalam permainan maklumat sempurna seperti catur, dam, shogi dan Go, serta permainan maklumat tidak sempurna seperti poker dan Scotland Yard.

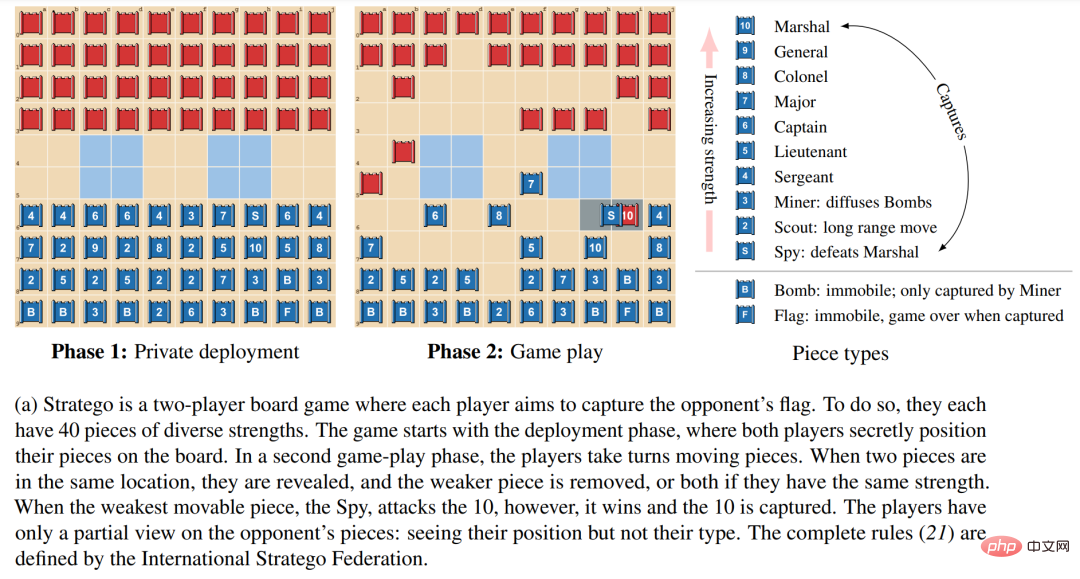

Stratego telah menjadi salah satu sempadan seterusnya penyelidikan AI. Visualisasi peringkat dan mekanik permainan ditunjukkan di bawah dalam 1a. Permainan ini menghadapi dua cabaran.

Pertama, pokok permainan Stratego mempunyai 10,535 kemungkinan keadaan, iaitu lebih banyak daripada permainan maklumat tidak sempurna Texas Hold’em Tanpa Sekatan (10,164 kemungkinan negeri yang mungkin) dan Go (10,360 kemungkinan keadaan yang mungkin) yang dipelajari dengan baik).

Kedua, bertindak dalam persekitaran tertentu dalam Stratego memerlukan penaakulan lebih 1066 kemungkinan penempatan untuk setiap pemain pada permulaan permainan, manakala poker hanya mempunyai 103 pasangan tangan yang mungkin. Permainan maklumat sempurna seperti Go dan catur tidak mempunyai fasa penggunaan peribadi, dengan itu mengelakkan kerumitan cabaran ini dalam Stratego.

Pada masa ini, tidak mungkin menggunakan teknologi perancangan maklumat sempurna SOTA berasaskan model, atau menggunakan teknologi carian maklumat yang tidak sempurna yang menguraikan permainan ke dalam situasi bebas.

Atas sebab ini, Stratego menyediakan penanda aras yang mencabar untuk mengkaji interaksi dasar berskala besar. Seperti kebanyakan permainan papan, Stratego menguji keupayaan kita untuk membuat keputusan yang agak perlahan, bertimbang rasa dan logik secara berurutan. Dan kerana struktur permainan ini sangat kompleks, komuniti penyelidikan AI telah membuat sedikit kemajuan, dan kecerdasan buatan hanya boleh mencapai tahap pemain amatur manusia. Oleh itu, membangunkan ejen untuk mempelajari strategi hujung ke hujung untuk membuat keputusan optimum di bawah maklumat Stratego yang tidak sempurna, bermula dari awal dan tanpa data demonstrasi manusia, kekal sebagai salah satu cabaran utama dalam penyelidikan AI.

Atas sebab ini, Stratego menyediakan penanda aras yang mencabar untuk mengkaji interaksi dasar berskala besar. Seperti kebanyakan permainan papan, Stratego menguji keupayaan kita untuk membuat keputusan yang agak perlahan, bertimbang rasa dan logik secara berurutan. Dan kerana struktur permainan ini sangat kompleks, komuniti penyelidikan AI telah membuat sedikit kemajuan, dan kecerdasan buatan hanya boleh mencapai tahap pemain amatur manusia. Oleh itu, membangunkan ejen untuk mempelajari strategi hujung ke hujung untuk membuat keputusan optimum di bawah maklumat Stratego yang tidak sempurna, bermula dari awal dan tanpa data demonstrasi manusia, kekal sebagai salah satu cabaran utama dalam penyelidikan AI.

Baru-baru ini, dalam kertas terbaharu daripada DeepMind, penyelidik mencadangkan DeepNash, ejen yang mempelajari permainan kendiri Stratego dengan cara tanpa model tanpa demonstrasi manusia. DeepNask mengalahkan ejen SOTA AI sebelumnya dan mencapai tahap pemain manusia pakar dalam varian paling kompleks permainan, Stratego Classic.

Alamat kertas: https://arxiv.org/pdf/2206.15378.pdf.

Alamat kertas: https://arxiv.org/pdf/2206.15378.pdf.

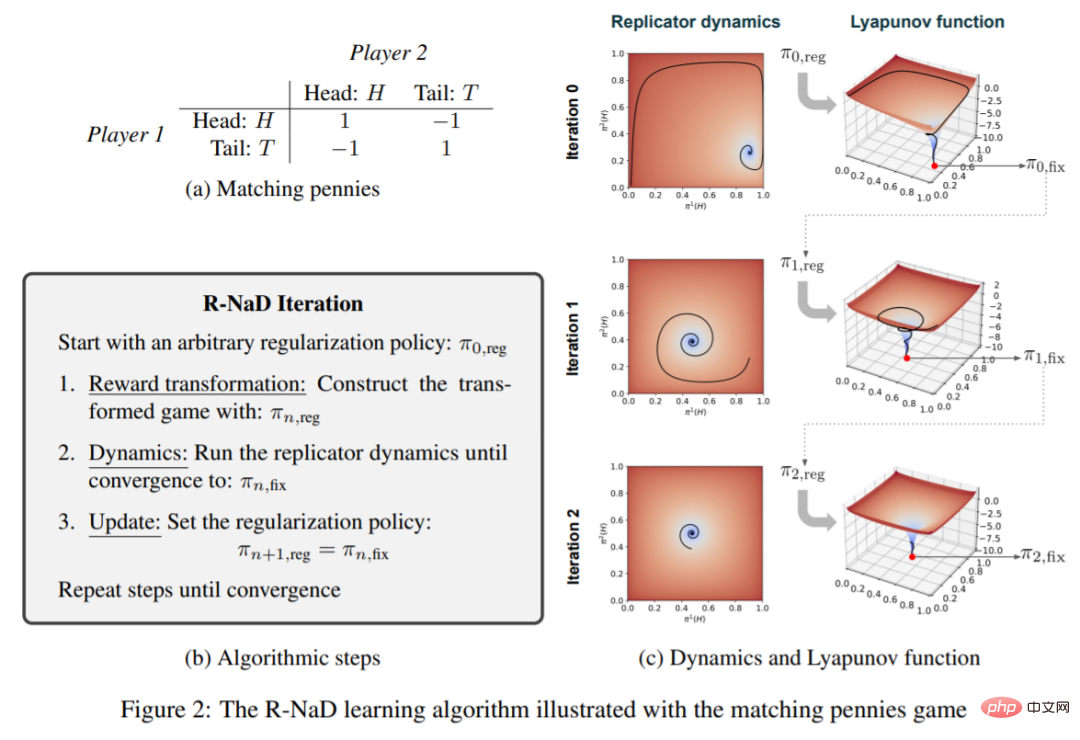

Inti DeepNash ialah algoritma pembelajaran tetulang bebas model yang berstruktur, yang penyelidik panggil Regularized Nash Dynamics (R-NaD). DeepNash menggabungkan R-NaD dengan seni bina rangkaian saraf yang mendalam dan menumpu kepada keseimbangan Nash, bermakna ia belajar bermain di bawah persaingan insentif dan teguh kepada pesaing yang cuba mengeksploitasinya.

Rajah 1 b di bawah ialah gambaran keseluruhan peringkat tinggi kaedah DeepNash. Para penyelidik secara sistematik membandingkan prestasinya dengan pelbagai robot SOTA Stratego dan pemain manusia pada platform permainan Gravon. Keputusan menunjukkan bahawa DeepNash mengalahkan semua robot SOTA semasa dengan kadar kemenangan lebih daripada 97% dan bersaing hebat dengan pemain manusia Ia menduduki tempat di antara 3 teratas dalam ranking pada 2022 dan dalam setiap tempoh, dengan kadar kemenangan 84%.

Penyelidik berkata buat pertama kalinya, algoritma AI boleh mencapai tahap pakar manusia dalam permainan papan kompleks tanpa menggunakan sebarang kaedah carian dalam algoritma pembelajaran. , ia juga merupakan kali pertama AI mencapai tahap pakar manusia dalam permainan Stratego.

Gambaran Keseluruhan Kaedah

DeepNash menggunakan strategi pembelajaran hujung ke hujung untuk menjalankan Stratego dan meletakkan buah catur secara strategik pada papan pada permulaan permainan (lihat Rajah 1a). -fasa bermain, Para penyelidik menggunakan kaedah RL mendalam dan teori permainan bersepadu. Ejen bertujuan untuk mempelajari anggaran keseimbangan Nash melalui permainan sendiri.

Penyelidikan ini menggunakan laluan ortogon tanpa carian dan mencadangkan kaedah baharu yang menggabungkan pembelajaran tetulang tanpa model dalam permainan kendiri dengan idea algoritma teori permainan - gabungan dinamik Nash (RNaD) yang dinormalisasi.

Bahagian bebas model bermakna penyelidikan tidak mewujudkan model lawan yang jelas untuk menjejaki kemungkinan keadaan pihak lawan. Bahagian teori permainan adalah berdasarkan idea bahawa berdasarkan kaedah pembelajaran pengukuhan, mereka bimbing ejen untuk belajar Pergerakan tingkah laku ke arah keseimbangan Nash. Kelebihan utama pendekatan komposisi ini ialah tidak perlu mengejek negara persendirian secara eksplisit daripada negeri awam. Cabaran kompleks tambahan adalah untuk menggabungkan pendekatan pembelajaran pengukuhan tanpa model ini dengan R-NaD untuk membolehkan permainan kendiri dalam catur Barat bersaing dengan pemain pakar manusia, sesuatu yang belum dicapai setakat ini. Kaedah gabungan DeepNash ini ditunjukkan dalam Rajah 1b di atas.

Algoritma Dinamik Nash Teratur

Algoritma pembelajaran R-NaD yang digunakan dalam DeepNash adalah berdasarkan idea penyelarasan untuk mencapai penumpuan R-NaD Langkah utama, seperti yang ditunjukkan dalam Rajah 2b di bawah:

DeepNash terdiri daripada tiga komponen: (1) Komponen latihan teras R-NaD ; (2) memperhalusi strategi pembelajaran untuk mengurangkan kebarangkalian sisa model mengambil tindakan yang sangat tidak mungkin, dan (3) pasca pemprosesan pada masa ujian untuk menapis tindakan berkemungkinan rendah dan membetulkan ralat.

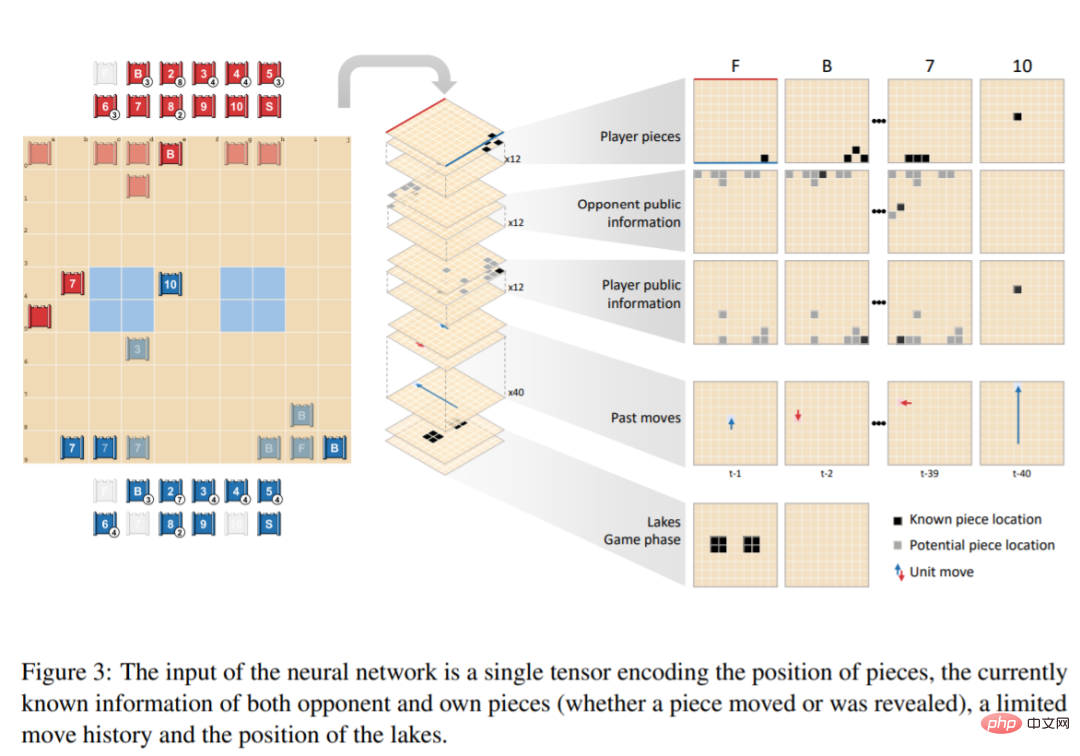

Rangkaian DeepNash terdiri daripada komponen berikut: tulang belakang U-Net dengan baki blok dan sambungan langkau, dan empat kepala. Kepala DeepNash pertama mengeluarkan fungsi nilai sebagai skalar, manakala tiga kepala yang selebihnya mengekod dasar ejen dengan mengeluarkan taburan kebarangkalian tindakannya semasa penggunaan dan permainan. Struktur tensor cerapan ini ditunjukkan dalam Rajah 3:

Hasil eksperimen

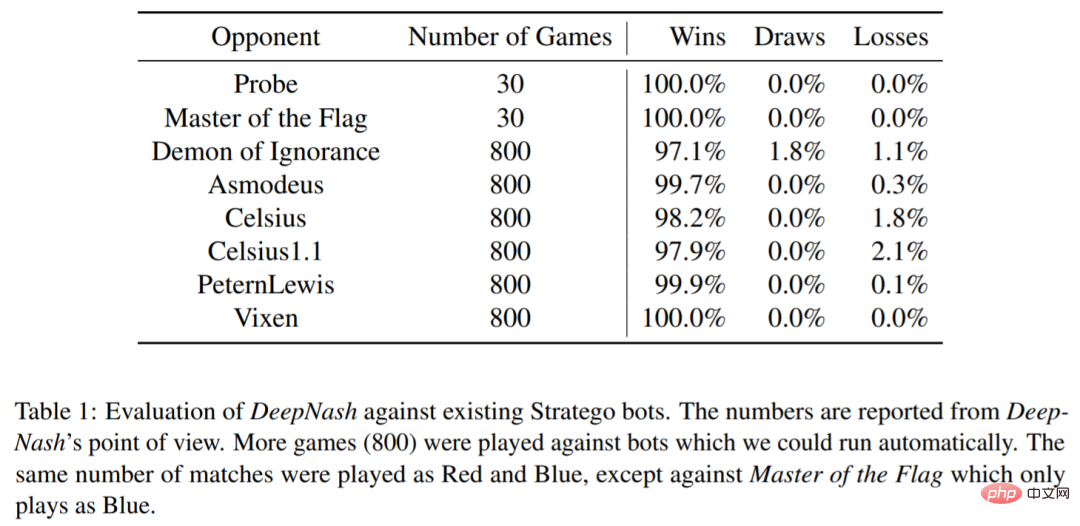

DeepNash juga berinteraksi dengan beberapa sedia ada Beberapa program komputer Stratego telah dinilai: Probe memenangi Kejohanan Dunia Strategi Komputer selama tiga tahun (2007, 2008, 2010); Celsius1.1, PeternLewis dan Vixen ialah program yang diserahkan dalam Pertandingan Pengaturcaraan Universiti Australia pada tahun 2012, yang dimenangi oleh PeternLewis.

Seperti yang ditunjukkan dalam Jadual 1, DeepNash memenangi sebahagian besar permainan menentang semua ejen ini, walaupun DeepNash tidak dilatih menentangnya dan hanya menggunakan permainan sendiri.

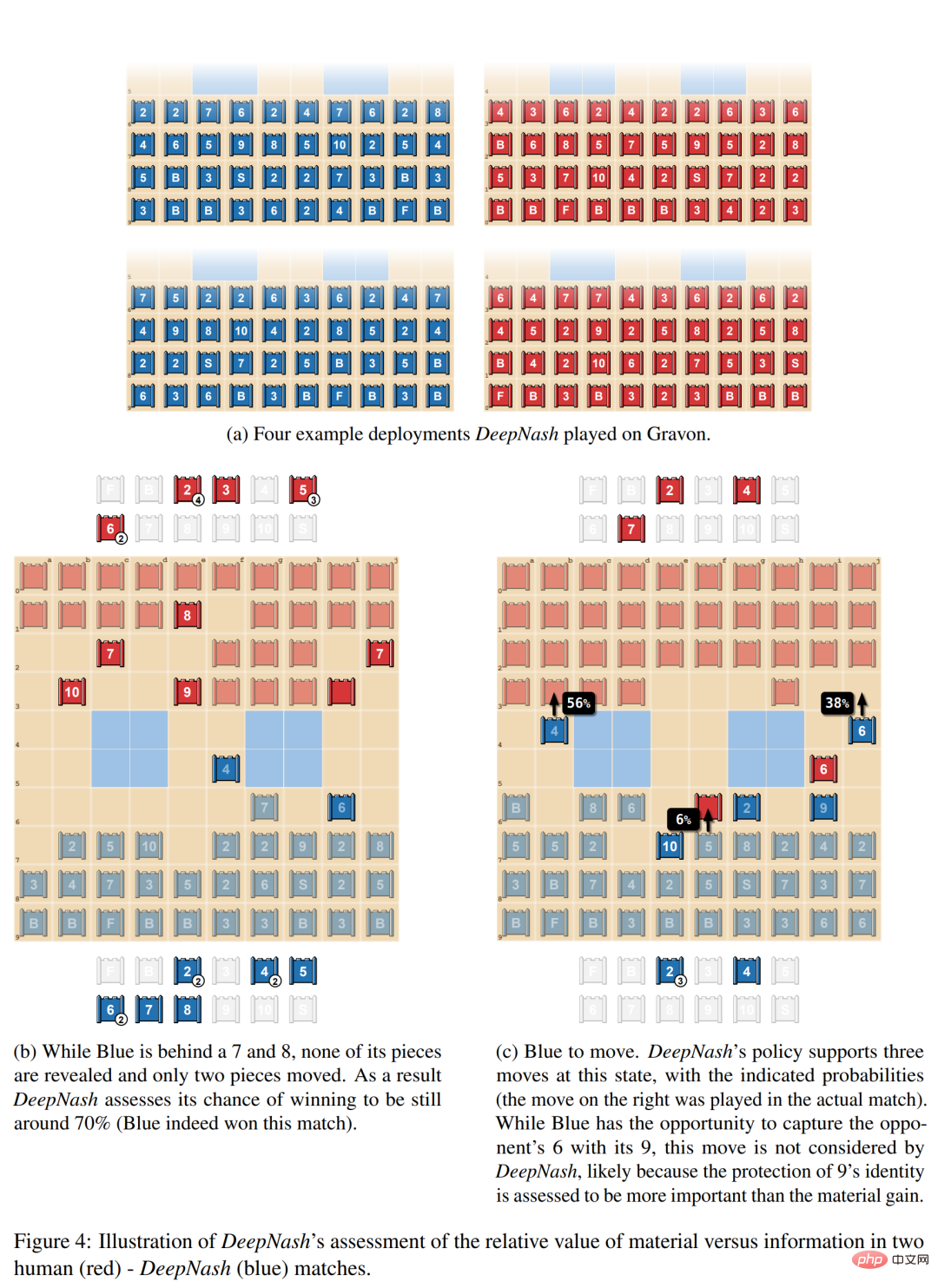

Rajah 4a di bawah menggambarkan beberapa kaedah penggunaan yang kerap diulang dalam DeepNash Rajah 4b menunjukkan DeepNash (biru) pada bahagian catur A situasi di mana anda berada di belakang di bahagian tengah (kalah 7 dan 8) tetapi di hadapan dari segi maklumat, kerana lawan di sebelah merah mempunyai 10, 9, 8 dan dua 7s. Contoh kedua dalam Rajah 4c menunjukkan DeepNash mempunyai peluang untuk menangkap 6 lawan dengan 9nya, tetapi langkah ini tidak dipertimbangkan, mungkin kerana DeepNash percaya bahawa melindungi identiti 9 dianggap lebih penting daripada keuntungan material.

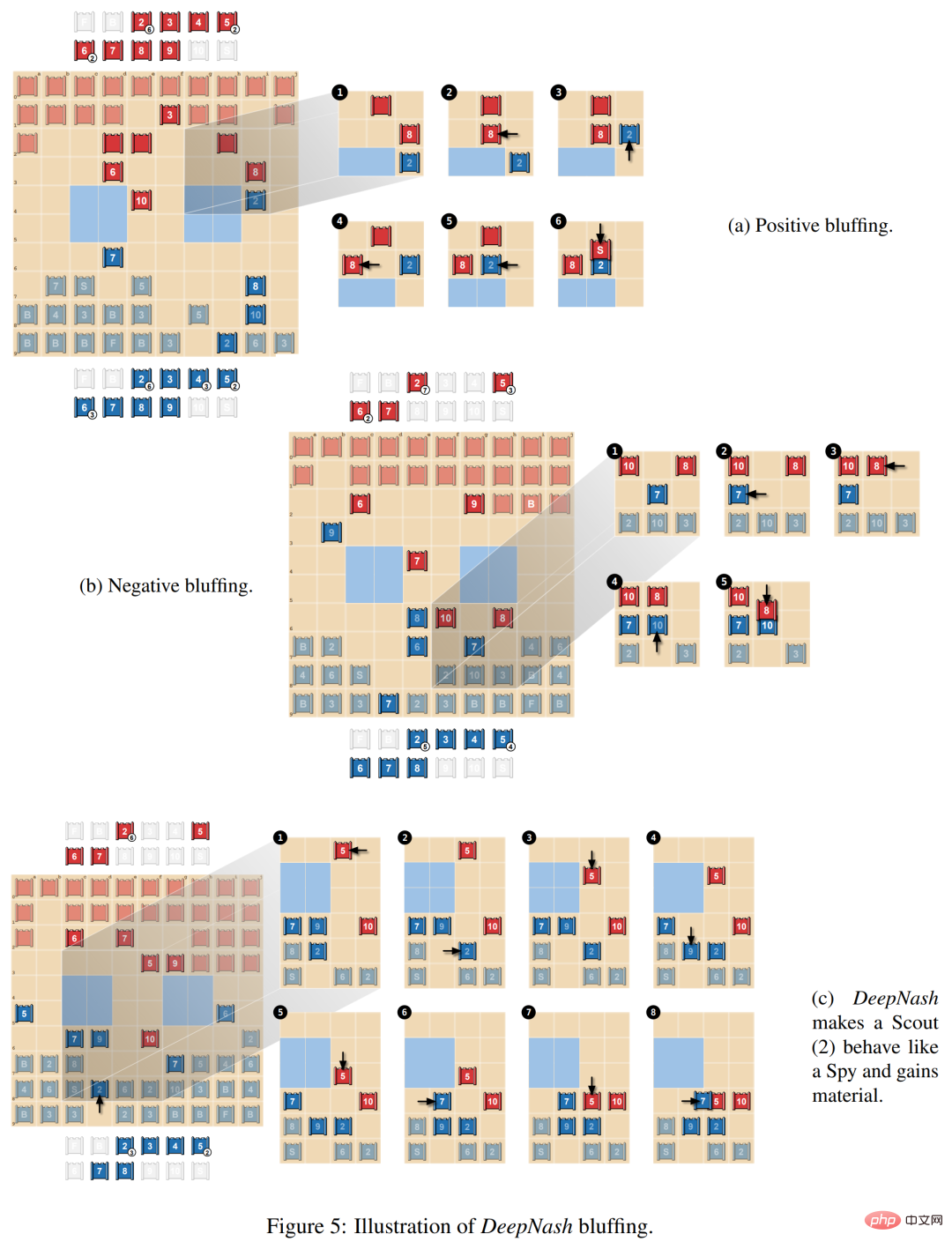

Dalam Rajah 5a di bawah, para penyelidik menunjukkan gertakan positif, di mana pemain berpura-pura bahawa nilai kepingan itu lebih tinggi daripada yang sebenarnya adalah. DeepNash mengejar 8 lawan dengan sekeping yang tidak diketahui Scout (2) dan berpura-pura ia adalah 10. Pihak lawan menganggap sekeping itu mungkin 10 dan membimbingnya di sebelah Perisik (di mana 10 boleh ditangkap). Walau bagaimanapun, untuk menangkap karya ini, Perisik lawan tewas kepada Pengakap DeepNash.

Jenis gertakan kedua ialah gertakan negatif, seperti ditunjukkan dalam Rajah 5b di bawah. Ia adalah bertentangan dengan gertakan aktif, di mana pemain berpura-pura bahawa karya itu bernilai kurang daripada yang sebenarnya.

Rajah 5c di bawah menunjukkan gertakan yang lebih kompleks, di mana DeepNash mendekatkan Pengakapnya (2) yang tidak didedahkan kepada 10 lawan, yang boleh ditafsirkan sebagai Perisik. Strategi ini sebenarnya membolehkan Biru menangkap Red 5 dengan 7 beberapa gerakan kemudian, dengan itu memperoleh bahan, menghalang 5 daripada menangkap Scout (2), dan mendedahkan bahawa ia sebenarnya bukan Perisik.

Atas ialah kandungan terperinci Kadar kemenangan terhadap manusia ialah 84%. AI DeepMind mencapai tahap pakar manusia dalam catur Barat untuk kali pertama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI