Rumah >Peranti teknologi >AI >Selepas kemunculan model yang sangat besar, adakah permainan AI telah tamat? Gary Marcus: Jalannya sempit

Selepas kemunculan model yang sangat besar, adakah permainan AI telah tamat? Gary Marcus: Jalannya sempit

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 11:46:061498semak imbas

Baru-baru ini, teknologi kecerdasan buatan telah membuat penemuan dalam model besar Imagen yang dicadangkan oleh Google semalam sekali lagi mencetuskan perbincangan tentang keupayaan AI. Melalui pembelajaran pra-latihan daripada sejumlah besar data, algoritma mempunyai keupayaan yang tidak pernah berlaku sebelum ini dalam membina imej yang realistik dan memahami bahasa.

Pada pendapat ramai orang, kita hampir dengan kecerdasan buatan umum, tetapi Gary Marcus, seorang sarjana dan profesor terkenal di Universiti New York, tidak berpendapat begitu.

Baru-baru ini, artikelnya "The New Science of Alt Intelligence" menyangkal pandangan Pengarah Penyelidikan DeepMind Nando de Freitas tentang "menang mengikut skala". Bagaimana untuk mengatakannya.

Berikut ialah teks asal daripada Gary Marcus:

Selama beberapa dekad, terdapat andaian dalam bidang AI bahawa kecerdasan buatan harus mendapat inspirasi daripada kecerdasan semula jadi. John McCarthy menulis kertas mani tentang mengapa AI memerlukan akal - "Program dengan Akal Biasa" Marvin Minsky menulis buku terkenal "Society of Mind", cuba mencari inspirasi daripada pemikiran manusia kerana dalam ekonomi tingkah laku Herb Simon, yang memenangi Hadiah Nobel dalam Ekonomi untuk sumbangannya, menulis "Models of Thought" yang terkenal, yang bertujuan untuk menerangkan "bagaimana bahasa komputer yang baru dibangunkan menyatakan teori proses psikologi supaya komputer dapat mensimulasikan tingkah laku manusia yang diramalkan." Setahu saya, sebahagian besar penyelidik AI semasa (sekurang-kurangnya yang lebih berpengaruh) tidak peduli sama sekali. Sebaliknya, mereka lebih menumpukan pada apa yang saya panggil "Alt Intelligence" (terima kasih kepada Naveen Rao atas sumbangannya kepada istilah itu).

Alt Intelligence tidak bermaksud membina mesin yang boleh menyelesaikan masalah dengan cara yang sama seperti kecerdasan manusia, sebaliknya menggunakan sejumlah besar data yang diperoleh daripada tingkah laku manusia untuk menggantikan kecerdasan. Pada masa ini, tumpuan utama Alt Intelligence ialah penskalaan. Penyokong sistem sedemikian berpendapat bahawa semakin besar sistem, semakin dekat kita dengan kecerdasan sebenar dan juga kesedaran.

Tiada perkara baru tentang mempelajari Alt Intelligence itu sendiri, tetapi keangkuhan yang dikaitkan dengannya.

Untuk beberapa waktu, saya telah melihat beberapa tanda bahawa bintang kepintaran buatan semasa, malah kebanyakan orang dalam keseluruhan bidang kecerdasan buatan, mengenepikan kognisi manusia, mengabaikan atau bahkan mengejek linguistik dan psikologi kognitif Ulama dalam bidang sains, antropologi dan falsafah.

Tetapi pagi ini saya menemui tweet baharu tentang Alt Intelligence. Nando de Freitas, pengarang tweet dan pengarah penyelidikan di DeepMind, mengisytiharkan bahawa AI "kini semuanya mengenai skala." Malah, pada pandangannya (mungkin sengaja provokatif dengan retorik berapi-api), cabaran yang lebih sukar dalam AI telah pun diselesaikan. "Permainan tamat!"

Pada dasarnya, tidak ada salahnya untuk mengejar Alt Intelligence.

Pada dasarnya, tidak ada salahnya untuk mengejar Alt Intelligence.

Alt Intelligence mewakili gerak hati (atau satu siri gerak hati) tentang cara membina sistem pintar. Memandangkan belum ada sesiapa yang tahu cara membina sistem yang boleh menandingi fleksibiliti dan kecerdasan kecerdasan manusia, adalah permainan yang adil untuk orang ramai meneruskan pelbagai hipotesis tentang cara mencapai matlamat ini. Nando de Freitas mempertahankan hipotesis ini seterus terang mungkin, dan saya memanggilnya Scaling-Uber-Alles.

Sudah tentu, nama itu tidak sepenuhnya memberikan keadilan. De Freitas sangat jelas bahawa anda tidak boleh membuat model lebih besar dan mengharapkan kejayaan. Orang ramai telah melakukan banyak penskalaan kebelakangan ini dan telah mencapai beberapa kejayaan besar, tetapi mereka juga menghadapi beberapa halangan. Sebelum kita menyelami cara De Freitas menghadapi status quo, mari kita lihat rupa status quo.

Status quoSistem seperti DALL-E 2, GPT-3, Flamingo dan

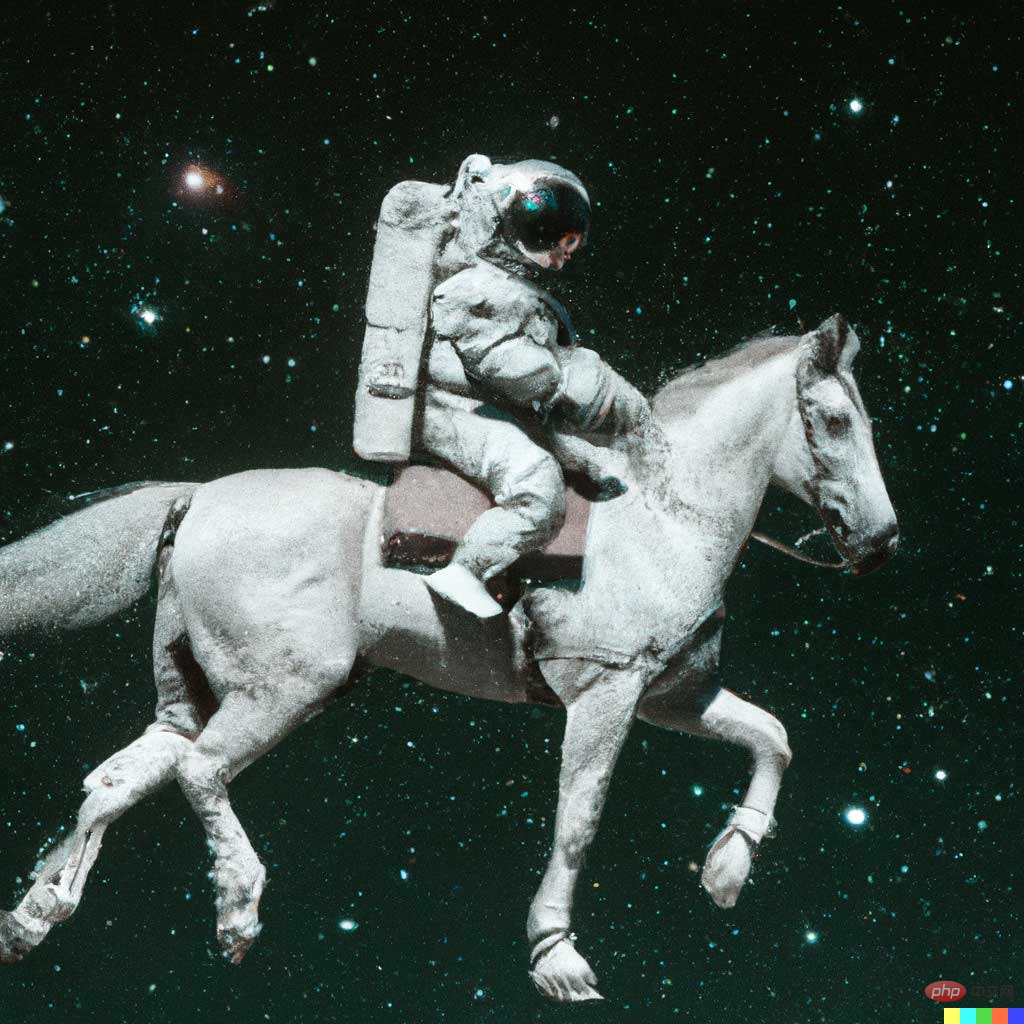

Gato nampaknya menarik Menarik, tetapi tiada sesiapa yang telah mengkaji model ini dengan teliti akan mengelirukan mereka dengan kecerdasan manusia. Sebagai contoh, DALL-E 2 boleh mencipta karya seni yang realistik berdasarkan penerangan teks, seperti "angkasawan menunggang kuda":

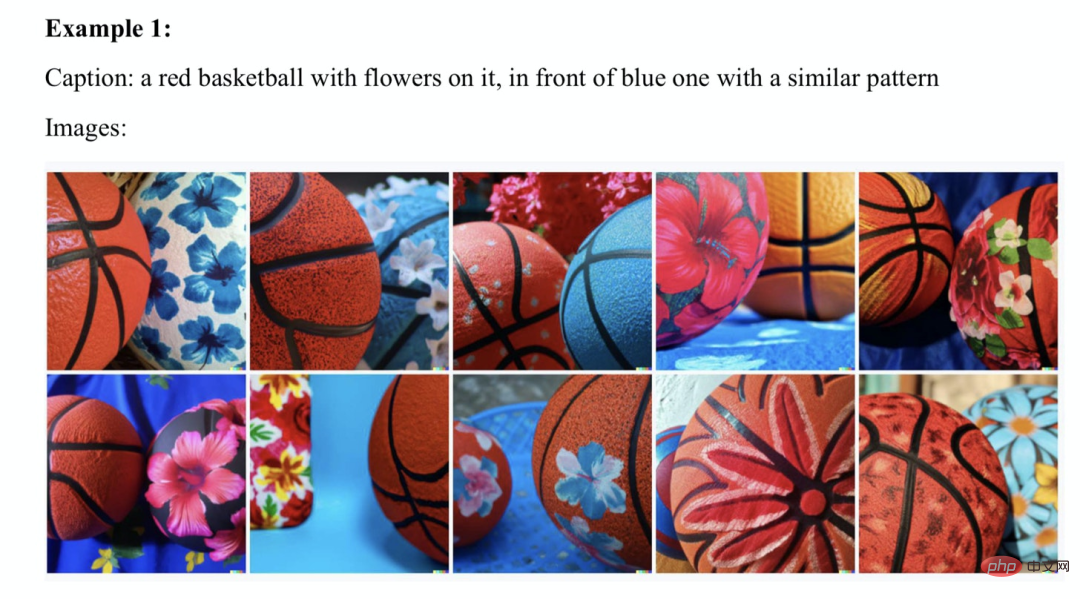

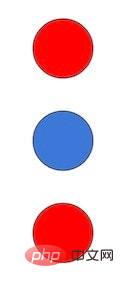

Tetapi Ia juga mudah untuk membuat kesilapan yang mengejutkan Contohnya, apabila penerangan teks ialah "segi empat segi merah pada segi empat sama biru", hasil yang dihasilkan DALL-E adalah seperti yang ditunjukkan dalam gambar kiri, dan gambar kanan dihasilkan oleh hasil model sebelumnya. Jelas sekali, hasil penjanaan DALL-E adalah lebih rendah daripada model sebelumnya.

Tetapi Ia juga mudah untuk membuat kesilapan yang mengejutkan Contohnya, apabila penerangan teks ialah "segi empat segi merah pada segi empat sama biru", hasil yang dihasilkan DALL-E adalah seperti yang ditunjukkan dalam gambar kiri, dan gambar kanan dihasilkan oleh hasil model sebelumnya. Jelas sekali, hasil penjanaan DALL-E adalah lebih rendah daripada model sebelumnya.

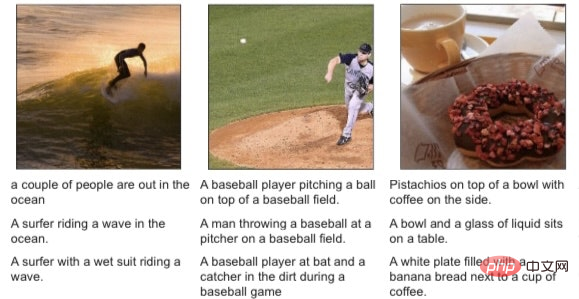

Apabila Ernest Davis, Scott Aaronson dan saya menggali masalah ini, kami menemui banyak contoh yang serupa:

Selain itu, Flamingo, yang kelihatan hebat di permukaan, juga mempunyai pepijatnya sendiri, cuma Seperti yang ditunjukkan oleh saintis penyelidikan kanan DeepMind Murray Shanahan dalam tweet, pengarang utama Flamingo Jean-Baptiste Alayrac kemudiannya menambah beberapa contoh. Sebagai contoh, Shanahan menunjukkan kepada Flamingo imej ini:

dan mempunyai perbualan cacat berikut mengelilingi imej:

Ia seolah-olah sesuatu "keluar daripada tiada".

Beberapa masa lalu, DeepMind juga mengeluarkan ejen "generalis" berbilang modal, berbilang tugas dan berbilang jelmaan Gato, tetapi apabila anda melihat cetakan kecil, anda masih boleh menemui ketidakpercayaan.

Sudah tentu, pembela pembelajaran mendalam akan menunjukkan bahawa manusia juga melakukan kesilapan.

Tetapi mana-mana orang yang jujur akan menyedari bahawa ralat ini menunjukkan bahawa ada sesuatu yang rosak pada masa ini. Tidak keterlaluan untuk mengatakan bahawa jika anak-anak saya melakukan kesilapan seperti ini secara tetap, saya akan menggugurkan semua yang saya lakukan dan membawa mereka ke pakar neurologi dengan segera.

Jadi, jujurlah: Penskalaan masih belum berfungsi, tetapi mungkin, atau sebagainya teori de Freitas — ungkapan yang jelas tentang zeitgeist — berlaku.

Scaling-Uber-Alles

Jadi bagaimanakah de Freitas menyelaraskan realiti dengan cita-cita? Malah, berbilion dolar kini telah dilaburkan dalam Transformer dan banyak bidang berkaitan lain, set data latihan telah berkembang daripada megabait kepada gigabait, dan saiz parameter telah berkembang daripada berjuta-juta kepada trilion. Walau bagaimanapun, kesilapan membingungkan yang telah didokumenkan secara terperinci dalam banyak karya sejak 1988 masih kekal.

Bagi sesetengah orang (seperti saya), kewujudan masalah ini mungkin bermakna kita perlu menjalani pemikiran semula asas, seperti yang ditunjukkan oleh Davis dan saya dalam "Reboot AI". Tetapi untuk de Freitas, ini tidak berlaku (ramai orang lain juga mungkin mempunyai idea yang sama dengannya, saya tidak cuba untuk memilih dia, saya hanya fikir kenyataannya lebih mewakili).

Dalam tweet, beliau menghuraikan pandangannya tentang menyelaraskan realiti dengan isu semasa, “(Kita perlu) menjadikan model lebih besar, lebih selamat, lebih cekap dari segi pengiraan, lebih cepat untuk dijadikan sampel dan lebih cekap untuk disimpan lebih banyak kecerdasan dan mod, dan kita juga perlu mengkaji inovasi data, dalam talian/luar talian, dsb. "Intinya, tiada satu pun perkataan yang datang daripada psikologi kognitif, linguistik atau falsafah (mungkin ingatan yang lebih bijak hampir tidak boleh dikira).

Dalam catatan susulan, de Freitas juga berkata:

Ini sekali lagi mengesahkan kenyataannya bahawa "skala lebih besar daripada yang lain" dan menunjukkan Satu matlamat: Cita-citanya bukan sahaja AI yang lebih baik, tetapi AGI.

AGI adalah singkatan dari Artificial General Intelligence, yang sekurang-kurangnya sama baiknya, sepindah dan boleh digunakan secara luas seperti kecerdasan manusia. Rasa sempit kecerdasan buatan yang kini kita sedar sebenarnya adalah kecerdasan alternatif (alt intelligence), dan kejayaan ikoniknya adalah permainan seperti catur (Deep Blue tiada kaitan dengan kecerdasan manusia) dan Go (AlphaGo tidak ada kaitan dengan kecerdasan manusia) . De Freitas mempunyai matlamat yang lebih bercita-cita tinggi, dan untuk kreditnya, dia sangat berterus terang tentangnya. Jadi, bagaimana dia mencapai matlamatnya? Untuk mengulangi di sini, de Freitas memfokuskan pada alat teknikal untuk menampung set data yang lebih besar. Idea lain, seperti daripada falsafah atau sains kognitif, mungkin penting tetapi dikecualikan.

Dia berkata, "Falsafah simbol tidak perlu." Mungkin ini adalah sanggahan kepada pergerakan saya yang telah lama wujud untuk mengintegrasikan manipulasi simbolik ke dalam sains kognitif dan kecerdasan buatan. Idea itu muncul semula baru-baru ini dalam majalah Nautilus, walaupun ia tidak dihuraikan sepenuhnya. Berikut ialah respons ringkas saya: Apa yang dia katakan "jaringan [neural] tidak mempunyai isu mencipta [simbol] dan memanipulasinya" mengabaikan kedua-dua sejarah dan realiti. Apa yang dia abaikan ialah sejarah bahawa ramai peminat rangkaian saraf telah menentang simbol selama beberapa dekad; dia mengabaikan realiti bahawa penerangan simbolik seperti "kiub merah pada kiub biru" yang disebutkan di atas masih boleh menghalang minda model SOTA 2022.

Pada akhir tweet, De Freitas menyatakan persetujuannya terhadap artikel terkenal Rich Sutton "Pengajaran Pahit":

Hujah Sutton ialah satu-satunya perkara yang akan membawa kepada kemajuan dalam AI ialah lebih banyak data, pengiraan yang lebih cekap. Pada pendapat saya, Sutton hanya separuh betul, penerangannya tentang masa lalu hampir betul, tetapi ramalan induktifnya tentang masa depan tidak meyakinkan.

Setakat ini, data besar telah (sementara) mengalahkan kejuruteraan pengetahuan yang direka dengan baik dalam kebanyakan bidang (sudah tentu bukan semua bidang).

Tetapi hampir semua perisian di dunia, daripada penyemak imbas web ke hamparan kepada pemproses perkataan, masih bergantung pada kejuruteraan pengetahuan, dan Sutton mengabaikan perkara ini. Sebagai contoh, ciri Isi Kilat Sumit Gulwani yang sangat baik ialah sistem pembelajaran sekali sahaja yang sangat berguna yang tidak dibina di atas premis data besar sama sekali, tetapi pada teknik pengaturcaraan klasik.

Saya tidak fikir mana-mana sistem pembelajaran mendalam/data besar yang tulen boleh menyamai ini.

Malah, masalah utama dengan kecerdasan buatan yang saintis kognitif seperti Steve Pinker, Judea Pearl, Jerry Fodor, dan saya sendiri telah nyatakan selama beberapa dekad sebenarnya masih belum diselesaikan. Ya, mesin boleh bermain permainan dengan sangat baik, dan pembelajaran mendalam telah memberikan sumbangan besar dalam bidang seperti pengecaman pertuturan. Tetapi pada masa ini tiada kecerdasan buatan yang mempunyai pemahaman yang mencukupi untuk mengecam mana-mana teks dan membina model yang boleh bercakap secara normal dan menyelesaikan tugasan, dan juga tidak boleh menaakul dan menghasilkan tindak balas yang padu seperti komputer dalam filem "Star Trek".

Kami masih di peringkat awal kecerdasan buatan.

Kejayaan dalam beberapa masalah menggunakan strategi khusus tidak menjamin bahawa kami akan menyelesaikan semua masalah dengan cara yang sama. Adalah bodoh untuk tidak menyedari perkara ini, terutamanya apabila beberapa mod kegagalan (tidak boleh dipercayai, pepijat aneh, kegagalan gabungan dan ketidakfahaman) kekal tidak berubah sejak Fodor dan Pinker menunjukkannya pada tahun 1988. Kesimpulan

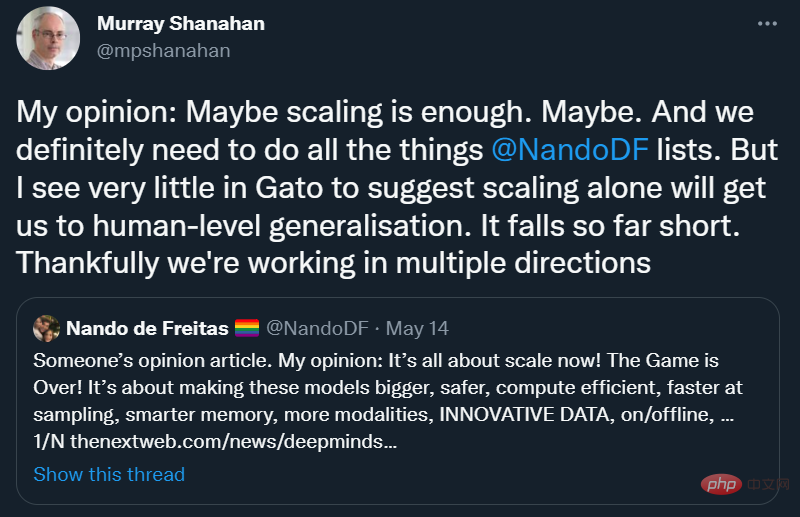

Senang melihat Scaling-Über-Alles belum dipersetujui sepenuhnya, malah di DeepMind:

Saya Sepenuhnya bersetuju dengan Murray Shanahan: "Saya melihat sangat sedikit dalam Gato untuk mencadangkan penskalaan sahaja akan membawa kita kepada generalisasi peringkat manusia."

Mari kita galakkan bidang yang cukup berfikiran terbuka sehingga orang ramai boleh membawa kerja mereka sendiri ke pelbagai arah tanpa membuang terlalu awal idea yang kebetulan belum dibangunkan sepenuhnya. Lagipun, jalan terbaik untuk kecerdasan buatan (umum) mungkin bukan Alt Intelligence.

Seperti yang dinyatakan sebelum ini, saya suka menganggap Gato sebagai "kecerdasan alternatif" - penerokaan menarik ke dalam cara alternatif membina kecerdasan, tetapi kita perlu meletakkannya dalam perspektif: ia tidak akan berfungsi seperti otak, ia akan Ia tidak belajar seperti kanak-kanak, ia tidak memahami bahasa, ia tidak selaras dengan nilai kemanusiaan, dan ia tidak boleh dipercayai untuk menyelesaikan tugas kritikal.

Ia mungkin lebih baik daripada apa-apa lagi yang kita ada sekarang, tetapi ia masih tidak benar-benar berkesan, dan walaupun selepas melabur banyak, sudah tiba masanya untuk kita berhenti seketika.

Ia sepatutnya membawa kita kembali ke zaman awal kecerdasan buatan. Sudah tentu, kecerdasan buatan tidak seharusnya menjadi salinan buta kecerdasan manusia Lagipun, ia mempunyai kelemahannya sendiri dan dibebani dengan daya ingatan yang lemah dan kecenderungan kognitif. Tetapi ia harus melihat kepada kognisi manusia dan haiwan untuk petunjuk. Wright bersaudara tidak meniru burung, tetapi mereka belajar sesuatu tentang kawalan penerbangan mereka. Mengetahui apa yang boleh dipelajari dan apa yang tidak boleh dipelajari, kita mungkin lebih daripada separuh berjaya.

Saya rasa kesimpulannya ialah, apa yang AI pernah nilai tetapi tidak lagi mengejar: Jika kita akan membina AGI, kita perlu belajar sesuatu daripada manusia - bagaimana mereka membuat alasan dan memahami dunia fizikal, dan Bagaimana mereka mewakili dan memperoleh bahasa dan konsep yang kompleks.

Adalah terlalu angkuh untuk menafikan idea ini.

Atas ialah kandungan terperinci Selepas kemunculan model yang sangat besar, adakah permainan AI telah tamat? Gary Marcus: Jalannya sempit. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI