Rumah >Peranti teknologi >AI >Satu artikel untuk memahami proses pelaksanaan platform AI asli Wuyun-KubeAI

Satu artikel untuk memahami proses pelaksanaan platform AI asli Wuyun-KubeAI

- 王林ke hadapan

- 2023-04-12 11:34:112020semak imbas

1. Kata Pengantar

Dalam beberapa tahun kebelakangan ini, bidang asli awan yang diwakili oleh teknologi kontena telah mendapat perhatian dan pembangunan yang hebat. Sehingga kini, Dewu pada asasnya telah melengkapkan kontena keseluruhan domain. Semasa proses kontena, di satu pihak, penggunaan perkhidmatan dan kaedah operasi dan penyelenggaraan telah ditukar dengan lancar daripada mod ECS sebelumnya kepada mod kontena sebaliknya, syarikat mencapai banyak keuntungan kecekapan dari segi penggunaan sumber dan kecekapan R&D; .

Dewu ialah generasi baharu komuniti beli-belah dalam talian yang bergaya Enjin carian dan sistem pengesyoran diperibadikan berdasarkan AI dan teknologi data besar adalah sokongan kukuh untuk pembangunan perniagaan aplikasi. Semasa proses kontena, memandangkan perbezaan antara proses R&D perkhidmatan aplikasi algoritma dan perkhidmatan biasa, dan berdasarkan penyiasatan sepenuhnya keperluan pelajar R&D dalam domain algoritma, kami membina platform AI asli Dewu Cloud-KubeAI untuk Senario R&D dalam domain algoritma. Selepas lelaran berterusan fungsi dan pengembangan berterusan senario yang disokong, KubeAI kini menyokong domain perniagaan yang melibatkan keupayaan AI seperti CV, pengesyoran carian, algoritma kawalan risiko dan analisis data, dan telah berjaya menyelesaikan kontena, meningkatkan penggunaan sumber dan kecekapan R&D penambahbaikan di atas telah mencapai keputusan yang baik Artikel ini akan membawa semua orang memahami proses pelaksanaan KubeAI.

2. Promosi kontena perniagaan AI

2.1 Proses pembangunan model algoritma AI

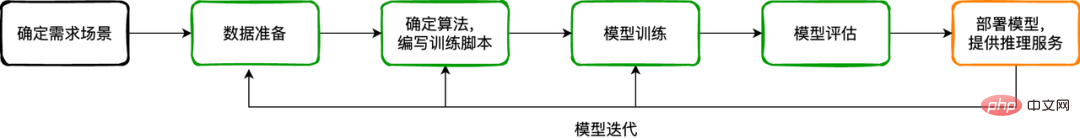

Perniagaan AI lebih kepada proses pembangunan berulang untuk model, biasanya proses pembangunan model Ia boleh diringkaskan ke dalam langkah-langkah berikut:

Tentukan senario permintaan: Proses ini mesti menentukan dengan jelas masalah yang diselesaikan, senario apa yang disediakan untuk fungsi, dan apakah input fungsi/perkhidmatan Apakah, apakah output? Contohnya: Jenama kasut yang manakah harus dikenal pasti atau kualiti diperiksa, apakah ciri produk jenama itu, apakah dimensi ciri yang ada pada sampel, jenis ciri, dsb. Senario yang berbeza mempunyai keperluan yang berbeza untuk data sampel dan algoritma pemprosesan yang digunakan.

Penyediaan data: Menurut hasil analisis permintaan senario, dapatkan data sampel melalui pelbagai kaedah (dalam talian/luar talian/olok-olok, dll.), dan lakukan pembersihan, pelabelan dan operasi lain yang diperlukan pada data. Proses ini adalah asas pembangunan perniagaan AI, kerana semua proses seterusnya dilakukan berdasarkan data.

Tentukan algoritma dan tulis skrip latihan: Berdasarkan pemahaman matlamat perniagaan, dalam pautan ini pelajar algoritma akan memilih algoritma yang sesuai dan menulis skrip latihan model berdasarkan pengalaman lalu, atau berdasarkan kajian tempat kejadian dan hasil eksperimen.

Latihan model: Untuk model algoritma, kita boleh memahaminya sebagai formula matematik yang kompleks akan terdapat banyak parameter dalam formula ini, sama seperti w dan b dalam f(x)=wx+b . Latihan ialah proses menggunakan sejumlah besar data sampel untuk mencari parameter optimum bagi menjadikan model mempunyai kadar pengecaman yang tinggi. Latihan model adalah bahagian yang sangat penting dalam proses pembangunan perniagaan AI Boleh dikatakan bahawa pencapaian matlamat perniagaan bergantung pada ketepatan model. Oleh itu, pautan ini memerlukan lebih banyak masa, tenaga dan sumber berbanding pautan lain, dan ia memerlukan latihan percubaan berulang untuk mencapai ketepatan model dan ketepatan ramalan yang terbaik. Proses ini bukan sekali sahaja, tetapi kitaran Mengikut kemas kini senario perniagaan dan kemas kini data, ia mesti dijalankan secara berkala. Untuk pembangunan dan latihan model algoritma, terdapat beberapa enjin AI arus perdana untuk dipilih dalam industri, seperti TensorFlow, PyTorch, MXNet, dll. Enjin ini boleh menyediakan tahap sokongan API tertentu untuk memudahkan pembangun algoritma mengedarkan model yang kompleks . latihan, atau membuat beberapa pengoptimuman untuk perkakasan untuk meningkatkan kecekapan latihan model. Hasil daripada latihan model adalah untuk mendapatkan fail model Kandungan fail ini boleh difahami sebagai menyimpan parameter model.

Penilaian model: Untuk mengelakkan kekurangan model akibat sisihan berlebihan atau pemasangan berlebihan disebabkan varians yang berlebihan, beberapa penunjuk penilaian biasanya diperlukan untuk membimbing pembangun menilai keupayaan generalisasi model. Beberapa penunjuk penilaian yang biasa digunakan, seperti: ketepatan, kadar panggil balik, keluk ROC/AUC, keluk PR, dsb.

Penempatan model: Selepas latihan dan penilaian berulang, model ideal boleh diperoleh untuk membantu proses perniagaan dalam talian/data pengeluaran. Ini memerlukan penggunaan model dalam bentuk perkhidmatan atau tugas untuk menerima data input dan memberikan hasil inferens Kami memanggil perkhidmatan ini sebagai perkhidmatan model. Perkhidmatan model ialah skrip perkhidmatan dalam talian yang memuatkan model Selepas ia sedia, ia menjalankan pengiraan inferens pada data yang telah diproses.

Selepas perkhidmatan model dilancarkan, perkhidmatan model perlu diulang disebabkan oleh perubahan dalam ciri data, peningkatan algoritma, peningkatan skrip perkhidmatan inferens dalam talian, keperluan perniagaan baharu untuk penunjuk inferens, dsb. Perlu diingatkan bahawa proses berulang ini mungkin memerlukan latihan semula dan penilaian semula model;

2.2 Penghijrahan kontena sedang giat dijalankan

Sejak tahun lepas, kami secara beransur-ansur mempromosikan pelaksanaan kontena perkhidmatan perniagaan dalam pelbagai domain Dewu. Untuk mengurangkan perubahan dalam tabiat pengendalian pengguna yang disebabkan oleh perubahan dalam kaedah penggunaan semasa proses kontena, kami terus menggunakan proses penggunaan platform penerbitan untuk melindungi perbezaan antara penggunaan kontena dan penggunaan ECS.

Dalam proses CI, templat kompilasi dan pembinaan yang berbeza disesuaikan mengikut jenis bahasa pembangunan yang berbeza Daripada kompilasi kod sumber kepada penghasilan imej kontena, ia diselesaikan secara seragam oleh lapisan platform kontena, yang menyelesaikan masalah biasa. Kebimbangan pelajar P&P tentang bekas Masalahnya ialah kod kejuruteraan tidak boleh dijadikan imej kontena kerana kurang pengetahuan. Semasa proses CD, kami melaksanakan pengurusan hierarki konfigurasi pada peringkat jenis aplikasi, peringkat persekitaran dan peringkat kumpulan persekitaran Apabila melaksanakan penggunaan, kami menggabungkan konfigurasi berbilang lapisan ke dalam nilai.yaml Carta Helm dan menyerahkan fail orkestrasi ke dalam. kelompok kontena. Pengguna hanya perlu menetapkan pembolehubah persekitaran yang sepadan mengikut keperluan sebenar mereka, menyerahkan penggunaan, dan kemudian mendapatkan contoh kelompok aplikasi (contoh bekas, serupa dengan contoh perkhidmatan ECS).

Untuk pengendalian dan penyelenggaraan kelompok aplikasi, platform kontena menyediakan fungsi log masuk ke contoh kontena melalui WebShell, sama seperti log masuk ke contoh ECS, yang sesuai untuk menyelesaikan masalah berkaitan proses aplikasi ; platform kontena juga menyediakan muat naik dan muat turun fail, Instance restart dan pembinaan semula, pemantauan sumber dan fungsi operasi dan penyelenggaraan yang lain.

Perniagaan AI (CV, carian dan pengesyoran, perkhidmatan algoritma kawalan risiko, dll.), sebagai perniagaan yang agak besar, mengambil bahagian dalam proses kontena bersama-sama dengan perkhidmatan perniagaan biasa Kami telah secara beransur-ansur menyelesaikan air terjun masyarakat dan urus niaga. Migrasi perkhidmatan adegan teras yang diwakili oleh aliran dan kedudukan vajra. Selepas kontena, penggunaan sumber persekitaran ujian telah bertambah baik, persekitaran pengeluaran juga telah bertambah baik, dan kecekapan operasi dan penyelenggaraan telah meningkat dua kali ganda.

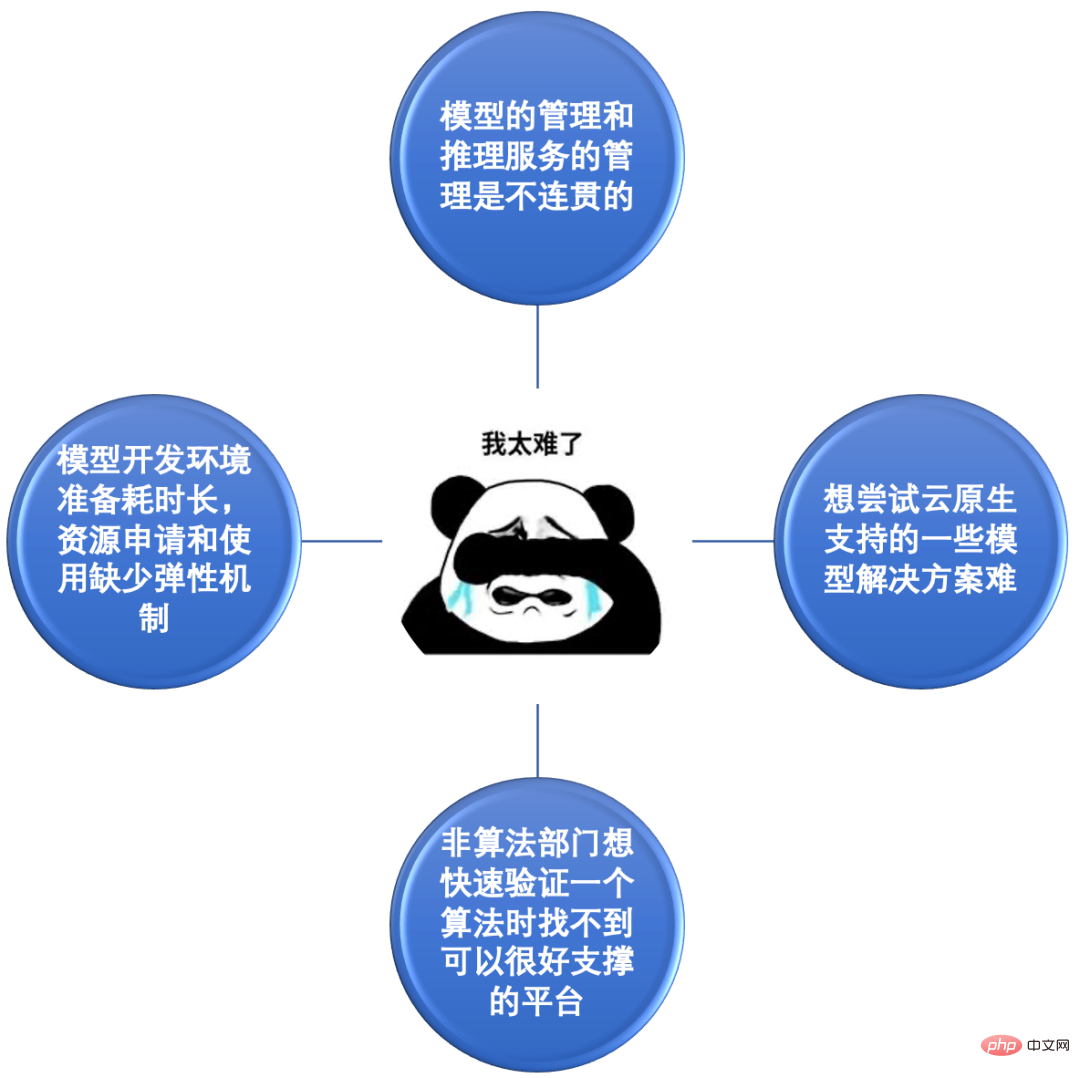

2.3 Pelajar algoritma tidak dapat menanggung kesakitan

Proses kontena Dewu disertai dengan perkembangan pesat sistem teknologi syarikat, yang menjadikan proses penyelidikan dan pembangunan perkhidmatan AI yang tidak matang awal sukar untuk kontena. Lebih banyak tuntutan dikemukakan, membolehkan kami yang pada asalnya hanya menumpukan pada kontena perkhidmatan inferens dalam talian untuk melihat titik kesakitan dan kesukaran yang dihadapi oleh pelajar algoritma dalam proses pembangunan model.

Perkara sakit 1: Pengurusan model dan pengurusan perkhidmatan inferens adalah tidak koheren. Kebanyakan model CV dilatih pada komputer meja dan kemudian dimuat naik secara manual ke OSS, dan kemudian alamat fail model pada OSS dikonfigurasikan kepada perkhidmatan inferens dalam talian. Kebanyakan model Soutui dilatih pada PAI, tetapi juga disimpan secara manual pada OSS, dan serupa dengan CV apabila dikeluarkan. Ia boleh dilihat bahawa pengurusan produk model tidak koheren dalam proses latihan dan keluaran model. Adalah mustahil untuk menjejaki perkhidmatan yang mana model digunakan, dan adalah mustahil untuk melihat perkhidmatan yang digunakan secara intuitif. Atau terdapat berbilang model, dan pengurusan versi model menyusahkan.

Titik sakit 2: Ia mengambil masa yang lama untuk menyediakan persekitaran pembangunan model, dan terdapat kekurangan mekanisme yang fleksibel untuk aplikasi dan penggunaan sumber. Sebelum kontena, sumber biasanya disediakan dalam bentuk contoh ECS Anda perlu melalui proses untuk memohon sumber Selepas memohon, anda perlu melakukan pelbagai kerja permulaan, memasang perisian, memasang kebergantungan dan memindahkan data (kebanyakan perpustakaan perisian yang digunakan dalam kerja penyelidikan algoritma adalah bersaiz besar). Selepas ECS dipasang, jika sumber tidak mencukupi kemudian, anda perlu memohon sekali lagi dan melalui proses yang sama sekali lagi, yang tidak cekap. Pada masa yang sama, permohonan sumber tertakluk kepada kekangan kuota (belanjawan) dan tidak mempunyai mekanisme untuk pengurusan autonomi serta aplikasi dan pelepasan yang fleksibel atas permintaan.

Titik sakit 3: Sukar untuk mencuba beberapa penyelesaian model yang disokong oleh cloud native. Memandangkan teknologi asli awan terus dilaksanakan dalam pelbagai bidang, penyelesaian seperti Kubeflow dan Argo Workflow memberikan sokongan yang baik untuk senario AI. Sebagai contoh: tfjob-operator boleh mengurus tugas latihan yang diedarkan berdasarkan rangka kerja TensorFlow dalam bentuk CRD Pengguna hanya perlu menetapkan parameter komponen yang sepadan (Ketua, PS, Pekerja, dll.) sebelum menyerahkan tugas latihan kepada Kubernetes. kelompok. Sebelum kontena, jika pelajar algoritma ingin mencuba penyelesaian ini, mereka perlu membiasakan diri dengan dan menguasai Docker, Kubernetes dan pengetahuan berkaitan kontena lain, dan tidak boleh menggunakan keupayaan ini sebagai pengguna biasa.

Mata sakit 4: Apabila jabatan bukan algoritma ingin mengesahkan algoritma dengan cepat, mereka tidak dapat mencari platform yang boleh menyokongnya dengan baik. Keupayaan AI jelas digunakan dalam pelbagai bidang perniagaan, terutamanya beberapa algoritma matang Pasukan perniagaan boleh menggunakannya dengan mudah untuk membuat beberapa ramalan penunjuk garis dasar atau ramalan klasifikasi untuk membantu perniagaan mencapai hasil yang lebih baik. Pada masa ini, platform yang boleh menyediakan keupayaan berkaitan AI diperlukan untuk memenuhi keperluan senario ini untuk sumber heterogen (CPU/GPU/storan/rangkaian, dll.) dan pengurusan model algoritma, dan menyediakan pengguna dengan sedia untuk- menggunakan fungsi.

Berdasarkan penyisihan dan analisis titik sakit di atas dan isu yang sukar, dan berdasarkan keperluan lain untuk platform kontena yang dibangkitkan oleh pelajar algoritma dalam proses kontena (seperti: keperluan pengurusan bersatu untuk model, keperluan pengumpulan log, sumber keperluan kumpulan, Keperluan kegigihan data, dsb.), kami membincangkan dan menyelesaikan setiap satu demi satu Semasa menyelesaikan masalah semasa, kami juga mempertimbangkan perancangan fungsi jangka panjang platform, dan secara beransur-ansur membina penyelesaian platform KubeAI berdasarkan. platform kontena dan berorientasikan perniagaan AI.

3. Penyelesaian platform KubeAI

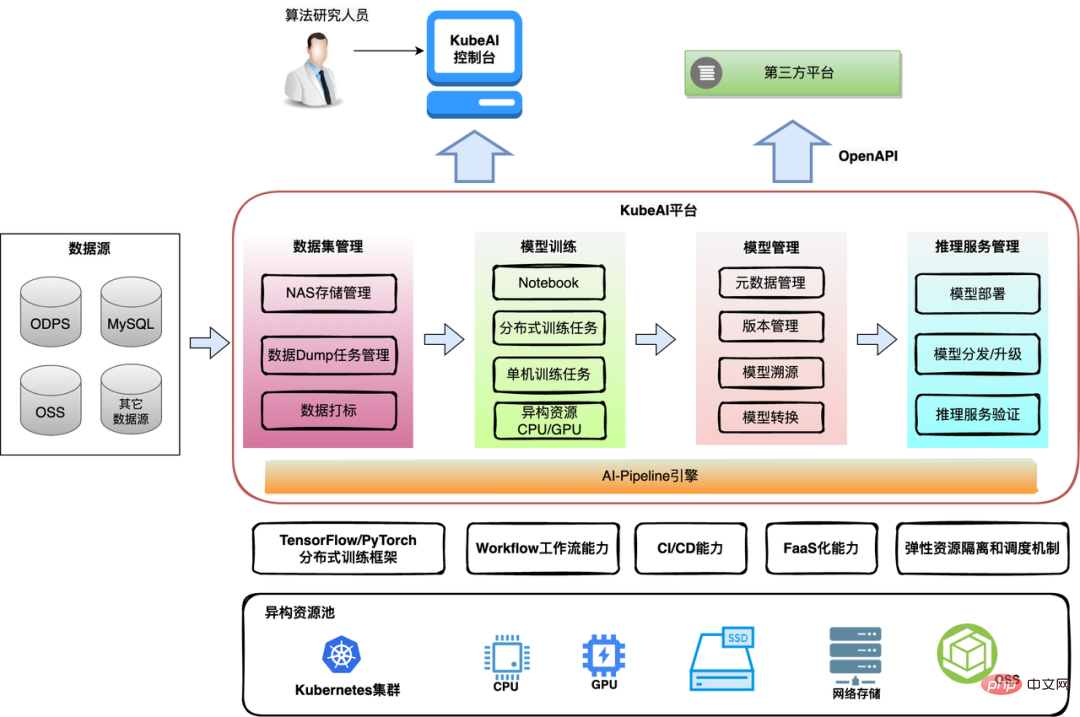

Berdasarkan penyelidikan dan kajian penuh seni bina asas dan bentuk produk platform AI industri, memfokuskan pada senario perniagaan AI dan keperluan perniagaan sekitarnya, teknologi kontena. pasukan mereka bentuk dan melaksanakan secara beransur-ansur platform AI asli awan-platform KubeAI semasa proses kontena. Platform KubeAI memfokuskan pada menyelesaikan keperluan titik kesakitan pelajar algoritma, menyediakan modul berfungsi yang diperlukan sepanjang proses pembangunan, pelepasan dan operasi serta penyelenggaraan model, membantu pembangun algoritma dengan cepat dan kos efektif mendapatkan dan menggunakan sumber infrastruktur AI, dan melaksanakan algoritma dengan cepat dan Reka bentuk model, pembangunan dan eksperimen.

3.1 Seni Bina Keseluruhan

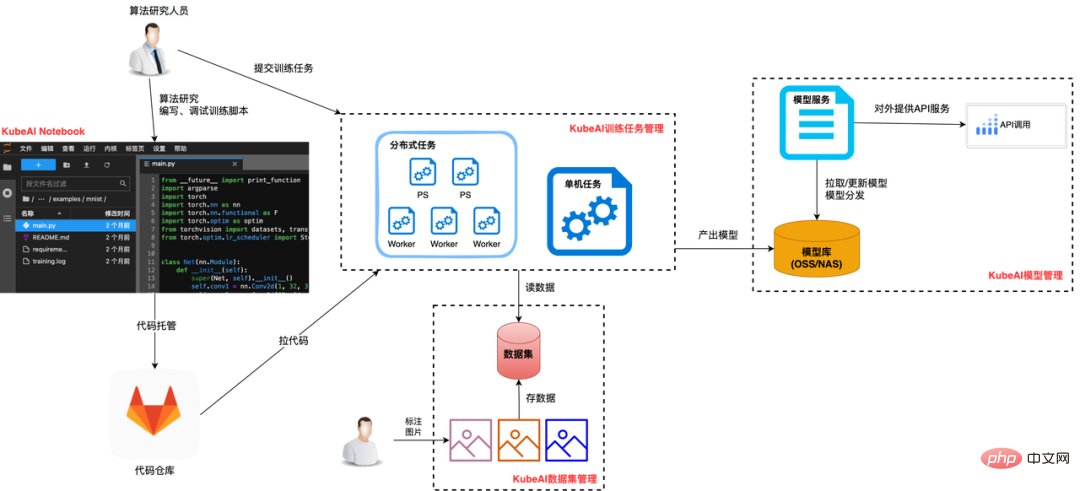

Platform KubeAI menyediakan modul berfungsi berikut di seluruh kitaran hayat model:

Pengurusan Set Data: Utama Ia serasi dengan sumber data yang berbeza dan menyediakan keupayaan pecutan caching data.

Latihan model: Ia bukan sahaja menyediakan Buku Nota untuk pembangunan dan latihan model, tetapi juga menyokong pengurusan tugasan sekali/berkala dalam proses ini, sumber heterogen (CPU/GPU/storan) digunakan secara elastik; dan dilepaskan.

Pengurusan model: Pengurusan bersepadu metadata model (maklumat model asas, senarai versi, dll.), disambungkan dengan lancar dengan keluaran perkhidmatan model serta proses operasi dan penyelenggaraan.

Pengurusan perkhidmatan inferens: Mengasingkan model daripada kod inferens, menghapuskan keperluan untuk membungkus model ke dalam imej, yang meningkatkan kecekapan kemas kini perkhidmatan inferens;

Enjin AI-Pipeline: menyokong penyusunan tugas mengikut saluran paip untuk memenuhi keperluan analisis data, memodelkan tugas latihan rutin berkala, lelaran model dan senario lain.

Platform KubeAI bukan sahaja menyokong pengguna individu, tetapi juga menyokong pengguna platform. Pembangun individu menggunakan Buku Nota KubeAI untuk membangunkan skrip model Model yang lebih kecil boleh dilatih terus dalam Buku Nota, dan model yang kompleks boleh dilatih melalui tugas. Selepas model dihasilkan, ia diuruskan secara seragam pada KubeAI, termasuk menerbitkannya sebagai perkhidmatan inferens dan mengulangi versi baharu. Platform perniagaan pihak ketiga memperoleh keupayaan KubeAI melalui OpenAPI untuk inovasi perniagaan lapisan atas.

Di bawah ini kami memberi tumpuan kepada fungsi empat modul pengurusan set data, latihan model, pengurusan perkhidmatan model dan enjin AI-Pipeline.

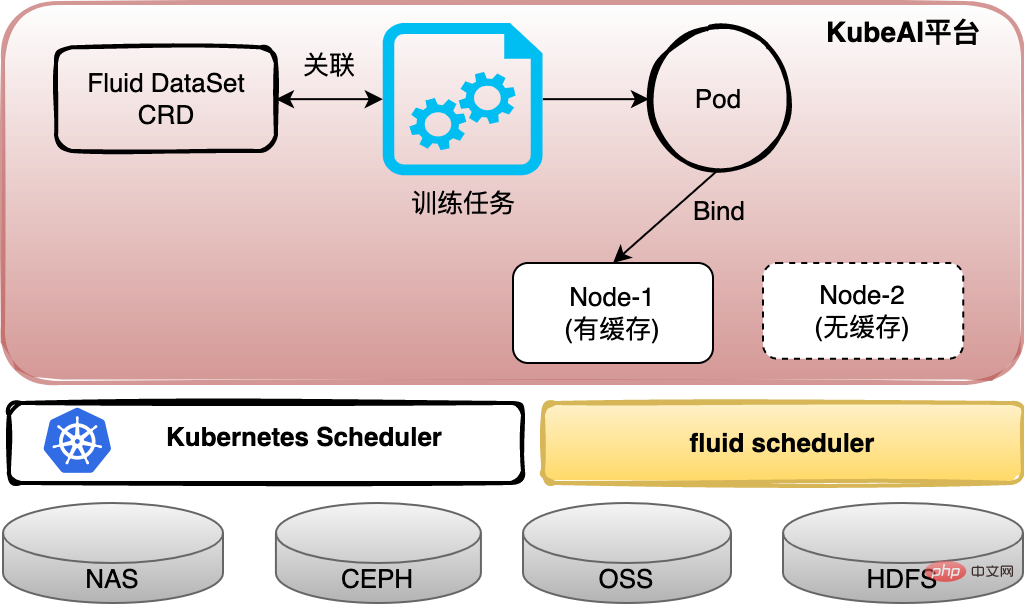

3.2 Pengurusan Set Data

Selepas diisih, data yang digunakan oleh pelajar algoritma sama ada disimpan dalam NAS, dibaca daripada ODPS atau ditarik daripada OSS. Untuk menyatukan pengurusan data, KubeAI berdasarkan sumber Kubernetes PVC (Persistent Volume Claim) untuk menyediakan pengguna dengan konsep set data dan serasi dengan format sumber data yang berbeza. Pada masa yang sama, untuk menyelesaikan masalah overhed capaian data tinggi yang disebabkan oleh pengasingan seni bina pengkomputeran dan storan, kami menggunakan Fluid untuk mengkonfigurasi perkhidmatan cache untuk set data Data boleh dicache secara tempatan untuk pusingan seterusnya pengiraan berulang, atau tugas boleh dijadualkan ke Set data telah dicache pada nod pengkomputeran.

3.3 Latihan model

Untuk latihan model, kami terutamanya melakukan tiga aspek kerja:

(1) Berdasarkan JupyterLab , menyediakan Fungsi Notebook, pengguna boleh membangunkan model algoritma melalui shell atau IDE Web dalam mod pembangunan yang sama seperti tempatan.

(2) Latihan model dijalankan dalam bentuk tugas, yang boleh memohon dan mengeluarkan sumber dengan lebih fleksibel, meningkatkan penggunaan sumber dan mengurangkan kos latihan model dengan banyak. Berdasarkan skalabiliti Kubernetes yang baik, pelbagai CRD TrainingJob dalam industri boleh disambungkan dengan mudah dan rangka kerja latihan seperti Tensorflow, PyTorch dan xgbost semuanya boleh disokong. Tugasan menyokong penjadualan kelompok dan baris gilir keutamaan tugas.

(3) Bekerjasama dengan pasukan algoritma untuk mengoptimumkan sebahagian rangka kerja latihan Tensorflow, dan mencapai beberapa peningkatan dalam kecekapan membaca data kelompok dan kelajuan komunikasi PS/Pekerja dalam ketidakseimbangan beban PS dan perlahan Beberapa penyelesaian telah dibuat untuk masalah seperti pekerja.

3.4 Pengurusan Perkhidmatan Model

Berbanding dengan perkhidmatan biasa, ciri terbesar perkhidmatan model ialah perkhidmatan itu perlu memuatkan satu atau lebih fail model. Pada masa awal kontena, atas sebab sejarah, kebanyakan perkhidmatan model CV membungkus fail model dan skrip inferens secara langsung ke dalam imej kontena, yang menghasilkan imej kontena yang agak besar dan kemas kini versi model yang menyusahkan.

KubeAI telah mengubah masalah di atas Berdasarkan pengurusan standard model, perkhidmatan model dikaitkan dengan model melalui konfigurasi Apabila menerbitkan, platform akan menarik fail model yang sepadan mengikut konfigurasi model untuk dimuatkan oleh skrip inferens. Kaedah ini mengurangkan tekanan ke atas pembangun model algoritma untuk mengurus imej/versi perkhidmatan inferens, mengurangkan lebihan storan, meningkatkan kecekapan kemas kini/putar balik model, meningkatkan kadar penggunaan semula model dan membantu pasukan algoritma mengurus Model dengan lebih mudah dan pantas dalam talian perkhidmatan inferens.

3.5 AI-Pipeline Engine

Senario perniagaan sebenar tidak akan menjadi satu nod tugasan Sebagai contoh, proses lelaran model lengkap secara kasarnya merangkumi pemprosesan data, latihan model dan penggunaan yang baharu Perkhidmatan inferens dalam talian kemas kini model, proses pengesahan trafik kecil dan proses keluaran rasmi. Platform KubeAI menyediakan enjin orkestrasi aliran kerja berdasarkan nod Aliran Kerja Argo menyokong tugas tersuai, tugas templat pratetap platform dan pelbagai tugas latihan AI pembelajaran mendalam (TFJob, PyTorchJob, dll.).

4. Kes biasa senario perniagaan AI yang dilaksanakan pada KubeAI

4.1 Proses pembangunan model algoritma CV

Mod pembangunan model algoritma CV biasanya untuk mengkaji algoritma teori sambil membangunkan model algoritma amalan kejuruteraan dan menyahpepijatnya pada bila-bila masa. Oleh kerana model biasanya lebih kecil, kos latihan adalah lebih rendah daripada model carian dan tolak, jadi pelajar CV lebih terbiasa berlatih secara langsung dalam Notebook selepas membangunkan skrip latihan dalam Notebook. Pengguna boleh memilih dan mengkonfigurasi sumber secara bebas seperti CPU, kad GPU dan cakera storan rangkaian untuk Notebook.

Selepas skrip latihan memenuhi keperluan melalui pembangunan dan penyahpepijatan, pengguna boleh menggunakan fungsi pengurusan tugasan yang disediakan oleh KubeAI untuk mengkonfigurasi skrip latihan sebagai tugas latihan yang berdiri sendiri atau tugas latihan yang diedarkan, dan menyerahkannya kepada platform KubeAI untuk pelaksanaan. Platform akan menjadualkan tugas untuk dijalankan dalam kumpulan sumber dengan sumber yang mencukupi Selepas operasi berjaya, model akan ditolak ke gudang model dan didaftarkan dalam senarai model KubeAI atau model akan disimpan di lokasi yang ditetapkan untuk dibuat oleh pengguna pemilihan dan pengesahan.

Selepas model dijana, pengguna boleh menggunakan model secara langsung sebagai perkhidmatan inferens dalam pengurusan perkhidmatan model KubeAI. Apabila versi baharu model dihasilkan kemudian, pengguna boleh mengkonfigurasi versi model baharu untuk perkhidmatan inferens. Kemudian, bergantung pada sama ada enjin inferens menyokong kemas kini panas model, anda boleh melengkapkan peningkatan model dalam perkhidmatan inferens dengan mengatur semula perkhidmatan atau membuat tugas peningkatan model.

Dalam senario perniagaan pengenalan mesin, proses di atas diatur melalui aliran kerja AI-Pipeline, dan lelaran model dilakukan secara berkala, meningkatkan kecekapan lelaran model sebanyak kira-kira 65%. Selepas adegan CV disambungkan ke platform KubeAI, kaedah latihan tempatan yang terdahulu ditinggalkan, dan kaedah pemerolehan sumber atas permintaan yang fleksibel pada platform meningkatkan penggunaan sumber dari segi pengurusan model, pengurusan perkhidmatan inferens dan lelaran model; Kecekapan R&D dipertingkatkan kira-kira 50%.

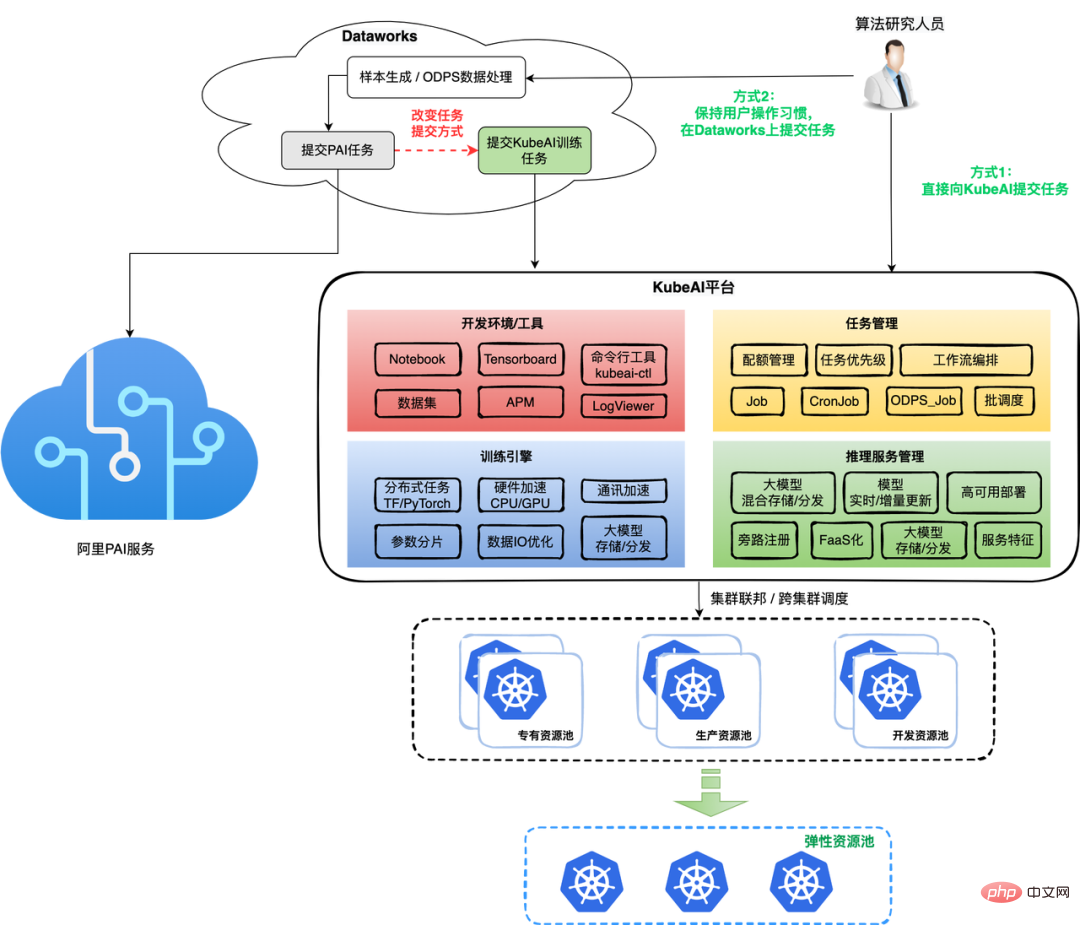

4.2 Tugas latihan model carian dan tolak dipindahkan daripada PAI ke platform KubeAI

Berbanding dengan model CV, kos latihan model carian dan tolak lebih tinggi, terutamanya ditunjukkan dalam data besar sampel dan masa latihan yang panjang. Satu tugas memerlukan sejumlah besar sumber. Sebelum KubeAI dilancarkan, memandangkan data kami disimpan pada ODPS (penyelesaian gudang data yang disediakan oleh Alibaba General Computing Platform, kini dinamakan semula sebagai MaxCompute), kebanyakan pelajar algoritma carian dan push berada dalam Dataworks (data besar berdasarkan data ODPS Build). memproses tugas pada konsol Platform Pengurusan Pembangunan) dan menyerahkan tugas latihan model kepada platform PAI. Walau bagaimanapun, memandangkan PAI adalah produk awan awam, kos satu tugasan yang diserahkan kepadanya adalah lebih tinggi daripada kos sumber yang diperlukan oleh tugas itu sendiri produk awan mempunyai Keperluan kawalan kos dalaman syarikat juga tidak memuaskan.

Selepas KubeAI dilaksanakan secara beransur-ansur, kami akan secara beransur-ansur memindahkan tugas latihan model senario carian dan tolak pada PAI ke platform kami dalam dua cara. Kaedah 1 adalah untuk mengekalkan tabiat pengguna bekerja dalam Dataworks, masih menyelesaikan beberapa tugasan SQL dalam Dataworks, dan kemudian menyerahkan tugasan ke platform KubeAI melalui arahan shell Kaedah 2 adalah untuk pengguna menyerahkan tugasan terus ke platform KubeAI. Kami berharap apabila infrastruktur gudang data bertambah baik, kami akan beralih kepada kaedah kedua secara beransur-ansur.

Proses pembangunan tugas latihan model Soutui menggunakan sepenuhnya persekitaran pembangunan dan alatan yang disediakan oleh KubeAI. Melalui projek latihan yang dibangunkan sendiri Framwork, apabila hanya menggunakan CPU, masa latihan boleh sama seperti menggunakan latihan GPU pada PAI bahagian enjin latihan juga menyokong latihan model besar dan senario latihan masa nyata, dan bekerjasama dengan pelbagai jenis penyelesaian penyimpanan (OSS/penyimpanan fail) dan penyelesaian pengedaran model untuk memastikan kadar kejayaan tugas latihan model besar dan kemas kini model lengkap untuk perkhidmatan dalam talian dengan cekap.

Dari segi penjadualan dan pengurusan sumber, KubeAI menggunakan sepenuhnya persekutuan kluster, mekanisme terlebih jual, penggabungan tugas dan cara teknikal lain untuk secara beransur-ansur mengubah penggunaan kumpulan sumber khusus untuk tugas latihan kepada memperuntukkan sumber elastik kepada Pod tugas dan menjadualkannya ke kumpulan sumber dalam talian, kumpulan sumber awam. Gunakan sepenuhnya ciri-ciri pelaksanaan berkala tugas pengeluaran dan tugas pembangunan utama pada siang hari, dan laksanakan penjadualan peralihan puncak dan dibezakan (contohnya, menggunakan sumber elastik untuk saiz kecil dan sumber biasa untuk saiz besar, dsb.). Berdasarkan data dalam beberapa bulan kebelakangan ini, kami telah dapat terus melaksanakan peningkatan yang lebih besar dalam tugas manakala jumlah peningkatan dalam sumber tidak banyak berubah.

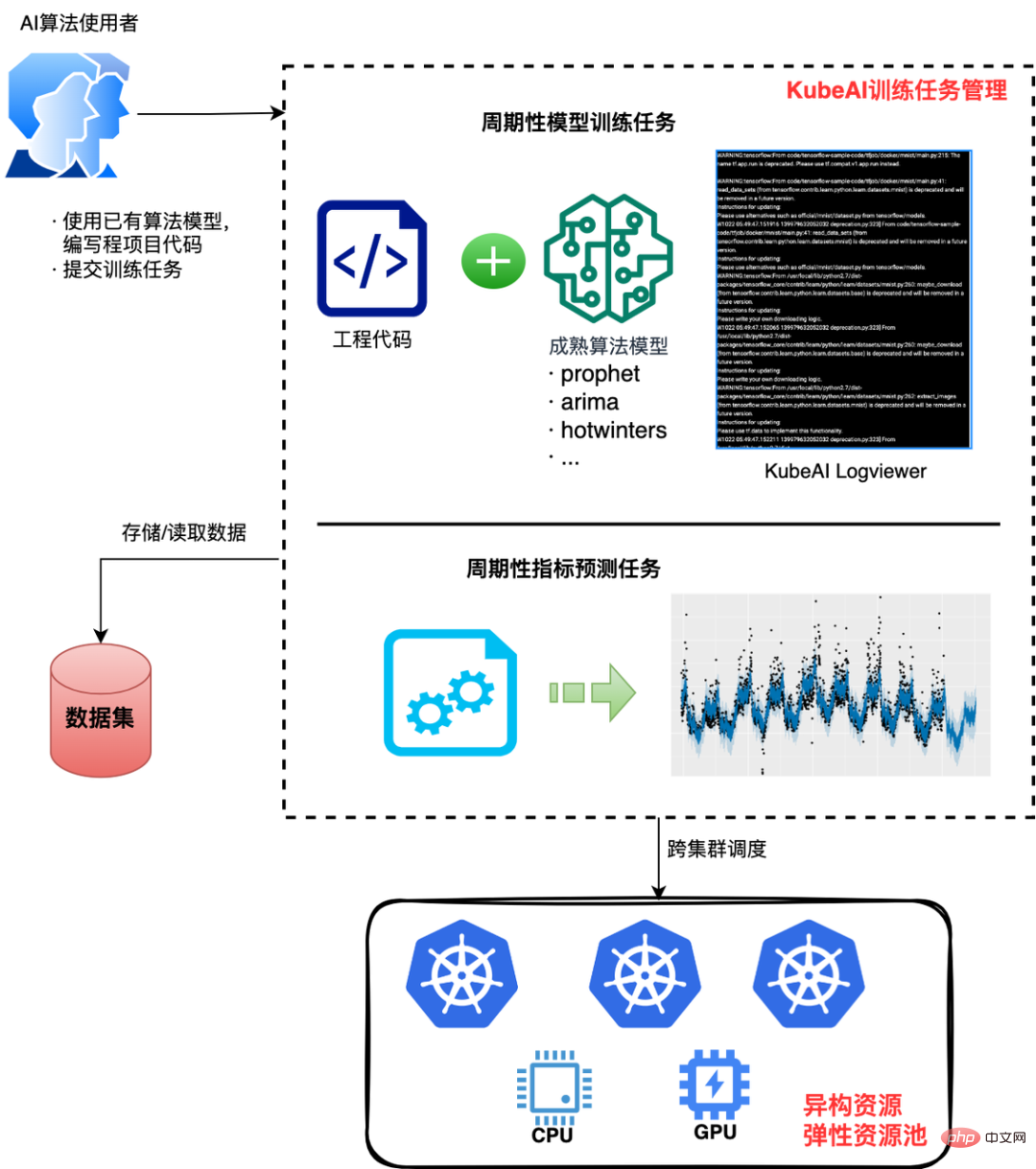

4.3 Senario ramalan penunjuk garis dasar

Ini ialah senario perniagaan bukan algoritma biasa yang menggunakan keupayaan AI. Contohnya, gunakan algoritma nabi Facebook untuk meramal garis dasar penunjuk perniagaan tertentu. KubeAI menyediakan keupayaan AI asas untuk keperluan senario ini, menyelesaikan masalah mereka "kesukaran dalam mengesahkan algoritma matang dengan cepat." Pengguna hanya perlu melaksanakan model algoritma dengan cara kejuruteraan (menggunakan amalan terbaik sedia ada atau pembangunan sekunder), kemudian mencipta imej kontena, menyerahkan tugas pada KubeAI, memulakan pelaksanaan dan mendapatkan hasil yang diingini Atau melakukan latihan dan inferens secara berkala untuk mendapatkan keputusan ramalan garis dasar.

Pengguna boleh mengkonfigurasi sumber pengkomputeran yang diperlukan untuk tugasan atau sumber heterogen lain atas permintaan dan menggunakannya. Pada masa ini, mengambil 12 petunjuk senario perniagaan dalam talian sebagai contoh, hampir 20,000 tugasan dilaksanakan setiap hari Berbanding dengan kos sumber sebelumnya untuk keperluan yang serupa, KubeAI membantu ia menjimatkan hampir 90% daripada kos dan meningkatkan kecekapan R&D sebanyak 3 kali. .

5. Tinjauan

Dewu telah berjaya menguasai perniagaannya dalam tempoh yang singkat Ini disebabkan oleh teknologi asli awan yang semakin matang di satu pihak, dan sebaliknya Terima kasih untuk pemahaman kami yang mendalam tentang keperluan senario perniagaan kami sendiri, kami boleh menyediakan penyelesaian yang disasarkan. Platform KubeAI adalah berdasarkan analisis mendalam kami tentang keperluan titik kesakitan bagi senario perniagaan algoritma, berdasarkan cara untuk terus meningkatkan kecekapan kejuruteraan senario perniagaan AI, meningkatkan penggunaan sumber dan mengurangkan ambang untuk pembangunan model/perkhidmatan AI, dan kemudian secara beransur-ansur lelaran melaksanakannya.

Pada masa hadapan, kami akan terus berusaha keras untuk melatih pengoptimuman enjin, penjadualan tugas AI yang diperhalusi dan latihan model anjal untuk meningkatkan lagi latihan model AI dan kecekapan lelaran serta meningkatkan penggunaan sumber.

Atas ialah kandungan terperinci Satu artikel untuk memahami proses pelaksanaan platform AI asli Wuyun-KubeAI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI