Rumah >Peranti teknologi >AI >Model AI yang diilhamkan oleh otak: Pembelajaran pengaktifan, penyebaran balik yang mencabar

Model AI yang diilhamkan oleh otak: Pembelajaran pengaktifan, penyebaran balik yang mencabar

- 王林ke hadapan

- 2023-04-12 11:10:161315semak imbas

Teknologi penyebaran belakang ialah teras pembelajaran mendalam, memacu kejayaan AI dalam banyak bidang seperti penglihatan, pertuturan, pemprosesan bahasa semula jadi, permainan dan ramalan biologi. Mekanisme operasi perambatan belakang adalah untuk mengira kecerunan ralat ramalan kepada berat sambungan rangkaian saraf secara terbalik, dan mengurangkan ralat ramalan dengan memperhalusi berat setiap lapisan. Walaupun perambatan balik adalah sangat cekap dan merupakan kunci kepada kejayaan semasa kecerdasan buatan, sebilangan besar penyelidik tidak percaya bahawa kaedah pembelajaran perambatan balik adalah konsisten dengan cara otak berfungsi.

Dengan perkembangan teknologi pembelajaran mendalam, semua orang secara beransur-ansur melihat beberapa kelemahan penyebaran belakang, seperti terlalu bergantung pada data label dan kuasa pengkomputeran, dan beberapa siri isu keselamatan konfrontasi. hanya boleh digunakan untuk tugas tertentu, dsb., dan ia juga telah menimbulkan beberapa kebimbangan tentang pembangunan model besar.

Sebagai contoh, Hinton, salah seorang pengarang cadangan penyebaran balik dan perintis pembelajaran mendalam, telah berkata banyak kali, “Jika anda ingin mencapai kemajuan yang besar, anda mesti meninggalkan perambatan balik dan mulakan semula [2] ", "Kepercayaan saya sekarang ialah perambatan balik, cara pembelajaran mendalam pada masa ini berfungsi, adalah berbeza sama sekali daripada apa yang dilakukan oleh otak, dan otak memperoleh kecerunan dengan cara yang berbeza [3]", " Saya percaya otak menggunakan Terdapat banyak fungsi objektif kecil tempatan, ia bukan rantaian sistem hujung ke hujung, dan fungsi objektif dioptimumkan melalui latihan [3]".

LeCun, yang juga pemenang Anugerah Turing, berkata bahawa "model pembelajaran mendalam semasa mungkin merupakan sebahagian daripada sistem pintar masa depan, tetapi saya fikir ia tidak mempunyai bahagian yang diperlukan. Saya fikir mereka Ia perlu tetapi tidak mencukupi[4]”. Saingan lamanya, profesor Universiti New York Gary Marcus, berkata perkara yang sama telah dikatakan sebelum ini, "Jika kita ingin mencapai kecerdasan buatan umum, pembelajaran mendalam mesti ditambah dengan teknologi lain [4]".

1 Inspirasi otak

Bagaimana untuk memulakan semula? otak. Walaupun kita masih jauh daripada memahami sepenuhnya mekanisme kerja otak—terasnya ialah cara melaraskan berat sambungan antara neuron berdasarkan maklumat luaran—kita masih boleh memperoleh beberapa pemahaman awal tentang otak, yang boleh memberi inspirasi kepada kita untuk mereka bentuk. model baru.

Pertama sekali, proses pembelajaran otak berkait rapat dengan peraturan Hebb, iaitu berat sambungan antara neuron yang diaktifkan pada masa yang sama akan diperkukuh, yang boleh Ia adalah dikatakan sebagai peraturan asas neurosains yang paling penting dan telah disahkan oleh sejumlah besar eksperimen biologi.

Kedua, pembelajaran dalam otak adalah berdasarkan pembelajaran tanpa pengawasan, yang boleh memperoleh perwakilan tempatan yang kaya dan korelasi antara perwakilan daripada sebilangan kecil sampel, dan isyarat maklum balas juga dalam pembelajaran proses Memainkan peranan yang lebih penting. Di samping itu, otak adalah sistem pembelajaran yang menyokong tugas-tugas umum Ciri-ciri yang dipelajari oleh otak harus secara relatifnya bertentangan dengan tugas-tugas tertentu kandungan.

Baru-baru ini, Zhou Hongchao, seorang penyelidik di Universiti Shandong, menyerahkan artikel mengenai arXiv, "Pembelajaran Pengaktifan oleh Pertandingan Tempatan", mencadangkan model AI yang diilhamkan oleh otak, dipanggil Pembelajaran pengaktifan(pembelajaran pengaktifan). Terasnya adalah untuk membina rangkaian neural berbilang lapisan supaya keamatan pengaktifan output rangkaian dapat mencerminkan kebarangkalian relatif input.

Model ini meninggalkan sepenuhnya kaedah perambatan belakang, tetapi bermula daripada menambah baik peraturan asas Hebbian (kaedah yang lebih dekat dengan otak), satu set baharu latihan rangkaian saraf dan kaedah inferens telah diwujudkan, yang boleh mencapai prestasi yang jauh lebih baik daripada perambatan belakang dalam eksperimen pembelajaran sampel kecil, dan juga boleh digunakan sebagai model penjanaan untuk imej. Kerja ini menunjukkan bahawa potensi kaedah pembelajaran bioinspired mungkin jauh dipandang rendah.

Pautan kertas: https://arxiv.org/pdf/2209.13400.pdf

2 Peraturan pembelajaran persaingan tempatan

Pembelajaran Hebbian telah menjadi hala tuju teras penyelidikan pembelajaran rangkaian saraf sebelum kemunculan perambatan balik, memberi inspirasi kepada satu siri sistem pembelajaran berfungsi, tetapi akhirnya tidak menjadi kaedah yang digunakan secara meluas.

Alasan yang mungkin ialah orang tidak memahami sepenuhnya beberapa mekanisme dalam peraturan Hebbian, terutamanya mekanisme persaingan antara neuron, dan persaingan memainkan peranan yang sangat penting dalam proses pembelajaran ciri rangkaian saraf dan pelarasan berat yang penting peranan.

Pemahaman intuitif ialah jika setiap neuron mencuba yang terbaik untuk bersaing untuk pengaktifan, dan pada masa yang sama terdapat beberapa jenis perencatan untuk menjadikan ciri-ciri yang diwakili oleh neuron yang berbeza berbeza dengan mungkin, maka rangkaian saraf akan menumpu Untuk memindahkan maklumat yang paling berguna ke lapisan seterusnya (adakah ia serupa dengan sosioekonomi? Apabila setiap individu dalam kumpulan sosial yang besar memaksimumkan pendapatan dan kumpulan itu cukup besar, di bawah peraturan tertentu, Jumlah faedah keseluruhan kumpulan cenderung untuk dimaksimumkan, di mana setiap individu mempamerkan tingkah laku yang berbeza).

Malah, terdapat sejumlah besar neuron perencatan dalam otak Persaingan dan perencatan antara neuron memainkan peranan penting dalam proses pembelajaran otak. Rumelhart, pengarang pertama backpropagation (anugerah tertinggi dalam bidang sains kognitif ialah Anugerah Rumelhart) adalah penganjur idea ini Pada masa yang sama beliau mencadangkan backpropagation (1985), beliau juga mencadangkan kaedah yang dipanggil pembelajaran kompetitif. Teras model [5] adalah untuk membahagikan neuron dalam setiap lapisan kepada beberapa kelompok Hanya neuron terkuat dalam setiap kelompok akan diaktifkan (dipanggil pemenang-ambil-semua) dan dilatih melalui peraturan Hebbian. Walau bagaimanapun, sebagai perbandingan, perambatan belakang telah menunjukkan kecekapan latihan rangkaian yang lebih baik dalam aplikasi praktikal, dan sejak itu telah menarik perhatian kebanyakan penyelidik AI, mempromosikan kemunculan dan kejayaan pembelajaran mendalam.

Walau bagaimanapun, sesetengah penyelidik masih percaya pada potensi kaedah pembelajaran yang diilhamkan secara biologi Pada 2019, Krotov dan Hopfield (ya, pencadang rangkaian Hopfield) menunjukkan pemenang-ambil-semua. peraturan Digabungkan dengan pembelajaran Hebbian, adalah mungkin untuk mencapai prestasi yang setanding dengan penyebaran balik [6]. Tetapi peraturan pemenang-ambil-semua, yang hanya membenarkan satu neuron diaktifkan, juga mengehadkan keupayaan pembelajaran dan ekspresi rangkaian saraf ke tahap tertentu.

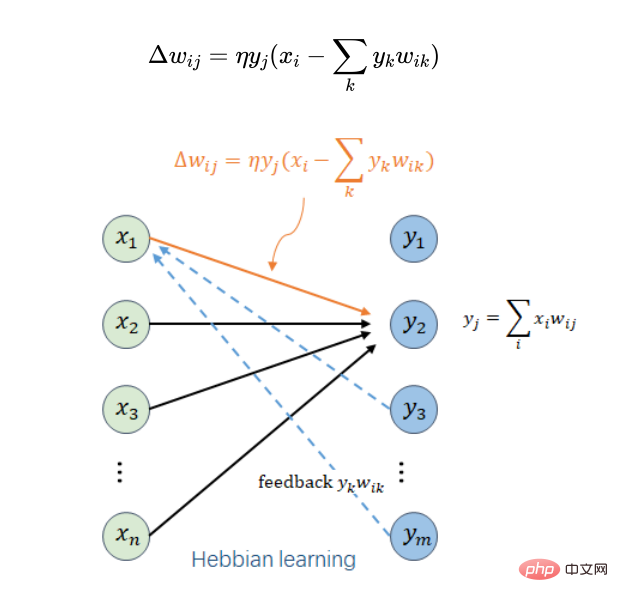

Para penyelidik dalam kerja ini secara langsung memperkenalkan mekanisme persaingan ke dalam peraturan pembelajaran Hebbian dan memperoleh peraturan pembelajaran tempatan yang ringkas:

Di sini diandaikan bahawa neuron i ialah input neuron j dalam lapisan di atasnya,  ialah berat sambungan antara neuron i dan neuron j,

ialah berat sambungan antara neuron i dan neuron j,  ialah jumlah pelarasan berat di bawah sampel latihan tertentu,

ialah jumlah pelarasan berat di bawah sampel latihan tertentu,  ialah output neuron i dan input neuron j,

ialah output neuron i dan input neuron j,  ialah neuron Jumlah input berwajaran j (atau keluaran neuron j),

ialah neuron Jumlah input berwajaran j (atau keluaran neuron j),  ialah kadar pembelajaran yang lebih kecil,

ialah kadar pembelajaran yang lebih kecil,  merentasi semua neuron dalam lapisan yang sama dengan neuron j neuron. Jika kita hanya mempertimbangkan

merentasi semua neuron dalam lapisan yang sama dengan neuron j neuron. Jika kita hanya mempertimbangkan  , ia adalah peraturan Hebbian yang asal. Kunci di sini ialah pengenalan item maklum balas keluaran daripada lapisan yang sama

, ia adalah peraturan Hebbian yang asal. Kunci di sini ialah pengenalan item maklum balas keluaran daripada lapisan yang sama  . Ia memainkan dua peranan: yang pertama adalah untuk memastikan bahawa semua pemberat tidak akan meningkat secara tidak terhingga dan proses pembelajaran adalah konvergen; yang kedua adalah untuk memperkenalkan persaingan antara neuron j dan neuron lain dalam lapisan ini untuk meningkatkan ekspresi ciri.

. Ia memainkan dua peranan: yang pertama adalah untuk memastikan bahawa semua pemberat tidak akan meningkat secara tidak terhingga dan proses pembelajaran adalah konvergen; yang kedua adalah untuk memperkenalkan persaingan antara neuron j dan neuron lain dalam lapisan ini untuk meningkatkan ekspresi ciri.

Analisis matematik peraturan pembelajaran tempatan di atas (dengan mengandaikan bahawa kadar pembelajaran cukup kecil dan bilangan langkah pembelajaran mencukupi), beberapa kesimpulan menarik boleh diperolehi.

(1) Memandangkan  setiap lapisan, input >

setiap lapisan, input > Menjadikan ralat pembinaan semula sekecil mungkin. Keupayaan pembinaan semula lapisan demi lapisan ini boleh meningkatkan keselamatan model terhadap serangan musuh dan menghalang penambahan hingar lawan pada sesetengah imej objek daripada dikenali sebagai objek lain.

Menjadikan ralat pembinaan semula sekecil mungkin. Keupayaan pembinaan semula lapisan demi lapisan ini boleh meningkatkan keselamatan model terhadap serangan musuh dan menghalang penambahan hingar lawan pada sesetengah imej objek daripada dikenali sebagai objek lain.

(2) Setiap pengekstrakan ciri lapisan berdasarkan peraturan pembelajaran tempatan mempunyai persamaan tertentu dengan analisis komponen utama (PCA) Kehilangan pembinaan semulanya adalah sama, tetapi ia berbeza daripada komponen utama Analisis. Perbezaannya ialah komponen yang diperolehi oleh peraturan pembelajaran tempatan tidak perlu berbentuk ortogon. Ini adalah perkara yang sangat munasabah, kerana analisis komponen utama adalah untuk mengekstrak maklumat utama setiap lapisan, tetapi jika neuron yang sepadan dengan komponen utama gagal, ia akan menjejaskan prestasi keseluruhan rangkaian, dan peraturan pembelajaran tempatan menyelesaikan masalah ini dengan mantap. Isu seksual.

(3) Jumlah kuasa dua berat sambungan setiap lapisan cenderung tidak melebihi bilangan neuron dalam lapisan itu, memastikan penumpuan proses pembelajaran rangkaian.

(4) Keamatan keluaran setiap lapisan (jumlah kuasa dua keluaran) cenderung tidak lebih tinggi daripada keamatan input lapisan (jumlah kuasa dua bagi input), dan untuk input biasa kira-kira Keamatan output secara amnya akan lebih tinggi, jadi kebarangkalian input boleh dianggarkan oleh keamatan output. Kesimpulan ini merupakan titik yang sangat kritikal untuk model pembelajaran pengaktifan yang akan dicadangkan.

3 Pembelajaran pengaktifan

Berdasarkan peraturan pembelajaran tempatan di atas, rangkaian saraf berbilang lapisan boleh dilatih lapisan bawah ke atas demi lapisan untuk mencapai ekstrak ciri tanpa pengawasan automatik . Rangkaian terlatih boleh digunakan sebagai model pra-latihan untuk pelbagai tugas pembelajaran yang diselia, seperti pengiktirafan, terjemahan, dll., untuk meningkatkan ketepatan tugasan pembelajaran. Pelbagai tugas pembelajaran diselia di sini masih berdasarkan latihan model perambatan belakang, dan model pralatihan tanpa penyeliaan diperhalusi.

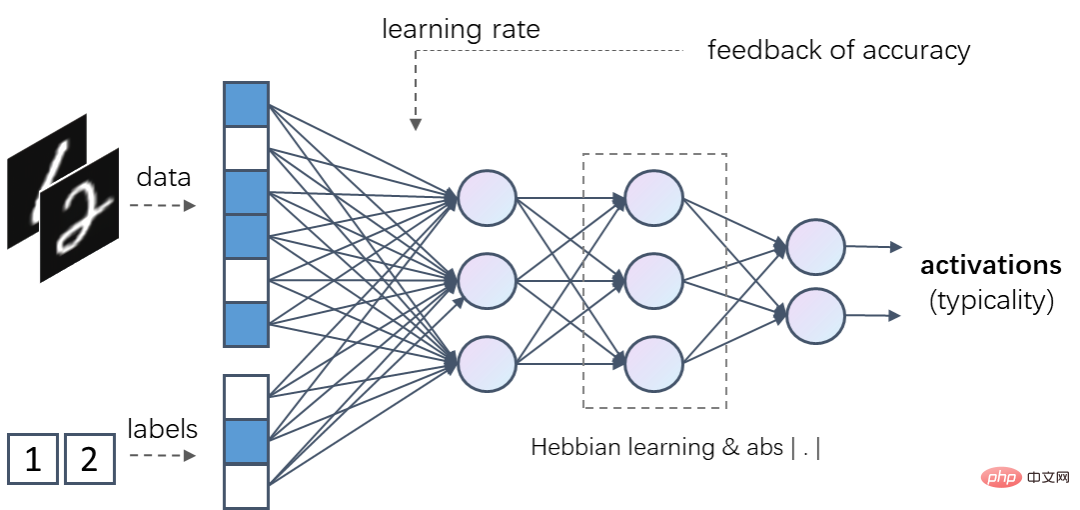

Tetapi yang lebih menarik ialah berdasarkan peraturan pembelajaran tempatan di atas, model AI baharu yang tidak menggunakan perambatan balik sama sekali boleh dibina, dipanggil pembelajaran pengaktifan (Activation Learning). teras adalah menggunakan latihan tempatan tanpa pengawasan untuk membolehkan kekuatan output keseluruhan rangkaian (jumlah kuasa dua output) untuk menganggarkan kebarangkalian relatif sampel input, iaitu, semakin kerap sampel input dilihat, semakin kuat kekuatan keluaran biasanya akan.

Dalam pembelajaran pengaktifan, sampel input dimasukkan ke dalam rangkaian saraf berbilang lapisan selepas penormalan. Setiap lapisan mengandungi transformasi linear yang boleh dilatih melalui peraturan pembelajaran tempatan. Fungsi pengaktifan tak linear bagi setiap lapisan perlu memastikan bahawa kekuatan input (jumlah kuasa dua) dan kekuatan output tidak berubah Sebagai contoh, fungsi nilai mutlak  boleh digunakan sebagai fungsi pengaktifan, jadi. bahawa kekuatan output rangkaian berubah selepas Fungsi pengaktifan tidak akan melemahkan atau meningkatkan, dan kekuatan output akhir keseluruhan rangkaian boleh mencerminkan kebarangkalian relatif sampel input.

boleh digunakan sebagai fungsi pengaktifan, jadi. bahawa kekuatan output rangkaian berubah selepas Fungsi pengaktifan tidak akan melemahkan atau meningkatkan, dan kekuatan output akhir keseluruhan rangkaian boleh mencerminkan kebarangkalian relatif sampel input.

Jika fungsi pengaktifan tak linear ditambahkan pada peraturan pembelajaran setempat, iaitu,  mewakili output neuron j, maka fungsi pengaktifan tidak perlu memerlukan kekuatan input dan output tidak berubah, fungsi tak linear lain seperti RELU boleh digunakan sebagai fungsi pengaktifan. Proses inferens pembelajaran pengaktifan adalah untuk menyimpulkan bahagian yang hilang berdasarkan bahagian input yang diketahui, supaya kekuatan output akhir rangkaian adalah maksimum.

mewakili output neuron j, maka fungsi pengaktifan tidak perlu memerlukan kekuatan input dan output tidak berubah, fungsi tak linear lain seperti RELU boleh digunakan sebagai fungsi pengaktifan. Proses inferens pembelajaran pengaktifan adalah untuk menyimpulkan bahagian yang hilang berdasarkan bahagian input yang diketahui, supaya kekuatan output akhir rangkaian adalah maksimum.

Sebagai contoh, rangkaian pembelajaran pengaktifan boleh mengambil data dan label (seperti pengekodan satu panas) sebagai input pada masa yang sama. Untuk rangkaian terlatih sedemikian, apabila diberi data dan input label yang betul, intensiti pengaktifan outputnya biasanya lebih tinggi daripada intensiti pengaktifan output data ini dan label yang salah.

Model pembelajaran pengaktifan sedemikian boleh digunakan sebagai model diskriminatif dan model generatif. Apabila digunakan sebagai model diskriminatif, ia menyimpulkan kategori yang hilang daripada data yang diberikan, apabila digunakan sebagai model generatif, ia membuat kesimpulan daripada kategori yang diberikan digabungkan dengan jumlah data yang hilang. Di samping itu, eksperimen mendapati bahawa jika maklumat maklum balas pengecaman diperkenalkan, seperti memberikan kadar pembelajaran global yang lebih tinggi kepada sampel yang tidak diiktiraf, kesan pembelajaran model diskriminasi boleh dipertingkatkan.

4 Klasifikasi sampel kecil dan penjanaan imej

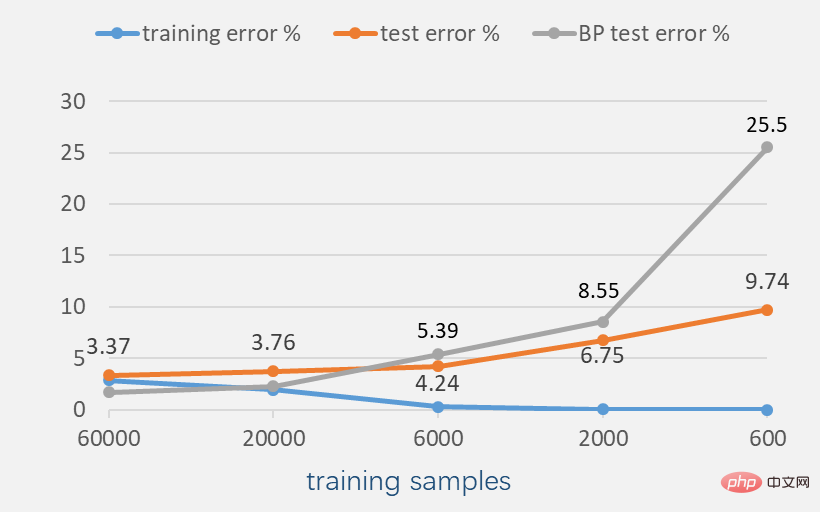

Percubaan pada set data MNIST (imej digit tulisan tangan hitam putih) menunjukkan bahawa jika latihan sampel Selalunya cukup, ketepatan perambatan balik lebih tinggi daripada ketepatan pembelajaran pengaktifan. Sebagai contoh, dalam kes 60,000 sampel latihan, berdasarkan rangkaian saraf dengan kerumitan yang sama, perambatan balik boleh mencapai kadar ralat kira-kira 1.62%, manakala pembelajaran pengaktifan hanya boleh mencapai kadar ralat kira-kira 3.37% (jika maklum balas daripada pengiktirafan keputusan diperkenalkan Untuk mengaktifkan pembelajaran, kadar ralat boleh dikurangkan kepada 2.28%).

Tetapi apabila bilangan sampel latihan berkurangan, pembelajaran pengaktifan boleh menunjukkan prestasi yang lebih baik. Sebagai contoh, dalam kes 6,000 sampel latihan, kadar ralat pembelajaran pengaktifan sudah lebih rendah daripada kadar ralat perambatan belakang dalam kes 600 sampel latihan, kadar ralat pengecaman perambatan belakang adalah setinggi 25.5%, tetapi kadar ralat pembelajaran pengaktifan Kadar ralat hanya 9.74%, yang juga jauh lebih rendah daripada kaedah yang menggabungkan model pra-latihan tanpa pengawasan (kadar ralat adalah kira-kira 20.3%).

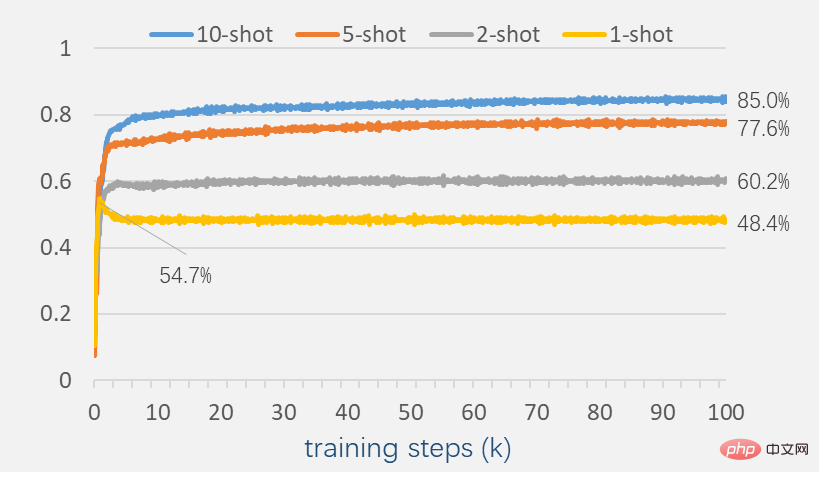

Untuk meneroka prestasi pembelajaran pengaktifan dengan bilangan sampel yang kecil, teruskan mengurangkan bilangan sampel kepada beberapa sampel. Pada masa ini, pembelajaran pengaktifan masih menunjukkan keupayaan pengecaman tertentu.

Apabila terdapat 2 sampel dalam setiap kategori, ketepatan pengecaman mencapai 60.2%; apabila terdapat 10 sampel dalam setiap kategori, ketepatan pengecaman boleh mencapai 85.0%. Fenomena yang perlu diberi perhatian ialah apabila terdapat sekurang-kurangnya 2 sampel untuk setiap kategori, ketepatan ujian tidak berkurangan semasa keseluruhan proses latihan. Ini berbeza daripada banyak model berdasarkan perambatan balik Dari satu aspek, ia mencerminkan bahawa pembelajaran pengaktifan mungkin mempunyai keupayaan generalisasi yang lebih baik.

Memandangkan rangkaian pembelajaran pengaktifan yang terlatih, cuba tambahkan gangguan tertentu pada imej untuk dikenali. Seperti yang ditunjukkan dalam gambar di bawah, tutup bahagian tertentu piksel gambar atau tambah beberapa garis rawak. Gambar-gambar yang terganggu ini belum ditemui oleh model semasa proses latihan, tetapi pembelajaran pengaktifan masih menunjukkan keupayaan pengecaman tertentu. Sebagai contoh, apabila 1/3 daripada imej dilindungi (bahagian bawah), pembelajaran pengaktifan boleh mencapai kadar ralat pengecaman kira-kira 7.5%.

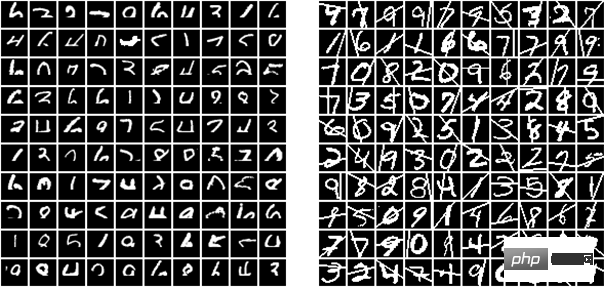

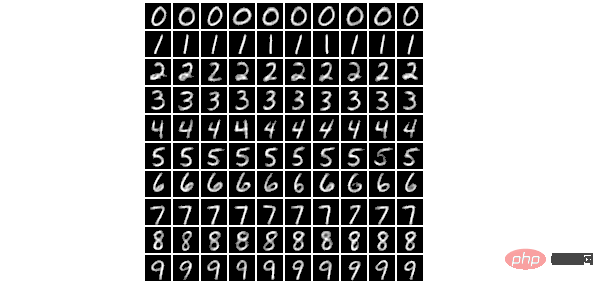

Rangkaian pembelajaran pengaktifan terlatih yang sama juga boleh digunakan untuk penjanaan imej. Memandangkan kategori, imej yang dijana optimum tempatan boleh diperolehi melalui keturunan kecerunan atau lelaran untuk memaksimumkan kekuatan pengaktifan output keseluruhan rangkaian. Dalam proses penjanaan imej, output beberapa neuron boleh dikawal berdasarkan hingar rawak, dengan itu meningkatkan rawak imej yang dihasilkan. Gambar di bawah adalah gambar yang dijana secara rawak berdasarkan rangkaian pembelajaran pengaktifan.

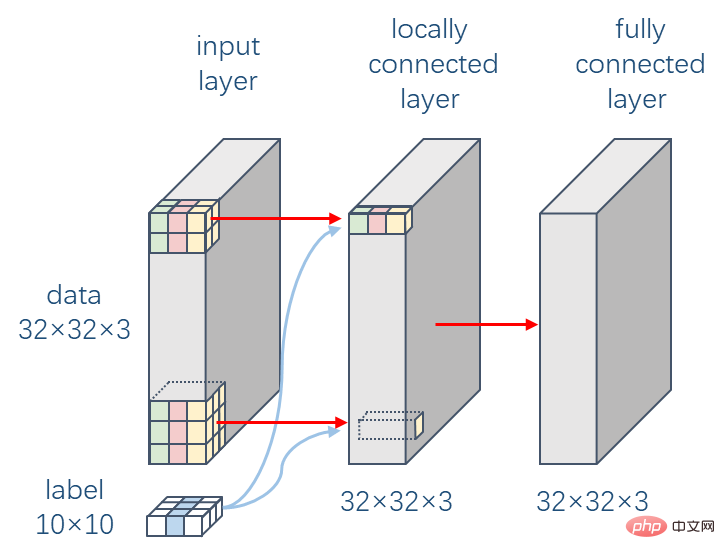

Dalam lapisan persepsi visual otak, neuron mempunyai medan penerimaan yang terhad, iaitu neuron hanya boleh menerima neuron lain dalam ruang tertentu. julat input Yuan. Ini memberi inspirasi kepada cadangan rangkaian saraf konvolusi (CNN), yang digunakan secara meluas dalam sebilangan besar tugas visual. Mekanisme kerja lapisan konvolusi masih sangat berbeza daripada sistem visual manusia Perbezaan penting ialah lapisan konvolusi berkongsi parameter, iaitu parameter berat adalah sama pada setiap kedudukan dua dimensi, tetapi sukar untuk dibayangkan. bahawa sistem visual manusia Akan ada perkongsian parameter sedemikian dalam sistem visual. Percubaan berikut mengkaji kesan sambungan tempatan pada pembelajaran pengaktifan berdasarkan set data CIFAR-10 (10 jenis gambar objek berwarna-warni).

Rangkaian saraf yang dieksperimenkan di sini terdiri daripada dua lapisan Lapisan pertama ialah lapisan sambungan tempatan, yang berbelit dengan saiz kernel lilitan 9 Lapisan mempunyai struktur sambungan yang sama, tetapi setiap kedudukan mempunyai parameter beratnya sendiri; lapisan kedua ialah lapisan bersambung sepenuhnya, dan bilangan nod dalam setiap lapisan ialah ,  Dimensi yang sama dengan imej input adalah Konsisten.

Dimensi yang sama dengan imej input adalah Konsisten.

Eksperimen menunjukkan bahawa sambungan setempat boleh menjadikan proses pembelajaran lebih stabil dan meningkatkan prestasi pembelajaran pada tahap tertentu. Berdasarkan rangkaian neural dua lapisan ini dan digabungkan dengan maklum balas daripada hasil pengiktirafan, pembelajaran pengaktifan boleh mencapai kadar ralat sebanyak 41.59% pada CIFAR-10.

Tanda aras sebelumnya untuk model bioinspirasi telah ditubuhkan oleh Krotov dan Hopfield, yang melaporkan kadar ralat sebanyak 49.25%. Mereka menggunakan rangkaian saraf dua lapisan, dengan lapisan pertama mengandungi 2,000 nod dan dilatih tanpa pengawasan melalui kaedah yang diilhamkan secara biologi, dan lapisan keluaran kedua diawasi melalui perambatan belakang. Sebagai perbandingan, rangkaian yang sama boleh mencapai kadar ralat 44.74% jika dilatih sepenuhnya melalui perambatan belakang, manakala pembelajaran pengaktifan tidak menggunakan perambatan balik sama sekali dan mencapai hasil yang lebih baik. Jika penambahan data termasuk pemangkasan rawak digunakan dan bilangan nod dalam lapisan pertama ditambah kepada  , kadar ralat pengecaman pembelajaran pengaktifan boleh dikurangkan kepada 37.52%.

, kadar ralat pengecaman pembelajaran pengaktifan boleh dikurangkan kepada 37.52%.

5 Ke arah tugas umum

Mengapakah kebanyakan model pembelajaran mendalam hanya digunakan untuk tugasan tertentu? Salah satu sebabnya ialah kami membahagikan sampel secara buatan kepada data dan label, dan menggunakan data sebagai input model dan label sebagai maklumat penyeliaan output Ini menjadikan model lebih cenderung untuk mengekalkan hanya ciri yang lebih berguna untuk meramal label, sambil mengabaikan beberapa Ciri yang berguna untuk tugasan lain. Pembelajaran pengaktifan mengambil semua maklumat yang boleh dilihat sebagai input dan boleh mempelajari kebarangkalian dan taburan statistik sampel latihan dan korelasi antara setiap bahagian Maklumat ini boleh digunakan untuk semua tugas pembelajaran yang berkaitan, jadi pembelajaran pengaktifan boleh dianggap sebagai model untuk tugasan umum. .

Sebenarnya, apabila kita melihat sesuatu objek dan orang lain memberitahu kita apa itu, sukar untuk kita menentukan bahawa otak pasti akan menggunakan isyarat bunyi sebagai label output dan isyarat visual sebagai Input; sekurang-kurangnya pembelajaran ini harus dua hala, iaitu apabila kita melihat objek ini, kita akan memikirkan apa itu, dan apabila diberi apa itu, kita juga akan memikirkan rupa objek ini.

Pembelajaran pengaktifan juga boleh digunakan untuk pembelajaran pelbagai mod. Sebagai contoh, apabila sampel latihan yang diberikan mengandungi modaliti gambar dan teks, ia mungkin mewujudkan perkaitan antara gambar dan teks apabila sampel latihan yang diberikan mengandungi modaliti teks dan bunyi, ia mungkin mewujudkan perkaitan antara teks dan bunyi. Pembelajaran pengaktifan berpotensi untuk menjadi model ingatan bersekutu, mewujudkan perkaitan antara pelbagai jenis kandungan berkaitan, dan bertanya atau mengaktifkan kandungan berkaitan melalui penyebaran. Secara amnya dipercayai bahawa keupayaan ingatan bersekutu ini memainkan peranan yang sangat penting dalam kecerdasan manusia. Bagaimanapun, masalah latihan data input tempatan dan masalah pelupaan bencana masih perlu diselesaikan di sini.

Selain menjadi model AI baharu, penyelidikan tentang pembelajaran pengaktifan juga mempunyai nilai lain. Sebagai contoh, ia lebih mudah menyokong latihan atas cip (latihan atas cip) sistem rangkaian saraf berdasarkan pelaksanaan fizikal seperti rangkaian saraf optik dan rangkaian saraf memristor, mengelakkan penurunan dalam ketepatan pengkomputeran keseluruhan sistem disebabkan oleh ketepatan komponen fizikal asas atau bunyi pengaturcaraan. Ia juga boleh digabungkan dengan eksperimen biologi untuk memberi inspirasi kepada kita untuk lebih memahami mekanisme kerja otak, seperti sama ada terdapat penjelasan biologi tertentu untuk peraturan latihan tempatan. Penyelidik Zhou Hongchao berkata, "Saya percaya bahawa kebanyakan sistem yang kompleks dikuasai oleh peraturan matematik yang mudah, dan otak adalah sistem yang sangat indah; akhirnya matlamat kami adalah untuk mereka bentuk mesin yang lebih pintar."

Atas ialah kandungan terperinci Model AI yang diilhamkan oleh otak: Pembelajaran pengaktifan, penyebaran balik yang mencabar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI