Rumah >Peranti teknologi >AI >Idea baharu untuk mempercepatkan model ViT! Meta melancarkan Penggabungan Token, yang bergantung pada penggabungan dan bukannya pemangkasan

Idea baharu untuk mempercepatkan model ViT! Meta melancarkan Penggabungan Token, yang bergantung pada penggabungan dan bukannya pemangkasan

- 王林ke hadapan

- 2023-04-12 10:58:021197semak imbas

Visual Transformer (ViT) memasuki mata umum dua tahun lalu dan telah menjadi komponen teras penyelidikan penglihatan komputer.

Ia berjaya memindahkan model Transformer dalam bidang pemprosesan bahasa semula jadi ke bidang penglihatan komputer. Sejak itu, kemajuan dalam bidang penglihatan komputer telah dipercepatkan.

Walaupun sudah diatasi dari segi kos dan prestasi, Vanilla ViT masih mempunyai banyak kelebihan.

Ia terdiri daripada pendaraban matriks mudah, yang menjadikannya lebih pantas daripada bilangan operasi mentah yang dicadangkan.

Selain itu, mereka menyokong teknik pra-latihan penyeliaan kendiri yang berkuasa seperti MAE (Masked Autoencoder) yang boleh menghasilkan hasil terkini pada masa yang sama Latihan cepat.

Dan kerana mereka tidak membuat andaian tentang data, mereka boleh digunakan pada banyak mod seperti imej, audio, teks, dsb. dengan hampir tiada perubahan.

Sudah tentu cita-cita sangat penuh, tetapi realitinya sangat kurus. Model ViT berskala besar dan mempunyai kelewatan yang besar. Menjalankan model kompleks ini pada peranti dengan sumber terhad boleh menjadi sangat bermasalah.

Pemangkasan token: semakin baik, tetapi tidak sepenuhnya lebih baik

Untuk menangani masalah operasi perlahan, penyelidik Pelbagai penyelesaian diberikan. Salah satu cara biasa untuk mempercepatkan model Transformer penglihatan adalah dengan melakukan pemangkasan token.

Memangkas token pada masa jalan untuk menghasilkan Transformer yang cekap dengan memangkas token yang kurang penting. Contohnya, DynamicViT memangkas token berlebihan secara hierarki untuk mengurangkan FLOP dalam tugas pengelasan.

Walau bagaimanapun, pemangkasan token mempunyai beberapa masalah, yang paling penting ialah token pemangkasan akan menyebabkan kehilangan maklumat Oleh itu, orang ramai tidak berminat dengan token model ViT . Bilangan pemangkasan adalah terhad Untuk mengurangkan kehilangan maklumat, hanya token yang tidak penting boleh dipangkas.

Selain itu, agar token pangkas itu sah, seseorang itu perlu melatih model itu semula. Ini mengakibatkan penggunaan sumber tambahan.

Lebih penting lagi, pemangkasan token ialah proses yang dinamik, dan bilangan pemangkasan token yang berbeza perlu ditentukan berdasarkan imej atau ayat yang berbeza. Walaupun ini bagus untuk meningkatkan ketepatan, ia tidak cukup praktikal kerana dalam kes ini data tidak lagi boleh diproses secara kelompok.

Untuk menyelesaikan masalah ini, orang ramai perlu menambah topeng semasa proses pemangkasan, yang akan menjejaskan peningkatan kecekapan.

Ringkasnya, pemangkasan token memang menjadikan ViT berjalan lebih pantas, tetapi ini dicapai dengan kos kehilangan maklumat.

TokenMerging: Idea lain

Cara menggunakan ViT adalah sama dalam kelajuan untuk pemangkasan, tetapi mengekalkan ketepatan yang lebih tinggi daripada pemangkasan? Pasukan penyelidik Meta AI telah menghasilkan penyelesaian baharu: Penggabungan Token (ToMe).

Pautan kertas: https://arxiv.org/pdf/2210.09461.pdf

Penggabungan Token memilih untuk menggabungkan token dan bukannya mencantasnya. Terima kasih kepada algoritma pemadanan tersuainya, ia sepantas pemangkasan sambil menjadi lebih tepat. Selain itu, ia berfungsi tanpa memerlukan sebarang latihan tambahan, jadi anda boleh menggunakannya pada model besar untuk mempercepatkannya tanpa mengorbankan banyak ketepatan.

Matlamat Meta adalah untuk memasukkan modul Penggabungan Token ke dalam ViT sedia ada untuk meningkatkan daya pengeluaran latihan dan inferens dengan menggabungkan token berlebihan tanpa memerlukan latihan tambahan.

Idea asasnya ialah: dalam model Transformer, melalui penggabungan, setiap lapisan dikurangkan dengan r token. Katakan model Transformer mempunyai lapisan L, maka token rL boleh dikurangkan dengan penggabungan. Saiz pembolehubah r menentukan hubungan antara kelajuan dan ketepatan, kerana lebih sedikit penanda bermakna ketepatan yang lebih rendah tetapi daya pemprosesan yang lebih tinggi.

Perlu diperhatikan bahawa dalam Penggabungan Token, token rL akan dikurangkan tanpa mengira kandungan imej. Ini menyelesaikan masalah ketidakupayaan untuk melakukan pemprosesan kelompok dalam pemangkasan token dengan sempurna.

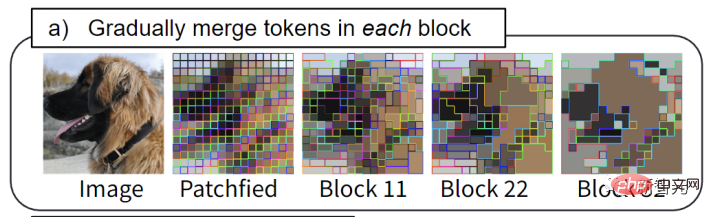

Dengan ToMe, kelompok token serupa digabungkan dalam setiap blok Transformer: contohnya, bulu anjing digabungkan menjadi satu token.

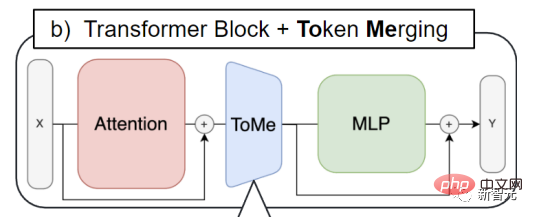

Penggabungan Token dimasukkan ke dalam setiap blok perhatian dan setiap blok Transformer. Ini juga berbeza dengan aliran kerja pemangkasan token. Yang terakhir cenderung untuk meletakkan langkah pemangkasan pada permulaan setiap blok Transformer.

Melalui Penggabungan Token, maklumat token yang perlu digabungkan boleh disebarkan, dan ViT juga boleh menggunakan blok perhatian Ciri-ciri untuk menentukan token yang perlu digabungkan.

Kaedah khusus

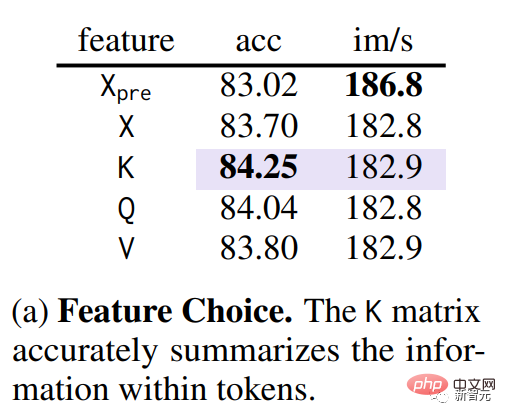

Langkah pertama penggabungan Ia ditentukan untuk menjadi token yang serupa. Di bawah syarat QKV (pertanyaan, kunci, nilai) dalam Transformer telah diekstrak, melalui eksperimen ablasi, pasukan penyelidik mendapati bahawa menggunakan kunci boleh mengukur kesamaan antara token (bahagian ungu dalam rajah di bawah).

Oleh kerana kunci telah meringkaskan maklumat yang terkandung dalam setiap token supaya ia boleh digunakan untuk produk titik dalam Perhatian. Ukur persamaan antara token.

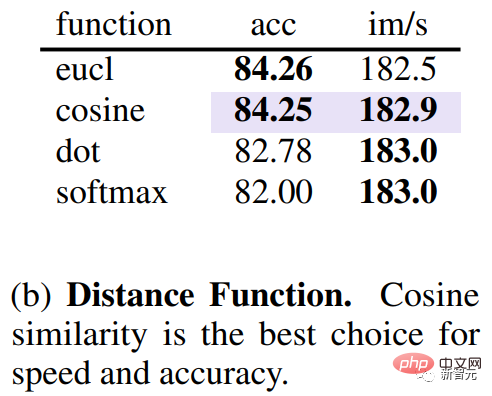

Selain mengkaji metrik mana yang lebih baik untuk mengukur persamaan token, anda juga perlu mengetahui jarak yang mengukur persamaan. Melalui eksperimen, pasukan penyelidik mendapati bahawa menggunakan jarak kosinus untuk mengukur persamaan antara toke boleh mencapai hubungan terbaik antara ketepatan dan kelajuan.

Selepas menentukan persamaan token, kaedah pantas diperlukan untuk menentukan token yang perlu dipadankan untuk mengurangkan jumlah r .

Pasukan Meta tidak menggunakan algoritma pengelompokan kmeans atau algoritma segmentasi graf, tetapi menggunakan algoritma pemadanan, kerana yang terakhir bukan sahaja dapat memadankan bilangan token dengan tepat dalam setiap lapisan , dan boleh melakukan beribu-ribu perlawanan dengan cepat. Ini tidak boleh dicapai dengan algoritma pengelompokan berulang.

Oleh itu, pasukan Meta telah menghasilkan penyelesaian yang lebih cekap.

Matlamat reka bentuk adalah seperti berikut. 1.) elakkan sebarang lelaran yang tidak boleh disejajarkan, 2.) inginkan perubahan yang digabungkan menjadi beransur-ansur, kerana pengelompokan tidak mempunyai had pada bilangan penanda yang boleh digabungkan ke dalam kumpulan (yang mungkin menjejaskan rangkaian), sambil memadankan Kebanyakan tag tidak digabungkan.

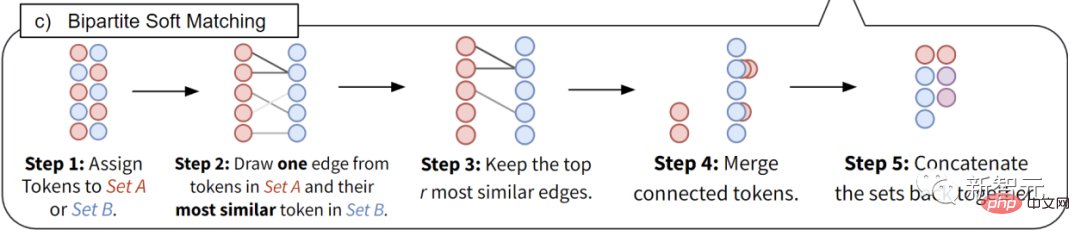

- Bahagikan semua token kepada 2 set A dan B yang sama saiz.

- Lukiskan tepi daripada setiap token dalam set A kepada token yang paling serupa dalam set B.

- Hanya simpan bahagian tepi yang paling serupa dan padamkan yang lain.

- Gabungan tepi yang masih bersambung (ciri dipuratakan).

- Satukan kedua-dua set ini untuk mendapatkan keputusan gabungan terakhir.

Dengan teknologi unik ini, daya pemprosesan dan kelajuan latihan sebenar model ViT boleh dipertingkatkan. Menggunakan Penggabungan Token boleh menggandakan kelajuan latihan. Ia boleh digunakan untuk tugasan imej, video dan audio dan masih mencapai ketepatan terkini.

Atas ialah kandungan terperinci Idea baharu untuk mempercepatkan model ViT! Meta melancarkan Penggabungan Token, yang bergantung pada penggabungan dan bukannya pemangkasan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI