Rumah >Peranti teknologi >AI >Melatih ViT terbesar dalam sejarah dengan mudah? Google meningkatkan model bahasa visual PaLI: menyokong 100+ bahasa

Melatih ViT terbesar dalam sejarah dengan mudah? Google meningkatkan model bahasa visual PaLI: menyokong 100+ bahasa

- 王林ke hadapan

- 2023-04-12 09:31:061491semak imbas

Kemajuan pemprosesan bahasa semula jadi dalam beberapa tahun kebelakangan ini sebahagian besarnya datang daripada model bahasa berskala besar setiap model baharu yang dikeluarkan mendorong jumlah parameter dan data latihan ke tahap tertinggi baharu, dan juga akan Menjalankan a pembunuhan beramai-ramai kedudukan penanda aras sedia ada!

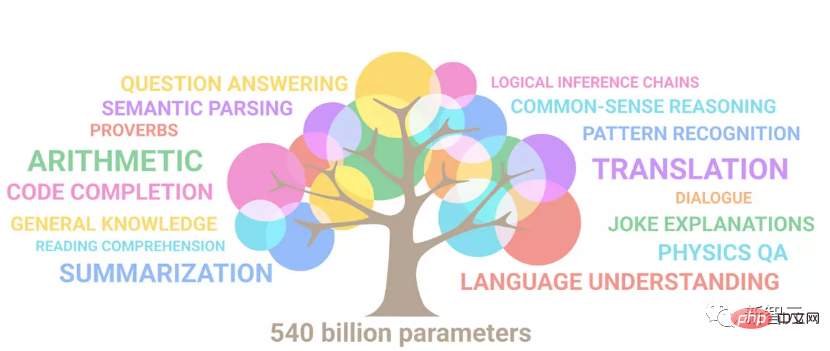

Sebagai contohPada bulan April tahun ini, Google mengeluarkan 540 bilion parameter model bahasa PaLM (Pathways Language Model) dalam bahasa dan penaakulan Ia telah berjaya mengatasi manusia dalam beberapa siri penilaian, terutamanya prestasi cemerlangnya dalam senario pembelajaran sampel kecil beberapa pukulan juga dianggap sebagai hala tuju pembangunan model bahasa generasi seterusnya.

Begitu juga Model Bahasa VisualMalah, juga Usaha yang gigih dapat menghasilkan keajaiban , anda boleh meningkatkan prestasi dengan meningkatkan saiz model melalui .

Sudah tentu, jika hanyalah model bahasa visual untuk berbilang tugas , ia jelas tidak begitu universal, dan ia mesti menyokong input dalam berbilang bahasa Hanya keluaran.

Baru-baru ini, Google telah menaik taraf sambungan PaLM kepada PALI (Model Bahasa dan Imej Laluan), yang mempunyai kedua-dua pemahaman berbilang bahasa dan imej keupayaan, sambil menyokong 100+ bahasa untuk melaksanakan pelbagai aplikasi imej dan bahasa merentas penglihatan, bahasa dan berbilang modal, seperti menjawab soalan visual, kapsyen imej, pengesanan objek, klasifikasi imej, OCR , teks penaakulan, dsb.

Pautan kertas: https://arxiv.org/abs/2209.06794

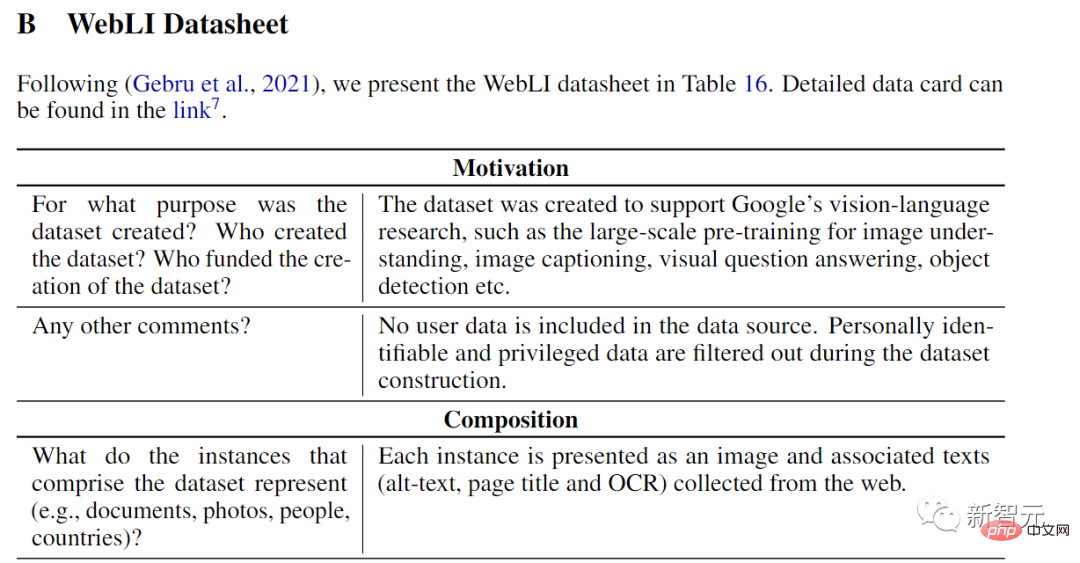

Model ini dilatih menggunakan koleksi imej awam, yang termasuk anotasi yang dirangkak secara automatik dalam 109 bahasa, yang juga dipanggil set data WebLI dalam artikel.

Model PaLI yang dilatih di WebLI mencapai prestasi terkini pada berbilang imej dan penanda aras bahasa, seperti COCO-Captions, TextCaps, VQAv2, OK-VQA, TextVQA , dsb. dsb., juga mengatasi tanda aras kapsyen visual berbilang bahasa dan menjawab soalan visual model terdahulu.

Seni Bina Model

Salah satu matlamat PALI adalah untuk mengkaji prestasi dan skala model bahasa dan visual Adakah sambungan pada sama, terutamanya kebolehskalaan model imej bahasa?

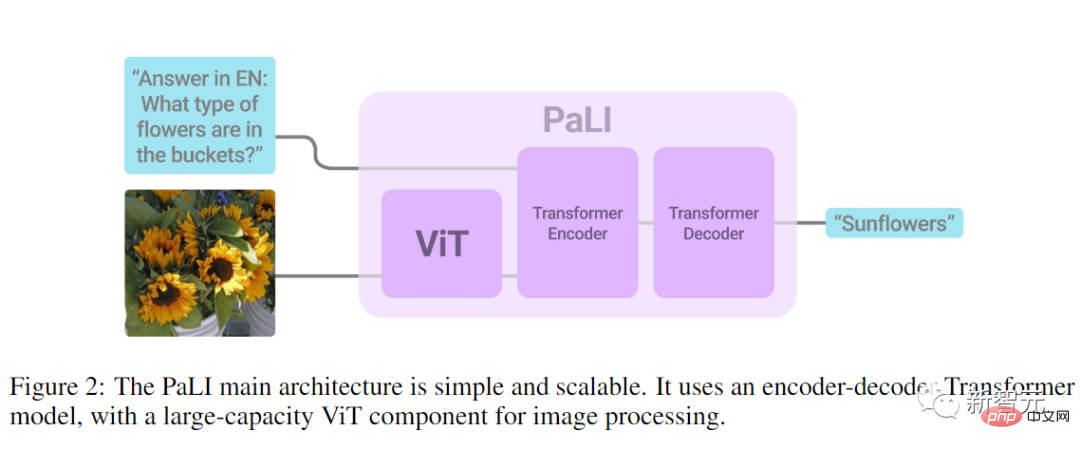

Jadi reka bentuk seni bina model adalah sangat mudah, terutamanya untuk kemudahan eksperimen, terutamanya untuk kebolehgunaan semula dan kebolehskalaan. Model

terdiri daripada pengekod Transformer yang memproses teks input dan penyahkod Transformer autoregresif yang menjana teks output.

Apabila memproses imej, input kepada pengekod Transformer juga termasuk perkataan visual yang mewakili imej yang diproses oleh ViT.

Reka bentuk utama model PaLI ialah penggunaan semula para penyelidik menggunakan pemberat penglihatan mod tunggal dan model bahasa yang dilatih sebelum ini (seperti mT5-XXL dan ViT besar) sebagai benih. daripada model, Penggunaan semula ini bukan sahaja memindahkan keupayaan mod tunggal, latihan, tetapi juga menjimatkan kos pengiraan.

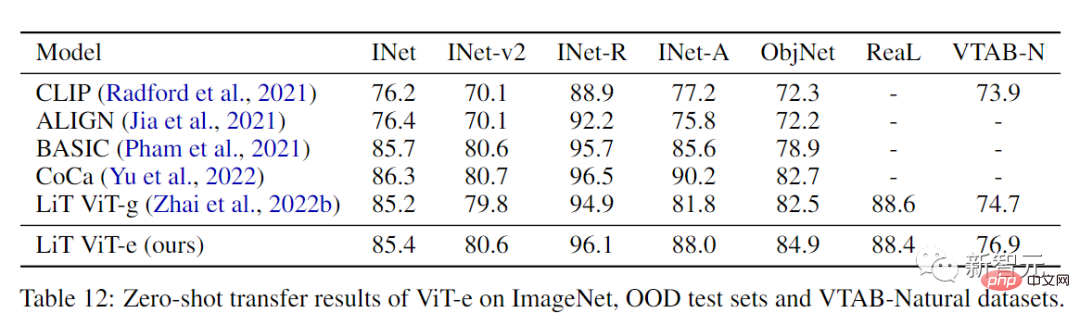

Komponen visual model menggunakan ViT-e, seni bina ViT terbesar setakat ini, yang mempunyai struktur yang sama dengan 1.8 bilion parameter ViT-G model, Dan menggunakan parameter latihan yang sama, perbezaannya ialah ia dikembangkan kepada 4 bilion parameter.

Walaupun peraturan penskalaan telah dikaji dalam kedua-dua bidang visual dan bahasa, tingkah laku penskalaan telah kurang diterokai dalam model gabungan penglihatan dan bahasa Meluaskan skala model tulang belakang visual mungkin membawa kepada ketepuan keuntungan dalam tugas klasifikasi.

Para penyelidik juga mengesahkan perkara ini, dan dapat diperhatikan bahawa ViT-e hanya lebih baik sedikit daripada ViT-G pada ImageNet, tetapi ViT-e mempunyai peningkatan yang hebat pada tugas bahasa visual PaLI. Contohnya, ViT-e mengatasi ViT-G dengan hampir 3 mata CIDEr pada tugas sari kata COCO. 3 mata lebih daripada ViT-G dalam tugasan. Ini juga membayangkan ruang untuk menggunakan model rangka ViT yang lebih besar dalam tugas bahasa visual pada masa hadapan.

Para penyelidik mengguna pakai tulang belakang mT5 sebagai komponen pemodelan bahasa, menggunakan mT5-Large (1 bilion parameter) yang telah dilatih. dan mT5-XXL (13 bilion parameter) untuk memulakan penyahkod-pengekod bahasa PaLI dan kemudian meneruskan latihan hibrid mengenai banyak tugas bahasa, termasuk tugas pemahaman bahasa tulen, yang juga membantu mengelakkan bencana melupakan pemahaman bahasa dan kapasiti penjanaan mT5.

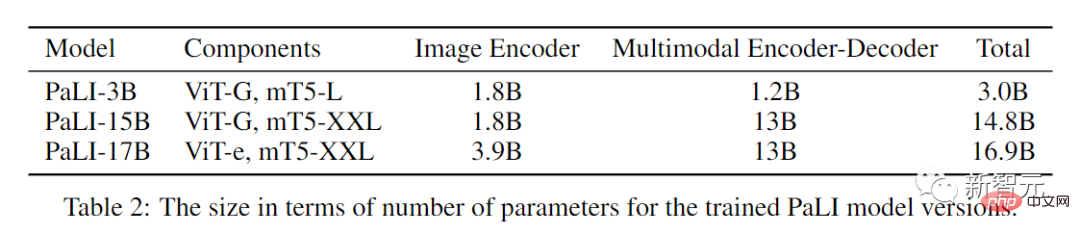

Akhirnya, kami mendapat tiga model PALI yang berbeza saiz.

Set data dalam 109 bahasa

Penyelidikan lanjutan berkaitan pembelajaran mendalam menunjukkan bahawa semakin besar model, semakin banyak data latihan diperlukan Set ini juga lebih besar.

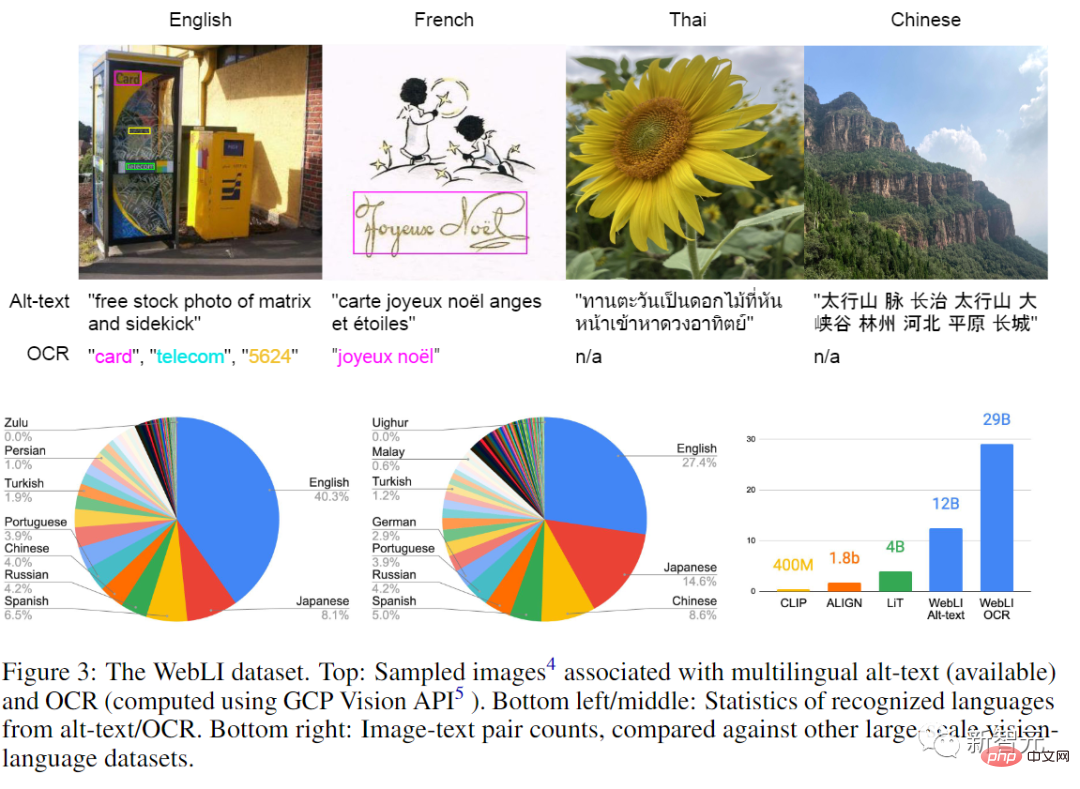

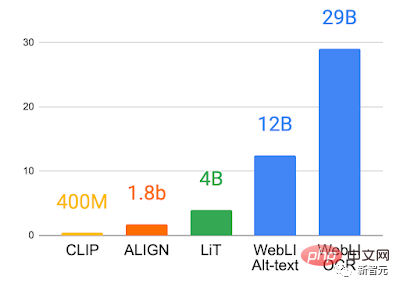

Jadi untuk mengkaji secara menyeluruh dan melepaskan potensi model pra-latihan imej bahasa, penyelidik merangkak sejumlah besar data imej dan teks daripada Internet dan membina set data baharu WebLI , yang merangkumi 12 bilion teks alt dan 10 bilion imej dalam 109 bahasa.

Selain menggunakan teks web untuk anotasi, penyelidik juga menggunakan API penglihatan awan untuk melaksanakan pengecaman OCR pada imej, menghasilkan 29 bilion imej- OCR pasangan data.

Menggunakan hampir pendua untuk menyahduplikasi imej daripada bahagian latihan, pengesahan dan ujian 68 set data bahasa visual dan visual biasa untuk mengelakkan kebocoran data di hiliran tugas penilaian.

Untuk meningkatkan lagi kualiti data, penyelidik juga akan menjaringkan dan melaraskan berdasarkan persamaan silang mod "imej dan teks alt" ambang, dan akhirnya hanya mengekalkan 10% daripada imej, sejumlah 1 bilion imej digunakan untuk melatih PaLI

melatih model besar

Sejak bahasa visual task is multi-modal , jadi model perlu mempunyai pelbagai keupayaan pemprosesan semantik dan mempunyai matlamat yang berbeza. Contohnya, sesetengah tugas memerlukan penyetempatan objek setempat untuk menyelesaikan tugasan dengan tepat, manakala tugasan lain mungkin memerlukan lebih banyak maklumat semantik global.

Begitu juga, sesetengah tugasan bahasa mungkin memerlukan jawapan yang panjang, manakala yang lain memerlukan jawapan yang padat.

Untuk menyelesaikan semua matlamat yang tidak konsisten ini, penyelidik mengambil kesempatan daripada kekayaan data pra-latihan WebLI dan memperkenalkan gabungan tugas pra-latihan (Pretraining Task Mixture) untuk menyediakan model untuk pelbagai aplikasi hiliran.

Untuk menjadikan model lebih serba boleh untuk menyelesaikan pelbagai tugas, pengarang mengelaskan semua tugas ke dalam API biasa tunggal (input: imej + teks; output: teks), membenarkan perkongsian Pengetahuan berbilang didayakan antara tugas imej dan bahasa, juga dengan tetapan pra-latihan.

Sasaran yang digunakan untuk pra-latihan diunjurkan ke dalam API yang sama sebagai campuran berwajaran, dengan matlamat kedua-duanya mengekalkan keupayaan untuk menggunakan semula komponen model sambil melatih model untuk melaksanakan tugas baharu .

Model menggunakan rangka kerja T5X dan Flaxformer sumber terbuka dan dilatih dengan Flax dalam JAX Bahagian visual ViT-e menggunakan rangka kerja BigVision sumber terbuka untuk menjana vektor perkataan bahasa bahagian dan bahagian visual. Vektor tampalan dilarikan dan digunakan bersama sebagai input penyahkod pengekod berbilang mod Pengekod dimulakan menggunakan latihan pra-latihan mT5-XXL. Semasa proses latihan PaLI, pemberat komponen visual dibekukan dan hanya pemberat pengekod-penyahkod multimodal dikemas kini.

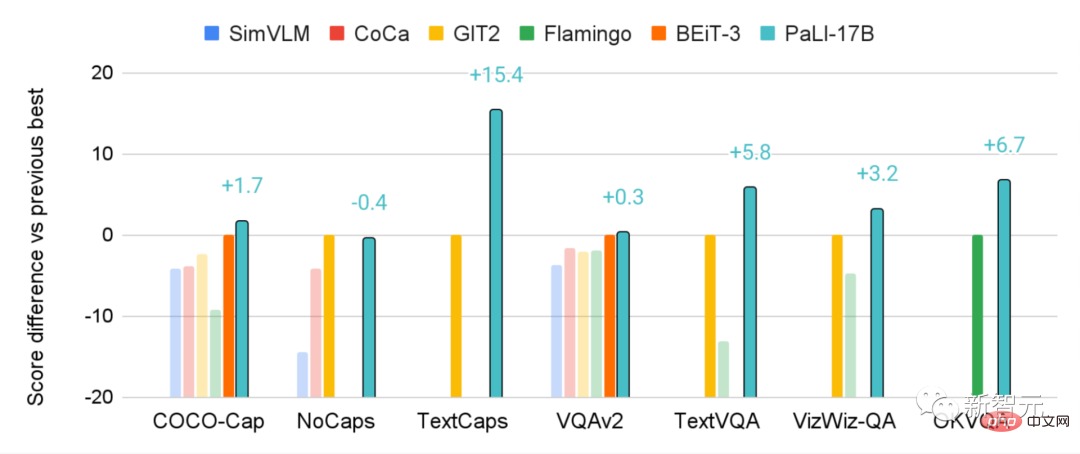

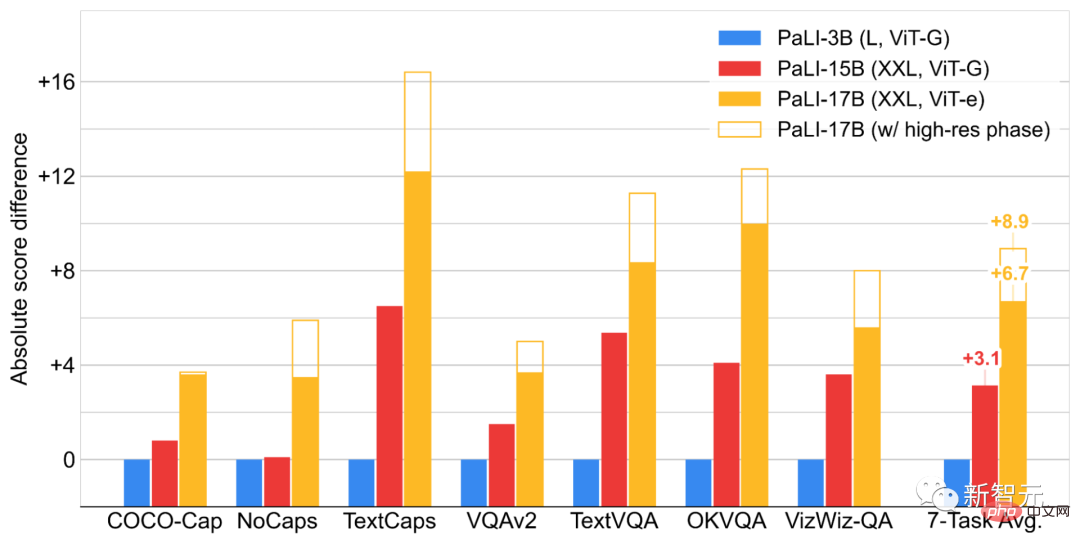

Dalam bahagian percubaan, penyelidik membandingkan PaLI pada penanda aras bahasa visual biasa, dan model PaLI mencapai hasil terkini dalam tugasan ini, malah melebihi yang sangat besar yang dicadangkan dalam literatur sebelumnya. Model.

Sebagai contoh, 17 bilion parameter PALI berprestasi lebih baik daripada 80 bilion parameter model Flamingo pada beberapa tugasan VQA dan kapsyen imej.

Dan PALI juga mengekalkan prestasi yang baik dalam bahasa tunggal atau tugas visual tunggal, walaupun ini bukan matlamat latihan utama PALI.

Kami juga mengkaji cara komponen model imej dan bahasa berinteraksi dari segi sambungan model, dan di mana model tersebut menghasilkan keuntungan terbesar.

Kesimpulan akhir ialah penskalaan bersama (scaling) kedua-dua komponen ini menghasilkan prestasi terbaik, khususnya untuk komponen visual yang memerlukan parameter yang agak sedikit Penskalaan adalah kritikal, tetapi penskalaan juga penting untuk meningkatkan prestasi pada tugasan berbilang bahasa.

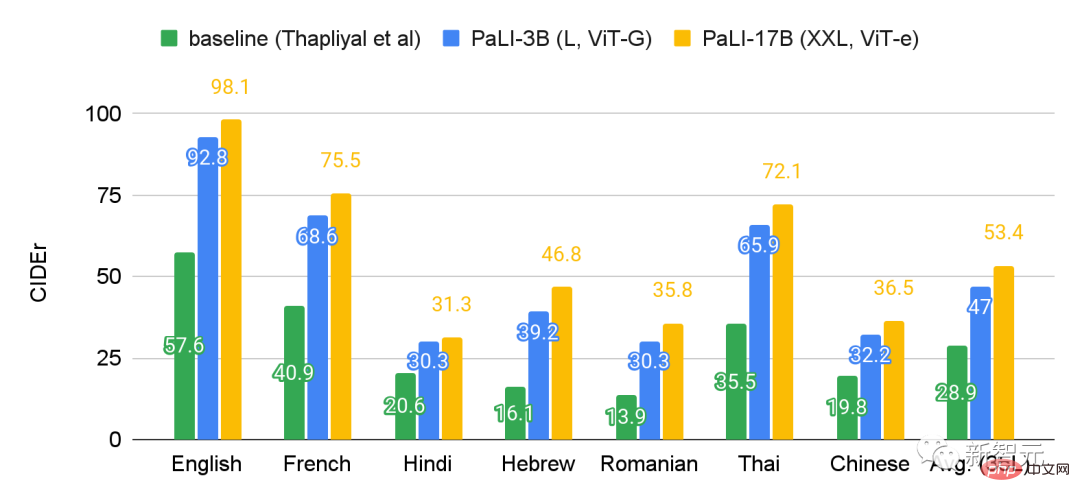

Selepas menilai PaLI pada penanda aras Crossmodal-3600 dalam 35 bahasa, boleh didapati bahawa tugas tajuk berbilang bahasa mendapat manfaat lebih daripada sambungan daripada model PaLI.

Untuk mengelak daripada mewujudkan atau mengukuhkan bias yang tidak adil dalam model bahasa dan imej yang besar, perlu ada sedikit pemahaman tentang data yang digunakan dan cara model digunakan data itu Untuk mengekalkan ketelusan, menguji kesaksamaan model dan menjalankan analisis data yang bertanggungjawab, artikel itu menyediakan Kad Data dan Kad Model

Atas ialah kandungan terperinci Melatih ViT terbesar dalam sejarah dengan mudah? Google meningkatkan model bahasa visual PaLI: menyokong 100+ bahasa. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI