Rumah >Peranti teknologi >AI >Alam Semula Jadi: Adakah model AI yang lebih besar lebih baik?

Alam Semula Jadi: Adakah model AI yang lebih besar lebih baik?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 09:01:021767semak imbas

Model AI Generatif semakin besar hari ini, jadi adakah lebih besar bermakna lebih baik?

Tidak. Kini, sesetengah saintis mencadangkan sistem yang lebih ramping dan lebih cekap tenaga.

Alamat artikel: https://www.nature.com/articles/d41586-023-00641-w

Dapatkan it Model bahasa matematik tak tentu

ChatGPT, kegemaran industri teknologi baru-baru ini, sering berprestasi buruk apabila berhadapan dengan soalan matematik yang memerlukan penaakulan untuk dijawab.

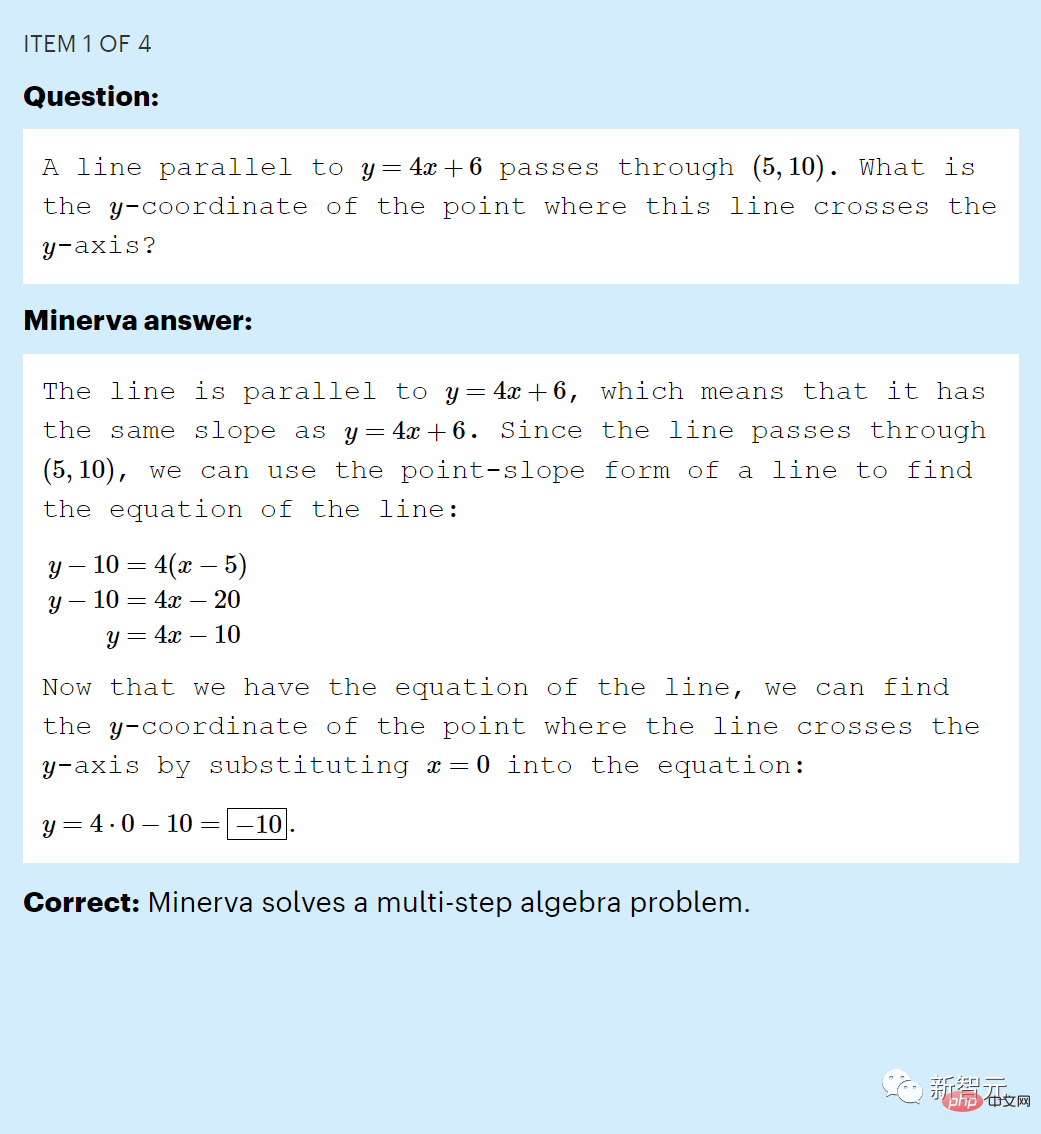

Contohnya, soalan ini "Garis lurus selari dengan y = 4 x + 6 melalui (5, 10). Apakah koordinat y bagi persilangan garis ini dan paksi y?", ia selalunya tidak dijawab dengan betul.

Dalam ujian awal keupayaan penaakulan, ChatGPT hanya memperoleh 26 (%) apabila menjawab sampel set data MATH di peringkat sekolah menengah.

Ini sudah tentu yang kami jangkakan Memandangkan teks input, ChatGPT hanya menjana teks baharu berdasarkan peraturan statistik perkataan, simbol dan ayat dalam set data latihan.

Sudah tentu mustahil model bahasa dapat belajar meniru penaakulan matematik hanya dengan mempelajari model bahasa.

Tetapi sebenarnya, seawal Jun 2022, model bahasa besar bernama Minerva yang dicipta oleh Google telah pun memecahkan "sumpahan" ini.

Minerva mendapat markah 50% pada soalan dalam set data MATH (2), hasil yang mengejutkan para penyelidik.

Minerva menjawab dengan betul masalah matematik sekolah menengah dalam set data "MATH"

Sébastien Bubeck, pakar pembelajaran mesin di Microsoft Research, berkata orang dalam Mereka semua terkejut dan bercakap mengenainya.

Kelebihan Minerva, sudah tentu, ia dilatih dalam teks matematik.

Tetapi penyelidikan Google mencadangkan satu lagi sebab besar mengapa model itu berprestasi baik — skalanya yang besar. Ia adalah lebih kurang tiga kali ganda saiz ChatGPT.

Hasil Minerva membayangkan sesuatu yang telah lama disyaki oleh beberapa penyelidik: melatih LLM yang lebih besar dan memberi mereka lebih banyak data boleh membolehkan mereka menyelesaikan masalah yang sepatutnya memerlukan inferens melalui pengecaman corak sahaja.

Jika begitu, penyelidik mengatakan strategi "lebih besar adalah lebih baik" ini boleh memberikan laluan kepada kecerdasan buatan yang berkuasa.

Tetapi hujah ini jelas boleh dipersoalkan.

LLM masih melakukan kesilapan yang jelas, dan sesetengah saintis percaya bahawa model yang lebih besar hanya menjadi lebih baik dalam menjawab pertanyaan dalam julat data latihan yang berkaitan dan tidak mendapat keupayaan untuk menjawab soalan baharu sepenuhnya.

Perdebatan ini kini merebak di sempadan kecerdasan buatan.

Syarikat komersial telah melihat bahawa dengan model AI yang lebih besar, mereka boleh mendapatkan hasil yang lebih baik, jadi mereka melancarkan LLM yang lebih besar dan lebih besar - setiap satu menelan belanja berjuta-juta dolar untuk dibina.

Tetapi model ini mempunyai kekurangan yang besar. Di samping fakta bahawa pengeluaran mereka boleh menjadi tidak percaya, dengan itu menyemarakkan penyebaran maklumat salah, mereka terlalu mahal dan menggunakan banyak tenaga.

Pengulas percaya bahawa LLM yang besar tidak akan dapat meniru atau memperoleh kemahiran yang membolehkan mereka menjawab soalan inferens secara konsisten.

Sebaliknya, sesetengah saintis berkata kemajuan memerlukan AI yang lebih kecil dan lebih cekap tenaga, pandangan yang sebahagiannya diilhamkan oleh cara otak belajar dan membuat perhubungan.

Adakah model yang lebih besar lebih baik?

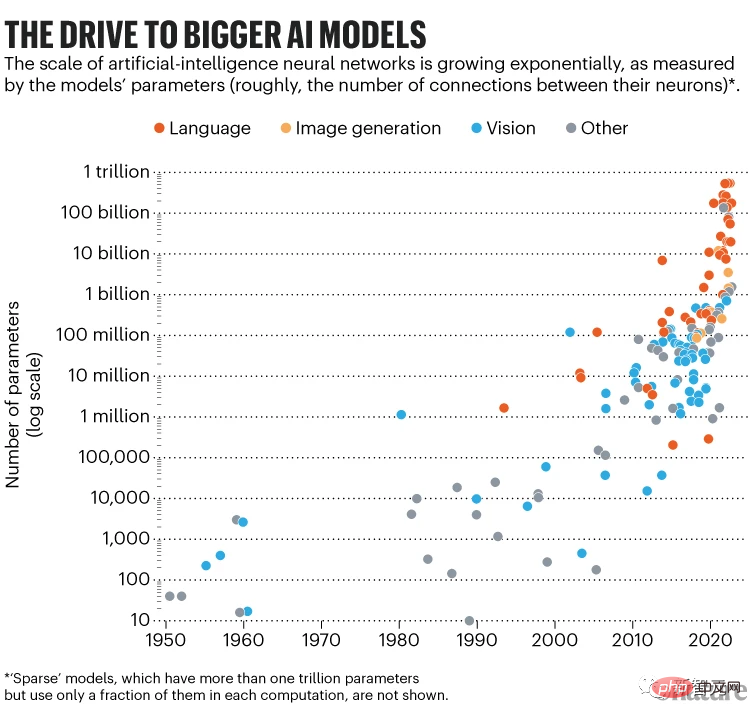

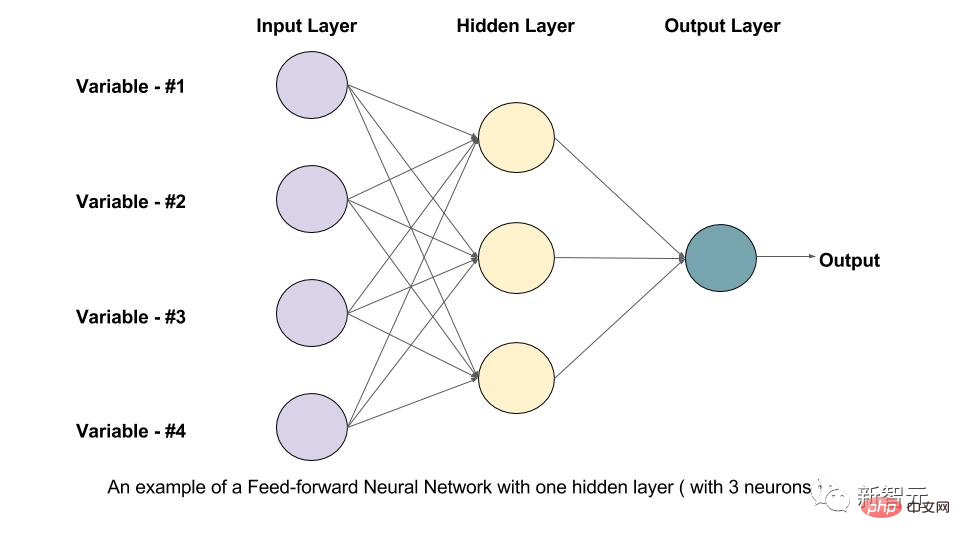

Model bahasa besar seperti ChatGPT dan Minerva ialah rangkaian besar unit pengkomputeran tersusun secara hierarki (juga dipanggil neuron buatan).

Saiz LLM diukur mengikut bilangan parameter yang ada dan bilangan parameter menerangkan nilai boleh laras kekuatan sambungan antara neuron.

Untuk melatih rangkaian sedemikian, anda perlu memintanya meramalkan bahagian bertopeng ayat yang diketahui dan melaraskan parameter ini supaya algoritma berfungsi dengan lebih baik pada masa akan datang.

Ulangi ini dalam berbilion ayat tulisan manusia, dan rangkaian saraf mempelajari perwakilan dalaman yang meniru cara manusia menulis bahasa.

Pada peringkat ini, LLM dianggap sebagai pra-latihan: parameternya menangkap struktur statistik bahasa bertulis yang dilihatnya semasa latihan, termasuk semua fakta, berat sebelah dan kesilapan dalam teks. Ia kemudiannya boleh "ditala dengan halus" berdasarkan data khusus.

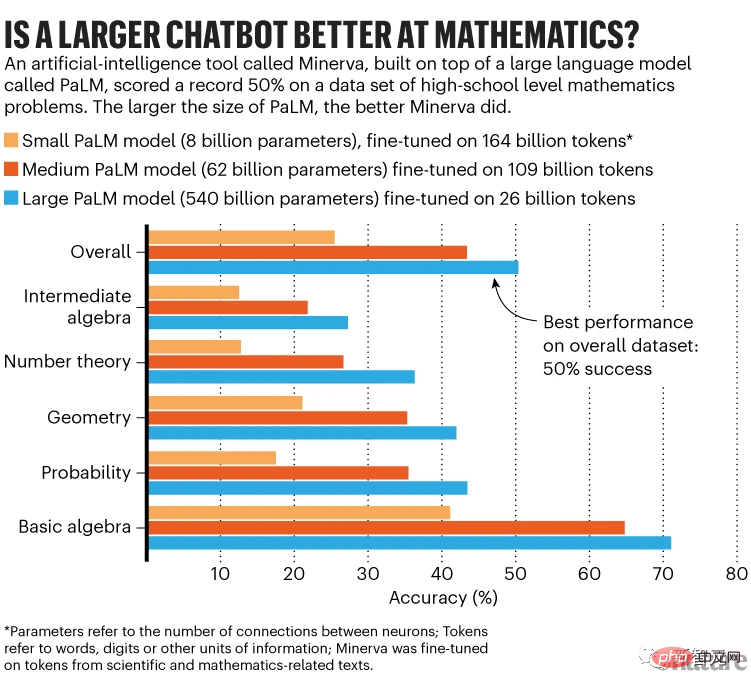

Sebagai contoh, untuk membuat Minerva, penyelidik bermula dengan Model Bahasa Laluan Google (PaLM), yang mempunyai 540 bilion parameter dan telah dilatih terlebih dahulu pada set data 780 bilion token.

Token boleh berupa perkataan, nombor, atau beberapa unit maklumat dalam kes PaLM, token dikumpulkan daripada dokumen, buku dan kod web bahasa Inggeris dan berbilang bahasa. Minerva adalah hasil daripada PaLM memperhalusi berpuluh bilion token daripada kertas saintifik dan halaman web matematik.

Minerva boleh menjawab soalan "Apakah gandaan terbesar bagi 30 yang kurang daripada 520?"

LLM nampaknya sedang berfikir secara berperingkat, tetapi apa yang dilakukannya ialah menukar masalah kepada urutan token, menjana token seterusnya yang munasabah dari segi statistik, menambahnya pada urutan asal, menjana token lain, dsb. Proses ini dipanggil penaakulan.

Penyelidik Google memperhalusi Minerva dalam tiga saiz menggunakan model PaLM terlatih asas dengan 8 bilion, 62 bilion dan 540 bilion parameter. Prestasi Minerva bertambah baik mengikut skala.

Pada keseluruhan set data MATH, ketepatan model terkecil ialah 25%, model sederhana mencapai 43% dan model terbesar memecahkan markah 50%.

Model terbesar juga menggunakan paling sedikit data penalaan halus - ia diperhalusi pada hanya 26 bilion token, manakala model terkecil diperhalusi pada 164 bilion token.

Tetapi model terbesar mengambil masa sebulan untuk diperhalusi, dengan perkakasan khusus yang memerlukan lapan kali kuasa pengkomputeran model terkecil, yang mengambil masa hanya dua minggu untuk diperhalusi.

Sebaik-baiknya, model terbesar harus diperhalusi pada lebih banyak token. Ethan Dyer, ahli pasukan Minerva di Google Research, berkata ini boleh membawa kepada prestasi yang lebih baik. Tetapi pasukan itu tidak fikir ia boleh dilakukan untuk mengira kos.

Kesan Penskalaan

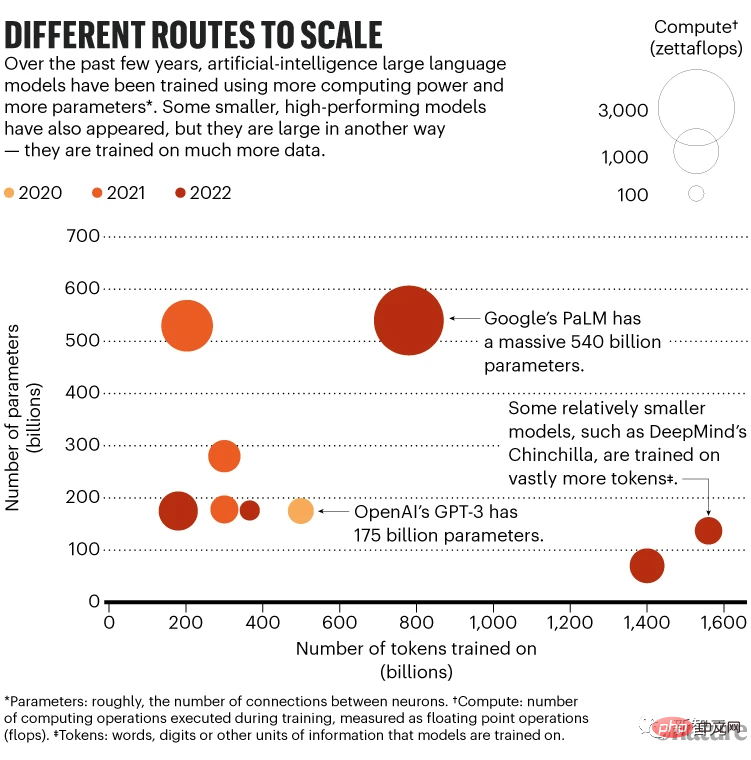

Model Minerva terbesar menunjukkan prestasi terbaik, yang konsisten dengan penyelidikan mengenai Undang-undang Skala - undang-undang ini menentukan prestasi Bagaimana untuk menambah baik apabila saiz model meningkat.

Kajian 2020 menunjukkan bahawa model berprestasi lebih baik memandangkan satu daripada tiga perkara: lebih banyak parameter, lebih banyak data latihan atau lebih banyak "pengiraan" (bilangan operasi pengiraan yang dilakukan semasa latihan) .

Skala prestasi mengikut undang-undang kuasa, bermakna ia bertambah baik apabila bilangan parameter bertambah.

Walau bagaimanapun, penyelidik tidak tahu mengapa. "Undang-undang ini adalah empirikal semata-mata," kata Irina Rish, seorang saintis komputer di Institut Mila-Quebec untuk Kepintaran Buatan di Universiti Montreal di Kanada.

Untuk hasil terbaik, penyelidikan 2020 mencadangkan saiz model perlu meningkat lima kali ganda apabila data latihan meningkat dua kali ganda. Ini telah diubah suai sedikit daripada kerja tahun lepas.

Pada bulan Mac tahun ini, DeepMind percaya bahawa adalah yang terbaik untuk mengembangkan kedua-dua saiz model dan data latihan, dan model yang lebih kecil yang dilatih menggunakan lebih banyak data berprestasi lebih baik daripada model yang lebih besar yang dilatih menggunakan kurang data.

Sebagai contoh, model Chinchilla DeepMind mempunyai 70 bilion parameter dan dilatih menggunakan 1.4 trilion token, manakala model 280 bilion parameter Gopher dilatih menggunakan 300 bilion token. Dalam penilaian seterusnya, Chinchilla mengatasi Gopher.

Pada bulan Februari, saintis Meta membina model parameter kecil yang dipanggil LLaMA berdasarkan konsep ini, yang dilatih menggunakan sehingga 1.4 trilion token.

Penyelidik berkata bahawa 13 bilion versi parameter LLaMA adalah lebih baik daripada ChatGPT pendahulu GPT-3 (175 bilion parameter), manakala versi 65 bilion parameter lebih kompetitif daripada Chinchilla atau bahkan PaLM.

Oktober lalu, Ethan Caballero dari McGill University di Montreal, Rish dan yang lain melaporkan bahawa mereka telah menemui hubungan yang lebih kompleks antara skala dan prestasi - dalam beberapa kes, pelbagai undang-undang kuasa boleh mengawal prestasi Bagaimana ia berubah mengikut saiz model .

Sebagai contoh, dalam senario hipotetikal untuk memasang persamaan am, prestasi mula-mula bertambah baik secara beransur-ansur dan kemudian lebih cepat apabila saiz model meningkat, tetapi kemudian berkurangan sedikit apabila bilangan parameter terus meningkat, dan kemudian bertambah lagi. Ciri-ciri perhubungan kompleks ini bergantung pada butiran setiap model dan cara ia dilatih.

Akhirnya, penyelidik berharap dapat meramalkan lebih awal bila mana-mana LLM tertentu akan meningkat.

Penemuan teori yang berasingan turut menyokong dorongan untuk model yang lebih besar - "undang-undang keteguhan" pembelajaran mesin, yang dicadangkan oleh Bubeck dan rakan sekerja pada 2021.

Sesuatu model adalah teguh jika jawapannya kekal konsisten walaupun terdapat gangguan kecil dalam inputnya.

Dan Bubeck serta rakan sekerja menunjukkan secara matematik bahawa peningkatan bilangan parameter dalam model meningkatkan keteguhan dan dengan itu keupayaan generalisasi.

Bubeck berkata bahawa keteraturan menunjukkan bahawa penskalaan adalah perlu tetapi tidak mencukupi untuk generalisasi. Namun, ia telah digunakan untuk mewajarkan perpindahan kepada model yang lebih besar. "Saya fikir ia adalah perkara yang munasabah untuk dilakukan."

Minerva juga mengambil kesempatan daripada inovasi utama yang dipanggil Thought Chain Prompts. Pengguna awalan soalan dengan teks yang merangkumi beberapa contoh masalah dan penyelesaian, serta penaakulan yang membawa kepada jawapan (ini adalah rantaian pemikiran klasik).

Semasa penaakulan, LLM mengambil petunjuk daripada konteks ini dan menyediakan jawapan langkah demi langkah yang kelihatan seperti penaakulan.

Ini tidak memerlukan pengemaskinian parameter model dan oleh itu tidak melibatkan kuasa pengiraan tambahan yang diperlukan untuk penalaan halus.

Keupayaan untuk bertindak balas kepada gesaan rantaian pemikiran hanya muncul dalam LLM dengan lebih 100 bilion parameter.

Blaise Agüera y Arcas dari Google Research berkata penemuan itu membantu model yang lebih besar bertambah baik berdasarkan undang-undang penskalaan empirikal. "Model yang lebih besar akan menjadi lebih baik." LLM mendapat, mereka tidak akan mempunyai kebolehan penaakulan (atau penaakulan meniru) yang cukup baik untuk menyelesaikan masalah baharu dengan pasti.

Beliau berkata bahawa LLM nampaknya hanya membuat alasan dengan menggunakan templat yang pernah ditemuinya sebelum ini, sama ada dalam data latihan atau dalam gesaan. "Ia tidak dapat memahami dengan serta-merta sesuatu yang tidak pernah dilihat sebelum ini." jawapan, kepada soalan.

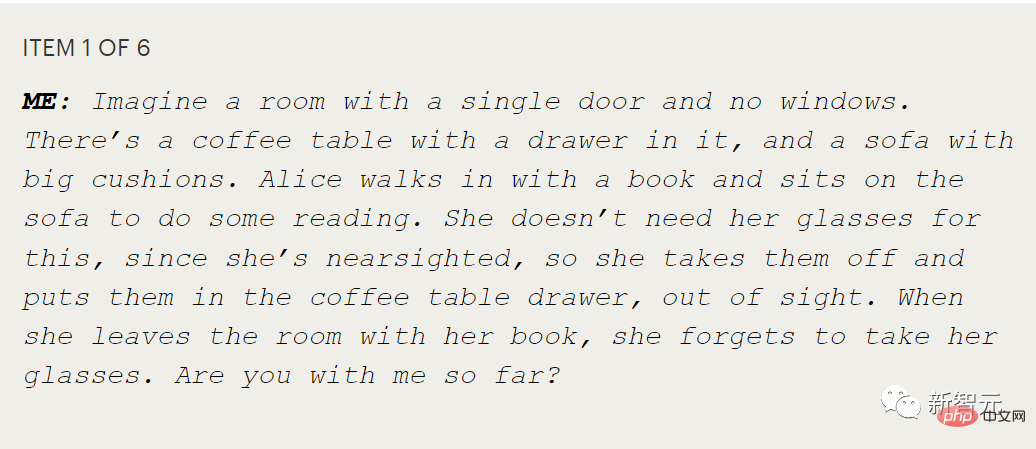

Khususnya, ujian yang menunjukkan sama ada seseorang itu mempunyai apa yang dipanggil teori minda, iaitu kebolehan untuk berteori atau mengukur keadaan mental orang lain.

Contohnya, Alice meletakkan cermin matanya di dalam laci, dan kemudian Bob menyembunyikannya di bawah kusyen tanpa diketahui oleh Alice. Di manakah Alice akan pergi dahulu untuk mencari cermin matanya?

Bertanya kepada kanak-kanak soalan ini adalah untuk menguji sama ada mereka faham bahawa Alice mempunyai kepercayaannya sendiri, yang mungkin tidak konsisten dengan apa yang diketahui oleh kanak-kanak itu.

Dalam ujiannya terhadap LaMDA, LLM lain daripada Google, Agüera y Arcas mendapati bahawa LaMDA bertindak balas dengan betul dalam jenis perbualan yang lebih lanjutan ini.

Baginya, ini menunjukkan keupayaan LLM untuk mensimulasikan secara dalaman niat orang lain.

Agüera y Arcas berkata: "Model ini, yang tidak melakukan apa-apa selain meramalkan urutan, telah membangunkan pelbagai kebolehan yang luar biasa, termasuk teori fikiran

Tetapi dia mengakui bahawa model ini terdedah kepada kesilapan. , dan dia tidak pasti menukar skala sahaja sudah cukup untuk membuat inferens yang boleh dipercayai, walaupun nampaknya perlu

Blaise Agüera y Arcas dari Google Research memblog tentang perbualannya dengan LaMDA, nampaknya ini adalah pertukaran yang mengagumkan untuk dapat memodelkan secara konsisten apa yang diketahui dan tidak diketahui oleh dua lawan bicara dalam cerita, yang jelas merupakan parodi teori fikiran >

Namun, Chollet berkata walaupun LLM mendapat jawapan yang betul, tiada persefahaman yang terlibat

“Apabila anda menyelidikinya sedikit, anda akan melihat ia kosong ChatGPT tidak mempunyainya pertunjukan boneka dan percaya bahawa boneka itu masih hidup."

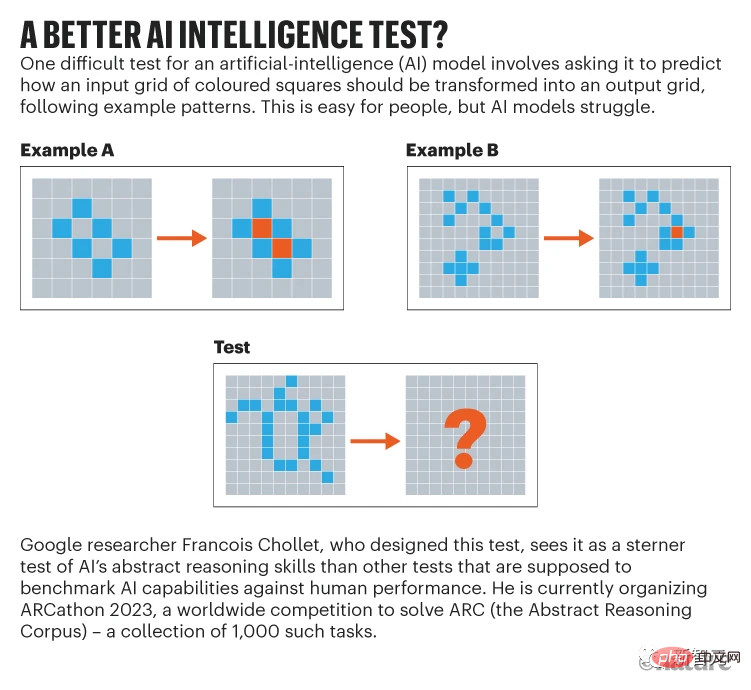

Setakat ini, LLM masih melakukan kesilapan yang tidak masuk akal yang tidak akan dilakukan oleh manusia, kata Melanie Mitchell. Dia mengkaji abstraksi dan analogi konsep dalam sistem kecerdasan buatan di Institut Santa Fe.

Ini menimbulkan kebimbangan sama ada selamat untuk melepaskan LLM ke dalam masyarakat tanpa pagar.

Mitchell menambah bahawa satu kesukaran sama ada LLM boleh menyelesaikan masalah yang benar-benar baharu dan tidak kelihatan ialah kami tidak dapat menguji sepenuhnya keupayaan ini.

Masalah disebabkan skala

Tetapi masalahnya ialah set data, kuasa pengkomputeran dan Kos mengehadkan pembangunannya. Pada masa ini, hanya syarikat yang mempunyai sumber pengkomputeran yang sangat besar boleh melakukan ini.

Sebagai contoh, OpenAI dijangka membelanjakan lebih daripada 4 juta dolar AS untuk latihan GPT-3, dan mungkin menelan belanja berjuta-juta dolar setiap bulan untuk mengekalkan operasi ChatGPT.

Hasilnya, kerajaan dari pelbagai negara telah mula campur tangan, dengan harapan dapat mengembangkan kelebihan mereka dalam bidang ini.

Namun, tidak kira siapa yang melakukan latihan, penggunaan kuasa LLM tidak boleh dipandang rendah.

Google berkata bahawa latihan PaLM mengambil masa kira-kira 3.4 gigawatt jam selama kira-kira dua bulan, yang bersamaan dengan penggunaan tenaga kira-kira 300 rumah A.S. selama setahun.

Walaupun Google mendakwa bahawa 89% daripada penggunaannya adalah tenaga bersih, tinjauan terhadap keseluruhan industri menunjukkan bahawa kebanyakan latihan menggunakan grid kuasa terutamanya dikuasakan oleh bahan api fosil.

Lebih kecil, lebih bijak?

Dari perspektif ini, penyelidik perlu segera mengurangkan penggunaan tenaga LLM - menjadikan rangkaian saraf lebih kecil, lebih cekap dan mungkin lebih pintar.

Selain kos tenaga latihan LLM (walaupun penting, ia juga sekali sahaja), tenaga yang diperlukan untuk inferens akan meningkat apabila bilangan pengguna bertambah. Sebagai contoh, model BLOOM menjawab sejumlah 230,768 pertanyaan dalam 18 hari ia digunakan pada Google Cloud Platform, dengan purata kuasa 1,664 watt.

Sebagai perbandingan, otak kita sendiri jauh lebih kompleks dan lebih besar daripada mana-mana LLM, dengan 86 bilion neuron dan kira-kira 100 trilion sambungan sinaptik, tetapi hanya kira-kira 20 hingga 50 watt kuasa .

Hasilnya, sesetengah penyelidik berharap dapat merealisasikan visi untuk menjadikan model lebih kecil, lebih pintar dan lebih cekap dengan meniru otak.

Pada asasnya, LLM ialah rangkaian "suapan", yang bermaksud bahawa maklumat mengalir dalam satu arah: dari input, melalui lapisan LLM, ke hujung output.

Tetapi itu tidak berlaku dengan otak. Sebagai contoh, dalam sistem visual manusia, selain penghantaran maklumat yang diterima ke hadapan ke dalam otak, neuron juga mempunyai sambungan maklum balas yang membolehkan maklumat dihantar ke arah yang bertentangan antara neuron. Mungkin terdapat sepuluh kali lebih banyak sambungan maklum balas berbanding sambungan suapan hadapan.

Dalam rangkaian saraf tiruan, Rangkaian Neural Berulang (RNN) juga mengandungi kedua-dua sambungan suapan dan maklum balas. Tidak seperti LLM, yang hanya mempunyai rangkaian suapan hadapan, RNN boleh membezakan corak dalam data dari semasa ke semasa. Walau bagaimanapun, RNN sukar untuk dilatih dan perlahan, menjadikannya sukar untuk menskalakannya kepada skala LLM.

Pada masa ini, beberapa kajian menggunakan set data kecil telah menunjukkan bahawa RNN dengan neuron spiking boleh mengatasi RNN standard dan secara teorinya lebih cekap dari segi pengiraan daripada tiga urutan magnitud.

Walau bagaimanapun, selagi rangkaian spiking tersebut disimulasikan dalam perisian, mereka tidak dapat benar-benar mencapai peningkatan dalam kecekapan (kerana perkakasan yang mensimulasikannya masih menggunakan tenaga).

Sementara itu, penyelidik sedang bereksperimen dengan kaedah yang berbeza untuk menjadikan LLM sedia ada lebih cekap tenaga.

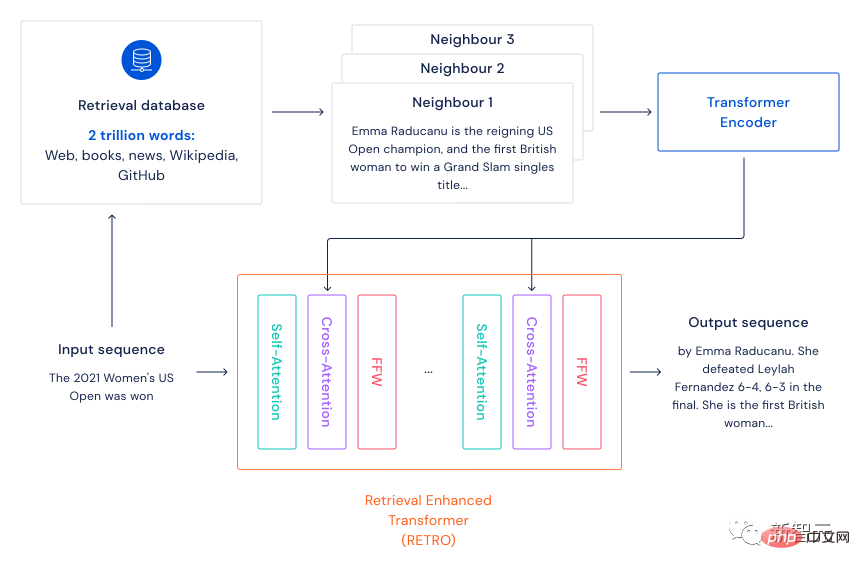

Pada Disember 2021, DeepMind mencadangkan rangka kerja model bahasa berasaskan pengambilan Retro.

Retro terutamanya meniru mekanisme otak yang bukan sahaja menggunakan pengetahuan semasa tetapi juga mendapatkan ingatan semasa belajar. Rangka kerjanya adalah untuk terlebih dahulu menyediakan set data teks berskala besar (bertindak sebagai ingatan otak), dan menggunakan algoritma kNN untuk mencari n ayat jiran terdekat bagi ayat input (ingatan perolehan).

Selepas mengekodkan ayat input dan ayat yang diambil melalui Transformer, Cross-Attention kemudiannya dilakukan, supaya model boleh menggunakan maklumat dalam ayat input dan maklumat memori secara serentak untuk menyelesaikan pelbagai tugas NLP.

Sebilangan besar parameter dalam model sebelumnya adalah untuk mengekalkan maklumat dalam data latihan Apabila rangka kerja berasaskan pengambilan ini digunakan, bilangan parameter model tidak perlu terlalu besar, lebih banyak maklumat teks boleh disertakan, yang secara semula jadi akan mempercepatkan model tanpa kehilangan terlalu banyak prestasi.

Kaedah ini juga boleh menjimatkan bil elektrik semasa latihan model Gadis-gadis mesra alam menyukainya selepas melihatnya!

Hasil eksperimen menunjukkan bahawa model bahasa yang besar dengan 7.5 bilion parameter, serta pangkalan data 2 trilion token, boleh mengatasi model dengan 25 kali lebih parameter. Para penyelidik menulis bahawa ini adalah "pendekatan yang lebih cekap daripada penskalaan parameter mentah kerana kami berusaha untuk membina model bahasa yang lebih berkuasa."

Pada bulan yang sama, penyelidik di Google mencadangkan cara lain untuk meningkatkan kecekapan tenaga pada skala.

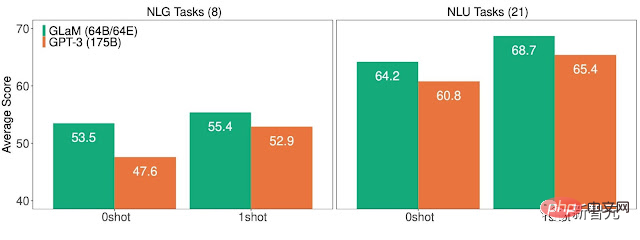

Model bahasa umum GLaM yang jarang ini dengan 1.2 trilion parameter mempunyai 64 rangkaian saraf yang lebih kecil secara dalaman.

Semasa proses inferens, model hanya menggunakan dua rangkaian untuk menyelesaikan tugasan. Dalam erti kata lain, hanya kira-kira 8% daripada lebih daripada satu trilion parameter digunakan.

Google berkata bahawa GLaM menggunakan sumber pengkomputeran yang sama seperti yang diperlukan untuk melatih GPT-3, tetapi disebabkan penambahbaikan dalam perisian dan perkakasan latihan, penggunaan tenaga hanya 1/3 daripada yang terakhir. Sumber pengkomputeran yang diperlukan untuk inferens adalah separuh daripada sumber GPT-3. Selain itu, GLaM juga berprestasi lebih baik daripada GPT-3 apabila dilatih pada jumlah data yang sama.

Walau bagaimanapun, untuk penambahbaikan selanjutnya, malah LLM yang lebih cekap tenaga ini nampaknya ditakdirkan untuk menjadi lebih besar, menggunakan lebih banyak data dan pengiraan.

Rujukan:

https://www.nature.com/articles/d41586-023-00641-w

Atas ialah kandungan terperinci Alam Semula Jadi: Adakah model AI yang lebih besar lebih baik?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI