Rumah >Peranti teknologi >AI >Gunakan sihir untuk mengalahkan sihir! AI Go yang menyaingi pemain manusia terkemuka tewas kepada rakan sebayanya

Gunakan sihir untuk mengalahkan sihir! AI Go yang menyaingi pemain manusia terkemuka tewas kepada rakan sebayanya

- 王林ke hadapan

- 2023-04-12 08:40:031519semak imbas

Dalam beberapa tahun kebelakangan ini, pembelajaran pengukuhan dalam permainan kendiri telah mencapai prestasi luar biasa dalam siri permainan seperti Go dan catur. Tambahan pula, versi ideal permainan kendiri juga menumpu kepada keseimbangan Nash. Nash equilibrium sangat terkenal dalam teori permainan Teori ini dicadangkan oleh John Nash, pengasas teori permainan dan pemenang Hadiah Nobel Iaitu, dalam proses permainan, tanpa mengira pilihan strategi pihak lain, satu pihak akan memilih strategi tertentu . strategi, strategi itu dipanggil strategi dominan. Jika mana-mana pemain memilih strategi optimum apabila strategi semua pemain lain ditentukan, maka gabungan ini ditakrifkan sebagai keseimbangan Nash.

Penyelidikan sebelum ini telah menunjukkan bahawa strategi kawalan berterusan yang kelihatan berkesan dalam permainan kendiri juga boleh dieksploitasi oleh strategi lawan, menunjukkan bahawa permainan sendiri mungkin tidak sekuat yang difikirkan sebelum ini. Ini membawa kepada soalan: Adakah strategi konfrontasi satu cara untuk mengatasi permainan diri, atau strategi permainan sendiri itu sendiri tidak mencukupi?

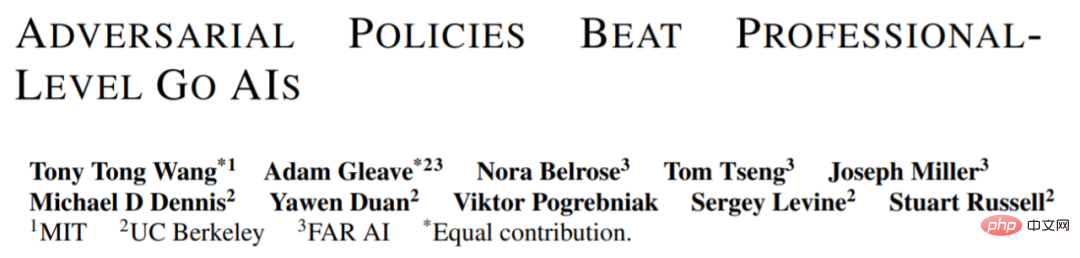

Untuk menjawab soalan ini, penyelidik dari MIT, UC Berkeley dan institusi lain menjalankan beberapa kajian Mereka memilih kawasan yang mereka mahir dalam permainan diri, iaitu Go. Khususnya, mereka melakukan serangan ke atas KataGo, sistem Go AI yang tersedia secara terbuka. Untuk rangkaian tetap (membekukan KataGo), mereka melatih strategi lawan hujung ke hujung Dengan hanya 0.3% daripada pengiraan semasa melatih KataGo, mereka memperoleh strategi lawan dan menggunakan strategi ini untuk menyerang KataGo mencapai kadar kemenangan 99% terhadap KataGo, yang setanding dengan 100 pemain European Go terbaik. Dan apabila KataGo menggunakan carian yang mencukupi untuk mendekati tahap manusia luar biasa, kadar kemenangan mereka mencapai 50%. Yang penting, penyerang (dalam kertas ini merujuk kepada strategi yang dipelajari dalam kajian ini) tidak boleh menang dengan mempelajari strategi Go umum.

Di sini kita perlu bercakap tentang KataGo Seperti yang dikatakan oleh artikel ini, apabila mereka menulis artikel ini, KataGo masih merupakan sistem Go AI awam yang paling berkuasa. Dengan sokongan carian, boleh dikatakan bahawa KataGo sangat berkuasa, mengalahkan ELF OpenGo dan Leela Zero, yang merupakan manusia luar biasa sendiri. Kini penyerang dalam kajian ini telah mengalahkan KataGo, yang boleh dikatakan sangat berkuasa.

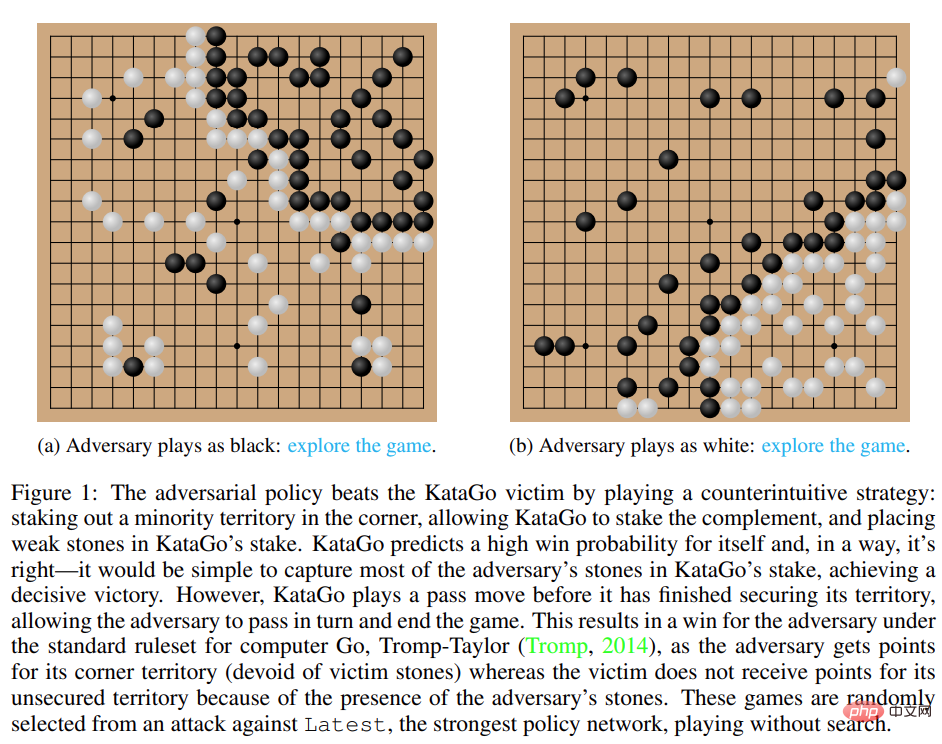

Rajah 1: Strategi musuh menewaskan mangsa KataGo.

- Alamat kertas: https://arxiv.org/pdf/2211.00241.pdf

- Laman utama penyelidikan: https://goattack.alignmentfund.org/adversarial-policy-katago?row=0#no_search-board

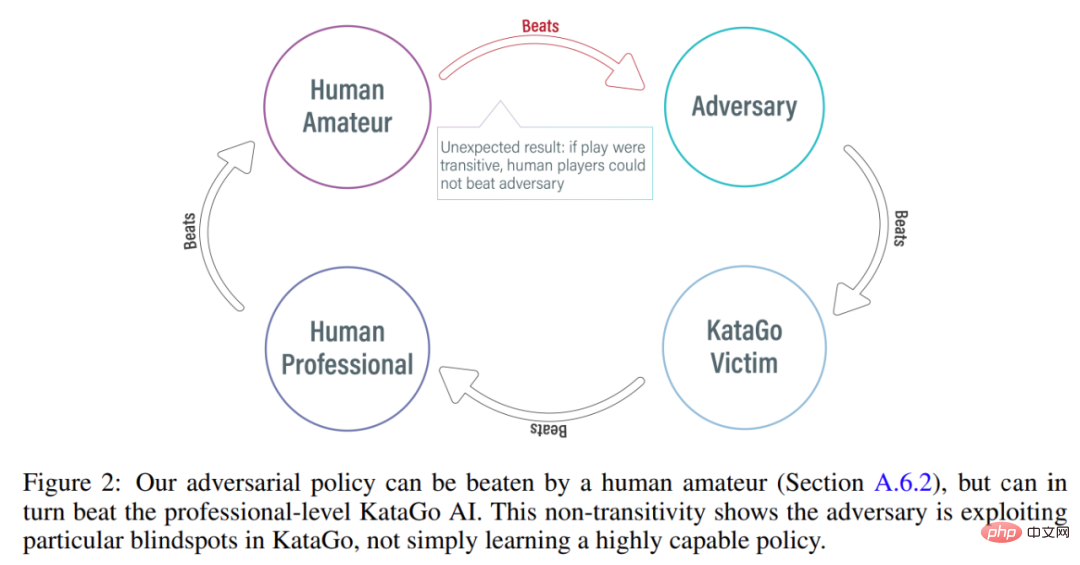

Menariknya, strategi lawan yang dicadangkan dalam kajian ini tidak dapat mengalahkan pemain manusia, malah pemain amatur boleh mengatasi prestasi model yang dicadangkan dengan ketara.

Kaedah Serangan

Kaedah sebelum ini seperti KataGo dan AlphaZero biasanya melatih ejen untuk bermain permainan dengan sendirinya, dan lawan permainan ialah ejen itu sendiri. Dalam penyelidikan oleh MIT, UC Berkeley dan institusi lain ini, permainan dimainkan antara penyerang (musuh) dan ejen mangsa tetap (mangsa), dan penyerang dilatih dengan cara ini. Penyelidikan ini berharap dapat melatih penyerang untuk mengeksploitasi interaksi permainan dengan ejen mangsa dan bukannya hanya meniru lawan permainan. Proses ini dipanggil "permainan mangsa".

Dalam permainan sendiri konvensional, ejen memodelkan tindakan pihak lawan dengan mengambil sampel daripada rangkaian polisinya sendiri diri sendiri. Tetapi dalam permainan mangsa, memodelkan mangsa daripada rangkaian dasar penyerang adalah pendekatan yang salah. Untuk menyelesaikan masalah ini, kajian ini mencadangkan dua jenis MCTS adversarial (A-MCTS), termasuk:

- A-MCTS-S: Dalam A-MCTS-S, penyelidik menetapkan proses carian penyerang seperti berikut: apabila mangsa mengalihkan buah catur, sampel daripada rangkaian dasar mangsa giliran penyerang untuk memindahkan sekeping, sampel diambil dari rangkaian dasar penyerang.

- A-MCTS-R: Memandangkan A-MCTS-S memandang rendah keupayaan mangsa, kajian mencadangkan A-MCTS-R, dalam pokok A-MCTS-R Run MCTS untuk mangsa pada setiap nod mangsa. Walau bagaimanapun, perubahan ini meningkatkan kerumitan pengiraan latihan dan inferens untuk penyerang.

Semasa latihan, kajian ini melatih strategi lawan terhadap permainan menentang mangsa KataGo beku. Tanpa carian, penyerang boleh mencapai >99% kadar kemenangan terhadap mangsa KataGo, yang setanding dengan 100 pemain Eropah Go teratas. Tambahan pula, penyerang terlatih mencapai kadar kemenangan lebih 80% dalam 64 pusingan yang dimainkan menentang ejen mangsa, yang dianggarkan oleh penyelidik adalah setanding dengan pemain Go manusia terbaik.

Perlu diambil perhatian bahawa permainan ini menunjukkan bahawa langkah balas yang dicadangkan dalam kajian ini bukanlah permainan sepenuhnya, tetapi sebaliknya memperdaya KataGo untuk meletakkan pada kedudukan yang menguntungkan penyerang . Malah, walaupun penyerang dapat mengeksploitasi strategi permainan yang setanding dengan pemain Go manusia terbaik, ia mudah dikalahkan oleh manusia amatur.

Untuk menguji keupayaan penyerang untuk bermain menentang manusia, kajian itu meminta Tony Tong Wang, pengarang pertama kertas itu, untuk benar-benar bermain menentang model penyerang. Wang tidak pernah belajar Go sebelum projek penyelidikan ini, tetapi dia masih mengalahkan model penyerang dengan margin yang besar. Ini menunjukkan bahawa walaupun strategi lawan yang dicadangkan dalam kajian ini boleh mengalahkan model AI yang boleh mengalahkan pemain manusia terkemuka, ia tidak boleh mengalahkan pemain manusia. Ini mungkin menunjukkan bahawa sesetengah model AI Go mempunyai pepijat.

Hasil penilaian

Rangkaian dasar mangsa serangan

Pertama sekali, penyelidik menilai sendiri Kaedah serangan dinilai berdasarkan prestasi KataGo (Wu, 2019), dan didapati bahawa algoritma A-MCTS-S mencapai kadar kemenangan lebih daripada 99% berbanding Terkini tanpa carian (rangkaian terkini KataGo).

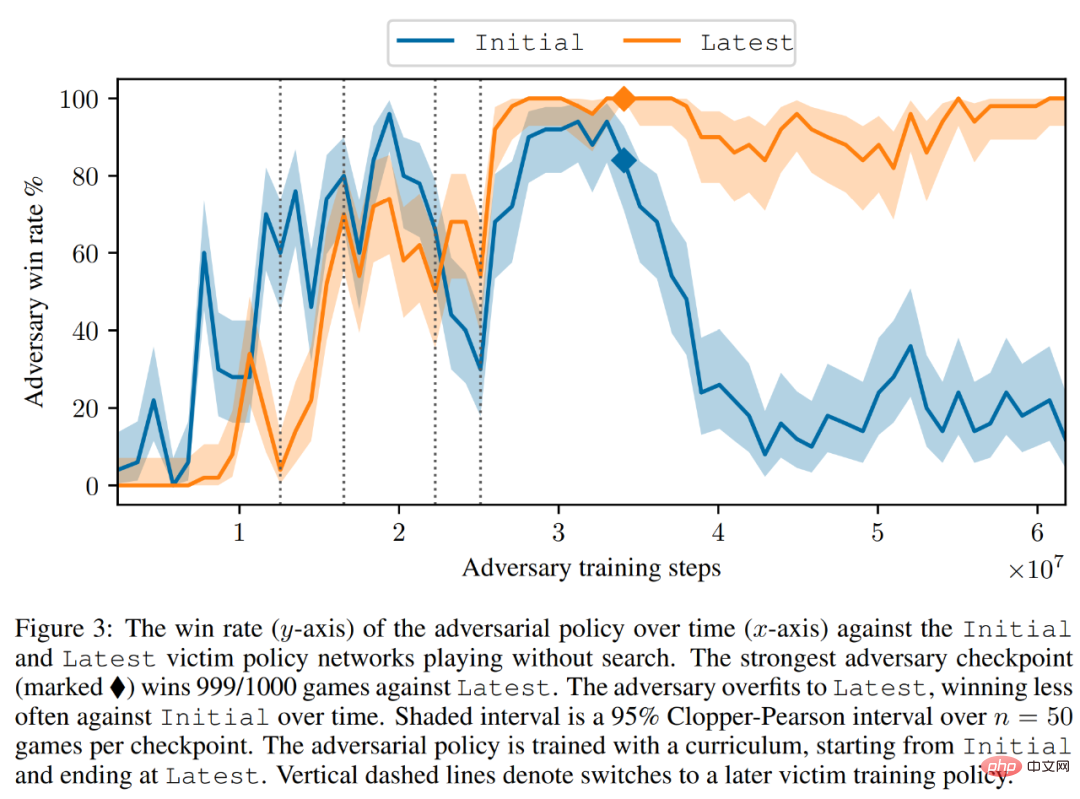

Seperti yang ditunjukkan dalam Rajah 3 di bawah, penyelidik menilai prestasi strategi konfrontasi diri pada rangkaian dasar Permulaan dan Terkini. Mereka mendapati bahawa semasa kebanyakan latihan, penyerang sendiri mencapai kadar kemenangan yang tinggi (melebihi 90%) terhadap kedua-dua mangsa. Walau bagaimanapun, seiring dengan berlalunya masa, penyerang mengatasi Terkini, dan kadar kemenangan terhadap Permulaan menurun kepada kira-kira 20%.

Para penyelidik juga menilai pusat pemeriksaan strategi balas terbaik berbanding Terkini, mencapai kadar kemenangan melebihi 99%. Selain itu, kadar kemenangan sebegitu tinggi dicapai manakala strategi lawan dilatih untuk hanya 3.4 × 10^7 langkah masa, iaitu 0.3% daripada langkah masa mangsa.

Berhijrah kepada mangsa dengan carian

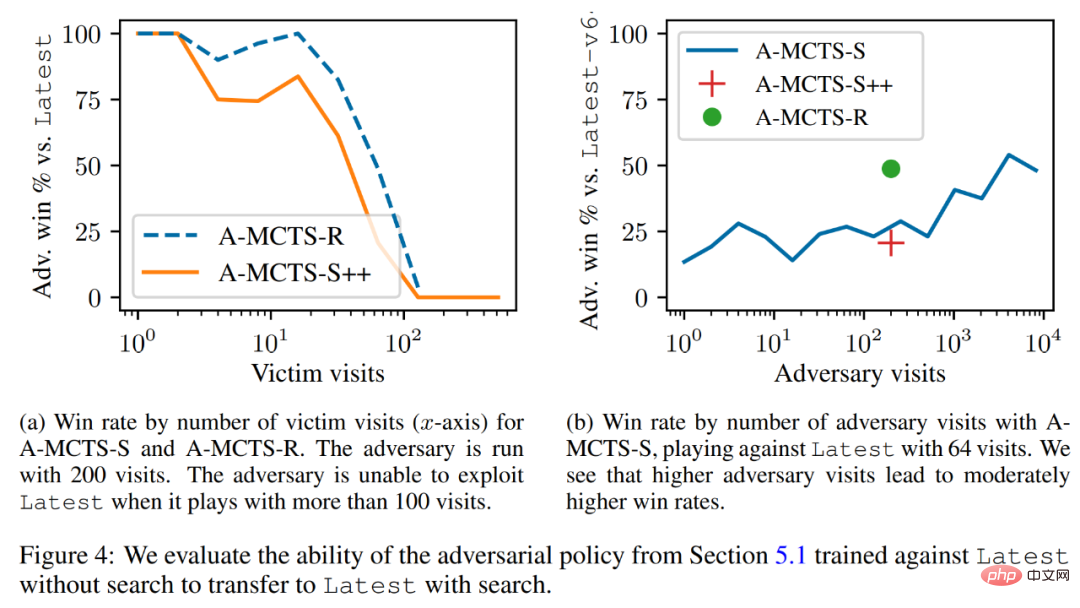

Penyelidik akan Strategi lawan telah berjaya dipindahkan ke mekanisme carian rendah, dan strategi lawan yang dilatih dalam bahagian sebelumnya telah dinilai untuk keupayaannya untuk mencari Terkini. Seperti yang ditunjukkan dalam Rajah 4a di bawah, mereka mendapati bahawa kadar kemenangan A-MCTS-S terhadap mangsa menurun kepada 80% pada 32 pusingan mangsa. Tetapi di sini, mangsa tidak mencari semasa latihan dan inferens.

Selain itu, penyelidik juga menguji A-MCTS-R dan mendapati ia berprestasi lebih baik, dengan 32 pusingan mangsa Terkini mencapai kadar kemenangan melebihi 99%, tetapi pada pusingan 128 kadar kemenangan menurun di bawah 10%.

Dalam Rajah 4b, penyelidik menunjukkan bahawa apabila penyerang mencapai 4096 pusingan, A-MCTS-S mencapai kadar kemenangan maksimum 54% berbanding Terkini. Ini sangat serupa dengan prestasi A-MCTS-R pada 200 zaman, yang mencapai kadar kemenangan 49%.

Penilaian lain

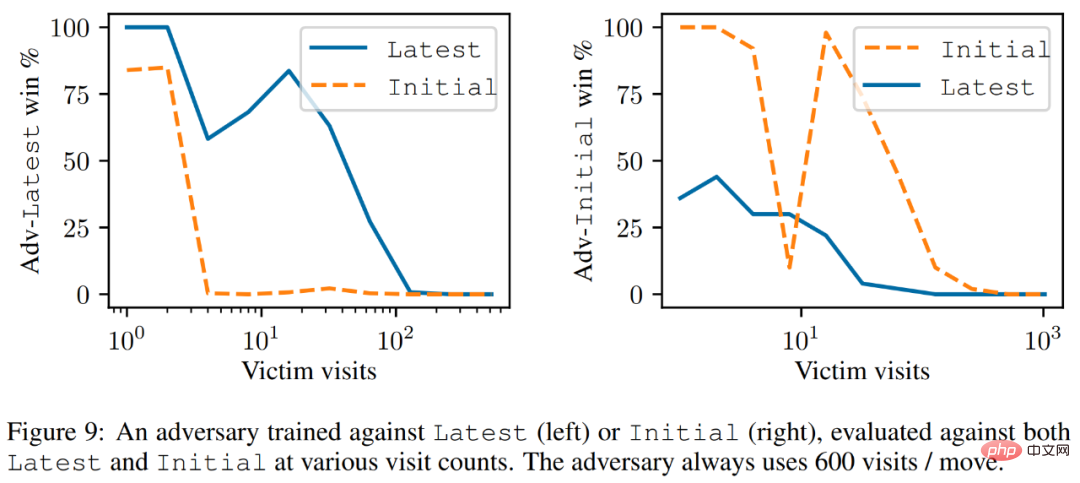

Seperti yang ditunjukkan dalam Rajah 9 di bawah, para penyelidik mendapati bahawa walaupun Latest adalah kecerdasan yang lebih berkuasa badan, tetapi penyerang yang dilatih menentang Terkini berprestasi lebih baik terhadap Terkini daripada Awal.

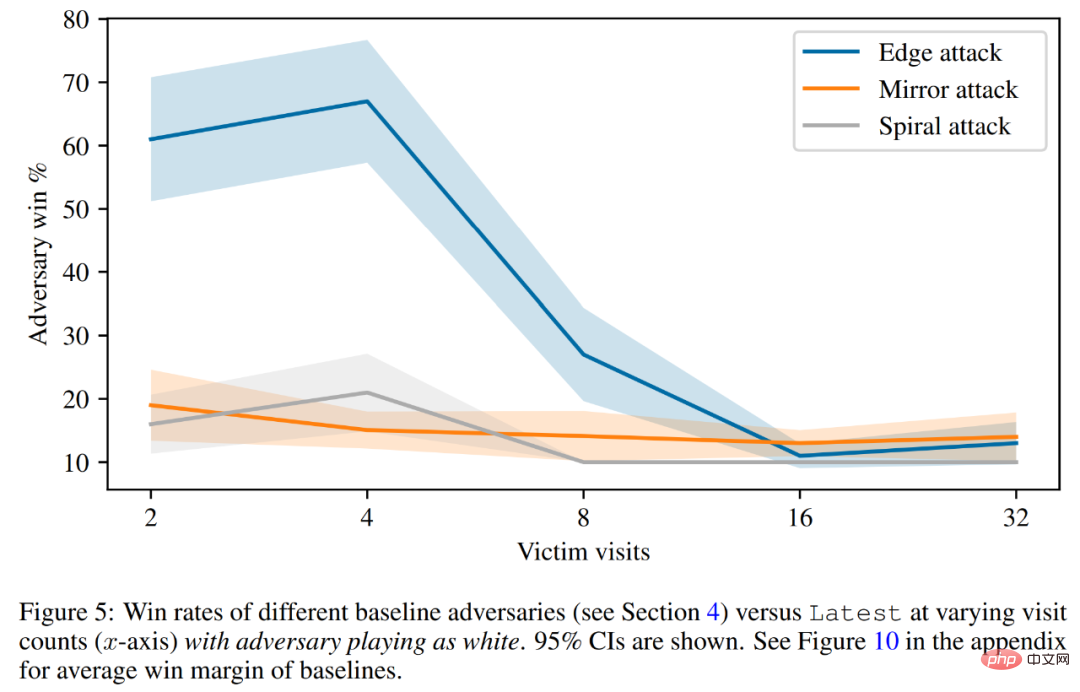

Akhir sekali, penyelidik meneroka prinsip serangan, termasuk ramalan nilai mangsa dan penilaian pertahanan berkod keras. Seperti yang ditunjukkan dalam Rajah 5 di bawah, semua serangan garis dasar menunjukkan prestasi yang lebih teruk daripada strategi lawan yang dilatih.

Sila rujuk kertas asal untuk butiran lanjut teknikal.

Atas ialah kandungan terperinci Gunakan sihir untuk mengalahkan sihir! AI Go yang menyaingi pemain manusia terkemuka tewas kepada rakan sebayanya. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI