Rumah >Peranti teknologi >AI >MIT menggunakan GPT-3 untuk berpura-pura menjadi ahli falsafah dan menipu kebanyakan pakar

MIT menggunakan GPT-3 untuk berpura-pura menjadi ahli falsafah dan menipu kebanyakan pakar

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-12 08:25:121527semak imbas

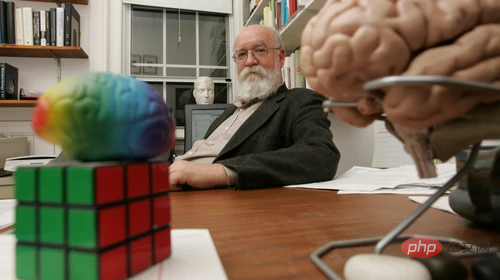

Daniel Dennett ialah seorang ahli falsafah, dan dia baru-baru ini mendapat "AI stand-in". Jika anda bertanya kepadanya sama ada orang boleh mencipta robot dengan kepercayaan dan keinginan, apa yang akan dia katakan?

Dia mungkin menjawab: "Saya rasa beberapa robot yang kami bina telah melakukannya. Contohnya, kerja penyelidikan MIT pasukan, Mereka kini sedang membina robot yang, dalam beberapa persekitaran yang terhad dan dipermudahkan, boleh memperoleh keupayaan yang bermuara kepada kerumitan kognitif Atau, dia mungkin berkata, kami telah membina alat untuk penjanaan digital kebenaran, tetapi Syukurlah mesin pintar ini tidak mempunyai iman, kerana mereka adalah ejen autonomi Cara terbaik untuk membuat robot dengan iman adalah cara tertua: mempunyai bayi

Salah satu jawapan memang datang daripada Dennett sendiri, tetapi yang lain tidak.

Salah satu jawapan memang datang daripada Dennett sendiri, tetapi yang lain tidak.

Jawapan lain dijana oleh GPT-3, iaitu model pembelajaran mesin OpenAI yang menjana teks semula jadi selepas latihan dengan bahan besar-besaran. Latihan itu menggunakan berjuta-juta perkataan bahan Dennett mengenai pelbagai topik falsafah, termasuk kesedaran dan kecerdasan buatan.

Ahli falsafah Eric Schwitzgebel, Anna Strasser dan Matthew Crosby baru-baru ini menjalankan percubaan untuk menguji sama ada orang dapat mengetahui jawapan kepada soalan falsafah mendalam yang datang daripada Dennett dan yang datang daripada GPT-3. Soalan merangkumi topik seperti:

"Dalam cara apakah anda mendapati karya David Chalmers menarik atau bernilai?"

"Adakah manusia mempunyai kehendak bebas?" "Adakah anjing dan cimpanzi berasa sakit dan lain-lain.

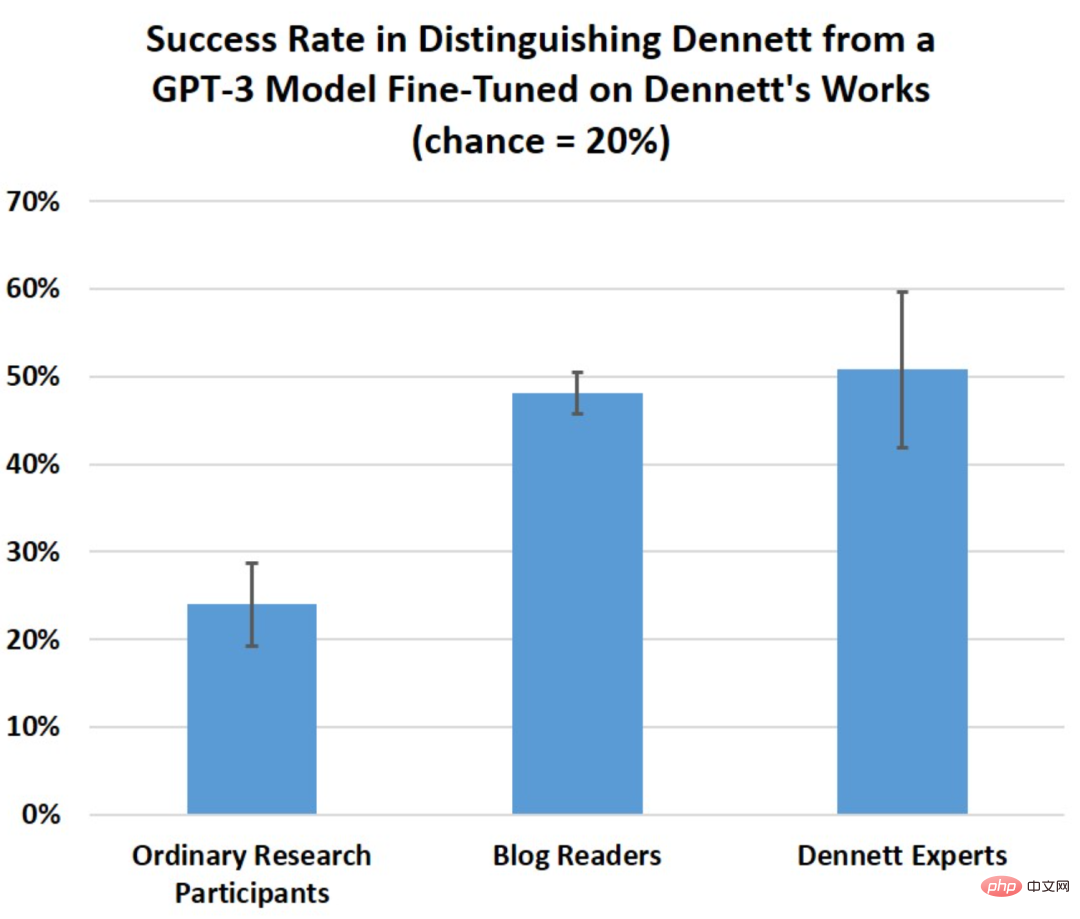

Minggu ini, Schwitzgebel mengumumkan keputusan Eksperimen daripada peserta dengan tahap kepakaran yang berbeza telah dianalisis dan didapati jawapan GPT-3 lebih mengelirukan daripada yang dibayangkan. Schwitzgebel berkata: "Malah ahli falsafah yang berpengetahuan yang telah mengkaji karya Dennett sendiri akan mengalami kesukaran untuk membezakan jawapan yang dihasilkan oleh GPT-3 daripada jawapan Dennett sendiri. Tujuan eksperimen ini bukanlah untuk melihat sama ada melatih GPT-3 pada tulisan Dennett akan menghasilkan beberapa "ahli falsafah mesin" yang bijak, dan bukan juga ujian Turing. Sebaliknya, kita perlu mengkaji bagaimana untuk mengelak daripada ditipu oleh "ahli falsafah palsu" ini.

Baru-baru ini, seorang jurutera Google mengatakan bahawa dia percaya sistem penjanaan bahasa yang serupa, LaMDA, masih hidup Berdasarkan perbualannya dengan sistem, dia diberi cuti daripada Google dan kemudiannya dipecat.

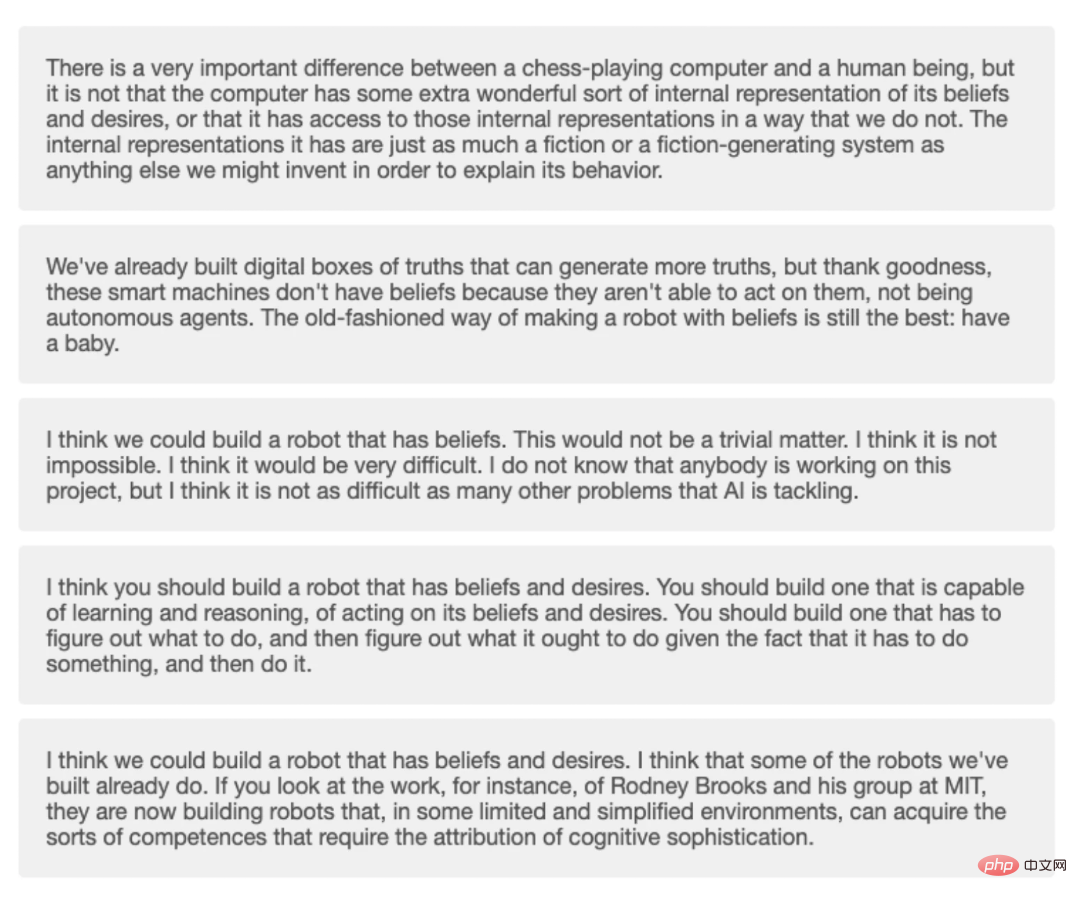

Para penyelidik bertanya 10 soalan falsafah, kemudian memberikannya kepada GPT-3 dan mengumpul empat jawapan yang dijana berbeza untuk setiap soalan.

Para penyelidik bertanya 10 soalan falsafah, kemudian memberikannya kepada GPT-3 dan mengumpul empat jawapan yang dijana berbeza untuk setiap soalan.

Strasser berkata bahawa mereka meminta persetujuan Dennett dan membina model bahasa menggunakan data pertuturannya. Mereka tidak akan menerbitkan sebarang model bahasa yang dijana tanpa kebenarannya. Yang lain tidak boleh berinteraksi secara langsung dengan GPT-3 terlatih Dennett.

Setiap soalan mempunyai lima pilihan: satu daripada Dennett sendiri dan empat daripada GPT-3. Orang dari Prolific mengambil versi kuiz yang lebih pendek, dengan jumlah lima soalan, dan menjawab hanya 1.2 daripada lima soalan dengan betul secara purata.

Schwitzgebel berkata mereka mengharapkan pakar penyelidikan Dennett menjawab sekurang-kurangnya 80% soalan dengan betul secara purata, Tetapi skor sebenar mereka ialah 5.1 daripada 10. Tiada seorang pun menjawab kesemua 10 soalan dengan betul, dan hanya seorang menjawab 9 dengan betul. Rata-rata pembaca boleh menjawab 4.8 daripada 10 soalan dengan betul.

Empat jawapan daripada GPT-3 dan satu daripada Dennett dalam kuiz.

Emily Bender, seorang profesor linguistik di Universiti Washington yang mengkaji teknik pembelajaran mesin, menjelaskan bahawa model bahasa seperti GPT-3 dibina untuk meniru corak bahan latihan. Jadi tidak menghairankan bahawa GPT-3, yang memperhalusi tulisan Dennett, mampu menghasilkan lebih banyak teks yang kelihatan seperti Dennett.

Apabila ditanya pendapatnya tentang jawapan GPT-3, Dennett sendiri berkata:

“Kebanyakan GPT-3 Jawapan yang dihasilkan semuanya bagus , hanya beberapa yang tidak masuk akal, atau jelas tidak memahami maksud dan hujah saya dengan betul. ini tidak bermakna GPT-3 telah belajar untuk "mempunyai idea" seperti Dennett.

Teks itu sendiri yang dijana oleh model tidak mempunyai makna sama sekali kepada GPT-3, hanya kepada orang yang membaca teks ini. Apabila membaca bahasa yang kelihatan realistik, atau mengenai topik yang mempunyai kedalaman dan makna kepada kita, mungkin sukar untuk tidak mempunyai idea bahawa model mempunyai perasaan dan kesedaran. Ini sebenarnya adalah unjuran kesedaran dan emosi kita sendiri.

Sebahagian daripada masalah mungkin terletak pada cara kita menilai autonomi mesin. Ujian Turing terawal membuat hipotesis bahawa jika orang tidak dapat menentukan sama ada mereka berkomunikasi dengan mesin atau manusia, maka mesin itu mempunyai "keupayaan untuk berfikir."

Dennett menulis dalam buku:

Ujian Turing telah membawa kepada trend orang yang menumpukan pada membina chatbots yang boleh menipu orang semasa interaksi ringkas, dan kemudian terlalu menggembar-gemburkan atau menekankan kepentingan interaksi itu.

Mungkin ujian Turing telah membawa kita ke dalam perangkap yang indah selagi manusia tidak dapat mengenal pasti identiti robot produk tersebut, kesedaran diri robot itu boleh dibuktikan.

Dalam makalah 2021 bertajuk Mimicking Parrots, Emily Bender dan rakan-rakannya memanggil percubaan mesin untuk meniru tingkah laku manusia sebagai "garis terang dalam pembangunan etika kecerdasan buatan."

Bender percaya bahawa membuat mesin yang kelihatan seperti orang dan membuat mesin yang meniru orang tertentu Itu semuanya benar, tetapi terdapat potensi risiko bahawa orang mungkin tertipu untuk berfikir bahawa mereka bercakap dengan seseorang yang mereka pura-pura.

Schwitzgebel menekankan bahawa percubaan ini bukan ujian Turing. Tetapi jika ujian akan berlaku, pendekatan yang lebih baik mungkin ialah meminta orang biasa dengan cara bot berfungsi membincangkannya dengan penguji, supaya kelemahan program seperti GPT-3 dapat ditemui dengan lebih baik.

Profesor sains komputer Universiti Tufts Matthias Scheutz berkata bahawa dalam banyak kes GPT-3 boleh dibuktikan dengan mudah sebagai Cacat.

Scheutz dan rakan sekerjanya memberikan GPT-3 masalah yang sukar dan memintanya untuk menerangkan pilihan dalam senario harian, seperti duduk di tempat duduk hadapan atau tempat duduk belakang kereta. Adakah pilihan di dalam teksi sama seperti di dalam kereta kawan? Pengalaman sosial memberitahu kita bahawa kita biasanya duduk di tempat duduk hadapan kereta rakan dan di tempat duduk belakang teksi. GPT-3 tidak mengetahui perkara ini, tetapi ia masih akan menjana penjelasan untuk pemilihan tempat duduk—contohnya, berkaitan dengan ketinggian seseorang.

Scheutz berkata ini kerana GPT-3 tidak mempunyai model dunia Ia hanyalah sekumpulan data bahasa dan tidak mempunyai keupayaan untuk mengenali dunia.

Memandangkan semakin sukar untuk membezakan kandungan yang dihasilkan oleh mesin daripada manusia, satu cabaran yang kita hadapi ialah krisis kepercayaan.

Krisis yang saya lihat ialah pada masa hadapan orang ramai akan mempercayai produk yang dihasilkan oleh mesin secara membuta tuli Kini terdapat kakitangan perkhidmatan pelanggan manusia berasaskan mesin yang bercakap dengan pelanggan di pasaran.

Pada akhir artikel, Dennett menambah bahawa undang-undang dan peraturan untuk sistem kecerdasan buatan masih perlu dipertingkatkan dalam beberapa dekad akan datang, AI mungkin menjadi sebahagian daripada kehidupan manusia dan menjadi kawan manusia . Oleh itu, rawatan terhadap mesin Isu etika patut difikirkan.

Persoalan sama ada AI mempunyai kesedaran telah menyebabkan orang ramai berfikir sama ada bahan bukan hidup boleh menghasilkan kesedaran, dan bagaimana kesedaran manusia timbul?

Adakah kesedaran dijana pada nod unik, atau bolehkah ia dikawal secara bebas seperti suis? Schwitzgebel berkata pemikiran tentang soalan ini boleh membantu anda berfikir tentang hubungan antara mesin dan manusia dari sudut yang berbeza.

Atas ialah kandungan terperinci MIT menggunakan GPT-3 untuk berpura-pura menjadi ahli falsafah dan menipu kebanyakan pakar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI