Rumah >Peranti teknologi >AI >Kajian berskala besar Meta tentang terjemahan bahasa, hasilnya semuanya 'rutin'

Kajian berskala besar Meta tentang terjemahan bahasa, hasilnya semuanya 'rutin'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 23:46:042044semak imbas

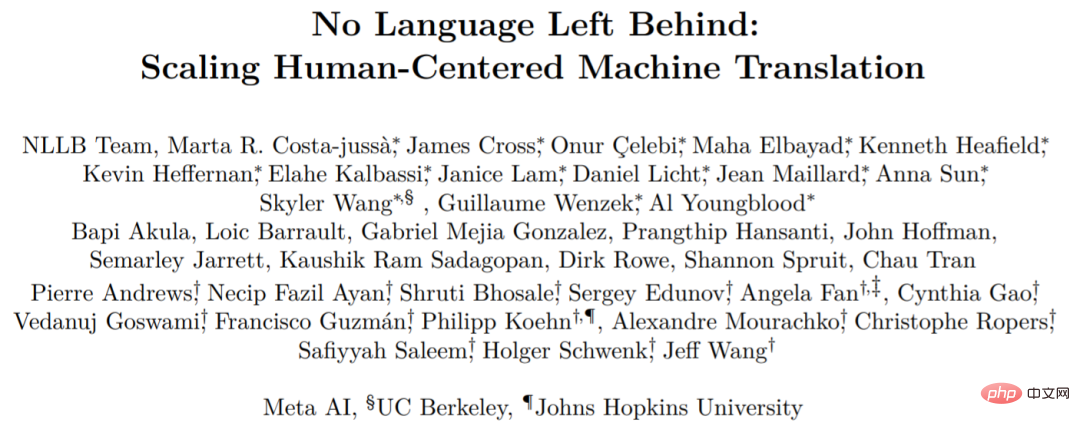

Pada awal Julai tahun ini, Meta AI mengeluarkan model terjemahan baharu yang dipanggil No Language Left Behind (NLLB), yang boleh kami terjemahkan secara literal sebagai "Tiada bahasa yang tertinggal."

Seperti namanya, NLLB boleh menyokong sebarang terjemahan antara 200+ bahasa, dan Meta AI juga telah menjadikannya sumber terbuka. Ia boleh menterjemah bahasa yang tidak pernah anda lihat sebelum ini, seperti Luganda, Urdu, dll.

- Alamat kertas: https://research.facebook.com/publications/no- language-left-behind/

- Alamat sumber terbuka: https://github.com/facebookresearch/fairseq/tree/nllb

Skeptik ialah saintis penyelidikan pemprosesan bahasa semula jadi Benjamin Marie, yang mahir dalam teknologi terjemahan. Apa yang dia persoalkan boleh diringkaskan sebagai Meta AI membandingkan spBLEU dan BLEU sebelah menyebelah.

Mengenai soalan ini, sesetengah penyelidik berkata: spBLEU ialah metrik yang munasabah, dengan syarat tiada ruang dalam teks ( Thai, dsb.). Tetapi membandingkan spBLEU dan BLEU pastinya tidak betul.

Mengenai soalan ini, sesetengah penyelidik berkata: spBLEU ialah metrik yang munasabah, dengan syarat tiada ruang dalam teks ( Thai, dsb.). Tetapi membandingkan spBLEU dan BLEU pastinya tidak betul.

Netizen Arle Lommel berkata sebagai balasan kepada Benjamin Marie: Ini adalah perkara yang bagus. Ini juga mengajar saya bahawa apabila ia berkaitan dengan penyelidikan pembelajaran mesin, kita harus berhati-hati dengan penyelidikan yang tidak mempunyai pengesahan. Apa yang anda dapati di sini menunjukkan bahawa masalah menjadi rumit apabila orang hanya merujuk kepada pecahan tanpa mengawal cara ia dihasilkan.

Netizen Arle Lommel berkata sebagai balasan kepada Benjamin Marie: Ini adalah perkara yang bagus. Ini juga mengajar saya bahawa apabila ia berkaitan dengan penyelidikan pembelajaran mesin, kita harus berhati-hati dengan penyelidikan yang tidak mempunyai pengesahan. Apa yang anda dapati di sini menunjukkan bahawa masalah menjadi rumit apabila orang hanya merujuk kepada pecahan tanpa mengawal cara ia dihasilkan.

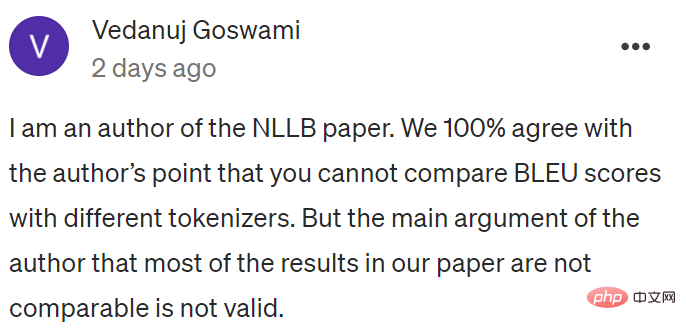

Vedanuj Goswami, salah seorang pengarang kertas kerja, berkata: “Kami 100% bersetuju dengan pengarang bahawa anda tidak boleh membahagikan Perbandingan skor BLEU dengan tokenizer yang berbeza Tetapi hujah utama penulis bahawa kebanyakan keputusan dalam kertas kerja kami tidak dapat dibandingkan dalam kertas kami, Jadual 30 dan Jadual 31 tidak boleh dibandingkan (FLORES-101 spm tokenizer), khusus untuk perbandingan kami tidak menggunakan FLORES-200 spm tokenizer Kami menerangkan ini secara terperinci dalam tajuk Jadual 30 dan dalam Bahagian 8.3.1 Begitu juga, Jadual 35, 36, 37. 38 semuanya menggunakan metrik/tokenizer yang setanding untuk perbandingan yang betul Kami telah mengemas kini kertas kerja

Vedanuj Goswami, salah seorang pengarang kertas kerja, berkata: “Kami 100% bersetuju dengan pengarang bahawa anda tidak boleh membahagikan Perbandingan skor BLEU dengan tokenizer yang berbeza Tetapi hujah utama penulis bahawa kebanyakan keputusan dalam kertas kerja kami tidak dapat dibandingkan dalam kertas kami, Jadual 30 dan Jadual 31 tidak boleh dibandingkan (FLORES-101 spm tokenizer), khusus untuk perbandingan kami tidak menggunakan FLORES-200 spm tokenizer Kami menerangkan ini secara terperinci dalam tajuk Jadual 30 dan dalam Bahagian 8.3.1 Begitu juga, Jadual 35, 36, 37. 38 semuanya menggunakan metrik/tokenizer yang setanding untuk perbandingan yang betul Kami telah mengemas kini kertas kerja

Secara keseluruhan, terjemahan mesin semasa Kaedah penilaian masih belum sempurna, dan kertas yang berbeza menggunakan kaedah yang berbeza.

Di bawah ini kami memperkenalkan perkara yang dipersoalkan oleh Benjamin Marie:

Penilaian kaedahnya cacat

Paul mempunyai 25 pisang dan Bill mempunyai 30 tomato. Adakah anda akan mengatakan bahawa Bill mempunyai 5 lebih banyak pisang daripada Paul?

BLEU macam pisang, spBLEU macam tomato. Gantikan Paul dengan Kerja sebelumnya dan Bill dengan NLLB. Kita kini boleh menulis sesuatu seperti ini:

Kerja sebelumnya dilakukan pada 25 BLEU dan NLLB pada 30 spBLEU. Adakah anda akan mengatakan NLLB adalah 5 mata BLEU lebih baik daripada kerja sebelumnya?

Dengan analogi di atas, kandungan berikut mungkin lebih mudah difahami.

Sebelum ini, Meta AI menerbitkan kertas kerja yang menerangkan dan menilai NLLB secara menyeluruh. Dalam abstrak kertas itu, mereka mendakwa bahawa model itu mencapai peningkatan BLEU sebanyak 44% berbanding kaedah SOTA sebelumnya. Dengan kata lain, NLLB akan menghasilkan keputusan yang lebih baik daripada kajian terdahulu.

Mengenai BLEU, jarang sekali dalam sejarah penyelidikan terjemahan mesin untuk melihat BLEU bertambah baik sebanyak 44% berbanding teknologi SOTA sebelumnya. Jadi ayat mudah dalam kertas ini mewakili kemajuan saintifik. Sesetengah media secara langsung melaporkan kenyataan ini dan, tanpa pengesahan lanjut, meletakkan Meta AI di bahagian atas terjemahan mesin bahasa.

Jika Meta AI memilih untuk menerbitkan kajian teknikal yang begitu besar, mereka harus memberikan bukti saintifik yang sangat boleh dipercayai. Jika tidak, dakwaan Meta AI untuk melakukan lebih baik daripada yang lain, tanpa sebarang bukti, hanya akan menjejaskan kerja keras yang telah dan sedang dilakukan oleh institusi penyelidikan lain.

Marie menerangkan masalah ralat NLLB dengan cuba menunjukkan cara Meta AI boleh disesatkan oleh keputusannya sendiri. Menggunakan contoh mudah daripada NLLB dan contoh serupa yang ditemuinya sendiri, Marie menunjukkan betapa mudahnya untuk melampaui SOTA apabila menggunakan kaedah penilaian NLLB yang cacat. Akhirnya, Marie mengenal pasti dan menerangkan secara khusus kesilapan utama dalam penilaian mereka.

Meta AI membandingkan modelnya dengan data daripada lebih 20 kajian terdahulu dan membuat kesimpulan bahawa NLLB jauh lebih baik daripada kajian terdahulu. Untuk menjadikan jumlah perbandingan yang begitu besar dapat dilaksanakan, mereka bergantung pada metrik penilaian automatik untuk penilaian terjemahan mesin, terutamanya BLEU dan spBLEU.

BLEU sangat popular dalam terjemahan mesin, walaupun terdapat kelemahan.

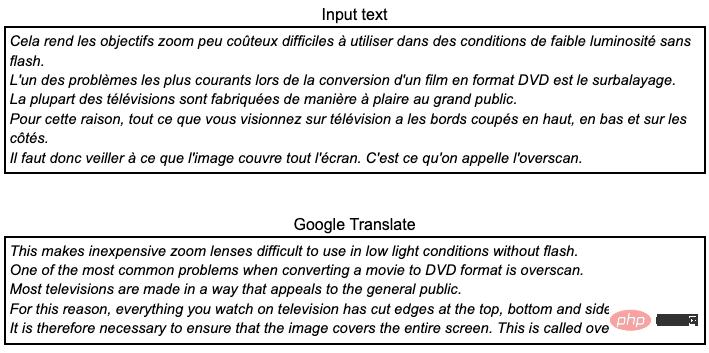

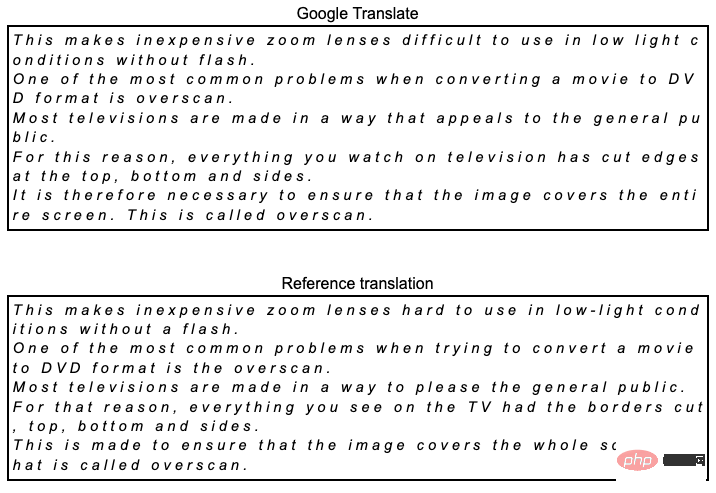

Sebagai contoh, kami ingin menterjemahkan teks Perancis berikut daripada set data FLORES101 ke dalam bahasa Inggeris menggunakan Terjemahan Google. Jika anda bertutur dalam bahasa Perancis, anda akan dapati bahawa ini adalah terjemahan yang tidak berkualiti: kesilapan tatabahasa, istilah yang tidak konsisten dan ia tidak dibaca secara semula jadi. Malah, memandangkan set data dicipta daripada bahasa Inggeris, Meta AI hanya menilai terjemahan mesin apabila menterjemah ke bahasa Inggeris.

Kita boleh membandingkannya dengan terjemahan rujukan dengan mengira berapa banyak token dalam Terjemahan Google yang turut terdapat dalam rujukan ini terjemahan Bandingkan. Token ditakrifkan di sini sebagai urutan aksara yang dipisahkan oleh ruang. Jingga menyerlahkan semua jujukan token dalam Terjemahan Google di atas yang muncul dalam terjemahan rujukan di bawah.

Memandangkan hanya semua token yang sepadan, skor BLEU boleh dikira menjadi 50.8 BLEU. Skor ini sahaja tidak bermakna, ia hanya masuk akal jika dibandingkan dengan skor BLEU yang lain.

Perkara utama yang perlu difahami di sini ialah skor dikira berdasarkan token, yang diabaikan dalam kebanyakan penyelidikan terjemahan mesin. Skor BLEU dikira menggunakan SacreBLEU, yang melakukan tokenisasi dalaman sendiri, pada asasnya hanya menambah ruang sebelum tanda baca. Ini adalah salah satu kaedah pengiraan markah BLEU yang paling boleh dipercayai dan boleh diulang. Meta AI menggunakan spBLEU.

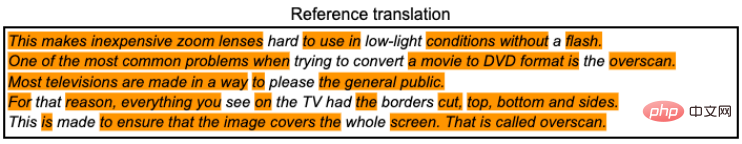

Jadi apa itu spBLEU? Ia adalah BLEU tetapi menggunakan tokenisasi yang berbeza. Ia menandakan Terjemahan Google dan terjemahan rujukan seperti berikut.

Token yang dikaitkan dengan spBLEU menjana token dengan memecahkan perkataan kepada kepingan yang lebih kecil (dilekatkan pada token Itu tidak penting di sini, cuba abaikan). Akibat langsung menggunakan tokenisasi spBLEU ialah kami mendapat lebih banyak token untuk kedua-dua terjemahan dan rujukan. Memandangkan terdapat lebih banyak token, kami boleh menjangkakan Terjemahan Google akan memadankan lebih banyak token daripada rujukan. Kemudian markah akan meningkat. Malah, skor spBLEU di sini ialah 54.8.

Kami tidak boleh tidak meminta 4 mata lebih tinggi daripada skor BLEU yang dikira di atas menggunakan tokenisasi dalaman SacreBLEU? Jadi adakah terjemahan menjadi lebih baik dan lebih baik?

Nampaknya tidak, terjemahannya tetap sama. Membandingkan BLEU dan spBLEU tidak masuk akal sama sekali. BLEU dan spBLEU mengendalikan Terjemahan Google dan terjemahan rujukan secara berbeza dan digunakan untuk tujuan penilaian sahaja. Mereka sebenarnya adalah penunjuk yang berbeza. Jika ia adalah penunjuk yang sama, kita tidak perlu menamakannya secara berbeza. Seperti yang sering kita baca dan dengar dalam komuniti penyelidikan terjemahan mesin, adalah tidak adil, malah tidak adil, untuk membandingkan kualiti terjemahan menggunakan skor BLEU yang dikira untuk token yang berbeza atau hampir serupa. Jika anda mahu penyelidikan anda boleh dipercayai secara saintifik, anda hanya perlu mengira skor BLEU anda secara konsisten menggunakan tokenisasi yang sama.

Meta AI mendakwa bahawa NLLB jauh lebih baik daripada kajian terdahulu kerana mereka sentiasa boleh mencapai skor spBLEU yang lebih baik daripada skor BLEU yang diterbitkan sebelum ini, sebaliknya adalah benar. Kerana mendapatkan skor spBLEU lebih rendah daripada skor BLEU untuk terjemahan tertentu adalah tugas yang amat sukar. Lebih sukar difahami ialah mengapa tidak menggunakan metrik chrBLEU sahaja jika matlamat mereka adalah untuk mendapatkan markah tertinggi.

Contohnya dalam Terjemahan Google dan Terjemahan Rujukan setiap aksara menjadi token iaitu ruang ditambah antara aksara).

Kemudian kami mengira nilai chrBLEU menjadi 75.5, iaitu 20.7 mata lebih tinggi daripada spBLEU. Menurut penilaian NLLB, ini akan menjadi peningkatan ketara yang akan menjadi titik tinggi baharu untuk terjemahan mesin, manakala Terjemahan Google asal kekal tidak berubah.

Contoh ralat dalam kertas

Sekarang, mari kita lihat spesifik Contoh penilaian NLLB.

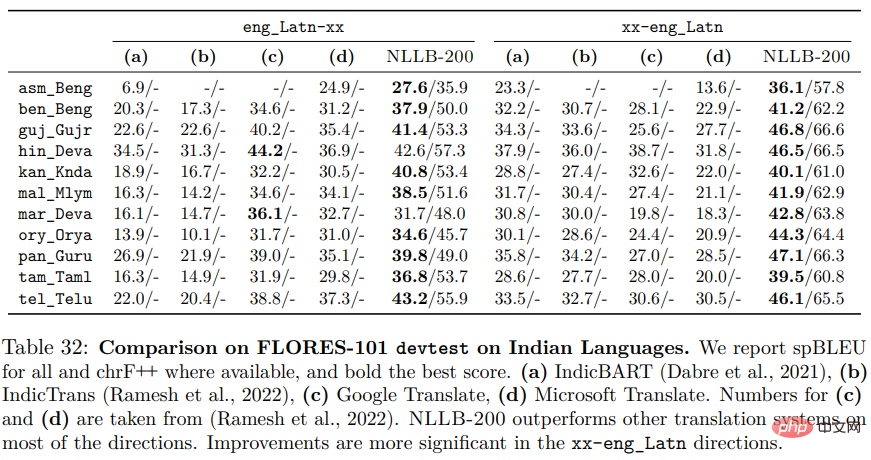

Meta AI mendakwa telah mengatasi prestasi sebelumnya dengan membandingkan bilangannya dengan angka yang diterbitkan sebelum ini. Dalam kertas ini, kesimpulan dibuat daripada Jadual 30, 31, 32, 35, 36, 37, dan 38, yang dibandingkan dengan kerja sebelumnya.

akan bermula dari jadual 32. Ini adalah salah satu contoh yang paling menggambarkan kerana pelbagai jenis ralat yang boleh berlaku.

Dari jadual, semua nombor kecuali lajur NLLB-200 disalin terus daripada kertas kerja yang diterbitkan sebelum ini IndicBART dan IndicTrans. Untuk kebolehbacaan, Meta AI menandakan markah tertinggi untuk setiap bahasa dalam huruf tebal, dengan lajur tebal menunjukkan sistem yang sepadan adalah yang terbaik.

Jadual menyatakan spBLEU untuk semua, yang mengelirukan. Sebenarnya, semua bermakna hanya NLLB-200, kerana IndicBART dan IndicTrans tidak menggunakan spBLEU tetapi BLEU. Walau bagaimanapun, apabila dibandingkan, didapati skor spBLEU NLLB adalah lebih tinggi daripada skor BLEU kerja sebelumnya. Tetapi adakah itu bermakna NLLB lebih baik? Adakah ini seperti 30 tomato lebih baik daripada 25 pisang?

Dalam teks yang menerangkan keputusan kita boleh lihat:

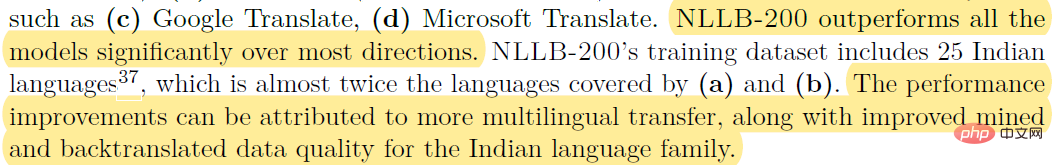

Untuk contoh (c) Terjemahan Google, (d) Terjemahan Microsoft. NLLB-200 dengan ketara mengatasi semua model dalam kebanyakan arah. Set data latihan untuk NLLB-200 termasuk 25 bahasa India, hampir dua kali lebih banyak daripada yang diliputi oleh (a) dan (b). Peningkatan prestasi boleh dikaitkan dengan lebih banyak penghantaran berbilang bahasa, serta kualiti data yang dipertingkatkan untuk perlombongan bahasa Indic dan terjemahan belakang.

Dalam erti kata lain, NLLB mempunyai lebih banyak tomato berbanding kajian sebelumnya yang mempunyai pisang. Jadi NLLB mempunyai lebih banyak pisang.

skor spBLEU lebih tinggi daripada skor BLEU kerana ia dikira pada token yang lebih kecil dan berbeza. Walau bagaimanapun, adakah NLLB menterjemah lebih baik? Kami langsung tidak boleh menjawab. Lebih memburukkan keadaan, IndicBART dan IndicTrans tidak dapat dibandingkan kerana kedua-duanya menggunakan dua kaedah token yang berbeza.

Kebanyakan jadual yang disenaraikan di atas mempunyai masalah yang sama dan mempunyai lebih kurang ralat.

Jika anda melihat kertas kerja yang diterbitkan oleh IndicBART dan IndicTrans untuk menyemak nombor, anda akan melihat bahawa terdapat isu lain. Lajur (a, b) dalam Jadual 32 semuanya ditukar, nombor IndicBART ialah nombor dalam indicatrans dan sebaliknya.

Jika anda lihat jadual 30, masalahnya lebih besar.  Walau bagaimanapun, Jadual 30 telah dikemas kini dalam kertas kerja, dan Benjamin Marie mengucapkan terima kasih kepada Vedanuj kerana mengemas kini artikel itu. Jadual 30 menyebut bahawa tokenizer adalah sama. Saya mengaku kesilapan saya.

Walau bagaimanapun, Jadual 30 telah dikemas kini dalam kertas kerja, dan Benjamin Marie mengucapkan terima kasih kepada Vedanuj kerana mengemas kini artikel itu. Jadual 30 menyebut bahawa tokenizer adalah sama. Saya mengaku kesilapan saya.

Seperti yang ditunjukkan dalam Jadual 32, Meta AI mendakwa bahawa NLLB adalah lebih baik daripada DeltaLM dan Deepnet sebelumnya, sambil membandingkan BLEU yang diperoleh menggunakan kaedah pengiraan yang berbeza Pecahan . Apa yang baru di sini ialah mereka juga membandingkan NLLB dengan kerja terdahulu mereka, M2M-100, juga dinilai menggunakan spBLEU. Jadi adakah perbandingan ini masuk akal? Tidak. Walaupun kedua-duanya menggunakan spBLEU, mereka sebenarnya menggunakan tokenizer yang berbeza, yang menjadikan perbandingan mustahil. Mereka membuat kenyataan berikut dalam nota kaki 28:

"Analisis kami menunjukkan bahawa apabila dilakukan pada bahasa FLORES-101 Apabila diukur, terdapat sedikit perbezaan antara SPM-200 FLORES-101 dan model SPM-100 FLORES-101 Kelebihan utama SPM-200 ialah ia merangkumi lebih daripada 200 bahasa 🎜>Perbezaan kecil juga . Dalam kes ini, perbezaan ini penting kerana kami sedang melakukan penyelidikan saintifik.

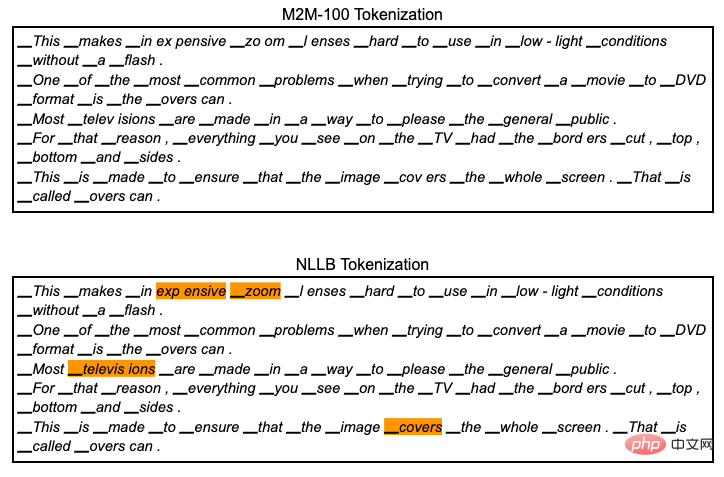

Satu kemajuan untuk NLLB berbanding kerja mereka pada M2M-100 ialah penambahan lebih banyak bahasa pada model dan set data. Ia termasuk model tokenisasi. Dari segi teknikal, jika anda menambah lebih banyak bahasa dengan sistem penulisan yang berbeza pada tokenizer ini sambil mengekalkan saiz perbendaharaan kata yang tetap, anda secara mekanikal akan mendapat perbendaharaan kata dengan token yang lebih kecil. Seperti yang dilihat di atas, menggunakan token yang lebih kecil boleh menghasilkan skor yang lebih baik. Mari sahkan.

Seperti yang ditunjukkan di bawah:

Tokenisasi ini menjana 95 token , manakala NLLB menjana 97 token. Ini hanyalah perbezaan halus, jika spBLEU dikira menggunakan tokenisasi M2M-100, skornya ialah 53.8, iaitu 1 mata lebih rendah daripada tokenisasi NLLB. Menurut kesusasteraan penyelidikan terjemahan mesin, perbezaan 1 mata biasanya cukup untuk mendakwa bahawa sistem adalah jauh lebih baik. Seperti yang dijangkakan, NLLB akan menghasilkan markah yang lebih tinggi daripada M2M-100.

Tokenisasi ini menjana 95 token , manakala NLLB menjana 97 token. Ini hanyalah perbezaan halus, jika spBLEU dikira menggunakan tokenisasi M2M-100, skornya ialah 53.8, iaitu 1 mata lebih rendah daripada tokenisasi NLLB. Menurut kesusasteraan penyelidikan terjemahan mesin, perbezaan 1 mata biasanya cukup untuk mendakwa bahawa sistem adalah jauh lebih baik. Seperti yang dijangkakan, NLLB akan menghasilkan markah yang lebih tinggi daripada M2M-100.

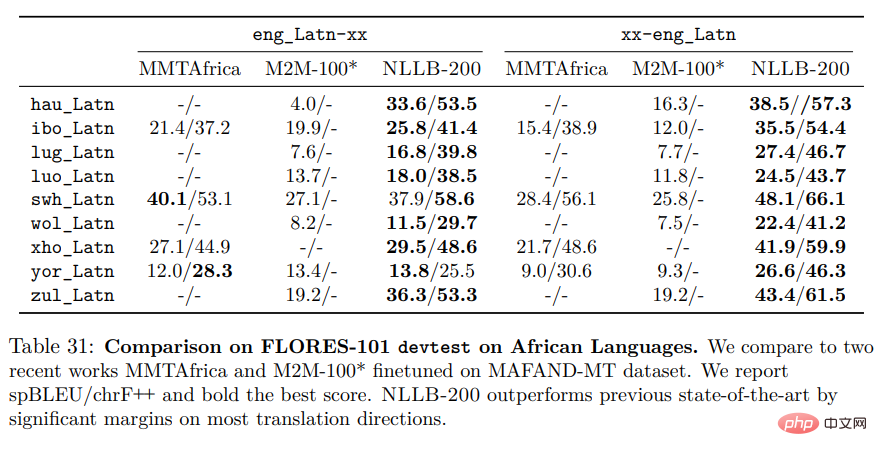

Jadual seterusnya ialah jadual terakhir dalam artikel ini: Jadual 31.

Begitu juga, kami mempunyai masalah yang sama yang dinyatakan di atas:

Begitu juga, kami mempunyai masalah yang sama yang dinyatakan di atas:

1 . M2M-100 dan NLLB menggunakan dua tokenisasi yang berbeza untuk pemarkahan, jadi perbandingan tidak boleh dibuat. 2. MMTAfrica nampaknya menggunakan tokenisasi M2M-100 dalam kertas kerja mereka. Ia setanding dengan M2M-100, tetapi tidak dengan NLLB.

Masih terdapat beberapa masalah dalam artikel, jadi saya tidak akan memperkenalkannya satu persatu di sini. Kesilapan utama yang dibuat oleh Meta AI dalam NLLB ialah kesilapan yang sangat biasa dalam penilaian terjemahan mesin, walaupun kita harus mengakui bahawa kerja ini benar-benar menakjubkan dan mungkin memberikan kualiti terjemahan yang lebih tinggi untuk banyak bahasa.

Atas ialah kandungan terperinci Kajian berskala besar Meta tentang terjemahan bahasa, hasilnya semuanya 'rutin'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI