Rumah >Peranti teknologi >AI >Kos pra-latihan penyebaran dikurangkan sebanyak 6.5 kali, dan kos perkakasan penalaan halus dikurangkan sebanyak 7 kali! Penyelesaian sumber terbuka lengkap Colossal-AI mempercepatkan pelaksanaan industri AIGC pada kos rendah

Kos pra-latihan penyebaran dikurangkan sebanyak 6.5 kali, dan kos perkakasan penalaan halus dikurangkan sebanyak 7 kali! Penyelesaian sumber terbuka lengkap Colossal-AI mempercepatkan pelaksanaan industri AIGC pada kos rendah

- 王林ke hadapan

- 2023-04-11 23:13:041307semak imbas

Cara melatih dan memperhalusi model AIGC dengan lebih baik, lebih pantas dan lebih murah telah menjadi titik kesakitan terbesar dalam pengkomersialan dan ledakan aplikasi AIGC.

Colossal-AI adalah berdasarkan pengumpulan teknologi profesional dalam pendemokrasian model besar, sumber terbuka dan penyelesaian pra-latihan Stable Diffusion yang lengkap dan penyelesaian penalaan halus yang diperibadikan, mempercepatkan masa pra-latihan dan mengurangkan kos ekonomi sebanyak 6.5 kali, dan mengurangkan kos perkakasan penalaan halus diperibadikan sebanyak 7 Kali! Proses penalaan halus boleh diselesaikan dengan cepat pada RTX 2070/3050 komputer peribadi, menjadikan model AIGC seperti Stable Diffusion dapat dicapai.

Alamat sumber terbuka:

https://github.com/hpcaitech/ColossalAI

Trek AIGC yang hangat dan kos tinggi

AIGC (AI- Kandungan Dijana (kandungan janaan kecerdasan buatan) ialah salah satu topik paling hangat dalam bidang AI semasa, terutamanya dengan kemunculan aplikasi rentas mod imej jana teks yang diwakili oleh Stable Diffusion, Midjourney, NovelAI, DALL-E, dsb., AIGC lebih popular Keluar daripada kalangan dan dapatkan perhatian yang meluas.

Resapan Stabil menjana imej

Memandangkan AIGC telah merangsang banyak permintaan industri, ia telah dianggap sebagai salah satu hala tuju penting gelombang seterusnya AI dalam industri dijangka secara meluas bahawa revolusi teknologi baharu dan aplikasi pembunuh berdasarkan AIGC akan muncul dalam teks, audio, imej dan video, permainan, metaverse dan senario teknikal lain. Kejayaan pengkomersilan AIGC dalam senario yang berkaitan dan pasaran berbilang trilion dolar yang berpotensi telah menjadikan syarikat pemula yang berkaitan sebagai modal yang digemari. Contohnya, Kestabilan AI, Jasper, dll. telah menerima pembiayaan ratusan juta dolar dalam masa satu atau dua tahun sahaja. sejak penubuhan mereka, dan telah dinaikkan pangkat kepada unicorn Perarakan binatang.

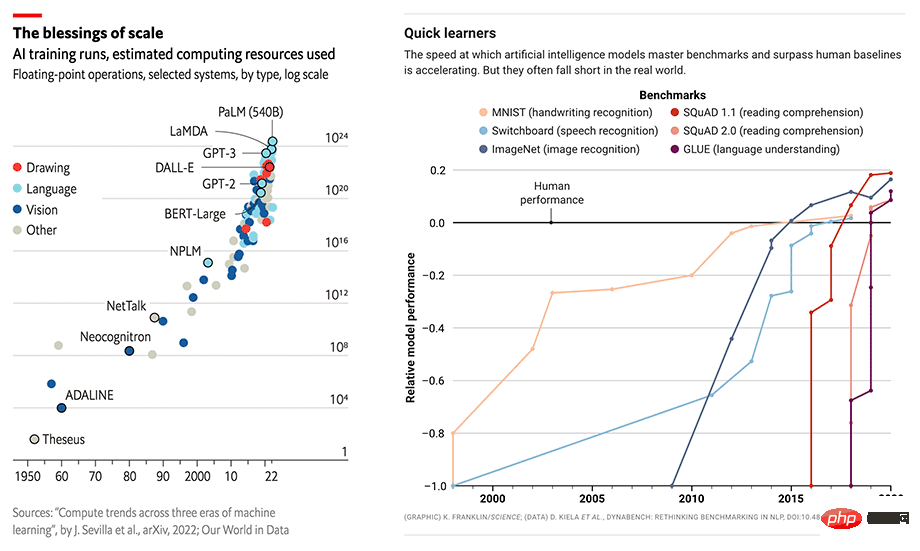

Skala dan prestasi model AI berkembang serentak

Walau bagaimanapun, keperluan perkakasan dan kos latihan yang tinggi masih menghalang perkembangan pesat industri AIGC. Prestasi cemerlang dalam aplikasi AIGC selalunya dibina pada model besar seperti GPT-3 atau Stable Diffusion dan diperhalusi untuk tugas dan aplikasi hiliran tertentu. Ambil Stable Diffusion yang popular sebagai contoh Walaupun Stability AI di belakangnya telah ditubuhkan tidak lama dahulu, ia mengekalkan lebih daripada 4,000 kumpulan GPU NVIDIA A100 dan telah membelanjakan lebih daripada 50 juta dolar AS dalam kos operasi untuk tujuan ini Versi v1 model sahaja Latihan ini memerlukan 150,000 Jam GPU A100.

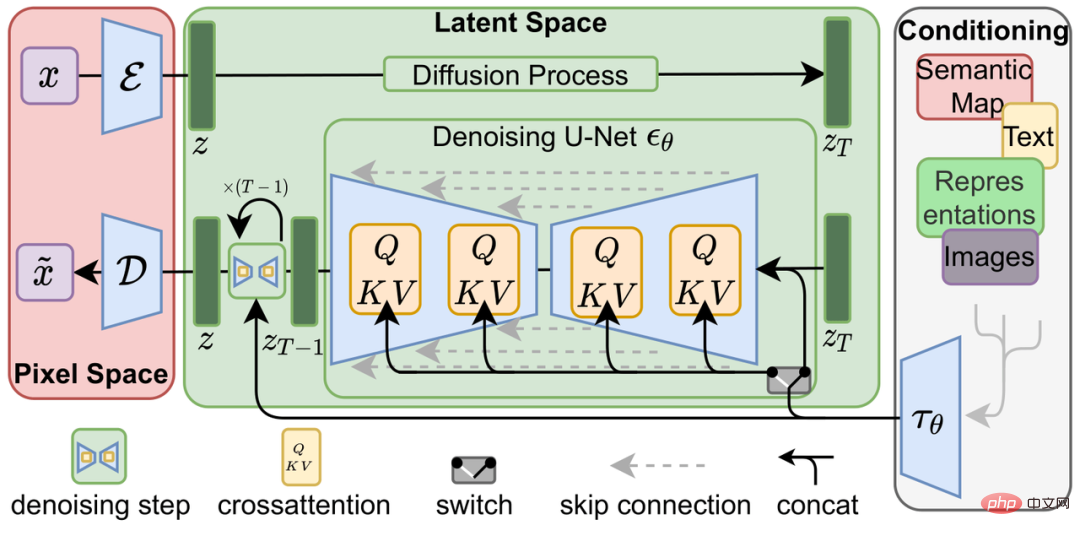

Model resapan

Idea Model Resapan (model resapan) pertama kali dicadangkan dalam makalah 2015 Deep Unsupervised Learning menggunakan Nonequilibrium Thermodynamics, dan telah dipromosikan oleh kertas 2020 Denoising Diffusion Probabilistic Models (DDPM) Mencapai ketinggian baharu, DALL-E 2, Imagen, dan Stable Diffusion berdasarkan model resapan telah mencapai lebih banyak daripada Generative Adversarial Network (GAN), Variable Differential Autoencoder (VAE) dan Autoregressive Model (AR) dalam tugas penjanaan dan kesan lain daripada model generatif tradisional.

Model resapan terdiri daripada dua proses: proses resapan ke hadapan dan proses penjanaan terbalik Proses resapan ke hadapan adalah untuk menambah secara beransur-ansur hingar Gaussian pada imej sehingga ia menjadi hingar rawak, manakala proses penjanaan terbalik adalah untuk. keluarkan hingar. Dalam proses itu, hingar rawak dibatalkan secara beransur-ansur menggunakan berbilang U-Net sehingga imej dijana, yang juga merupakan sebahagian daripada latihan model resapan.

Model Resapan Terpendam

Berbanding dengan model pembelajaran mendalam hujung ke hujung tradisional, proses latihan model resapan sudah pasti lebih rumit Stable Diffusion sebagai contoh, selain itu Model resapan itu sendiri juga mempunyai Frozen CLIP Textcoder untuk memasukkan gesaan teks, dan Autoencoder untuk memampatkan imej resolusi tinggi ke dalam ruang terpendam (Latent Space) dan mengira kerugian pada setiap langkah masa. Ini menimbulkan cabaran yang lebih besar kepada overhed memori grafik dan kelajuan pengkomputeran penyelesaian latihan.

Kos yang lebih rendah - pecutan pra-latihan dan penalaan halus sumber rendah

Pengoptimuman pra-latihan

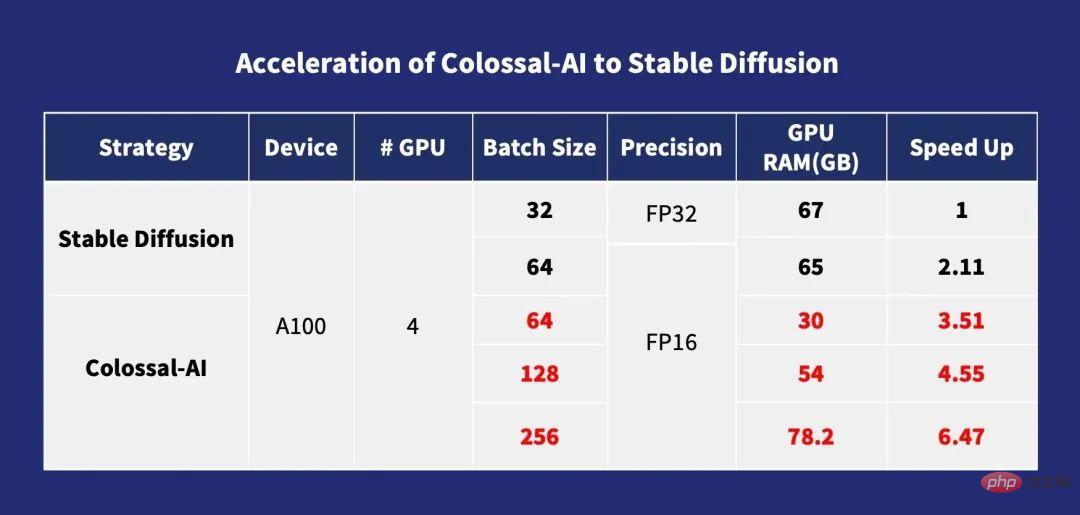

Untuk pra-latihan, secara amnya lebih besar saiz kelompok, kelajuan latihan juga lebih pantas, dan model Difusi adalah serupa. Colossal-AI mengoptimumkan pengiraan silang perhatian melalui ZeRO, Gemini, strategi pengurusan memori berasaskan Chunk dan modul Flash Attention, yang mengurangkan overhed memori latihan model Diffusion, yang membolehkan pengguna menggunakan kad grafik gred pengguna dengan memori 10G (seperti sebagai RTX3080) Model resapan boleh dilatih pada kad grafik khusus seperti A100, yang boleh menyokong latihan secara langsung dengan Saiz Batch tunggal kad maksimum 256. Berbanding dengan stable-diffusion-v1-1, latihan DistributedDataParallel (DDP) FP32 boleh dipercepatkan sebanyak 6.5 kali. Ini bermakna kos latihan berjuta-juta dolar boleh dikurangkan sebanyak 6.5 kali ganda, sekali gus mengurangkan kos latihan dan halangan kemasukan industri AIGC!

Pecutan Colossal-AI kepada Resapan Stabil

Pengoptimuman penalaan halus diperibadikan

Disebabkan set data LAION-5B yang digunakan dalam pra- latihan Stable Diffusion, sejumlah 585 bilion pasangan teks imej memerlukan 240TB ruang storan Digabungkan dengan kerumitan model, adalah jelas bahawa kos pra-latihan lengkap adalah sangat tinggi: Pasukan Kestabilan Stable Diffusion membelanjakan lebih daripada. $50 juta untuk menggunakan 4,000 GPU A100. Pilihan yang lebih praktikal untuk kebanyakan pemain AIGC ialah menggunakan pemberat model pra-latihan sumber terbuka untuk memperhalusi tugas hiliran pemperibadian.

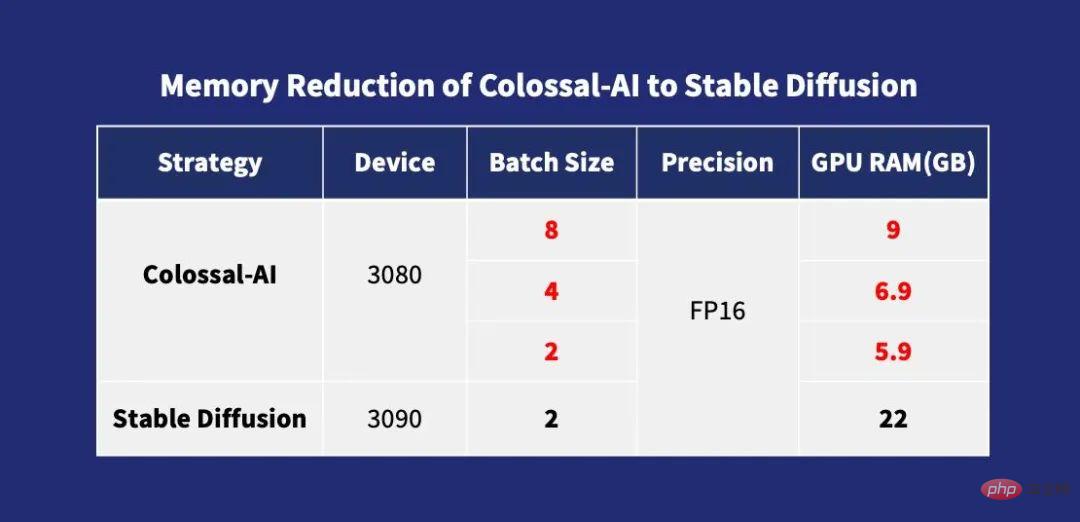

Walau bagaimanapun, kaedah paralelisme latihan yang digunakan dalam penyelesaian finetune sumber terbuka sedia ada adalah terutamanya DDP, yang menghasilkan sejumlah besar penggunaan memori video semasa proses latihan Walaupun penalaan halus memerlukan penggunaan sekurang-kurangnya RTX 3090 atau 4090, kad grafik gred pengguna tertinggi. Pada masa yang sama, banyak rangka kerja latihan sumber terbuka pada peringkat ini tidak menyediakan konfigurasi dan skrip latihan yang lengkap, yang memerlukan pengguna menghabiskan masa tambahan untuk menyiapkan dan menyahpepijat yang membosankan.

Tidak seperti penyelesaian lain, Colossal-AI ialah penyelesaian pertama untuk membuka parameter konfigurasi latihan lengkap dan skrip latihan pada masa yang sama, membolehkan pengguna melatih versi terkini model segmentasi untuk tugas hiliran baharu pada bila-bila masa , menggunakan rangkaian aplikasi yang lebih Fleksibel dan lebih luas. Dan kerana Colossal-AI memperkenalkan pengoptimuman memori video dan teknologi lain, ia boleh menyelesaikan dengan cepat proses penalaan halus pada hanya satu kad grafik gred pengguna komputer peribadi biasa (seperti GeForce RTX 2070/3050 8GB Berbanding dengan). RTX 3090 atau 4090, ia boleh menjimatkan kira-kira 7 kali ganda kos perkakasan, yang sangat mengurangkan ambang dan kos penggunaan model AIGC seperti Stable Diffusion, membolehkan pengguna tidak lagi terhad kepada penaakulan berat sedia ada dan melengkapkan perkhidmatan penyesuaian peribadi dengan cepat dan mudah . Untuk tugasan yang tidak sensitif terhadap kelajuan, anda boleh menggunakan Colossal-AI NVMe, yang menggunakan ruang cakera keras kos rendah untuk mengurangkan penggunaan memori grafik.

Pengurangan Memori Colossal-AI kepada Resapan Stabil

Teknologi pengoptimuman di belakangnya

ZeRO + Gemini

Colossal-AI menyokong penggunaan kaedah Zero Redundancy Optimizer (ZeRO) untuk menghapuskan lebihan memori, yang boleh meningkatkan kecekapan penggunaan memori dengan banyak berbanding dengan strategi selari data klasik tanpa mengorbankan kebutiran pengiraan dan kecekapan komunikasi.

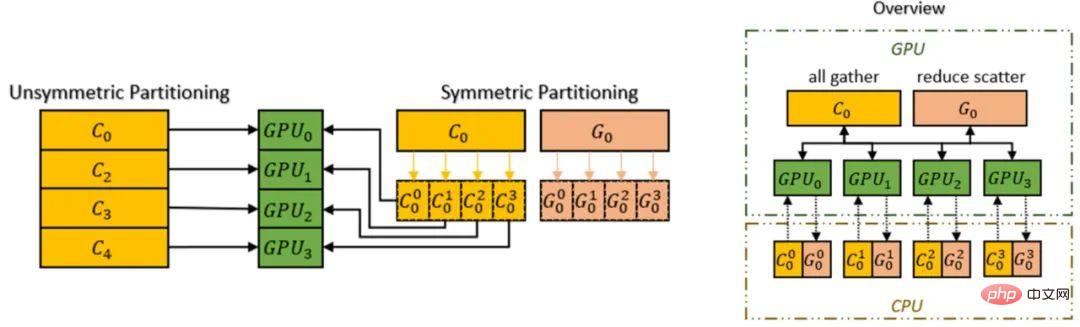

Colossal-AI memperkenalkan mekanisme Chunk, jadi kami boleh meningkatkan lagi prestasi ZeRO. Satu set parameter yang berturutan dalam susunan operasi disimpan dalam Chunk (Chunk ialah bahagian ruang memori yang berterusan), dan setiap Chunk adalah saiz yang sama. Kaedah ketulan mengatur memori boleh memastikan penggunaan lebar jalur rangkaian yang cekap antara PCI-e dan GPU-GPU, mengurangkan bilangan komunikasi dan mengelakkan pemecahan memori yang berpotensi.

Mekanisme Ketulan

Selain itu, pengurus ruang memori heterogen Colossal-AI Gemini menyokong keadaan pengoptimuman pemunggahan daripada GPU ke CPU untuk menjimatkan penggunaan Memori GPU. Memori GPU dan memori CPU (terdiri daripada memori CPU DRAM atau NVMe SSD) boleh digunakan serentak untuk menembusi batasan dinding memori GPU tunggal dan mengembangkan lagi skala model boleh dilatih.

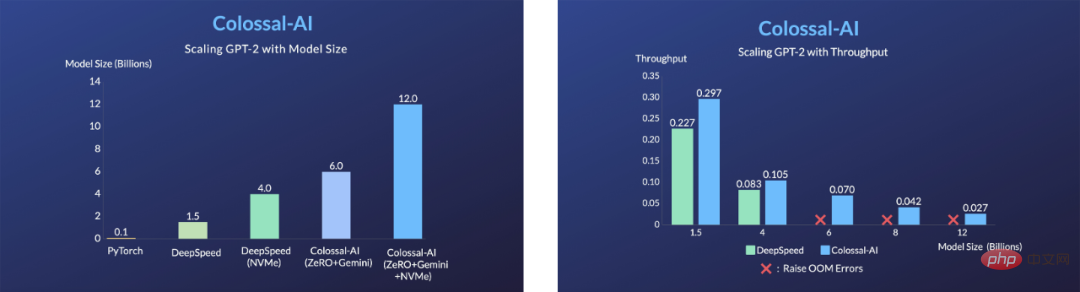

Tingkatkan kapasiti model perkakasan melalui ZeRO + Gemini

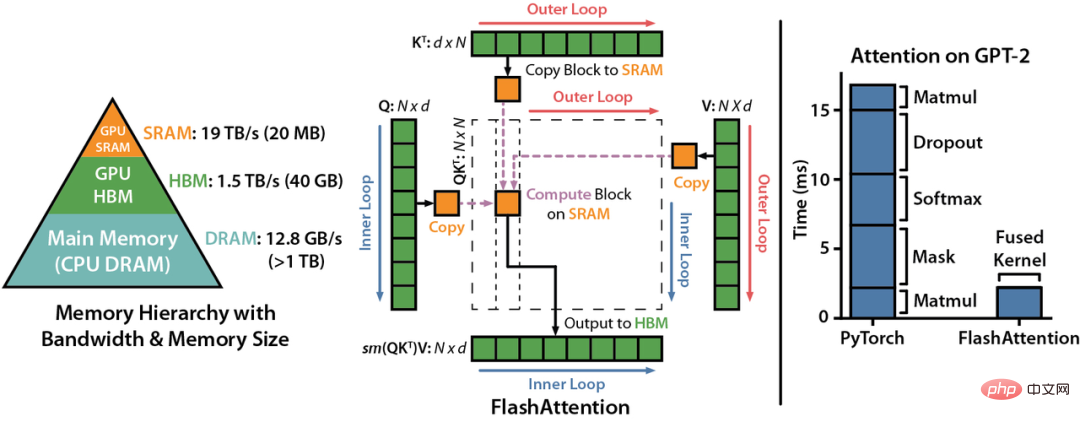

Flash Attention

LDM (Model Resapan Terpendam) Oleh memperkenalkan perhatian silang (lapisan perhatian silang) ke dalam seni bina model untuk mencapai latihan pelbagai modal, model Difusi boleh menyokong keadaan kelas, teks ke imej, susun atur ke imej dengan lebih fleksibel. Walau bagaimanapun, lapisan perhatian silang menambah overhed pengiraan tambahan berbanding lapisan CNN model Penyebaran asal, yang meningkatkan kos latihan dengan banyak.

Dengan memperkenalkan mekanisme perhatian Flash, Colossal-AI berjaya meningkatkan kelajuan perhatian sebanyak 104% dan mengurangkan memori video puncak latihan hujung ke hujung sebanyak 23% . Perhatian kilat ialah versi dipercepatkan untuk perhatian jujukan yang panjang digunakan untuk mengurangkan bilangan bacaan/tulisan memori antara memori jalur lebar tinggi GPU (HBM perhatian kilat juga mereka bentuk algoritma perhatian yang lebih cepat daripada yang lain kaedah perhatian anggaran sedia ada.

Pengoptimuman lain

Colossal-AI juga menyepadukan teknologi pengoptimuman biasa seperti FP16 dan pusat pemeriksaan pengaktifan. Sebagai contoh, aktifkan kerja pusat pemeriksaan dengan pengiraan perdagangan untuk ingatan. Ia mengelak daripada menyimpan semua pengaktifan perantaraan keseluruhan graf pengiraan untuk pengiraan ke belakang, tidak menyimpan pengaktifan perantaraan di bahagian pusat pemeriksaan, dan sebaliknya mengiranya semula dalam pas ke belakang, seterusnya mengurangkan memori video. FP16 menukar operasi titik terapung 32-bit asal kepada 16-bit tanpa menjejaskan ketepatan, mengurangkan penggunaan memori video dan meningkatkan kecekapan pengkomputeran.

Mulakan dengan pantas

Berbeza daripada projek sumber terbuka PyTorch biasa, resapan stabil panas semasa dibina pada PyTorch Lightning. PyTorch Lightning menyediakan antara muka peringkat tinggi yang ringkas, mudah digunakan, fleksibel dan cekap untuk rangka kerja pembelajaran mendalam yang popular, PyTorch, menyediakan abstraksi peringkat tinggi yang mudah dan mudah digunakan untuk majoriti penyelidik AI, dengan itu menjadikan mendalam eksperimen pembelajaran lebih mudah dibaca dan dihasilkan semula. Ia telah diterbitkan di GitHub 20.5k Bintang telah dituai.

Dijemput oleh PyTorch Lightning, Colossal-AI telah disepadukan sebagai penyelesaian model besar rasmi PyTorch Lightning. Terima kasih kepada gabungan kuat kedua-duanya, penyelidik AI kini boleh melatih dan menggunakan model resapan dengan lebih cekap. Mengambil latihan model resapan yang stabil sebagai contoh, ia boleh dimulakan dengan cepat dengan hanya sejumlah kecil kod.

from colossalai.nn.optimizer import HybridAdam from lightning.pytorch import trainer class MyDiffuser(LightningModule): ... def configure_sharded_model(self) -> None: # create your model here self.model = construct_diffuser_model(...) ... def configure_optimizers(self): # use the specified optimizer optimizer = HybridAdam(self.model.parameters(), self.lr) ... model = MyDiffuser() trainer = Trainer(accelerator="gpu", devices=1, precision=16, strategy="colossalai") trainer.fit(model)

Colossal-AI dan PyTorch Lightning juga memberikan sokongan dan pengoptimuman yang baik untuk model dan komuniti popular seperti OPT dan HuggingFace.

Penalaan halus kos rendah

Colossal-AI Untuk memenuhi keperluan pengguna untuk menjana model dengan gaya mereka sendiri melalui latihan jangka pendek dengan kurang sumber, Colossal-AI menyediakan berat model Stable Diffusion sumber terbuka berdasarkan Keupayaan HuggingFace untuk membuat pelarasan halus. Pengguna hanya perlu mengubah suai Pemuat Data untuk memuatkan set data diperhalusi mereka sendiri dan membaca pemberat pra-latihan, hanya mengubah suai konfigurasi parameter fail yaml dan menjalankan skrip latihan untuk memperhalusi model diperibadikan mereka sendiri pada komputer peribadi mereka.

model: target: ldm.models.diffusion.ddpm.LatentDiffusion params: your_sub_module_config: target: your.model.import.path params: from_pretrained: 'your_file_path/unet/diffusion_pytorch_model.bin' ... lightning: trainer: strategy: target: pytorch_lightning.strategies.ColossalAIStrategy params: ... python main.py --logdir /your_log_dir -t -b config/train_colossalai.yaml

Inferens pantas

Colossal-AI juga menyokong saluran paip Inferens Stable Diffusion asli Selepas menamatkan latihan atau penalaan halus, anda hanya perlu menghubungi terus pustaka peresap dan memuatkan yang disimpan parameter model. Inferens dilakukan secara langsung tanpa sebarang perubahan lain, menjadikannya lebih mudah untuk pengguna baharu membiasakan diri dengan proses inferens dan membenarkan pengguna yang biasa menggunakan rangka kerja asal untuk bermula dengan cepat.

from diffusers import StableDiffusionPipeline

pipe = StableDiffusionPipeline.from_pretrained(

"your_ColoDiffusion_checkpoint_path"

).to("cuda")

image = pipe('your prompt', num_inference_steps=50)["sample"][0]

image.save('file path')

Kerja yang dihasilkan daripada proses inferens di atas

Satu Perkara Lagi

Kejayaan pengoptimuman latihan AIGC yang dinyatakan di atas mewakili oleh Diffusion adalah berdasarkan Colossal-AI ialah sistem pembelajaran mendalam umum untuk era model besar Ia mencapai penggunaan yang cekap dan pantas bagi latihan model besar AI dan inferens melalui selari automatik berbilang dimensi yang cekap, pengurusan memori heterogen, pengoptimuman berskala besar. perpustakaan, penjadualan tugas adaptif, dsb., dan mengurangkan kos model besar AI. Sejak sumber terbukanya, Colossal-AI telah menduduki tempat pertama di dunia pada senarai hangat GitHub dan Papers With Code berkali-kali, dan telah menarik perhatian di dalam dan luar negara bersama-sama dengan banyak projek sumber terbuka bintang dengan berpuluh ribu bintang! Selepas semakan ketat oleh pakar antarabangsa, Colossal-AI telah berjaya dipilih sebagai tutorial rasmi persidangan AI dan HPC antarabangsa terkemuka seperti SC, AAAI dan PPoPP.

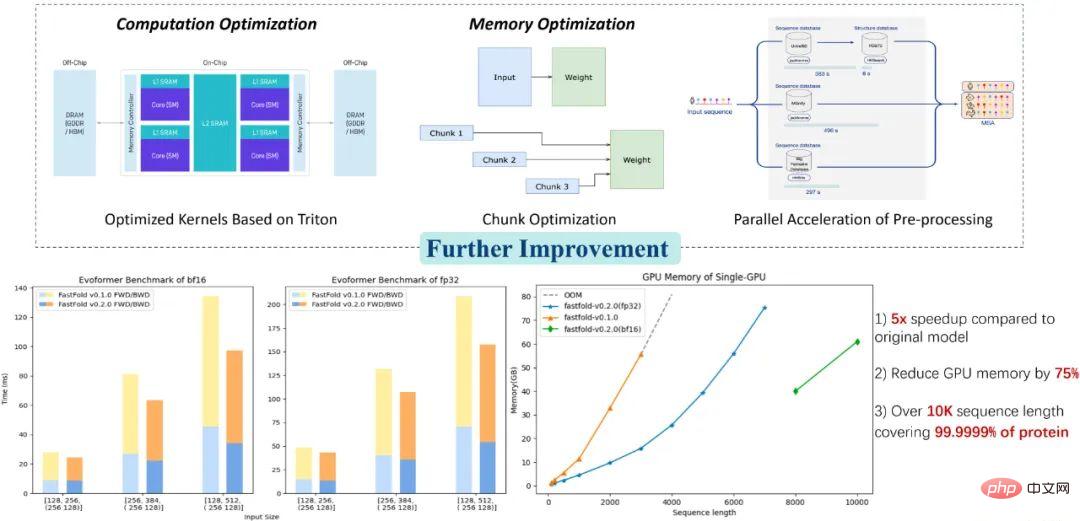

Aplikasi Colossal-AI: penyelesaian ramalan struktur protein yang lebih baik

Penyelesaian berkaitan Colossal-AI telah berjaya digunakan dalam pemanduan autonomi, pengkomputeran awan, runcit Ia telah telah dilaksanakan oleh pengeluar terkenal dalam , perubatan, cip dan industri lain dan telah mendapat pujian secara meluas. Sebagai contoh, untuk model ramalan struktur protein AlphaFold dalam industri bioperubatan, penyelesaian pengoptimuman FastFold berdasarkan Colossal-AI berjaya melebihi panjang jujukan asid amino maksimum yang boleh disimpulkan oleh GPU tunggal kepada 10,000, meliputi 99.9999% protein, menggunakan hanya komputer riba Kad grafik gred pengguna boleh menyelesaikan 90% protein. Ia boleh mempercepatkan lagi keseluruhan proses latihan dan penaakulan secara selari, dan telah membantu banyak syarikat R&D ubat baharu memendekkan proses pembangunan dan mengurangkan kos R&D.

Alamat sumber terbuka:

https://github.com/hpcaitech/ColossalAI

Atas ialah kandungan terperinci Kos pra-latihan penyebaran dikurangkan sebanyak 6.5 kali, dan kos perkakasan penalaan halus dikurangkan sebanyak 7 kali! Penyelesaian sumber terbuka lengkap Colossal-AI mempercepatkan pelaksanaan industri AIGC pada kos rendah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI