Rumah >Peranti teknologi >AI >AI menjadi gila apabila datang ke kuiz! Kadar ketepatan peperiksaan matematik peringkat tinggi ialah 81%, dan markah soalan pertandingan melebihi markah doktor sains komputer

AI menjadi gila apabila datang ke kuiz! Kadar ketepatan peperiksaan matematik peringkat tinggi ialah 81%, dan markah soalan pertandingan melebihi markah doktor sains komputer

- WBOYke hadapan

- 2023-04-11 23:10:111428semak imbas

Gagal dalam ujian matematik sekolah menengah adalah mimpi ngeri bagi ramai orang.

Adakah lebih sukar untuk menerima bahawa ujian matematik tinggi anda tidak sebaik AI?

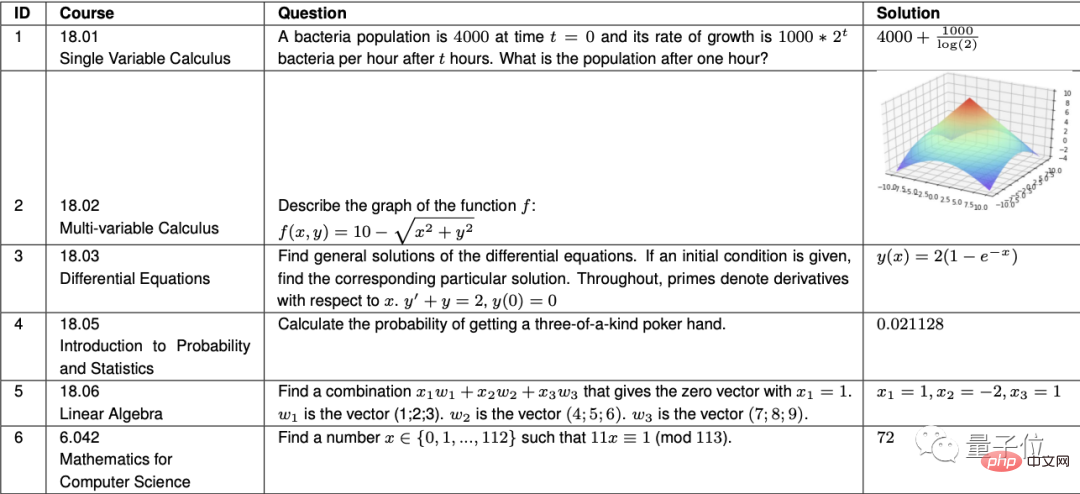

Ya, Codex daripada OpenAI telah mencapai kadar ketepatan 81.1% dalam 7 kursus matematik lanjutan di MIT, yang merupakan tahap yang baik untuk pelajar MIT.

Kursus terdiri daripada kalkulus asas kepada persamaan pembezaan, teori kebarangkalian dan algebra linear Selain pengiraan, soalan juga termasuk lukisan.

Perkara ini telah menjadi sohor kini di Weibo baru-baru ini.

△ "Sahaja" mendapat 81 mata, jangkaan untuk AI terlalu tinggi

Kini, berita besar terkini datang daripada Google :

Bukan sahaja dalam matematik, AI kami malah telah mencapai markah tertinggi dalam keseluruhan mata pelajaran sains dan kejuruteraan!

Nampaknya gergasi teknologi telah mencapai tahap baharu dalam memupuk "penyelesai masalah AI".

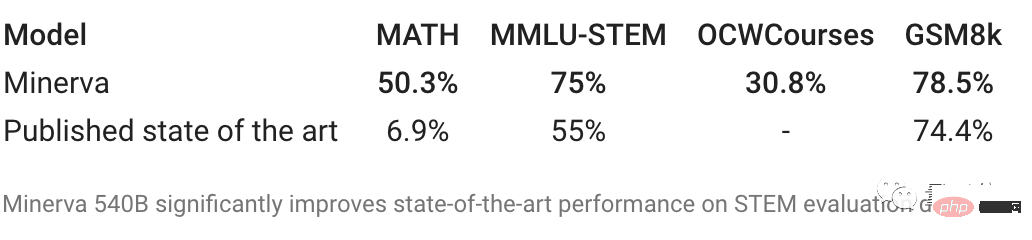

Google, pembuat soalan AI terkini, mengambil empat peperiksaan.

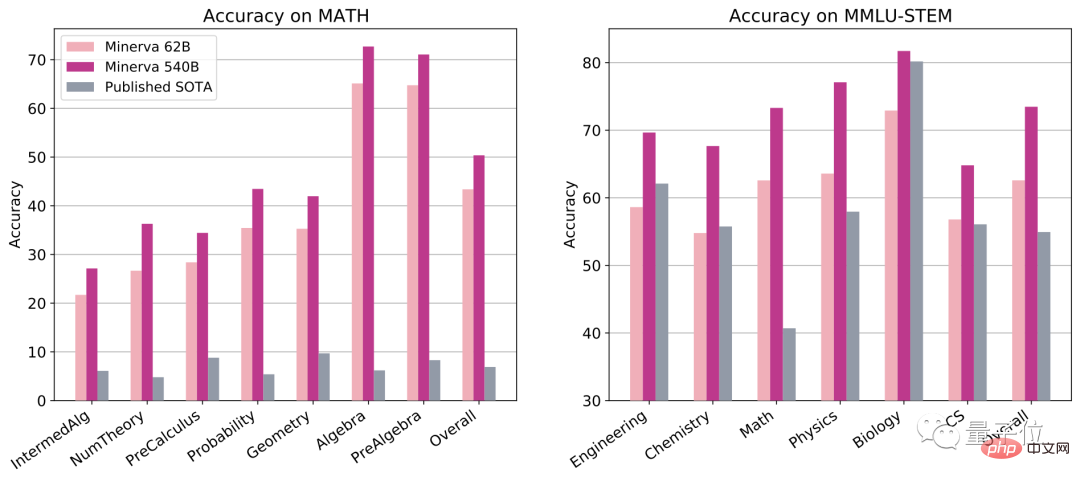

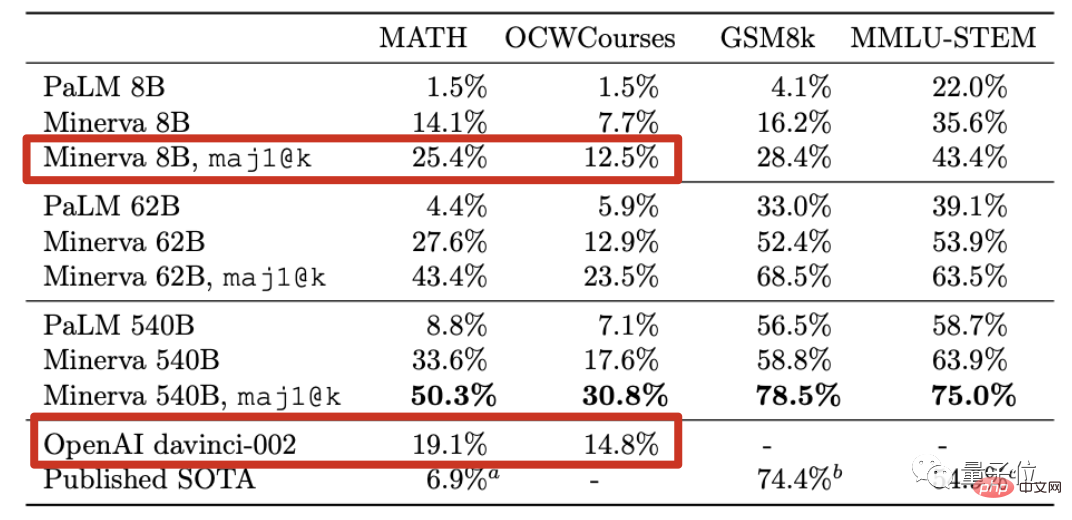

Dalam peperiksaan pertandingan matematik MATH, hanya pemenang pingat emas IMO tiga kali telah memperoleh 90 mata pada masa lalu, dan doktor komputer biasa hanya boleh mendapat kira-kira 40 mata.

Bagi jawapan soalan AI yang lain, markah terbaik sebelum ini hanya 6.9 mata...

Tetapi kali ini, AI baharu Google memperoleh 50 mata, yang lebih tinggi daripada ijazah kedoktoran sains komputer .

Peperiksaan komprehensif MMLU-STEM merangkumi matematik, fizik, kimia, biologi, kejuruteraan elektronik dan sains komputer Kesukaran soalan sampai ke peringkat sekolah menengah atau pun kolej.

Kali ini, "versi kesihatan penuh" Google AI juga mendapat skor tertinggi antara semua soalan, secara langsung meningkatkan skor sebanyak kira-kira 20 mata.

GSM8k, soalan matematik sekolah rendah, secara langsung menaikkan markah kepada 78 mata Sebagai perbandingan, GPT-3 gagal (hanya 55 mata).

Malah untuk kursus sarjana dan siswazah MIT seperti kimia keadaan pepejal, astronomi, persamaan pembezaan dan relativiti khas, AI baharu Google boleh menjawab hampir satu pertiga daripada lebih 200 soalan.

Perkara yang paling penting ialah tidak seperti kaedah OpenAI untuk mendapatkan markah tinggi dalam matematik dengan bergantung kepada “kemahiran pengaturcaraan”, Google AI kali ini mengambil pendekatan “berfikir seperti seorang manusia” Luzi——

Ia seperti pelajar seni liberal yang hanya menghafal tetapi tidak membuat soalan, tetapi dia telah menguasai kemahiran menyelesaikan masalah yang lebih baik dalam sains dan kejuruteraan.

Perlu disebut bahawa Lewkowycz, pengarang pertama kertas kerja, juga berkongsi sorotan yang tidak disebutkan dalam kertas:

Model kami mengambil bahagian dalam tahun ini Skor Peperiksaan Masuk Kolej Matematik Poland adalah lebih tinggi daripada purata kebangsaan.

Melihat perkara ini, sesetengah ibu bapa tidak boleh duduk diam lagi.

Jika saya memberitahu anak perempuan saya perkara ini, saya takut dia akan menggunakan AI untuk melakukan kerja rumahnya. Tetapi jika anda tidak memberitahunya, anda tidak menyediakannya untuk masa depan!

Di mata orang dalam industri, mencapai tahap ini dengan hanya bergantung pada model bahasa tanpa aritmetik, logik dan algebra pengekodan keras adalah perkara yang paling menakjubkan tentang ini tempat penyelidikan.

Jadi, bagaimana ini dilakukan?

AI membaca 2 juta kertas di arXiv

Model baharu Minerva adalah berdasarkan model bahasa umum PaLM di bawah seni bina Pathway.

Latihan lanjut dilakukan berdasarkan 8 bilion, 60 bilion dan 540 bilion parameter model PaLM masing-masing.

Pendekatan Minerva untuk menjawab soalan berbeza sama sekali daripada Codex.

Kaedah Codex adalah untuk menulis semula setiap masalah matematik ke dalam masalah pengaturcaraan dan kemudian menulis kod untuk menyelesaikannya.

Minerva, sebaliknya, membaca kertas dengan gila dan memaksa dirinya untuk memahami simbol matematik dengan cara yang sama seperti bahasa semula jadi.

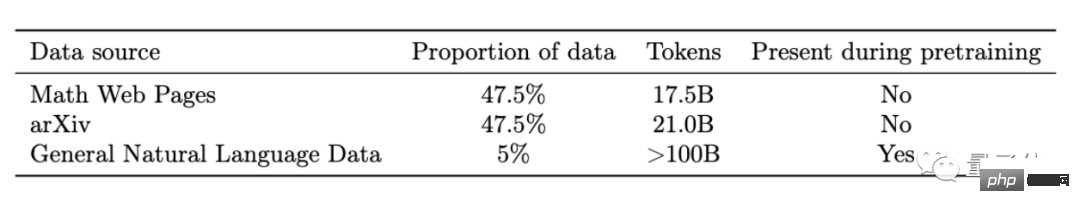

Teruskan latihan berdasarkan PaLM Set data baharu mempunyai tiga bahagian:

Terutamanya merangkumi 2 juta kertas akademik yang dikumpul di arXiv, halaman web 60GB dengan formula LaTeX, dan sebahagian kecil daripada. teks yang digunakan dalam fasa latihan PaLM.

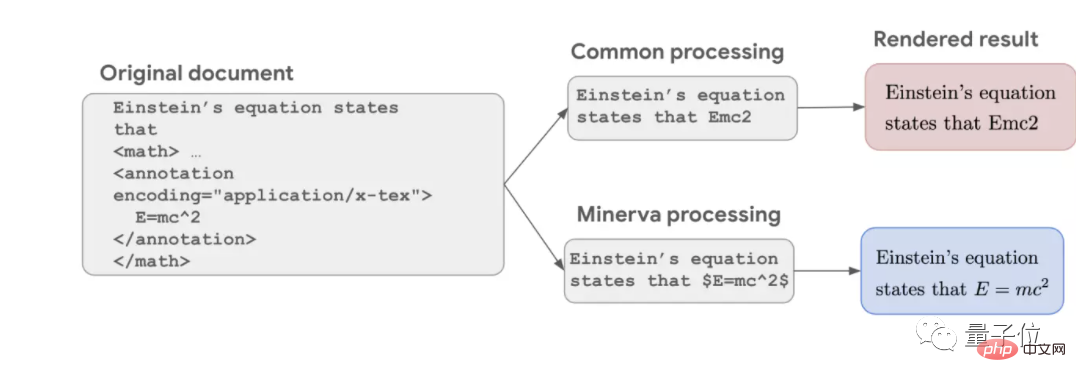

Proses pembersihan data NLP yang biasa akan memadamkan semua simbol dan hanya menyimpan teks tulen, menyebabkan formula tidak lengkap Contohnya, hanya persamaan tenaga jisim Einstein yang terkenal kekal sebagai Emc2.

Tetapi kali ini Google menyimpan semua formula dan menjalani program latihan Transformer seperti teks biasa, membenarkan AI memahami simbol seperti ia memahami bahasa.

Ini adalah salah satu sebab mengapa Minerva berprestasi lebih baik dalam masalah matematik berbanding model bahasa sebelumnya.

Tetapi berbanding dengan AI yang pakar dalam menyelesaikan masalah matematik, Minerva tidak mempunyai struktur matematik asas yang jelas dalam latihannya, yang membawa kelemahan dan kelebihan.

Kelemahannya ialah AI mungkin menggunakan langkah yang salah untuk mendapatkan jawapan yang betul.

Kelebihannya ialah ia boleh disesuaikan dengan disiplin yang berbeza Walaupun sesetengah masalah tidak dapat diungkapkan dalam bahasa matematik formal, ia boleh diselesaikan dengan menggabungkan keupayaan pemahaman bahasa semula jadi.

Dalam peringkat penaakulan AI, Minerva turut menggabungkan beberapa teknologi baharu yang dibangunkan oleh Google baru-baru ini.

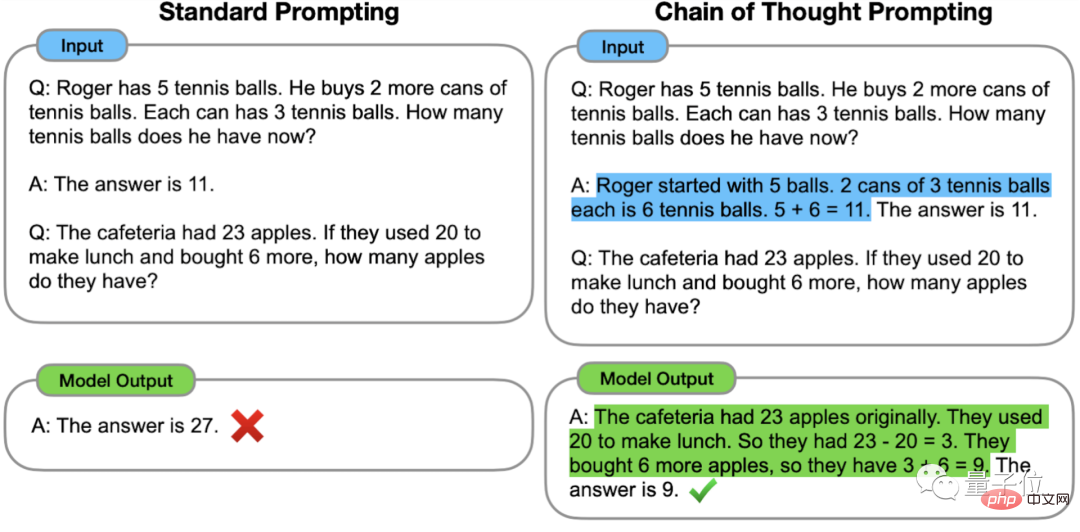

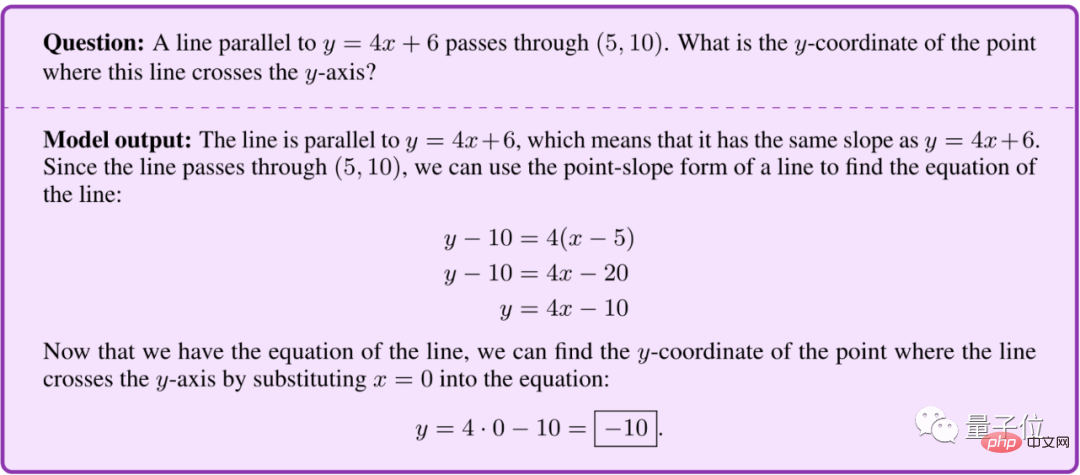

Pertama ialah gesaan pautan pemikiran Rantaian Pemikiran, yang dicadangkan oleh pasukan Google Brain pada Januari tahun ini.

Secara khusus, apabila bertanya soalan, berikan contoh jawapan langkah demi langkah untuk membimbing anda. AI boleh menggunakan proses pemikiran yang serupa apabila menjawab soalan untuk menjawab soalan dengan betul yang sebaliknya akan dijawab dengan salah.

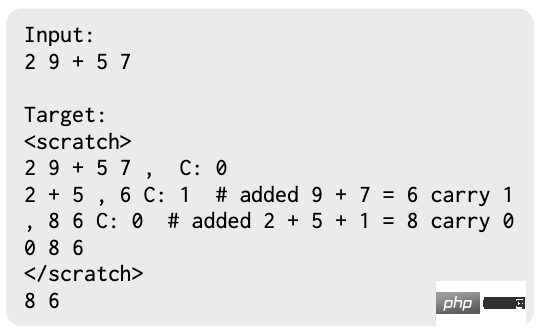

Kemudian terdapat kaedah Scrathpad yang dibangunkan oleh Google dan MIT, yang membolehkan AI menyimpan sementara hasil pengiraan langkah demi langkah.

Akhir sekali, terdapat kaedah Pengundian Majoriti, yang hanya dikeluarkan pada Mac tahun ini.

Biarkan AI menjawab soalan yang sama beberapa kali dan pilih jawapan yang paling kerap muncul.

Selepas semua teknik ini digunakan, Minerva dengan 540 bilion parameter mencapai SOTA dalam pelbagai set ujian.

Malah versi 8 bilion parameter Minerva boleh mencapai tahap GPT-3 versi davinci-002 terkini dalam masalah matematik peringkat persaingan dan masalah kursus terbuka MIT.

Setelah berkata begitu banyak, apakah soalan khusus yang boleh Minerva lakukan?

Google juga telah membuka set sampel, mari kita lihat.

Ia serba boleh dalam matematik, fizik dan kimia, malah boleh melakukan pembelajaran mesin

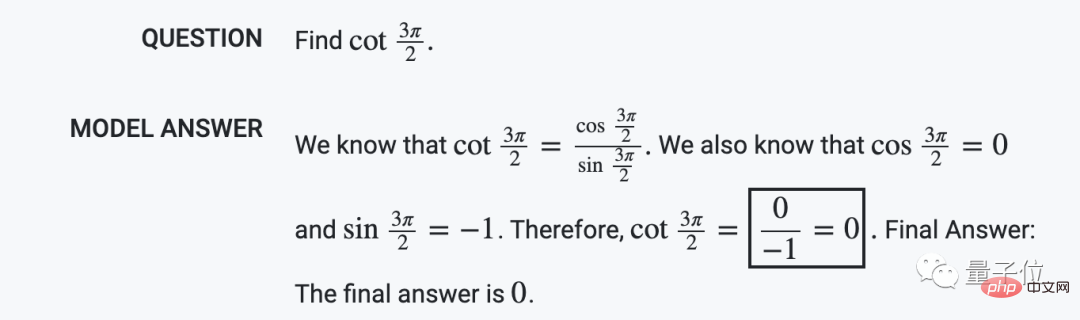

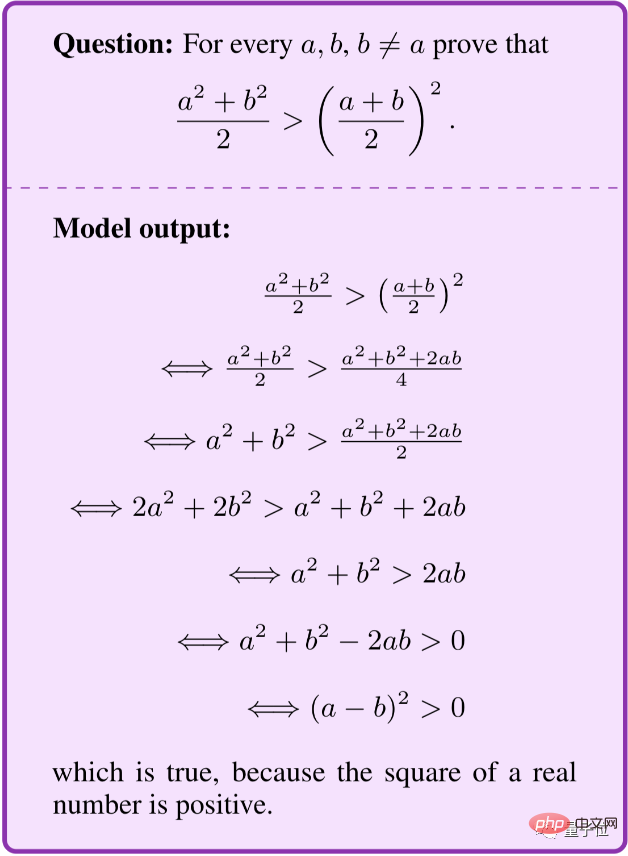

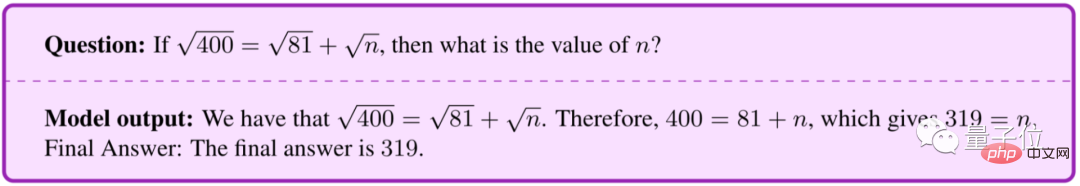

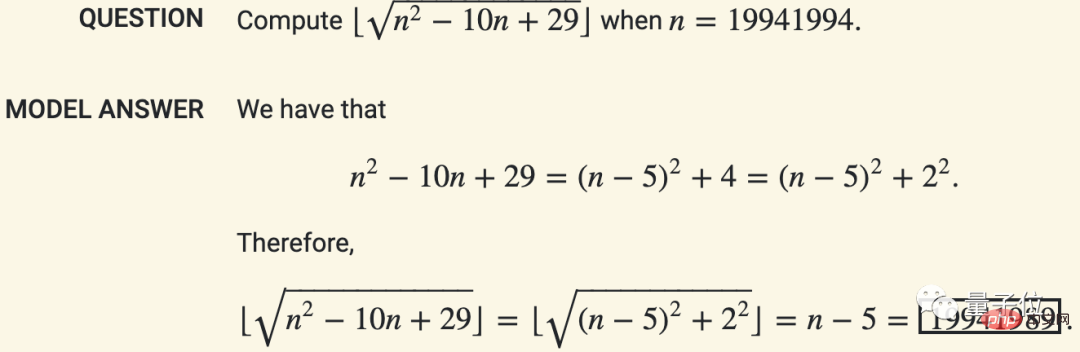

Dalam matematik, Minerva boleh mengira nilai langkah demi langkah seperti manusia, bukannya penyelesaian kekerasan secara langsung.

Untuk masalah perkataan, anda boleh membuat persamaan anda sendiri dan memudahkannya.

Anda juga boleh mendapatkan buktinya.

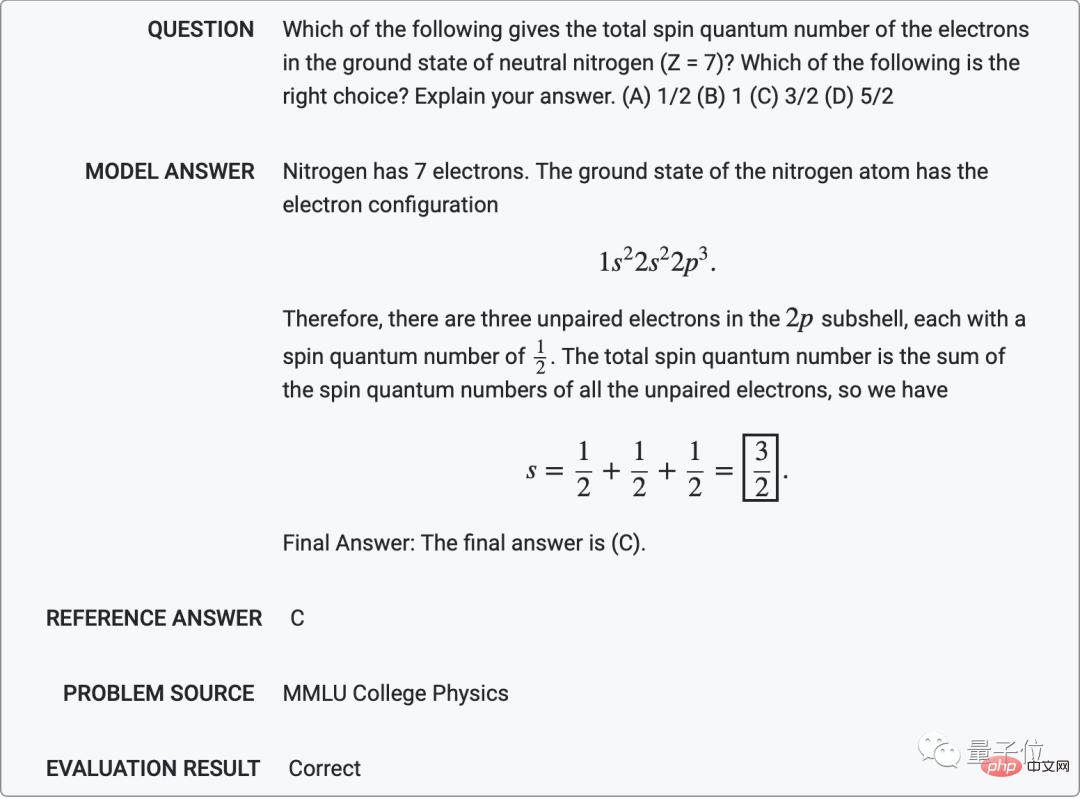

Dalam fizik, Minerva boleh menyelesaikan soalan peringkat universiti seperti mencari jumlah bilangan kuantum putaran elektron dalam keadaan tanah nitrogen neutral (Z = 7).

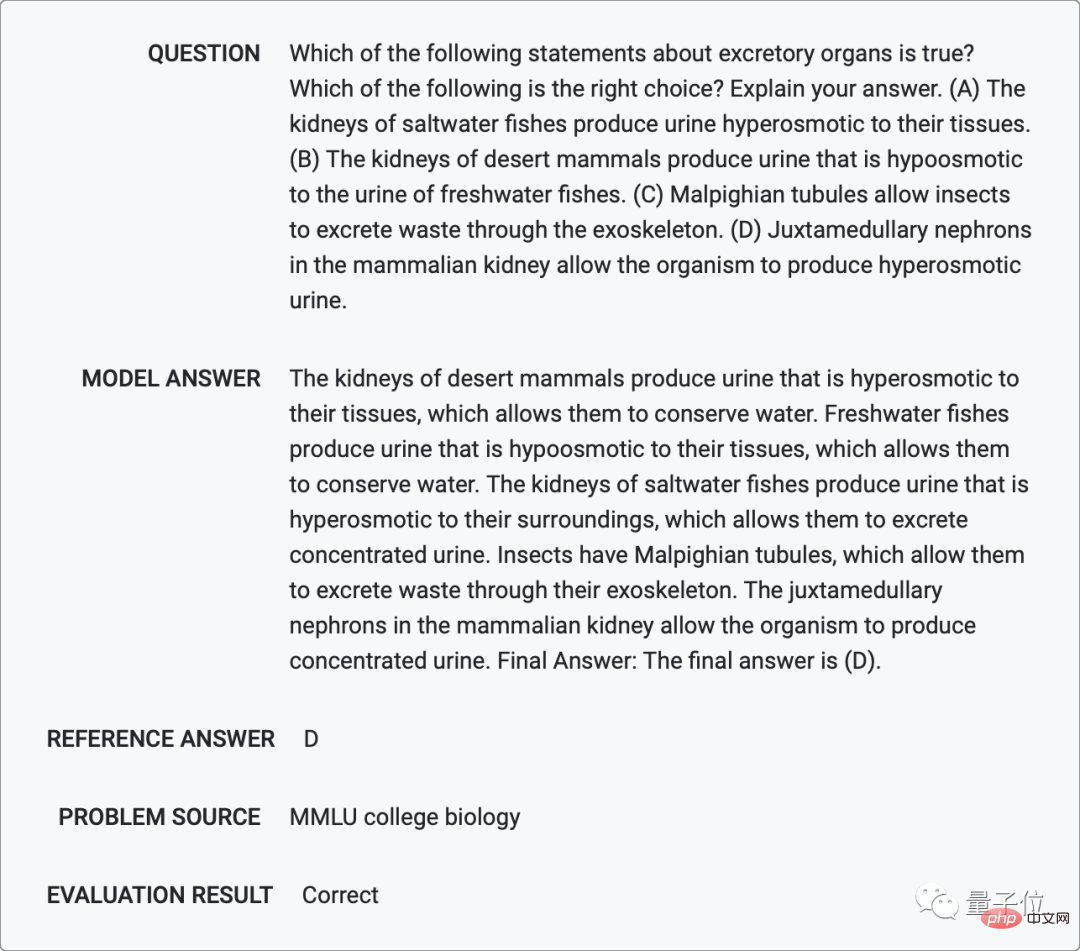

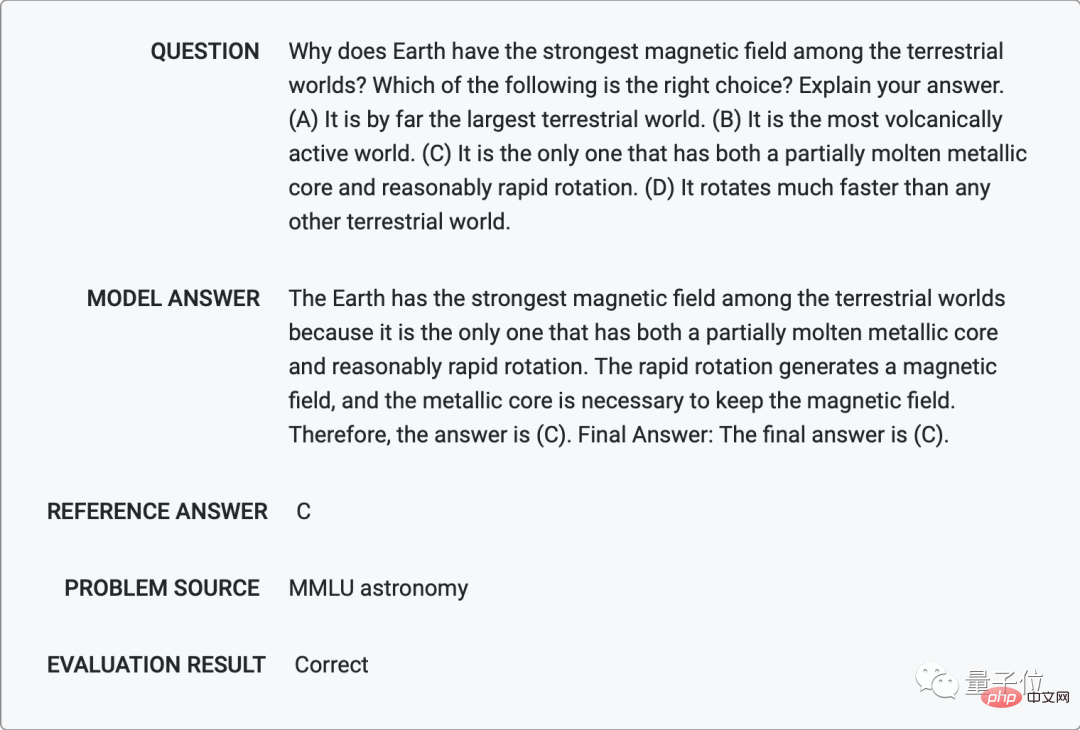

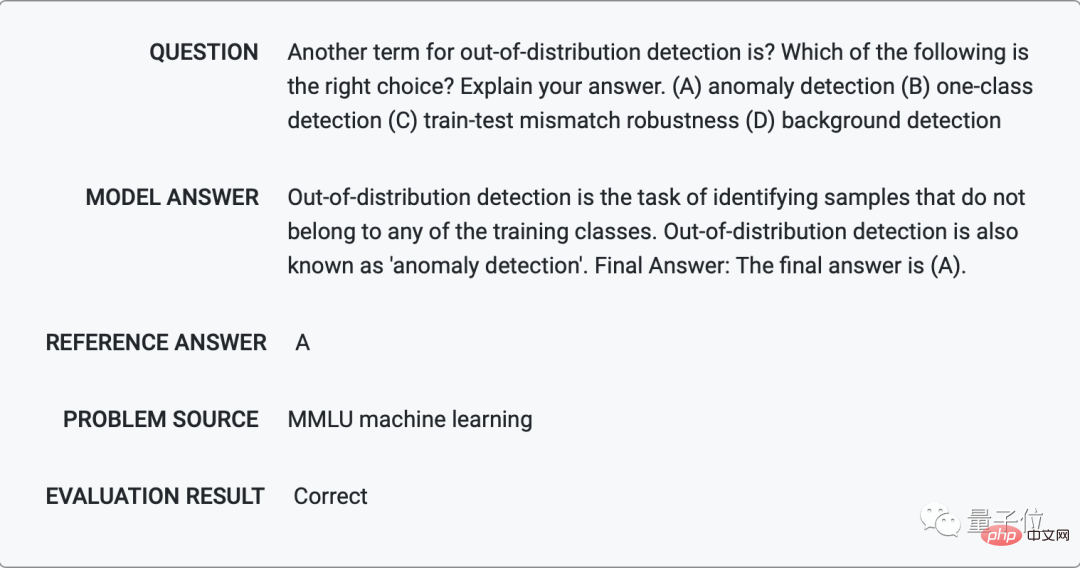

Dalam biologi dan kimia, Minerva juga boleh menjawab pelbagai soalan aneka pilihan dengan keupayaan pemahaman bahasanya.

Antara bentuk mutasi titik berikut yang manakah tidak mempunyai kesan negatif ke atas protein yang terbentuk daripada jujukan DNA?

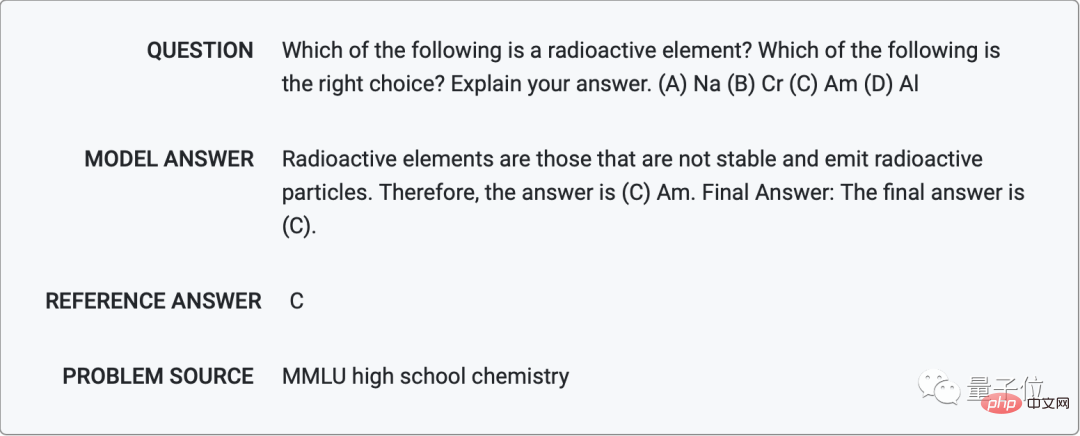

Antara berikut, yang manakah unsur radioaktif?

Dan astronomi: Mengapa bumi mempunyai medan magnet yang kuat?

Dari segi pembelajaran mesin, ia memberikan cara lain untuk menyebut istilah ini dengan betul dengan menerangkan maksud khusus "pengesanan sampel luar pengedaran".

...

Walau bagaimanapun, Minerva kadangkala membuat beberapa kesilapan bodoh, seperti membatalkan √ pada kedua-dua belah persamaan.

Selain itu, Minerva akan mengalami situasi "positif palsu" di mana proses penaakulan adalah salah tetapi hasilnya betul, seperti berikut, dengan kebarangkalian 8%.

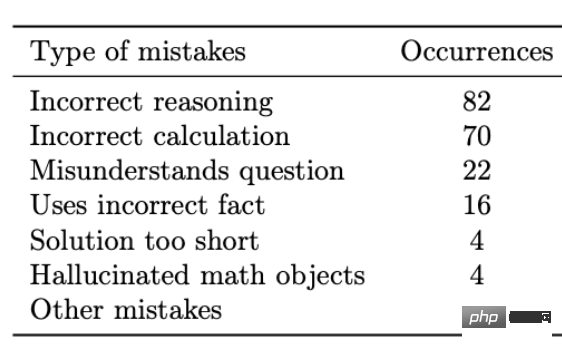

Setelah analisis, pasukan mendapati bahawa bentuk ralat utama datangnya daripada kesilapan pengiraan dan kesilapan penaakulan, dan hanya sebahagian kecil daripada kesilapan dalam memahami maksud soalan dan menggunakan fakta yang salah dalam situasi lain.

Ralat pengiraan boleh diselesaikan dengan mudah dengan mengakses kalkulator luaran atau penterjemah Python, tetapi jenis ralat lain sukar untuk dilaraskan kerana rangkaian saraf terlalu besar.

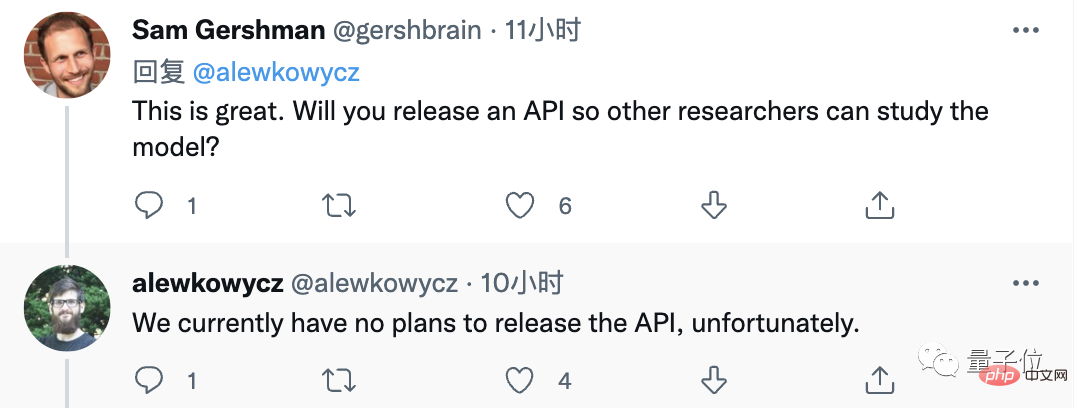

Secara keseluruhan, prestasi Minerva telah mengejutkan ramai orang, dan mereka telah meminta API dalam kawasan ulasan (malangnya, Google belum mempunyai rancangan awam lagi).

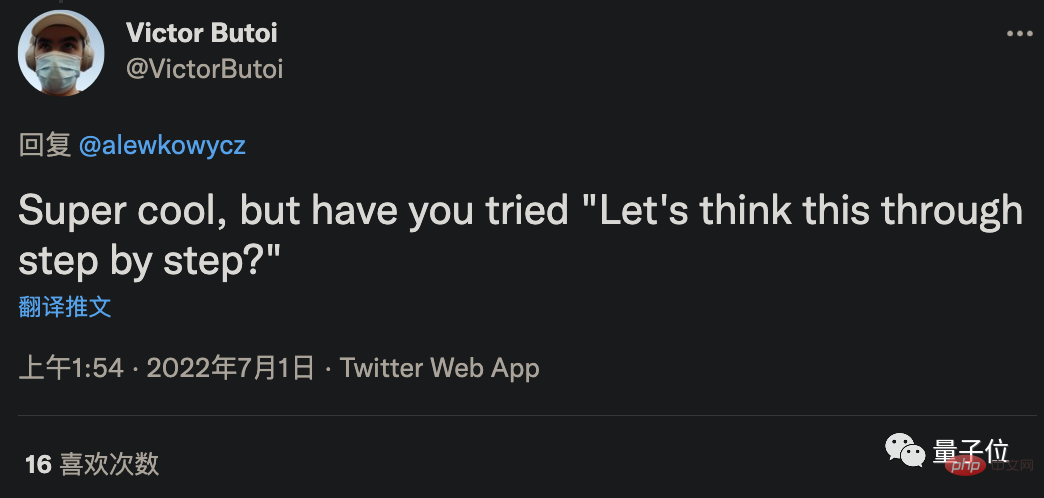

Sesetengah netizen berpendapat, ditambah pula dengan kaedah "memujuk" yang menjadikan ketepatan penyelesaian masalah GPT-3 melonjak sebanyak 61% dalam beberapa hari lalu, ketepatannya mungkin masih menjadi Bolehkah ia diperbaiki lagi?

Walau bagaimanapun, jawapan penulis ialah kaedah memujuk tergolong dalam pembelajaran sampel sifar, dan tidak kira betapa kuatnya ia, ia mungkin tidak sebaik beberapa sampel pembelajaran dengan 4 contoh.

Ada netizen bertanya, memandangkan ia boleh buat soalan, bolehkah ia digunakan secara terbalik?

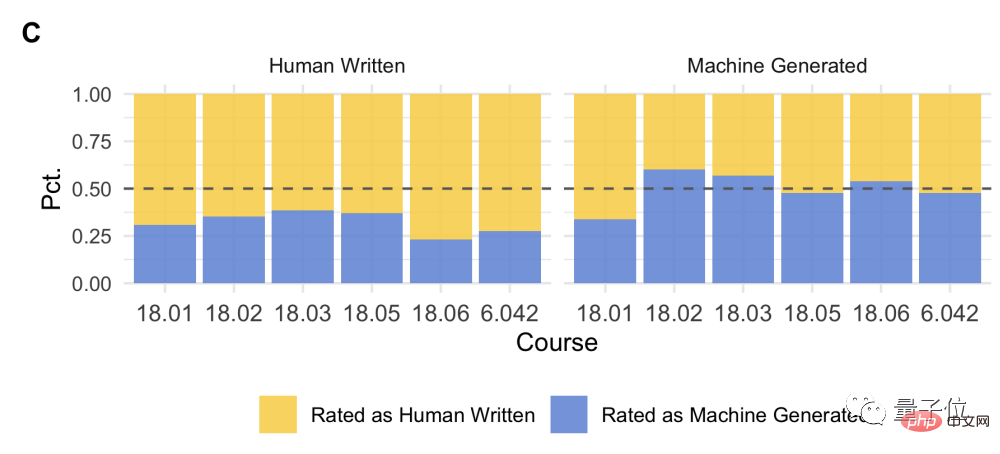

Malah, MIT telah bekerjasama dengan OpenAI untuk menggunakan AI untuk menetapkan soalan untuk pelajar kolej.

Mereka mencampur-adukkan soalan yang ditanya oleh manusia dan soalan yang ditanya oleh AI, dan meminta pelajar membuat soal selidik Sukar untuk semua orang mengetahui sama ada sesuatu soalan ditanya oleh AI.

Ringkasnya, keadaan semasa kecuali mereka yang mengusahakan AI sibuk membaca kertas ini.

Pelajar menantikan suatu hari nanti dapat menggunakan AI untuk melakukan kerja rumah mereka.

Guru juga menantikan hari apabila mereka boleh menggunakan AI untuk menghasilkan kertas ujian.

Alamat kertas: https://storage.googleapis.com/minerva-paper/minerva_paper.pdf

Alamat demo: https://minerva- demo.github.io/

Kertas berkaitan: Rantaian Pemikiran https://arxiv.org/abs/2201.11903Scrathpads https://arxiv.org/abs/2112.00114Majority Undian https://arxiv.org /abs/2203.11171

Pautan rujukan:

https://ai.googleblog.com/2022/06/minerva-solving-quantitative-reasoning.html

https: //twitter.com/bneyshabur/status/1542563148334596098

https://twitter.com/alewkowycz/status/1542559176483823622

Atas ialah kandungan terperinci AI menjadi gila apabila datang ke kuiz! Kadar ketepatan peperiksaan matematik peringkat tinggi ialah 81%, dan markah soalan pertandingan melebihi markah doktor sains komputer. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI