Rumah >Peranti teknologi >AI >Sejauh manakah model besar boleh dipercayai? Tutorial terbaharu IBM dan sarjana lain tentang 'Kekukuhan Asas Model Asas'

Sejauh manakah model besar boleh dipercayai? Tutorial terbaharu IBM dan sarjana lain tentang 'Kekukuhan Asas Model Asas'

- 王林ke hadapan

- 2023-04-11 22:43:061275semak imbas

Sebagai salah satu persidangan akademik AI yang paling berprestij di dunia, NeurIPS ialah acara penting dalam komuniti akademik setiap tahun nama penuhnya ialah Sistem Pemprosesan Maklumat Neural, yang biasanya dihoskan oleh Yayasan NeurIPS pada bulan Disember setiap tahun.

Kandungan yang dibincangkan pada persidangan itu termasuk pembelajaran mendalam, penglihatan komputer, pembelajaran mesin berskala besar, teori pembelajaran, pengoptimuman, teori jarang dan banyak subbahagian lain.

Tahun ini NeurIPS adalah edisi ke-36 dan akan diadakan selama dua minggu dari 28 November hingga 9 Disember.

Minggu pertama akan diadakan pertemuan secara peribadi di Pusat Konvensyen Ernest N. Morial di New Orleans, Amerika Syarikat, dan minggu kedua ialah mesyuarat dalam talian.

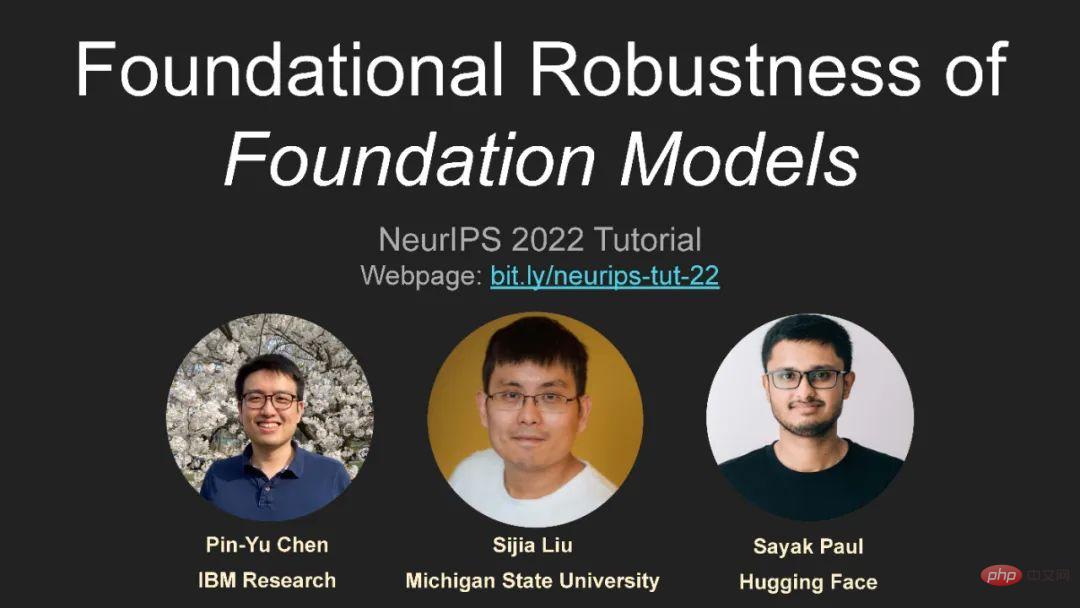

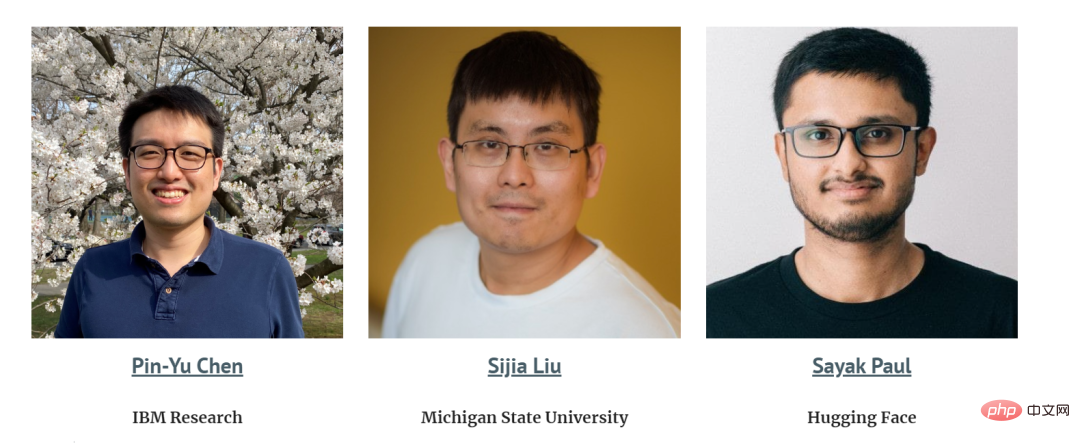

Ulama dari Pusat Penyelidikan IBM dan sarjana lain bercakap tentang keteguhan model besar, yang sangat patut diberi perhatian!

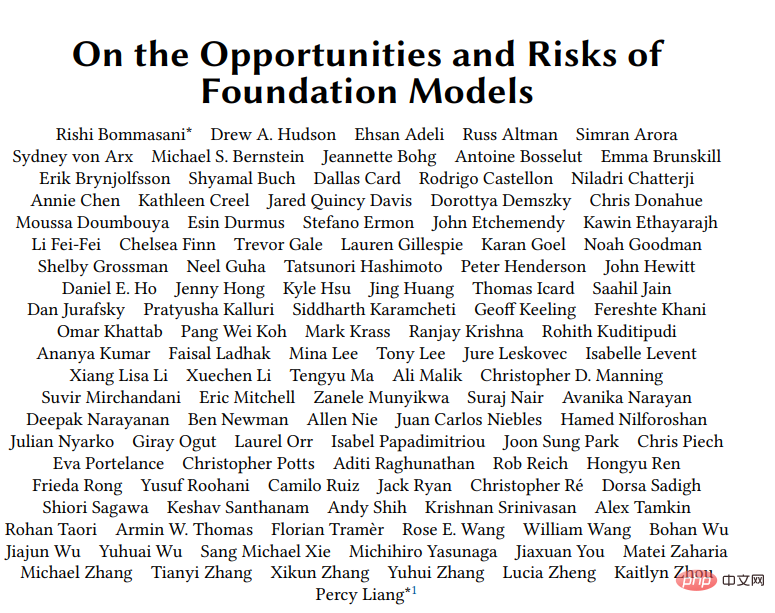

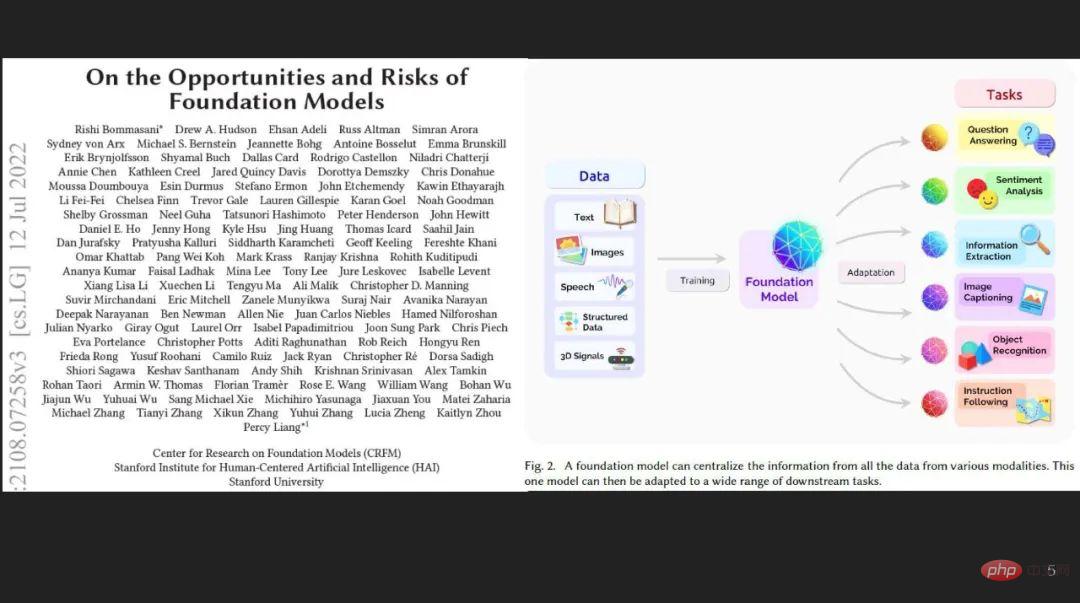

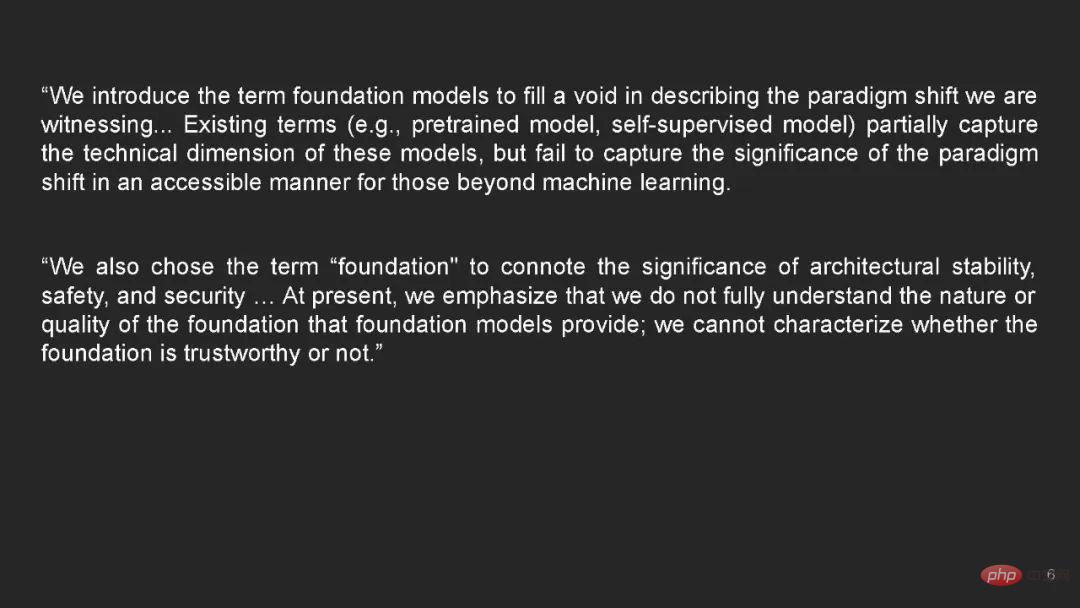

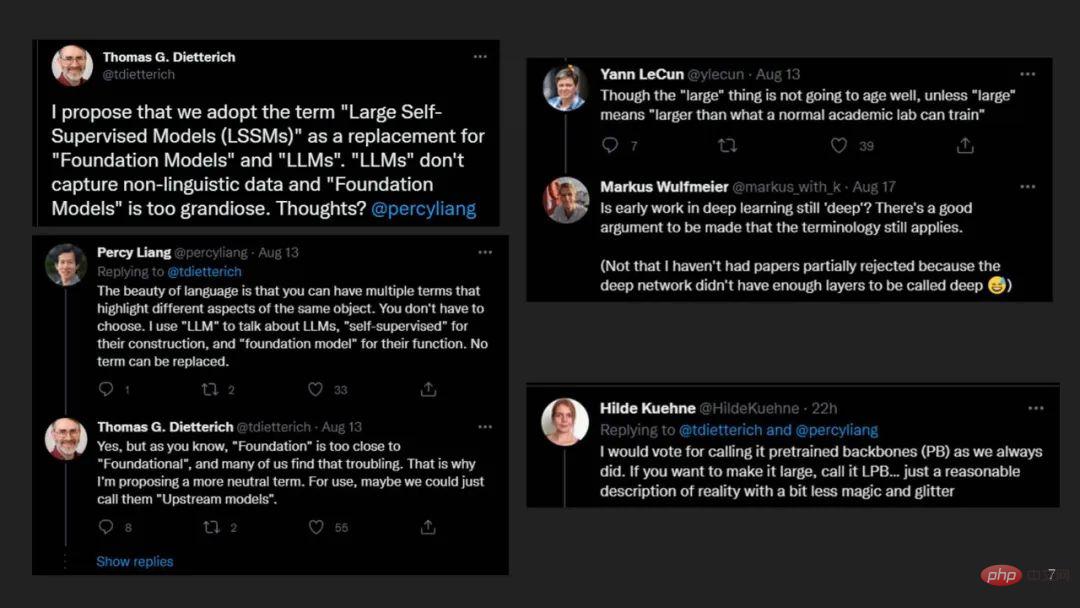

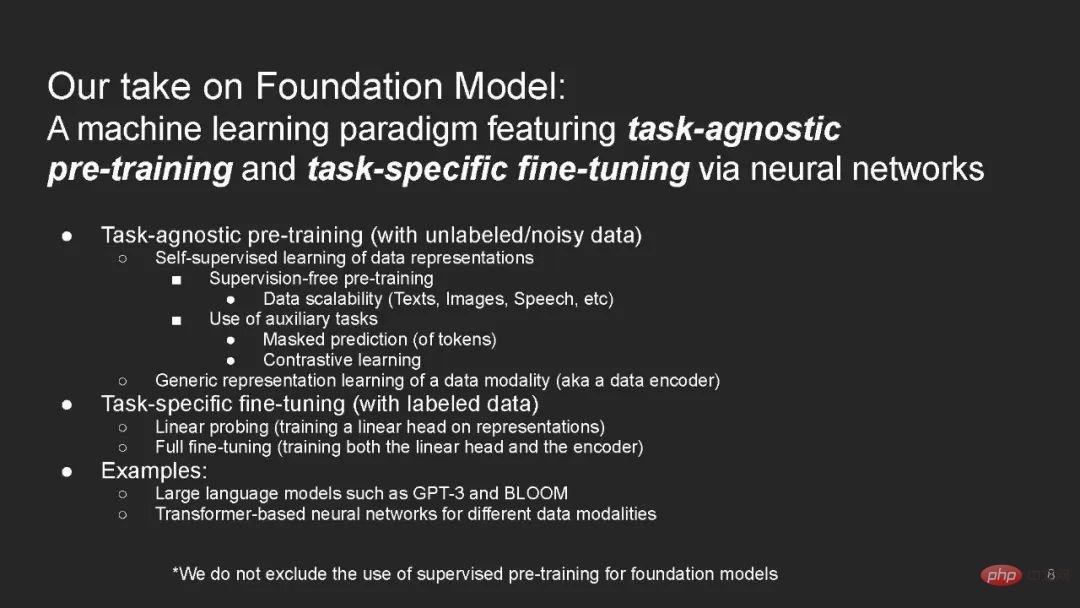

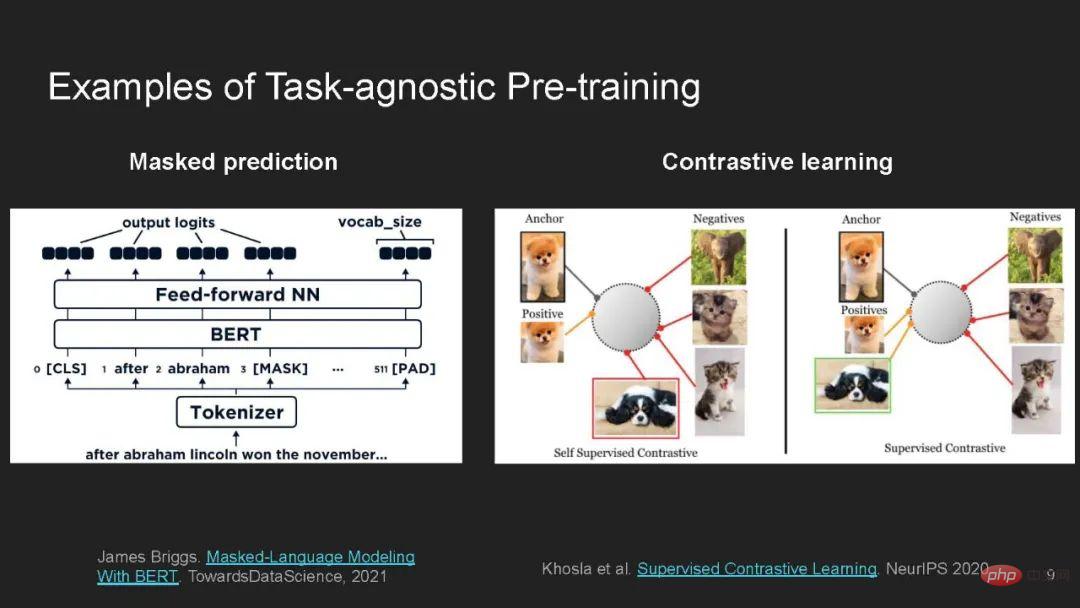

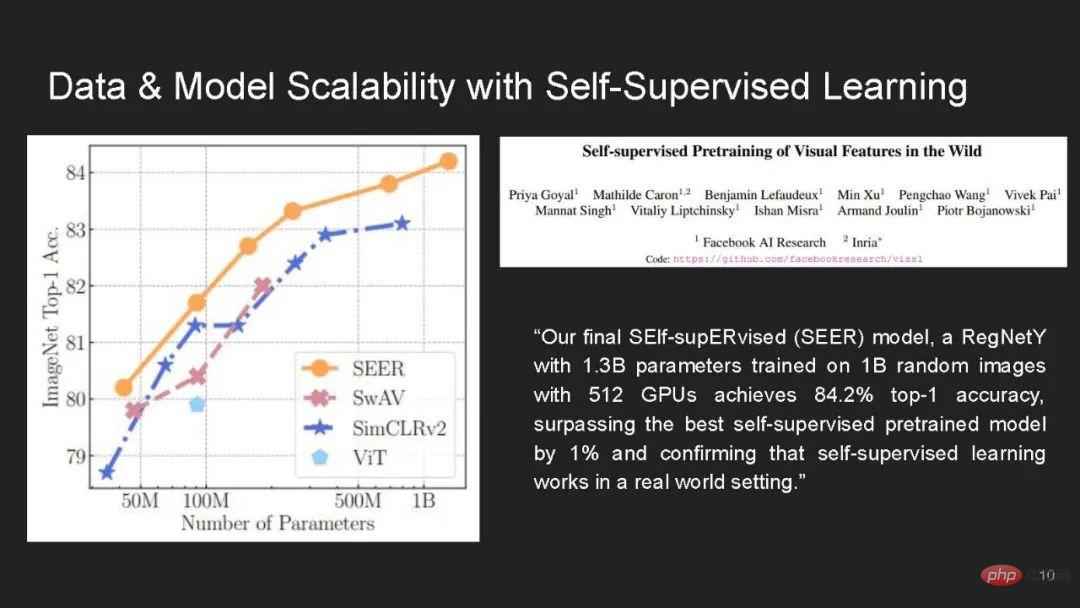

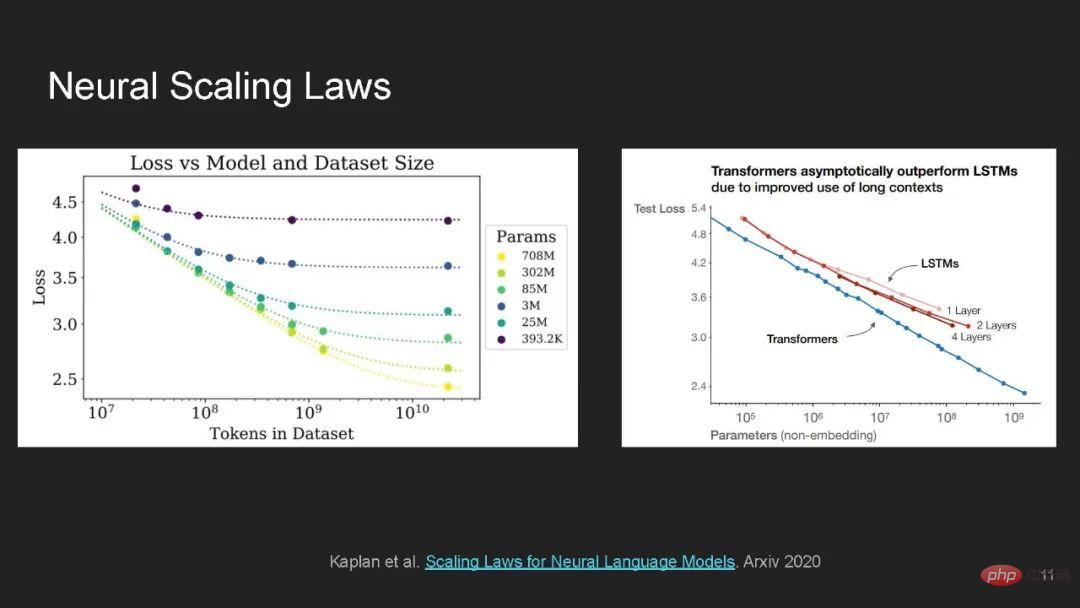

Model asas menggunakan kaedah pembelajaran mendalam, pra-latihan pada data tidak berlabel berskala besar, dan penalaan halus melalui penyeliaan tugasan khusus teknologi arus perdana untuk pembelajaran mesin.

Walaupun model asas memegang banyak janji dalam mempelajari perwakilan umum dan generalisasi beberapa/sifar pukulan merentas domain dan corak data, model ini juga mengalami volum data yang berlebihan dan kerumitan yang digunakan Neural seni bina rangkaian, ia menimbulkan cabaran yang belum pernah terjadi sebelumnya dan risiko yang besar dari segi keteguhan dan privasi.

Tutorial ini bertujuan untuk menyediakan tutorial dalam talian seperti coursera yang mengandungi kuliah komprehensif, demonstrasi pengekodan Jupyter/Colab interaktif dan interaktif serta tutorial tentang kebolehpercayaan dalam asas. model. Perbincangan kumpulan tentang pelbagai aspek seksualiti.

https://sites.google.com/view/neurips2022-frfm-turotial

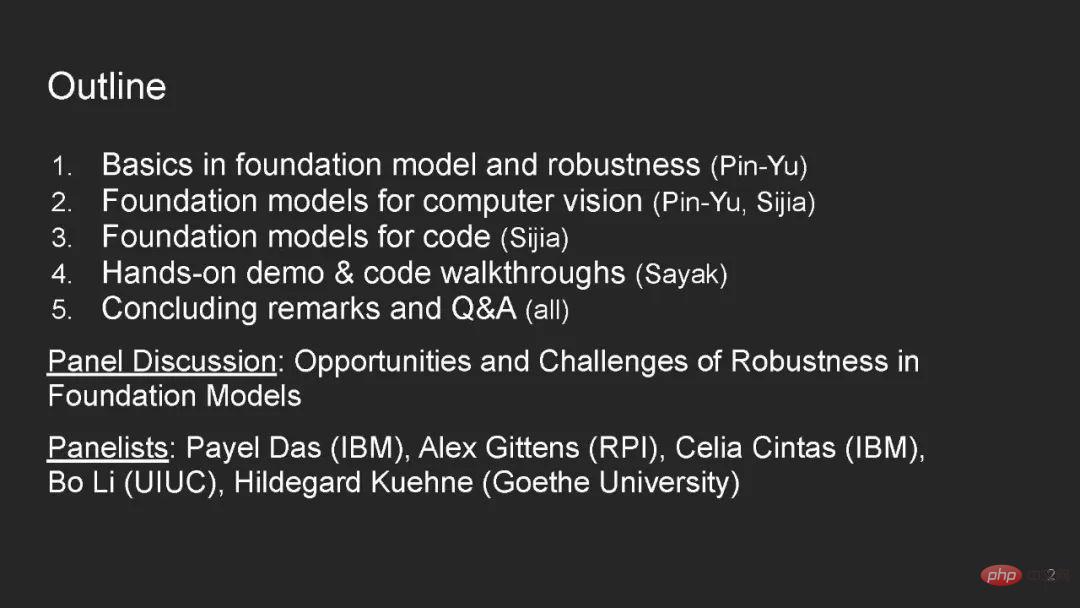

Kandungan direktori:

- Asas dalam model asas dan keteguhan

- Selam mendalam pada model asas untuk penglihatan komputer

- Selam dalam model asas untuk kod

- Panduan kod praktikal

- Ucapan Penutup

- S&J

- Perbincangan panel

Speaker:

Sistem pembelajaran mesin dunia sebenar perlu teguh kepada perubahan pengedaran - mereka harus berfungsi dengan baik pada pengedaran ujian yang berbeza daripada pengedaran latihan.

Seperti peta kemiskinan bagi negara yang kurang sumber [Xie et al 2016], kereta pandu sendiri [Yu et al. 2020a], Aplikasi berisiko tinggi seperti diagnosis perubatan [AlBadawy et al 2018; persekitaran yang berbeza, atau dari hospital yang berbeza.

Kerja terdahulu telah menunjukkan bahawa perubahan pengedaran ini boleh membawa kepada penurunan prestasi yang besar walaupun untuk model terkini [Blitzer et al 2006; al. 2007 dan Lempitsky et al. 2019; 2020b;

Model asas dilatih pada set data tidak berlabel yang besar dan pelbagai yang dijadikan sampel daripada pengedaran  dan kemudiannya boleh disesuaikan dengan banyak tugas hiliran.

dan kemudiannya boleh disesuaikan dengan banyak tugas hiliran.

Untuk setiap tugas hiliran  , model asas berada dalam pengedaran berlabel yang diambil sampel daripada pengedaran latihan

, model asas berada dalam pengedaran berlabel yang diambil sampel daripada pengedaran latihan  Latih terus data latihan (dalam pengedaran, ID), dan kemudian menilai pada pengedaran ujian luar pengedaran (OOD)

Latih terus data latihan (dalam pengedaran, ID), dan kemudian menilai pada pengedaran ujian luar pengedaran (OOD)  .

.

Sebagai contoh, model ramalan peta kemiskinan [Xie et al 2016] boleh mempelajari ciri berguna untuk semua negara dalam data satelit yang tidak berlabel di seluruh dunia, dan kemudian Penalaan halus dilakukan pada contoh berlabel dari Nigeria dan akhirnya dinilai di Malawi yang kekurangan contoh berlabel.

Kami percaya bahawa: 1) Model asas ialah pendekatan yang sangat menjanjikan dari segi keteguhan. Kerja sedia ada menunjukkan bahawa pralatihan pada data tidak berlabel ialah kaedah yang berkesan dan umum untuk meningkatkan ketepatan pada pengedaran ujian OOD, berbeza dengan banyak campur tangan kekukuhan yang terhad kepada perubahan pengedaran terhad.

Walau bagaimanapun, kami turut membincangkan 2) mengapa model asas mungkin tidak sentiasa menghadapi perubahan pengedaran, seperti sesetengahnya disebabkan korelasi palsu atau perubahan pengedaran dari semasa ke semasa.

Akhir sekali, 3) kami menggariskan beberapa hala tuju penyelidikan yang mengeksploitasi dan meningkatkan keteguhan model asas.

Kami ambil perhatian bahawa satu cara untuk model asas meningkatkan prestasi tugasan hiliran ialah menyediakan model yang disesuaikan dengan bias induktif (melalui permulaan model) yang berada di luar data latihan hiliran dipelajari pada pelbagai set data.

Walau bagaimanapun, kecenderungan induktif yang sama juga mungkin mengekodkan perkaitan yang merosakkan daripada data pra-latihan dan membawa kepada perwakilan dan kemudaratan tugasan dengan adanya perubahan pengedaran.

Atas ialah kandungan terperinci Sejauh manakah model besar boleh dipercayai? Tutorial terbaharu IBM dan sarjana lain tentang 'Kekukuhan Asas Model Asas'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI