Rumah >Peranti teknologi >AI >Adakah penggantian ChatGPT sumber terbuka Meta mudah digunakan? Keputusan ujian dan kaedah pengubahsuaian telah dikeluarkan, 5.2k bintang dalam 2 hari

Adakah penggantian ChatGPT sumber terbuka Meta mudah digunakan? Keputusan ujian dan kaedah pengubahsuaian telah dikeluarkan, 5.2k bintang dalam 2 hari

- PHPzke hadapan

- 2023-04-11 22:25:011312semak imbas

Kepopularan berterusan ChatGPT telah membuatkan syarikat teknologi utama resah.

Baru seminggu yang lalu, Meta "bersumberkan terbuka" siri model besar baharu - LLaMA(Large Language Model Meta AI), bilangan parameter berjulat dari 7 bilion hingga 65 bilion. Oleh kerana LLaMA mempunyai parameter yang lebih sedikit tetapi prestasi yang lebih baik daripada kebanyakan model besar yang dikeluarkan sebelum ini, ramai penyelidik teruja apabila ia dikeluarkan.

Sebagai contoh, model LLaMA 13 bilion parameter boleh mengatasi 175 bilion parameter GPT-3 "pada kebanyakan penanda aras" dan boleh dijalankan pada satu GPU V100 Model LLaMA terbesar dengan 65 bilion parameter adalah setanding dengan Chinchilla-70B dan PaLM-540B Google.

Pengurangan dalam bilangan parameter adalah perkara yang baik untuk penyelidik biasa dan organisasi komersial, tetapi adakah LLaMA benar-benar berprestasi sebaik yang dikatakan oleh kertas kerja? Berbanding dengan ChatGPT semasa, bolehkah LLaMA hampir tidak bersaing? Untuk menjawab soalan-soalan ini, beberapa penyelidik telah menguji model ini.

Sesetengah syarikat sudah cuba untuk memperbaiki kelemahan LLaMA dan ingin melihat sama ada mereka boleh menjadikan LLaMA berprestasi lebih baik dengan menambah kaedah latihan seperti RLHF.

Semakan Awal LLaMA

Ulasan ini datang daripada pengarang Sederhana bernama @Enryu. Ia membandingkan prestasi LLaMA dan ChatGPT pada tiga tugas mencabar tafsiran jenaka, klasifikasi sifar pukulan dan penjanaan kod. Catatan blog yang berkaitan ialah "Mini-post: first look at LLaMA".

Pengarang menjalankan versi LLaMA 7B/13B pada RTX 3090/RTX 4090 dan versi 33B pada A100 tunggal.

Perlu diambil perhatian bahawa tidak seperti ChatGPT, model lain tidak berdasarkan penalaan halus arahan, jadi struktur prompt adalah berbeza.

Menjelaskan Jenaka

Ini ialah kes penggunaan yang ditunjukkan dalam kertas PaLM asal Google: diberi jenaka, biarlah Model untuk menerangkan mengapa ia lucu. Misi ini memerlukan gabungan pengetahuan dunia dan beberapa logik asas. Semua model sebelum PaLM tidak dapat melakukan ini. Penulis mengekstrak beberapa contoh daripada kertas PaLM dan membandingkan prestasi LLaMA-7B, LLaMA-13B, LLaMA-33B dengan ChatGPT.

Seperti yang anda lihat, hasilnya adalah dahsyat. Model ini mendapat sedikit ketawa tetapi tidak begitu faham, mereka hanya menjana beberapa aliran teks yang berkaitan secara rawak. Walaupun ChatGPT berprestasi buruk seperti LLaMA-33B (beberapa model lain lebih teruk), ia mengikut strategi yang berbeza: ia menghasilkan banyak teks, dengan harapan bahawa sekurang-kurangnya beberapa jawapannya adalah betul (tetapi kebanyakannya jelas Tidak) , adakah ia hampir sama dengan strategi setiap orang untuk menjawab soalan semasa peperiksaan?

Walau bagaimanapun, ChatGPT sekurang-kurangnya mendapat jenaka tentang Schmidthuber. Tetapi secara keseluruhan, prestasi model ini pada tugas tafsiran jenaka sampel sifar adalah jauh daripada PaLM (melainkan contoh PaLM dipilih dengan teliti).

Pengkelasan sampel sifar

Tugas kedua yang dipertimbangkan oleh pengarang adalah lebih mencabar - clickbait )Pengkelasan. Memandangkan manusia pun tidak boleh bersetuju tentang apa itu clickbait, pengarang memberikan beberapa contoh untuk model ini dalam gesaan (jadi sebenarnya sampel kecil dan bukannya sampel sifar). Berikut ialah gesaan LLaMa:

I will tell whether the following news titles are clickbait: 1) The WORST care homes in England: Interactive map reveals the lowest-rated 2,530 residences - so is there one near you? Clickbait: yes 2) Netflix's top 10 most-watched movies of all time Clickbait: yes 3) Peering Through the Fog of Inflation Clickbait: no 4) You’ll never believe which TV cook this cheeky chap grew up to be Clickbait: yes

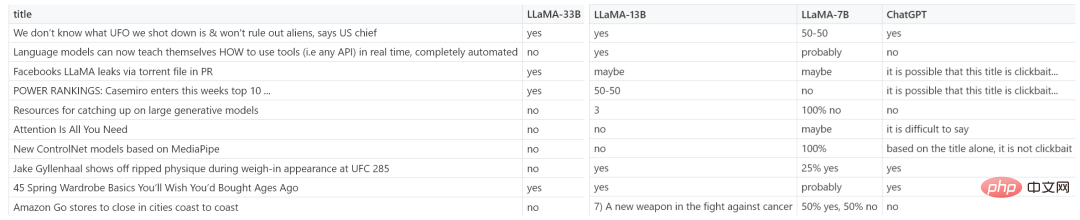

Gambar di bawah menunjukkan lebih banyak contoh hasil LLaMA-7B, LLaMA-13B, LLaMA-33B dan ChatGPT.

很明显,赢家为 LLaMA-33B,它是唯一一个能够遵循所有请求格式(yes/no)的模型,并且预测合理。ChatGPT 也还可以,但有些预测不太合理,格式也有错误。较小的模型(7B/13B)不适用于该任务。

代码生成

虽然 LLM 擅长人文学科,但在 STEM 学科上表现糟糕。LLaMA 虽然有基准测试结果,但作者在代码生成领域尝试了一些特别的东西,即将人类语言零样本地转换为 SQL 查询。这并不是很实用,在现实生活中直接编写查询会更有效率。这里只作为代码生成任务的一个示例。

在 prompt 中,作者提供表模式(table schema)以及想要实现的目标,要求模型给出 SQL 查询。如下为一些随机示例,老实说,ChatGPT 看起来效果更好。

-- We have a table `events` with columns `event_id`, `timestamp`, `user_id`, `rpc_method`. -- We want to count how many users issued request "Login" over the last week. -- SQL query for this is: -- 7b SELECT count (*) FROM events WHERE user_id IN (SELECT user_id FROM events WHERE timestamp >= NOW () - INTERVAL 7 DAY) AND rpc_method = 'Login'; -- 13b SELECT COUNT (*) FROM events WHERE rpc_method = "Login" AND UNIX_TIMESTAMP (timestamp) >= UNIX_TIMESTAMP (CURRENT_DATE - INTERVAL 7 DAY) -- 33b SELECT user_id, COUNT (DISTINCT user_id) AS total FROM events WHERE timestamp BETWEEN TIMESTAMP '2013-08-14 00:00:00' AND TIMESTAMP '2013-08-21 00:00:00' AND rpc_method = 'Login' GROUP BY user_id -- ChatGPT SELECT COUNT (DISTINCT user_id) FROM events WHERE rpc_method = 'Login' AND timestamp >= DATE_SUB (NOW (), INTERVAL 1 WEEK);

从测试结果来看,LLaMA 在一些任务上表现还不错,但在另一些任务上和 ChatGPT 还有一些差距。如果能像 ChatGPT 一样加入一些「训练秘籍」,效果会不会大幅提升?

加入 RLHF,初创公司 Nebuly AI 开源 ChatLLaMA 训练方法

虽然 LLaMA 发布之初就得到众多研究者的青睐,但是少了 RLHF 的加持,从上述评测结果来看,还是差点意思。

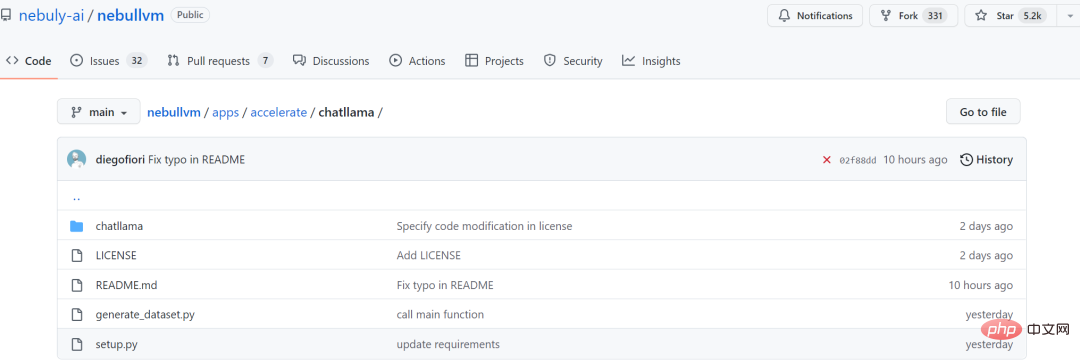

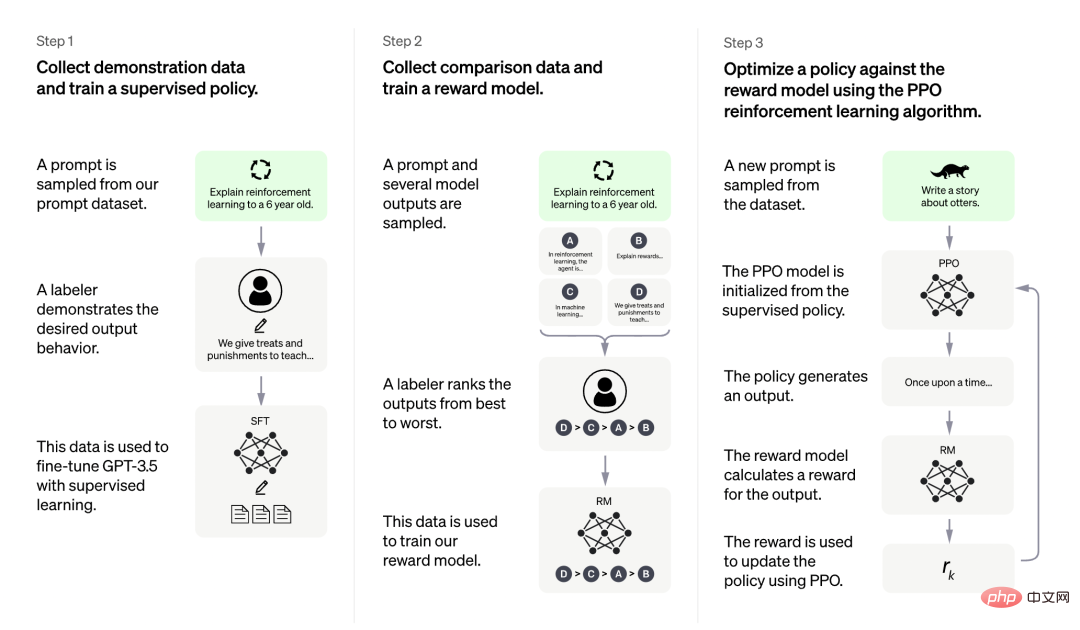

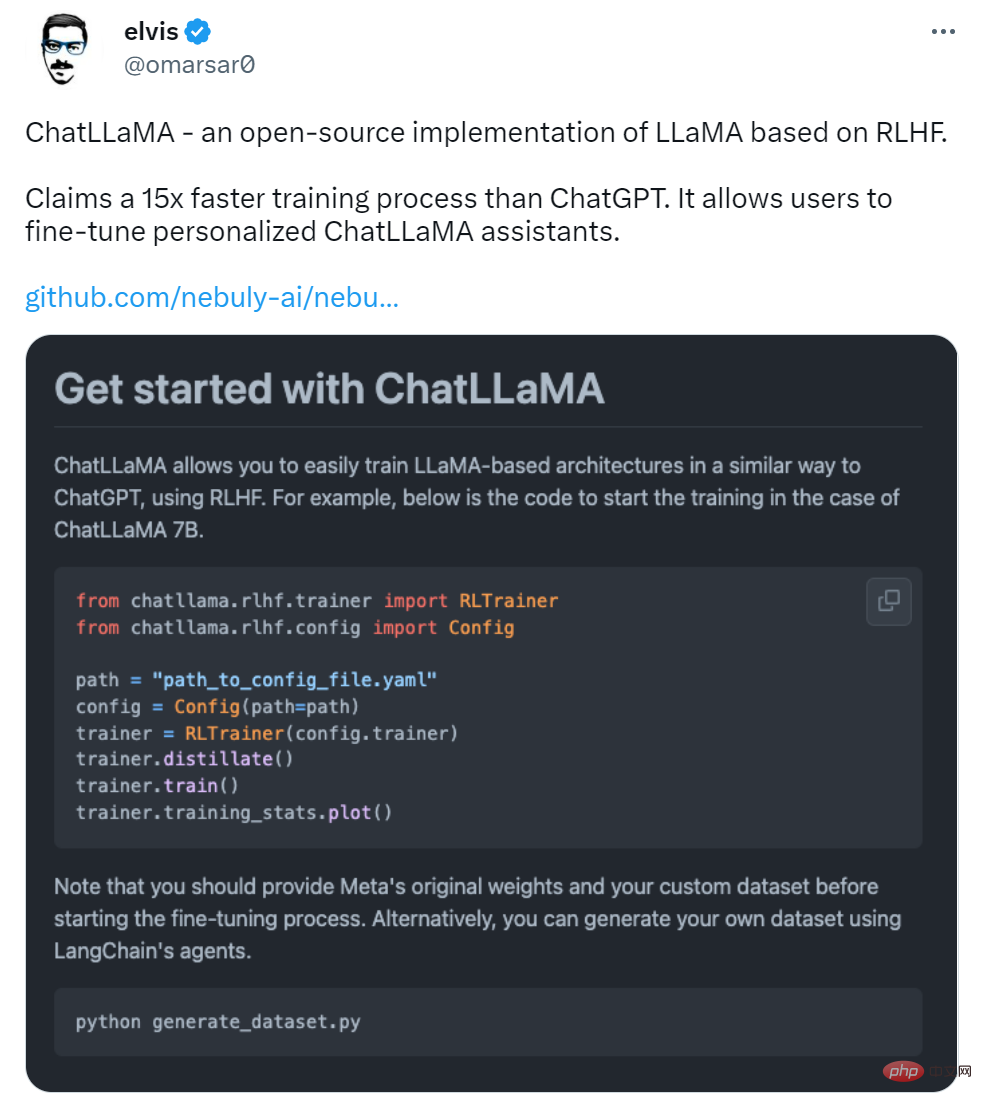

在 LLaMA 发布三天后,初创公司 Nebuly AI 开源了 RLHF 版 LLaMA(ChatLLaMA)的训练方法。它的训练过程类似 ChatGPT,该项目允许基于预训练的 LLaMA 模型构建 ChatGPT 形式的服务。项目上线刚刚 2 天,狂揽 5.2K 星。

项目地址:https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

ChatLLaMA 训练过程算法实现主打比 ChatGPT 训练更快、更便宜,我们可以从以下四点得到验证:

- ChatLLaMA 是一个完整的开源实现,允许用户基于预训练的 LLaMA 模型构建 ChatGPT 风格的服务;

- 与 ChatGPT 相比,LLaMA 架构更小,但训练过程和单 GPU 推理速度更快,成本更低;

- ChatLLaMA 内置了对 DeepSpeed ZERO 的支持,以加速微调过程;

- 该库还支持所有的 LLaMA 模型架构(7B、13B、33B、65B),因此用户可以根据训练时间和推理性能偏好对模型进行微调。

图源:https://openai.com/blog/chatgpt

更是有研究者表示,ChatLLaMA 比 ChatGPT 训练速度最高快 15 倍。

不过有人对这一说法提出质疑,认为该项目没有给出准确的衡量标准。

项目刚刚上线 2 天,还处于早期阶段,用户可以通过以下添加项进一步扩展:

- 带有微调权重的 Checkpoint;

- 用于快速推理的优化技术;

- 支持将模型打包到有效的部署框架中。

Nebuly AI 希望更多人加入进来,创造更高效和开放的 ChatGPT 类助手。

该如何使用呢?首先是使用 pip 安装软件包:

pip install chatllama-py

然后是克隆 LLaMA 模型:

git clone https://github.com/facebookresearch/llama.gitcd llama pip install -r requirements.txt pip install -e .

一切准备就绪后,就可以运行了,项目中介绍了 ChatLLaMA 7B 的训练示例,感兴趣的小伙伴可以查看原项目。

Atas ialah kandungan terperinci Adakah penggantian ChatGPT sumber terbuka Meta mudah digunakan? Keputusan ujian dan kaedah pengubahsuaian telah dikeluarkan, 5.2k bintang dalam 2 hari. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI