Rumah >Peranti teknologi >AI >Koleksi Transformer paling lengkap dalam sejarah! LeCun mengesyorkan: Buat katalog untuk 60 model kertas yang manakah anda terlepas?

Koleksi Transformer paling lengkap dalam sejarah! LeCun mengesyorkan: Buat katalog untuk 60 model kertas yang manakah anda terlepas?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 21:22:011072semak imbas

Jika ada sesuatu yang menyokong pembangunan model berskala besar dalam beberapa tahun kebelakangan ini, ia mestilah Transformer!

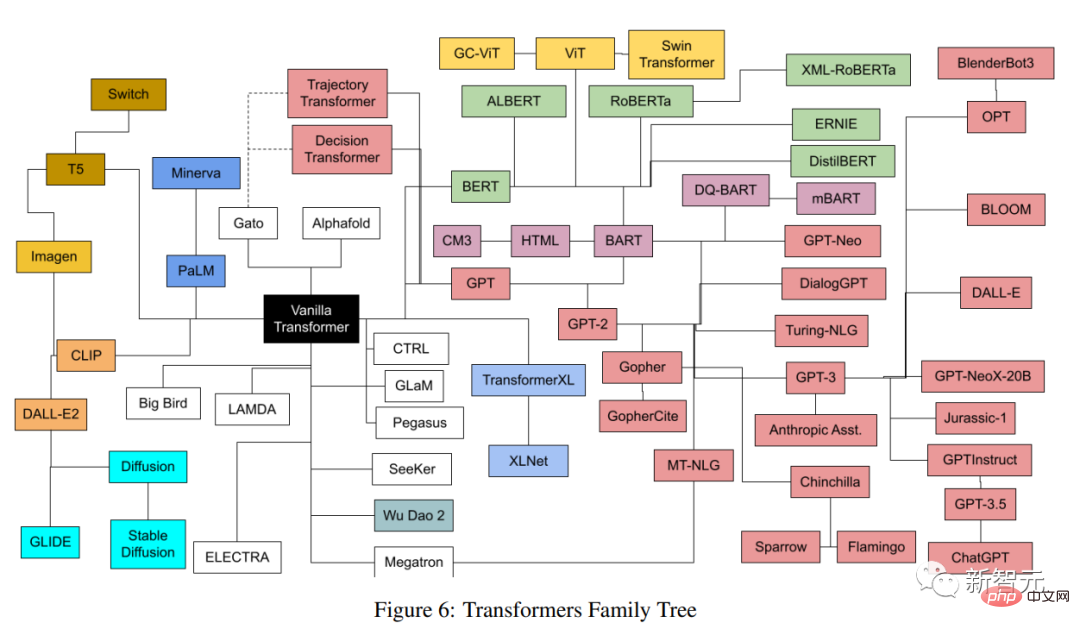

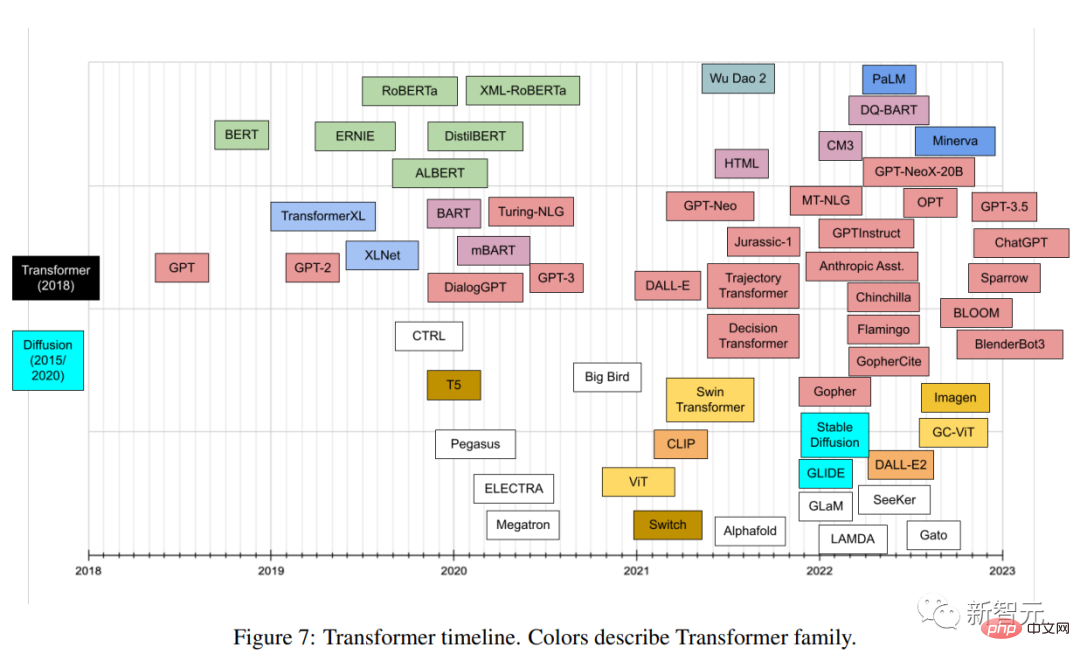

Berdasarkan Transformer, sejumlah besar model muncul dalam pelbagai bidang Setiap model mempunyai seni bina yang berbeza, butiran yang berbeza dan nama yang tidak mudah untuk dijelaskan.

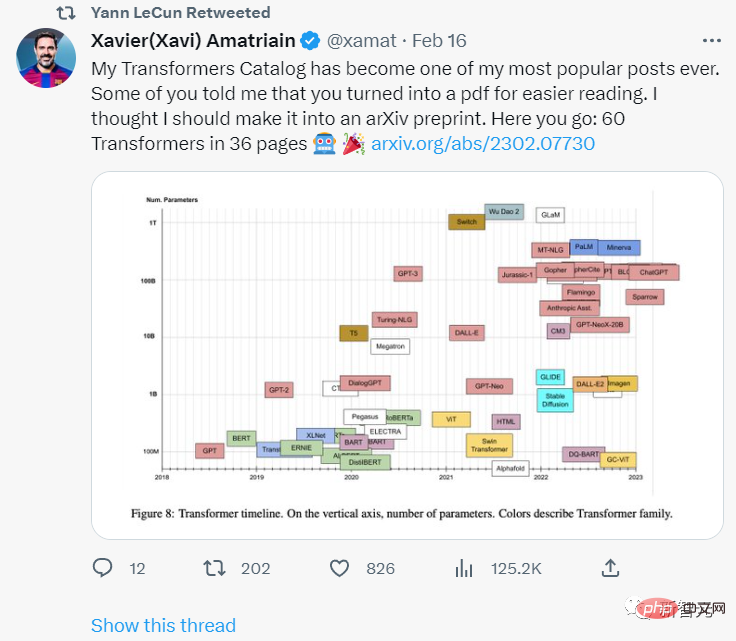

Baru-baru ini, seorang pengarang telah menjalankan klasifikasi komprehensif bagi semua model Transformer popular yang dikeluarkan dalam beberapa tahun dan indeks , cuba sediakan katalog yang komprehensif tetapi ringkas Artikel tersebut termasuk pengenalan kepada inovasi Transformer dan semakan proses pembangunan.

Pautan kertas: https://arxiv.org/pdf/2302.07730.pdf

Pemenang Anugerah Turing Yann LeCun menyatakan persetujuannya.

Penulis artikel, Xavier (Xavi) Amatriain, berkelulusan PhD dari Universiti Pompeu Fabra di Sepanyol di 2005 dan kini merupakan Naib Presiden Kejuruteraan LinkedIn Jabatan, bertanggungjawab terutamanya untuk strategi kecerdasan buatan produk.

Apakah itu Transformer?

Transformer ialah sejenis model pembelajaran mendalam dengan beberapa ciri seni bina yang unik. Ia pertama kali muncul dalam kertas terkenal "Attention is All you Need" yang diterbitkan oleh penyelidik Google pada tahun 2017. Kertas itu diterbitkan dalam In. hanya 5 tahun, ia telah mengumpul 38,000 petikan yang menakjubkan.

Seni bina Transformer juga tergolong dalam model penyahkod pengekod (penyahkod-pengekod), tetapi dalam model sebelumnya, perhatian hanyalah satu daripada mekanisme, dan kebanyakannya adalah berdasarkan LSTM (Memori Jangka Pendek Panjang) dan varian lain RNN (Rangkaian Neural Berulang).

Pandangan utama kertas kerja yang mencadangkan Transformer ialah, seperti yang dikatakan tajuk, mekanisme perhatian boleh digunakan sebagai satu-satunya mekanisme untuk memperoleh pergantungan antara input dan output tidak berhasrat untuk Untuk mendalami semua butiran seni bina Transformer, rakan-rakan yang berminat boleh mencari di blog "The Illustrated Transformer".

Pautan blog: https://jalammar.github.io/illustrated-transformer/

Hanya beberapa komponen terpenting diterangkan secara ringkas di bawah.

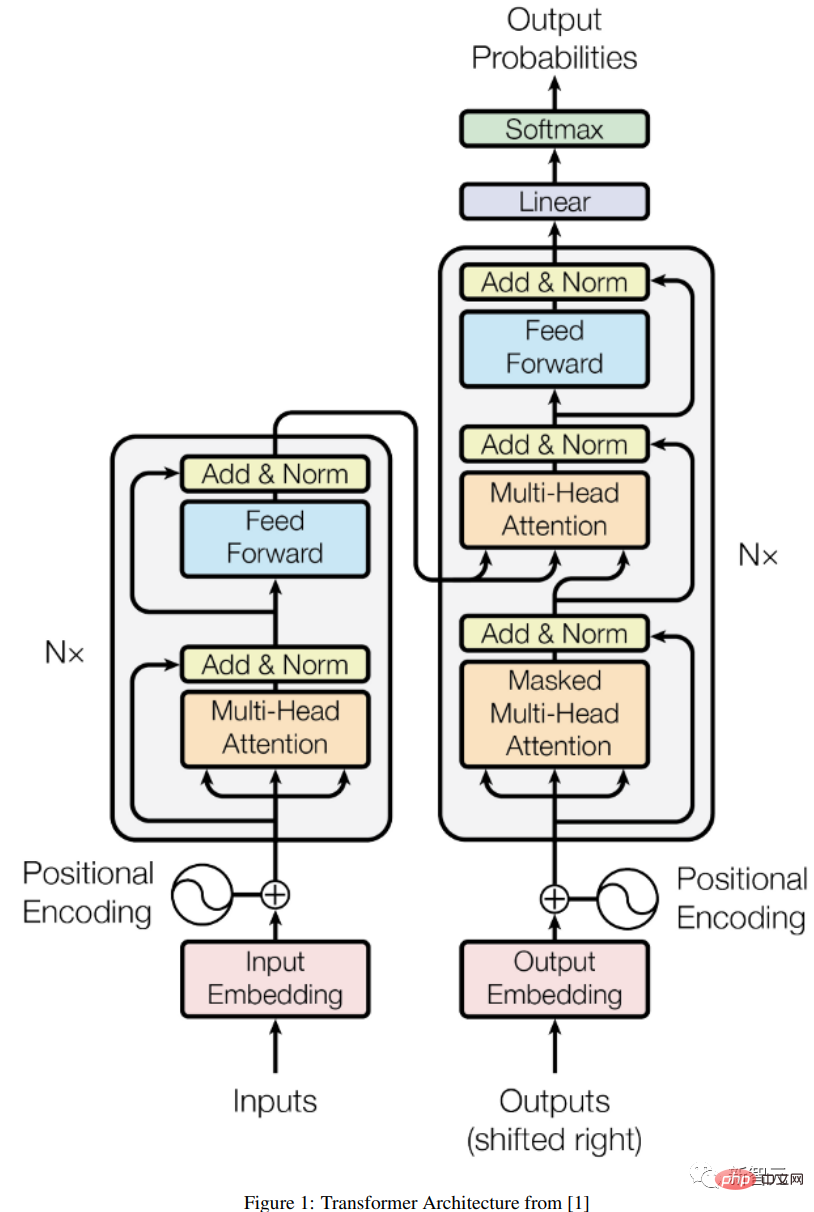

Seni Bina Pengekod-Penyahkod

A Umum seni bina pengekod/penyahkod terdiri daripada dua model, pengekod mengambil input dan mengekodnya menjadi vektor panjang tetap;

Pengekod dan penyahkod dilatih bersama untuk meminimumkan kemungkinan log bersyarat. Setelah dilatih, pengekod/penyahkod boleh menjana output berdasarkan urutan input yang diberikan, atau ia boleh menjaringkan sepasang urutan input/output.

Di bawah seni bina Transformer yang asal, kedua-dua pengekod dan penyahkod mempunyai 6 lapisan yang sama Dalam setiap 6 lapisan ini, pengekod mempunyai dua sub-lapisan: lapisan perhatian berbilang kepala dan rangkaian suapan hadapan mudah. dengan satu sambungan baki dan satu penormalan lapisan untuk setiap sub-lapisan.

Saiz output pengekod ialah 512, dan penyahkod menambah sublapisan ketiga, iaitu satu lagi lapisan perhatian berbilang kepala pada output pengekod. Di samping itu, satu lagi lapisan berbilang kepala dalam penyahkod ditutup untuk mengelakkan kebocoran maklumat daripada memberi perhatian kepada kedudukan seterusnya.

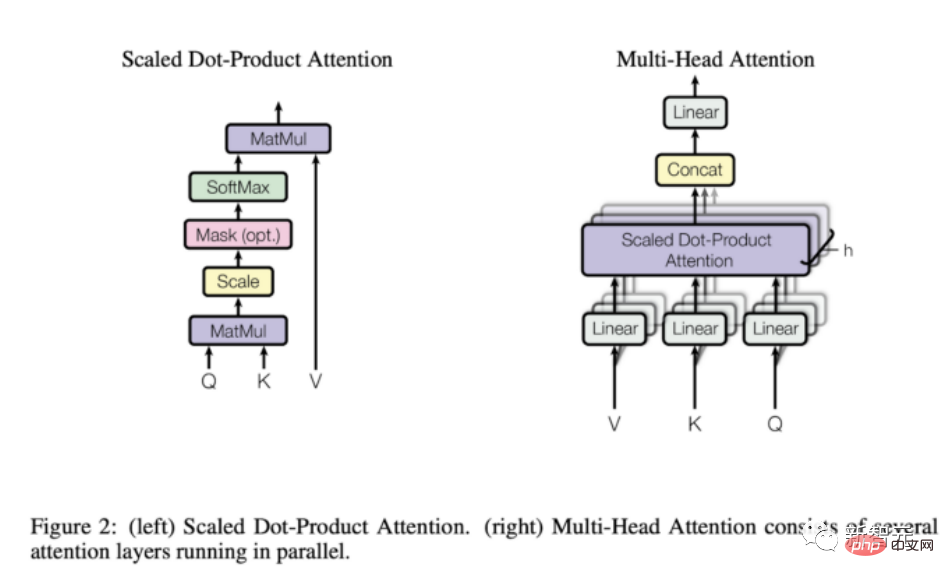

Mekanisme perhatian

Daripada penerangan di atas Sebagai dapat dilihat, satu-satunya elemen "pelik" dalam struktur model ialah perhatian lembu jantan, dan di sinilah letaknya keseluruhan kuasa model.

Fungsi perhatian ialah pemetaan antara pertanyaan dan set pasangan nilai kunci kepada output dikira sebagai jumlah nilai berwajaran, di mana berat diberikan kepada setiap satu nilai diberikan oleh Dikira oleh fungsi keserasian antara pertanyaan dan kunci yang sepadan.

Transformer menggunakan perhatian berbilang kepala, iaitu pengiraan selari bagi satu set fungsi perhatian, juga dikenali sebagai perhatian produk titik skala.

Berbanding dengan rangkaian berulang dan konvolusi, lapisan perhatian mempunyai beberapa kelebihan yang lebih penting ialah kerumitan pengiraan yang lebih rendah dan ketersambungan yang lebih tinggi, yang sangat baik untuk urutan pembelajaran -bergantungan jangka dalam .

Apa yang Transformer boleh lakukan? Mengapa ia menjadi popular?

Transformer asal direka untuk terjemahan bahasa, terutamanya daripada bahasa Inggeris ke Jerman, tetapi versi pertama kertas kerja Keputusan eksperimen telah menunjukkan bahawa seni bina dapat digeneralisasikan dengan baik kepada tugas bahasa lain.

Arah aliran tertentu ini disedari dengan cepat oleh komuniti penyelidik.

Dalam beberapa bulan akan datang, penarafan mana-mana tugasan ML berkaitan bahasa akan diduduki sepenuhnya oleh beberapa versi seni bina Transformer, seperti Skuad tugasan soal jawab tidak lama lagi. dibunuh oleh pelbagai model Transformer.

Salah satu sebab utama mengapa Transofrmer boleh menduduki kebanyakan kedudukan NLP dengan begitu cepat ialah: keupayaan mereka untuk menyesuaikan diri dengan pantas kepada tugas lain, iaitu, memindahkan model Transformer yang telah dilatih; sangat Mudah dan cepat menyesuaikan diri dengan tugas yang mereka belum dilatih, kelebihan yang besar berbanding model lain.

Sebagai pengamal ML, anda tidak perlu lagi melatih model besar dari awal pada set data yang besar dan hanya menggunakan semula model pra-latihan pada tugas yang sedang dijalankan, mungkin hanya mengubahnya sedikit dengan set data yang lebih kecil.

Teknik khusus yang digunakan untuk menyesuaikan model pra-latihan kepada tugasan yang berbeza dipanggil penalaan halus.

Ternyata Transformers begitu mudah menyesuaikan diri dengan tugasan lain sehinggakan walaupun pada asalnya ia dibangunkan untuk tugasan yang berkaitan dengan bahasa, ia cepat menjadi berguna untuk tugasan lain, Daripada aplikasi visual atau audio dan muzik sepanjang jalan untuk bermain catur atau membuat matematik.

Sudah tentu, semua aplikasi ini tidak akan dapat dilakukan jika bukan kerana pelbagai alatan yang tersedia untuk sesiapa sahaja yang boleh menulis beberapa baris kod.

Bukan sahaja Transformer disepadukan dengan pantas ke dalam rangka kerja kecerdasan buatan utama (iaitu Pytorch dan TensorFlow), terdapat juga beberapa syarikat yang dibina sepenuhnya untuk Transformer.

Huggingface, sebuah syarikat permulaan yang telah mengumpul lebih $60 juta setakat ini, dibina hampir keseluruhannya berdasarkan idea untuk mengkomersialkan perpustakaan Transformer sumber terbuka mereka.

GPT-3 ialah model Transformer yang dilancarkan oleh OpenAI pada Mei 2020. Ia merupakan versi susulan GPT dan GPT-2 mereka yang terdahulu. Syarikat itu mencipta banyak heboh dengan memperkenalkan model itu dalam pracetak, mendakwa model itu sangat berkuasa sehingga mereka tidak layak untuk mengeluarkannya kepada dunia.

Selain itu, OpenAI bukan sahaja tidak mengeluarkan GPT-3, tetapi juga mencapai pengkomersilan melalui perkongsian yang sangat besar dengan Microsoft.

Kini, GPT-3 menyediakan sokongan teknikal asas untuk lebih daripada 300 aplikasi berbeza dan merupakan asas kepada strategi perniagaan OpenAI. Itu penting bagi syarikat yang telah menerima lebih daripada $1 bilion dalam pembiayaan.

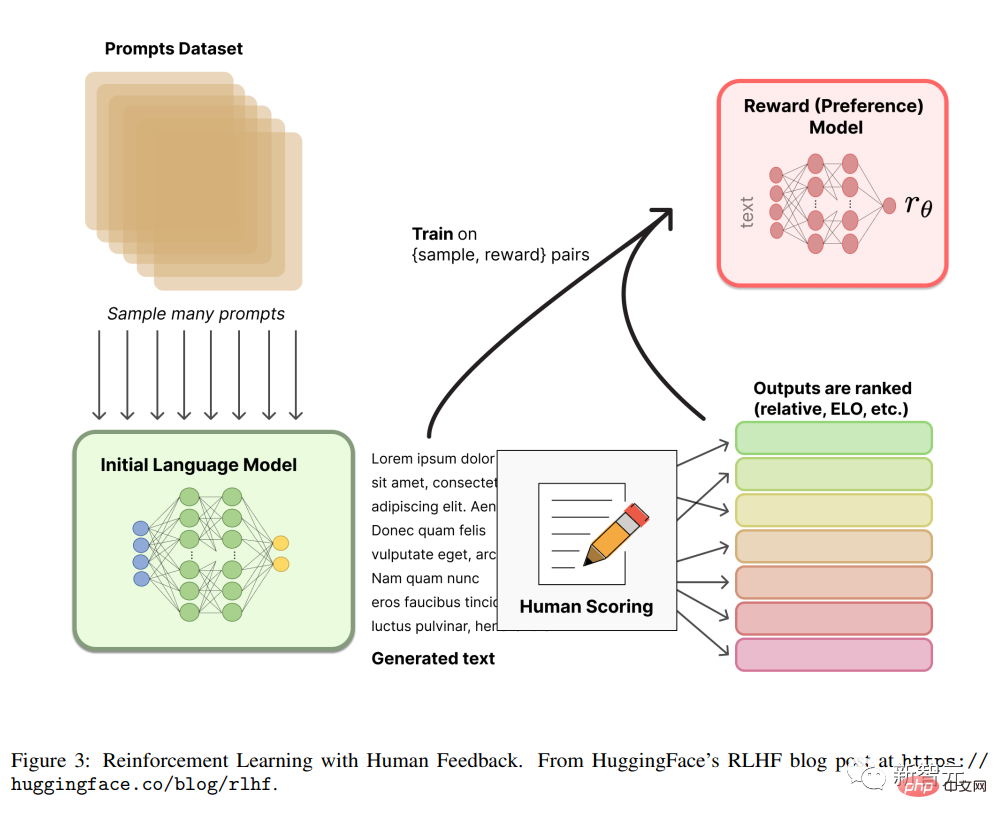

RLHF

Daripada maklum balas manusia (atau pilihan ), juga dikenali sebagai RLHF (atau RLHP), baru-baru ini telah menjadi tambahan besar kepada kotak alat kecerdasan buatan.

Konsep ini pertama kali datang daripada kertas kerja 2017 "Pembelajaran Pengukuhan Mendalam daripada Keutamaan Manusia", tetapi baru-baru ini ia telah digunakan untuk ChatGPT dan ejen perbualan yang serupa, dan telah mencapai keputusan yang agak baik Kesannya telah menarik perhatian orang ramai lagi.

Idea dalam artikel sangat mudah setelah model bahasa dilatih, ia boleh menghasilkan kesan yang berbeza pada dialog dan meminta manusia menetapkan keputusan, kedudukan ini (juga dikenali sebagai keutamaan atau maklum balas) boleh digunakan untuk melatih ganjaran menggunakan mekanisme pembelajaran pengukuhan.

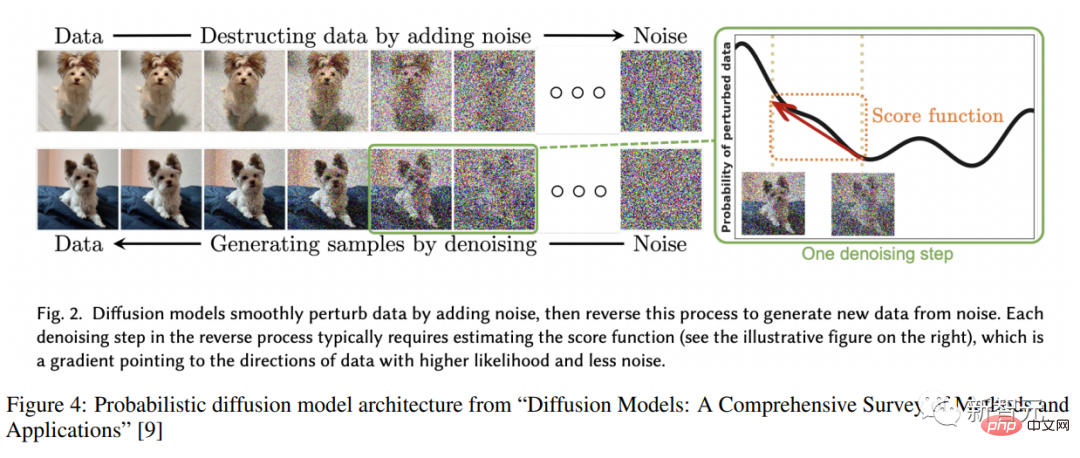

Resapan model resapan

Model resapan mempunyai menjadi SOTA baharu untuk penjanaan imej mempunyai kecenderungan untuk menggantikan GAN (Generative Adversarial Networks).

Model resapan ialah sejenis model pembolehubah pendam terlatih bagi inferens variasi Secara praktikalnya, ini bermakna melatih rangkaian saraf dalam untuk menggunakan fungsi hingar tertentu Imej kabur dinafikan.

Rangkaian yang dilatih dengan cara ini sebenarnya sedang mempelajari ruang terpendam yang diwakili oleh imej ini.

Selepas membaca pengenalan, mulakan Perjalanan retrospektif Transformer!

Atas ialah kandungan terperinci Koleksi Transformer paling lengkap dalam sejarah! LeCun mengesyorkan: Buat katalog untuk 60 model kertas yang manakah anda terlepas?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI