Rumah >Peranti teknologi >AI >Sepuluh soalan temu bual biasa untuk metrik penilaian pembelajaran mesin

Sepuluh soalan temu bual biasa untuk metrik penilaian pembelajaran mesin

- WBOYke hadapan

- 2023-04-11 20:58:021595semak imbas

Metrik penilaian ialah metrik kuantitatif yang digunakan untuk menilai prestasi model pembelajaran mesin. Mereka menyediakan cara yang sistematik dan objektif untuk membandingkan model yang berbeza dan mengukur kejayaan mereka dalam menyelesaikan masalah tertentu. Dengan membandingkan keputusan model yang berbeza dan menilai prestasinya, anda boleh membuat keputusan yang tepat tentang model yang hendak digunakan, cara menambah baik model sedia ada dan cara mengoptimumkan prestasi tugasan yang diberikan, jadi metrik penilaian memainkan peranan penting dalam pembangunan dan penggunaan model pembelajaran mesin peranan penting. Oleh itu, penunjuk penilaian adalah soalan asas yang sering ditanya semasa temu bual Artikel ini telah menyusun 10 soalan biasa.

1 Bolehkah anda terangkan perbezaan antara ketepatan dan ingat semula dalam konteks pembelajaran mesin

Dalam model pembelajaran mesin, ketepatan dan Ingat semula adalah dua perkara biasa menggunakan metrik penilaian. Ketepatan ialah ukuran bilangan ramalan positif benar yang dibuat oleh model daripada semua ramalan positif, yang menunjukkan keupayaan model untuk mengelakkan ramalan positif palsu.

Ketepatan = TP/TP+FP

Imbas kembali ialah ukuran bilangan ramalan sebenar yang dibuat oleh model merentas semua kejadian positif sebenar dalam set data. Recall mewakili keupayaan model untuk mengenal pasti semua kejadian positif dengan betul.

Imbas Balik = TP/TP+FN

Kedua-dua ketepatan dan penarikan balik adalah metrik penilaian yang penting, tetapi pertukaran antara kedua-duanya bergantung pada keperluan masalah khusus untuk diselesaikan. Contohnya, dalam diagnosis perubatan, ingat mungkin lebih penting kerana adalah penting untuk mengenal pasti semua kes penyakit, walaupun jika ini menghasilkan kadar positif palsu yang lebih tinggi. Tetapi dalam pengesanan penipuan, ketepatan mungkin lebih penting, kerana mengelakkan tuduhan palsu adalah penting, walaupun ini menghasilkan kadar negatif palsu yang lebih tinggi.

2. Bagaimana untuk memilih metrik penilaian yang sesuai untuk masalah yang diberikan

Memilih penilaian yang sesuai untuk masalah tertentu adalah aspek utama proses pembangunan model. Apabila memilih penunjuk, adalah penting untuk mempertimbangkan sifat masalah dan matlamat analisis. Beberapa faktor biasa yang perlu dipertimbangkan termasuk:

Jenis masalah: Adakah masalah klasifikasi binari, masalah klasifikasi berbilang kelas, masalah regresi atau sesuatu yang lain

Matlamat perniagaan: Apakah itu matlamat akhir analisis, Apakah prestasi yang diperlukan Contohnya, jika matlamatnya adalah untuk meminimumkan negatif palsu, ingat akan menjadi metrik yang lebih penting daripada ketepatan.

Ciri set data: Adakah kelas seimbang atau tidak seimbang Adakah set data besar atau kecil

Kualiti data: Apakah kualiti data, berapa banyak bunyi yang terdapat dalam set data? ?

Berdasarkan faktor ini, anda boleh memilih indeks penilaian, seperti ketepatan, F1-skor, AUC-ROC, Precision-Recall, ralat min kuasa dua, dsb. Tetapi adalah perkara biasa untuk menggunakan pelbagai metrik penilaian untuk mendapatkan pemahaman lengkap tentang prestasi model.

3. Bolehkah anda memperkenalkan penggunaan skor F1

Skor F1 ialah indeks penilaian yang biasa digunakan dalam pembelajaran mesin, digunakan untuk mengimbangi ketepatan dan mengingat semula. Ketepatan mengukur perkadaran pemerhatian positif daripada semua ramalan positif yang dibuat oleh model, manakala ingat kembali mengukur perkadaran ramalan positif daripada semua pemerhatian positif sebenar. Skor F1 ialah min harmonik ketepatan dan ingatan semula dan sering digunakan sebagai metrik tunggal untuk meringkaskan prestasi pengelas binari.

F1 = 2 * (Precision * Recall) / (Precision + Recall)

Dalam situasi di mana model mesti membuat pertukaran antara ketepatan dan ingat semula, skor F1 adalah lebih baik daripada menggunakan ketepatan sahaja atau ingat semula memberikan penilaian prestasi yang lebih terperinci. Contohnya, dalam kes di mana ramalan positif palsu lebih mahal daripada ramalan negatif palsu, pengoptimuman ketepatan mungkin lebih penting, manakala dalam kes di mana ramalan negatif palsu lebih mahal, penarikan balik mungkin diutamakan. Skor F1 boleh digunakan untuk menilai prestasi model dalam senario ini dan menyediakan sokongan data yang sepadan tentang cara melaraskan ambangnya atau parameter lain untuk mengoptimumkan prestasi.

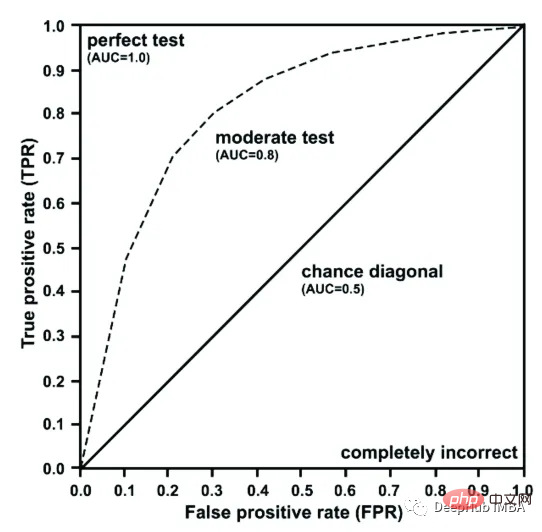

4. Bolehkah anda menerangkan sebab menggunakan keluk ROC dalam penilaian model

Keluk ROC ialah perwakilan grafik prestasi model klasifikasi binari yang memplotkan kadar positif sebenar ( TPR) lwn. Kadar positif palsu (FPR). Ia membantu menilai pertukaran antara kepekaan (positif sebenar) dan kekhususan (negatif sebenar) model, dan digunakan secara meluas untuk menilai model yang membuat ramalan berdasarkan hasil pengelasan binari (seperti ya atau tidak, lulus atau gagal, dsb. .).

Keluk ROC mengukur prestasi model dengan membandingkan keputusan ramalannya dengan keputusan sebenar. Model yang baik mempunyai kawasan yang besar di bawah lengkung ROC, yang bermaksud ia dapat membezakan dengan tepat antara kelas positif dan negatif. ROC AUC (Area Under the Curve, area under the curve) digunakan untuk membandingkan prestasi model yang berbeza, terutamanya cara yang baik untuk menilai prestasi model apabila kelas tidak seimbang.

5. Bagaimanakah cara untuk menentukan ambang optimum untuk model klasifikasi binari? Ini boleh dicapai dengan menggunakan metrik penilaian seperti skor F1, yang mengimbangi ketepatan dan ingat semula, atau menggunakan lengkung ROC, yang memplotkan kadar positif positif dan palsu sebenar untuk pelbagai ambang. Ambang optimum biasanya dipilih sebagai titik pada lengkung ROC yang paling hampir dengan penjuru kiri atas, kerana ini memaksimumkan kadar positif sebenar sambil meminimumkan kadar positif palsu. Dalam amalan, ambang optimum mungkin juga bergantung pada matlamat khusus masalah dan kos yang berkaitan dengan positif palsu dan negatif palsu.

6. Bolehkah anda memperkenalkan pertukaran berikut antara ketepatan dan penarikan balik dalam penilaian model

Pertukaran antara ketepatan dan penarikan balik dalam penilaian model merujuk kepada mengenal pasti kejadian positif dengan betul (kadar ingatan semula? ) dan mengenal pasti dengan betul hanya kejadian positif (ingat). Ketepatan tinggi bermaksud bilangan positif palsu yang rendah, manakala ingat semula yang tinggi bermakna bilangan negatif palsu yang rendah. Untuk model tertentu, selalunya mustahil untuk memaksimumkan ketepatan dan mengingat semula secara serentak. Untuk membuat pertukaran ini, seseorang perlu mempertimbangkan matlamat dan keperluan khusus masalah dan memilih metrik penilaian yang selaras dengannya.

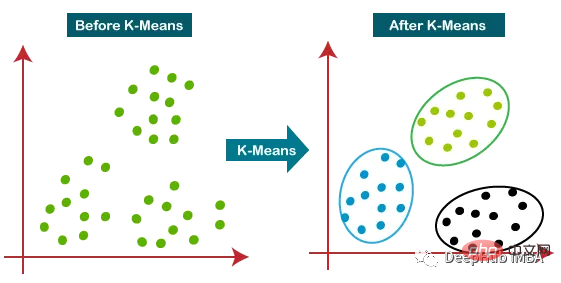

7. Bagaimana untuk menilai prestasi model pengelompokan

Prestasi model pengelompokan boleh dinilai menggunakan banyak penunjuk. Beberapa metrik biasa termasuk:

Skor Siluet: Ia mengukur persamaan kelompok yang diperhatikan dengan dirinya sendiri berbanding dengan kelompok lain. Markah berjulat dari -1 hingga 1, dengan nilai lebih hampir kepada 1 menunjukkan struktur pengelompokan yang lebih kukuh.- Indeks Calinski-Harabasz: Ia mengukur nisbah varians antara kelompok kepada varians dalam kelompok. Nilai yang lebih tinggi menunjukkan penyelesaian pengelompokan yang lebih baik.

- Indeks Davies-Bouldin: Ia mengukur purata persamaan antara setiap kluster dan klusternya yang paling serupa. Nilai yang lebih kecil menunjukkan penyelesaian pengelompokan yang lebih baik.

- Indeks Rand Terlaras: Ia mengukur persamaan antara label kelas sebenar dan label kelompok yang diramalkan, dilaraskan berdasarkan kebarangkalian. Nilai yang lebih tinggi menunjukkan penyelesaian pengelompokan yang lebih baik.

- Matriks Kekeliruan: Ia boleh menilai ketepatan model pengelompokan dengan membandingkan kelompok yang diramalkan dengan kelas sebenar.

Tetapi memilih metrik penilaian yang sesuai juga bergantung pada masalah khusus dan matlamat analisis kelompok.

Tetapi memilih metrik penilaian yang sesuai juga bergantung pada masalah khusus dan matlamat analisis kelompok.

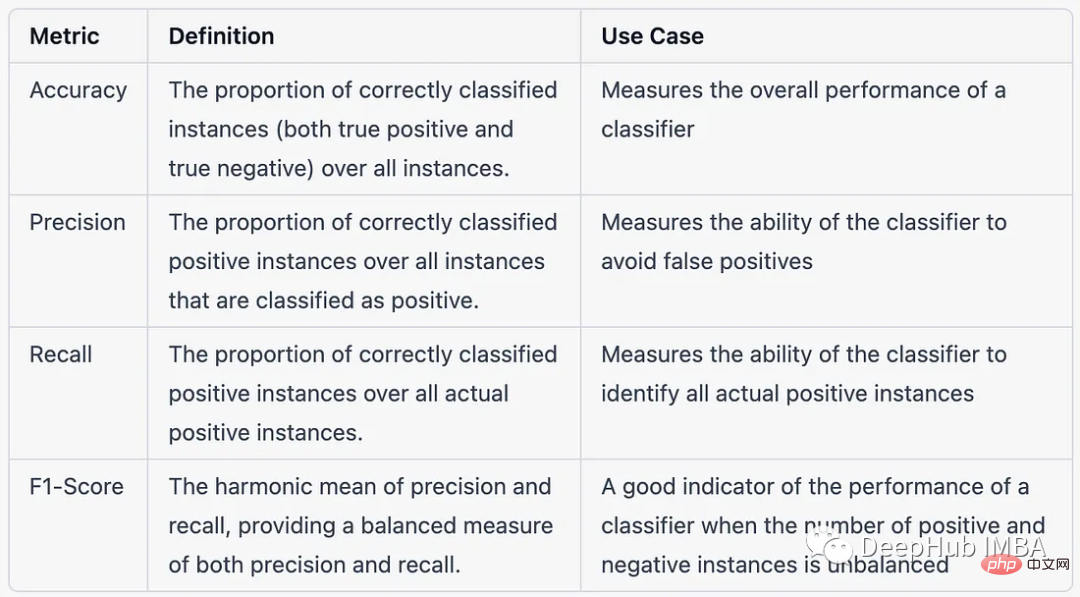

8 Dalam konteks masalah pengelasan berbilang kelas, perbezaan antara ketepatan, ketepatan, ingat kembali dan skor F1

Berikut adalah dalam konteks masalah pengelasan berbilang kelas, dalam bentuk jadual Bandingkan ketepatan, ketepatan, ingatan semula dan skor F1:

9 Bagaimana untuk menilai prestasi sistem pengesyoran?

9 Bagaimana untuk menilai prestasi sistem pengesyoran?

Menilai prestasi sistem pengesyoran termasuk mengukur Keberkesanan dan kecekapan sistem dalam mengesyorkan item yang berkaitan kepada pengguna. Beberapa metrik yang biasa digunakan untuk menilai prestasi sistem pengesyoran termasuk:

Ketepatan: perkadaran item disyorkan yang berkaitan dengan pengguna.- Imbas kembali: Perkadaran item berkaitan yang disyorkan oleh sistem.

- F1-Skor: Min harmonik ketepatan dan ingatan semula.

- Min Purata Ketepatan (MAP): Ukuran ketepatan purata keseluruhan pengguna sistem pengesyoran.

- Keuntungan Terkumpul Diskaun Normal (NDCG): Mengukur perkaitan berwajaran kedudukan item yang disyorkan.

- Root Mean Square Error (RMSE): Ukuran perbezaan antara penilaian yang diramalkan dan sebenar untuk set item.

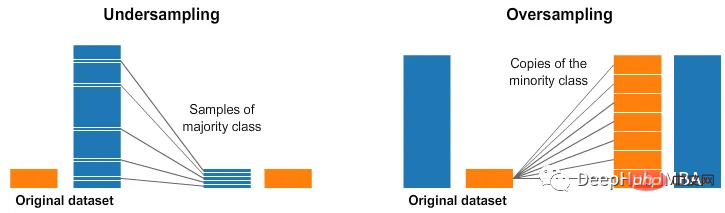

- 10. Bagaimana untuk menangani set data tidak seimbang semasa menilai prestasi model?

- Untuk menangani set data tidak seimbang dalam penilaian model, teknik berikut boleh digunakan:

- Gunakan metrik penilaian yang berbeza: Metrik seperti ketepatan, ingat semula, skor F1 dan kawasan di bawah lengkung ROC (AUC-ROC) adalah sensitif kepada ketidakseimbangan kelas dan boleh memahami dengan lebih baik prestasi model pada set data yang tidak seimbang prestasi.

- Gunakan pembelajaran sensitif kos: tetapkan kos kepada pelbagai jenis salah klasifikasi, seperti memperuntukkan kos yang lebih tinggi kepada negatif palsu daripada positif palsu, untuk menjadikan model lebih sensitif kepada kelas minoriti.

- Gunakan kaedah ensemble: Dengan menggabungkan hasil berbilang model, teknik seperti membungkus, meningkatkan dan menyusun boleh digunakan untuk meningkatkan prestasi model pada set data yang tidak seimbang.

- Kaedah hibrid: Gabungan teknik di atas boleh digunakan untuk mengendalikan set data yang tidak seimbang dalam penilaian model.

- Ringkasan

Metrik penilaian memainkan peranan penting dalam pembelajaran mesin Memilih metrik penilaian yang betul dan menggunakannya dengan sewajarnya adalah penting untuk memastikan kualiti dan Kebolehpercayaan adalah penting. Kerana ia pasti akan digunakan, ini adalah soalan yang sering ditanya dalam temu bual saya harap soalan yang disusun dalam artikel ini akan membantu anda.

Atas ialah kandungan terperinci Sepuluh soalan temu bual biasa untuk metrik penilaian pembelajaran mesin. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI