Rumah >Peranti teknologi >AI >Cara yang betul untuk bermain pembelajaran mendalam blok binaan! Universiti Nasional Singapura mengeluarkan DeRy, paradigma pembelajaran pemindahan baharu yang menukar pemindahan pengetahuan kepada percetakan jenis alih

Cara yang betul untuk bermain pembelajaran mendalam blok binaan! Universiti Nasional Singapura mengeluarkan DeRy, paradigma pembelajaran pemindahan baharu yang menukar pemindahan pengetahuan kepada percetakan jenis alih

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 20:43:012026semak imbas

Semasa zaman Qingli Renzong dalam Dinasti Song Utara 980 tahun yang lalu, revolusi pengetahuan sedang berlaku secara senyap-senyap di China.

Pencetus semua ini bukanlah kata-kata orang bijak yang tinggal di kuil, tetapi batu bata tanah liat dengan tulisan biasa yang dibakar sekeping demi sekeping.

Revolusi ini betul-betul "cetakan jenis alih".

Kehalusan percetakan jenis alih terletak pada idea "pemasangan blok bangunan": tukang mula-mula membuat acuan aksara terbalik bagi aksara tunggal, dan kemudian menambah aksara tunggal mengikut manuskrip Dipilih dan dicetak dengan dakwat, fon ini boleh digunakan seberapa banyak yang diperlukan.

Berbanding dengan proses rumit "satu cetakan, satu versi" cetakan kayu, Modular-Assemble on demand-Pelbagai kegunaan Ini mod kerja secara geometri meningkatkan kecekapan percetakan dan meletakkan asas untuk pembangunan dan pewarisan tamadun manusia selama beribu-ribu tahun.

Kembali ke bidang pembelajaran mendalam, hari ini dengan populariti model pra-latihan yang besar, cara memindahkan keupayaan satu siri model besar kepada tertentu tugas hiliran telah menjadi soalan Utama.

Kaedah pemindahan pengetahuan atau penggunaan semula sebelumnya adalah serupa dengan "pencetakan blok": kita selalunya perlu melatih model lengkap baharu mengikut keperluan tugas. Kaedah-kaedah ini selalunya disertai dengan kos latihan yang besar dan sukar untuk skala kepada sejumlah besar tugas.

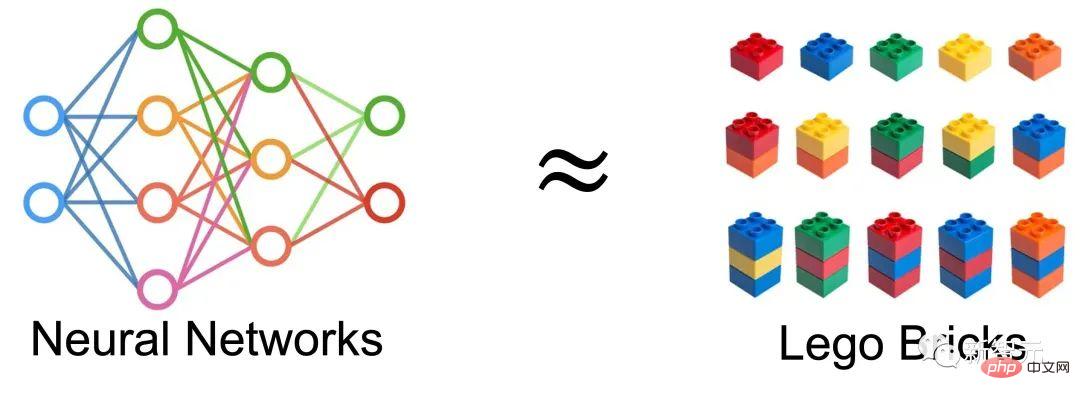

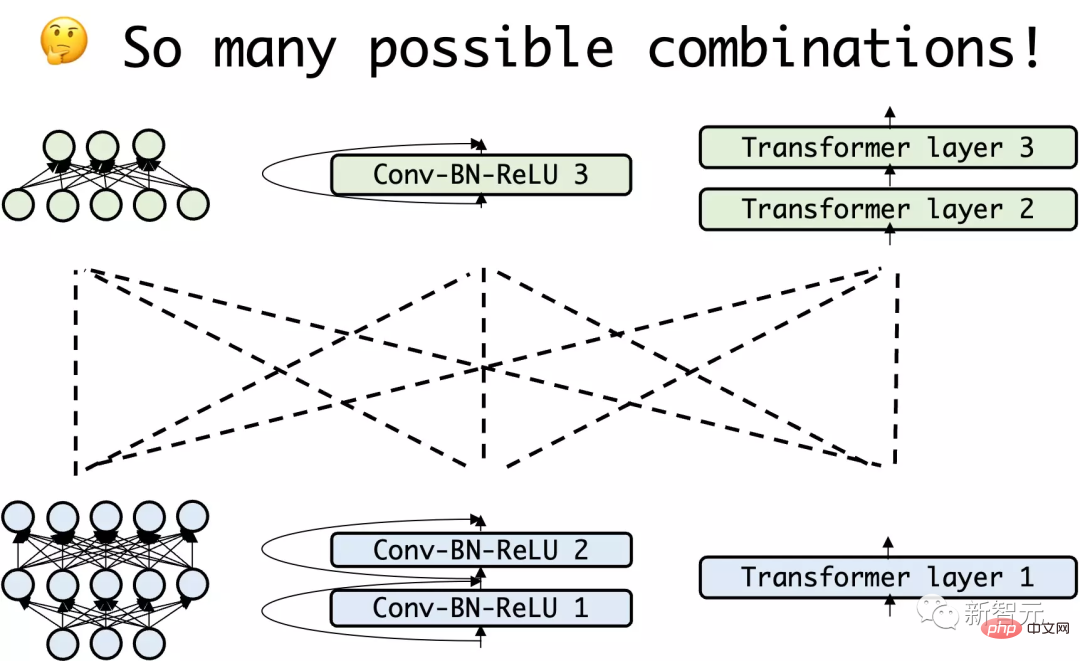

Jadi idea yang sangat semula jadi muncul: Bolehkah kita menganggap rangkaian saraf sebagai himpunan blok binaan dan mendapatkan rangkaian baharu? dengan memasang semula rangkaian sedia ada, dan menggunakannya untuk melaksanakan pembelajaran pemindahan?

Di NeurIPS 2022, daripada Universiti Kebangsaan Singapura Pasukan LVlab telah mencadangkan paradigma pembelajaran pemindahan baharu yang dipanggil "Pemasangan Semula Model Dalam".

Pautan kertas: https://arxiv.org/abs/2210.17409

Pautan kod: https://github.com/Adamdad/DeRy

Laman utama projek: https://adamdad.github.io/dery/

OpenReview: https://openreview.net/forum?id=gtCPWaY5bNh

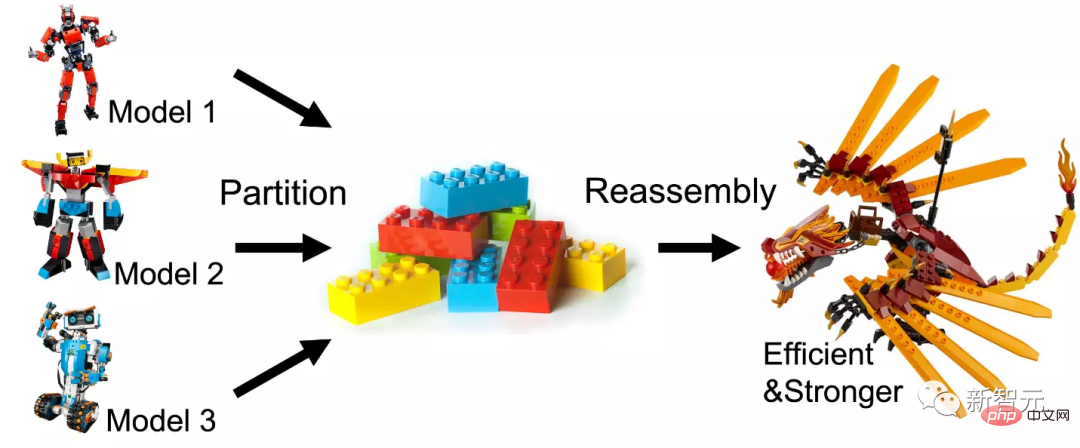

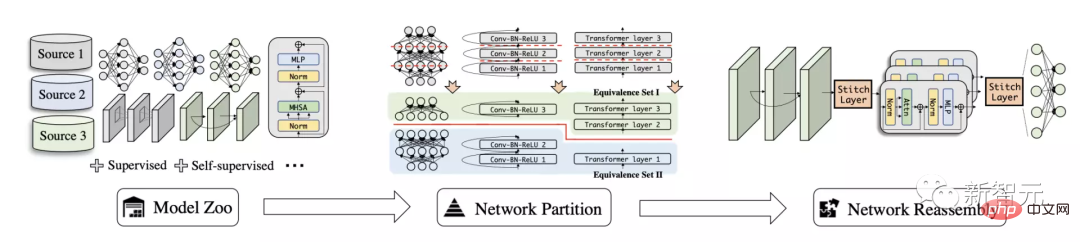

Penulis dahulu Leraikan model pra-latihan sedia ada ke dalam sub-rangkaian berdasarkan persamaan fungsi, dan kemudian pasang semula sub-rangkaian untuk membina model yang cekap dan mudah digunakan untuk tugasan tertentu.

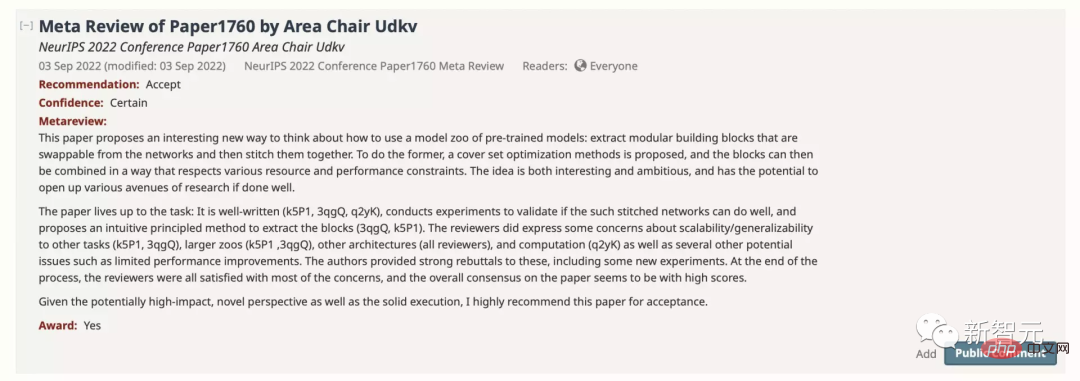

Kertas tersebut telah diterima oleh NeurIPS dengan markah 886 dan disyorkan untuk Pencalonan Anugerah Kertas.

Dalam artikel ini, penulis meneroka tugas pemindahan pengetahuan baharu yang dipanggil Deep Model Reassembly (pendek kata DeRy), digunakan untuk kegunaan semula model umum.

Memandangkan satu set model pra-latihan yang dilatih pada data yang berbeza dan seni bina heterogen, penstrukturan model mendalam mula-mula membahagikan setiap model kepada ketulan model bebas dan kemudian secara selektif untuk memasang semula kepingan submodel dalam perkakasan dan kekangan prestasi.

Kaedah ini serupa dengan merawat model rangkaian saraf dalam sebagai blok binaan: hapus blok bangunan besar sedia ada kepada blok bangunan kecil, dan kemudian bahagian dipasang mengikut keperluan. Model baharu yang dipasang bukan sahaja harus mempunyai prestasi yang lebih kukuh; proses pemasangan tidak seharusnya mengubah struktur dan parameter modul asal sebanyak mungkin untuk memastikan kecekapannya.

Memecah dan menyusun semula model yang mendalam

Kaedah dalam artikel ini boleh dibahagikan kepada dua bahagian. DeRy mula-mula menyelesaikan Masalah Penutup Set dan membahagikan semua rangkaian pra-latihan mengikut tahap fungsian, dalam langkah kedua, DeRy memformalkan pemasangan model menjadi masalah pengaturcaraan integer 0-1 untuk memastikan model yang dipasang adalah Prestasi terbaik pada tugasan tertentu.

Pemasangan Semula Model Dalam

Pertama, pengarang mentakrifkan masalah pemasangan semula model dalam: memandangkan model dalam yang terlatih, ia dipanggil perpustakaan model.

Setiap model terdiri daripada pautan lapisan, diwakili oleh . Rangkaian yang berbeza boleh mempunyai struktur dan operasi yang berbeza sepenuhnya, selagi model disambungkan lapisan demi lapisan.

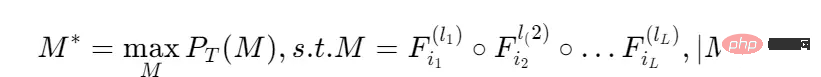

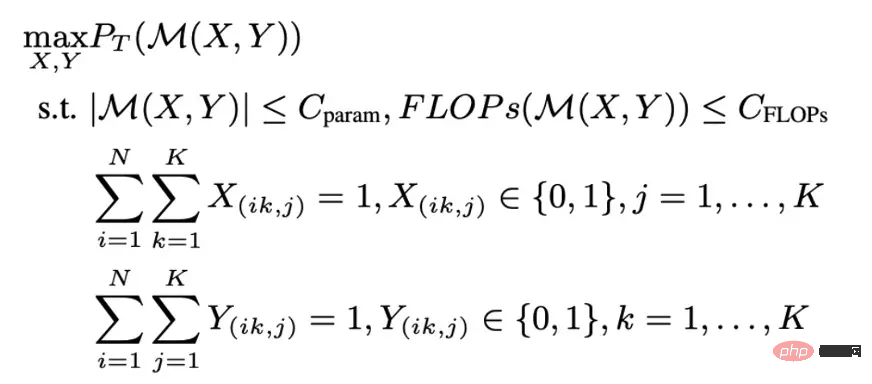

Memandangkan tugasan, kami berharap dapat mencari model campuran lapisan dengan prestasi terbaik, dan jumlah pengiraan model memenuhi had tertentu:

Prestasi pada tugasan mewakili operasi lapisan model ke; Maksimumkan hasil. Pada dasarnya, tugas ini melibatkan pengoptimuman gabungan yang sangat kompleks.

Untuk memudahkan kos carian, artikel ini mula-mula memisahkan model perpustakaan model dari arah kedalaman untuk membentuk beberapa sub-rangkaian yang lebih cetek dan lebih kecil kemudian melakukan carian penyambungan di sub-; tahap rangkaian.

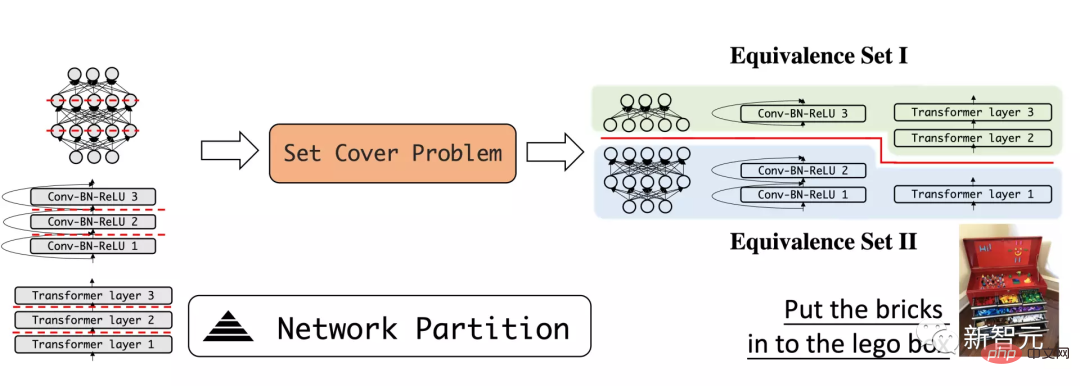

Pisah rangkaian mengikut tahap fungsi

Langkah pertama dalam DeRy ialah Ambil memisahkan model pembelajaran mendalam seperti blok binaan. Penulis menggunakan kaedah pemisahan rangkaian dalam untuk membahagikan model dalam kepada beberapa model kecil yang lebih cetek.

Artikel berharap submodel yang dibongkar mempunyai fungsi yang berbeza sebaik mungkin. Proses ini boleh dibandingkan dengan proses merungkai blok bangunan dan memasukkannya ke dalam kotak mainan mengikut kategori: Blok bangunan yang serupa disatukan, dan blok bangunan yang berbeza diasingkan.

Sebagai contoh, bahagikan model kepada lapisan bawah dan lapisan yang lebih tinggi, dan jangkakan bahawa lapisan bawah bertanggungjawab terutamanya untuk mengenal pasti corak tempatan seperti lengkung atau bentuk, manakala lapisan yang lebih tinggi boleh menilai keseluruhan semantik sampel.

Menggunakan ukuran persamaan ciri umum, persamaan fungsi mana-mana model boleh diukur secara kuantitatif.

Idea utama ialah untuk input yang serupa, rangkaian saraf dengan fungsi yang sama boleh menghasilkan output yang serupa.

Jadi, untuk tensor input X dan X' yang sepadan dengan jumlah kedua-dua rangkaian, persamaan fungsinya ditakrifkan sebagai:

Kemudian perpustakaan model boleh dibahagikan kepada set kesetaraan fungsi melalui persamaan fungsi.

Subrangkaian dalam setiap set kesetaraan mempunyai persamaan fungsi yang tinggi, dan pembahagian setiap model memastikan kebolehpisahan perpustakaan model.

Faedah teras pembongkaran sedemikian ialah disebabkan persamaan fungsi, sub-rangkaian dalam setiap set setara boleh dianggap sebagai kira-kira komutatif, iaitu, blok rangkaian boleh Digantikan dengan subrangkaian lain daripada set kesetaraan yang sama tanpa menjejaskan ramalan rangkaian.

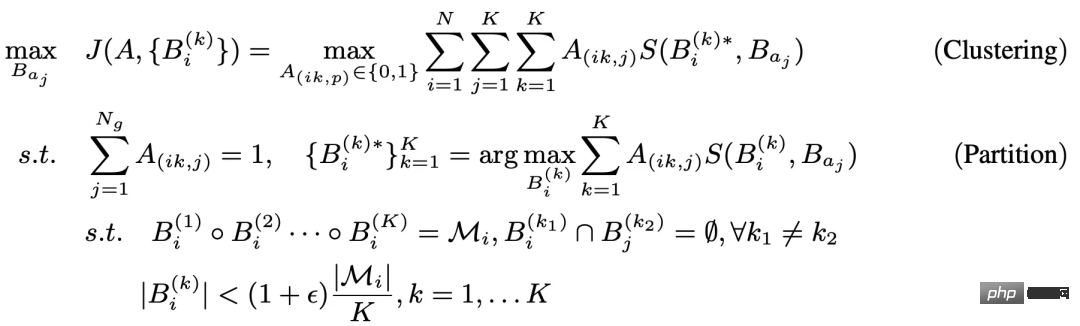

Masalah pemisahan di atas boleh diformalkan sebagai masalah pengoptimuman terkekang tiga peringkat:

The pengoptimuman peringkat dalaman bagi masalah ini sangat serupa dengan masalah set penutup umum atau masalah pembahagian graf. Oleh itu, penulis menggunakan algoritma heuristik Kernighan-Lin (KL) untuk mengoptimumkan lapisan dalam.

Idea umum ialah untuk dua submodel yang dimulakan secara rawak, satu lapisan operasi ditukar setiap kali Jika pertukaran boleh meningkatkan nilai fungsi penilaian, pertukaran itu dikekalkan ; jika tidak, ia ditinggalkan.

Gelung luar di sini menggunakan algoritma pengelompokan K-Means.

Untuk setiap bahagian rangkaian, setiap sub-rangkaian sentiasa diberikan kepada set fungsi dengan jarak tengah terbesar. Oleh kerana gelung dalam dan luar adalah berulang dan mempunyai jaminan penumpuan, pemisahan subrangkaian optimum mengikut tahap fungsi boleh diperolehi dengan menyelesaikan masalah di atas.

Pemasangan rangkaian berdasarkan pengoptimuman integer

Pembahagian rangkaian membahagikan setiap rangkaian kepada sub-rangkaian, setiap sub-rangkaian Kepunyaan set kesetaraan. Ini boleh digunakan sebagai ruang carian untuk mencari penyambungan rangkaian yang optimum untuk tugas hiliran.

Disebabkan kepelbagaian submodel, pemasangan rangkaian ini merupakan masalah pengoptimuman gabungan dengan ruang carian yang besar dan keadaan carian tertentu ditentukan : Setiap gabungan rangkaian mengambil blok rangkaian daripada set fungsi yang sama dan meletakkannya mengikut kedudukannya dalam rangkaian asal, rangkaian yang disintesis perlu memenuhi had pengiraan. Proses ini digambarkan sebagai pengoptimuman masalah pengoptimuman integer 0-1.

Untuk mengurangkan lagi overhed latihan mengira prestasi model gabungan setiap kali, penulis menggunakan fungsi alternatif dalam latihan NAS yang tidak memerlukan latihan, dipanggil untuk NASWOT. Daripada ini, prestasi sebenar rangkaian boleh dianggarkan hanya dengan menggunakan inferens rangkaian pada set data tertentu.

Melalui proses split-recombine yang dinyatakan di atas, model pra-latihan yang berbeza boleh disambung dan digabungkan untuk mendapatkan model baharu dan lebih kukuh.

Hasil eksperimen

Penyusunan semula model sesuai untuk pembelajaran pemindahan

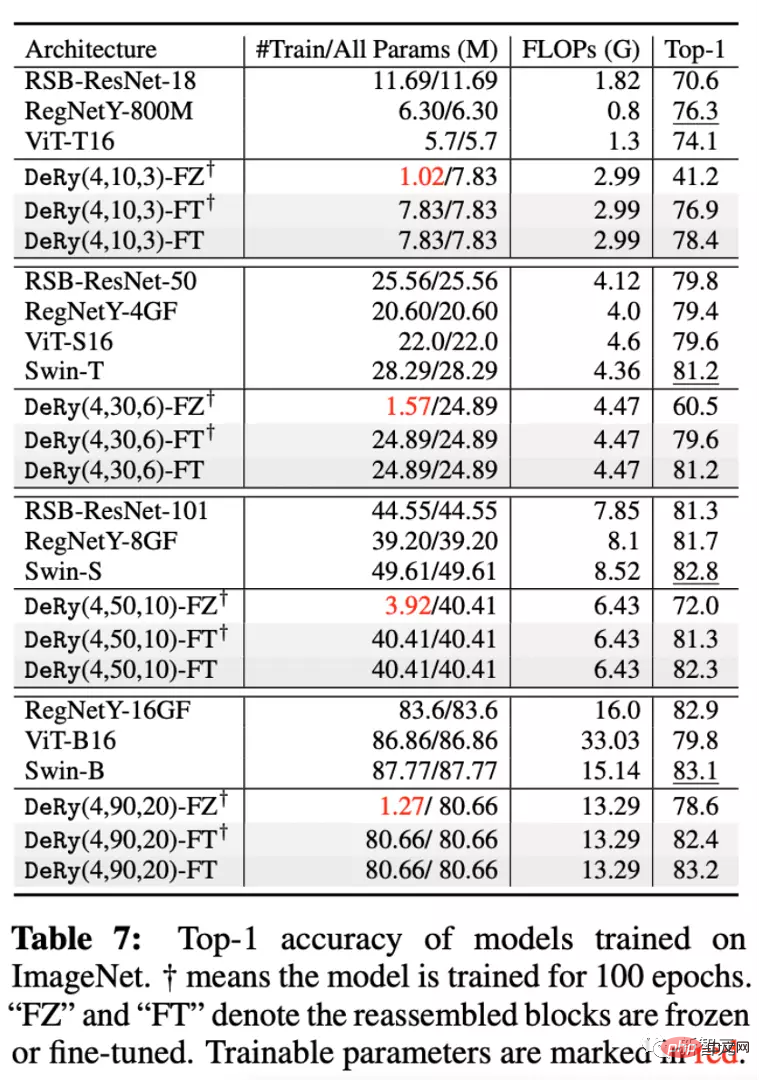

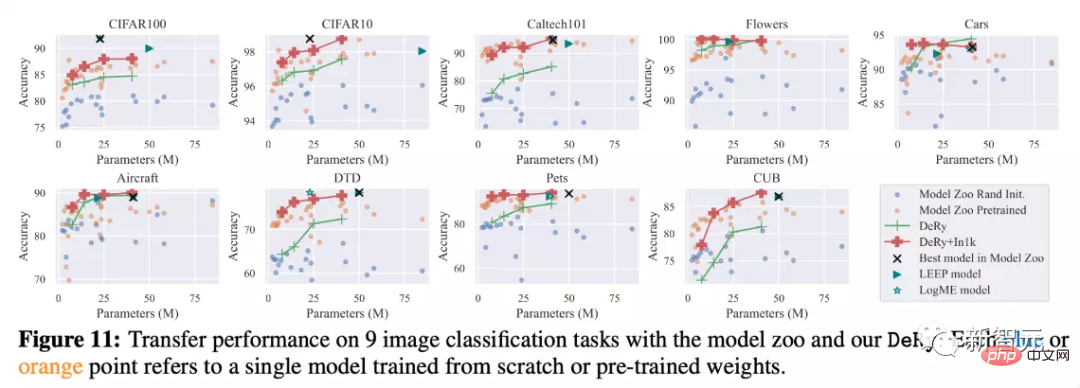

Pengarang menggunakan model yang mengandungi 30 pra-latihan berbeza rangkaian Perpustakaan telah dibongkar dan dipasang semula dengan teliti, dan prestasi dinilai pada ImageNet dan 9 tugas pengelasan hiliran lain.

Dua kaedah latihan berbeza telah digunakan dalam percubaan: Penalaan Penuh, yang bermaksud bahawa semua parameter model yang disambungkan telah dilatih; - Penalaan bermakna hanya lapisan sambungan yang disambungkan dilatih.

Selain itu, lima model skala telah dipilih dan dibandingkan, dipanggil DeRy(, ,).

Seperti yang anda lihat dalam gambar di atas, pada set data ImageNet, model skala berbeza yang diperoleh oleh DeRy boleh lebih baik daripada atau sama dengan model saiz yang serupa dalam perpustakaan model.

Telah didapati bahawa walaupun hanya parameter bahagian pautan dilatih, model masih boleh mencapai peningkatan prestasi yang kukuh. Sebagai contoh, model DeRy(4,90,20) mencapai ketepatan Top1 sebanyak 78.6% dengan hanya 1.27M parameter yang dilatih.

Pada masa yang sama, 9 eksperimen pembelajaran pemindahan juga mengesahkan keberkesanan DeRy. Ia boleh dilihat bahawa tanpa pra-latihan, model DeRy boleh mengatasi model lain dalam perbandingan pelbagai saiz model dengan pra-latihan model yang dipasang semula secara berterusan, prestasi model boleh dipertingkatkan dengan ketara.

Berbanding dengan kaedah pemindahan pembelajaran lain daripada perpustakaan model seperti LEEP atau LogME, DeRy boleh melepasi had prestasi perpustakaan model itu sendiri, malah lebih baik daripada model terbaik dalam versi asal perpustakaan model.

Meneroka sifat penyusunan semula model

Pengarang juga sangat ingin tahu tentang penyusunan semula model yang dicadangkan dalam sifat artikel ini, seperti "Corak apakah model yang akan dipecahkan mengikut peraturan apa?". Penulis menyediakan eksperimen untuk analisis.

Persamaan fungsi, lokasi penyusunan semula dan prestasi penyusunan semula

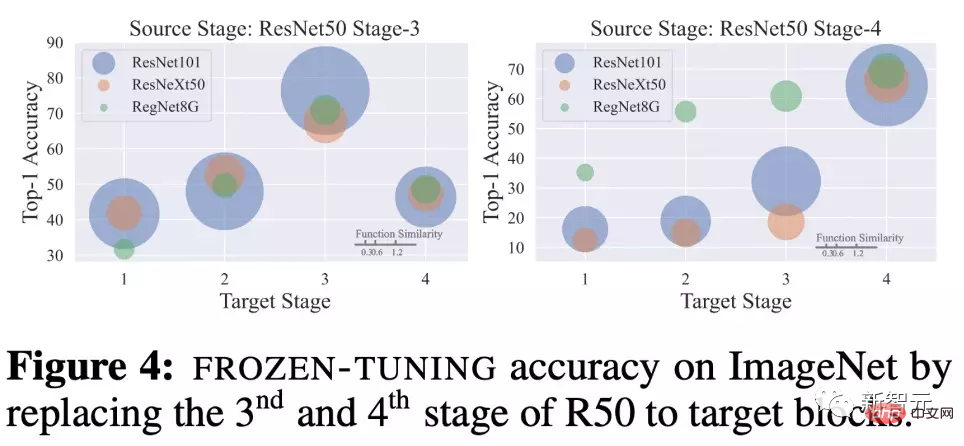

Pengarang meneroka bagaimana blok rangkaian yang sama digunakan oleh lain Selepas menggantikan blok rangkaian dengan persamaan fungsi yang berbeza, Penalaan Pembekuan perbandingan prestasi 20 zaman.

Untuk ResNet50 yang dilatih di ImageNet, gunakan blok rangkaian peringkat ke-3 dan ke-4, Penggantian dengan blok rangkaian berbeza untuk ResNet101, ResNeXt50 dan RegNetY8G.

Dapat diperhatikan bahawa kedudukan penggantian mempunyai kesan yang besar terhadap prestasi.

Sebagai contoh, jika peringkat ketiga digantikan dengan peringkat ketiga rangkaian lain, prestasi rangkaian yang disusun semula akan menjadi kuat terutamanya. Pada masa yang sama, persamaan fungsi juga dipadankan secara positif dengan prestasi penggabungan semula.

Blok model rangkaian pada kedalaman yang sama mempunyai persamaan yang lebih besar, menghasilkan keupayaan model yang lebih kukuh selepas latihan. Ini menunjukkan kepada pergantungan dan hubungan positif antara keserupaan-penggabungan semula kedudukan-prestasi penggabungan semula.

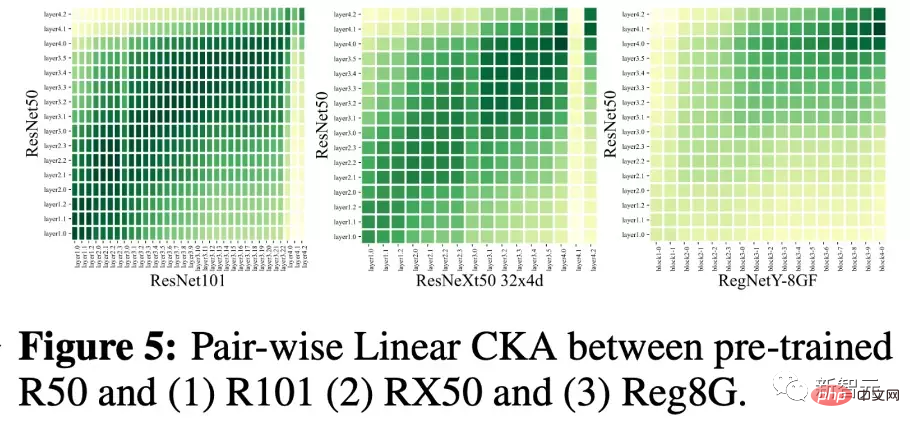

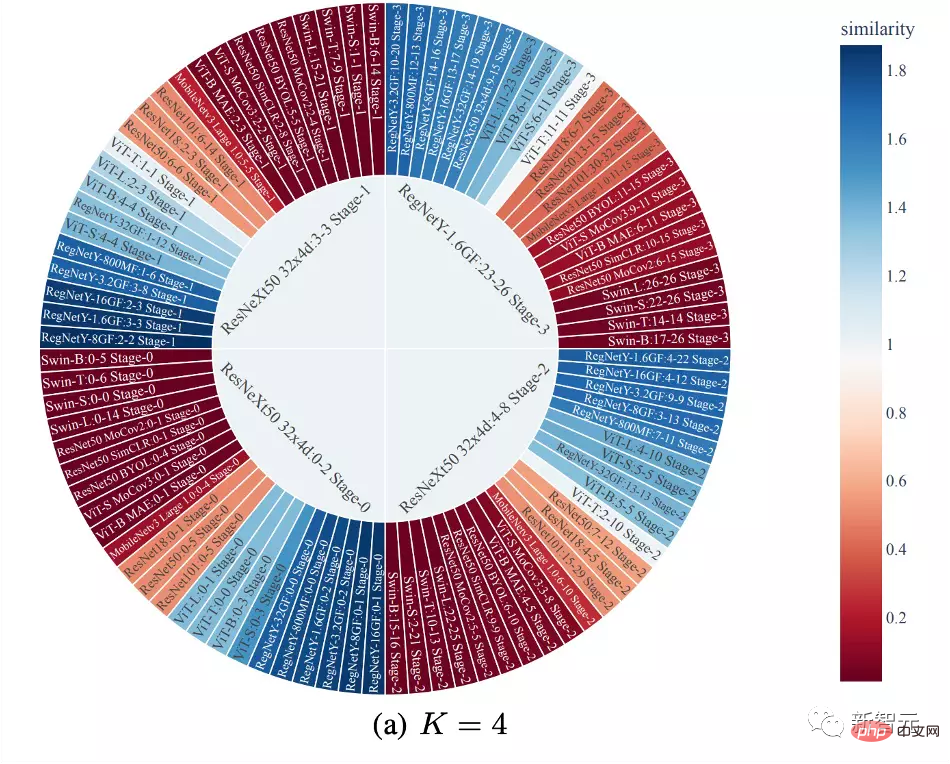

Pemerhatian hasil belahan

Dalam gambar di bawah, penulis melukis The hasil pemisahan satu langkah. Warna mewakili persamaan antara blok rangkaian dan blok rangkaian di tengah set kesetaraan lagu.

Dapat dilihat bahawa pembahagian yang dicadangkan dalam artikel ini cenderung untuk mengelompokkan sub-rangkaian bersama-sama mengikut kedalaman dan memisahkannya. Pada masa yang sama, data persamaan fungsi CNN dan Transformer adalah kecil, tetapi persamaan fungsi antara CNN dan CNN seni bina yang berbeza biasanya lebih besar.

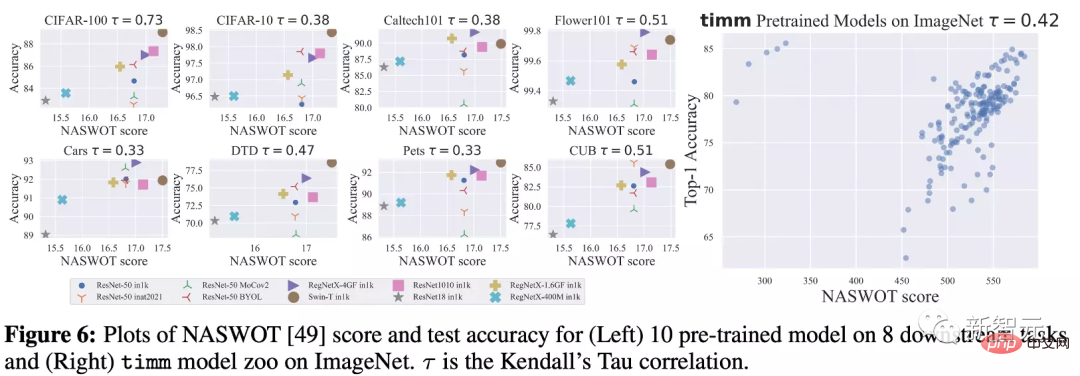

Menggunakan NASWOT sebagai penunjuk prestasi

Memandangkan artikel ini menggunakan NASWOT untuk ramalan pemindahan latihan sifar buat kali pertama, penulis juga menguji kebolehpercayaan penunjuk ini.

Dalam rajah di bawah, pengarang mengira markah NASWOT untuk model yang berbeza pada set data yang berbeza, dan membandingkannya dengan ketepatan pembelajaran pemindahan tambah satu.

Dapat diperhatikan bahawa markah NASWOT telah memperoleh kedudukan prestasi yang lebih tepat (korelasi Tau Kendall). Ini menunjukkan bahawa indeks latihan sifar yang digunakan dalam artikel ini boleh meramalkan prestasi model pada data hiliran dengan berkesan.

Ringkasan

Kertas kerja ini mencadangkan tugas pemindahan pengetahuan baharu yang dipanggil penstrukturan model mendalam (Deep Model Reassembly , Pendek kata DeRy). Dia membina model yang disesuaikan dengan tugas hiliran dengan memecahkan model pra-latihan heterogen sedia ada dan memasangnya semula.

Pengarang mencadangkan pelaksanaan dua peringkat mudah untuk menyelesaikan tugasan ini. Pertama, DeRy menyelesaikan masalah set penutup dan membahagikan semua rangkaian pra-latihan mengikut tahap kefungsian, dalam langkah kedua, DeRy memformalkan pemasangan model menjadi masalah pengaturcaraan integer 0-1 untuk memastikan prestasi model yang dipasang pada tugas tertentu. optimum.

Kerja ini bukan sahaja mencapai peningkatan prestasi yang kukuh, tetapi juga memetakan kemungkinan ketersambungan antara rangkaian saraf yang berbeza.

Atas ialah kandungan terperinci Cara yang betul untuk bermain pembelajaran mendalam blok binaan! Universiti Nasional Singapura mengeluarkan DeRy, paradigma pembelajaran pemindahan baharu yang menukar pemindahan pengetahuan kepada percetakan jenis alih. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI