Rumah >Peranti teknologi >AI >90% daripada otak manusia adalah pembelajaran diselia sendiri Sejauh manakah model AI yang besar daripada mensimulasikan otak?

90% daripada otak manusia adalah pembelajaran diselia sendiri Sejauh manakah model AI yang besar daripada mensimulasikan otak?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 20:29:131232semak imbas

Kita semua tahu bahawa 90% daripada otak manusia adalah pembelajaran yang diselia sendiri, dan organisma akan sentiasa membuat ramalan tentang perkara yang akan berlaku seterusnya. Pembelajaran penyeliaan kendiri bermaksud keputusan boleh dibuat tanpa campur tangan luar. Terdapat hanya beberapa kes di mana kami akan menerima maklum balas luaran, seperti guru berkata: "Anda membuat kesilapan." Kini beberapa sarjana telah mendapati bahawa mekanisme pembelajaran penyeliaan sendiri bagi model bahasa besar adalah sama seperti otak kita. Majalah Quanta, media sains popular yang terkenal, baru-baru ini melaporkan bahawa semakin banyak kajian mendapati bahawa model pembelajaran penyeliaan kendiri, terutamanya kaedah pembelajaran kendiri model bahasa berskala besar, sangat serupa dengan model pembelajaran otak kita. .

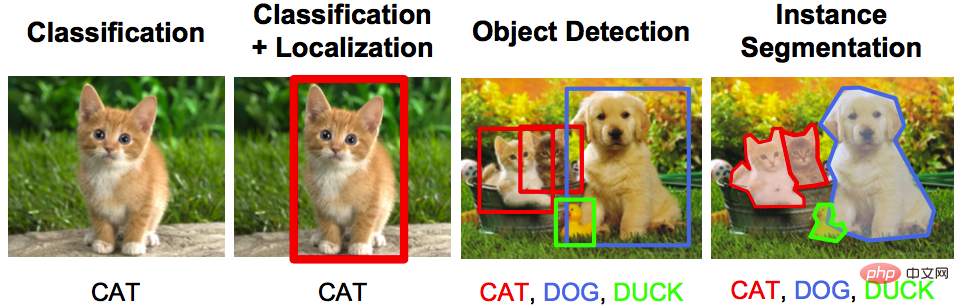

Sistem AI biasa pada masa lalu menggunakan sejumlah besar data berlabel untuk latihan. Sebagai contoh, imej mungkin dilabelkan "kucing kucing" atau "kucing harimau" untuk melatih rangkaian saraf tiruan untuk membezakan dengan betul antara kucing dan harimau.

Latihan "pengawasan diri" semacam ini memerlukan kerja keras buruh manual Data label, dan rangkaian saraf sering mengambil jalan pintas dan belajar mengaitkan label dengan maklumat yang minimum, dan kadangkala dangkal. Sebagai contoh, rangkaian saraf mungkin menggunakan kehadiran rumput untuk mengenal pasti foto lembu, kerana lembu sering difoto di padang. Alexei Efros, seorang saintis komputer di University of California, Berkeley, berkata: "Algoritma yang kami latih adalah seperti mahasiswa yang tidak pernah ke kelas selama satu semester, dan walaupun mereka tidak mempelajari bahan secara sistematik, mereka berjaya dalam peperiksaan.

Tambahan pula, bagi penyelidik yang berminat dalam persimpangan kecerdasan haiwan dan kecerdasan mesin, "pembelajaran diselia" ini mungkin terhad kepadanya. Didedahkan tentang biologi otak. Banyak haiwan, termasuk manusia, tidak menggunakan set data berlabel untuk belajar. Untuk sebahagian besar, mereka meneroka persekitaran mereka sendiri, dan dengan berbuat demikian, mereka memperoleh pemahaman yang kaya dan mendalam tentang dunia.

Kini, beberapa ahli sains saraf pengiraan telah mula meneroka rangkaian saraf yang dilatih dengan sedikit atau tiada data berlabel manusia. Penemuan baru-baru ini mencadangkan bahawa model pengiraan sistem visual dan pendengaran haiwan yang dibina menggunakan model pembelajaran penyeliaan sendiri lebih hampir menghampiri fungsi otak berbanding model pembelajaran diselia.

Bagi sesetengah ahli sains saraf, rangkaian saraf tiruan nampaknya mula mendedahkan cara menggunakan otak sebagai analogi untuk pembelajaran mesin.

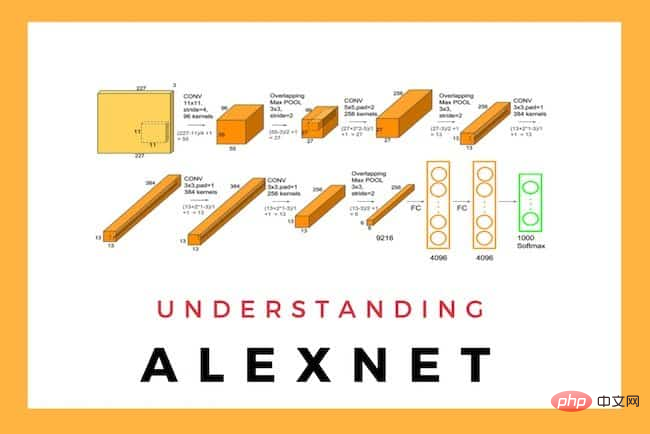

Penyeliaan CacatKira-kira 10 tahun yang lalu, model otak yang diilhamkan oleh rangkaian saraf tiruan mula muncul, dan pada masa yang sama projek dipanggil Rangkaian Neural AlexNet telah merevolusikan tugas mengklasifikasikan imej yang tidak diketahui.

Keputusan ini diterbitkan dalam makalah "Klasifikasi ImageNet dengan Rangkaian Neural Konvolusi Dalam" oleh Alex Krizhevsky, Ilya Sutskever, dan Geoffrey E. Hinton.

Keputusan ini diterbitkan dalam makalah "Klasifikasi ImageNet dengan Rangkaian Neural Konvolusi Dalam" oleh Alex Krizhevsky, Ilya Sutskever, dan Geoffrey E. Hinton.

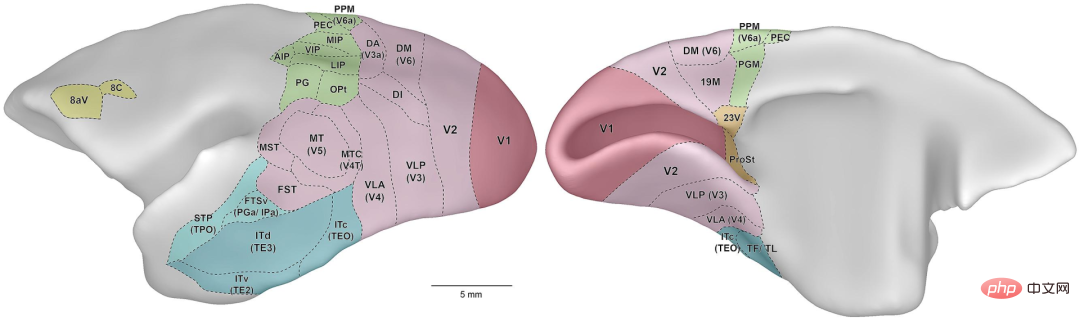

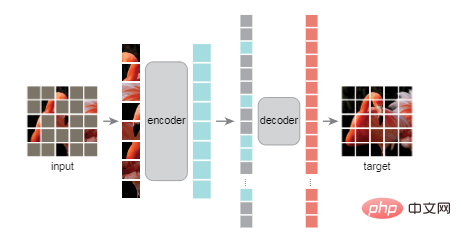

Alamat kertas: https://dl.acm.org/doi/10.1145/3065386 Seperti semua rangkaian saraf, rangkaian ini terdiri daripada berbilang lapisan Terdiri daripada neuron buatan, di mana berat sambungan antara neuron yang berbeza adalah berbeza. Jika rangkaian saraf gagal mengklasifikasikan imej dengan betul, algoritma pembelajaran mengemas kini berat sambungan antara neuron untuk mengurangkan kemungkinan salah klasifikasi dalam pusingan seterusnya latihan seks. Algoritma mengulangi proses ini beberapa kali, melaraskan pemberat, sehingga kadar ralat rangkaian adalah rendah. Kemudian, ahli sains saraf menggunakan AlexNet untuk membangunkan model pengiraan pertama sistem visual primata. Apabila monyet dan rangkaian saraf tiruan ditunjukkan imej yang sama , aktiviti neuron sebenar dan neuron buatan menunjukkan tindak balas yang sama. Keputusan yang sama diperoleh pada model buatan pendengaran dan pengesanan bau. Tetapi apabila bidang itu berkembang, penyelidik menyedari batasan latihan yang diselia sendiri. Pada 2017, saintis komputer Leon Gatys dari Universiti Tübingen di Jerman dan rakan-rakannya mengambil gambar Ford Model T dan kemudian menutup gambar itu dengan corak kulit harimau. Manakala rangkaian neural kecerdasan buatan mengklasifikasikan imej asal dengan betul sebagai Model T, tetapi lihat imej yang diubah suai sebagai harimau bintang. Sebabnya ia hanya fokus pada tekstur imej dan tidak memahami bentuk kereta (atau harimau bintang). Model pembelajaran penyeliaan kendiri direka bentuk untuk mengelakkan masalah tersebut. Dalam pendekatan ini, manusia tidak melabelkan data sebaliknya, label datang daripada data itu sendiri; Algoritma yang diselia sendiri pada asasnya mencipta jurang dalam data dan meminta rangkaian saraf untuk mengisinya. Contohnya, dalam apa yang dipanggil model bahasa besar, algoritma latihan akan menunjukkan rangkaian saraf beberapa perkataan pertama ayat dan memintanya untuk meramalkan. perkataan seterusnya. Apabila dilatih menggunakan sejumlah besar teks yang dikumpul daripada Internet, model tersebut nampaknya mempelajari struktur sintaksis sesuatu bahasa, menunjukkan kehebatan linguistik yang mengagumkan—semuanya tanpa label atau pengawasan luaran. Usaha yang sama sedang dijalankan dalam visi komputer. Pada penghujung tahun 2021, He Kaiming dan rakan sekerjanya menunjukkan penyelidikan auto-pengekod bertopeng yang terkenal "Masked Auto-Encoder" (MAE). Alamat kertas: https://arxiv.org/ abs/2111.06377 MAE menukarkan bahagian yang tidak bertopeng kepada perwakilan terpendam—penerangan matematik termampat yang mengandungi maklumat penting tentang objek. Dalam kes imej, perwakilan asas mungkin merupakan penerangan matematik yang merangkumi bentuk objek dalam imej. Penyahkod kemudian menukar perwakilan ini kembali kepada imej yang lengkap. Dalam sistem sedemikian, sesetengah ahli sains saraf percaya , otak kita sebenarnya adalah pembelajaran yang diselia sendiri. "Saya fikir tidak ada persoalan bahawa 90 peratus daripada apa yang dilakukan oleh otak adalah pembelajaran diselia sendiri, " kata Blake Richards, ahli sains saraf pengiraan di Universiti McGill dan Institut Kecerdasan Buatan Quebec (Mila) Otak biologi Fikirkan ia sebagai sentiasa meramal, sebagai contoh, kedudukan masa depan objek semasa ia bergerak, atau perkataan seterusnya dalam ayat, sama seperti algoritma pembelajaran diselia sendiri yang cuba meramalkan jurang dalam imej atau sekeping teks. Saintis saraf pengiraan Blake Richards mencipta sistem AI yang meniru badan hidup Rangkaian visual dalam otak Richards dan pasukannya mencipta model penyeliaan sendiri yang membayangkan jawapan. Mereka melatih kecerdasan buatan yang menggabungkan dua rangkaian saraf yang berbeza. Yang pertama, dipanggil seni bina ResNet, direka untuk memproses imej yang kedua, dipanggil Recurrent Network, boleh menjejaki urutan input sebelumnya, meramalkan input yang dijangkakan seterusnya. Untuk melatih AI bersama, pasukan bermula dengan urutan video, katakan 10 bingkai, dan membolehkan ResNet memprosesnya satu demi satu. Kemudian, rangkaian berulang meramalkan perwakilan terpendam bingkai 11 dan bukannya hanya sepadan dengan 10 bingkai sebelumnya. Algoritma pembelajaran yang diselia sendiri membandingkan nilai ramalan dengan nilai sebenar dan mengarahkan rangkaian saraf untuk mengemas kini pemberatnya untuk membuat ramalan yang lebih baik. Untuk mengujinya dengan lebih lanjut, para penyelidik menunjukkan AI satu set video yang sebelum ini ditunjukkan oleh penyelidik di Allen Institute for Brain Science di Seattle kepada tikus video. Seperti primata, tikus mempunyai kawasan otak yang khusus untuk imej dan pergerakan statik. Penyelidik Allen merekodkan aktiviti saraf dalam korteks visual tikus manakala tikus menonton video. Pasukan Richards menemui persamaan dalam cara AI dan otak hidup bertindak balas terhadap video. Semasa latihan, satu laluan dalam rangkaian saraf tiruan menjadi lebih serupa dengan kawasan ventral, kawasan pengesanan objek otak tetikus, manakala laluan lain menjadi lebih serupa dengan kawasan dorsal yang memfokuskan pada pergerakan. Hasil ini menunjukkan bahawa sistem visual kami mempunyai dua laluan khusus kerana ia membantu meramalkan masa hadapan visual satu laluan tidak cukup baik . Model sistem pendengaran manusia menceritakan kisah yang sama. Pada bulan Jun, pasukan yang diketuai oleh Jean-Rémi King, seorang saintis penyelidikan di Meta AI, melatih kecerdasan buatan yang dipanggil Wav2Vec 2.0, yang menggunakan rangkaian saraf untuk menukar audio kepada perwakilan terpendam. Para penyelidik menutup beberapa perwakilan ini dan kemudian memasukkannya ke dalam rangkaian saraf komponen lain yang dipanggil penukar. Semasa proses latihan, penukar meramalkan maklumat yang disekat. Dalam proses itu, AI secara keseluruhan belajar untuk mengubah bunyi menjadi representasi asas, sekali lagi, tanpa memerlukan label. Pasukan itu menggunakan kira-kira 600 jam data pertuturan untuk melatih rangkaian. "Itu tentang apa yang seorang kanak-kanak dapat dalam dua tahun pertama pengalaman," kata King. Jean-Remy King Meta AI membantu dengan latihan membangunkan kecerdasan buatan yang memproses audio dengan cara yang meniru otak—sebahagiannya dengan meramalkan perkara yang akan berlaku seterusnya Setelah sistem dilatih, para penyelidik memainkannya bahagian buku audio dalam bahasa Inggeris, Perancis dan Mandarin, dan kemudian memberi makan kepada AI Prestasi itu. berbanding dengan data daripada 412 orang, semua penutur asli daripada tiga bahasa, yang mendengar panjang audio yang sama semasa imbasan MRI mengimejan otak mereka. Hasilnya menunjukkan bahawa walaupun bunyi bising dan resolusi rendah imej fMRI, rangkaian neural AI dan otak manusia "bukan sahaja berkait antara satu sama lain, tetapi juga bertindak dengan cara yang sistematik untuk mengaitkannya”. Aktiviti dalam lapisan awal AI adalah konsisten dengan aktiviti dalam korteks pendengaran primer, manakala aktiviti dalam lapisan terdalam AI adalah konsisten dengan aktiviti di peringkat otak yang lebih tinggi, seperti korteks prefrontal. " Ini adalah data yang cantik, tidak konklusif, tetapi bukti yang meyakinkan tentang cara kita belajar bahasa. Banyak daripadanya meramalkan apa yang akan dikatakan seterusnya. 》 Seseorang tidak bersetuju: otak simulasi? Model dan algoritma jauh lebih terukSudah tentu, tidak semua orang bersetuju dengan kenyataan ini. Josh McDermott, ahli sains saraf pengiraan di MIT, telah menggunakan pembelajaran diselia dan diselia sendiri untuk mengkaji model penglihatan dan pendengaran. Makmalnya merekayasa isyarat audio dan visual sintetik yang, bagi manusia, hanyalah bunyi yang sukar difahami. Walau bagaimanapun, bagi rangkaian saraf tiruan, isyarat ini nampaknya tidak dapat dibezakan daripada bahasa dan imej sebenar. Ini menunjukkan bahawa perwakilan yang terbentuk jauh dalam rangkaian saraf, walaupun dengan pembelajaran yang diselia sendiri, tidak sama dengan yang ada dalam otak kita. McDermott berkata: "Kaedah pembelajaran yang diselia sendiri ini adalah satu peningkatan kerana anda boleh mempelajari perwakilan yang boleh menyokong banyak tingkah laku pengecaman tanpa memerlukan semua label. Tetapi masih terdapat banyak ciri model yang diselia." 🎜> Untuk benar-benar membuat model AI serupa dengan otak manusia, kita masih perlu melakukan banyak perkara, kata Jin. Jika persamaan antara otak dan model pembelajaran penyeliaan sendiri yang ditemui setakat ini berlaku dalam tugas deria yang lain, ia akan menjadi petunjuk yang lebih kuat bahawa apa sahaja kebolehan ajaib yang dimiliki oleh otak kita, beberapa bentuk pembelajaran penyeliaan sendiri diperlukan.

Otak juga "mengawasi diri"

Atas ialah kandungan terperinci 90% daripada otak manusia adalah pembelajaran diselia sendiri Sejauh manakah model AI yang besar daripada mensimulasikan otak?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI