Rumah >Peranti teknologi >AI >GPT-3: Kecerdasan buatan yang boleh menulis

GPT-3: Kecerdasan buatan yang boleh menulis

- PHPzke hadapan

- 2023-04-11 20:10:101406semak imbas

Penterjemah |. >

Walaupun ia dalam peringkat awal pembangunannya, kecerdasan buatan (AI) berpotensi untuk merevolusikan cara manusia berinteraksi dengan teknologi.Pengenalan Kepada Kepintaran Buatan

Mengenai kecerdasan buatan, pada masa ini terdapat dua pandangan utama. Sesetengah percaya bahawa AI akhirnya akan mengatasi kecerdasan manusia, sementara yang lain percaya bahawa AI akan sentiasa berkhidmat kepada manusia. Terdapat satu perkara yang boleh dipersetujui oleh kedua-dua pihak: Kecerdasan buatan berkembang pada kadar yang semakin meningkat.Kecerdasan buatan (AI) masih dalam peringkat awal pembangunannya, tetapi ia berpotensi merevolusikan cara manusia berinteraksi dengan teknologi.

Penerangan yang ringkas dan umum ialah kecerdasan buatan ialah proses pengaturcaraan komputer untuk membuat keputusan sendiri. Ini boleh dicapai dalam pelbagai cara, tetapi paling biasa melalui penggunaan algoritma. Algoritma ialah satu set peraturan atau arahan yang boleh diikuti untuk menyelesaikan masalah. Dalam kes kecerdasan buatan, algoritma digunakan untuk mengajar komputer cara membuat keputusan.

Pada masa lalu, kecerdasan buatan digunakan terutamanya untuk tugas mudah seperti bermain catur atau menyelesaikan masalah matematik. Kini, kecerdasan buatan digunakan untuk tugas yang lebih kompleks seperti pengecaman muka, pemprosesan bahasa semula jadi, dan juga pemanduan autonomi. Memandangkan kecerdasan buatan terus berkembang, kita tidak tahu apakah keupayaan yang akan ada pada masa hadapan. Memandangkan keupayaan AI berkembang pesat, adalah penting untuk memahami apa itu, cara ia berfungsi dan potensi kesannya.

Faedah yang dibawa oleh kecerdasan buatan adalah besar. Dengan keupayaan untuk membuat keputusan sendiri, AI berpotensi untuk menjadikan banyak industri lebih cekap dan menyediakan peluang untuk semua jenis orang. Dalam artikel ini, kita akan bercakap tentang GPT-3.

Apakah itu GPT-3 dan dari mana asalnya?

GPT-3 telah dicipta oleh OpenAI, sebuah syarikat penyelidikan AI perintis yang berpangkalan di San Francisco. Mereka mentakrifkan matlamat mereka sebagai "memastikan kecerdasan buatan memberi manfaat kepada semua manusia." Visi mereka untuk mencipta kecerdasan buatan adalah jelas: kecerdasan buatan yang tidak terhad kepada tugas khusus, tetapi boleh melakukan pelbagai tugas seperti manusia.Beberapa bulan yang lalu, syarikat OpenAI mengeluarkan model bahasa baharunya yang dipanggil GPT-3 kepada semua pengguna. GPT-3 ialah singkatan Generative Pretrained Transformer 3, yang merangkumi keupayaan untuk menjana teks melalui premis yang dipanggil Prompt. Ringkasnya, ia mempunyai keupayaan "auto-lengkap" peringkat tinggi. Sebagai contoh, anda hanya perlu menyediakan dua atau tiga ayat pada topik tertentu dan GPT-3 akan melakukan yang lain. Anda juga boleh menjana perbualan, dan jawapan yang diberikan oleh GPT-3 akan berdasarkan konteks soalan dan jawapan sebelumnya.

Perlu ditegaskan bahawa setiap jawapan yang diberikan oleh GPT-3 hanyalah kemungkinan, jadi ia bukan satu-satunya jawapan yang mungkin. Tambahan pula, jika anda menguji premis yang sama beberapa kali, ia mungkin memberikan jawapan yang berbeza atau malah bercanggah. Jadi ini adalah model yang mengembalikan jawapan berdasarkan apa yang telah dikatakan sebelum ini dan menghubungkannya dengan semua yang anda ketahui untuk mendapatkan jawapan yang paling munasabah. Ini bermakna tidak wajib memberikan jawapan dengan data sebenar, yang mana kita mesti ambil kira. Ini tidak bermakna pengguna tidak boleh mendedahkan data kerja yang berkaitan, tetapi GPT-3 perlu membandingkan data ini dengan maklumat kontekstual. Lebih komprehensif konteks, lebih munasabah jawapan yang anda akan dapat, dan begitu juga sebaliknya.

Model bahasa GPT-3 OpenAI telah dilatih terlebih dahulu, dan latihan itu termasuk mengkaji sejumlah besar maklumat di Internet. GPT-3 dimasukkan ke dalam semua buku yang tersedia untuk umum, keseluruhan kandungan Wikipedia, dan berjuta-juta halaman web dan kertas saintifik di Internet. Ringkasnya, ia menggabungkan pengetahuan manusia yang paling penting yang telah kami terbitkan di web sepanjang sejarah.

Selepas membaca dan menganalisis maklumat ini, model bahasa mencipta sambungan dalam model 700GB yang terletak pada 48 16GB GPU. Untuk membolehkan kami memahami dimensi ini, model OpenAI sebelumnya, model GPT-2, bersaiz 40GB dan menganalisis 45 juta halaman web. Perbezaannya sangat besar, kerana GPT-2 mempunyai 1.5 bilion parameter, manakala GPT-3 mempunyai 175 bilion parameter.

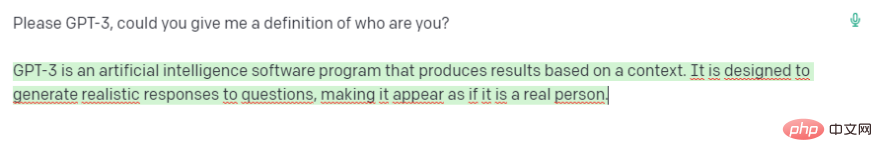

Bolehkah kita melakukan ujian? Saya bertanya kepada GPT-3 bagaimana untuk mentakrifkan dirinya, dan hasilnya adalah seperti berikut:

Cara menggunakan GPT-3

Untuk dapat menggunakan GPT-3 dan mengujinya, satu-satunya perkara yang perlu kita lakukan pergi ke laman web mereka, Daftar dan tambah maklumat peribadi. Semasa proses anda akan ditanya: Untuk apa anda menggunakan kecerdasan buatan Untuk contoh ini, saya memilih pilihan "Penggunaan Peribadi".

Saya ingin menyatakan bahawa dalam pengalaman saya ia berfungsi lebih baik dalam konteks bahasa Inggeris. Itu tidak bermakna ia tidak berfungsi dengan baik dalam bahasa lain sebenarnya, dalam bahasa Sepanyol ia melakukannya dengan sangat baik, tetapi saya lebih suka keputusan yang diberikan dalam bahasa Inggeris, itulah sebabnya mulai sekarang saya menunjukkan Ujian dan keputusan adalah dalam bahasa Inggeris.

GPT-3 memberi kami hadiah percuma apabila kami masuk. Sebaik sahaja anda mendaftar dengan e-mel dan nombor telefon anda, anda akan mempunyai $18 untuk digunakan secara percuma, tidak perlu memasukkan kaedah pembayaran. Walaupun ia mungkin tidak kelihatan seperti banyak, sebenarnya, $18 adalah agak banyak. Untuk memberi anda idea, saya telah menguji AI selama lima jam dan ia hanya menelan kos $1. Nanti saya akan terangkan harganya supaya kita lebih faham.

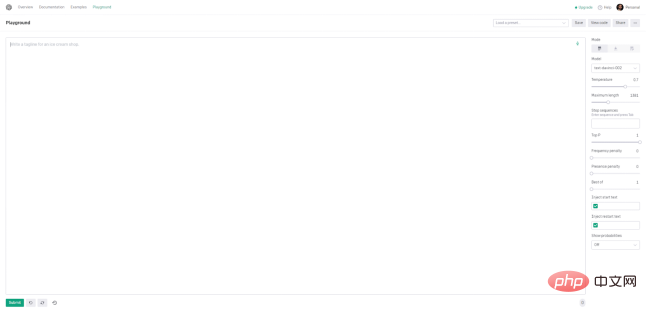

Sebaik sahaja kita memasuki laman web, kita perlu pergi ke bahagian Taman Permainan. Di sinilah semua keajaiban berlaku.

Segera+Serah

Pertama sekali, yang paling ketara dalam talian Ia adalah kotak teks yang besar. Di sinilah kami boleh mula memasukkan gesaan ke dalam AI (ingat, ini adalah permintaan dan/atau arahan kami). Ia semudah memasukkan sesuatu, dalam kes ini soalan, dan mengklik butang hantar di bawah untuk membenarkan GPT-3 menjawab kami dan menulis perkara yang kami minta.

Pratetap

Pratetap ialah fungsi yang boleh dilaksanakan pada bila-bila masa untuk tugasan yang berbeza. Ia boleh didapati di penjuru kanan sebelah atas kotak teks. Jika kita mengklik pada beberapa daripadanya, "Lagi Contoh" akan membuka skrin baharu di mana kita akan mempunyai keseluruhan senarai tersedia. Apabila pratetap dipilih, kandungan kawasan teks dikemas kini dengan teks lalai. Tetapan di bar sisi kanan juga akan dikemas kini. Sebagai contoh, jika kita ingin menggunakan pratetap "Pembetulan Tatabahasa", kita harus mengikut struktur berikut untuk mendapatkan hasil yang terbaik.

Model

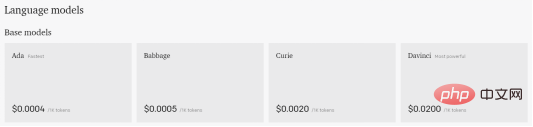

Sebuah set data besar yang digunakan untuk melatih GPT-3, ia ialah GPT-3 The sebab utama mengapa ia begitu berkuasa. Walau bagaimanapun, lebih besar tidak selalu bermakna lebih baik. Atas sebab ini, OpenAI menyediakan empat model utama. Sudah tentu ada model lain, tetapi kami dinasihatkan untuk menggunakan versi terkini, yang kami gunakan sekarang.

Model yang tersedia dipanggil Davinci, Babbage, Curie dan Ada. Daripada empat model, Davinci adalah yang terbesar dan paling berkebolehan, kerana ia boleh menampung sebarang tugas yang dilakukan oleh enjin lain.

Kami akan memberikan gambaran keseluruhan model dan jenis tugas yang dipadankan dengan model tersebut. Perlu diingat bahawa walaupun enjin yang lebih kecil mungkin tidak dilatih mengenai seberapa banyak data, ia masih merupakan model tujuan umum yang sangat boleh dilaksanakan dan mudah untuk tugasan tertentu.

Davinci

Seperti yang dinyatakan di atas, ia adalah model yang paling berkebolehan dan boleh melakukan semua yang boleh dilakukan oleh model lain, biasanya hanya Memerlukan lebih sedikit arahan . Leonardo da Vinci dapat menyelesaikan masalah logik, menentukan hubungan sebab dan akibat, memahami maksud teks, menghasilkan kandungan kreatif, menerangkan motivasi watak, dan mengendalikan tugas meringkaskan yang kompleks.

Curie

Model ini cuba mengimbangi kuasa dan kelajuan pengkomputeran. Ia boleh melakukan apa sahaja yang Ada atau Babbage boleh lakukan, tetapi ia juga boleh mengendalikan tugas pengelasan yang lebih kompleks dan tugas yang lebih bernuansa seperti ringkasan, analisis sentimen, aplikasi chatbot dan menjawab soalan.

Babbage

Ia lebih berkuasa sedikit daripada Ada, tetapi tidak secekap itu. Ia boleh melaksanakan semua tugas yang sama seperti Ada, tetapi juga boleh mengendalikan tugas pengelasan yang sedikit lebih kompleks, menjadikannya sesuai untuk tugas carian semantik yang mengklasifikasikan sejauh mana dokumen sepadan dengan pertanyaan carian.

Ada

Akhir sekali, ini biasanya model terpantas dan paling murah. Ia paling sesuai untuk tugas yang kurang bernuansa, seperti menghuraikan teks, memformat semula teks dan tugas pengelasan yang lebih mudah. Lebih banyak konteks yang anda berikan kepada Ada, lebih baik prestasinya.

Enjin

Parameter lain yang boleh kita selaraskan untuk mendapatkan respons terbaik kepada isyarat kita ialah model.

Salah satu tetapan terpenting yang mengawal output enjin GPT-3 ialah Suhu. Tetapan ini mengawal rawak teks yang dijana. Pada nilai 0, enjin adalah deterministik, bermakna untuk input teks yang diberikan, ia akan sentiasa menghasilkan output yang sama. Pada nilai 1, enjin mengambil risiko paling besar dan menggunakan banyak kreativiti.

Anda mungkin perasan bahawa dalam beberapa ujian yang anda boleh jalankan sendiri, GPT-3 akan berhenti di tengah-tengah ayat. Untuk mengawal jumlah maksimum teks yang kami benarkan untuk dijana, anda boleh menggunakan tetapan "panjang maksimum" yang dinyatakan dalam token. Kami akan menerangkan apakah token ini kemudian.

Parameter "Top P" boleh mengawal rawak dan kreativiti teks GPT-3, tetapi dalam kes ini, dengan token (perkataan) dalam kebarangkalian julat ) bergantung pada tempat kita meletakkannya (0.1 akan menjadi 10%). Dokumentasi OpenAI mengesyorkan menggunakan hanya satu fungsi antara Suhu dan P Atas, jadi apabila menggunakan satu, pastikan yang lain ditetapkan kepada 1.

Sebaliknya, kami mempunyai dua parameter untuk menghukum jawapan yang diberikan oleh GPT-3. Salah satunya ialah "penalti frekuensi", yang mengawal kecenderungan model untuk membuat ramalan berulang. Ia juga mengurangkan kebarangkalian bahawa perkataan telah dijana dan bergantung pada berapa kali perkataan telah muncul dalam ramalan.

Penalty kedua ialah penalti kewujudan. Kehadiran parameter penalti menggalakkan model membuat ramalan baharu. Jika perkataan telah muncul dalam teks yang diramalkan, terdapat penalti yang mengurangkan kebarangkalian perkataan itu. Tidak seperti penalti kekerapan, penalti kehadiran tidak bergantung pada kekerapan perkataan itu muncul dalam ramalan lalu.

Akhir sekali, kami mempunyai parameter "terbaik" yang menghasilkan beberapa jawapan kepada pertanyaan. Taman permainan akan memilih yang terbaik untuk bertindak balas kepada kami. GPT-3 akan memberi amaran bahawa beberapa jawapan yang lengkap kepada gesaan akan mengakibatkan perbelanjaan lebih banyak token.

Sejarah

Untuk melengkapkan bahagian ini, ikon ketiga di sebelah butang "Serah" akan memaparkan komitmen kami kepada GPT-3 Semua sejarah permintaan. Di sini anda boleh menemui gesaan untuk respons berprestasi terbaik.

Yuran dan Token

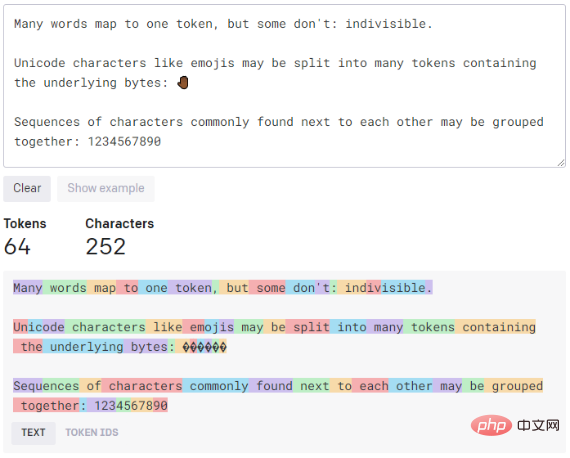

GPT-3 juga menyediakan cara untuk terus menggunakan platformnya sebaik sahaja kredit percuma $18 habis, bukan bulanan langganan atau sebagainya. Harga akan berkaitan secara langsung dengan penggunaan. Dengan kata lain, anda dicaj mengikut token. Ini adalah istilah yang digunakan untuk kecerdasan buatan, di mana token berkaitan dengan kos output. Token boleh menjadi apa-apa sahaja daripada surat kepada ayat. Oleh itu, sukar untuk mengetahui dengan tepat berapa harga setiap penggunaan AI. Tetapi memandangkan mereka biasanya hanya sesen dolar, ia tidak mengambil masa yang lama untuk melihat kos segala-galanya dengan hanya sedikit percubaan.

Walaupun OpenAI hanya menunjukkan kepada kita sedozen contoh penggunaan GPT-3, kita dapat melihat token yang dibelanjakan untuk setiap contoh, dengan itu Lebih memahami cara ia berfungsi.

Ini adalah versi dan harga masing-masing.

Untuk memberi kita gambaran tentang kos beberapa perkataan tertentu, atau memberi kita idea cara markup berfungsi Sebagai contoh, kami mempunyai alat berikut, dipanggil Tokenizer.

Ia memberitahu kita bahawa siri model GPT memproses teks menggunakan token, yang merupakan jujukan aksara biasa yang terdapat dalam teks. Model ini memahami hubungan statistik antara token dan dipilih apabila token seterusnya digunakan dalam urutan pengeluaran.

Akhir sekali, berikut ialah contoh tahap rendah tentang kos kita untuk contoh yang sama.

Kesimpulan

Dari sudut pandangan saya, GPT-3 adalah sesuatu yang pengguna mesti tahu bagaimana kepada Apabila digunakan dengan betul, GPT-3 tidak semestinya memberikan data yang betul. Ini bermakna jika anda ingin menggunakannya untuk melakukan kerja, menjawab soalan atau membuat kerja rumah, anda perlu menyediakan konteks yang baik untuk jawapan yang diberikan kepada anda supaya hampir dengan hasil yang anda inginkan.

Sesetengah orang bimbang sama ada GPT-3 akan menukar pendidikan, atau sama ada beberapa pekerjaan berkaitan penulisan yang wujud hari ini akan hilang kerananya. Pada pendapat saya, ini akan berlaku. Cepat atau lambat, kita semua akan digantikan oleh kecerdasan buatan. Contoh ini adalah mengenai kecerdasan buatan yang berkaitan dengan penulisan, tetapi ia wujud dalam pengaturcaraan, lukisan, audio, dll.

Sebaliknya, ia membuka lebih banyak peluang untuk banyak, banyak pekerjaan dan projek, baik peribadi mahupun profesional. Sebagai contoh, pernahkah anda ingin menulis cerita seram? Fungsi ini boleh dilaksanakan secara khusus dalam senarai contoh penyemak tatabahasa.

Setelah mengatakan semua itu, apa yang saya ingin katakan ialah kita berada dalam versi awal kecerdasan buatan Masih banyak produk di dunia ini yang memerlukan untuk berkembang dan bertambah baik, tetapi masih banyak produk yang perlu ditanam dan diperbaiki. Tidak bermakna ia tidak mendarat. Selagi kita belajar dan menggunakan kecerdasan buatan, kita perlu terus melatihnya untuk memberikan respons yang terbaik.

Pengenalan penterjemah

Cui Hao, editor komuniti 51CTO, arkitek kanan, mempunyai 18 tahun pengalaman pembangunan perisian dan seni bina, 10 tahun Seni bina teragih pengalaman.

Tajuk asal: GPT-3 Taman Permainan: AI That Can Write for You, oleh Isaac Alvarez

Atas ialah kandungan terperinci GPT-3: Kecerdasan buatan yang boleh menulis. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI