Rumah >Peranti teknologi >AI >DeepFake tidak pernah begitu nyata! Seberapa kuat 'herotan tersirat' terbaru Nvidia?

DeepFake tidak pernah begitu nyata! Seberapa kuat 'herotan tersirat' terbaru Nvidia?

- PHPzke hadapan

- 2023-04-11 19:31:171523semak imbas

Dalam beberapa tahun kebelakangan ini, teknologi penjanaan dalam bidang penglihatan komputer telah menjadi semakin berkuasa, dan teknologi "pemalsuan" yang sepadan telah menjadi semakin matang Daripada perubahan wajah DeepFake kepada simulasi tindakan , sukar untuk membezakan yang sebenar daripada yang palsu.

Baru-baru ini, NVIDIA telah membuat satu lagi langkah besar, dan menerbitkan rangka kerja Implicit Warping (Implicit Warping) di persidangan NeurIPS 2022, menggunakan Satu set imej sumber dan mendorong gerakan video untuk membuat animasi sasaran.

Pautan kertas: https://arxiv.org/pdf/2210.01794.pdf

Dari sudut kesan, imej yang dihasilkan lebih realistik Apabila watak bergerak dalam video, latar belakang tidak akan berubah.

Masukkan imej berbilang sumber biasanya memberikan maklumat penampilan yang berbeza, mengurangkan ruang "fantasi" penjana , sebagai contoh, yang berikut dua digunakan sebagai input model.

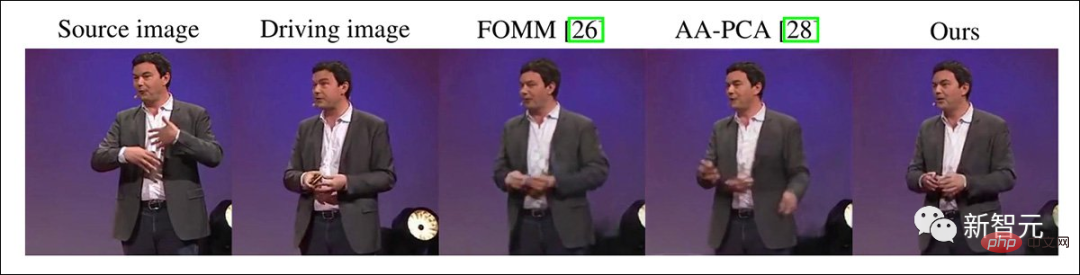

Boleh didapati bahawa berbanding model lain, herotan tersirat tidak menghasilkan "herotan ruang" yang serupa dengan kesan kecantikan.

Disebabkan kesesakan orang, imej berbilang sumber juga boleh memberikan latar belakang yang lebih lengkap.

Seperti yang anda boleh lihat dari video di bawah, jika hanya ada satu gambar di sebelah kiri, ialah gambar di belakang latar belakang " BD" atau " ED" sukar diteka , yang akan menyebabkan herotan latar belakang dan dua gambar akan menghasilkan imej yang lebih stabil.

Apabila membandingkan model lain, hanya satu imej sumber adalah lebih baik.

Penyelewengan Tersirat Sihir

Tiruan video dalam akademik boleh dikesan kembali ke 2005, dan banyak projek mempunyai pembiakan muka masa nyata Penghantaran ekspresi, Face2Face, Obama sintetik, Recycle-GAN, ReenactGAN, medan sinaran saraf dinamik, dsb. mempelbagaikan teknologi terhad pada masa itu, seperti rangkaian adversarial generatif (GAN), medan sinaran saraf (NeRF) dan pengekod auto.

Bukan semua kaedah cuba menjana video daripada satu bingkai imej. Terdapat juga beberapa kajian yang melakukan pengiraan yang rumit pada setiap bingkai dalam video. Ambil laluan tiruan.

Walau bagaimanapun, memandangkan model DeepFake memperoleh maklumat yang kurang, kaedah ini memerlukan latihan untuk setiap klip video, dan prestasinya berkurangan berbanding kaedah sumber terbuka DeepFaceLab atau FaceSwap This Both boleh mengenakan identiti pada sebarang bilangan klip video.

Model FOMM yang dikeluarkan pada 2019 membenarkan watak bergerak bersama video, memberikan tugas meniru video sekali lagi.

Penyelidik lain kemudiannya cuba mendapatkan berbilang pose dan ekspresi daripada imej muka tunggal atau perwakilan badan penuh walau bagaimanapun, pendekatan ini secara amnya hanya berfungsi untuk subjek yang agak tanpa ekspresi dan tidak bergerak, seperti a "kepala bercakap" yang agak pegun kerana tiada "perubahan mendadak dalam tingkah laku" dalam ekspresi muka atau gerak isyarat yang perlu ditafsirkan oleh rangkaian.

Walaupun beberapa teknologi dan kaedah ini mendapat perhatian umum sebelum teknologi palsu mendalam dan kaedah sintesis imej penyebaran berpotensi menjadi popular, skop penggunaannya adalah terhad. , serba boleh dipersoalkan.

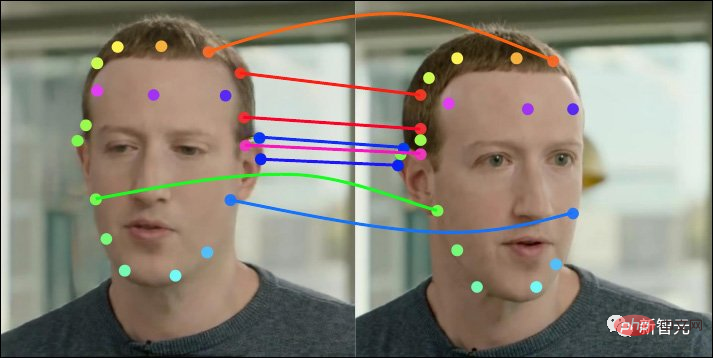

Penyelewengan tersirat yang difokuskan oleh NVIDIA kali ini adalah untuk mendapatkan maklumat antara berbilang bingkai atau bahkan antara dua bingkai, dan bukannya mendapatkan semua pose yang diperlukan daripada satu bingkai Maklumat, persediaan ini adalah' t hadir dalam model bersaing lain, atau dikendalikan dengan sangat buruk.

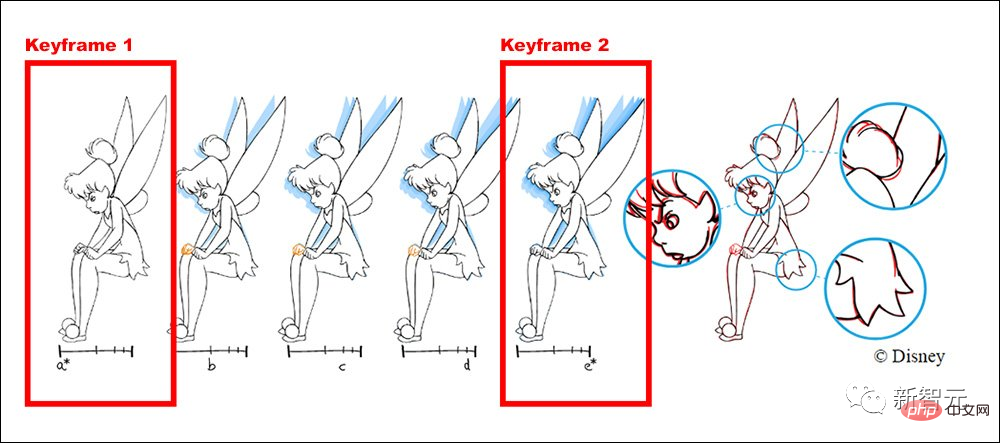

Sebagai contoh, aliran kerja Disney ialah animator kanan melukis bingkai utama dan bingkai utama, dan animator junior lain bertanggungjawab untuk melukis bingkai perantaraan.

Melalui ujian pada versi terdahulu, penyelidik NVIDIA mendapati bahawa kualiti hasil kaedah sebelumnya merosot dengan "keyframe" tambahan, dan kaedah baharu itu tidak konsisten dengan logik pengeluaran animasi secara konsisten , prestasi bertambah baik secara linear apabila bilangan bingkai utama bertambah.

Jika terdapat beberapa perubahan mendadak di tengah-tengah klip, seperti peristiwa atau ungkapan yang tidak ditunjukkan dalam bingkai mula atau bingkai akhir, herotan tersirat boleh ditambah di bingkai Satu titik tengah ini, maklumat tambahan akan diberikan kembali kepada mekanisme perhatian keseluruhan klip.

Struktur model

Kaedah sebelumnya seperti FOMM, Monkey-Net dan face-vid2vid dsb. gunakan herotan yang jelas untuk melukis Masa siri, Maklumat yang diekstrak daripada muka dan kawalan sumber, pergerakan mesti disesuaikan dan konsisten dengan siri kali ini.

Di bawah reka bentuk model ini, pemetaan akhir perkara utama agak ketat.

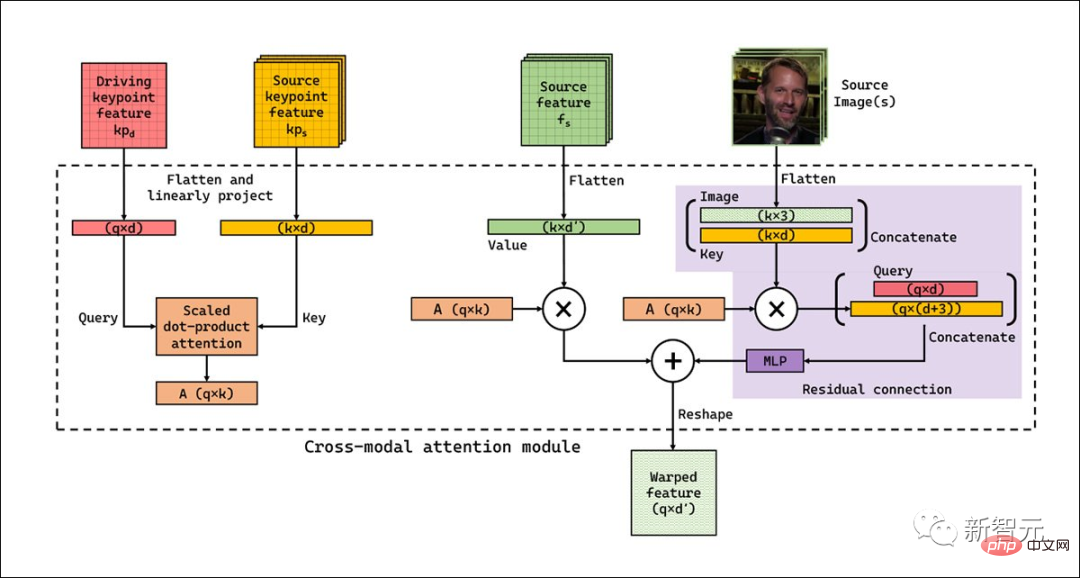

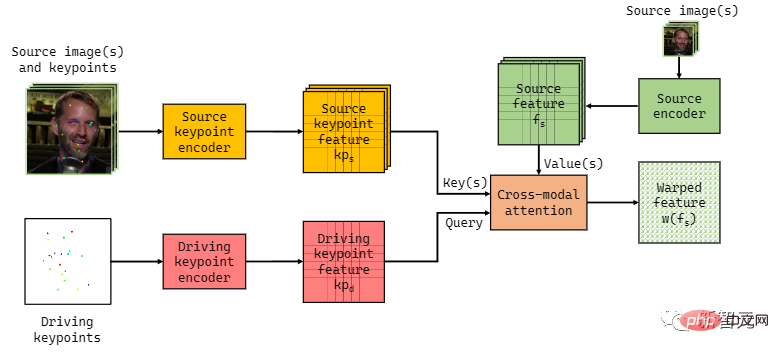

Sebaliknya, ledingan tersirat menggunakan lapisan perhatian merentas mod dengan kurang strap but pratakrif disertakan dalam aliran kerjanya dan boleh menyesuaikan diri dengan input daripada berbilang rangka kerja.

Aliran kerja juga tidak memerlukan herotan berdasarkan setiap kekunci, sistem boleh memilih ciri yang paling sesuai daripada satu siri imej.

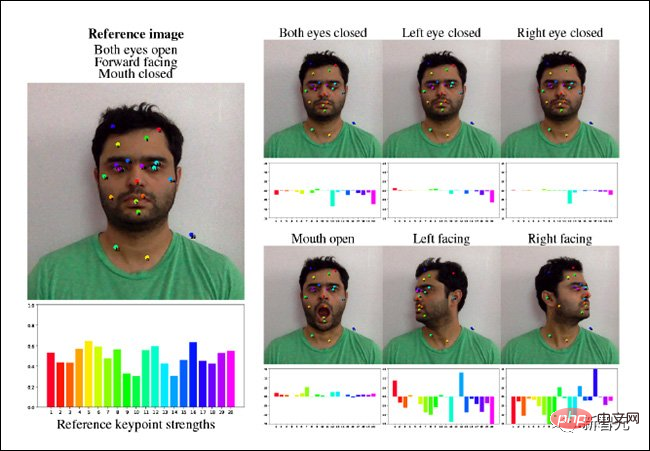

Ledingan tersirat juga menggunakan semula beberapa komponen ramalan titik penting dalam rangka kerja FOMM dan akhirnya menggunakan U-net mudah untuk memperoleh perwakilan titik utama Drive ruang untuk pengekodan. U-net yang berasingan digunakan untuk mengekod imej sumber bersama-sama dengan perwakilan spatial terbitan Kedua-dua rangkaian boleh beroperasi pada resolusi antara 64px (256px keluaran kuasa dua) hingga 384x384px.

Oleh kerana mekanisme ini tidak boleh mengambil kira secara automatik semua kemungkinan perubahan dalam pose dan pergerakan dalam mana-mana video tertentu, bingkai utama tambahan diperlukan , boleh ditambah buat sementara waktu. Tanpa keupayaan campur tangan ini, kunci yang tidak cukup serupa dengan titik gerakan sasaran akan dikemas kini secara automatik, mengakibatkan penurunan dalam kualiti output.

Penjelasan penyelidik untuk perkara ini ialah walaupun ia adalah kunci yang paling serupa dengan pertanyaan dalam set bingkai utama tertentu, ia mungkin tidak mencukupi untuk menghasilkan output yang baik.

Contohnya, katakan imej sumber mempunyai muka dengan bibir tertutup, dan imej pemandu mempunyai muka dengan bibir terbuka dan gigi terdedah. Dalam kes ini, tiada kunci (dan nilai) yang sesuai dalam imej sumber untuk memacu kawasan mulut imej.

Kaedah ini mengatasi masalah ini dengan mempelajari pasangan nilai kunci bebas imej tambahan, yang boleh mengatasi kekurangan maklumat dalam imej sumber.

Walaupun pelaksanaan semasa agak pantas, sekitar 10 FPS pada imej 512x512px, para penyelidik percaya bahawa dalam versi akan datang, saluran paip boleh melalui lapisan perhatian I-D terfaktor Atau Spatial Lapisan Pengurangan Perhatian (SRA) (iaitu Pyramid Vision Transformer) untuk dioptimumkan.

Oleh kerana pelesenan tersirat menggunakan perhatian global dan bukannya perhatian tempatan, ia boleh meramalkan faktor yang tidak dapat diramalkan oleh model terdahulu.

Hasil eksperimen

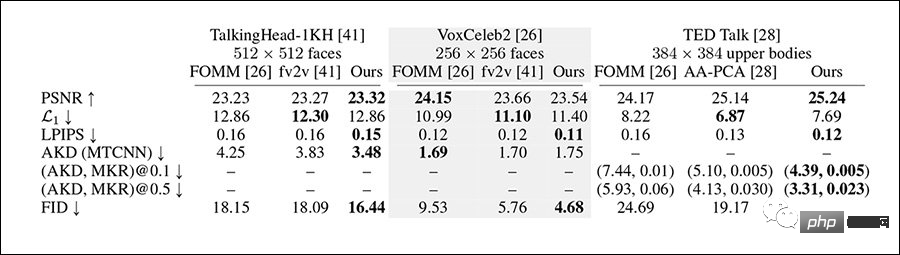

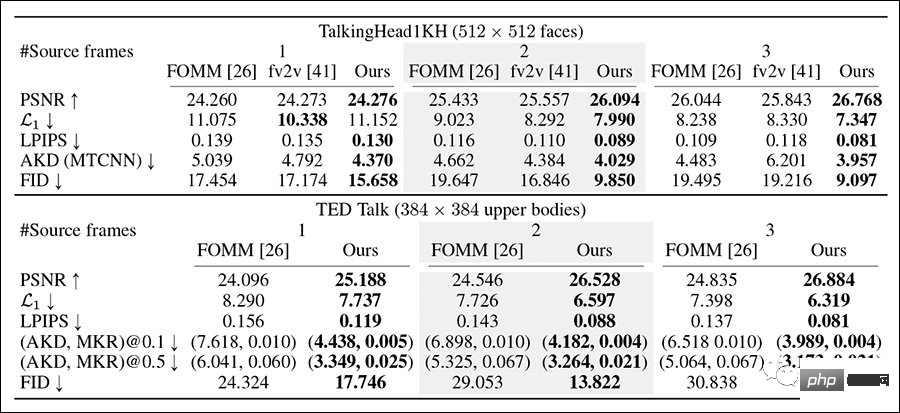

Para penyelidik menguji sistem pada set data VoxCeleb2, set data TED Talk yang lebih mencabar dan set data TalkingHead-1KH, membandingkan Baseline antara 256x256px dan resolusi penuh 512x512px, menggunakan metrik termasuk FID, LPIPS berasaskan AlexNet dan Nisbah Isyarat-ke-Bunyi Puncak (pSNR).

Rangka kerja perbandingan yang digunakan untuk ujian termasuk FOMM dan face-vid2vid, serta AA-PCA, yang juga merupakan inovasi utama herotan tersirat kerana kaedah sebelumnya mempunyai sedikit atau tiada keupayaan untuk menggunakan berbilang bingkai utama, penyelidikan kakitangan juga mereka bentuk kaedah ujian yang serupa.

Ledingan tersirat mengatasi prestasi kaedah yang berbeza pada kebanyakan metrik.

Dalam ujian pembinaan semula bingkai kunci berbilang, di mana penyelidik menggunakan jujukan sehingga 180 bingkai dan bingkai jurang terpilih, herotan tersirat memenangi keseluruhan kali ini.

Apabila bilangan imej sumber meningkat, kaedah ini boleh mencapai hasil pembinaan semula yang lebih baik, dan markah semua penunjuk bertambah baik.

Dan apabila bilangan imej sumber meningkat, kesan pembinaan semula kerja terdahulu menjadi lebih teruk, bertentangan dengan jangkaan.

Selepas menjalankan penyelidikan kualitatif oleh kakitangan AMT, ia juga dipercayai bahawa hasil penjanaan ubah bentuk tersirat adalah lebih kuat daripada kaedah lain.

Memiliki akses kepada rangka kerja ini, pengguna akan dapat mencipta simulasi video yang lebih koheren, lebih panjang dan video palsu dalam badan penuh, sambil Mampu mempamerkan julat pergerakan yang jauh lebih besar daripada mana-mana bingkai yang sistem telah diuji.

Tetapi penyelidikan terhadap sintesis imej yang lebih realistik juga membawa kebimbangan, kerana teknik ini boleh digunakan dengan mudah untuk pemalsuan, dan terdapat penafian standard dalam kertas itu.

Jika kaedah kami digunakan untuk mencipta produk DeepFake, ia mungkin mempunyai akibat negatif. Sintesis pertuturan berniat jahat mencipta imej palsu orang dengan memindahkan dan menghantar maklumat palsu merentas identiti, yang membawa kepada kecurian identiti atau penyebaran berita palsu. Tetapi dalam tetapan terkawal, teknologi yang sama juga boleh digunakan untuk tujuan hiburan.

Makalah ini juga menunjukkan potensi sistem ini untuk pembinaan semula video saraf, seperti Project Starline Google Dalam rangka kerja ini, kerja pembinaan semula tertumpu terutamanya pada pelanggan, memanfaatkan input yang jarang daripada. orang di hujung yang lain.

Penyelesaian ini menarik lebih banyak minat daripada komuniti penyelidikan, dan sesetengah syarikat berhasrat untuk melaksanakan panggilan persidangan lebar jalur rendah dengan menghantar data gerakan tulen atau bingkai kunci yang jarang dijarakkan akan Ditafsirkan dan dimasukkan ke dalam video HD penuh apabila mencapai pelanggan sasaran.

Atas ialah kandungan terperinci DeepFake tidak pernah begitu nyata! Seberapa kuat 'herotan tersirat' terbaru Nvidia?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI