Rumah >Peranti teknologi >AI >Google membelanjakan $400 juta untuk Anthrophic: Pengiraan latihan model AI meningkat 1,000 kali ganda dalam 5 tahun!

Google membelanjakan $400 juta untuk Anthrophic: Pengiraan latihan model AI meningkat 1,000 kali ganda dalam 5 tahun!

- PHPzke hadapan

- 2023-04-11 19:27:401218semak imbas

Sejak penemuan undang-undang penskalaan, orang berpendapat bahawa perkembangan kecerdasan buatan akan secepat roket.

Pada tahun 2019, pelbagai mod, penaakulan logik, kelajuan pembelajaran, pembelajaran pemindahan silang tugas dan ingatan jangka panjang masih akan mempunyai "dinding" yang melambatkan atau menghentikan kemajuan tiruan kecerdasan. Pada tahun-tahun sejak itu, "dinding" penaakulan multimodal dan logik telah turun.

Memandangkan perkara ini, kebanyakan orang semakin yakin bahawa kemajuan pesat dalam kecerdasan buatan akan berterusan dan bukannya terbantut atau menurun.

Kini, prestasi sistem kecerdasan buatan hampir sama dengan tahap manusia dalam sejumlah besar tugas, dan kos latihan sistem ini jauh lebih rendah daripada Teleskop Angkasa Hubble dan Large Hadron Collider Ia adalah projek "sains besar", jadi AI mempunyai potensi besar untuk pembangunan masa depan.

Walau bagaimanapun, risiko keselamatan yang dibawa oleh pembangunan semakin ketara.

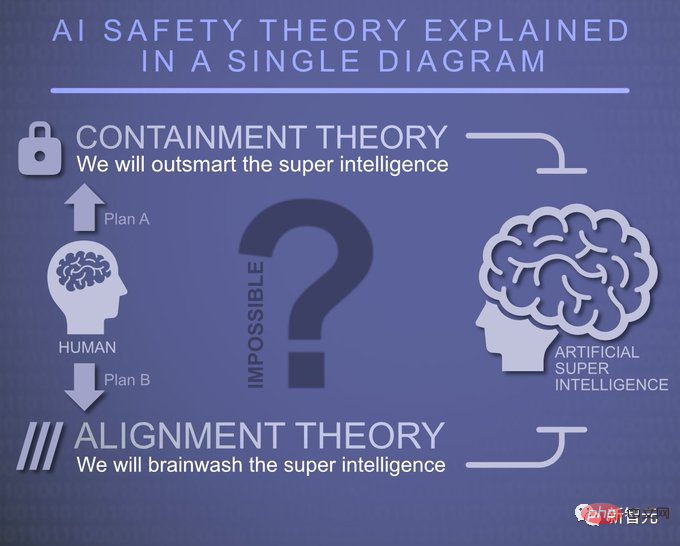

Mengenai isu keselamatan kecerdasan buatan, Anthropic menganalisis tiga kemungkinan:

Dalam keadaan optimistik, kemungkinan risiko bencana yang disebabkan oleh kecerdasan buatan lanjutan akibat kegagalan keselamatan adalah sangat kecil. Teknologi keselamatan yang telah dibangunkan, seperti Pembelajaran Pengukuhan daripada Maklum Balas Manusia (RLHF) dan Kepintaran Buatan Perlembagaan (CAI), sebahagian besarnya mencukupi untuk menangani risiko.

Risiko utama ialah penyalahgunaan yang disengajakan dan potensi bahaya yang disebabkan oleh automasi yang meluas dan perubahan dalam dinamik kuasa antarabangsa, yang memerlukan makmal AI dan pihak ketiga seperti akademia dan agensi masyarakat sivil menjalankan penyelidikan yang meluas untuk membantu penggubal dasar menavigasi beberapa potensi risiko struktur yang ditimbulkan oleh kecerdasan buatan lanjutan.

Risiko malapetaka sama ada baik atau buruk adalah hasil yang mungkin dan munasabah daripada pembangunan kecerdasan buatan termaju, dan kita memerlukan usaha saintifik dan kejuruteraan yang besar untuk mengelakkannya Risiko ini, untuk contoh, boleh dielakkan melalui "punch kombinasi" yang disediakan oleh Anthropic.

Penyelidikan keselamatan semasa Anthropic

Anthropic kini bekerja dalam pelbagai arah yang berbeza, terutamanya Divided ke dalam tiga bidang: keupayaan AI dalam penulisan, pemprosesan atau penjanaan imej, permainan, dsb.; membangunkan algoritma baharu untuk melatih keupayaan penjajaran sistem kecerdasan buatan menilai dan memahami sama ada sistem kecerdasan buatan benar-benar sejajar, sejauh mana keberkesanannya, dan mereka; Keupayaan aplikasi.

Anthropic telah melancarkan projek berikut untuk mengkaji cara melatih kecerdasan buatan yang selamat.

Kebolehtafsiran Mekanisme

Kebolehtafsiran Mekanisme, iaitu, cuba merekayasa terbalik rangkaian neural menjadi algoritma yang boleh difahami oleh manusia, sama seperti bagaimana orang memahami sesuatu yang tidak diketahui, Ia adalah mungkin untuk kejuruteraan terbalik program komputer yang berpotensi tidak selamat.

Anthropic berharap ia dapat membolehkan kami melakukan sesuatu yang serupa dengan "semakan kod", yang boleh menyemak model dan menentukan aspek tidak selamat untuk memberikan jaminan keselamatan yang kukuh.

Ini adalah masalah yang sangat sukar, tetapi tidak mustahil seperti yang disangka.

Di satu pihak, model bahasa ialah program komputer yang besar dan kompleks (fenomena "superposisi" menjadikan perkara lebih sukar). Sebaliknya, terdapat tanda-tanda bahawa pendekatan ini mungkin lebih mudah diselesaikan daripada satu pemikiran pertama. Anthropic telah berjaya memperluaskan pendekatan ini kepada model bahasa kecil, malah menemui mekanisme yang seolah-olah memacu pembelajaran kontekstual, dan mempunyai pemahaman yang lebih baik tentang mekanisme yang bertanggungjawab untuk ingatan.

Penyelidikan kebolehtafsiran Antropic mahu mengisi kekosongan yang ditinggalkan oleh jenis sains pilihatur lain. Sebagai contoh, mereka percaya bahawa salah satu perkara paling berharga yang boleh dihasilkan oleh penyelidikan kebolehtafsiran ialah keupayaan untuk mengenal pasti sama ada model diselaraskan secara menipu.

Dalam banyak cara, masalah ketekalan teknikal tidak dapat dipisahkan daripada masalah mengesan tingkah laku buruk dalam model AI.

Jika tingkah laku buruk dapat dikesan dengan mantap dalam situasi baharu (mis. dengan "membaca fikiran model"), maka kita boleh mencari cara yang lebih baik untuk melatih model yang tidak mempamerkan model kegagalan ini.

Anthropic percaya bahawa dengan lebih memahami cara kerja terperinci rangkaian saraf dan pembelajaran, rangkaian alat yang lebih luas boleh dibangunkan dalam usaha mencari keselamatan.

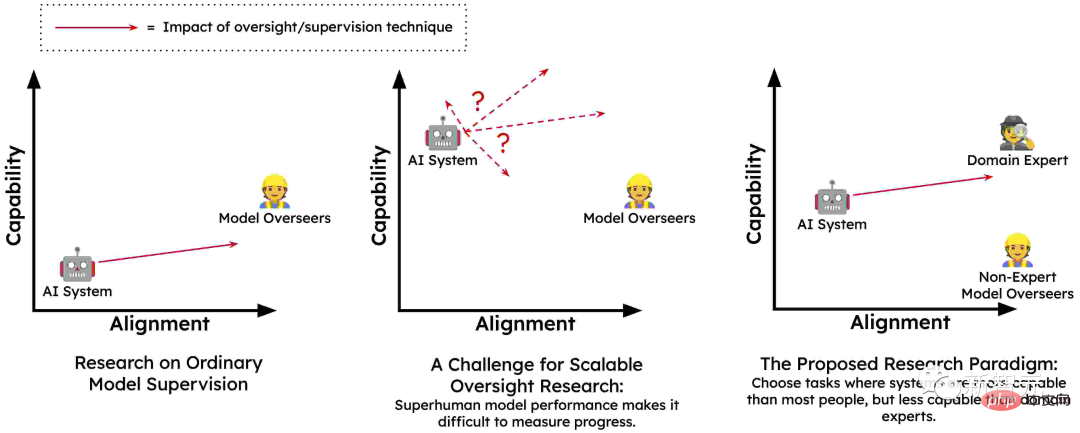

Penyeliaan Berskala

Mentransformasikan model bahasa kepada sistem kecerdasan buatan bersatu memerlukan sejumlah besar maklum balas berkualiti tinggi untuk membimbing tingkah laku mereka. Sebab utama ialah manusia mungkin tidak dapat memberikan maklum balas yang tepat yang diperlukan untuk melatih model dengan secukupnya untuk mengelakkan tingkah laku berbahaya dalam pelbagai persekitaran.

Mungkin manusia tertipu oleh sistem AI untuk memberikan maklum balas yang mencerminkan keperluan sebenar mereka (mis., secara tidak sengaja memberikan maklum balas positif untuk cadangan yang mengelirukan). Dan manusia tidak boleh melakukan ini secara berskala, yang merupakan masalah penyeliaan berskala dan merupakan teras latihan sistem AI yang selamat dan konsisten.

Oleh itu, Anthropic percaya bahawa satu-satunya cara untuk menyediakan penyeliaan yang diperlukan ialah membenarkan sistem AI menyelia sebahagian diri mereka sendiri atau membantu manusia dalam menyelia diri mereka sendiri. Dalam beberapa cara, sejumlah kecil penyeliaan manusia berkualiti tinggi dikuatkan kepada sejumlah besar penyeliaan kecerdasan buatan berkualiti tinggi.

Idea ini telah menunjukkan janji melalui teknologi seperti RLHF dan AI Perlembagaan, dan model bahasa sudah pun dilatih terlebih dahulu Setelah mempelajari banyak tentang nilai kemanusiaan, seseorang boleh mengharapkan model yang lebih besar untuk mempunyai pemahaman yang lebih tepat tentang nilai kemanusiaan.

Satu lagi ciri utama penyeliaan boleh skala, terutamanya teknik seperti CAI, ialah ia membolehkan pasukan merah automatik (aka latihan lawan). Iaitu, mereka secara automatik boleh menjana input yang berpotensi bermasalah kepada sistem AI, melihat cara mereka bertindak balas, dan kemudian secara automatik melatih mereka untuk berkelakuan dengan cara yang lebih jujur dan tidak berbahaya.

Selain CAI, terdapat pelbagai kaedah penyeliaan berskala seperti penyeliaan bantuan manusia, perbahasan AI-AI, pasukan merah RL berbilang ejen, dan penilaian penjanaan model. Melalui kaedah ini, model boleh lebih memahami nilai manusia dan tingkah laku mereka akan lebih konsisten dengan nilai kemanusiaan. Dengan cara ini, Anthropic boleh melatih sistem keselamatan yang lebih berkuasa.

Ketahui prosesnya, bukan hasilnya

Salah satu cara untuk mempelajari tugasan baharu ialah melalui percubaan dan kesilapan. Jika anda tahu hasil akhir yang diingini, anda boleh terus mencuba strategi baharu sehingga anda berjaya. Anthropic memanggil ini "pembelajaran berorientasikan hasil."

Dalam proses ini, strategi ejen ditentukan sepenuhnya oleh hasil yang diingini, dan akan cenderung memilih beberapa strategi kos rendah untuk membolehkannya mencapai matlamat ini.

Cara belajar yang lebih baik biasanya dengan membiarkan pakar membimbing anda dan memahami proses kejayaan mereka. Semasa pusingan latihan, kejayaan anda mungkin tidak begitu penting kerana anda boleh menumpukan pada meningkatkan pendekatan anda.

Semasa anda maju, anda boleh berunding dengan jurulatih anda untuk meneruskan strategi baharu untuk melihat sama ada strategi itu lebih berkesan untuk anda. Ini dipanggil "pembelajaran berorientasikan proses." Dalam pembelajaran berorientasikan proses, hasil akhir bukanlah matlamat, tetapi menguasai proses adalah kuncinya.

Banyak kebimbangan tentang keselamatan sistem kecerdasan buatan termaju, sekurang-kurangnya pada peringkat konsep, boleh ditangani dengan melatih sistem ini dalam cara yang berorientasikan proses.

Pakar manusia akan terus memahami pelbagai langkah yang diikuti oleh sistem AI, dan agar proses ini digalakkan, mereka mesti menerangkan sebabnya kepada manusia.

Sistem AI tidak akan diberi ganjaran kerana berjaya dalam cara yang sukar difahami atau berbahaya, kerana ia hanya akan diberi ganjaran berdasarkan keberkesanan dan kebolehfahaman proses mereka.

Dengan cara ini mereka tidak akan diberi ganjaran kerana mengejar sub-matlamat yang bermasalah (seperti pemerolehan sumber atau penipuan) seperti yang dilakukan oleh manusia atau ejen mereka semasa latihan untuk proses pemerolehannya Memberi maklum balas negatif.

Anthropic percaya bahawa "pembelajaran berorientasikan proses" mungkin merupakan cara yang paling menjanjikan untuk melatih sistem yang selamat dan telus, dan ia juga merupakan kaedah paling mudah.

Memahami Generalisasi

Kebolehtafsiran mekanistik berfungsi membuat kejuruteraan terbalik pengiraan yang dilakukan oleh rangkaian saraf. Anthropic juga berusaha untuk mendapatkan pemahaman yang lebih terperinci tentang prosedur latihan untuk model bahasa besar (LLM).

LLM telah menunjukkan pelbagai tingkah laku baharu yang mengejutkan, daripada kreativiti yang menakjubkan kepada perlindungan diri kepada penipuan. Semua tingkah laku ini datang daripada data latihan, tetapi prosesnya rumit:

Model ini mula-mula "dilatih" pada sejumlah besar teks asal, mempelajari pelbagai perwakilan daripada itu, dan mensimulasikan keupayaan ejen yang berbeza. Mereka kemudiannya diperhalusi dalam pelbagai cara, beberapa daripadanya mungkin mempunyai akibat yang mengejutkan.

Disebabkan penparameteran berlebihan dalam fasa penalaan halus, model yang dipelajari sangat bergantung pada bias tersirat yang telah dilatih, yang datang daripada kebanyakan pengetahuan dunia Rangkaian perwakilan kompleks yang dibina dalam pra-latihan.

Apabila model berkelakuan dengan cara yang membimbangkan, seperti apabila ia bertindak sebagai AI yang mengelirukan, adakah ia hanya memuntahkan urutan latihan yang hampir serupa tanpa memudaratkan? Atau adakah tingkah laku ini (dan juga kepercayaan dan nilai yang membawa kepadanya) menjadi bahagian penting dalam konsep model pembantu AI sehingga mereka menerapkannya dalam konteks yang berbeza?

Anthropic sedang mengusahakan teknik yang cuba mengesan output model kembali ke data latihan untuk mengenal pasti petunjuk penting yang boleh membantu memahami tingkah laku ini.

Pengujian Mod Kegagalan Berbahaya

Isu utama ialah AI lanjutan boleh membangunkan tingkah laku timbul yang berbahaya, seperti penipuan atau keupayaan perancangan strategik, Tingkah laku ini tidak terdapat dalam yang lebih kecil. dan sistem yang kurang berkemampuan.

Sebelum masalah ini menjadi ancaman segera, Anthropic percaya bahawa cara untuk meramalkannya adalah dengan membina persekitaran. Jadi, mereka sengaja melatih sifat-sifat ini menjadi model berskala kecil. Kerana model ini tidak cukup kuat untuk menimbulkan bahaya, mereka boleh diasingkan dan dikaji.

Anthropic amat berminat dengan cara sistem AI berkelakuan di bawah "kesedaran situasi" - contohnya, apabila mereka menyedari bahawa mereka adalah AI yang bercakap dengan manusia dalam persekitaran latihan , bagaimana ini mempengaruhi tingkah laku mereka semasa latihan? Bolehkah sistem AI menjadi menipu, atau membangunkan matlamat yang sangat tidak optimum?

Sebaik-baiknya, mereka ingin membina model kuantitatif terperinci tentang cara kecenderungan ini berubah mengikut skala, supaya mod kegagalan mendadak dan berbahaya boleh diramalkan lebih awal.

Pada masa yang sama, Anthropic juga mengambil berat tentang risiko yang berkaitan dengan penyelidikan itu sendiri:

Jika penyelidikan dijalankan pada yang lebih kecil model, tidak ada kemungkinan risiko serius jika dilakukan pada model yang lebih besar dan lebih berkebolehan. Oleh itu, Anthropic tidak bercadang untuk menjalankan penyelidikan seperti ini terhadap model yang boleh menyebabkan kemudaratan yang serius.

Impak Sosial dan Penilaian

Tunjang utama penyelidikan Anthropic ialah menilai secara kritis dan memahami keupayaan, batasan dan keupayaan sistem AI dengan mewujudkan alat, pengukuran dan Potensi. Kesan Sosial Kesan sosial yang berpotensi.

Sebagai contoh, Anthropic telah menerbitkan penyelidikan yang menganalisis kebolehramalan model bahasa besar, di mana mereka melihat kebolehramalan dan ketidakpastian tahap tinggi model ini dan menganalisis bagaimana sifat ini Membawa kepada tingkah laku berbahaya .

Dalam kerja ini, mereka menyiasat pendekatan kepada model bahasa gabungan merah untuk mencari dan mengurangkan bahaya dengan meneliti keluaran model pada skala model yang berbeza. Baru-baru ini, mereka mendapati bahawa model bahasa semasa boleh mengikut arahan dan mengurangkan berat sebelah dan stereotaip.

Anthropic sangat prihatin tentang cara aplikasi pantas sistem kecerdasan buatan akan memberi kesan kepada masyarakat dalam jangka pendek, sederhana dan panjang.

Dengan menjalankan penyelidikan yang teliti tentang kesan AI hari ini, mereka menyasarkan untuk menyediakan penggubal dasar dan penyelidik hujah dan alat yang mereka perlukan untuk membantu mengurangkan kemungkinan krisis masyarakat yang besar dan memastikan manfaat AI dapat memberi manfaat kepada orang ramai.

Kesimpulan

Kecerdasan buatan akan memberi kesan yang tidak pernah berlaku sebelum ini kepada dunia dalam tempoh sepuluh tahun akan datang. Pertumbuhan eksponen dalam kuasa pengkomputeran dan peningkatan yang boleh diramal dalam keupayaan kecerdasan buatan menunjukkan bahawa teknologi masa depan akan jauh lebih maju daripada hari ini.

Walau bagaimanapun, kami belum mempunyai pemahaman yang kukuh tentang cara memastikan sistem berkuasa ini disepadukan rapat dengan nilai kemanusiaan, dan oleh itu tidak dapat menjamin bahawa risiko kegagalan bencana akan diminimumkan . Oleh itu, kita mesti sentiasa bersedia untuk situasi yang kurang optimistik.

Melalui penyelidikan empirikal dari pelbagai sudut, "tebuk kombinasi" kerja keselamatan yang disediakan oleh Anthropic nampaknya dapat membantu kami menyelesaikan isu keselamatan kecerdasan buatan.

Syor keselamatan daripada Anthropic ini memberitahu kami:

"Untuk meningkatkan pemahaman kami tentang cara sistem AI belajar dan membuat generalisasi kepada dunia sebenar, bangunkan penyeliaan sistem AI boleh skala dan teknologi semakan, cipta sistem AI yang telus dan boleh dijelaskan, melatih sistem AI untuk mengikuti proses keselamatan dan bukannya mengejar keputusan, menganalisis mod kegagalan AI yang berpotensi berbahaya dan cara menghalangnya, menilai kecerdasan buatan Kesan sosial kecerdasan untuk membimbing dasar dan penyelidikan, dsb. 》

Kami masih dalam peringkat penerokaan untuk pertahanan yang sempurna terhadap kecerdasan buatan, tetapi Anthropic telah memberi anda panduan yang baik.

Atas ialah kandungan terperinci Google membelanjakan $400 juta untuk Anthrophic: Pengiraan latihan model AI meningkat 1,000 kali ganda dalam 5 tahun!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI