Rumah >Peranti teknologi >AI >Terdapat juga Transformer dalam otak! Mekanisme yang sama seperti 'hippocampus'

Terdapat juga Transformer dalam otak! Mekanisme yang sama seperti 'hippocampus'

- PHPzke hadapan

- 2023-04-11 15:43:031742semak imbas

Saya tidak boleh menciptanya, dan saya juga tidak memahaminya Untuk mencipta kecerdasan buatan, kita mesti terlebih dahulu memahami otak manusia Betapa pintarnya.

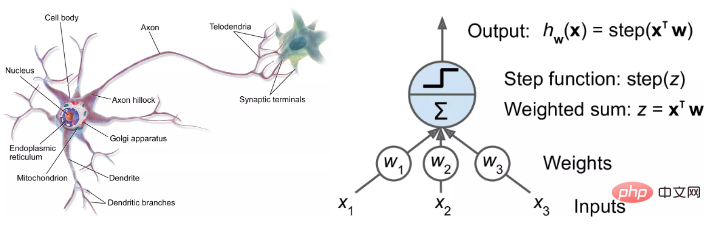

Dengan kelahiran rangkaian saraf dan perkembangan cemerlangnya yang seterusnya, para penyelidik telah mencari penjelasan biologi

dan kemajuan biologi untuk rangkaian saraf itu juga memberi inspirasi kepada penyelidik AI untuk membangunkan model baharu.

Tetapi penyelidik dalam bidang kecerdasan buatan sebenarnya mempunyai usaha yang lebih bercita-cita tinggi:  Menggunakan model AI untuk membantu memahami otak

Menggunakan model AI untuk membantu memahami otak

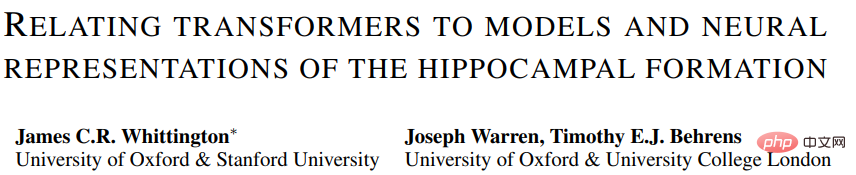

Penyelidikan terkini mendapati walaupun model Transformer

yang paling popular telah dibangunkantanpa sebarang bantuan daripada pengetahuan biologi , tetapi struktur nya sangat serupa dengan struktur hippocampus otak manusia .

Pautan kertas: https://arxiv.org/pdf/2112.04035.pdf

Pautan kertas: https://arxiv.org/pdf/2112.04035.pdf

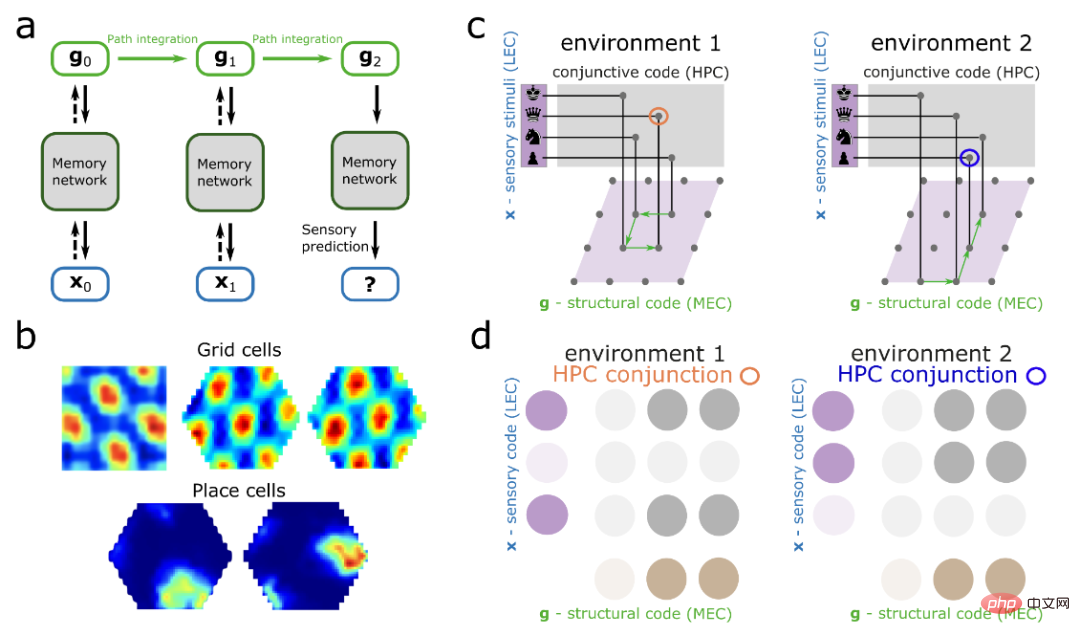

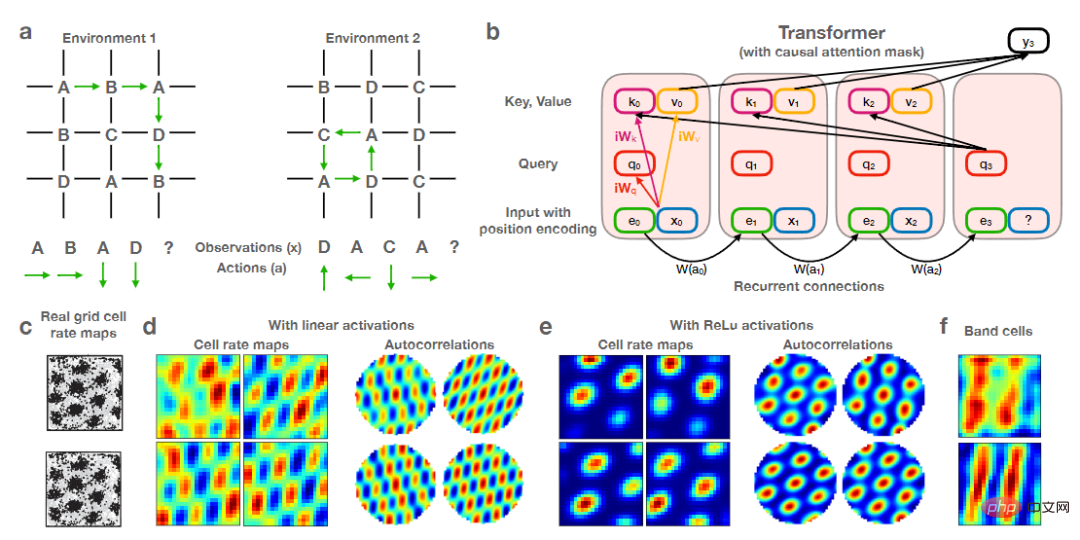

Selepas melengkapkan Transformer dengan pengekodan kedudukan rekursif, penyelidik mendapati model itu boleh mereplikasi dengan tepat perwakilan spatial

pembentukan hippocampal.Walau bagaimanapun, penulis juga mengatakan bahawa dia tidak terkejut dengan keputusan ini, kerana Transformer berkait rapat dengan model hippocampal

semasa dalam neurosains, yang paling jelas. ialahSel letak (sel letak) dan Sel grid (sel grid). Selain itu, didapati melalui eksperimen bahawa model Transformer mempunyai peningkatan prestasi yang besar berbanding model yang disediakan oleh versi neurosains.

Kerja ini menggabungkan pengiraan rangkaian saraf tiruan dan rangkaian otak untuk memberikan pemahaman baharu tentang interaksi antara hippocampus dan korteks serebrum

, dan membayangkan bagaimana kawasan kortikal mungkin melaksanakanpelbagai tugas kompleks yang lebih luas melangkaui model saintifik saraf semasa , seperti pemahaman bahasa. Transformer meniru hippocampus?

Masih sukar bagi manusia untuk memahami otak mereka sendiri Contohnya, mengkaji cara otak mengatur dan mengakses maklumat spatial untuk menyelesaikan "di mana kita berada, apa yang ada di sekeliling dan bagaimana untuk sampai ke sana. " masih merupakan satu tugas yang sukar. cabaran.Seluruh proses mungkin melibatkan panggilan keseluruhan rangkaian memori dan menyimpan data spatial daripada berpuluh bilion neuron, setiap satu disambungkan kepada beribu-ribu neuron lain.

Walaupun ahli sains saraf telah mengenal pasti beberapa elemen utama, seperti sel grid, neuron yang memetakan kedudukan, cara untuk pergi lebih dalam masih tidak diketahui: penyelidik tidak boleh bergerak Bahagikan dan kaji kepingan jirim kelabu manusia untuk dilihat bagaimana memori berasaskan lokasi bagi imej, bunyi dan bau mengalir dan bersambung antara satu sama lain.

Model kecerdasan buatan menyediakan cara lain untuk memahami otak manusia Selama bertahun-tahun, ahli sains saraf telah menggunakan pelbagai jenis rangkaian saraf untuk mensimulasikan penembakan neuron dalam otak.

Penyelidikan terkini menunjukkan bahawa hippocampus (struktur otak yang penting untuk ingatan) pada asasnya serupa dengan model Transformer.

Penyelidik telah mencapai beberapa keputusan yang luar biasa menggunakan model baharu untuk mengesan maklumat spatial dengan cara yang serupa dengan kerja dalaman otak.

James Whittington, ahli sains saraf kognitif dari Universiti Oxford dan Universiti Stanford, berkata apabila kita tahu bahawa model otak ini bersamaan dengan Transformer, ia bermakna Model baharu akan berprestasi lebih baik dan lebih mudah untuk dilatih.

Seperti yang dilihat daripada kerja Whittington dan lain-lain, Transformer boleh meningkatkan keupayaan model rangkaian saraf untuk meniru pelbagai pengiraan yang dilakukan oleh sel grid dan bahagian lain otak.

Whittington berkata model sedemikian boleh memajukan pemahaman kita tentang cara rangkaian saraf tiruan berfungsi, dan kemungkinan besar, cara pengiraan dilakukan dalam otak.

David Ha, seorang saintis komputer di Google Brain yang kebanyakannya terlibat dalam penyelidikan model Transformer, berkata bahawa kami tidak cuba mencipta semula otak baharu, tetapi bolehkah kami mencipta mekanisme untuk melakukan apa yang otak boleh buat?

Transformer pertama kali dicadangkan lima tahun lalu sebagai model baharu untuk kecerdasan buatan untuk memproses bahasa semula jadi Ia juga merupakan senjata rahsia "model bintang" seperti BERT dan GPT-3. . Model ini boleh menjana lirik lagu yang meyakinkan, mengarang soneta Shakespeare, atau melakukan beberapa kerja perkhidmatan pelanggan manusia.

Mekanisme teras Transformer ialah perhatian kendiri, di mana setiap input (seperti perkataan, piksel, nombor dalam urutan) sentiasa disambungkan kepada semua input lain dan rangkaian neural biasa yang lain hanya menyambungkan input kepada input tertentu.

Walaupun Transformer direka khusus untuk tugasan bahasa semula jadi, penyelidikan seterusnya juga membuktikan bahawa Transformer juga berfungsi dengan baik dalam tugasan lain, seperti mengelaskan imej, dan kini Otak dimodelkan.

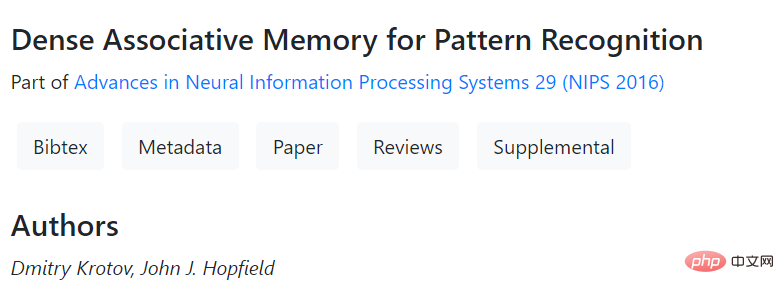

Pada tahun 2020, pasukan yang diketuai oleh Sepp Hochreiter, seorang saintis komputer di Universiti Johann Kepler di Linz, Austria (pengarang pertama kertas LSTM), menggunakan Transformer untuk menggunakan semula alat yang berkuasa. , jangka panjang Model perolehan ingatan sedia ada Rangkaian Hopfield.

Pertama kali dicadangkan oleh ahli fizik Princeton John Hopfield 40 tahun yang lalu, rangkaian ini mengikut peraturan umum: Neuron yang aktif pada masa yang sama mewujudkan hubungan yang kukuh antara satu sama lain.

Hochreiter dan rakan usaha samanya menyatakan bahawa penyelidik sentiasa mencari model perolehan semula ingatan yang lebih baik, dan mereka melihat cara kelas baharu rangkaian Hopfield mendapatkan semula ingatan dan cara Transformers melakukan hubungan perhatian antara daya.

Dibangunkan oleh Hopfield dan Dmitry Krotov dari Makmal Kepintaran Buatan MIT-IBM Watson, rangkaian Hopfield baharu ini menampilkan sambungan yang lebih cekap daripada rangkaian Hopfield standard, lebih banyak kenangan boleh disimpan dan diambil semula.

Pautan kertas: https://papers.nips.cc/paper/2016/hash/eaae339c4d89fc102edd9dbdb6a28915

Pasukan Hochreiter menaik taraf rangkaian ini dengan menambahkan peraturan yang serupa dengan mekanisme perhatian dalam Transformer.

Pada tahun 2022, kertas baharu ini melaraskan lagi kaedah Hochreiter dan mengubah suai Transformer supaya ia tidak lagi menganggap ingatan sebagai urutan linear, tetapi seperti rentetan dalam perkataan ayat, mengekodkannya sebagai koordinat dalam ruang berdimensi tinggi.

Para penyelidik mengatakan "putaran" ini meningkatkan lagi prestasi model pada tugasan neurosains. Keputusan eksperimen juga menunjukkan bahawa model itu secara matematik setara dengan model pola penembakan sel grid yang dilihat oleh ahli sains saraf dalam imbasan fMRI.

Caswell Barry, ahli sains saraf di University College London, berkata bahawa sel grid mempunyai struktur teratur yang menarik, cantik dan dengan corak yang menarik yang tidak Terlalu mungkin muncul secara rawak.

Kerja baharu ini menunjukkan cara Transformer mereplikasi dengan tepat corak yang diperhatikan dalam hippocampus.

Mereka juga menyedari bahawa model Transformer boleh mengetahui di mana ia berdasarkan keadaan sebelumnya dan bagaimana ia bergerak, dan dengan cara yang penting ke dalam model sel grid tradisional.

Beberapa karya terbaru lain juga mencadangkan bahawa Transformers boleh memajukan pemahaman kita tentang fungsi otak yang lain.

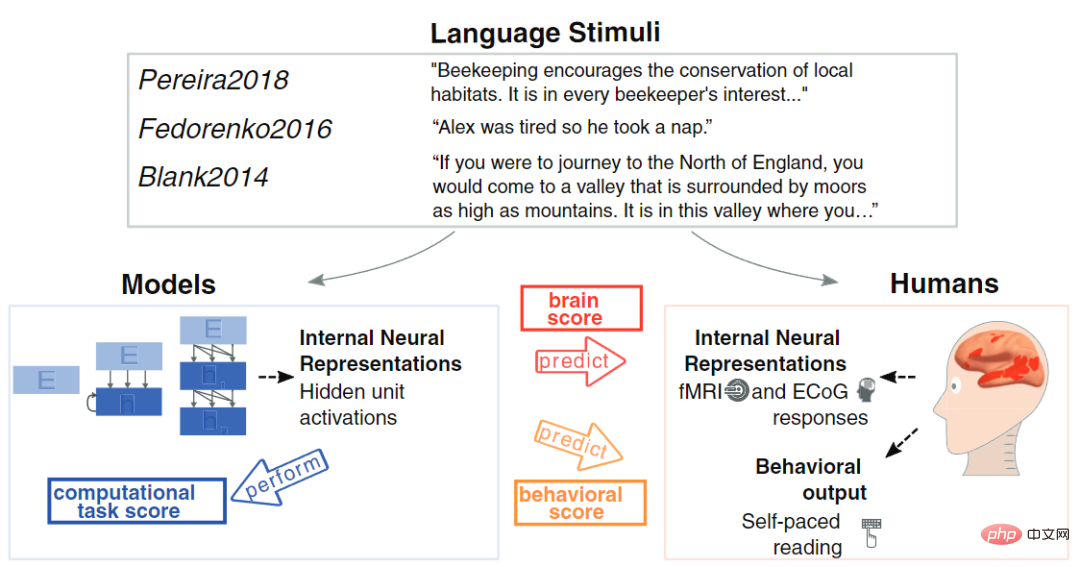

Tahun lepas, pakar neurosains pengiraan MIT, Martin Schrimpf menganalisis 43 model rangkaian saraf yang berbeza untuk memahami kesannya terhadap pengukuran aktiviti saraf manusia yang dilaporkan oleh fMRI dan elektrokortikografi.

Beliau mendapati Transformer kini merupakan rangkaian neural terkemuka dan paling maju yang boleh meramalkan hampir semua perubahan yang terdapat dalam pengimejan.

David Ha dan Yujin Tang, juga seorang saintis komputer, baru-baru ini mereka bentuk model yang boleh secara sengaja memasukkan sejumlah besar data ke dalam Transformer secara rawak dan tidak teratur, meniru cara manusia badan menghantar data ke otak. Ternyata Transformer berjaya memproses aliran maklumat yang tidak teratur sama seperti otak kita.

Pautan kertas: https://arxiv.org/abs/2111.14377

Yujin Tang berkata bahawa rangkaian saraf adalah berwayar keras dan hanya boleh menerima input tertentu. Tetapi dalam kehidupan sebenar, set data sering berubah dengan cepat, dan kebanyakan AI tidak mempunyai sebarang cara untuk menyesuaikan diri. Pada masa hadapan kami ingin mencuba seni bina yang boleh menyesuaikan diri dengan cepat.

Atas ialah kandungan terperinci Terdapat juga Transformer dalam otak! Mekanisme yang sama seperti 'hippocampus'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI