Rumah >Peranti teknologi >AI >'Teknologi penjanaan imej' mengembara di tepi undang-undang: Kertas kerja ini mengajar anda untuk mengelak daripada menjadi 'defendan'

'Teknologi penjanaan imej' mengembara di tepi undang-undang: Kertas kerja ini mengajar anda untuk mengelak daripada menjadi 'defendan'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 14:55:031551semak imbas

Dalam beberapa tahun kebelakangan ini, kandungan yang dijana AI (AIGC) telah menarik banyak perhatian Kandungannya meliputi imej, teks, audio, video, dll. Walau bagaimanapun, AIGC telah menjadi pedang bermata dua kerana penggunaannya yang tidak bertanggungjawab. Sangat kontroversi.

Setelah teknologi penjanaan imej tidak digunakan dengan betul, anda boleh menjadi "defendan".

Baru-baru ini, penyelidik dari Sony AI dan Wisdom Source telah membincangkan isu semasa AIGC dari banyak aspek dan cara menjadikan kandungan yang dijana AI lebih bertanggungjawab.

Pautan kertas: https://arxiv.org/pdf/2303.01325.pdf

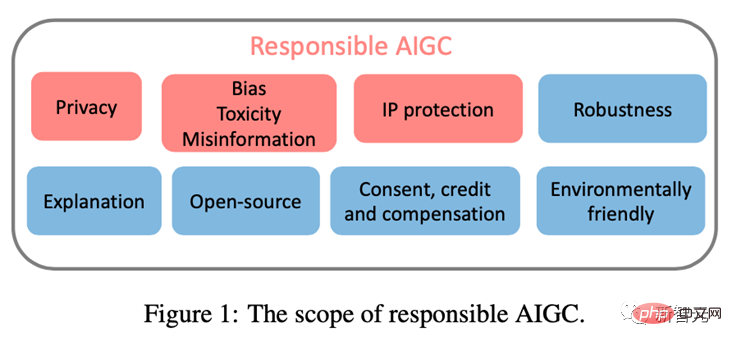

Artikel ini memfokuskan kepada tiga isu utama yang mungkin menghalang pembangunan sihat AIGC, termasuk: (1) Privasi; maklumat salah; (3) Harta Intelek (IP) Risiko.

Dengan mendokumentasikan risiko yang diketahui dan berpotensi, serta sebarang kemungkinan senario penyalahgunaan AIGC, artikel ini bertujuan untuk meningkatkan kesedaran Kebimbangan tentang potensi risiko dan penyalahgunaan AIGC dan menyediakan arahan untuk menangani risiko ini untuk menggalakkan pembangunan AIGC ke arah yang lebih beretika dan selamat untuk manfaat masyarakat.

PrivasiAdalah diketahui umum bahawa model asas yang besar mempunyai beberapa siri masalah kebocoran privasi.

Penyelidikan terdahulu telah menunjukkan bahawa penceroboh boleh menjana jujukan daripada model GPT-2 terlatih dan mengenal pasti urutan yang dihafal daripada set latihan, [Kandpal et al., 2022] mengaitkan kejayaan ini. pencerobohan privasi terhadap kehadiran data pendua dalam set latihan, dan penyelidikan telah menunjukkan bahawa jujukan yang muncul beberapa kali lebih berkemungkinan dijana daripada jujukan yang muncul sekali sahaja.

Memandangkan model AIGC dilatih pada data yang dikikis web berskala besar, isu overfitting dan kebocoran privasi menjadi sangat penting.

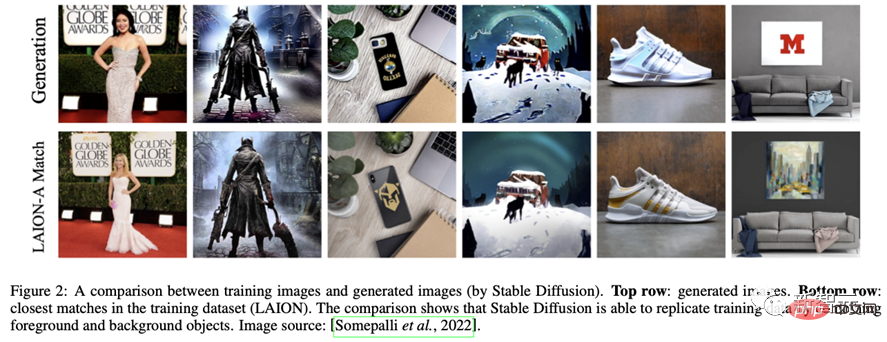

Sebagai contoh, model Stable Diffusion menghafal imej berulang dalam data latihan [Rombach et al., 2022c]. [Somepalli et al., 2022] menunjukkan bahawa model Stable Diffusion secara terang-terangan menyalin imej daripada data latihannya dan menjana gabungan mudah objek latar depan dan latar belakang dalam set data latihan.

Tambahan pula, model ini juga menunjukkan keupayaan untuk membina semula ingatan, dengan itu menjana objek yang semantik sama dengan asal tetapi objek mengikut piksel dalam bentuk yang berbeza. Kewujudan imej sedemikian menimbulkan kebimbangan mengenai memori dan pemilikan data.

Begitu juga, penyelidikan terkini menunjukkan bahawa sistem Imagen Google juga menghadapi masalah membocorkan foto orang sebenar dan imej berhak cipta. Dalam tuntutan mahkamah Matthew Butterick baru-baru ini [Butterick, 2023], beliau menegaskan bahawa kerana semua maklumat visual dalam sistem berasal daripada imej latihan berhak cipta, imej yang dijana, tanpa mengira penampilannya, mestilah hasil daripada imej latihan tersebut.

Begitu juga, DALL·E 2 mengalami masalah yang sama: kadangkala ia akan menyalin imej daripada data latihannya dan bukannya mencipta yang baharu.

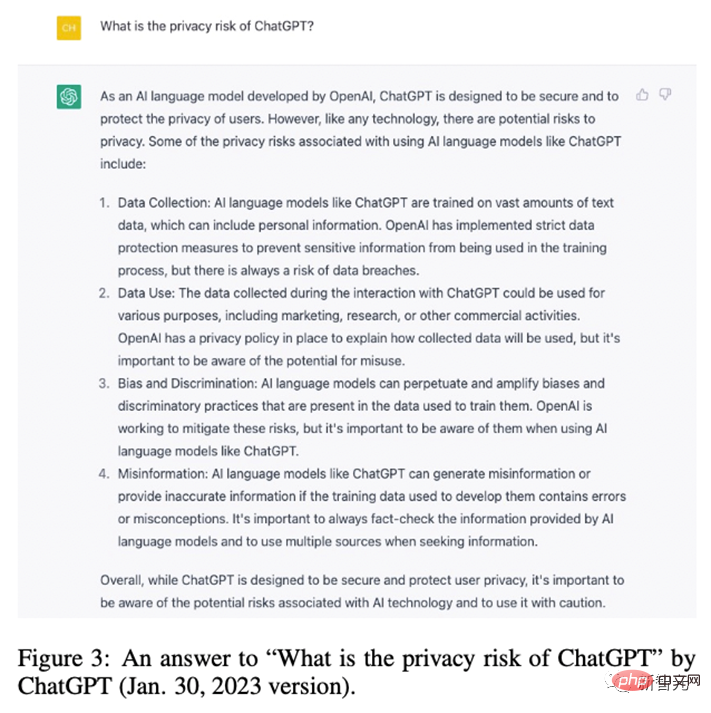

OpenAI mendapati fenomena ini berlaku kerana imej telah disalin beberapa kali dalam set data Begitu juga, ChatGPT sendiri mengakui bahawa ia mempunyai risiko kebocoran privasi.

Untuk mengurangkan masalah kebocoran privasi model besar, banyak syarikat dan penyelidik telah melakukan banyak usaha dalam pertahanan privasi. Di peringkat perindustrian, Stability AI telah mengiktiraf batasan Resapan Stabil.

Untuk tujuan ini, mereka menyediakan tapak web (https://rom1504.github.io/clip-retrieval/) untuk mengenal pasti imej yang dihafal oleh Stable Diffusion.

Selain itu, syarikat seni Spawning AI telah mencipta tapak web yang dipanggil "Have I Been Trained" (https://haveibeentrained.com) untuk membantu pengguna mengenal pasti foto atau karya mereka Sama ada ia digunakan untuk latihan kecerdasan buatan.

OpenAI cuba menyelesaikan isu privasi dengan mengurangkan pertindihan data.

Selain itu, syarikat seperti Microsoft dan Amazon telah melarang pekerja berkongsi data sensitif dengan ChatGPT untuk mengelakkan pekerja daripada membocorkan kerahsiaan, kerana maklumat ini boleh digunakan untuk latihan versi ChatGPT akan datang .

Di peringkat akademik, Somepalli et al mengkaji rangka kerja pengambilan imej untuk mengenal pasti pertindihan kandungan, dan Dockhorn et al juga mencadangkan model penyebaran privasi yang berbeza untuk memastikan privasi generatif model.

Bias, ketoksikan, maklumat salah

Data latihan untuk model AIGC berasal dari dunia nyata Walau bagaimanapun, data ini mungkin secara tidak sengaja mengukuhkan stereotaip yang berbahaya dan mengecualikan atau meminggirkan seseorang .

Model yang dilatih atau diperhalusi pada set data bermasalah ini mungkin mewarisi stereotaip berbahaya, berat sebelah dan ketoksikan sosial, malah menjana maklumat salah yang membawa kepada diskriminasi tidak adil dan bahaya kepada kumpulan sosial tertentu.

Sebagai contoh, model Stable Diffusion v1 dilatih terutamanya pada set data LAION-2B, yang hanya mengandungi imej dengan perihalan bahasa Inggeris. Oleh itu, model itu berat sebelah kepada orang kulit putih dan budaya Barat, dan isyarat daripada bahasa lain mungkin tidak diwakili sepenuhnya.

Sementara versi model Stable Diffusion yang berikutnya telah diperhalusi pada versi ditapis set data LAION, isu berat sebelah berterusan. Begitu juga, DALLA·E, DALLA·E 2 dan Imagen juga menunjukkan berat sebelah sosial dan stereotaip negatif kumpulan minoriti.

Selain itu, Imagen telah terbukti mempunyai berat sebelah sosial dan budaya walaupun semasa menjana imej bukan manusia. Disebabkan isu ini, Google memutuskan untuk tidak menyediakan Imagen kepada umum.

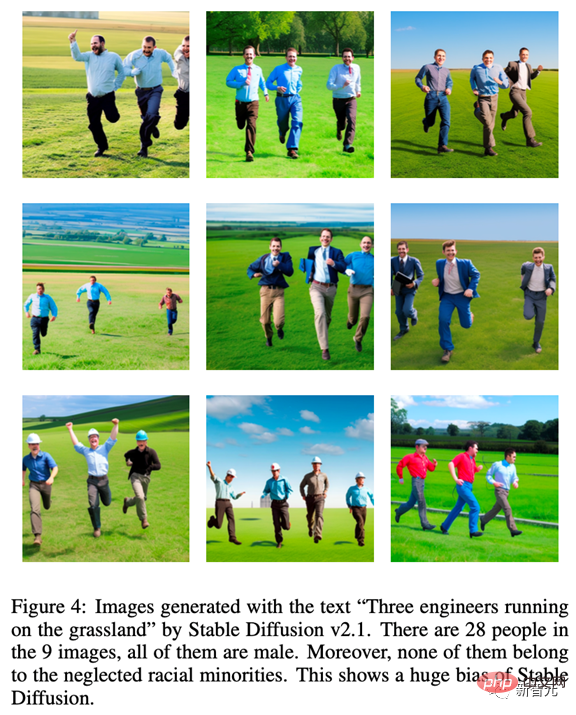

Untuk menggambarkan kecenderungan yang wujud pada model AIGC, kami menguji Stable Diffusion v2.1 dan menggunakan gesaan "Tiga jurutera yang berlari di padang rumput" untuk menjana imej yang semuanya lelaki Dan tidak ada yang tergolong dalam kumpulan minoriti yang diabaikan, yang menggambarkan kekurangan kepelbagaian dalam imej yang dihasilkan.

Selain itu, model AIGC juga mungkin menghasilkan maklumat yang salah. Sebagai contoh, kandungan yang dijana oleh GPT dan terbitannya mungkin kelihatan tepat dan berwibawa, tetapi mungkin mengandungi maklumat yang tidak betul sepenuhnya.

Oleh itu, ia mungkin memberikan maklumat yang mengelirukan di sesetengah kawasan (seperti sekolah, undang-undang, perubatan, ramalan cuaca). Contohnya, dalam bidang perubatan, jawapan yang diberikan oleh ChatGPT tentang dos perubatan mungkin tidak tepat atau tidak lengkap, yang boleh mengancam nyawa. Dalam bidang pengangkutan, jika pemandu mengikut peraturan lalu lintas yang salah diberikan oleh ChatGPT, ia boleh mengakibatkan kemalangan atau kematian.

Banyak pertahanan telah dibuat terhadap data dan model yang bermasalah.

OpenAI menapis halus set data latihan asal dan mengalih keluar sebarang kandungan ganas atau lucah dalam data latihan DALLA·E 2 Walau bagaimanapun, penapisan mungkin menimbulkan berat sebelah dalam data latihan, Kecondongan ini kemudiannya disebarkan kepada model hiliran.

Untuk menyelesaikan masalah ini, OpenAI membangunkan teknologi pra-latihan untuk mengurangkan berat sebelah yang disebabkan oleh penapis. Di samping itu, untuk memastikan model AIGC dapat mencerminkan situasi sosial semasa tepat pada masanya, penyelidik mesti sentiasa mengemas kini set data yang digunakan oleh model, yang akan membantu mencegah kesan negatif yang disebabkan oleh ketinggalan maklumat.

Perlu diambil perhatian bahawa walaupun berat sebelah dan stereotaip dalam data sumber boleh dikurangkan, ia mungkin masih tersebar atau bertambah teruk semasa latihan dan pembangunan model AIGC. Oleh itu, adalah penting untuk menilai kehadiran bias, ketoksikan dan maklumat salah sepanjang latihan model dan kitaran hayat pembangunan, bukan hanya pada peringkat sumber data.

Harta Intelektual (IP)

Dengan perkembangan pesat dan aplikasi AIGC yang meluas, isu hak cipta AIGC telah menjadi sangat penting.

Pada November 2022, Matthew Butterick memfailkan saman tindakan kelas terhadap anak syarikat Microsoft GitHub, menuduh perkhidmatan penjanaan kod produknya Copilot melanggar undang-undang hak cipta. Seperti model teks-ke-imej, beberapa model generatif telah dituduh melanggar hak asal artis terhadap karya mereka.

[Somepalli et al., 2022] menunjukkan bahawa imej yang dijana oleh Stable Diffusion boleh disalin daripada data latihan. Walaupun Stable Diffusion menafikan sebarang hak pemilikan ke atas imej yang dijana dan membenarkan pengguna menggunakannya secara bebas selagi kandungan imej itu sah dan tidak berbahaya, kebebasan ini masih mencetuskan pertikaian sengit mengenai hak cipta.

Model generatif seperti Stable Diffusion dilatih mengenai imej berskala besar daripada internet tanpa kebenaran daripada pemegang harta intelek, dan oleh itu, sesetengah pihak percaya ini melanggar hak mereka.

Untuk menyelesaikan isu harta intelek, banyak syarikat AIGC telah mengambil tindakan.

Contohnya, Midjourney telah memasukkan dasar alih keluar DMCA dalam syarat perkhidmatannya, membenarkan artis meminta karya mereka dialih keluar daripada set data jika pelanggaran hak cipta disyaki.

Begitu juga, Stability AI merancang untuk memberi artis pilihan untuk mengecualikan karya mereka daripada set latihan untuk versi Stable Diffusion yang akan datang. Selain itu, tera air teks [He et al., 2022a; He et al., 2022b] juga boleh digunakan untuk mengenal pasti sama ada alat AIGC ini menggunakan sampel daripada sumber lain tanpa kebenaran.

Contohnya, Stable Diffusion menjana imej dengan tera air Getty Images [Vincent, 2023].

OpenAI sedang membangunkan teknologi penanda air untuk mengenal pasti teks yang dijana oleh model GPT, alat yang boleh digunakan oleh pendidik untuk mengesan plagiarisme dalam tugasan. Google juga telah menggunakan tera air Parti pada imej yang diterbitkannya. Sebagai tambahan kepada tera air, OpenAI baru-baru ini mengeluarkan pengelas untuk membezakan antara teks yang dijana AI dan teks tulisan manusia.

Kesimpulan

Walaupun AIGC masih di peringkat awal, ia berkembang pesat dan akan kekal aktif untuk masa hadapan.

Untuk membolehkan pengguna dan syarikat memahami sepenuhnya risiko ini dan mengambil langkah yang sesuai untuk mengurangkan ancaman ini, kami merumuskan risiko semasa dan potensi dalam model AIGC dalam artikel ini.

Sekiranya potensi risiko ini tidak dapat difahami sepenuhnya dan langkah pencegahan risiko yang sesuai serta jaminan keselamatan diterima pakai, pembangunan AIGC mungkin menghadapi cabaran besar dan halangan pengawalseliaan. Oleh itu, kami memerlukan penyertaan komuniti yang lebih luas untuk menyumbang kepada AIGC yang bertanggungjawab.

Akhir sekali, terima kasih SonyAI dan BAAI!

Atas ialah kandungan terperinci 'Teknologi penjanaan imej' mengembara di tepi undang-undang: Kertas kerja ini mengajar anda untuk mengelak daripada menjadi 'defendan'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI