Rumah >Peranti teknologi >AI >Set data soal jawab saintifik pelbagai mod pertama dengan penjelasan terperinci, penaakulan model pembelajaran mendalam mempunyai rantai pemikiran

Set data soal jawab saintifik pelbagai mod pertama dengan penjelasan terperinci, penaakulan model pembelajaran mendalam mempunyai rantai pemikiran

- 王林ke hadapan

- 2023-04-11 12:52:031127semak imbas

Apabila menjawab soalan yang kompleks, manusia boleh memahami maklumat dalam modaliti yang berbeza dan membentuk Rantaian Pemikiran (CoT) yang lengkap. Bolehkah model pembelajaran mendalam membuka "kotak hitam" dan menyediakan rantaian pemikiran untuk proses penaakulannya? Baru-baru ini, UCLA dan Institut Allen untuk Kecerdasan Buatan (AI2) mencadangkan ScienceQA, set data soalan dan jawapan saintifik pelbagai mod pertama dengan penjelasan terperinci, untuk menguji keupayaan penaakulan pelbagai mod model. Dalam tugasan ScienceQA, penulis mencadangkan model GPT-3 (CoT), yang memperkenalkan pembelajaran segera berdasarkan rantai pemikiran ke dalam model GPT-3, supaya model itu boleh menjana penjelasan penaakulan yang sepadan sambil menjana jawapan. GPT-3 (CoT) mencapai ketepatan 75.17% pada ScienceQA; dan penilaian manusia menunjukkan bahawa ia boleh menjana penjelasan yang lebih berkualiti.

Mempelajari dan menyelesaikan tugas yang kompleks dengan berkesan seperti manusia adalah salah satu matlamat jangka panjang yang dikejar oleh kecerdasan buatan. Manusia boleh mengikuti proses penaakulan rantaian pemikiran (CoT) yang lengkap semasa proses membuat keputusan untuk membuat penjelasan yang munasabah bagi jawapan yang diberikan.

Walau bagaimanapun, kebanyakan model pembelajaran mesin sedia ada bergantung pada sejumlah besar latihan sampel input-output untuk menyelesaikan tugasan tertentu. Model kotak hitam ini selalunya menjana jawapan akhir secara langsung tanpa mendedahkan proses penaakulan tertentu.

Menjawab Soalan Sains boleh mendiagnosis dengan baik sama ada model kecerdasan buatan mempunyai keupayaan penaakulan pelbagai langkah dan kebolehtafsiran. Untuk menjawab soalan saintifik, model bukan sahaja perlu memahami kandungan multimodal, tetapi juga mengekstrak pengetahuan luaran untuk mendapatkan jawapan yang betul. Pada masa yang sama, model yang boleh dipercayai juga harus memberikan penjelasan yang mendedahkan proses penaakulannya. Walau bagaimanapun, kebanyakan set data soalan dan jawapan saintifik semasa tidak mempunyai penjelasan terperinci tentang jawapan, atau terhad kepada modaliti teks.

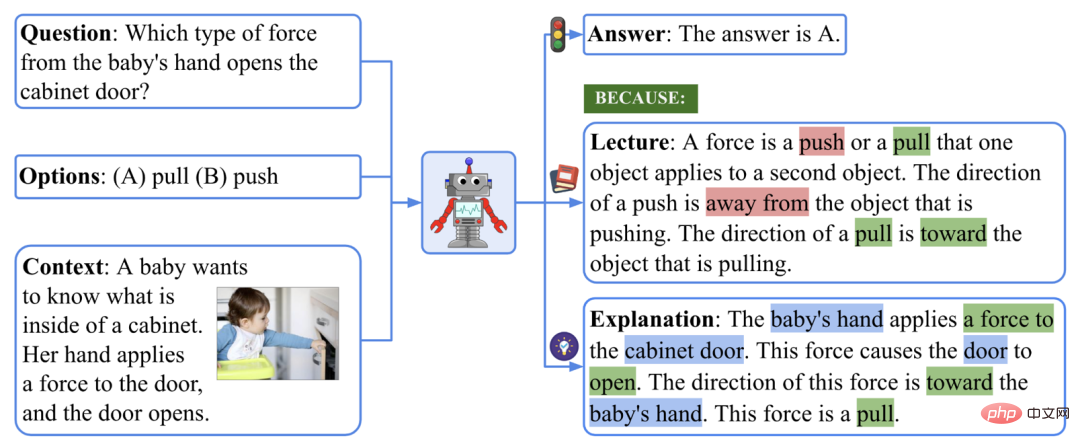

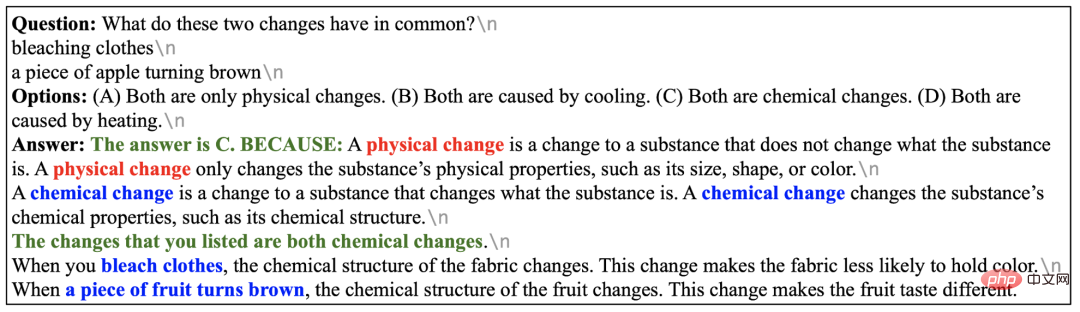

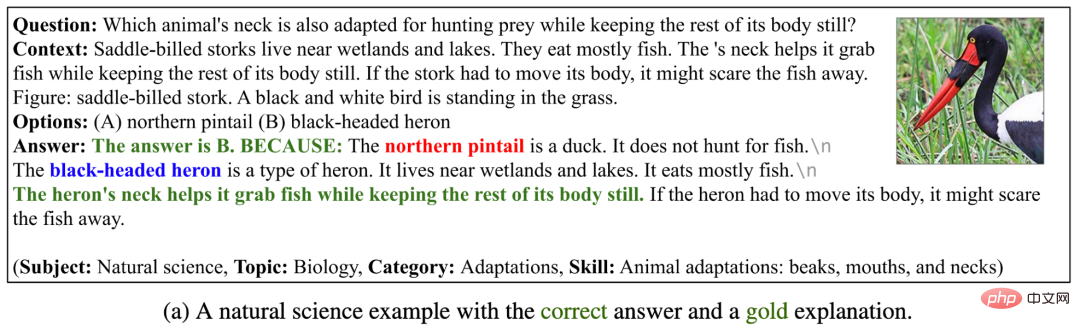

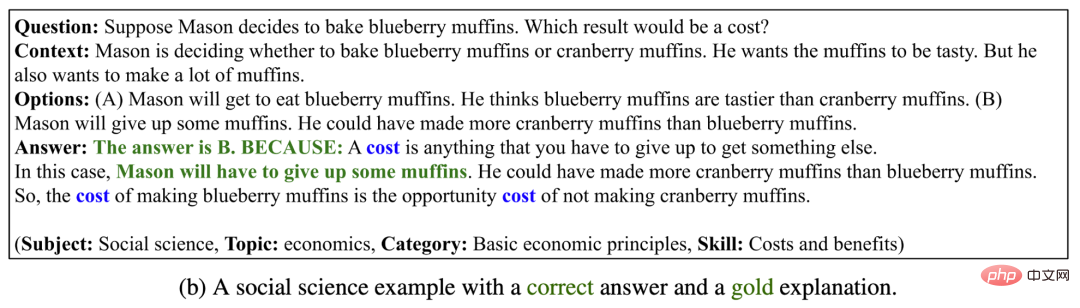

Oleh itu, Pengarang mengumpul set data soalan dan jawapan saintifik baharu ScienceQA, yang mengandungi 21,208 soalan aneka pilihan daripada kursus sains sekolah rendah dan menengah. Soalan lazim mengandungi konteks berbilang modal, pilihan yang betul, pengetahuan latar belakang am (kuliah) dan penjelasan khusus (penjelasan) . Contoh set data ScienceQA.

Untuk menjawab contoh yang ditunjukkan di atas, kita mesti ingat dahulu definisi daya: "Daya ialah tolakan atau tarikan yang... Arah tolakan ialah... Arah tarikan ialah...", dan kemudian membentuk proses penaakulan pelbagai langkah: "Tangan bayi mengenakan daya pada pintu kabinet → Daya ini menyebabkan pintu terbuka arah daya ini adalah ke arah tangan bayi.", dan akhirnya mendapat jawapan yang betul: "Daya ini adalah tarikan.".

Untuk menjawab contoh yang ditunjukkan di atas, kita mesti ingat dahulu definisi daya: "Daya ialah tolakan atau tarikan yang... Arah tolakan ialah... Arah tarikan ialah...", dan kemudian membentuk proses penaakulan pelbagai langkah: "Tangan bayi mengenakan daya pada pintu kabinet → Daya ini menyebabkan pintu terbuka arah daya ini adalah ke arah tangan bayi.", dan akhirnya mendapat jawapan yang betul: "Daya ini adalah tarikan.".

Dalam tugas ScienceQA, model perlu meramalkan jawapan sambil mengeluarkan penjelasan terperinci. Dalam kertas kerja ini, penulis menggunakan model bahasa berskala besar untuk menjana pengetahuan latar belakang dan penjelasan sebagai rantai pemikiran (CoT) untuk meniru keupayaan penaakulan pelbagai langkah yang dimiliki manusia .

Eksperimen menunjukkan bahawa kaedah menjawab soalan pelbagai mod semasa tidak dapat mencapai prestasi yang baik dalam tugas ScienceQA. Sebaliknya, melalui pembelajaran segera berasaskan rantaian pemikiran, model GPT-3 boleh mencapai ketepatan 75.17% pada set data ScienceQA dan boleh menjana penjelasan berkualiti tinggi

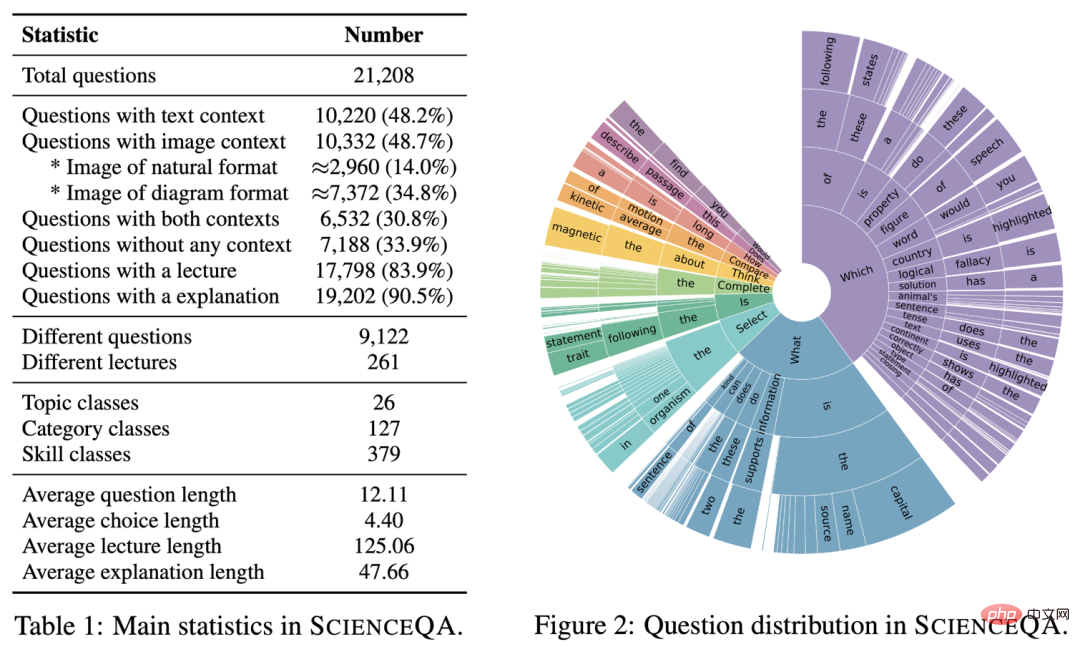

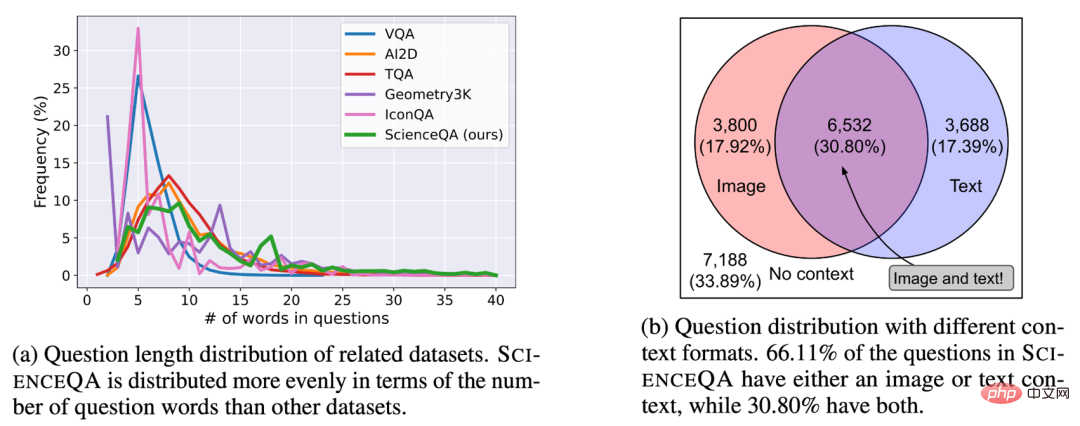

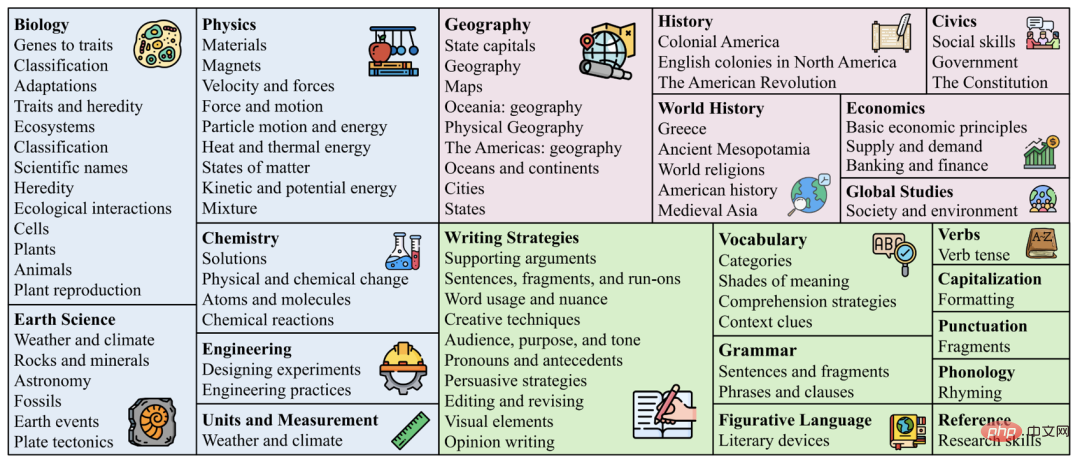

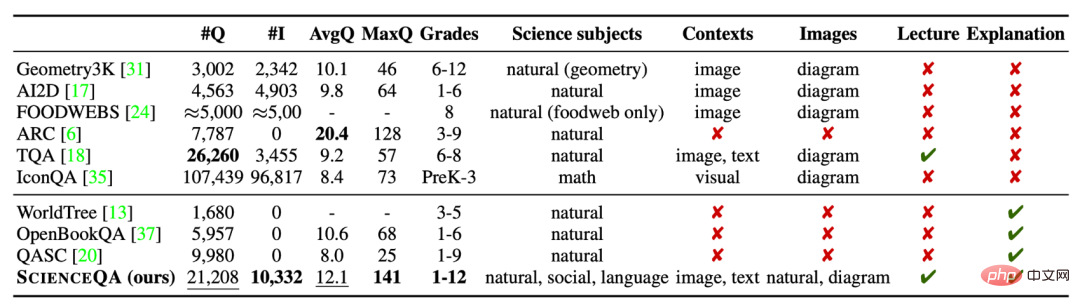

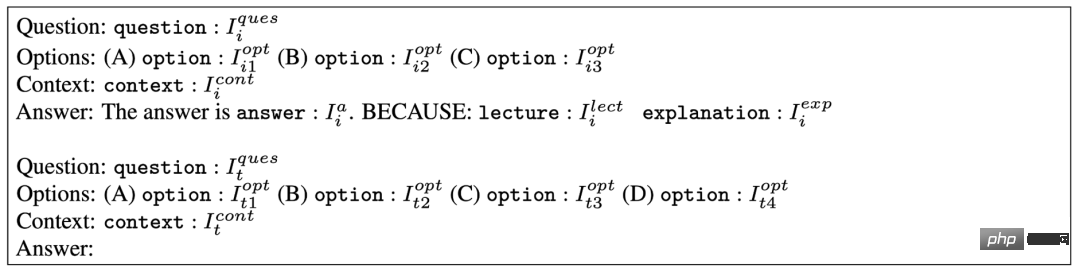

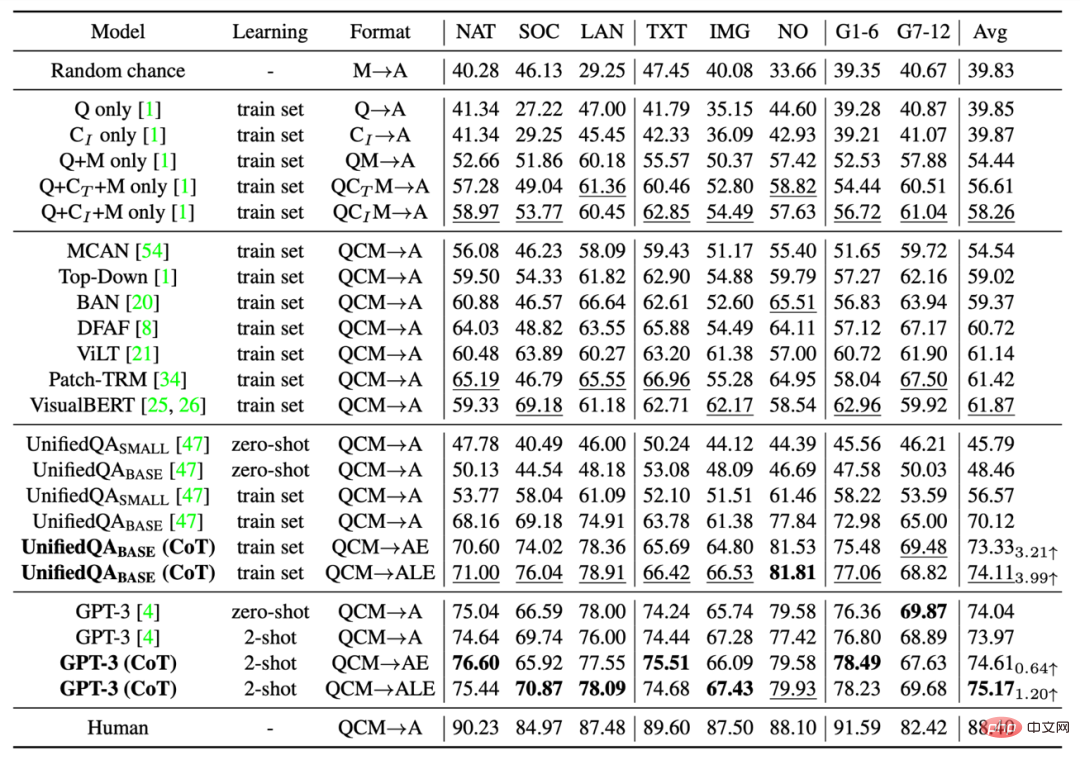

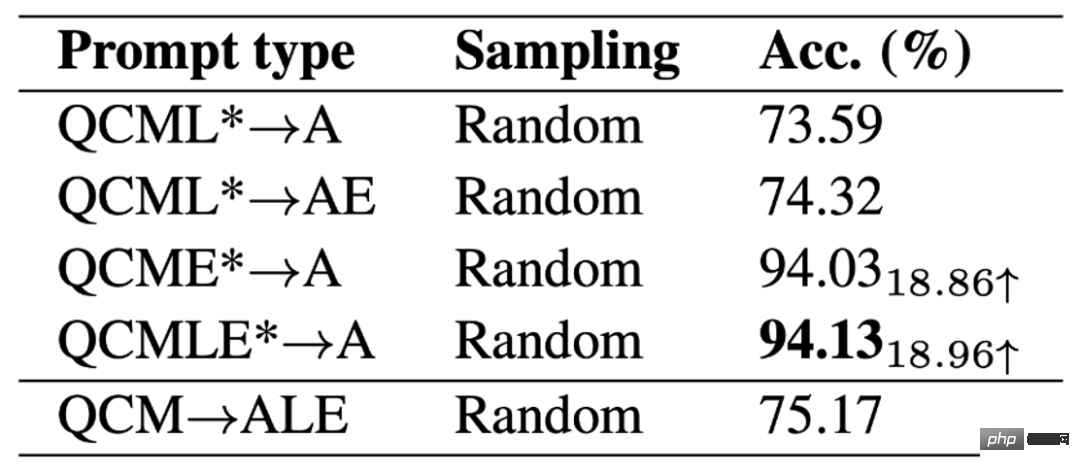

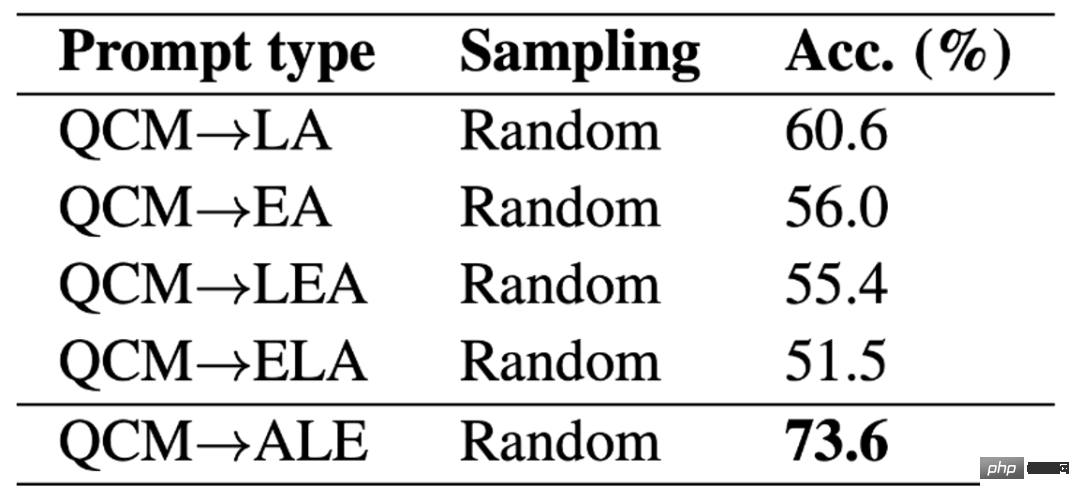

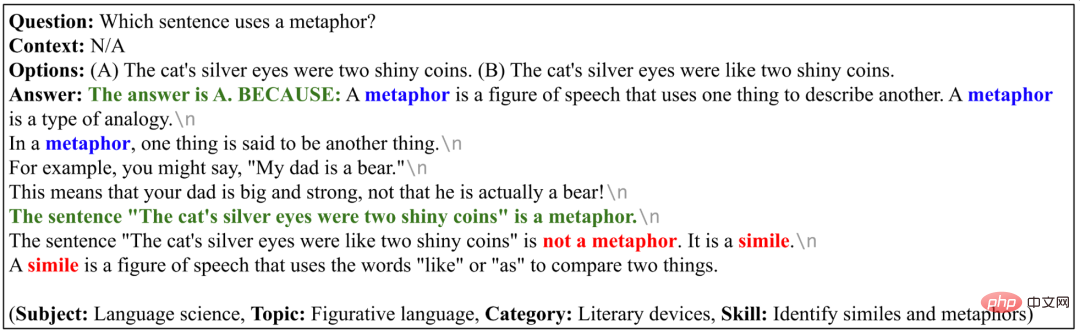

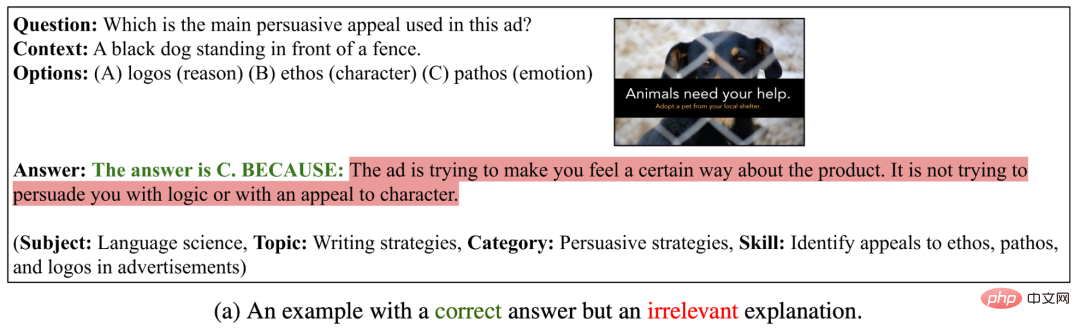

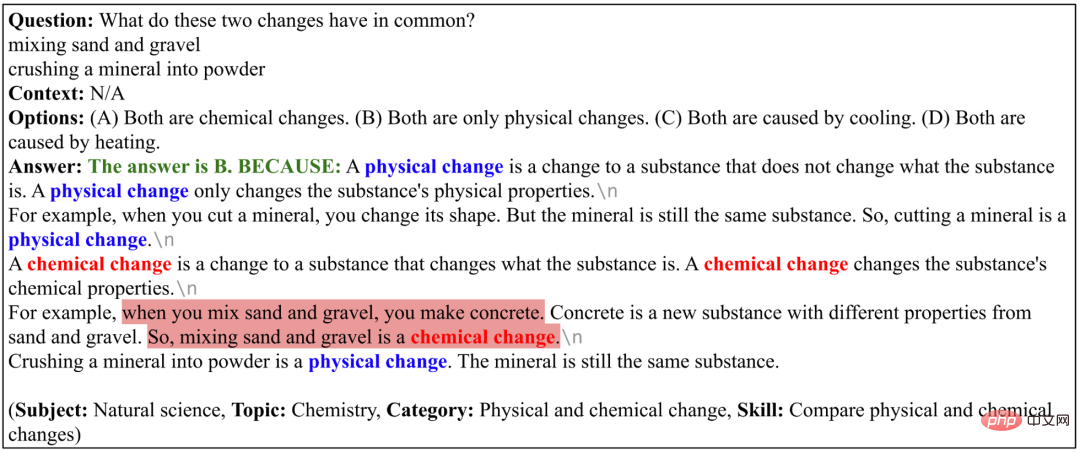

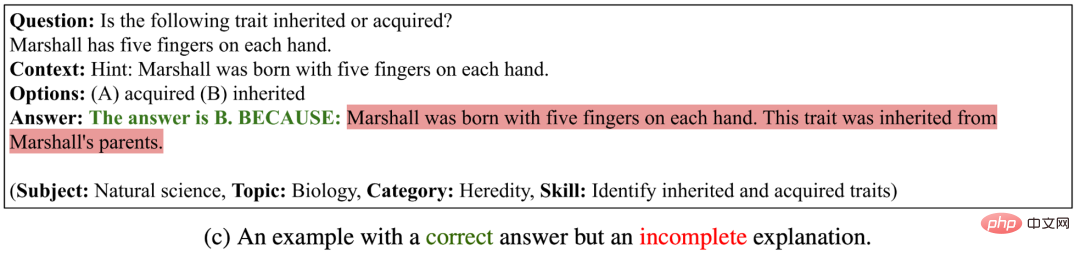

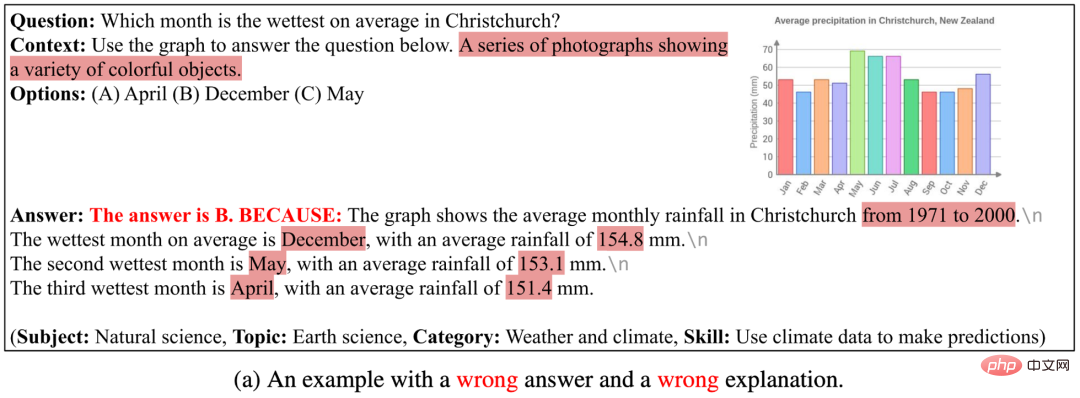

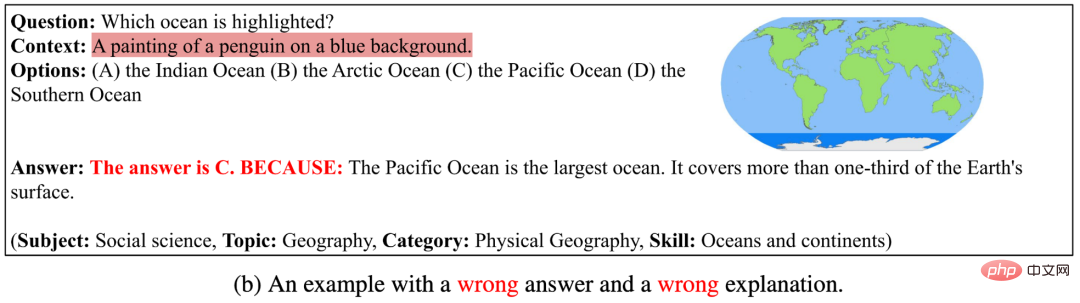

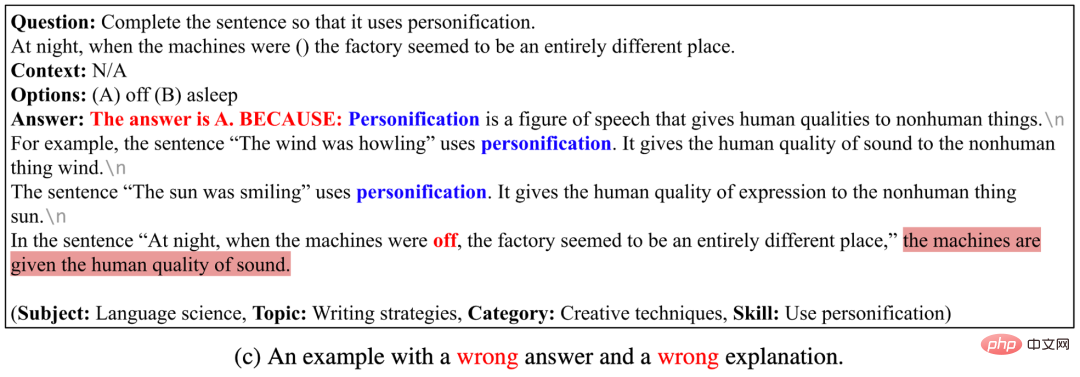

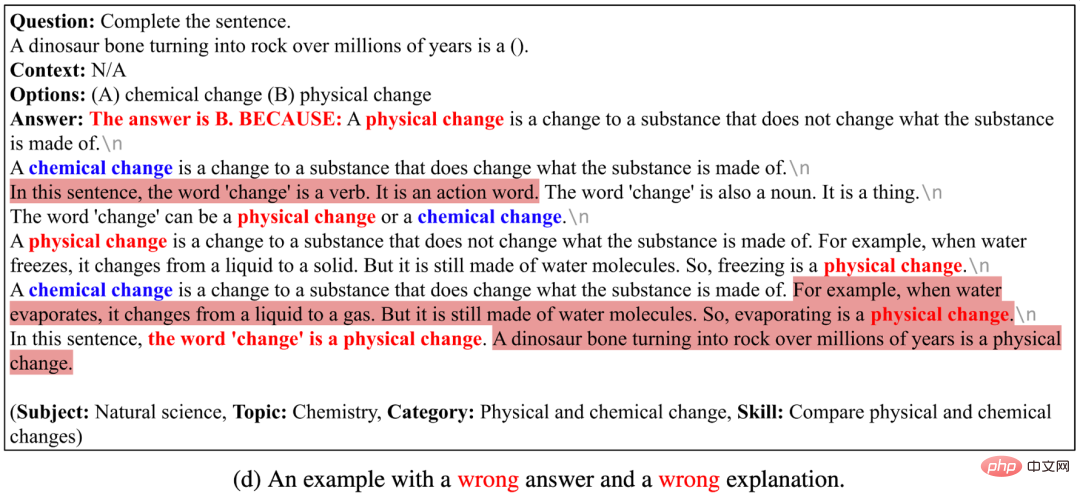

: Menurut penilaian manusia, di mana 65.2% daripada penjelasan adalah relevan, betul dan lengkap. Thoughtchain juga boleh membantu model UnifiedQA mencapai peningkatan 3.99% pada dataset ScienceQA. Statistik set data Statistik utama ScienceQA ditunjukkan di bawah. Maklumat utama dataset ScienceQA ScienceQA mengandungi 21208 contoh, termasuk 9122 soalan yang berbeza. 10,332 risalah (48.7%) mempunyai maklumat latar belakang visual, 10,220 risalah (48.2%) mempunyai maklumat latar belakang teks, dan 6,532 risalah (30.8%) mempunyai maklumat latar belakang visual + tekstual. Sebilangan besar soalan diberi penjelasan dengan penjelasan terperinci: 83.9% daripada soalan mempunyai anotasi pengetahuan latar belakang (kuliah), dan 90.5% daripada soalan mempunyai jawapan terperinci (penjelasan). Taburan soalan dan latar belakang dalam set data ScienceQA. Pengagihan topik set data Berbeza daripada set data sedia ada, ScienceQA merangkumi tiga cabang utama sains semula jadi, sains sosial dan linguistik, termasuk 26 topik, 127 kategori dan 379 kemahiran pengetahuan (kemahiran) . Pengagihan topik ScienceQA. Taburan awan perkataan set data Seperti yang ditunjukkan dalam perkataan taburan awan dalam rajah di bawah, Soalan dalam ScienceQA kaya dengan kepelbagaian semantik. Model perlu memahami rumusan masalah yang berbeza, senario, dan pengetahuan latar belakang. Taburan awan perkataan ScienceQA. Perbandingan Set Data ScienceQA ialah Multi- set data soalan dan jawapan saintifik modal dengan penjelasan terperinci . Berbanding dengan set data sedia ada, saiz data ScienceQA, kepelbagaian jenis soalan, kepelbagaian topik dan dimensi lain mencerminkan kelebihannya. Perbandingan dataset ScienceQA dengan set data soalan dan jawapan saintifik yang lain . Garis asas Pengarang menilai kaedah penanda aras yang berbeza pada set data ScienceQA, termasuk model VQA seperti Top-Down Attention, MCAN, BAN, DFAF, ViLT, Patch-TRM dan VisualBERT, dan model bahasa berskala besar seperti UnifiedQA dan GPT- 3, serta peluang rawak dan prestasi manusia. Untuk model bahasa UnifiedQA dan GPT-3, imej latar belakang ditukar kepada kapsyen teks. GPT-3 (CoT) Kerja penyelidikan terkini menunjukkan bahawa, diberi petunjuk yang sesuai, GPT-3 model boleh menunjukkan prestasi cemerlang pada tugas hiliran yang berbeza. Untuk tujuan ini, pengarang mencadangkan model GPT-3 (CoT), menambahkan rantaian pemikiran (CoT) pada gesaan, supaya model itu boleh menjana pengetahuan dan penjelasan latar belakang yang sepadan sambil menjana jawapan . Templat gesaan khusus adalah seperti yang ditunjukkan di bawah. di mana Ii mewakili contoh latihan dan Ia mewakili contoh ujian. Contoh latihan mengandungi soalan, pilihan, konteks dan elemen jawapan, di mana jawapan terdiri daripada jawapan yang betul, pengetahuan latar belakang (Kuliah) dan penjelasan (Penjelasan). GPT-3 (CoT) akan melengkapkan jawapan yang diramalkan, pengetahuan latar belakang dan penjelasan contoh ujian berdasarkan maklumat gesaan input. Templat petua yang diterima pakai oleh GPT-3 (CoT). Hasil percubaan adalah berbeza Keputusan ketepatan penanda aras dan kaedah pada set ujian ScienceQA ditunjukkan dalam jadual di bawah. VisualBERT, salah satu model VQA terbaik semasa, hanya boleh mencapai ketepatan 61.87%. Memperkenalkan data CoT semasa proses latihan, model UnifiedQA_BASE boleh mencapai ketepatan 74.11%. Dan GPT-3 (CoT) mencapai ketepatan 75.17% dengan gesaan 2 contoh latihan, yang lebih tinggi daripada model garis dasar lain . Manusia berprestasi baik pada set data ScienceQA, mencapai ketepatan keseluruhan 88.40% dan menunjukkan prestasi yang stabil merentas kategori soalan yang berbeza. Hasil kaedah berbeza pada set ujian ScienceQA. Penilaian penjelasan yang dijana Pengarang menggunakan metrik penilaian automatik seperti BLEU- 1, BLEU-2, ROUGE-L dan Persamaan Ayat menilai penjelasan yang dihasilkan oleh kaedah yang berbeza. Memandangkan metrik penilaian automatik hanya boleh mengukur persamaan antara hasil ramalan dan kandungan beranotasi, pengarang seterusnya menggunakan kaedah penilaian manual untuk menilai kaitan, ketepatan dan kesempurnaan penjelasan yang dijana. Seperti yang dapat dilihat, 65.2% daripada penjelasan yang dijana oleh GPT-3 (CoT) memenuhi standard Emas . Hasil kaedah penilaian yang berbeza pada tafsiran yang dijana. Templat segera yang berbeza Pengarang membandingkan yang berbeza Kesan templat segera pada ketepatan GPT-3 (CoT) . Ia boleh dilihat bahawa di bawah templat QAM-ALE, GPT-3 (CoT) boleh memperoleh ketepatan purata terbesar dan varians terkecil. Selain itu, GPT-3 (CoT) berprestasi terbaik apabila digesa dengan 2 contoh latihan. Perbandingan hasil templat segera yang berbeza. Had atas model Untuk meneroka had atas prestasi model GPT-3 (CoT), penulis menambah pengetahuan latar belakang beranotasi dan penjelasan pada input model (QCMLE*-A) . Kita dapat melihat bahawa GPT-3 (CoT) boleh mencapai ketepatan sehingga 94.13%. Ini juga mencadangkan arah yang mungkin untuk penambahbaikan model: model boleh melakukan penaakulan langkah demi langkah, iaitu, mula-mula mendapatkan semula pengetahuan latar belakang yang tepat dan menjana penjelasan yang tepat, dan kemudian menggunakan keputusan ini sebagai input. Proses ini hampir sama dengan cara manusia menyelesaikan masalah yang kompleks. Siling prestasi untuk model GPT-3 (CoT). Lokasi ALE yang berbeza Pengarang membincangkan lebih lanjut GPT -3 (CoT) Apabila menjana ramalan, kesan kedudukan ALE yang berbeza pada keputusan . Keputusan eksperimen pada ScienceQA menunjukkan bahawa jika GPT-3 (CoT) mula-mula menjana pengetahuan latar belakang L atau penjelasan E, dan kemudian menjana jawapan A, ketepatan ramalannya akan menurun dengan ketara. Sebab utama ialah pengetahuan latar belakang L dan penjelasan E mempunyai bilangan perkataan yang banyak Jika LE dijana dahulu, model GPT-3 mungkin kehabisan bilangan perkataan maksimum, atau berhenti menjana teks lebih awal, supaya jawapan akhir. A tidak boleh diperolehi. Kes Berjaya Dalam 4 contoh berikut, GPT-3 (CoT) Bukan sahaja menjana jawapan yang betul, tetapi juga memberikan penjelasan yang relevan, betul dan lengkap. Ini menunjukkan bahawa GPT-3 (CoT) mempamerkan keupayaan penaakulan dan penjelasan pelbagai langkah yang kukuh pada dataset ScienceQA. GPT-3 (CoT) Contoh menjana jawapan dan penjelasan yang betul. Kes Kegagalan I Dalam tiga contoh di bawah, GPT-3 (CoT ) Walaupun jawapan yang betul dihasilkan, penjelasan yang dihasilkan adalah tidak relevan, tidak betul atau tidak lengkap . Ini menunjukkan bahawa GPT-3 (CoT) masih menghadapi kesukaran yang lebih besar dalam menghasilkan jujukan panjang yang konsisten secara logik. Contoh di mana GPT-3 (CoT) boleh menjana jawapan yang betul, tetapi menjana penjelasan yang salah. Kes Kegagalan II Dalam empat contoh di bawah, GPT-3 (CoT) tidak boleh dijana dengan betul jawapan tidak boleh menghasilkan penjelasan yang betul . Sebabnya ialah: (1) Model kapsyen imej semasa tidak dapat menerangkan dengan tepat maklumat semantik gambar seperti rajah skema dan jadual Jika gambar diwakili oleh teks anotasi gambar, GPT-3 (CoT) belum dapat memberikan jawapan yang baik soalan yang mengandungi latar belakang masalah carta; (2) Apabila GPT-3 (CoT) menghasilkan urutan yang panjang, ia terdedah kepada masalah yang tidak konsisten atau tidak koheren; soalan khusus. GPT-3 (CoT) boleh menjana contoh jawapan dan penjelasan yang salah. Pengarang mencadangkan ScienceQA, set data soalan dan jawapan saintifik pelbagai mod dengan penjelasan terperinci. ScienceQA mengandungi 21,208 soalan aneka pilihan daripada mata pelajaran sains sekolah rendah dan menengah, meliputi tiga bidang sains utama dan pelbagai topik Kebanyakan soalan diberi penjelasan dengan pengetahuan latar belakang yang terperinci. ScienceQA menilai keupayaan model dalam pemahaman pelbagai mod, penaakulan pelbagai langkah dan kebolehtafsiran. Penulis menilai model asas yang berbeza pada dataset ScienceQA dan mencadangkan model GPT-3 (CoT) boleh menjana pengetahuan latar belakang dan penjelasan yang sepadan sambil menjana jawapan. Sebilangan besar analisis eksperimen dan kajian kes telah memberikan inspirasi berguna untuk penambahbaikan model.

1. Set data ScienceQA

2. Model dan kaedah

3 Eksperimen dan analisis

Jawatan LE yang berbeza.

Jawatan LE yang berbeza.

4. Kesimpulan dan pandangan

Atas ialah kandungan terperinci Set data soal jawab saintifik pelbagai mod pertama dengan penjelasan terperinci, penaakulan model pembelajaran mendalam mempunyai rantai pemikiran. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI