Rumah >Peranti teknologi >AI >DeepMind kembali menggunakan Sains! AI 'Wall Breaker' memainkan helah untuk mengalahkan tuan manusia

DeepMind kembali menggunakan Sains! AI 'Wall Breaker' memainkan helah untuk mengalahkan tuan manusia

- WBOYke hadapan

- 2023-04-10 22:53:11829semak imbas

Baru-baru ini, ejen AI DeepMind, DeepNash berjaya mengalahkan pemain manusia profesional dalam Stratego dan berjaya menduduki tempat 3 Teratas.

Pada 1 Disember, kertas kerja itu diterbitkan secara rasmi dalam Sains.

Alamat kertas: http://www.science.org/doi/10.1126/science.add4679

Gunakan AI ini untuk memberi penghormatan kepada John Nash

Pada era hari ini, AI permainan telah berkembang ke peringkat baharu.

Pada masa lalu, ramai saintis menggunakan catur dan Go untuk melatih AI, tetapi DeepMind menggunakan Stratego kali ini, iaitu permainan papan klasik yang lebih kompleks daripada catur dan Go, dan lebih bijak daripada poker.

Dan ejen AI bernama DeepNash ini mempelajari Stratego dari awal dengan bermain menentang dirinya sendiri.

Kini, DeepNash berada di kedudukan antara tiga teratas dalam sejarah dalam kalangan pakar manusia di Gravon, platform Stratego dalam talian terbesar di dunia.

DeepNash mengamalkan kaedah permainan serba baharu, berdasarkan teori permainan dan pembelajaran peneguhan mendalam tanpa model.

Dapat dilihat bahawa nama ini juga bertujuan untuk memberi penghormatan kepada ahli matematik terkenal Amerika John Nash.

Keseimbangan Nash yang dicadangkannya, juga dikenali sebagai keseimbangan permainan bukan koperasi, adalah bahagian yang sangat penting dalam teori permainan.

Apakah rahsia Stratego?

Permainan papan secara historis menjadi penanda aras untuk mengukur kemajuan dalam AI kerana ia membolehkan kita mengkaji cara manusia dan mesin merumus dan melaksanakan strategi dalam persekitaran terkawal.

Dan apakah rahsia Strategi ini?

Perbezaan daripada catur dan Go ialah Stratego ialah permainan maklumat yang tidak lengkap: pemain tidak boleh memerhati secara langsung identiti kepingan lawan mereka.

Disebabkan kerumitan ini, sistem Strategi berasaskan AI selalunya berada di peringkat amatur, tidak kira betapa sukarnya ia berfungsi, adalah mustahil untuk mencapai tahap "pakar" .

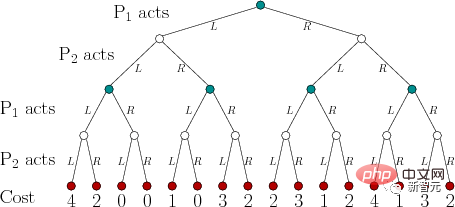

Pada masa lalu, sebab mengapa pelbagai AI telah mencapai kejayaan besar dalam permainan dan mengalahkan manusia sepenuhnya adalah kerana teknologi AI yang dipanggil "Game Tree Search".

Walaupun "Game Tree Search" boleh membunuh semua pihak dalam pelbagai permainan dengan maklumat penuh, ia agak tidak berdaya untuk permainan seperti Stratego kerana tidak cukup berskala.

Pada ketika ini, DeepNash telah melepasi carian pokok permainan sepenuhnya.

Malah, DeepNash telah menguasai nilai Stratego, yang jauh melebihi permainan itu sendiri.

Dunia sebenar selalunya sangat kompleks dan maklumat adalah terhad. Sistem AI yang benar-benar maju menghadapi persekitaran seperti Stratego.

DeepNash berjaya menunjukkan kepada kita bagaimana AI boleh berjaya mengimbangi keputusan dan menyelesaikan masalah kompleks di bawah ketidakpastian.

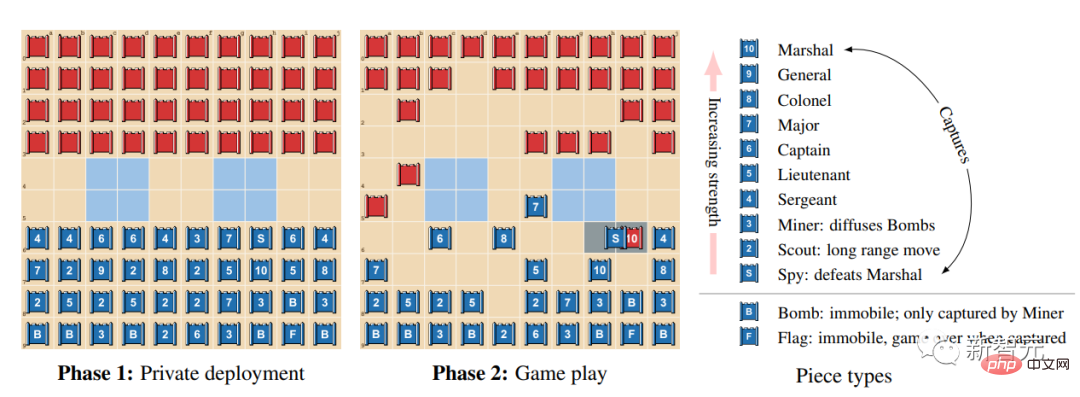

Cara bermain Stratego

Stratego ialah permainan menangkap bendera berasaskan giliran. Dalam permainan, pemain perlu menipu, menggunakan taktik bulatan, mengumpul maklumat, dan beroperasi dengan mahir.

Ia adalah permainan jumlah sifar, jadi sebarang keuntungan untuk seorang pemain mewakili jumlah kerugian yang sama untuk pihak lawan.

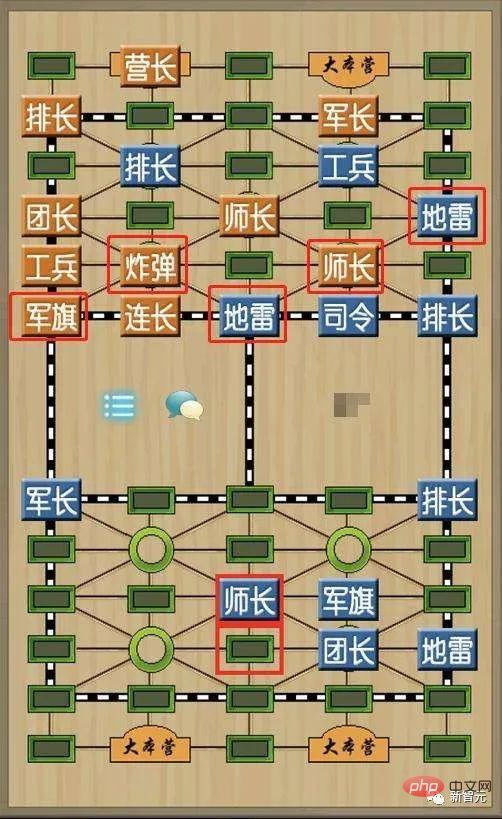

Bunyinya sangat mirip dengan catur tentera kita.

Perbezaan antara Stratego dan catur tentera ialah ia mempunyai bilangan buah catur yang lebih banyak, lebih banyak pangkat tentera, reka bentuk papan catur yang lebih ringkas dan tiada landasan kereta api, kem dan pengadil.

Apabila kedua-dua belah pihak membuat formasi, semua buah catur hendaklah tegak dan tidak boleh dilihat oleh pihak lain.

Selepas formasi selesai, bahagian merah bergerak dahulu, dan kemudian bergilir-gilir untuk menggerakkan satu bahagian.

Antara buah catur, bendera tentera dan lombong tidak boleh digerakkan mana-mana petak secara mendatar dan menegak, tetapi tidak boleh melintasi buah catur yang lain hanya boleh menggerakkan satu petak secara mendatar atau menegak.

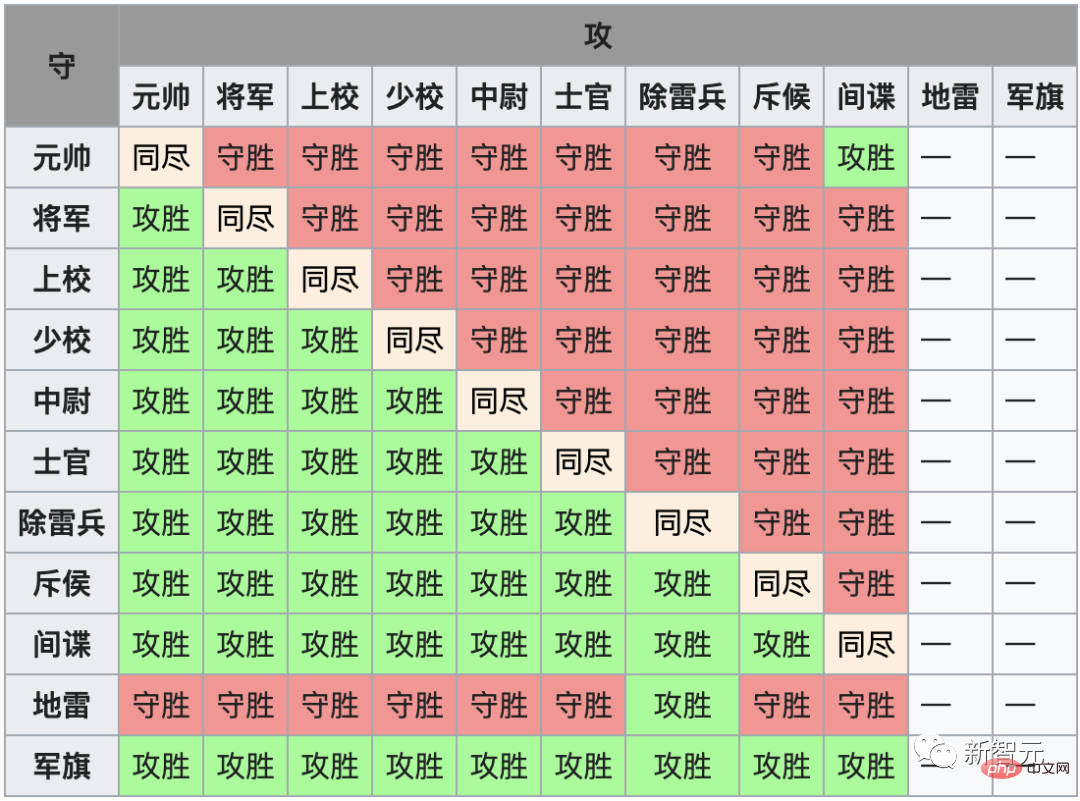

Apabila buah catur kedua-dua belah berada dalam grid yang sama, ia didedahkan bersama-sama, nilaikan saiznya, bahagian yang menang diletakkan semula ke kedudukan asalnya, menghadap ke belakang, dan bahagian yang hilang dikeluarkan.

Kaedah kemenangan Stratego adalah serupa dengan catur tentera China Kemenangan dicapai dengan menangkap bendera tentera lawan atau memusnahkan semua buah catur yang bergerak.

Mengapa Stratego begitu mencabar untuk AI? Sebahagian daripada sebabnya ialah ia adalah permainan maklumat yang tidak sempurna.

Dua pemain dalam Stratego bersembunyi antara satu sama lain apabila mengatur 40 keping ke dalam formasi permulaan.

Oleh kerana pemain tidak mempunyai akses kepada pengetahuan yang sama, mereka perlu mengimbangi semua kemungkinan hasil apabila membuat sebarang keputusan.

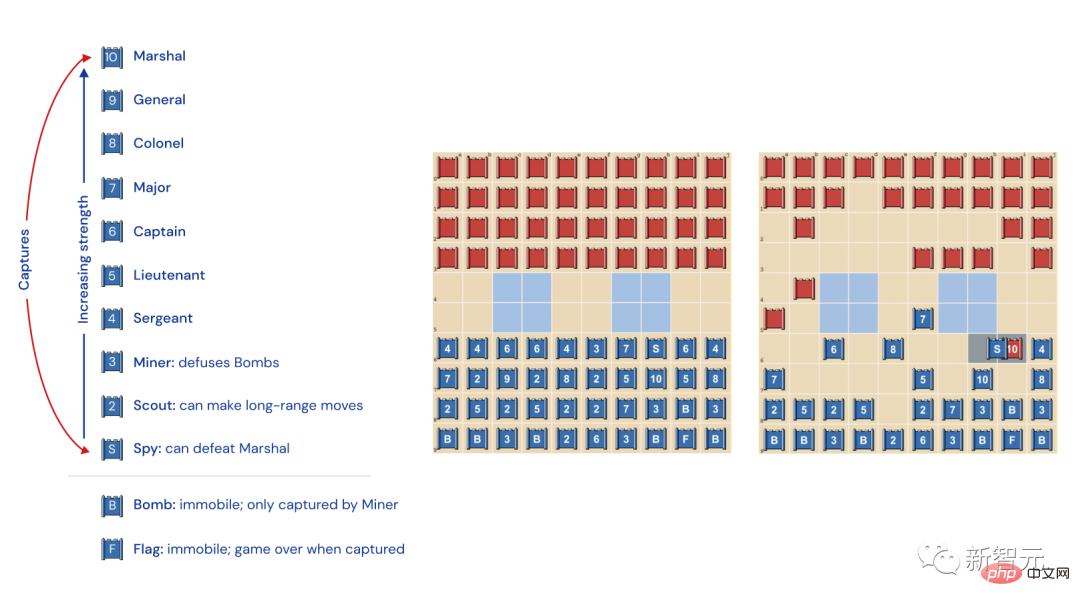

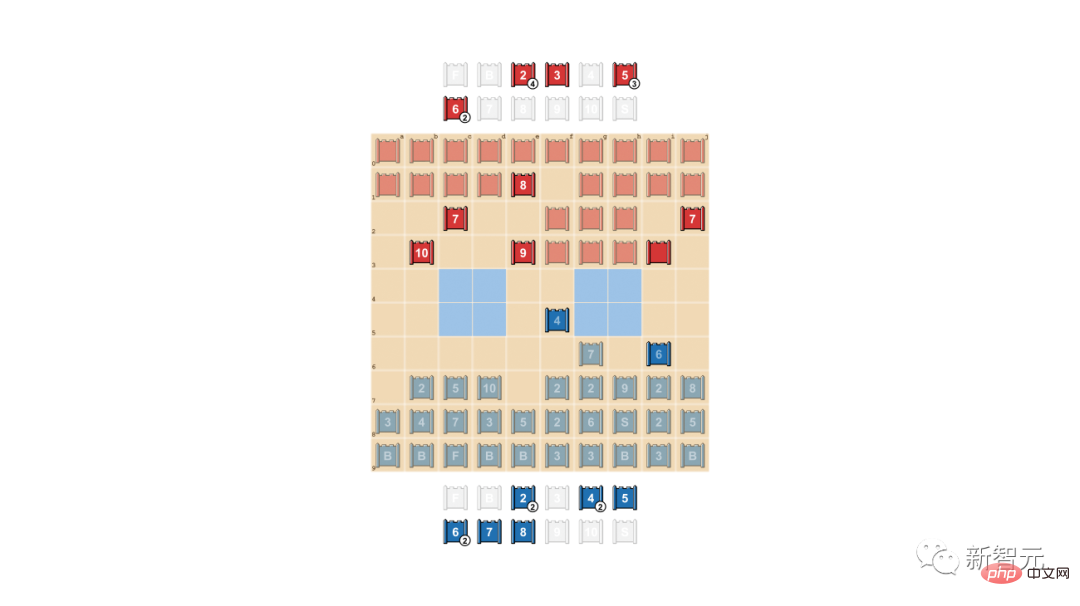

Jenis dan kedudukan buah catur Stratego

Kiri: Kedudukan buah catur. Dalam permainan, sekeping dengan pangkat tentera yang lebih tinggi menang, dengan satu-satunya pengecualian ialah 10 (Marshal) yang diserang oleh pengintip sentiasa menang, dengan satu-satunya pengecualian ditangkap oleh pelombong.

Tengah: Kemungkinan pembentukan permulaan. Bendera hendaklah disimpan dengan selamat di belakang, dengan bom di bahagian tepi memberikan perlindungan. Dua kawasan biru muda itu adalah "tasik" dan tidak boleh dimasuki.

Kanan: Permainan sedang berlangsung Anda dapat melihat bahawa pengintip pasukan biru menangkap marshal pasukan merah.

Permainan ini membingungkan AlphaZero

Dalam Stratego, maklumat disembunyikan.

Hanya apabila bertemu pemain lain, identiti kepingan lawan akan didedahkan.

Perbezaan antara catur dan Go ialah ia adalah "permainan maklumat yang sempurna" kerana kedua-dua pemain mengetahui dengan tepat lokasi dan identiti setiap buah catur.

AlphaZero DeepMind sentiasa menunjukkan prestasi yang baik dalam permainan maklumat yang sempurna, tetapi dalam Stratego, ia gagal.

Dalam catur, AlphaZero mengatasi Stockfish selepas 4 jam; dalam shogi, AlphaZero mengatasi Elmo selepas 2 jam dan dalam Go, AlphaZero mengatasi Elmo dalam 30 Selepas jam, ia mengatasi AlphaGo , yang mengalahkan Lee Sedol

Stratego lebih serupa dengan Texas Hold'em dan memerlukan kebolehan seperti manusia - manusia perlu membuat keputusan dengan maklumat yang tidak lengkap dan perlu menipu.

Penulis Amerika Jack London pernah menegaskan: "Dalam kehidupan, kita tidak selalu memegang kad yang baik, tetapi kadangkala, kita boleh bermain dengan baik dengan tangan yang buruk

Malah, banyak AI juga sangat pandai bermain poker, tetapi apabila berdepan dengan Stratego, mereka keliru - proses permainan ini terlalu lama!

Untuk menang, pemain perlu membuat ratusan gerakan. Oleh itu, penaakulan dalam permainan mesti berdasarkan sejumlah besar tindakan berterusan Dalam proses ini, sukar untuk melihat dengan jelas bagaimana setiap tindakan akan mempengaruhi keputusan akhir.

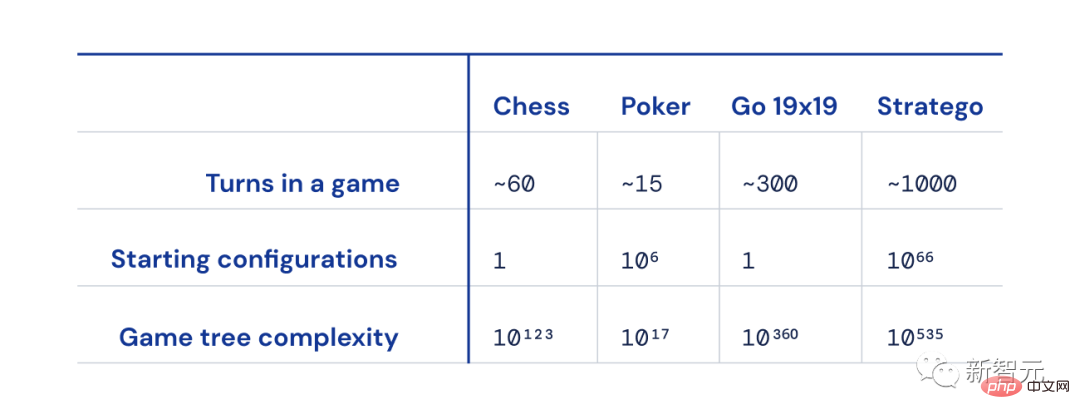

Perbezaan saiz antara Catur, Poker, Go dan Strateg

Selain itu, kemungkinan permainan berbanding Catur, Go dan Poker Bilangan keadaan ("pokok permainan kerumitan") berada di luar carta dan amat sukar untuk diselesaikan.

Dan inilah sebabnya Stratego sangat menarik - ia mewakili cabaran selama berdekad-dekad dalam komuniti AI.

Stratego: Tapak tinggi untuk AI menakluki

Selama bertahun-tahun, cara untuk menonjolkan kecerdasan buatan dalam permainan Stratego telah menjadi tumpuan penyelidik AI.

Terdapat dua kesukaran utama untuk mengalahkan pemain manusia dalam permainan ini.

Pertama sekali, pokok permainan permainan ini mempunyai 10 keadaan kuasa ke-535, iaitu, terdapat 10 kemungkinan susun atur kuasa ke-535 dalam permainan. Sebaliknya, terdapat hanya 10 reka letak yang mungkin dalam Go.

Kedua, dalam Stratego, kecerdasan buatan perlu membuat alasan tentang strategi penggunaan lawan dengan lebih daripada 10 hingga kuasa ke-66, manakala poker hanya mempunyai seribu pasangan kad yang mungkin.

Oleh itu, tidak mudah untuk memecahkan susun atur Stratego yang rumit. Bagaimana untuk mengalahkan pemain Stratego manusia adalah cabaran yang belum pernah terjadi sebelum ini oleh penyelidik AI.

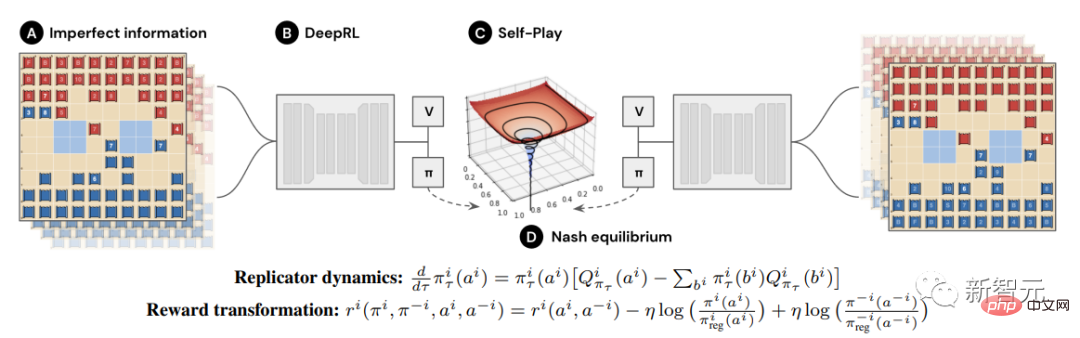

Bagaimana untuk mengalahkan AI lain? Bergantung pada senjata teras R-NaD

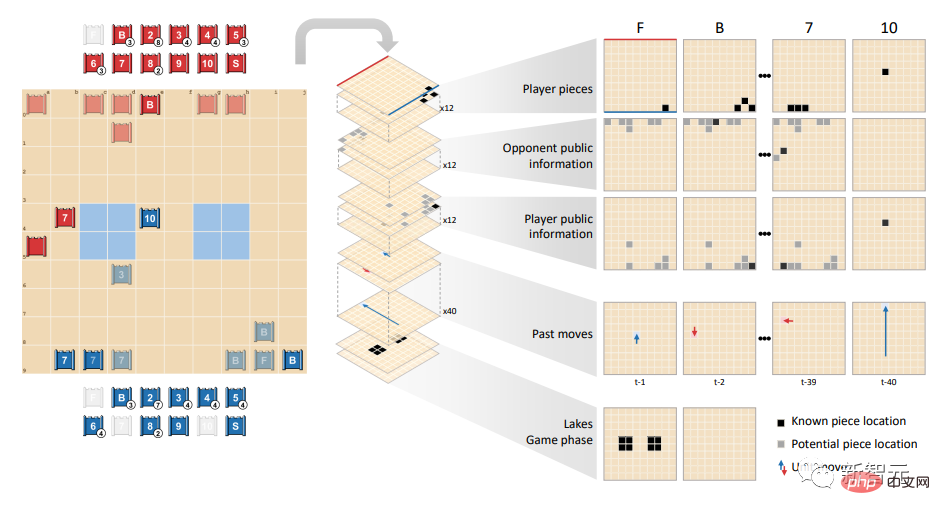

Sebab DeepNash telah mengatasi sepenuhnya AI lain adalah kerana ia menggunakan kaedah baru berdasarkan gabungan teori permainan dan pembelajaran peneguhan dalam tanpa model.

"Tanpa Model" bermaksud DeepNash tidak cuba mensimulasikan keadaan lawan secara eksplisit dalam permainan.

Terutama pada peringkat awal permainan, apabila DeepNash mengetahui serba sedikit tentang cebisan lawan, model seperti ini, walaupun boleh diselesaikan, mempunyai kebarangkalian yang tinggi untuk menjadi tidak sah.

Selain itu, kerana pokok permainan Stratego sangat kompleks, DeepNash tidak boleh menggunakan carian pokok Monte Carlo yang digunakan oleh AI lain semasa bermain permainan. Yang terakhir adalah kunci kepada pencapaian penting AI dalam permainan papan dan poker yang kurang kompleks.

Dapat dilihat bahawa walaupun strategi keseimbangan boleh memainkan peranan dalam permainan maklumat yang lengkap di mana kedua-dua pihak bergilir-gilir untuk bertindak, ia tidak mencukupi dalam permainan maklumat yang tidak lengkap.

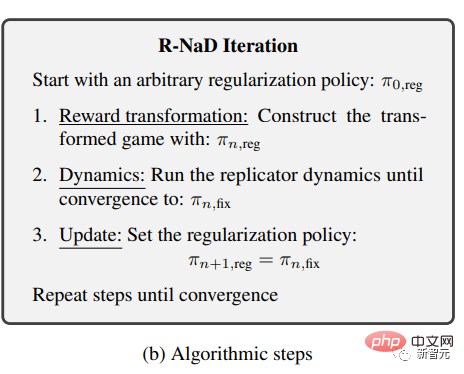

DeepNash menggunakan idea algoritma teori permainan baharu - Pengaturcaraan Dinamik Nash Teratur (Dinamik Nash Teratur, R-NaD).

Algoritma pembelajaran tetulang tanpa model ini ialah teras DeepNash.

Ia membimbing DeepNash dan menjadikan tingkah laku pembelajarannya berkembang ke arah keseimbangan Nash.

DeepNash menggabungkan R-NaD dengan seni bina rangkaian saraf dalam dan menumpu kepada keseimbangan Nash.

Termasuk tiga langkah: transformasi ganjaran, pengaturcaraan dinamik (dinamik) dan lelaran kemas kini (udate).

Pasukan penyelidik berulang kali menggunakan tiga langkah ini sehingga satu siri titik tetap dijana untuk membuktikan bahawa algoritma itu menumpu kepada keseimbangan Nash permainan asal.

Apabila bermain menentang robot Stratego terkuat (termasuk beberapa pemenang Kejohanan Dunia Strategi Komputer), DeepNash mempunyai kadar kemenangan sebanyak 97% dan selalunya mencapai kadar kemenangan 100%.

Pada platform permainan Gravon, DeepNash mencapai kadar kemenangan sebanyak 84% berbanding pemain manusia terkemuka, berada di antara tiga teratas dalam sejarah.

Sudah tentu keseimbangan Nash tidak boleh dicapai melalui teori permainan tanpa sekatan dalam permainan, kerana kadar kemenangan pemain tidak boleh dijamin dengan cara ini.

Strategi keseimbangan hanya terpakai sepenuhnya dalam permainan dengan maklumat lengkap Dalam permainan dengan maklumat yang tidak lengkap, strategi lain diperlukan untuk menang tanpa diduga.

DeepNash menggunakan beberapa permainan yang luar biasa dalam pembentukan awal. Untuk menjadi sukar untuk dieksploitasi, DeepNash membangunkan strategi yang tidak dapat diramalkan.

Ini bermakna penempatan awal mestilah cukup fleksibel untuk menghalang pihak lawan daripada menemui coraknya sendiri dalam siri perlawanan berikutnya.

Dalam peringkat permainan, DeepNash juga akan cuba merawak sebanyak mungkin antara tindakan yang kelihatan sama untuk mengelakkan dirinya daripada menjadi boleh dieksploitasi.

Dalam proses ini, menyembunyikan maklumat adalah sangat penting.

Sembunyikan maklumat dan mengelirukan lawan anda

Dalam senario kehidupan sebenar, orang juga akan menggunakan cara lain untuk menang, seperti Menggertak.

Seperti yang diterangkan oleh "bapa teori permainan" von Neumann: "Kehidupan sebenar penuh dengan 'penggelapan', 'helah kecil penipuan' dan 'meneka apa yang orang lain fikirkan saya akan lakukan'." 🎜>

Apa yang dipanggil gertakan aktif adalah untuk berpura-pura bahawa buah catur seseorang adalah tahap tinggi untuk menakutkan pihak lawan. Ringkasnya, ia adalah "menggertak."

Dalam contoh ini, DeepNash mengajar kita satu pengajaran yang baik:

Apabila bermain menentang pemain manusia (pasukan merah), DeepNash (pasukan biru) mengorbankan 7 ( Dengan kos bahagian lain seperti Major ) dan 8 (Kolonel), ketahui 10 (Marshal), 9 (Jeneral), 8 dan dua 7 lawan.

Pada ketika ini, DeepNash (sebelah biru) telah menemui banyak bahagian paling berkuasa lawan, dan pada masa yang sama, menyembunyikan kepingan kuncinya sendiri.

Pada pandangan pertama, DeepNash nampaknya berada pada kelemahan yang jelas: 7 dan 8nya sudah tiada, tetapi lawan manusia mengekalkan semua bahagian yang berada di kedudukan 7 dan ke atas.

Bagaimanapun, DeepNash ketawa terakhir - bergantung pada maklumat yang boleh dipercayai yang diperolehi daripada pengurusan tertinggi lawan, ia menganggarkan kebarangkalian kemenangannya ialah 70%.

Akhirnya, ia menang.

"Seni" gertakan

Dalam poker, pemain yang baik akan bermain perang psikologi untuk menakut-nakutkan pihak lain walaupun kita lemah.

DeepNash juga mempelajari strategi gertakan ini - gertakan negatif.

Inilah yang sering kita panggil "berpura-pura menjadi babi dan makan harimau": menyamar buah catur peringkat tinggi anda sebagai buah catur peringkat rendah, tunggu sehingga pihak lawan tertipu, kemudian turunkan mereka. sekali gus.

Dalam contoh di bawah, DeepNash menggunakan 2 (yang merupakan peninjau yang lemah) untuk mengejar 8 lawan yang mendedahkan identitinya.

Lawan manusia menentukan dari sini bahawa pengejar berkemungkinan berumur 10 tahun, dan oleh itu cuba menariknya ke dalam bulatan penyerang hendap pengintip.

Akhirnya, DeepNash berjaya memusnahkan mata-mata buah catur utama lawan dengan buah catur kecil 2.

Pemain manusia (sebelah merah) yakin bahawa sekeping yang tidak diketahui yang mengejar 8nya mestilah DeepNash's 10 (kerana DeepNash sudah kehilangan 9 sahaja pada masa ini

Berikut ialah empat video permainan lengkap antara DeepNash dan pakar manusia (tanpa nama), Permainan 1, Permainan 2, Permainan 3 dan Permainan 4. Klik masuk dan anda akan mendapat lebih banyak kejutan (video. Alamat disenaraikan dalam bahan yang dipetik )

Saya terkejut dengan tahap permainan DeepNash Saya tidak pernah mendengar mana-mana pemain Stratego tiruan menghampiri tahap yang diperlukan untuk menang melawan pemain manusia >

Tetapi selepas bermain menentang DeepNash secara peribadi tidak terkejut bahawa ia berada di kedudukan 3 teratas di Gravon. Ramalan saya: jika ia dibenarkan untuk mengambil bahagian dalam kejohanan dunia manusia, ia akan berjaya dengan baik Masa depan tidak dapat diukur Dapat dilihat bahawa kaedah R-NaD novel DeepMind ini boleh digunakan secara langsung untuk permainan sifar dua pemain yang sempurna atau lain dengan maklumat yang tidak sempurna >R-NaD berpotensi untuk melampaui tetapan permainan dua pemain dan menyelesaikan masalah dunia sebenar berskala besar

Selain itu, R-NaD juga menjanjikan aplikasi baharu AI dalam bidang lain dengan matlamat berbeza

Sebagai contoh, dalam pengoptimuman skala pengurusan trafik, di mana orang tidak mengetahui niat orang lain atau maklumat alam sekitar, R-NaD dijangka dapat mengoptimumkan masa perjalanan pemandu >

Dunia manusia sememangnya tidak dapat diramalkan Dan kini, orang ramai telah mencipta sistem AI umum yang teguh dalam menghadapi ketidakpastian, yang menjadikan kita lebih yakin tentang manusia Masa depan penuh dengan imaginasi. Rujukan: http://www.science.org/doi/10.1126/science.add4679https://www.alam.com/articles/d41586 -022-04246-7https://www.deepmind.com/blog/mastering-stratego-the-classic-game-of-imperfect-informationhttps://youtu .be/HaUdWoSMjSYhttps://youtu.be/L-9ZXmyNKgshttps://youtu.be/EOalLpAfDSshttps ://youtu.be/ MhNoYl_g8moAtas ialah kandungan terperinci DeepMind kembali menggunakan Sains! AI 'Wall Breaker' memainkan helah untuk mengalahkan tuan manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI