Rumah >Peranti teknologi >AI >Paradigma baharu untuk penyuntingan teks dan imej, satu model membolehkan penyuntingan imej berpandukan berbilang teks

Paradigma baharu untuk penyuntingan teks dan imej, satu model membolehkan penyuntingan imej berpandukan berbilang teks

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-10 19:41:021316semak imbas

Ikhtisar ringkas kertas kerja

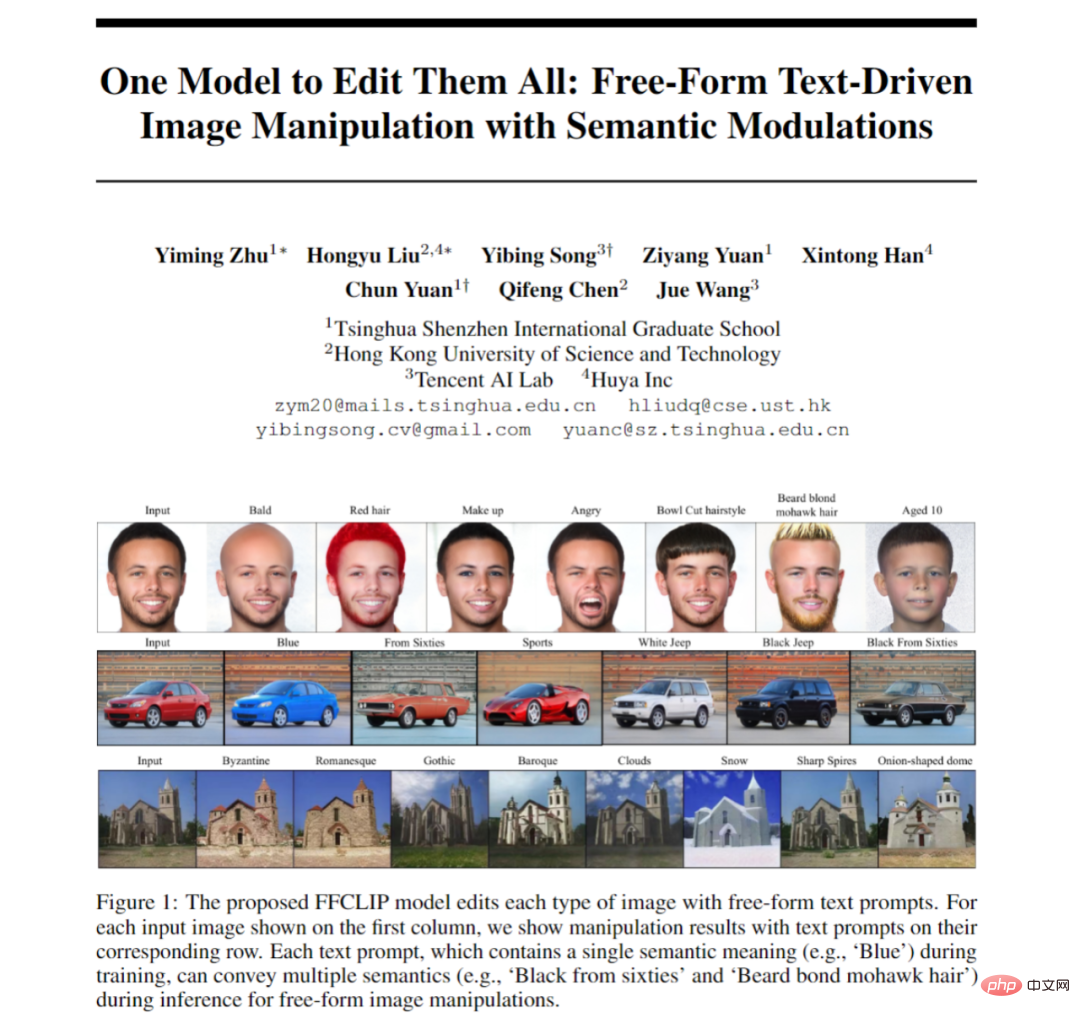

Penyelidikan yang berkaitan dengan penyuntingan imej menggunakan teks sangat hangat dan banyak kajian baru-baru ini adalah berdasarkan pada penyebaran denoising Walau bagaimanapun, beberapa sarjana terus memberi perhatian kepada penyelidikan berkaitan GAN. Artikel ini adalah berdasarkan StyleGAN dan CLIP klasik dan mencadangkan modul modulasi semantik, supaya hanya satu model diperlukan untuk teks yang berbeza untuk melaksanakan pengeditan imej teks.

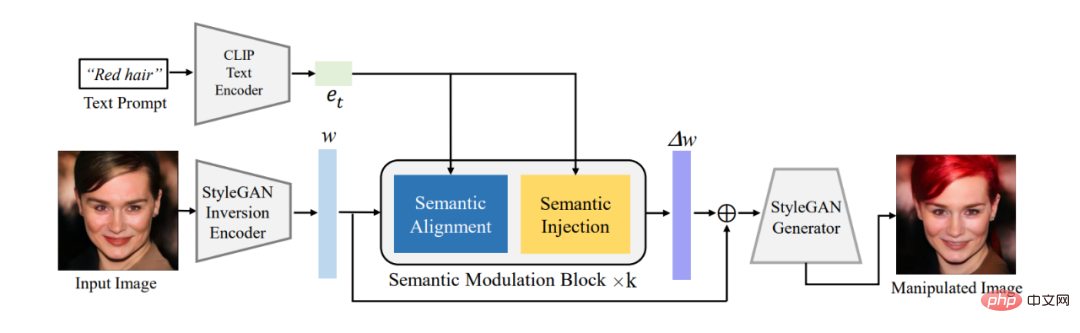

Artikel ini mula-mula menggunakan pengekod sedia ada untuk menukar imej untuk diedit ke dalam pengekodan terpendam w dalam ruang semantik W^+ StyleGAN, dan kemudian menggunakan modul modulasi semantik yang dicadangkan untuk mengekod kod pendam w Pengekodan melaksanakan modulasi adaptif. Modul pemodulatan semantik termasuk penjajaran semantik dan modul suntikan semantik Ia mula-mula menjajarkan semantik antara pengekodan teks dan pengekodan terpendam GAN melalui mekanisme perhatian, dan kemudian menyuntik maklumat teks ke dalam pengekodan terpendam sejajar untuk memastikan pengekodan Cain memiliki. teks. Maklumat dengan itu mencapai keupayaan untuk mengedit imej menggunakan teks.

Berbeza daripada model StyleCLIP klasik, model kami tidak perlu melatih model berasingan untuk setiap teks Satu model boleh bertindak balas kepada berbilang teks untuk mengedit imej dengan berkesan, jadi kita Model itu menjadi Manipulasi Imej Dipacu Teks Borang Bebas FFCLIP. Pada masa yang sama, model kami telah mencapai hasil yang sangat baik pada set data gereja, muka dan kereta klasik.

- Alamat kertas: https://arxiv.org/pdf/2210.07883.pdf

- Alamat Github: https://github.com/KumapowerLIU/FFCLIP

Latar belakang dan inspirasi

Baru-baru ini, gesaan teks percuma yang menerangkan niat pengguna telah digunakan untuk mengedit ruang terpendam StyleGAN untuk operasi penyuntingan imej [1, 2]. Mengambil sebagai input ayat (cth., 'Biru') atau frasa (cth., 'Lelaki berumur 10'), kaedah ini mengedit atribut imej yang diterangkan dengan sewajarnya dengan memodulasi pengekodan pendam dalam ruang pendam StyleGAN.

Pengeditan imej teks yang tepat bergantung pada pemetaan terpendam yang tepat antara ruang semantik visual StyleGAN dan ruang semantik teks CLIP. Sebagai contoh, apabila gesaan teks ialah "kejutan", kami mula-mula mengenal pasti subruang semantik yang berkaitan (iaitu "ungkapan", kerana kejutan tergolong dalam atribut ungkapan) dalam ruang semantik visual. Selepas mencari subruang semantik yang sepadan dengan teks, teks akan memberitahu kami arah perubahan pengekodan terpendam, daripada ungkapan semasa kepada ungkapan kejutan. Kajian perintis seperti TediGAN [1] dan StyleCLIP [2] dipratentukan secara empirik subruang visual terpendam yang sepadan dengan pembenaman pembayang teks sasaran (iaitu, pemilihan atribut khusus dalam TediGAN dan pemetaan kumpulan dalam StyleCLIP). Pengecaman empirikal ini mengekang bahawa diberikan gesaan teks, mereka mesti melatih model penyuntingan yang sepadan.

Isyarat teks yang berbeza memerlukan model yang berbeza untuk memodulasi kod terpendam dalam subruang visual terpendam StyleGAN. Walaupun kaedah orientasi global dalam StyleCLIP tidak menggunakan proses sedemikian, pelarasan parameter dan orientasi penyuntingan dipratakrifkan secara manual. Atas sebab ini, kami mempunyai sebab untuk meneroka cara mencari subruang semantik visual tersirat secara automatik melalui teks eksplisit, supaya satu model boleh mengendalikan berbilang teks.

Dalam kertas kerja ini, kami mencadangkan FFCLIP-Free Borang CLIP, yang secara automatik boleh mencari subruang visual yang sepadan untuk teks yang berbeza. FFCLIP terdiri daripada beberapa modul modulasi semantik yang mengambil sebagai input pengekodan terpendam w^+ dan pengekodan teks e dalam ruang pendam StyleGAN W^+.

Modul modulasi semantik terdiri daripada modul penjajaran semantik dan modul suntikan semantik. Modul penjajaran semantik mengambil pengekodan teks e sebagai pertanyaan dan pengekodan terpendam w sebagai kunci dan nilai. Kemudian kami mengira perhatian silang dalam dimensi kedudukan dan saluran masing-masing, menghasilkan dua peta perhatian. Kemudian kami menggunakan transformasi linear untuk mengubah ruang visual semasa ke dalam subruang yang sepadan dengan teks, di mana parameter transformasi linear (iaitu, terjemahan dan parameter penskalaan) dikira berdasarkan dua peta perhatian ini. Melalui penjajaran ini, kami boleh mencari subruang visual yang sepadan secara automatik untuk setiap teks. Akhir sekali, modul suntikan semantik [3] mengubah suai kod terpendam dalam subruang dengan mengikuti satu lagi transformasi linear.

Dari perspektif FFCLIP, [1, 2] pemilihan empirikal ruang neutron ialah satu bentuk khas transformasi linear kami dalam modul penjajaran semantik. Operasi pemilihan kumpulan mereka adalah serupa dengan nilai binari parameter penskalaan kami untuk menunjukkan penggunaan setiap dimensi kedudukan w. Sebaliknya, kami melihat bahawa semantik ruang W^+ masih terikat, dan reka bentuk empirikal tidak dapat mencari pemetaan yang tepat antara ruang terpendam StyleGAN dan ruang semantik teks CLIP. Sebaliknya, parameter penskalaan dalam modul penjajaran semantik kami secara adaptif mengubah suai kod terpendam w untuk memetakan pembenaman kiu teks yang berbeza. Penjajaran kemudiannya dipertingkatkan lagi melalui parameter terjemahan kami. Kami menilai kaedah kami pada set data penanda aras dan membandingkan FFCLIP dengan kaedah terkini. Keputusan menunjukkan bahawa FFCLIP mampu menjana kandungan yang lebih munasabah sambil menyampaikan niat pengguna.

FFCLIP

Rajah 1 menunjukkan rangka kerja keseluruhan kami. FFCLIP mula-mula memperoleh pengekodan terpendam imej dan teks melalui pengekod penyongsangan GAN dan pengekod teks yang telah terlatih Pengekodan terpendam imej adalah w dalam ruang semantik visual StyleGAN W^+ yang dinyatakan sebelum ini, manakala pengekodan teks ialah e_t. Seperti StyleCLIP, kami menggunakan pengekod penyongsangan e4e GAN [4] dan pengekod teks dalam CLIP untuk mendapatkan pengekodan pendam yang sepadan masing-masing. Kemudian kami menggunakan e_t dan w sebagai input modul modulasi dan keluarkan offset Δw w Akhir sekali, tambahkan Δw kepada w asal dan masukkan ke dalam StyleGAN yang telah dilatih untuk mendapatkan hasil yang sepadan.

Rajah 1: Gambarajah keseluruhan bingkai

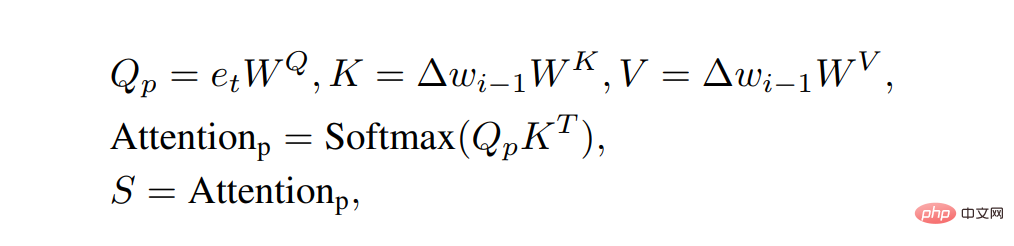

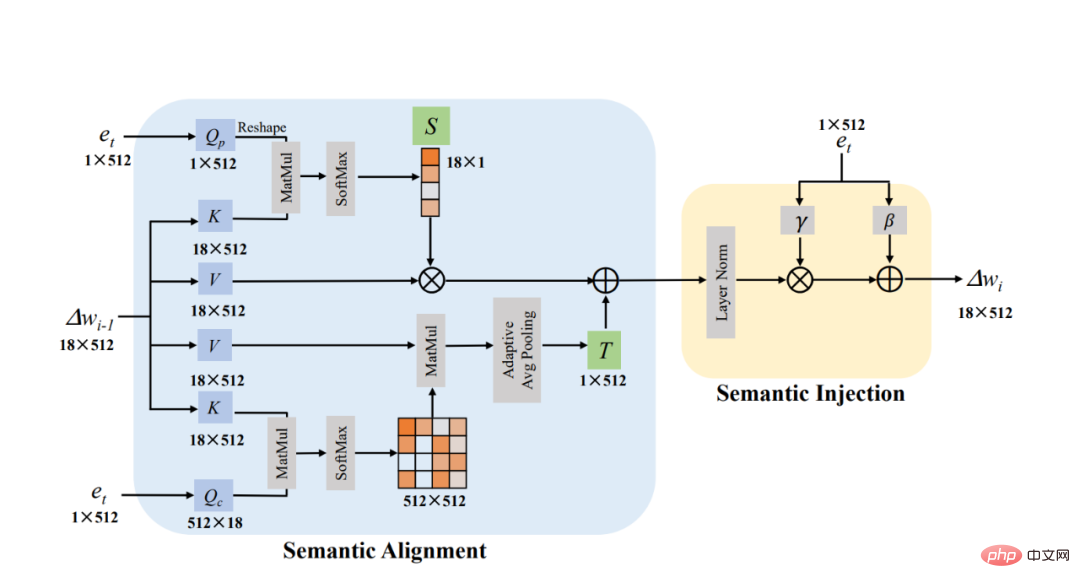

Rajah 2 di bawah ialah modul modulasi semantik kami. Dalam modul penjajaran semantik (Penjajaran Semantik), kita dapat melihat dengan jelas bahawa kita menetapkan Δw kepada Kunci dan Nilai dan menetapkan e_t kepada Pertanyaan untuk mengira dua peta perhatian Saiz kedua-dua peta perhatian ini adalah 18×1 dan 512×512 . Kemudian kami menganggap peta perhatian 18×1 sebagai pekali skala S dalam penjelmaan linear Proses kami mengira peta perhatian adalah seperti berikut:

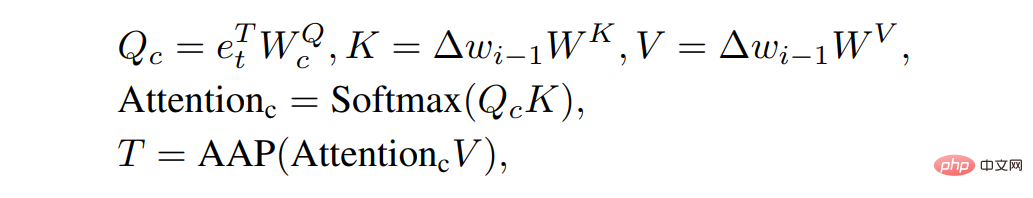

Pada masa yang sama kita Selepas mendarab peta perhatian 512×512 dengan Nilai, pekali terjemahan T dalam penjelmaan eksplisit diperoleh melalui operasi Pengumpulan. Proses kami mengira peta perhatian adalah seperti berikut:

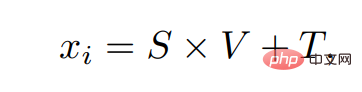

Selepas mempunyai terjemahan dan pekali penskalaan, kita boleh mencari fasa untuk teks semasa e_t melalui transformasi linear Untuk subruang visual yang sepadan, langkah pengiraan adalah seperti berikut:

Pertengahan x_i ialah hasil keluaran modulasi semantik ke-i kami modul. Oleh kerana saiz Δw ialah 18×512, peta perhatian 18×1 dan 512×512 masing-masing dikira dalam dua dimensi kedudukan dan saluran Δw Operasi ini serupa dengan Perhatian Berganda [5]. 🎜>

Rajah 2: Modulasi semantik Kita boleh dapatkan subruang visual yang sepadan dengan teks melalui operasi di atas Kemudian kami menggunakan kaedah yang serupa dengan AdaIN untuk menyuntik maklumat teks ke dalam ruang ini untuk mendapatkan hasil akhir Kami memanggil operasi ini sebagai modul suntikan semantik. Langkah-langkah pelaksanaan keseluruhan modul adalah seperti berikut:

Akhirnya, sejumlah 4 modul modulasi semantik telah disusun dalam FFCLIP kami, dan akhirnya offset akhir Δw diperolehi.

Hasil eksperimen

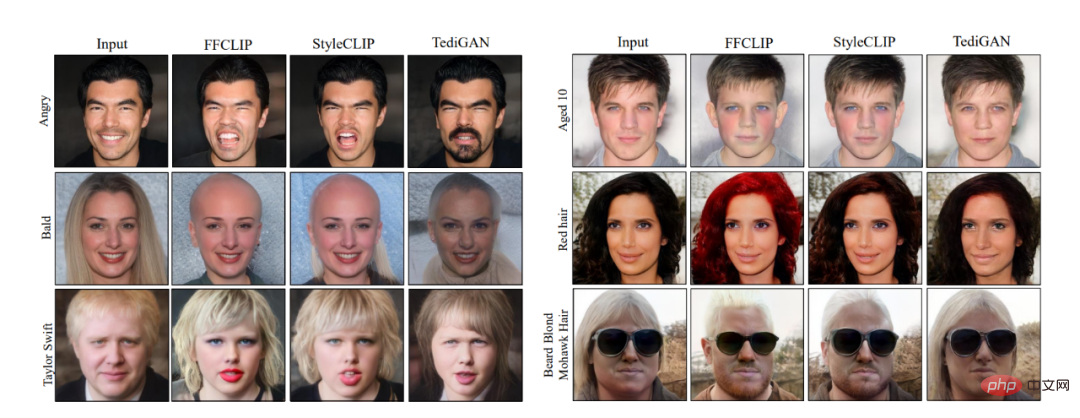

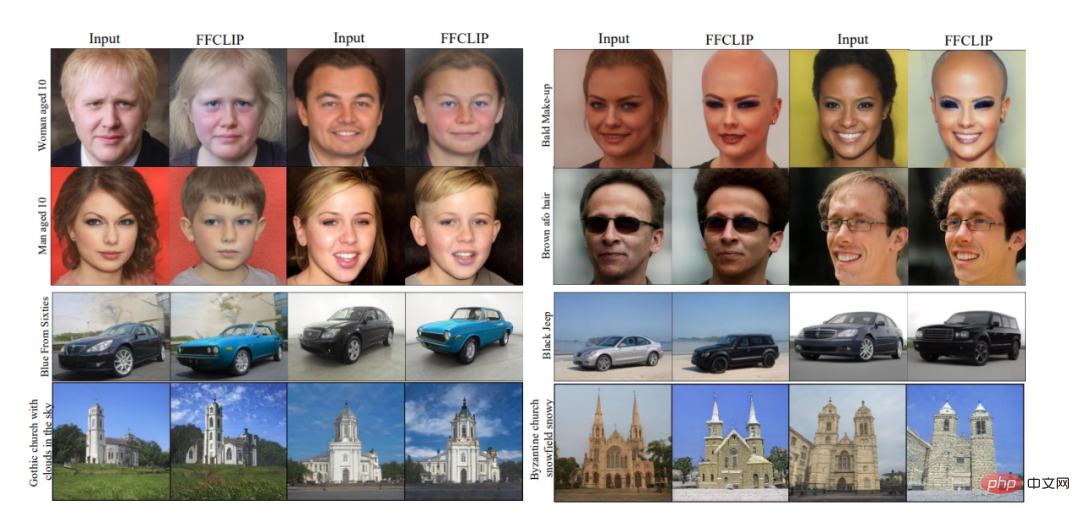

Rajah 3: Perbandingan visual

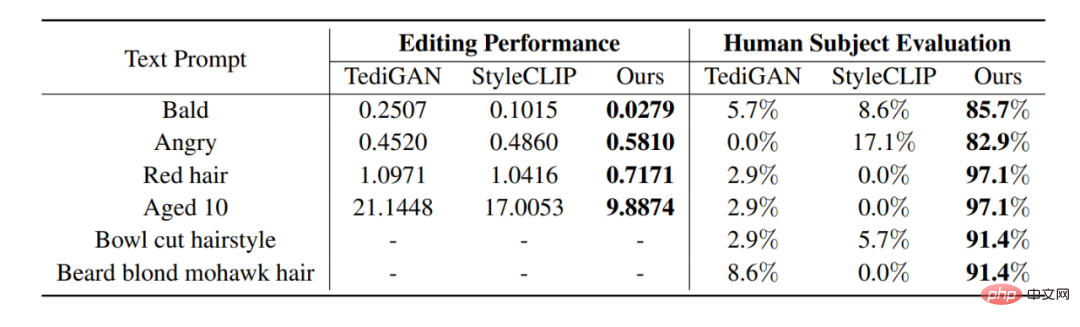

Seperti yang ditunjukkan dalam Rajah 3, kami membuat perbandingan visual dengan StyleCLIP [1], TediGAN [2] dan HairCLIP [3]: dapat dilihat bahawa FFCLIP boleh mencerminkan semantik teks dengan lebih baik, dan menjana imej yang disunting yang lebih realistik. Pada masa yang sama, hasil perbandingan berangka yang sepadan ditunjukkan dalam jadual di bawah Kaedah kami boleh mencapai hasil terbaik dalam kedua-dua nilai objektif dan subjektif.

Jadual 1: Perbandingan berangka

Pada masa yang sama, kaedah kami juga menunjukkan keteguhan yang sangat baik semasa latihan tetapi menggunakan perkataan tunggal untuk latihan, bagaimanapun, ia boleh melakukan pemprosesan imej dengan baik berdasarkan semantik kumpulan perkataan. kesan visual ditunjukkan dalam Rajah 4.

Rajah 4: Penyuntingan frasa

Untuk lebih banyak keputusan percubaan dan percubaan ablasi, sila lihat teks asal.

Ringkasan

Dalam kertas kerja ini kami mencadangkan FFCLIP, kaedah baharu untuk penyuntingan imej yang cekap yang boleh menyasarkan teks yang berbeza tetapi hanya memerlukan satu model. Motivasi artikel ini ialah kaedah sedia ada sepadan dengan teks semasa dan subruang semantik GAN berdasarkan pengalaman sedia ada, jadi model pengeditan hanya boleh mengendalikan satu gesaan teks. Kami menambah baik pemetaan terpendam melalui penjajaran dan modulasi semantik yang disuntik. Ia memudahkan satu model penyuntingan untuk mengendalikan berbilang gesaan teks. Percubaan pada berbilang set data menunjukkan bahawa FFCLIP kami berkesan menghasilkan hasil yang berkaitan secara semantik dan visual yang realistik.

Atas ialah kandungan terperinci Paradigma baharu untuk penyuntingan teks dan imej, satu model membolehkan penyuntingan imej berpandukan berbilang teks. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI