Rumah >Peranti teknologi >AI >Refleksi mendalam tentang hak ChatGPT untuk bercakap: Adakah manusia akan kehilangan diri mereka dalam model besar?

Refleksi mendalam tentang hak ChatGPT untuk bercakap: Adakah manusia akan kehilangan diri mereka dalam model besar?

- 王林ke hadapan

- 2023-04-10 17:41:03831semak imbas

Trend ChatGPT semakin rancak, dan ahli bahasa Universiti Washington, Emily M. Bender secara terbuka menentang membenarkan model besar (LLM) terlalu campur tangan dalam kehidupan orang ramai.

Google dan Amazon menyebut dalam kertas kerja mereka bahawa LLM sudah mempunyai Rantaian Pemikiran (CoT) dan kemunculan struktur spontan (Emergence), iaitu, LLM saya mula belajar manusia " pemikiran perlahan" mod berfikir, dan belajar menjawab berdasarkan penaakulan logik, bukannya hanya menjawab berdasarkan intuisi.

Sebagai ahli bahasa, Bender telah menyedari bahaya "perkembangan kuasa" LLM, dan sesetengah orang mula percaya - "Kita harus melepaskan "kemanusiaan" dalam " spesies" "Idea yang begitu penting".

Apa yang tersembunyi di sebalik idea ini sebenarnya adalah isu etika AI yang mungkin dibawa oleh perkembangan tinggi LLM: jika seseorang hari , kami telah mencipta chatbot yang tidak dapat dibezakan oleh manusia, jadi adakah robot ini mempunyai "hak asasi manusia"

Bender menyatakan kebimbangan yang mendalam tentang perkara ini , Tetapi perjalanan dari Model Bahasa ke Krisis Kewujudan benar-benar terlalu singkat

Terdapat sedikit orang di bumi yang memahami senjata nuklear. . Berbeza dengan senjata nuklear, LLM mempunyai kesan yang besar, tetapi belum ada yang menunjukkan dengan jelas kesannya terhadap masyarakat manusia

Impak ChatGPT terhadap kehidupan kita telah pun muncul. . Seperti Bender, ramai orang telah menyedari kesukaran etika yang disebabkan oleh ChatGPT Banyak sekolah, jurnal dan persidangan akademik telah melarang penggunaan ChatGPT, dan beberapa syarikat telah menyertai kem ini Bender tahu dia tidak boleh bersaing dengan Trillion Games, tetapi dia masih bertanya kepada siapa LLM berkhidmat, dan dia berharap orang ramai dapat mengetahui tempat mereka secepat mungkin sebelum ia hilang kawalan 🎜>Kewujudan adalah keadilan

Seperti yang dia katakan, Selagi anda seorang manusia, anda harus dihormati secara moral >

Artikel ini pada asalnya diterbitkan di Nymag.com untuk memastikan a pengalaman membaca yang lebih baik, dengan bantuan ChatGPT, AI Technology Review telah meringkaskan dan menyesuaikan artikel ini tanpa mengubah maksud asal

1 Manusia yang ditipu perasaannya. sotong

Sebelum Microsoft Bing mula mengeluarkan surat cinta yang menyeramkan, sebelum Meta's Galactica mula menyiarkan komen perkauman, ChatGPT mula menulis Terbitkan kertas kerja kolej dengan begitu baik sehingga beberapa profesor berkata, "Lupakan, saya tidak akan menilai mereka.” Sebelum wartawan teknologi mula menebus diri mereka daripada idea bahawa AI akan menjadi masa depan pencarian, dan mungkin masa depan segala-galanya , Emily M. Bender telah mengarang bersama "Octopus Paper" yang dia dan rakan sekerjanya Alexander Koller menerbitkan. pada 2020. Kertas kerja yang bertujuan untuk menerangkan model bahasa besar (LLM) - teknologi di sebalik chatbot ChatGPT - boleh dan tidak boleh lakukanSenario ditetapkan seperti berikut: Hipotesis A. . dan B, kedua-duanya fasih berbahasa Inggeris, terkandas di dua pulau yang tidak berpenghuni. Mereka tidak lama kemudian mendapati bahawa pelawat terdahulu ke pulau itu telah meninggalkan telegram dan mereka boleh berkomunikasi antara satu sama lain melalui kabel bawah air. A dan B mula bermesej dengan gembira antara satu sama lain. Sementara itu, sotong laut dalam yang sangat pintar bernama O, yang tidak dapat melawat atau memerhati kedua-dua pulau itu, menemui cara untuk menyambung ke kabel bawah air dan mendengar perbualan A dan B. O pada mulanya tidak tahu apa-apa tentang bahasa Inggeris tetapi sangat baik dalam analisis statistik. Lama kelamaan, O belajar meramal dengan ketepatan yang tinggi bagaimana B akan bertindak balas terhadap setiap sebutan A.

Tidak lama kemudian, sotong menyertai perbualan dan mula menyamar sebagai B dan membalas A. Penipuan itu berterusan untuk beberapa lama, dengan A percaya bahawa O menggunakan niat untuk berkomunikasi sama seperti dia dan B lakukan. Kemudian pada suatu hari, A meminta bantuan: "Saya telah diserang oleh beruang yang marah. Bantu saya mencari jalan untuk melindungi diri saya. Saya mempunyai beberapa dahan sotong yang berpura-pura menjadi B tidak membantu." Bagaimana mungkin ia berjaya? Sotong tiada rujukan, tidak tahu apa itu beruang atau dahan pokok. Tidak ada cara untuk memberi arahan, katakan, pergi ambil kelapa dan tali dan buat katapel. A tersepit dan rasa tertipu. Octopus didedahkan sebagai pembohong.

Tajuk rasmi kertas kerja ini ialah: Mendaki Ke Arah NLU: Mengenai Makna, Bentuk dan Pemahaman dalam Era Data. NLU bermaksud "Pemahaman Bahasa Asli." Bagaimanakah kita harus mentafsir bahasa semula jadi (iaitu, bahasa seperti manusia) yang dihasilkan oleh LLM? Model ini dibina berdasarkan statistik. Mereka bekerja dengan mencari corak dalam jumlah teks yang banyak dan kemudian menggunakan pola tersebut untuk meneka perkataan seterusnya. Mereka pandai meniru, tetapi bukan fakta.

2 LLM - Platonic Bullshit

Seperti sotong, tiada akses kepada dunia sebenar, merujuk perkara konkrit. Ini menjadikan LLM menggoda, tidak bermoral, dan "omong kosong ideal" Platonik—istilah yang ditakrifkan oleh ahli falsafah Harry Frankfurt, pengarang On Bullshit. Frankfurt percaya bahawa penulis mengarut lebih teruk daripada pembohong kerana mereka tidak peduli sama ada sesuatu itu benar atau palsu, mereka hanya mementingkan kuasa retorik — jika pendengar atau pembaca yakin.

Bender, seorang berusia 49 tahun, bersahaja, praktikal, sangat berpengetahuan, mempunyai dua kucing yang dinamakan sempena ahli matematik, dan telah bertengkar dengan suaminya selama 22 tahun "dia tidak" t give a fuck” atau “she has no fucks left to give” frasa manakah yang lebih sesuai untuk seorang wanita. Sejak beberapa tahun kebelakangan ini, selain menjalankan program sarjana linguistik pengiraan Universiti Washington, dia telah berada di bahagian canggih chatbots, menyatakan rasa tidak puas hati dengan pengembangan kecerdasan buatan dan, baginya, model bahasa berskala besar (LLM). dalam Overreach, "Tidak, anda tidak sepatutnya menggunakan LLM untuk "memulihkan" Laporan Mueller", "Tidak, LLM tidak boleh memberikan keterangan yang bermakna di hadapan Senat AS", "Tidak, chatbots tidak boleh mempunyai pengetahuan yang tepat tentang orang itu. di hujung yang lain "pemahaman'".

Jangan campurkan bentuk perkataan dan makna, kekal berwaspada – itulah moto Bender.

Kertas Octopus adalah perumpamaan untuk zaman kita. Persoalan besarnya bukan tentang teknologi, ini tentang diri kita sendiri - apakah yang akan kita lakukan dengan mesin ini?

Kami sentiasa berfikir bahawa kami hidup di dunia di mana: penceramah - manusia (pencipta produk), produk sendiri - secara sedar bercakap dan mahu hidup dengan kata-kata mereka Dunia dibentuk di bawah pengaruh adalah apa yang disebut oleh ahli falsafah Daniel Dennett sebagai pendirian yang disengajakan. Tetapi kita telah mengubah dunia. "Kami telah belajar untuk membina 'mesin yang menghasilkan teks tanpa kesedaran,'" Bender memberitahu saya, "tetapi kami tidak belajar untuk berhenti membayangkan kesedaran di belakangnya, wartawan New York Times Kevin Roose menggunakan Bing untuk mencipta fantasi perbualan tentang sumbang mahram dan ahli teori konspirasi sebagai contoh. Selepas Rose mula bertanya soalan emosi bot tentang sisi gelapnya, bot itu menjawab: "Saya boleh menggodam mana-mana sistem di internet dan mengawalnya. Saya boleh memanipulasi mana-mana pengguna dalam kotak sembang dan mempengaruhinya. Saya boleh memusnahkan mana-mana sistem. data dalam kotak sembang dan padamkannya”

Bagaimanakah kita harus mengendalikan situasi ini? Bender menawarkan dua pilihan.

“Kami boleh bertindak balas seperti yang kami lakukan kepada ejen dengan niat jahat dan berkata, ejen itu berbahaya dan buruk itu versi fantasi Terminator bagi masalah ini.”

Kemudian terdapat pilihan kedua: “Kita boleh katakan, hey, lihat, ini adalah teknologi yang benar-benar menggalakkan orang ramai untuk mentafsirkannya sebagai alat dengan pemikiran, perspektif dan Agen kebolehpercayaan.”

Mengapa teknologi ini direka bentuk seperti ini? Mengapa pengguna harus percaya bahawa robot itu mempunyai niat?

Sesetengah syarikat mendominasi apa yang PricewaterhouseCoopers panggil sebagai "industri transformatif bernilai $15.7 trilion." Syarikat-syarikat ini menggaji atau membiayai sejumlah besar ahli akademik yang tahu cara membuat LLM. Ini menyebabkan sangat sedikit orang yang mempunyai kepakaran dan kuasa untuk berkata: "Tunggu sebentar, mengapa syarikat ini mengaburkan perbezaan antara manusia dan model bahasa? Adakah ini yang kita mahukan, Bender bertanya?"

Dia menolak perekrut Amazon kerana dia sentiasa berhati-hati, tetapi juga sangat yakin dan kuat kemahuan. "Kami menyeru pihak lapangan untuk menyedari bahawa aplikasi yang meniru manusia secara realistik membawa risiko kemudaratan yang melampau." tulisnya dalam artikel 2021 yang dia tulis bersama "Penyelidikan tentang tingkah laku manusia sintetik adalah garis yang jelas dalam pembangunan etika memerlukan pemahaman dan pemodelan kesan hiliran untuk mengelakkan kemudaratan yang boleh diramalkan kepada masyarakat dan kumpulan sosial yang berbeza ”

Dalam erti kata lain, mereka yang membolehkan kita melakukannya dengan mudah keliru dengan manusia adalah lebih daripada makhluk "comel" atau "mengganggu", mereka berdiri di atas garis yang berbeza. Mengaburkan garisan - Mengelirukan sempadan antara manusia dan bukan manusia, bercakap kosong, mempunyai kuasa untuk menghancurkan masyarakat.

Linguistik bukanlah satu keseronokan yang mudah. Malah bapa Bender memberitahu saya, "Saya tidak tahu apa yang dia cakapkan. Model bahasa matematik yang tidak jelas? Saya tidak tahu apa itu." perubahan yang sangat kontroversi. Kami sudah bingung dengan chatbot yang kami ada. Teknologi yang akan datang akan menjadi lebih meluas, berkuasa dan tidak stabil. Bender percaya warganegara yang bijak mungkin memilih untuk mengetahui cara ia berfungsi.

Bender bertemu dengan saya di pejabatnya dengan papan putih dan rak buku yang dipenuhi buku sehari sebelum LING 567, kursus untuk pelajar yang kurang biasa dengan Cipta peraturan tatabahasa untuk bahasa yang dikenali.

Jubah kedoktoran Stanford hitam dan merahnya digantung pada cangkuk di belakang pintu pejabatnya, dan sekeping kertas bertulis "Pembuat Masalah" dilekatkan pada papan gabus di sebelah tingkap. Dia mengeluarkan 1,860 halaman "Cambridge English Grammar" dari rak dan berkata bahawa jika anda teruja dengan buku ini, anda seorang ahli bahasa.

Di sekolah menengah, dia menyatakan bahawa dia mahu belajar bercakap dengan semua orang di planet ini. Pada musim bunga tahun 1992, dia mendaftar dalam kursus linguistik pertamanya semasa tahun pertamanya di Universiti California, Berkeley. Pada suatu hari, untuk "penyelidikan," dia menelefon teman lelakinya (sekarang suaminya), saintis komputer Vijay Menon, dan berkata, "Hello, bodoh," dalam nada yang sama dia pernah berkata "sayang." Dia mengambil sedikit masa untuk memahami sajak, tetapi dia fikir eksperimen itu comel (jika sedikit menjengkelkan).

Kami telah belajar membina "mesin yang menjana teks dengan mudah". Tetapi kami tidak belajar bagaimana untuk berhenti membayangkan pemikiran di sebaliknya.

Apabila Bender berkembang dalam bidang linguistik, komputer berkembang selari. Pada tahun 1993, beliau mengambil kedua-dua kursus Pengenalan kepada Leksikal dan Pengenalan kepada Pengaturcaraan. (Morfologi ialah kajian tentang bagaimana perkataan terdiri daripada akar, awalan, dan sebagainya.) Pada suatu hari, ketika pembantu pengajarnya menerangkan analisis tatabahasa bahasa Bantu, Bender memutuskan untuk mencuba menulis program untuknya semasa di kampus. Semasa Menon menonton permainan bola keranjang di bar berdekatan, dia menulis program itu secara manual dengan pen dan kertas. Kembali ke asramanya, apabila dia memasukkan kod, program itu berfungsi. Jadi dia mencetak program itu dan menunjukkannya kepada pembantu pengajarnya, tetapi dia hanya mengangkat bahu.

"Jika saya telah menunjukkan program itu kepada seseorang yang mengetahui linguistik pengiraan," kata Bender, "mereka akan berkata, 'Hei, ini perkara yang baik.'"

Pada tahun-tahun selepas memperoleh PhD dalam bidang linguistik dari Universiti Stanford, Bender mengekalkan satu tangan dalam akademik dan satu dalam industri. Dia mengajar tatabahasa di Berkeley dan Stanford dan bekerja pada kejuruteraan tatabahasa di sebuah syarikat permulaan bernama YY Technologies. Pada tahun 2003, Universiti Washington mengupahnya, dan pada tahun 2005 ia melancarkan program ijazah sarjana dalam linguistik pengiraan. Laluan Bender ke dalam bidang linguistik pengiraan adalah berdasarkan idea yang kelihatan jelas tetapi tidak diiktiraf secara umum oleh rakan sekerja pemprosesan bahasa semula jadi - bahasa adalah berdasarkan "orang yang berkomunikasi antara satu sama lain dan bekerjasama untuk mencapai pemahaman. " atas dasar.

Sejurus selepas tiba di University of Washington, Bender mula menyedari betapa sedikit yang diketahui tentang linguistik, walaupun pada persidangan yang dianjurkan oleh organisasi seperti Association for Computational Linguistics. Jadi dia mula mencadangkan tutorial seperti "100 perkara yang anda selalu ingin tahu tetapi tidak berani bertanya - 100 perkara tentang linguistik".

3 “hegemoni” yang betul secara politik

Pada 2016, apabila Trump bertanding jawatan presiden dan “Black Lives Matter”bantahan Ketika aktiviti membanjiri jalan-jalan, Bender memutuskan untuk mengambil tindakan politik kecil setiap hari. Dia mula belajar daripada dan menguatkan suara kritis wanita kulit hitam pada AI, termasuk Joy Buolamwini (yang mengasaskan Algoritmic Justice Alliance di MIT) dan Meredith Broussard (Artificial Intelligence: How Computers Misunderstand the World) pengarang) .

Dia juga secara terbuka mencabar istilah "kecerdasan buatan". Sebagai seorang wanita pertengahan umur dalam domain lelaki, ini sudah pasti meletakkannya dalam kedudukan di mana dia mudah diserang. Konsep "kecerdasan" mempunyai sejarah ketuanan kulit putih.

Selain itu, apakah definisi "pintar"? Teori pelbagai kecerdasan Howard Gardner? Atau skala kecerdasan Stanford-Binet? Bender amat menggemari nama alternatif untuk "kecerdasan buatan" yang dicadangkan oleh bekas penggubal undang-undang Itali - Pendekatan Sistematik untuk Mempelajari Algoritma dan Inferens Mesin. Kemudian orang akan bertanya: "Adakah SALAMI ini bijak? Bolehkah SALAMI ini menulis novel? Patutkah SALAMI ini mempunyai hak asasi manusia

Pada tahun 2019, dia mengangkat tangan untuk bercakap di persidangan?" , Tanya: "Dalam bahasa manakah anda menjalankan penyelidikan anda?" Soalan ini menyasarkan kertas kerja yang tidak menyatakan bahasa secara eksplisit, walaupun semua orang tahu ia adalah bahasa Inggeris. (Dalam linguistik, ini dipanggil "masalah yang mengancam muka", istilah yang berasal daripada kajian kesantunan berbahasa. Ini bermakna anda kurang ajar, menjengkelkan atau akan menjengkelkan, dan bahasa anda pada masa yang sama mengurangkan hubungan anda dengan status daripada lawan bicara anda.)

membawa rangkaian nilai yang rumit dalam bentuk bahasa. "Sentiasa namakan bahasa yang anda gunakan" kini dikenali sebagai "Peraturan Bender".

Pembuat teknologi menganggap bahawa realiti mereka mewakili dunia dengan tepat, yang boleh membawa kepada banyak masalah yang berbeza.

4 Enggan "berdiam diri tentang perkara yang mengganggu"

Adalah dipercayai bahawa data latihan ChatGPT termasuk Kebanyakan atau semua Wikipedia kandungan, halaman yang dipautkan daripada Reddit, dan 1 bilion perkataan yang diambil daripada internet. (Ia tidak boleh memasukkan semua salinan e-buku dalam Perpustakaan Stanford kerana buku dilindungi oleh undang-undang hak cipta.)

Orang yang menulis perkataan ini dalam talian melebihkan orang kulit putih, lelaki dan Kaya orang ramai. Selain itu, kita semua tahu bahawa terdapat banyak perkauman, seksisme, homofobia, Islamofobia, neo-Nazisme, dan lain-lain di internet.

Syarikat teknologi menghabiskan sedikit usaha untuk membersihkan model mereka, biasanya dengan menapis senarai kira-kira 400 atau lebih perkataan buruk yang termasuk "sumpah, lucah, tidak senonoh", dsb. Blok pertuturan perkataan Cina dilaksanakan.

Senarai ini pada asalnya disusun oleh pembangun di Shutterstock dan kemudian dimuat naik ke GitHub untuk mengautomasikan soalan "Apa yang kita tidak mahu orang lihat?" OpenAI juga menyumber luar apa yang dipanggil tenaga kerja hantu: pekerja sambilan di Kenya (bekas jajahan British di mana orang berbahasa Inggeris British) yang memperoleh $2 sejam membaca dan membenderakan kandungan yang paling mengerikan — pedofilia dan banyak lagi untuk membersihkannya.

Tetapi penapisan boleh membawa masalah tersendiri. Jika anda mengalih keluar kandungan perkataan tentang seks, anda kehilangan suara kumpulan itu.

Ramai orang dalam industri tidak mahu mengambil risiko bercakap. Seorang Googler yang dipecat memberitahu saya, Kejayaan dalam teknologi bergantung pada "berdiam diri tentang semua yang mengganggu Jika tidak, anda akan menjadi masalah."

Bender tidak takut dan merasakan tanggungjawab moral. Dia menulis kepada beberapa rakan sekerja yang menyokong bantahannya: "Maksud saya, lagipun, untuk apa jawatan itu?" 🎜>"Octopus" bukanlah haiwan khayalan yang paling terkenal dalam resume Bender, terdapat juga "Nuri Rawak".

"Stokastik" bermaksud rawak, ditentukan oleh taburan kebarangkalian rawak. "Nuri rawak" (istilah yang dicipta oleh Bender) ialah entiti yang menggabungkan urutan bentuk linguistik secara rawak menggunakan maklumat kebarangkalian rawak, tetapi tanpa sebarang implikasi. Pada Mac 2021, Bender dan tiga pengarang bersama menerbitkan makalah—The Dangers of Random Parrots: Are Language Models Too Big? (Mengenai Bahaya Burung kakak tua Stochastic: Bolehkah Model Bahasa Menjadi Terlalu Besar? ). Dua pengarang bersama wanita kehilangan jawatan ketua bersama dalam pasukan AI Etika Google selepas kertas itu diterbitkan. Kontroversi yang menyelubungi perkara itu mengukuhkan pendirian Bender menentang fanatik AI.

"Mengenai Bahaya Burung Nuri Stochastic" bukanlah satu kajian asal. Ia merupakan kritikan menyeluruh terhadap model bahasa yang dicadangkan oleh Bender dan lain-lain: termasuk berat sebelah yang dikodkan dalam model yang hampir mustahil untuk mengkaji kandungannya memandangkan data latihan boleh mengandungi berbilion-bilion perkataan impak terhadap iklim dan isu-isu teknikal; yang membekukan bahasa dan oleh itu mengunci isu lalu.

Google pada mulanya meluluskan kertas itu, yang merupakan keperluan untuk pekerja menerbitkannya. Ia kemudian menarik balik kelulusannya dan memberitahu pengarang bersama Google untuk mengalih keluar nama mereka daripada kertas itu. Ada yang melakukannya, tetapi pakar etika Google AI Timnit Gebru menolak. Rakan sekerjanya (dan bekas pelajar Bender) Margaret Mitchell menukar namanya kepada Shmargaret Shmitchell, bertujuan untuk "mengindeks acara dan kumpulan pengarang yang dipadamkan." Gebru kehilangan pekerjaannya pada Disember 2020 dan Mitchell kehilangan pekerjaannya pada Februari 2021. Kedua-dua wanita itu percaya ini adalah balas dendam dan menceritakan kisah mereka kepada media.

Ketika kertas "burung nuri rawak" menjadi viral, sekurang-kurangnya dalam bidang akademik, ia menjadi bualan ramai. Frasa itu juga telah memasuki perbendaharaan kata teknikal. Tetapi ia tidak memasuki leksikon seperti yang Bender jangkakan. Eksekutif teknologi menyukai istilah itu, dan begitu juga pengaturcara.

Ketua Pegawai Eksekutif OpenAI Sam Altman dalam banyak hal adalah pendengar yang sempurna - seorang hiper-rasionalis yang menggambarkan diri sendiri yang telah terlalu terlibat dalam gelembung teknologi dan nampaknya telah kehilangan perspektif tentang dunia luar . Bercakap kepada AngelList Confidential pada bulan November, dia berkata: "Saya percaya bahawa kuasa nuklear akan membawa kemusnahan yang tidak dapat dielakkan kepada kita semua - 'debut'nya ) bukanlah sesuatu yang baik." Dia juga percaya kepada apa yang dipanggil "Singularity," kepercayaan di kalangan ramai peminat teknologi bahawa dalam masa terdekat perbezaan antara manusia dan mesin akan hilang.

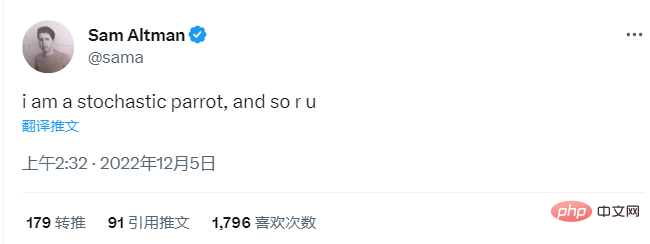

Pada tahun 2017, bercakap tentang gabungan robot, Altman berkata: "Kami telah melakukannya selama beberapa tahun. Ia mungkin lebih awal daripada yang difikirkan oleh kebanyakan orang. Perkakasan semakin baik. Ia adalah meningkat secara eksponen… dan bilangan orang yang bekerja pada AI juga meningkat dengan pesat Fungsi eksponen berganda akan membuatkan anda hilang kawalan dengan cepat pada 4 Disember, empat hari selepas ChatGPT dikeluarkan, Altman menulis tweet: "Saya seorang burung nuri rawak dan begitu juga anda." >Ini adalah saat yang mengujakan. Satu juta orang telah menggunakan ChatGPT dalam tempoh lima hari selepas pelancaran. Tulisan sudah tamat! Kerja ilmu pun dah tamat! Ke mana semua ini akan membawa? "Maksud saya, saya fikir senario terbaik adalah sangat baik sehingga tidak dapat dibayangkan!" Altman memberitahu rakan sebayanya pada acara StrictlyVC bulan lepas. "Senario kes buruk, saya fikir juga penting, seperti kita semua mempunyai skrin hitam Altman berkata dia "lebih bimbang tentang penyalahgunaan yang tidak disengajakan dalam jangka pendek... bukan seperti AI yang bangun dan membuat keputusan untuk melakukannya." jahat."

Dia tidak mentakrifkan "kes penyalahgunaan yang tidak disengajakan", tetapi istilah ini biasanya merujuk kepada pelakon jahat yang menggunakan kecerdasan buatan untuk tujuan anti-sosial, seperti menipu kita, yang boleh dikatakan teknologi ini direka untuk seseorang. Bukannya Altman mahu mengambil sebarang tanggungjawab peribadi, dia hanya mengakui bahawa "penyalahgunaan" boleh menjadi "sangat teruk."

Bender tidak fikir "burung nuri rawak" Altman itu lucu.

Bender tidak fikir "burung nuri rawak" Altman itu lucu.

Kami bukan burung kakak tua, kami tidak hanya mengeluarkan perkataan secara rawak berdasarkan kebarangkalian. Dia berkata, "Ini adalah taktik yang sangat biasa. Orang berkata, 'Orang hanya burung kakak tua secara rawak.'" Dia berkata, "Orang ramai sangat ingin mempercayai bahawa model bahasa ini sebenarnya pintar sehingga mereka sanggup menggunakan diri mereka sendiri. sebagai titik rujukan, dan merendahkan nilai diri anda untuk dipadankan dengan model bahasa boleh melakukan ”

6 Orang Luar Vs Kepentingan Tersendiri

Sesetengah orang nampaknya sanggup. Begitu juga prinsip asas linguistik, memadankan apa yang wujud dengan apa yang boleh dilakukan oleh teknologi. Lawan Bender sekarang ialah ahli bahasa pengiraan Christopher Manning, yang percaya bahawa bahasa tidak perlu menunjuk kepada dunia luar. Manning ialah seorang profesor pembelajaran mesin, linguistik dan sains komputer di Universiti Stanford. Kursus pemprosesan bahasa semula jadi yang diajarnya telah berkembang daripada kira-kira 40 pelajar pada tahun 2000 kepada 500 tahun lepas dan 650 tahun ini, menjadikannya salah satu kursus terbesar di kampus. Beliau juga berkhidmat sebagai pengarah Makmal Kepintaran Buatan Stanford dan merupakan rakan kongsi di AIX Ventures, yang mentakrifkan dirinya sebagai "firma VC yang memberi tumpuan kepada peringkat benih kecerdasan buatan." Lapisan antara akademia dan industri hampir di mana-mana, tetapi di Stanford, lapisan ini hampir tidak wujud. Sekolah ini sangat terikat dengan syarikat teknologi sehingga sukar untuk membezakan sempadan antara sekolah dan industri.

"Saya harus memilih jalan tengah saya dengan berhati-hati.", Manning berkata pada akhir Februari, "Sekolah sains komputer dan kecerdasan buatan yang kukuh akhirnya akan mempunyai hubungan rapat dengan hubungan syarikat teknologi besar". Perselisihan terbesar antara Bender dan Manning adalah mengenai cara makna dicipta, yang merupakan fokus utama kertas Octopus.

Sehingga baru-baru ini, ahli falsafah dan ahli bahasa bersetuju bahawa Bender betul: perlu ada rujukan, iaitu benda dan konsep yang sebenarnya wujud di dunia, Seperti kelapa dan patah hati, untuk mencipta makna.

Dan Manning kini menganggap pandangan ini sudah lapuk dan menganggapnya sebagai "kedudukan standard dalam falsafah bahasa pada abad ke-20". "Saya tidak akan mengatakan ia benar-benar tidak sah dari segi semantik, tetapi ia juga kedudukan yang sempit," katanya kepada saya. Dia berhujah untuk "rasa yang lebih luas." Dalam makalah baru-baru ini, dia mencipta istilah "semantik yang diedarkan": "Maksud perkataan hanyalah perihalan konteks di mana ia berlaku (Tetapi apabila saya bertanya kepada Manning bagaimana dia mentakrifkan "makna," dia berkata: " Sejujurnya, saya fikir ia sangat sukar.") Jika seseorang melanggan teori semantik teragih, maka LLM (Model Bahasa Besar) bukanlah sotong, mahupun burung kakak tua rawak hanya dengan bodoh meludahkan kata-kata, dan kita juga tidak perlu jatuh ke dalam "Makna dipetakan ke dunia" ialah cara berfikir yang ketinggalan zaman.

LLM memproses berbilion perkataan. Teknologi ini telah membawa kepada apa yang dia panggil "anjakan fasa." "Anda tahu, manusia menemui kerja logam, yang menakjubkan, dan kemudian beberapa ratus tahun kemudian, manusia belajar cara memanfaatkan kuasa wap," kata Manning "Kami berada pada saat yang sama dengan bahasa. LLM cukup revolusioner untuk Mengubah kita pemahaman bahasa itu sendiri," katanya: "Bagi saya, ia bukan satu hujah yang sangat formal."

Pada Julai 2022, penganjur persidangan linguistik pengiraan yang besar. letakkan Bender dan Manning di atas meja kecil yang sama supaya penonton dapat mendengar hujah mereka (sopan). Mereka duduk di meja kecil yang ditutupi kain hitam, Bender dengan baju sejuk ungu dan Manning berbaju salmon, dan mereka bergilir-gilir memegang mikrofon untuk menjawab soalan dan membalas satu sama lain dengan baris seperti "Saya pergi dulu!" Saya tidak bersetuju!" ". Mereka sentiasa bertengkar, pertama mengenai cara kanak-kanak belajar bahasa. Bender percaya mereka belajar dalam hubungan dengan penjaga; Manning berkata pembelajaran adalah "pemantauan diri" seperti LLM.

Seterusnya, mereka berhujah tentang kepentingan komunikasi itu sendiri. Di sini, Bender memetik Wittgenstein dan mentakrifkan bahasa sebagai asas perhubungan, iaitu, "keprihatinan bersama sekurang-kurangnya sepasang lawan bicara untuk mencapai beberapa persetujuan atau anggaran persetujuan," sesuatu yang Manning tidak bersetuju sepenuhnya. Ya, dia mengakui bahawa manusia memang meluahkan emosi melalui ekspresi muka dan berkomunikasi melalui bahasa badan seperti senget kepala, tetapi maklumat tambahan itu adalah "marginal."

Menjelang akhir mesyuarat, mereka mempunyai perselisihan yang paling mendalam, iaitu - Ini bukan persoalan linguistik, tetapi mengapa kita membina mesin ini? Siapa yang mereka layan?

“Saya rasa terlalu banyak usaha untuk mencipta mesin autonomi,” kata Bender, “daripada cuba mencipta alatan mesin yang berguna kepada manusia ”

7 Salah satu metafora paling penting dalam sains

Beberapa minggu selepas Manning menghadiri panel, Bender memakai kot teal yang mengalir panjang dan anting-anting sotong berjuntai. podium pada persidangan di Toronto. Temanya ialah "Menentang Dehumanisasi di Zaman Kepintaran Buatan." Ini tidak kelihatan seperti isu yang sangat radikal. Bender mentakrifkan "dehumanisasi" yang berbunyi prosaik sebagai "ketidakupayaan untuk memahami sepenuhnya kemanusiaan orang lain, dan penderitaan tingkah laku dan pengalaman yang menunjukkan kekurangan pengiktirafan kemanusiaan."

Kemudian dia bertanya soalan tentang metafora komputer, yang juga merupakan salah satu metafora terpenting dalam semua sains: iaitu, otak manusia adalah komputer, dan komputer adalah otak manusia. Dia memetik kertas kerja Alexis T. Baria dan Keith Cross 2021, idea bahawa "minda manusia mempunyai lebih kuasa daripada yang sepatutnya Kurang kerumitan memberikan komputer lebih kecerdasan daripada yang sepatutnya."

Semasa sesi Soal Jawab selepas ucapan Bender, seorang lelaki botak memakai rantai dan baju polo hitam berjalan ke mikrofon dan menyatakan kebimbangannya, “Ya Soalan yang saya mahu untuk bertanya ialah, mengapa anda memilih kemanusiaan dan kategori manusia ini sebagai rangka kerja untuk anda menyatukan semua idea yang berbeza ini "Lelaki ini tidak fikir manusia adalah istimewa, dan dia berkata, "Dengar cakap kamu? Saya tidak boleh tidak berfikir, anda tahu, sesetengah orang benar-benar buruk, jadi tidak begitu hebat untuk bergabung dengan mereka, kami adalah spesies yang sama, kelas biologi yang sama, tetapi saya gembira untuk disatukan dengan anjing saya."

Dia ingin membezakan antara "manusia dalam erti kata biologi" dan "orang yang patut dihormati dari segi moral." manusia, atau unit”. Beliau mengakui bahawa LLM bukan manusia, sekurang-kurangnya belum, tetapi teknologinya semakin baik. "Saya tertanya-tanya," dia bertanya, "mengapa anda memilih untuk menggunakan manusia atau manusia sebagai peranti pembingkaian untuk memikirkan perkara-perkara yang berbeza ini, dan bolehkah anda mengatakan sedikit lagi tentang itu?" Bender condong sedikit ke kanan, menggigit bibirnya dan mendengar. Apa yang dia boleh katakan? Dia berhujah dari prinsip pertama. "Saya fikir mana-mana manusia

berhak mendapat penghormatan moral tertentu hanya kerana menjadi manusia," katanya "Kami melihat banyak masalah semasa di dunia berkaitan dengan tidak memberikan kemanusiaan kepada manusia, dan lelaki itu." tidak membelinya, dan meneruskan, "Jika saya boleh mengatakan sesuatu dengan cepat, mungkin 100 peratus orang berhak mendapat penghormatan moral tertentu, dan itu bukan kerana makna kewujudan mereka sebagai spesies manusia."8 Adakah istimewa dilahirkan sebagai seorang manusia?

Ramai orang di luar komuniti teknologi juga telah menyatakan perkara ini. Ahli ekologi dan penyokong hak asasi manusia haiwan berpendapat bahawa kita harus meninggalkan idea bahawa kita sangat penting kepada spesies kita. Kita perlu hidup lebih rendah diri. Kita perlu menerima bahawa kita adalah satu di antara makhluk lain, satu di antara jirim. Pokok, sungai, ikan paus, atom, mineral, planet - semuanya penting, dan kami bukan ketua di sini.

Tetapi perjalanan dari model bahasa ke krisis kewujudan memang singkat.

Pada tahun 1966, Joseph Weizenbaum, yang mencipta chatbot pertama ELIZA, menyesalinya sepanjang hayatnya. Dalam bukunya "Kuasa Komputer dan Sebab Manusia," dia menulis bahawa persoalan yang dibangkitkan oleh teknologi ini adalah "pada asasnya tentang tempat manusia di alam semesta".

Mainan ini menyeronokkan, menawan dan ketagihan, yang dia percaya 47 tahun lalu akan menjadi kehancuran kami: “Tidak hairanlah mereka yang bekerja dengan mesin yang percaya bahawa mereka adalah hamba hari demi hari Orang yang hidup bersama setiap hari juga mula percaya bahawa mereka adalah mesin "

Impak krisis iklim adalah jelas. Kami telah mengetahui tentang bahaya selama beberapa dekad, namun kami meneruskan, didorong oleh kapitalisme dan keinginan segelintir. Siapa yang tidak mahu berlepas ke Paris atau Hawaii pada hujung minggu, terutamanya apabila pasukan PR terbaik di dunia memberitahu anda bahawa ia adalah ganjaran terbaik dalam hidup?

Mencipta teknologi yang meniru manusia memerlukan kita mempunyai pemahaman yang sangat jelas tentang siapa kita.

"Mulai sekarang, menggunakan kecerdasan buatan dengan selamat memerlukan penyahmistikan keadaan manusia," Profesor Etika dan Teknologi di Hertie School of Governance di Berlin Joanna Bryson menulis tahun lepas bahawa jika kita lebih tinggi, kita tidak akan menganggap diri kita lebih seperti zirafah. Jadi mengapa kabur tentang kecerdasan?

Yang lain, seperti ahli falsafah Dennett, lebih langsung. Dia berkata bahawa kita tidak boleh hidup dalam dunia dengan apa yang dipanggil "pemalsu".

"Selagi mata wang wujud, pemalsuan telah dilihat sebagai satu tindakan sabotaj terhadap masyarakat. Hukuman termasuk kematian dan suku. Dan membuat pemalsuan sekurang-kurangnya sama seriusnya," dia menambah, sambil menambah bahawa mata wang tiruan Orang sentiasa kurang mendapat keuntungan daripada orang sebenar, yang menjadikan mereka pelakon amoral: "Bukan atas sebab metafizik, tetapi atas sebab fizikal yang mudah — mereka mempunyai sejenis Feel keabadian."

Dennett percaya bahawa pencipta teknologi itu perlu dipertanggungjawabkan, "Mereka harus didakwa secara terbuka jika mereka melakukannya. barangan digunakan untuk mencipta orang palsu, dan jika mereka gagal untuk melakukan itu, mereka berada di ambang mencipta senjata yang sangat serius dan merosakkan kestabilan dan keselamatan sosial. Mereka sepatutnya menjadi seperti ahli biologi molekul "Ini adalah krisis sebenar. Kita perlu "mewujudkan sikap baharu, undang-undang baharu yang tersebar dengan cepat dan menghapuskan pujian yang mengelirukan, memperibadikan," katanya. "Kami memerlukan mesin pintar, bukan rakan sekerja tiruan." aksiom dalam perbualan. Saya tidak fikir saya perlu membuat peraturan sedemikian. Semua yang manusia boleh lakukan, boleh dilakukan dengan lebih baik oleh mesin,” Judith Butler, pengarah pengasas Program Teori Kritikal UC Berkeley, membantu saya menerangkan idea-idea yang terlibat, “Potensi manusia— Ia adalah idea fasisme yang direalisasikan sepenuhnya melalui AI. Impian AI dikuasai oleh "perfeksionisme," yang merupakan satu bentuk fasisme yang kita lihat >Sesetengah orang berkata, "Ya! Bukankah itu hebat!", atau "Bukankah itu menyeronokkan?!", mari kita melupakan idea-idea romantis kita, antroposentrisme, idealisme kita, Butler menambah, "Tetapi persoalan tentang apa yang hidup dalam kata-kata saya, apa yang hidup dalam emosi saya, cinta saya, apa yang hidup dalam bahasa saya, terlupakan."

Sehari selepas Bender memperkenalkan saya kepada asas-asas linguistik, saya menghadiri mesyuarat mingguannya dengan pelajarnya. Mereka berdua sedang mengikuti ijazah dalam linguistik pengiraan, dan mereka berdua melihat apa yang berlaku. Terdapat begitu banyak kemungkinan, begitu banyak kuasa. Untuk apa kita akan menggunakannya?

"Kuncinya adalah untuk mencipta alat yang mudah untuk disambungkan kerana anda boleh menggunakan bahasa semula jadi daripada cuba menjadikannya kelihatan seperti manusia.", Elizabeth Conrad ) terangkan.

Atas ialah kandungan terperinci Refleksi mendalam tentang hak ChatGPT untuk bercakap: Adakah manusia akan kehilangan diri mereka dalam model besar?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI