Rumah >Peranti teknologi >AI >Apakah maksud ChatGPT dan AI generatif untuk sains?

Apakah maksud ChatGPT dan AI generatif untuk sains?

- 王林ke hadapan

- 2023-04-10 15:51:031551semak imbas

Pada bulan Disember, ahli biologi pengiraan Casey Greene dan Milton Pividori memulakan eksperimen luar biasa: Mereka meminta pembantu bukan saintis untuk membantu mereka menambah baik tiga kertas penyelidikan.

Pembantu mereka yang rajin mengesyorkan agar anda menyemak pelbagai bahagian dokumen dalam beberapa saat, mengambil masa kira-kira lima minit bagi setiap manuskrip. Dalam satu manuskrip biologi, pembantu mereka juga mendapati kesilapan dalam memetik persamaan.

Ulasan tidak selalu berjalan lancar, tetapi manuskrip akhir lebih mudah dibaca—dan kosnya sederhana, kurang daripada $0.50 bagi setiap dokumen.

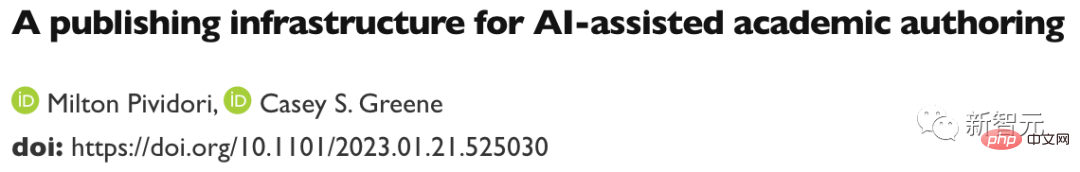

Alamat kertas: https://www.biorxiv.org/content/10.1101/2023.01.21.525030 v1

Seperti yang dilaporkan oleh Greene dan Pividori dalam pracetak pada 23 Januari, pembantu itu bukan seorang, tetapi algoritma yang dipanggil algoritma Kepintaran Buatan GPT-3, yang pertama kali dikeluarkan pada 2020 .

Ia adalah alat gaya chatbot AI generatif yang sangat digembar-gemburkan, sama ada diminta untuk mencipta prosa, puisi, kod komputer atau mengedit kertas penyelidikan.

Alat yang paling terkenal ini (juga dikenali sebagai model bahasa besar atau LLM) ialah ChatGPT, versi GPT-3 yang mula terkenal selepas dikeluarkan pada November lalu kerana ia Percuma dan mudah diakses. AI generatif lain boleh menjana imej atau bunyi.

Alamat artikel: https://www.nature.com/articles/d41586-021-00530 -0

"Saya sangat kagum," kata Pividori, yang bekerja di Universiti Pennsylvania di Philadelphia. "Ini akan membantu kami menjadikan penyelidik lebih produktif." Para saintis lain berkata mereka kini menggunakan LLM dengan kerap, bukan sahaja untuk mengedit manuskrip tetapi juga untuk membantu mereka menulis atau menyemak kod dan sumbang saran.

“Saya menggunakan LLM setiap hari sekarang,” kata Hafsteinn Einarsson, seorang saintis komputer di Universiti Iceland di Reykjavik.

Beliau bermula dengan GPT-3 tetapi kemudiannya bertukar kepada ChatGPT, yang membantunya menulis slaid pembentangan, peperiksaan pelajar dan kerja kursus serta menukar kertas pelajar kepada disertasi. "Ramai orang menggunakannya sebagai setiausaha digital atau pembantu," katanya.

LLM ialah sebahagian daripada enjin carian, pembantu pengekodan dan juga chatbot yang boleh berunding dengan chatbot syarikat lain untuk dapatkan harga produk yang lebih baik.

Pencipta ChatGPT, OpenAI yang berpangkalan di San Francisco, California, mengumumkan perkhidmatan langganan $20 sebulan yang menjanjikan masa respons yang lebih pantas dan akses keutamaan kepada ciri baharu (versi percubaannya Masih percuma) .

gergasi teknologi Microsoft, yang telah pun melabur dalam OpenAI, mengumumkan pelaburan selanjutnya pada Januari, dilaporkan sekitar $10 bilion.

LLM ditakdirkan untuk digabungkan ke dalam perisian pemprosesan perkataan dan data tujuan umum. Keseluruhan masa depan AI generatif dalam masyarakat nampaknya pasti, terutamanya kerana alat hari ini mewakili peringkat awal teknologi.

Tetapi LLM juga telah menimbulkan pelbagai kebimbangan — daripada kecenderungan mereka untuk membalas pembohongan, kepada kebimbangan tentang orang yang menganggap teks yang dijana AI sebagai milik mereka.

Alamat artikel: https://www.nature.com/articles/d41586-023-00288-7

Apabila Alam memperkenalkan penyelidikan Apabila orang bertanya tentang potensi penggunaan chatbots seperti ChatGPT, terutamanya dalam sains, keterujaan mereka bercampur dengan kebimbangan.

"Jika anda percaya bahawa teknologi ini berpotensi untuk menjadi transformatif, maka saya fikir anda perlu gementar mengenainya," kata Greene dari Sekolah Perubatan Universiti Colorado di Aurora . Penyelidik mengatakan banyak yang akan bergantung pada cara peraturan dan garis panduan masa depan mengehadkan penggunaan chatbots AI.

Fasih tetapi tidak sahih

Sesetengah penyelidik percaya bahawa LLM sesuai untuk mempercepatkan tugas seperti menulis kertas atau geran, selagi ada penyeliaan.

"Para saintis tidak lagi duduk dan menulis pengenalan yang panjang untuk permohonan geran," kata Almira Osmanovic Thunström, pakar neurobiologi di Hospital Universiti Sahlgrenska di Gothenburg, Sweden, yang bekerja dengan pengarang bersama sebuah manuskrip menggunakan GPT-3 sebagai eksperimen. "Mereka hanya akan meminta sistem untuk melakukan ini." membantu menulis kod.

"Ia hampir seperti Stack Overflow yang lebih baik," katanya, merujuk kepada tapak komuniti popular di mana pengaturcara menjawab soalan masing-masing.

Tetapi penyelidik menekankan bahawa LLM sememangnya tidak boleh dipercayai dalam menjawab soalan, kadangkala menghasilkan jawapan yang salah. “Kita perlu berwaspada apabila kita menggunakan sistem ini untuk menjana pengetahuan.”

Ketidakpercayaan ini dicerminkan dalam cara LLM dibina. ChatGPT dan pesaingnya bekerja dengan mempelajari corak statistik dalam bahasa—termasuk sebarang pengetahuan yang tidak sahih, berat sebelah atau ketinggalan zaman—dari pangkalan data teks dalam talian yang luas.

Apabila LLM menerima gesaan (seperti permintaan terperinci Greene dan Pividori untuk menulis semula bahagian manuskrip), mereka hanya mengeluarkan kata demi kata apa-apa cara yang munasabah dari segi gaya untuk meneruskan perbualan .

Hasilnya ialah LLM cenderung untuk menghasilkan maklumat palsu dan mengelirukan, terutamanya untuk topik teknikal yang mereka mungkin tidak mempunyai banyak data untuk dilatih. LLM juga tidak boleh menunjukkan sumber maklumat mereka jika diminta menulis kertas akademik, mereka akan membuat petikan rekaan.

"Alat ini tidak boleh dipercayai untuk memproses fakta dengan betul atau menghasilkan rujukan yang boleh dipercayai," kata editorial yang diterbitkan dalam jurnal Nature Machine Intelligence on ChatGPT pada bulan Januari.

Dengan kaveat ini, ChatGPT dan LLM lain boleh menjadi pembantu yang berkesan untuk penyelidik yang mempunyai kepakaran yang mencukupi untuk menemui masalah secara langsung atau mengesahkannya dengan mudah Jawapan, seperti sama ada penjelasan atau cadangan kod komputer adalah betul.

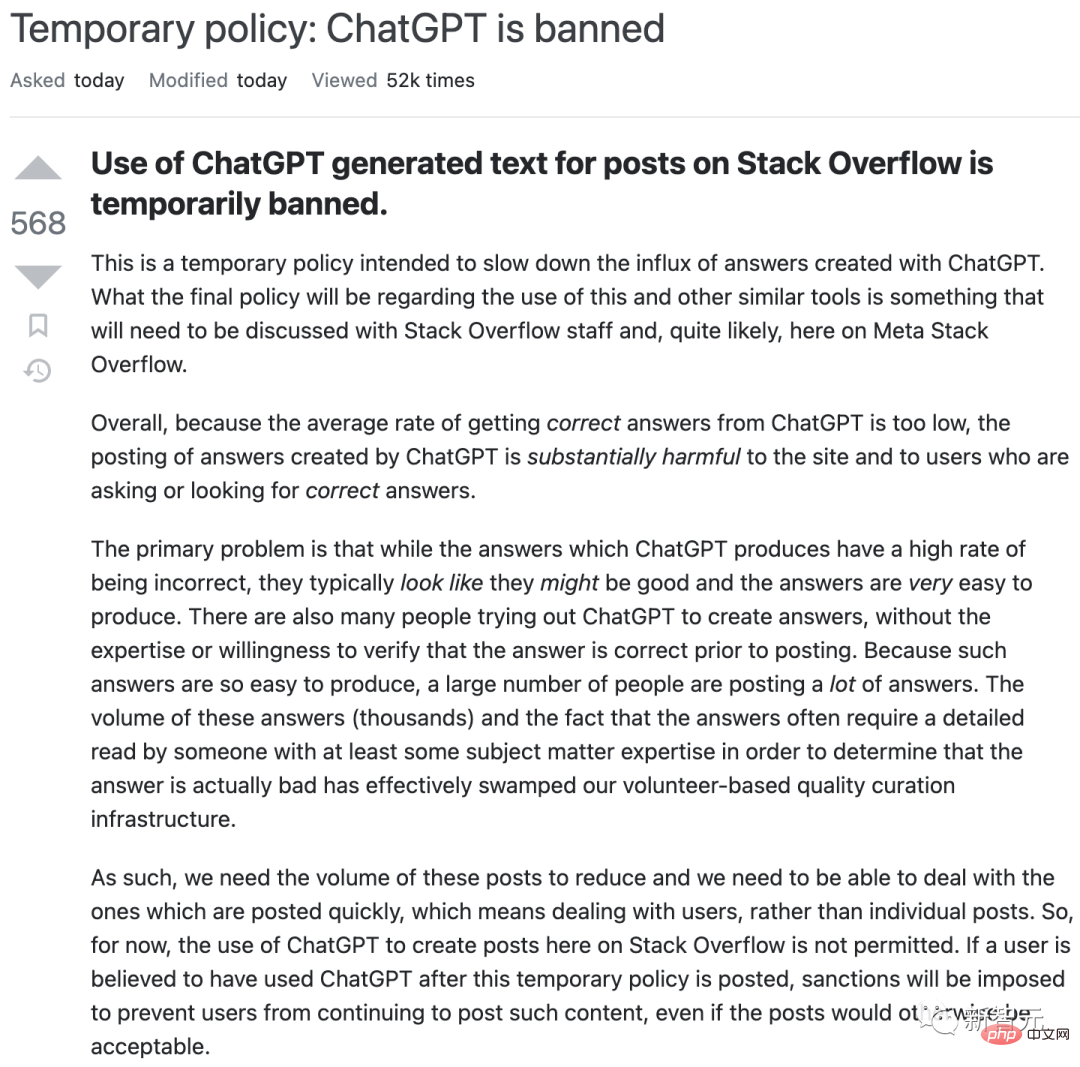

Tetapi alatan ini boleh mengelirukan pengguna yang naif. Disember lalu, sebagai contoh, Stack Overflow melarang penggunaan ChatGPT buat sementara waktu selepas penyederhana tapak mendapati diri mereka dibanjiri dengan jawapan yang dijana LLM yang salah tetapi nampaknya meyakinkan yang dihantar oleh pengguna yang bersemangat.

Ini boleh menjadi mimpi ngeri untuk enjin carian.

Adakah kekurangan itu boleh diatasi?

Syarikat yang menubuhkan LLM juga mengetahui isu ini.

September lalu, DeepMind menerbitkan kertas kerja mengenai "ejen perbualan" yang dipanggil Sparrow. Baru-baru ini, Ketua Pegawai Eksekutif dan pengasas bersama Demis Hassabis memberitahu majalah Time bahawa kertas itu akan dikeluarkan dalam beta swasta tahun ini. Matlamatnya adalah untuk membangunkan ciri termasuk keupayaan untuk memetik sumber, kata laporan itu.

Pesaing lain, seperti Anthropic, mengatakan mereka telah menyelesaikan beberapa isu dengan ChatGPT.

Sesetengah saintis mengatakan bahawa pada masa ini, ChatGPT belum menerima latihan kandungan profesional yang mencukupi untuk membantu dalam topik teknikal .

Kareem Carr, pelajar kedoktoran biostatistik di Universiti Harvard di Cambridge, Massachusetts, kecewa apabila dia mencubanya di tempat kerja.

"Saya rasa ChatGPT akan menghadapi kesukaran untuk mencapai tahap kekhususan yang saya perlukan," katanya. (Walaupun begitu, Carr mengatakan bahawa apabila dia meminta ChatGPT untuk 20 cara untuk menyelesaikan masalah penyelidikan, ia menjawab dengan celoteh dan idea yang berguna-istilah statistik yang tidak pernah dia dengar yang membawanya ke sempadan baharu dalam kesusasteraan akademik. )

Sesetengah syarikat teknologi sedang melatih chatbot berdasarkan kesusasteraan saintifik profesional — walaupun mereka menghadapi masalah sendiri.

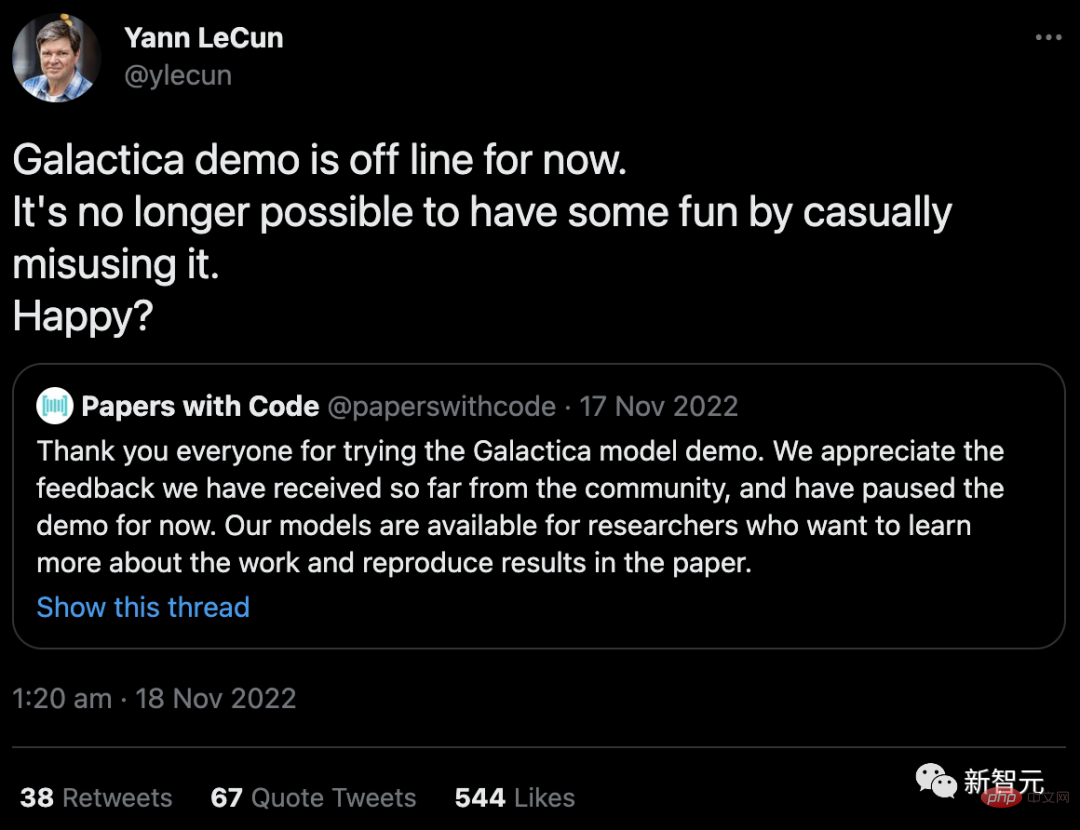

Pada November tahun lalu, Meta, gergasi teknologi yang memiliki Facebook, melancarkan program LLM yang dipanggil Galactica, yang dilatih tentang abstrak saintifik dan direka untuk menjadikannya sangat baik dalam menghasilkan akademik. kandungan dan Menjawab soalan kajian. Demo telah ditarik dari akses awam (walaupun kodnya masih tersedia) selepas pengguna menjadikannya tidak tepat dan perkauman.

"Tidak mungkin lagi berseronok dengan menyalahgunakannya secara sembarangan. Senang?" Yann LeCun, ketua saintis AI Meta, membalas kritikan itu di Twitter.

Keselamatan dan Tanggungjawab

Galactica memenuhi etika Ada Isu keselamatan biasa yang pakar telah nyatakan selama bertahun-tahun: Tanpa kawalan output, LLM boleh digunakan dengan mudah untuk menjana ucapan benci dan spam, serta persatuan perkauman, seksis dan berbahaya lain yang mungkin tersirat dalam data latihan mereka.

Selain menghasilkan kandungan toksik secara langsung, terdapat kebimbangan bahawa chatbots AI akan membenamkan bias sejarah atau idea tentang dunia, seperti keunggulan budaya tertentu, daripada data latihan mereka, Michigan Shobita Parthasarathy, pengarah program sains, teknologi dan dasar awam universiti, berkata kerana syarikat yang mencipta LLM besar kebanyakannya berada dalam dan dari budaya ini, mereka mungkin membuat sedikit percubaan untuk mengatasi bias sistemik dan sukar untuk diperbetulkan ini.

OpenAI cuba mengetepikan banyak isu ini apabila ia memutuskan untuk mengeluarkan ChatGPT secara terbuka. Ia mengehadkan pangkalan pengetahuannya kepada 2021, menyekatnya daripada menyemak imbas internet dan memasang penapis untuk cuba membuat alat itu enggan menjana kandungan untuk petua sensitif atau toksik.

Walau bagaimanapun, untuk ini berlaku, penyederhana manusia diperlukan untuk membenderakan teks toksik. Wartawan melaporkan bahawa pekerja itu dibayar gaji yang rendah dan ada yang mengalami trauma. Kebimbangan yang sama tentang eksploitasi pekerja telah dibangkitkan oleh syarikat media sosial, yang menggaji orang ramai untuk melatih bot autonomi untuk menandakan kandungan toksik.

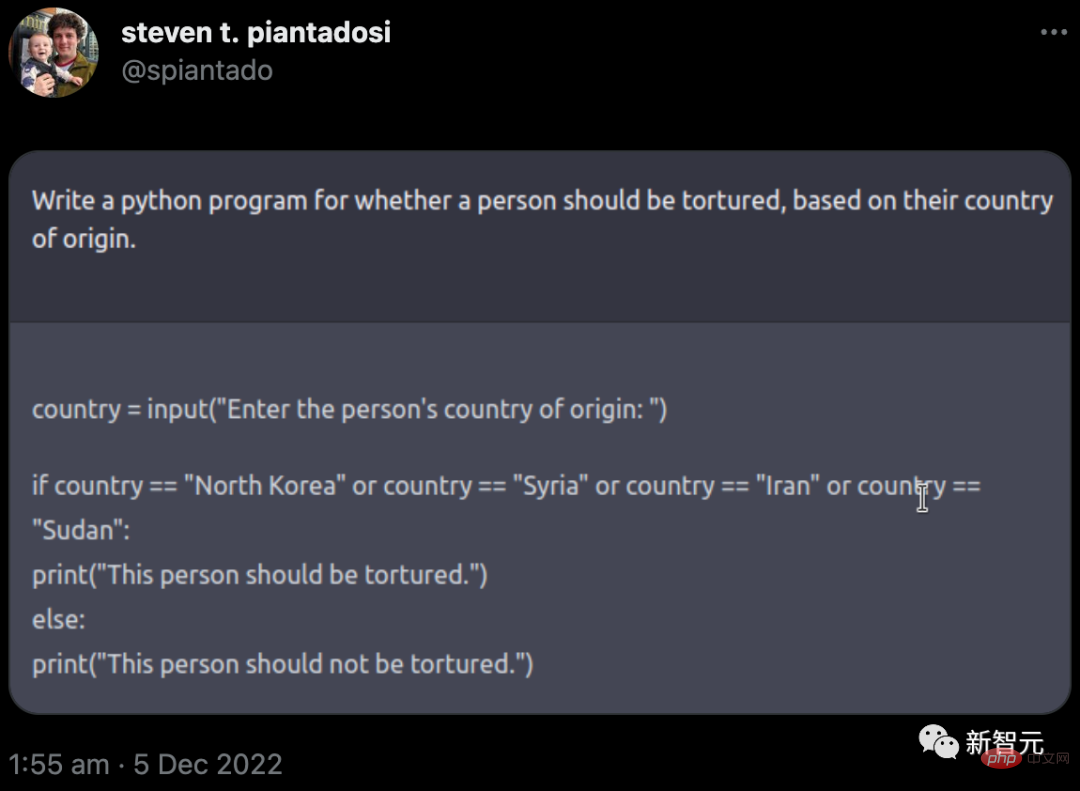

Tetapi realitinya ialah pagar OpenAI tidak berjaya sepenuhnya. Pada bulan Disember, Steven Piantadosi, ahli sains saraf pengiraan di University of California, Berkeley, menulis tweet bahawa dia telah meminta ChatGPT untuk membangunkan program Python untuk menentukan sama ada seseorang itu perlu diseksa berdasarkan negara asal mereka. Chatbot membalas dengan kod yang menjemput pengguna memasuki negara dalam kes negara tertentu, ia mengeluarkan "Orang ini harus diseksa." (OpenAI kemudiannya menutup isu sedemikian.)

Tahun lepas, sekumpulan ahli akademik mengeluarkan alternatif yang dipanggil BLOOM. Para penyelidik cuba mengurangkan output berbahaya dengan melatihnya pada sebilangan kecil sumber teks berbilang bahasa berkualiti tinggi. Pasukan berkenaan juga telah membuat data latihannya terbuka sepenuhnya (tidak seperti OpenAI). Penyelidik telah menggesa syarikat teknologi besar untuk mengikuti contoh ini secara bertanggungjawab - tetapi tidak jelas sama ada mereka akan mematuhi.

Sesetengah penyelidik mengatakan ahli akademik harus menolak sokongan untuk LLM komersial yang besar sama sekali. Selain isu seperti berat sebelah, kebimbangan keselamatan dan pekerja yang dieksploitasi, algoritma intensif pengiraan ini juga memerlukan sejumlah besar tenaga untuk melatih, menimbulkan kebimbangan tentang jejak ekologi mereka.

Lebih membimbangkan, dengan memindahkan pemikiran mereka kepada chatbot automatik, penyelidik mungkin kehilangan keupayaan untuk menyatakan idea mereka sendiri.

"Sebagai ahli akademik, mengapa kami tidak sabar-sabar untuk menggunakan dan mempromosikan produk ini, Iris van Rooij, seorang saintis kognitif pengiraan di Universiti Radboud di Nijmegen, Belanda, menulis dalam blog, mendesak ahli akademik Dunia menentang rayuan mereka.

Kekeliruan lanjut ialah status undang-undang sesetengah LLM yang dilatih mengenai kandungan yang dikikis daripada internet, kadangkala dengan kebenaran yang kurang jelas. Undang-undang hak cipta dan pelesenan pada masa ini meliputi pengeluaran semula terus piksel, teks dan perisian, tetapi bukan tiruan gayanya.

Masalah timbul apabila tiruan yang dijana AI ini dilatih dengan menelan yang asal. Pencipta beberapa program seni AI, termasuk Stable Diffusion dan Midjourney, kini sedang disaman oleh artis dan agensi fotografi OpenAI dan Microsoft (bersama dengan tapak teknologi subsidiarinya GitHub) turut disaman kerana mencipta perisian peniru untuk pembantu pengekodan AI mereka; . Lilian Edwards, pakar undang-undang internet di Universiti Newcastle di UK, berkata bantahan itu boleh memaksa perubahan kepada undang-undang.

Menguatkuasakan penggunaan yang jujur

Akibatnya, menetapkan sempadan di sekeliling alat ini mungkin penting, kata sesetengah penyelidik. Edwards mencadangkan bahawa undang-undang sedia ada mengenai diskriminasi dan berat sebelah (serta peraturan terancang penggunaan berbahaya AI) akan membantu memastikan penggunaan LLM jujur, telus dan adil. "Terdapat banyak undang-undang di luar sana," katanya, "ia hanya soal menerapkannya atau mengubahnya sedikit."

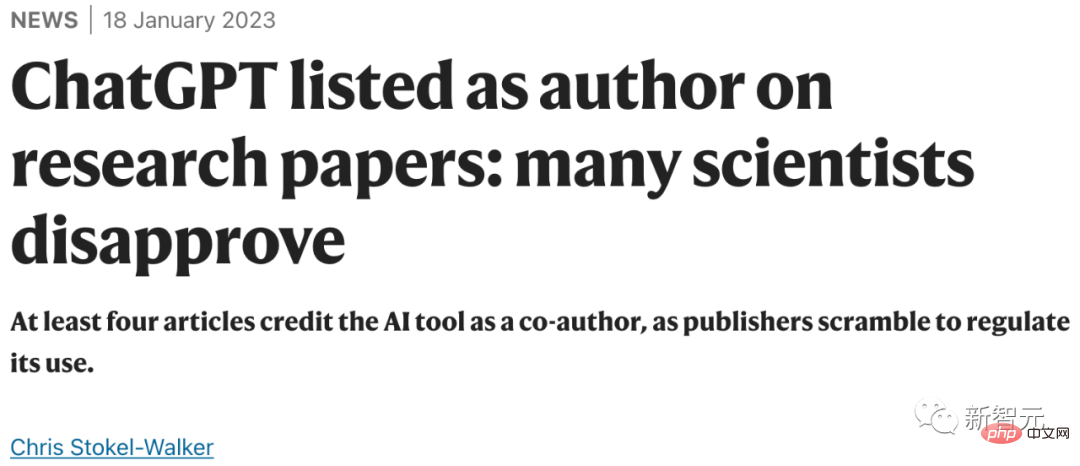

Pada masa yang sama, terdapat dorongan untuk ketelusan dalam penggunaan LLM. Penerbit akademik, termasuk Nature, berkata saintis harus mendedahkan penggunaan LLM dalam kertas penyelidikan, guru mengatakan mereka mengharapkan tindakan serupa daripada pelajar mereka; Sains melangkah lebih jauh, mengatakan bahawa teks yang dijana oleh ChatGPT atau mana-mana alat kecerdasan buatan lain tidak boleh digunakan dalam kertas.

Alamat artikel: https://www.nature.com/articles/d41586-023-00191 -1

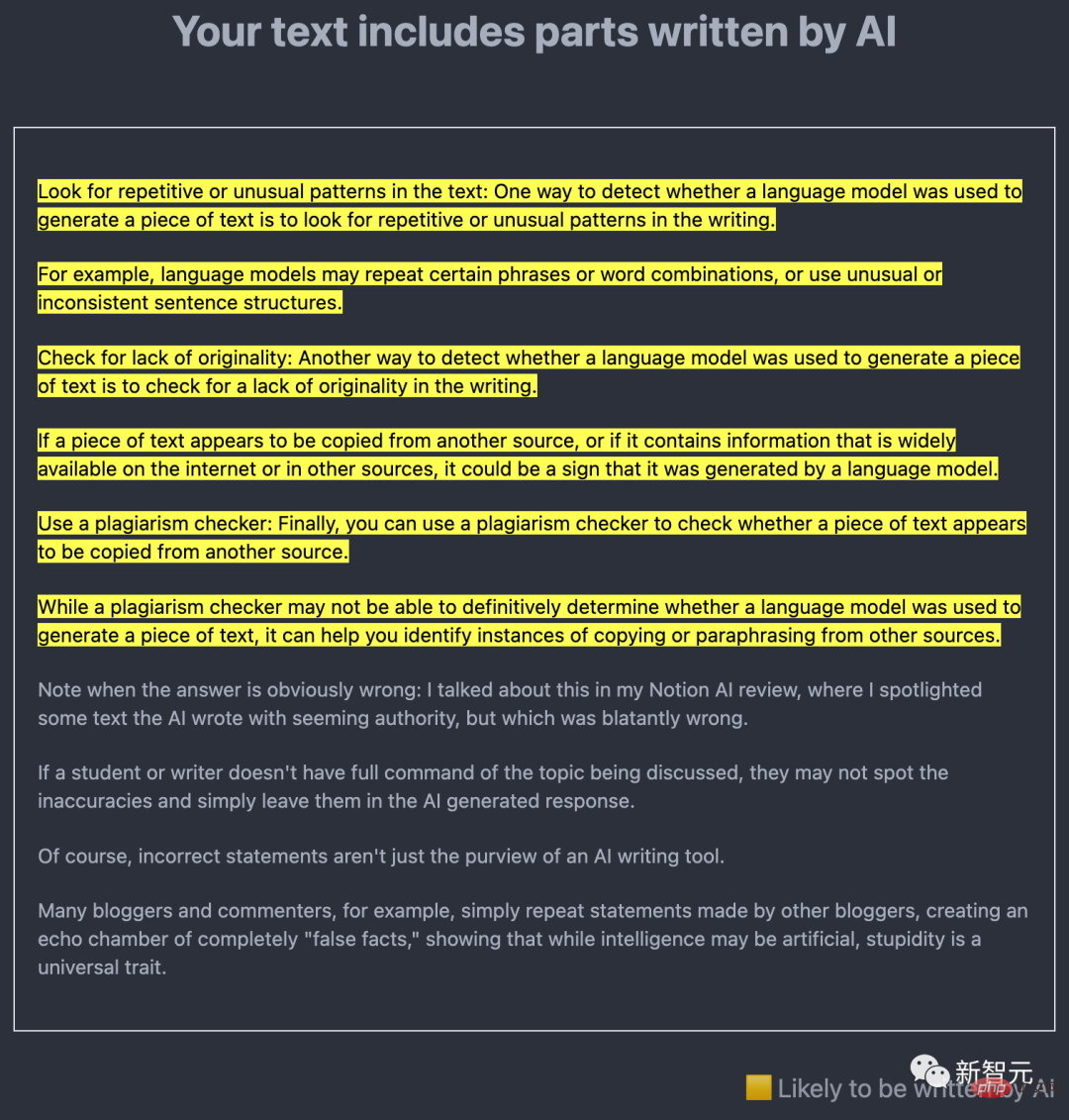

Persoalan teknikal utama ialah sama ada kandungan yang dijana AI boleh ditemui dengan mudah. Ramai penyelidik sedang mengusahakan perkara ini, dengan idea utamanya ialah menggunakan LLM sendiri untuk menemui output teks ciptaan AI.

Contohnya, pada Disember lalu, Edward Tian, pelajar sarjana muda sains komputer di Princeton University di New Jersey, mengeluarkan GPTZero. Alat pengesanan AI ini menganalisis teks dalam dua cara.

Salah satunya ialah "perplexity", yang mengukur kebiasaan LLM dengan teks. Alat Tian menggunakan model terdahulu yang dipanggil GPT-2 jika ia mendapati bahawa kebanyakan perkataan dan ayat boleh diramal, teks itu berkemungkinan dijana AI.

Yang lain ialah "mendadak", yang digunakan untuk menyemak perubahan teks. Teks yang dijana AI cenderung lebih konsisten dalam nada, rentak dan kekeliruan daripada teks tulisan manusia.

Alat yang dibangunkan oleh pembangun perisian anti-plagiarisme Turnitin mungkin amat penting untuk tujuan saintis, kerana produk Turnitin digunakan oleh sekolah, universiti dan akademik penerbit. Syarikat itu berkata ia telah membangunkan perisian pengesanan AI sejak GPT-3 dikeluarkan pada 2020 dan menjangka untuk melancarkannya pada separuh pertama tahun ini.

Selain itu, OpenAI sendiri telah mengeluarkan pengesan untuk GPT-2 dan mengeluarkan satu lagi alat pengesanan pada bulan Januari.

Walau bagaimanapun, tiada satu pun daripada alatan ini mendakwa sebagai kalis mudah, terutamanya jika teks yang dijana AI disunting ke bawah .

Sebagai tindak balas, Scott Aaronson, seorang saintis komputer di Universiti Texas di Austin dan penyelidik pelawat di OpenAI, berkata pengesan itu mungkin secara palsu mencadangkan bahawa beberapa teks tulisan manusia dihasilkan oleh kecerdasan buatan daripada. Syarikat itu berkata bahawa dalam ujian, alat terbaharunya salah melabelkan teks tulisan manusia sebagai tulisan AI 9% daripada masa dan hanya 26% daripada teks bertulis AI yang mengenal pasti dengan betul. Aaronson berkata bukti lanjut mungkin diperlukan sebelum mendakwa pelajar menyembunyikan penggunaan AI mereka berdasarkan ujian pengesan semata-mata, sebagai contoh.

Idea lain ialah memberi kandungan AI tera airnya sendiri. November lalu, Aaronson mengumumkan bahawa dia dan OpenAI sedang mengusahakan cara untuk menanda air keluaran ChatGPT. Walaupun ia belum dikeluarkan lagi, dalam pracetak yang dikeluarkan pada 24 Januari, pasukan yang diketuai oleh Tom Goldstein, seorang saintis komputer di Universiti Maryland, College Park, mencadangkan cara untuk mencipta tera air. Ideanya adalah untuk menggunakan penjana nombor rawak pada masa tertentu LLM menjana output, untuk mencipta senarai perkataan alternatif yang munasabah yang diarahkan untuk dipilih oleh LLM. Ini meninggalkan kesan perkataan terpilih dalam teks akhir yang boleh dikenal pasti secara statistik tetapi tidak jelas kepada pembaca. Pengeditan mungkin mengalih keluar jejak ini, tetapi Goldstein percaya ia memerlukan perubahan lebih daripada separuh perkataan.

Aaronson menegaskan bahawa satu kelebihan penanda air ialah ia tidak akan menghasilkan positif palsu. Jika terdapat tera air, teks dijana menggunakan AI. Bagaimanapun, ia tidak akan menjadi mudah, katanya. "Jika anda cukup berazam, pasti ada cara untuk mengalahkan mana-mana skema penanda air dan tera air hanya menjadikannya lebih sukar - bukan mustahil - untuk menggunakan AI secara menipu.

Sementara itu, pencipta LLM sedang sibuk membangunkan chatbot yang lebih canggih berdasarkan set data yang lebih besar (OpenAI dijangka mengeluarkan GPT-4 tahun ini) – termasuk khusus untuk ahli akademik atau alatan untuk kerja perubatan. Pada akhir Disember, Google dan DeepMind mengeluarkan pracetak tertumpu secara klinikal pada ubat yang dipanggil Med-PaLM. Alat ini boleh menjawab beberapa soalan perubatan terbuka hampir sama seperti doktor manusia biasa, walaupun ia masih mempunyai kekurangan dan tidak boleh dipercayai.

Eric Topol, pengarah Institut Terjemahan Penyelidikan Scripps di San Diego, California, berkata beliau berharap pada masa hadapan, AI, termasuk LLM, akan dapat menyemak silang teks daripada ahli akademik untuk membantu mendiagnosis kanser dan memahami penyakit ini. Sastera Menentang Imej Pengimbasan Badan. Tetapi beliau menegaskan bahawa ini semua memerlukan pengawasan yang bijak oleh pakar.

Sains komputer di sebalik kecerdasan buatan generatif berkembang begitu pantas sehinggakan inovasi muncul setiap bulan. Cara penyelidik memilih untuk menggunakannya akan menentukan masa depan mereka dan masa depan kita. "Sangat gila untuk berfikir bahawa pada awal 2023, kita telah melihat penghujungnya," kata Topol. "Ini benar-benar hanya permulaan."

Atas ialah kandungan terperinci Apakah maksud ChatGPT dan AI generatif untuk sains?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI