Rumah >Peranti teknologi >AI >Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

- 王林ke hadapan

- 2023-04-10 10:21:081782semak imbas

Dalam beberapa tahun kebelakangan ini, pembelajaran multimodal telah mendapat banyak perhatian, terutamanya dalam dua arah sintesis imej teks dan pembelajaran kontrastif teks imej. Sesetengah model AI telah menarik perhatian umum kerana aplikasinya dalam penjanaan dan penyuntingan imej kreatif, seperti model imej teks DALL・E dan DALL-E 2 yang dilancarkan oleh OpenAI, dan GauGAN dan GauGAN2 NVIDIA.

Tidak ketinggalan, Google mengeluarkan model teks-ke-imej sendiri Imagen pada penghujung Mei, yang nampaknya memperluaskan lagi sempadan penjanaan imej bersyarat kapsyen.

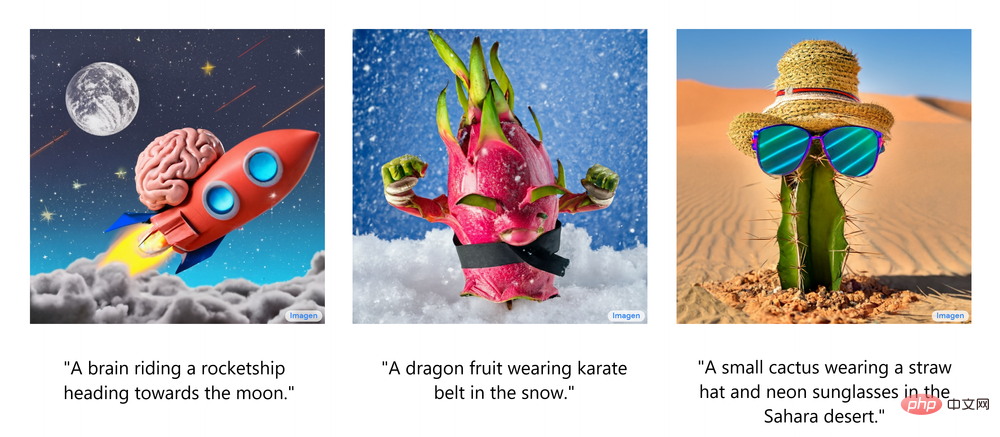

Memandangkan hanya perihalan adegan, Imagen menghasilkan imej yang berkualiti tinggi dan beresolusi tinggi, tidak kira sama ada pemandangan itu masuk akal di dunia nyata. Rajah berikut menunjukkan beberapa contoh imej yang dihasilkan teks Imagen, dengan sari kata yang sepadan dipaparkan di bawah imej.

Imej terjana yang mengagumkan ini membuatkan anda tertanya-tanya: Bagaimanakah Imagen berfungsi?

Baru-baru ini, pensyarah pemaju Ryan O'Connor menulis artikel panjang "Bagaimana Imagen Sebenarnya Berfungsi" di blog AssemblyAI, menerangkan secara terperinci prinsip kerja Imagen, memberikan gambaran keseluruhan Imagen, menganalisis dan memahaminya High- komponen tahap dan hubungan antara mereka.

Ikhtisar prinsip kerja Imagen

Dalam bahagian ini, penulis menunjukkan seni bina keseluruhan Imagen dan memberikan penjelasan peringkat tinggi tentang prinsip kerja lain dan kemudian menganalisis setiap Imagen dengan lebih lanjut; teliti pula komponen. Animasi berikut menunjukkan aliran kerja Imagen.

Pertama, suapkan sari kata ke dalam pengekod teks . Pengekod ini menukar sari kata teks kepada perwakilan berangka yang merangkum maklumat semantik dalam teks. Pengekod teks dalam Imagen ialah pengekod Transformer, yang memastikan pengekodan teks memahami cara perkataan dalam sari kata berkaitan antara satu sama lain, menggunakan kaedah perhatian diri.

Jika Imagen hanya memfokuskan pada perkataan individu dan bukannya perkaitan di antara mereka, walaupun imej berkualiti tinggi yang mampu menangkap elemen individu sari kata boleh diperolehi, imej ini tidak boleh dihuraikan dengan cara yang sesuai yang mencerminkan semantik sari kata. Seperti yang ditunjukkan dalam contoh di bawah, jika perkaitan antara perkataan tidak dipertimbangkan, kesan penjanaan yang sama sekali berbeza akan berlaku.

Walaupun pengekod teks menghasilkan perwakilan yang berguna untuk input sari kata Imagen, kaedah masih perlu direka untuk menjana imej yang menggunakan perwakilan ini, iaitu Penjana Imej . Untuk melakukan ini, Imagen menggunakan model resapan , model generatif yang telah mendapat populariti dalam beberapa tahun kebelakangan ini berkat prestasi SOTAnya pada pelbagai tugas.

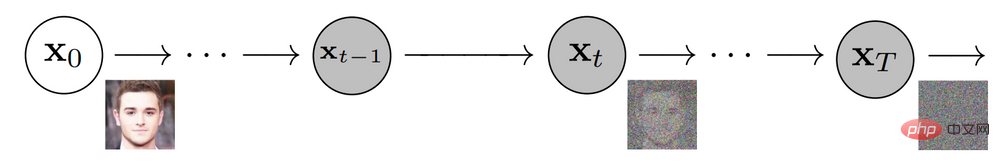

Model penyebaran merosakkan data latihan dengan menambahkan hingar untuk mencapai latihan, dan kemudian belajar memulihkan data dengan membalikkan proses hingar ini. Memandangkan imej input, model resapan akan merosakkan imej secara berulang dengan hingar Gaussian sepanjang beberapa langkah masa, akhirnya meninggalkan hingar Gaussian atau TV statik. Rajah berikut menunjukkan proses hingar berulang model resapan:

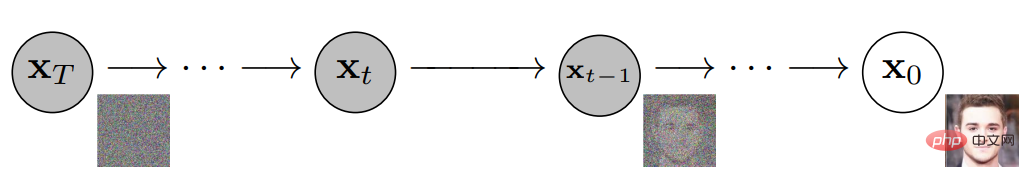

Model resapan kemudiannya akan berfungsi ke belakang, mempelajari cara mengasingkan dan menghapuskan hingar pada setiap langkah masa, membatalkan keluar apa yang baru berlaku proses pemusnahan. Selepas latihan selesai, model boleh dibahagikan kepada dua. Ini membolehkan anda bermula dengan pensampelan secara rawak bunyi Gaussian dan denoise secara beransur-ansur menggunakan model resapan untuk menjana imej, seperti ditunjukkan di bawah:

Ringkasnya, model resapan terlatih bermula dengan hingar Gaussian dan kemudian secara berulang menjana imej yang serupa dengan imej latihan. Jelas sekali bahawa tiada cara untuk mengawal output sebenar imej, hanya suapkan bunyi Gaussian ke dalam model dan ia akan mengeluarkan imej rawak yang kelihatan seperti ia tergolong dalam set data latihan.

Walau bagaimanapun, matlamatnya adalah untuk mencipta imej yang merangkumi maklumat semantik input sari kata kepada Imagen, jadi cara untuk memasukkan sari kata ke dalam proses penyebaran diperlukan. Bagaimana untuk melakukan ini?

Seperti yang dinyatakan di atas, pengekod teks menghasilkan pengekodan sari kata wakil, yang sebenarnya merupakan jujukan vektor. Untuk menyuntik maklumat yang dikodkan ini ke dalam model resapan, vektor ini diagregatkan bersama dan model resapan dilaraskan berdasarkannya. Dengan melaraskan vektor ini, model resapan mempelajari cara melaraskan proses denoisingnya untuk menghasilkan imej yang sepadan dengan sari kata dengan baik. Visualisasi proses kelihatan seperti ini:

Memandangkan penjana imej atau model asas mengeluarkan imej 64x64 yang kecil, untuk menambah sampel model ini kepada versi 1024x1024 terakhir, Tambah imej secara bijak menggunakan model peleraian super.

Untuk model peleraian super, Imagen sekali lagi menggunakan model resapan. Proses keseluruhan pada asasnya adalah sama dengan model asas, kecuali ia dilaraskan berdasarkan pengekodan sari kata semata-mata, tetapi juga dengan imej yang lebih kecil dijadikan sampel. Visualisasi keseluruhan proses adalah seperti berikut:

Output model resolusi super ini sebenarnya bukan output akhir, tetapi imej bersaiz sederhana. Untuk menaikkan skala imej ini kepada resolusi 1024x1024 terakhir, model peleraian super lain digunakan. Kedua-dua seni bina resolusi super adalah lebih kurang sama, jadi ia tidak akan diterangkan lagi. Output model resolusi super kedua ialah output akhir Imagen.

Mengapa Imagen lebih baik daripada DALL-E 2?

Menjawab dengan tepat mengapa Imagen lebih baik daripada DALL-E 2 adalah sukar. Walau bagaimanapun, sebahagian besar jurang prestasi berpunca daripada perbezaan sari kata dan isyarat. DALL-E 2 menggunakan sasaran yang berbeza untuk menentukan sejauh mana pengekodan teks berkaitan dengan imej (pada asasnya CLIP). Pengekod teks dan imej melaraskan parameternya supaya persamaan kosinus pasangan imej sari kata yang serupa dimaksimumkan, manakala persamaan kosinus pasangan imej sari kata yang tidak serupa diminimumkan.

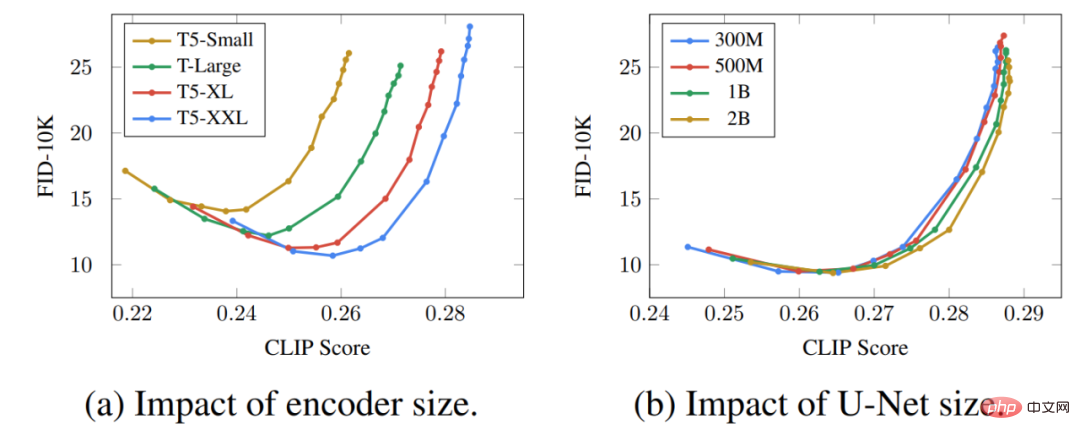

Sebahagian besar jurang prestasi berpunca daripada fakta bahawa pengekod teks Imagen jauh lebih besar dan terlatih pada lebih banyak data berbanding pengekod teks DALL-E 2. Sebagai bukti untuk hipotesis ini, kita boleh memeriksa prestasi Imagen apabila pengekod teks berskala. Berikut ialah keluk Pareto untuk prestasi Imagen:

Kesan peningkatan pengekod teks adalah sangat tinggi, manakala kesan peningkatan skala U-Net adalah sangat rendah. Keputusan ini menunjukkan bahawa model resapan yang agak mudah boleh menghasilkan hasil yang berkualiti tinggi selagi ia dikondisikan pada pengekodan yang kuat.

Memandangkan pengekod teks T5 jauh lebih besar daripada pengekod teks CLIP, ditambah pula dengan fakta bahawa data latihan bahasa semula jadi semestinya lebih kaya daripada pasangan kapsyen imej, banyak jurang prestasi berkemungkinan disebabkan oleh perbezaan ini .

Selain itu, pengarang juga menyenaraikan beberapa perkara utama Imagen, termasuk yang berikut:

- Menskalakan pengekod teks sangat cekap;

- Menskalakan pengekod teks adalah lebih penting daripada menskalakan saiz U-Net; 🎜>Peningkatan keadaan hingar adalah penting dalam model resolusi super;

- Menggunakan perhatian silang untuk penyesuaian teks adalah penting;

- Cerapan ini memberikan hala tuju berharga kepada penyelidik yang mengusahakan model resapan yang bukan sahaja berguna dalam subbidang teks ke imej.

Atas ialah kandungan terperinci Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI