Rumah >Peranti teknologi >AI >Selepas bermain lebih daripada 300 kali dalam masa empat minit, Google mengajar robotnya bermain pingpong

Selepas bermain lebih daripada 300 kali dalam masa empat minit, Google mengajar robotnya bermain pingpong

- 王林ke hadapan

- 2023-04-10 09:11:031646semak imbas

Biarkan peminat tenis meja bermain menentang robot Berdasarkan arah aliran pembangunan robot, memang sukar untuk mengatakan siapa yang akan menang dan siapa yang akan kalah.

Robot ini mempunyai kebolehgerakan yang cekap, pergerakan kaki yang fleksibel, dan keupayaan menggenggam yang sangat baik... dan telah digunakan secara meluas dalam pelbagai tugas yang mencabar. Tetapi bagaimanakah robot melakukan tugasan yang melibatkan interaksi rapat dengan manusia? Ambil tenis meja sebagai contoh Ini memerlukan kerjasama yang tinggi daripada kedua-dua pihak, dan bola bergerak dengan sangat pantas, yang menimbulkan cabaran besar kepada algoritma.

Dalam pingpong, perkara yang paling penting ialah kelajuan dan ketepatan, yang meletakkan permintaan tinggi pada algoritma pembelajaran. Pada masa yang sama, sukan ini mempunyai dua ciri utama: sangat berstruktur (dengan persekitaran yang tetap dan boleh diramal) dan kerjasama pelbagai ejen (robot boleh bertarung dengan manusia atau robot lain), menjadikannya tempat yang ideal untuk mengkaji interaksi manusia-komputer dan pembelajaran pengukuhan. Platform eksperimen yang ideal untuk masalah.

Pasukan penyelidik robotik daripada Google telah membina platform sedemikian untuk mengkaji masalah yang dihadapi oleh pembelajaran robot dalam persekitaran berbilang orang, dinamik dan interaktif. Google juga menulis blog khas untuk tujuan ini untuk memperkenalkan dua projek yang telah mereka pelajari, Iterative-Sim2Real (i-S2R) dan GoalsEye. i-S2R membolehkan bot bermain lebih 300 perlawanan dengan pemain manusia, manakala GoalsEye membolehkan bot mempelajari beberapa strategi berguna (strategi bersyarat matlamat) daripada amatur.

Strategi i-S2R membolehkan robot bermain menentang manusia Walaupun cengkaman robot tidak kelihatan sangat profesional, ia tidak akan terlepas bola:

<.>

Anda datang dan saya pergi, perkara yang hampir sama, rasanya seperti bermain bola berkualiti tinggi.

Strategi GoalsEye boleh mengembalikan bola ke kedudukan yang ditetapkan di atas meja, sama seperti memukulnya di mana-mana sahaja anda menghalakannya:

Dalam projek ini, robot bertujuan untuk belajar bekerjasama dengan manusia, iaitu bermain sparring dengan manusia selama lama yang boleh. Memandangkan latihan secara langsung terhadap pemain manusia adalah membosankan dan memakan masa, Google menggunakan pendekatan berasaskan simulasi. Walau bagaimanapun, ini menghadapi masalah baharu Adalah sukar bagi kaedah berasaskan simulasi untuk mensimulasikan tingkah laku manusia, tugas interaksi gelung tertutup, dsb.

Dalam i-S2R, Google mencadangkan model yang boleh mempelajari tingkah laku manusia dalam tugasan interaksi manusia-komputer dan mewujudkannya pada platform pingpong robot. Google telah membina sistem yang boleh mencapai sehingga 340 balingan pemukul dengan pemain manusia amatur (ditunjukkan di bawah).

Manusia dan robot bertarung selama 4 minit, sehingga 340 kali

Belajar Manusia model tingkah lakuMembenarkan robot mempelajari tingkah laku manusia dengan tepat juga menghadapi masalah berikut: Jika tidak ada strategi robot yang cukup baik dari awal, adalah mustahil untuk mengumpul data berkualiti tinggi tentang cara manusia berinteraksi dengan robot. Tetapi tanpa model tingkah laku manusia, strategi robot tidak boleh diperolehi dari awal masalah ini agak berbelit-belit, seperti mana yang pertama, ayam atau telur. Satu pendekatan adalah untuk melatih dasar robot secara langsung di dunia nyata, tetapi ini selalunya lambat, mahal dan menimbulkan cabaran berkaitan keselamatan yang lebih teruk apabila manusia terlibat.

Seperti yang ditunjukkan dalam rajah di bawah, i-S2R menggunakan model tingkah laku manusia yang ringkas sebagai anggaran titik permulaan dan berselang-seli antara latihan simulasi dan penggunaan dunia sebenar. Dalam setiap lelaran, model dan strategi tingkah laku manusia disesuaikan.

Kaedah i-S2R

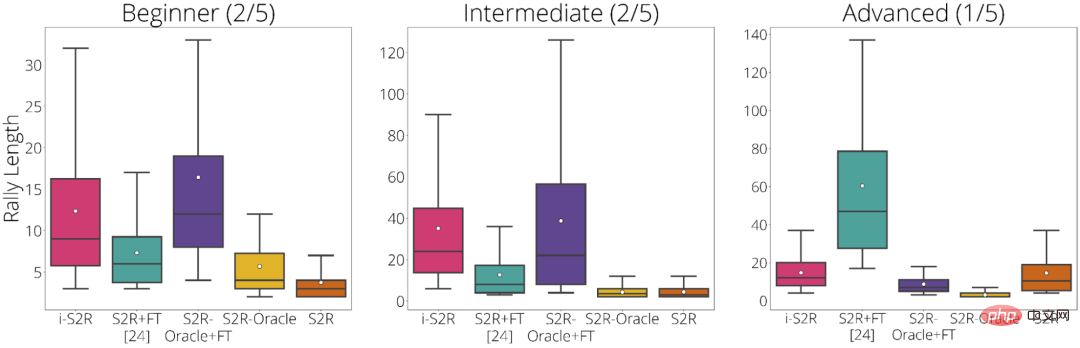

Google memecahkan keputusan percubaan berdasarkan jenis pemain: Pemula (40% pemain), Pertengahan (40% pemain) dan Lanjutan (20% pemain). Daripada keputusan percubaan, i-S2R menunjukkan prestasi yang lebih baik daripada S2R+FT (sim-to-real ditambah penalaan halus) untuk pemain pemula dan pertengahan (80% daripada pemain).

hasil i-S2R mengikut jenis pemain

GoalsEye: Tekan lokasi yang ditetapkan dengan tepat

Dalam GoalsEye, Google turut menunjukkan kaedah yang menggabungkan teknik pengklonan tingkah laku untuk mempelajari strategi penyasaran yang tepat .

Di sini Google memfokuskan pada ketepatan pingpong mereka berharap robot itu dapat memulangkan bola dengan tepat ke mana-mana kedudukan yang ditetapkan di atas meja, seperti yang ditunjukkan dalam rajah di bawah. Untuk mencapai kesan berikut, mereka juga menggunakan LFP (Pembelajaran dari Bermain) dan GCSL (Pembelajaran Terselia Bersyarat Matlamat).

Strategi GoalsEye menyasarkan bulatan berdiameter 20cm (kiri). Pemain manusia boleh menyasarkan matlamat yang sama (kanan)

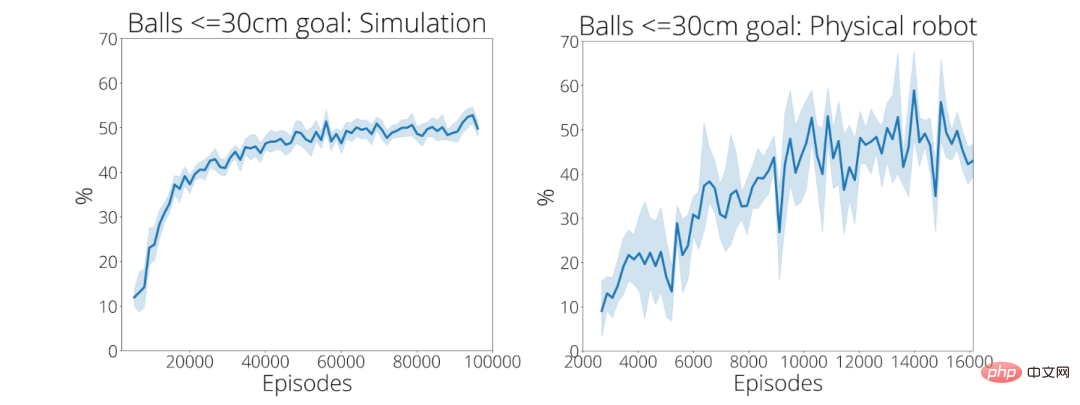

Dalam 2480 demo pertama, strategi latihan Google hanya berfungsi 9% daripada masa dengan Tepat memukul sasaran bulat dengan jejari 30 cm. Selepas kira-kira 13,500 demonstrasi, ketepatan bola mencapai sasarannya meningkat kepada 43 peratus (kanan bawah).

Untuk pengenalan lanjut kepada kedua-dua projek ini, sila rujuk pautan berikut:

- Iterative-Sim2Real Homepage: https://sites.google.com/view/is2r

- GoalsEye Homepage: https://sites.google.com /view/goals-eye

Atas ialah kandungan terperinci Selepas bermain lebih daripada 300 kali dalam masa empat minit, Google mengajar robotnya bermain pingpong. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI