Rumah >Peranti teknologi >AI >Peminat dan Fikiran tentang Syarikat Besar Membelanjakan Wang untuk Mengejar Model AI Besar

Peminat dan Fikiran tentang Syarikat Besar Membelanjakan Wang untuk Mengejar Model AI Besar

- 王林ke hadapan

- 2023-04-09 23:51:011040semak imbas

Artikel ini diterbitkan semula daripada Lei Feng.com Jika anda perlu mencetak semula, sila pergi ke tapak web rasmi Lei Feng.com untuk memohon kebenaran.

Pernahkah anda semua mendengar cerita kipas elektrik dan pinggan sabun yang kosong?

Khabarnya pengeluar barangan pengguna terkenal antarabangsa yang bergerak pantas pernah memperkenalkan barisan pengeluaran pembungkusan sabun Didapati bahawa barisan pengeluaran ini mempunyai kecacatan dalam proses pembungkusan sabun, iaitu, sering terdapat kotak yang tidak dimuatkan. Mereka tidak dapat menjual kotak kosong kepada pelanggan, jadi mereka mengupah rakan pasca doktoral dalam automasi untuk mereka bentuk rancangan untuk mengisih kotak sabun kosong.

Felo pasca doktoral segera memanggil pasukan teknikal lebih daripada sepuluh orang, menggunakan gabungan jentera, automasi, mikroelektronik, pengesanan sinar-X dan teknologi lain, membelanjakan 900,000, dan akhirnya berjaya dibangunkan Penyelesaian ialah memasang dua pengesan bersepadu pada kedua-dua belah barisan pengeluaran Setiap kali kotak sabun kosong dikesan lewat, robot akan didorong untuk menolak kotak sabun kosong itu.

Boleh dikatakan ini adalah satu kejayaan penting bagi pelaksanaan teknologi untuk menyelesaikan masalah industri sebenar.

Secara kebetulan, pada masa yang sama, sebuah perusahaan perbandaran di selatan China juga membeli barisan pengeluaran yang sama. Apabila bos menemui masalah ini, dia sangat marah Dia memanggil seorang pekerja ke kilang dan berkata, "Mari dan fikirkan cara untuk menyelesaikan masalah ini, di bawah tekanan, pekerja itu dengan cepat membuat rancangan yang bijak 190 yuan Saya membeli kipas elektrik berkuasa tinggi dan meletakkannya di sebelah barisan pengeluaran pembungkusan sabun Sebaik sahaja barisan pengeluaran berpusing, ia mula bertiup dengan kuat Sebaik sahaja kotak sabun kosong muncul, ia diterbangkan.

Seorang pekerja kecil, dengan kreativiti yang bijak, dengan cepat menyelesaikan masalah ini dan mencapai matlamat besar yang sering diperhatikan dalam industri: mengurangkan kos dan meningkatkan kecekapan.

Maksud inovasi teknologi dan kecerdasan dalam industri tidak lebih daripada dua slogan ini: satu adalah untuk menjimatkan wang, dan satu lagi adalah untuk meningkatkan kecekapan. Walau bagaimanapun, dalam pembangunan AI dalam beberapa tahun kebelakangan ini, terdapat fenomena "pelik" yang seolah-olah melanggar undang-undang modal: sama ada akademia atau industri, sama ada syarikat besar atau syarikat kecil, sama ada sebuah perusahaan swasta atau penyelidikan yang dibiayai oleh kerajaan Institut semuanya membelanjakan banyak wang untuk "memurnikan" model besar.

Mengarahkan kepada dua suara dalam bulatan:

Satu suara mengatakan bahawa model besar telah menunjukkan prestasi yang kukuh pada pelbagai penanda aras tugas Prestasi dan potensi mesti menjadi hala tuju pembangunan kecerdasan buatan pada masa akan datang Pelaburan pada masa ini adalah untuk mempersiapkan diri untuk tidak melepaskan peluang besar pada masa depan Adalah berbaloi untuk melabur berjuta-juta (atau lebih) dalam latihan. Dalam erti kata lain, merebut kedudukan tinggi model besar adalah percanggahan utama, dan pelaburan kos tinggi adalah percanggahan sekunder.

Suara lain mengatakan bahawa dalam proses sebenar pelaksanaan teknologi AI, gembar-gembur komprehensif semasa model besar bukan sahaja merompak sumber penyelidikan model kecil dan hala tuju AI lain, tetapi juga disebabkan oleh The kos pelaburan adalah tinggi, keberkesanan kos adalah rendah dalam menyelesaikan masalah industri sebenar, dan ia tidak dapat memberi manfaat kepada lebih banyak perusahaan kecil dan sederhana dalam konteks transformasi digital.

Dalam erti kata lain, "ketersediaan ekonomi" dan "berkuasa atau tidak" membentuk dua fokus utama algoritma AI dalam menyelesaikan masalah praktikal. Hari ini, industri telah mencapai kata sepakat: pada masa hadapan, AI akan menjadi "kuasa" yang memperkasakan semua lapisan masyarakat. Jadi, dari perspektif pelaksanaan AI berskala besar, yang manakah lebih baik, model besar atau model kecil? Adakah industri benar-benar memikirkannya?

1 Ketibaan model "besar"

Dalam beberapa tahun kebelakangan ini, antara suara syarikat teknologi utama dalam dan luar negara yang mempublikasikan keupayaan R&D AI mereka, sentiasa ada satu frekuensi tinggi muncul: Model Besar.

Pertandingan ini bermula dengan gergasi teknologi asing. Pada 2018, Google melancarkan model bahasa pra-latihan berskala besar BERT Selepas membuka tirai pada model besar, OpenAI melancarkan GPT-2 dan GPT-3 pada 2019 dan 2020, Google tidak ketinggalan, melancarkan bilangan parameter yang sangat besar. "Kebesaran" model merujuk kepada sejumlah besar parameter.

Sebagai contoh, bilangan parameter BERT mencecah 300 juta buat kali pertama pada 2018, mengatasi manusia dalam dua ukuran ujian kefahaman bacaan mesin peringkat atas SQuAD1.1, dan mengatasi manusia dalam semua aspek. Mencapai prestasi SOTA dalam 11 ujian NLP yang berbeza, termasuk menolak penanda aras GLUE kepada 80.4% (peningkatan mutlak 7.6%), ketepatan MultiNLI mencapai 86.7% (peningkatan mutlak 5.6%), menunjukkan kesan peningkatan dalam parameter saiz pada algoritma AI Kuasa peningkatan prestasi.

OpenAI telah melancarkan GPT-2 berturut-turut dengan volum parameter mencecah 1.5 bilion, dan volum parameter GPT-3 melebihi 100 bilion buat kali pertama, mencecah 175 bilion. Transformer Suis yang dikeluarkan oleh Google pada Januari 2021 mencecah trilion buat kali pertama, dengan volum parameter 1.6 trilion.

Menghadapi situasi yang meruncing ini, pengeluar domestik utama dan juga institusi penyelidikan yang dibiayai kerajaan tidak ketinggalan, dan telah berturut-turut melancarkan keputusan mereka pada model penapisan berskala besar: Pada April 2021, Alibaba Damo Academy mengeluarkan Bahasa Cina model bahasa pra-latihan "PLUG" dengan 27 bilion parameter pada bulan April, Huawei dan Makmal Pengcheng bersama-sama mengeluarkan "Pangu α" dengan 200 bilion parameter pada bulan Jun, Institut Penyelidikan Kecerdasan Buatan Beijing mengeluarkan "Enlightenment 2.0" , dengan 1.75 trilion parameter; ; pada bulan September, Baidu mengeluarkan model dwibahasa Cina-Inggeris PLATO-X, dengan 10 bilion parameter.

Sehingga Oktober tahun lepas, Alibaba Damo Academy mengeluarkan "M6-10T", yang telah mencapai 10 trilion parameter dan kini merupakan model AI terbesar di China. Walaupun ia tidak sebaik Alibaba, Baidu tidak ketinggalan dalam mengejar bilangan parameter model Ia bersama-sama mengeluarkan "Baidu Wenxin" dengan Makmal Pengcheng, dengan nombor parameter 260 bilion, iaitu 10 kali lebih besar daripada PLATO. -X.

Selain itu, Tencent juga mengatakan bahawa mereka telah membangunkan model besar "Paida Star", tetapi magnitud parameter tidak diketahui. Sebagai tambahan kepada syarikat R&D AI utama yang secara amnya menarik perhatian semua orang, pemain R&D model besar domestik utama juga termasuk pembekal kuasa pengkomputeran Inspur Mereka mengeluarkan model besar "Sumber 1.0" pada Oktober tahun lepas, dengan jumlah parameter sebanyak 245.7 bilion. . Secara keseluruhannya, 2021 boleh dipanggil "tahun pertama model besar" China.

Tahun ini, model besar terus popular. Pada mulanya, model besar tertumpu dalam bidang bahasa pengiraan, tetapi kini mereka telah berkembang secara beransur-ansur kepada penglihatan, membuat keputusan, dan aplikasinya malah meliputi isu saintifik utama seperti ramalan protein, aeroangkasa, dll. Google, Meta, Baidu dan syarikat utama lain mempunyai hasil yang sepadan. Untuk sementara waktu, model AI dengan parameter di bawah 100 juta tidak mempunyai suara.

Tidak syak lagi bahawa sama ada ia adalah transendensi prestasi atau pengembangan tugas, model besar AI telah menunjukkan potensi yang wujud, membawa imaginasi tanpa had kepada akademia dan industri.

Eksperimen penyelidikan telah menunjukkan bahawa meningkatkan jumlah data dan parameter secara berkesan boleh meningkatkan ketepatan model dalam menyelesaikan masalah. Mengambil contoh pemindahan visual Big Transfer yang dikeluarkan oleh Google pada tahun 2021 sebagai contoh, dua set data 1.28 juta imej dalam 1,000 kategori dan 300 juta imej dalam 18,291 kategori telah digunakan untuk latihan Ketepatan model boleh ditingkatkan daripada 77% kepada 79 %.

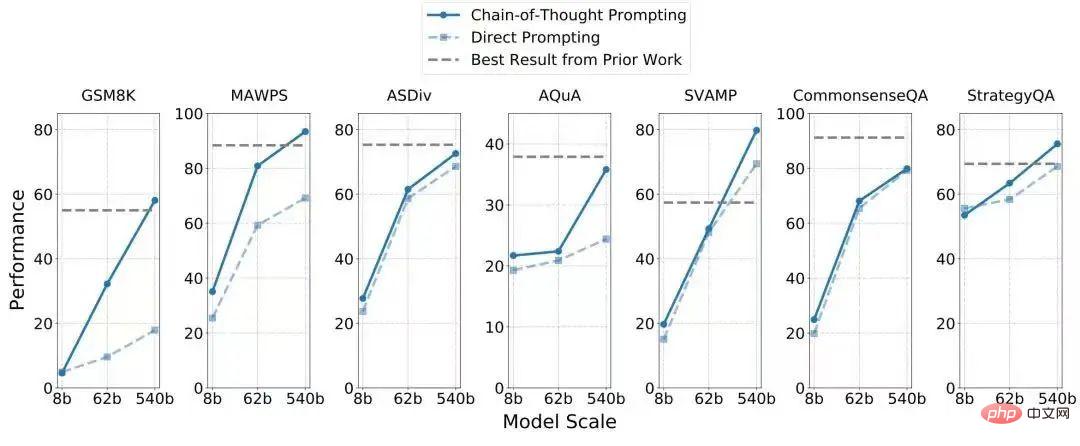

Ambil 540 bilion parameter model bahasa sehala PaLM yang dilancarkan oleh Google tahun ini Ia berdasarkan Pathways, rangka kerja AI generasi baharu yang dikeluarkan oleh Google tahun ini 175 bilion parameter dalam penalaan halus GPT-3, dan keupayaan penaakulan telah dipertingkatkan dengan banyaknya Pada 7 set data masalah aritmetik/penaakulan akal, 4 telah melepasi SOTA semasa (seperti yang ditunjukkan dalam jadual di bawah), dan hanya. 8 sampel (iaitu, data yang dikumpul) telah digunakan.

Penglihatan adalah persepsi, bahasa adalah kecerdasan, tetapi kedua-duanya tidak pernah membuat kejayaan yang mempesonakan dalam kemenangan "penaakulan sebab", dan penaakulan sebab Keupayaan ini sangat penting untuk evolusi sistem AI. Ia boleh difahami dengan cara ini: keupayaan mudah kanak-kanak untuk memperoleh 100+100=200 berdasarkan 1+1=2 adalah sangat rumit untuk sistem mesin, kerana sistem itu tidak mempunyai imaginasi penaakulan sebab-akibat. Jika mesin tidak mempunyai keupayaan penaakulan/imaginasi yang munasabah, maka kita akan jauh daripada membangunkan robot super-pintar dalam filem fiksyen sains. Kemunculan model besar menjadikan realisasi kecerdasan buatan umum (AGI) mungkin.

Jadi, kita dapat melihat bahawa apabila syarikat besar mempromosikan model besar, mereka sering menekankan bahawa ia boleh menyelesaikan pelbagai tugas pada masa yang sama dan mencapai SOTA (tahap tertinggi semasa) pada pelbagai penanda aras tugas. Sebagai contoh, 540 bilion parameter model bahasa PaLM yang dilancarkan oleh Google tahun ini boleh mentafsir jenaka dan meneka filem melalui ekspresi emoji "Enlightenment 2.0" yang dilancarkan oleh Zhiyuan boleh mengeram Hua Zhibing, seorang pelajar maya yang mahir dalam muzik, catur, kaligrafi. dan lukisan.

Ringkasnya, model besar selalunya mempunyai satu ciri: ia serba boleh dan boleh memakai banyak topi. Ini penting untuk menyelesaikan cabaran senario yang kompleks.

"Model kecil mempunyai bilangan parameter yang kecil dan terhad kepada satu tugasan; manakala (kelebihan) model besar adalah seperti pengetahuan yang dipelajari seseorang apabila belajar bermain. pingpong. Badminton mempunyai kesan tambahan Apabila menghadapi tugasan baharu, model kecil mungkin memerlukan beribu-ribu atau berpuluh-puluh ribu data latihan, manakala model besar mungkin hanya memerlukan satu data latihan. ” Lan Zhenzhong, ketua Makmal Pembelajaran Dalam di West Lake University, menjelaskan kepada Leifeng.com-AI Technology Review.

Ambil kajian tentang sistem dialog sebagai contoh. Sistem dialog terbahagi terutamanya kepada dua kategori: satu ialah dialog berasaskan tugas, di mana pengguna menetapkan tugasan dan sistem AI secara automatik melaksanakannya, seperti menempah tiket penerbangan dengan cepat, membeli tiket wayang, dsb.; dialog, seperti filem "Her" (Her) ialah robot fiksyen yang boleh berkomunikasi dengan manusia dalam sebarang topik malah membuatkan pengguna berasa ditemani secara emosi. Antaranya, tahap keupayaan yang terakhir ini jelas lebih tinggi dan penyelidikan dan pembangunannya lebih sukar. Terdapat banyak kabus di hadapan, dan anda tidak tahu jenis cabaran yang akan anda hadapi Pada masa ini, model besar itu sendiri mempunyai "pakej keupayaan" yang kaya dan prestasi luar biasa dalam tugasan baharu, dan keberkesanan pertempurannya jelas sekali. lebih baik daripada model kecil.

Lan Zhenzhong menegaskan bahawa pada masa ini penyelidik AI dalam akademik dan industri belum memahami sepenuhnya banyak ciri model besar. Sebagai contoh, dari generasi sebelumnya GPT-3 kepada generasi arahan GPT, kita dapat melihat bahawa ia telah membuat lonjakan kualitatif, tetapi kesan arahan GPT adalah lebih baik apabila menerima arahan ini adalah apa yang telah mereka lakukan Ini hanya boleh dialami apabila mengkaji model besar.

Apabila bilangan parameter menjadi lebih besar dan lebih besar, apakah yang akan berlaku kepada prestasi model AI? Ini adalah isu saintifik yang memerlukan penerokaan yang mendalam Oleh itu, adalah perlu untuk terus melabur dalam penyelidikan pada model besar.

2 Cita-cita itu jauh, tetapi hakikatnya sangat dekat

Sekiranya manusia ingin maju, mesti sentiasa ada orang yang berani pergi ke tempat yang tidak berpenghuni. .

Walau bagaimanapun, dalam dunia sebenar, tidak semua orang mampu memiliki cita-cita bintang dan laut Lebih ramai orang hanya mahu menyelesaikan masalah yang mereka hadapi secepat dan sehemat mungkin. masalah. Dalam analisis akhir, untuk algoritma AI dilaksanakan, nisbah input-output penyelidikan dan pembangunan teknologi mesti dipertimbangkan. Pada masa ini, kelemahan model besar mula terdedah.

Hakikat kejam yang tidak boleh diabaikan ialah pengiraan model besar adalah perlahan dan kos latihan amat tinggi.

Secara umumnya, semakin besar bilangan parameter model, semakin perlahan mesin akan berjalan dan semakin tinggi kos pengiraan. Menurut pendedahan media asing, OpenAI membelanjakan hampir AS$5 juta (kira-kira RMB 35 juta) untuk melatih GPT-3, yang mengandungi 175 bilion parameter. Google menggunakan 6,144 TPU semasa melatih PaLM, yang mengandungi 540 bilion parameter Menurut statistik daripada netizen yang bersemangat, kos untuk orang biasa melatih PaLM adalah antara AS$9 juta dan AS$17 juta. Ini hanyalah kos kuasa pengkomputeran.

Pengilang domestik utama tidak mendedahkan kos ekonomi mereka untuk melatih model besar, tetapi berdasarkan kaedah dan sumber pengkomputeran yang dikongsi secara global sedia ada, perbelanjaan pengkomputeran seharusnya tidak jauh. Kedua-dua GPT-3 dan PaLM hanya mencecah ratusan bilion, tetapi kos model besar dengan parameter mencecah lebih daripada trilion mesti mengejutkan. Jika pengeluar besar cukup bermurah hati dalam R&D, kos pelaburan model besar tidak akan menjadi "halangan." Walau bagaimanapun, pada masa modal menjadi lebih berhati-hati tentang AI, beberapa syarikat permulaan dan institusi penyelidikan yang dibiayai oleh kerajaan masih bertaruh. banyak pada model besar, yang bermaksud Ia kelihatan agak ajaib.

Keperluan kuasa pengkomputeran yang tinggi bagi model besar telah menjadikan persaingan dalam kekuatan teknikal antara perusahaan menjadi persaingan untuk mendapatkan wang. Dalam jangka panjang, sebaik sahaja algoritma menjadi komoditi penggunaan tinggi, AI yang paling canggih ditakdirkan untuk tersedia hanya kepada beberapa orang, mengakibatkan situasi monopoli pengepungan dan kepungan. Dalam erti kata lain, walaupun kecerdasan buatan am muncul suatu hari nanti, ia tidak akan memberi manfaat kepada semua pengguna.

Pada masa yang sama, di landasan ini, kuasa inovasi perniagaan kecil akan diperah. Untuk membina model besar, perniagaan kecil mesti sama ada bekerjasama dengan pengeluar besar dan berdiri di atas bahu gergasi (tetapi ini bukan sesuatu yang setiap kilang kecil boleh lakukan), atau mereka mesti melabur banyak dan menyediakan perbendaharaan mereka (tetapi dari segi modal, Pada musim sejuk, ini tidak praktikal).

Selepas mengira input, kira output. Malangnya, tiada syarikat yang sedang menapis model besar telah mendedahkan berapa banyak manfaat ekonomi yang telah dicipta oleh model besar. Walau bagaimanapun, dapat diketahui daripada maklumat awam bahawa model besar ini telah mula dilaksanakan satu demi satu untuk menyelesaikan masalah Sebagai contoh, selepas Alibaba Damo Academy mengeluarkan model trilion-parameter M6, ia mengatakan bahawa keupayaan penjanaan imejnya sudah boleh membantu. pereka kereta dalam reka bentuk kenderaan , copywriting yang dicipta dengan meminjam keupayaan penjanaan copywriting M6 juga telah digunakan pada Taobao mudah alih, Alipay dan Alibaba Xiaomi.

Untuk model besar yang berada di peringkat awal penerokaan, menekankan pulangan jangka pendek adalah terlalu keras. Walau bagaimanapun, kami masih perlu menjawab soalan: Sama ada dunia korporat atau akademia, apabila bertaruh pada model besar, adakah ia untuk mengelakkan kehilangan arah teknikal yang mungkin mendominasi pada masa hadapan, atau kerana ia boleh menyelesaikan sebarang masalah dengan lebih baik. isu yang diketahui di tangan? Yang pertama mempunyai warna penerokaan akademik yang kuat, manakala yang kedua adalah kebimbangan sebenar perintis industri yang menggunakan teknologi AI untuk menyelesaikan masalah.

Model besar itu dimulakan oleh keluaran Google BERT, yang merupakan idea huru-hara dan berfikiran terbuka: sebelum percubaan BERT, pasukan teknikal Google Brain tidak dibangunkan di sekitar masalah dunia sebenar yang diketahui . Model , saya tidak sangka model AI dengan bilangan parameter terbesar pada masa itu (300 juta) boleh membawa peningkatan yang ketara dalam hasil. Dengan cara yang sama, apabila OpenAI meniru Google untuk membangunkan GPT-2 dan GPT-3, ia tidak mempunyai tugas khusus Sebaliknya, selepas pembangunan yang berjaya, semua orang menguji kesan tugas pada GPT-3 dan mendapati bahawa pelbagai penunjuk telah bertambah baik . GPT-3 hari ini adalah seperti platform dan telah digunakan oleh beribu-ribu pengguna.

Namun, seiring dengan berlalunya masa, pembangunan model besar sudah pasti kembali kepada niat asal untuk menyelesaikan masalah praktikal tertentu Contohnya, model ramalan protein besar ESMFold yang dikeluarkan oleh Meta ini tahun, Baidu tidak lama lagi Model aeroangkasa besar dikeluarkan sebelum ini. Jika model berskala besar awal seperti GPT-3 bertujuan terutamanya untuk meneroka kesan peningkatan bilangan parameter ke atas prestasi algoritma, dan semata-mata "tidak diketahui membimbing yang tidak diketahui", maka arus besar- penyelidikan model skala telah mula mencerminkan matlamat yang lebih kompleks Jelas: untuk menyelesaikan masalah sebenar dan mencipta nilai keusahawanan.

Pada masa ini, hala tuju pembangunan model besar berubah daripada kehendak penyelidik kepada keperluan pengguna. Dalam beberapa keperluan yang sangat kecil (seperti pengecaman plat lesen), model besar juga boleh menyelesaikan masalah, tetapi disebabkan kos latihannya yang mahal, ia agak seperti "membunuh babi dengan tukul besi", dan prestasinya tidak semestinya cemerlang. . Dalam erti kata lain, jika peningkatan ketepatan beberapa mata diperoleh dengan kos berpuluh-puluh juta, nisbah harga/prestasi akan menjadi sangat rendah.

Seorang orang dalam industri memberitahu Leifeng.com-AI Technology Review bahawa dalam kebanyakan kes, kami mengkaji teknologi untuk menyelesaikan masalah praktikal yang diketahui seperti analisis sentimen dan ringkasan berita , kita sebenarnya boleh mereka bentuk tugas kecil khas untuk dikaji, dan kesan "model kecil" yang terhasil dengan mudah lebih baik daripada model besar seperti GPT-3. Walaupun untuk beberapa tugas tertentu, model besar "tidak mungkin digunakan."

Oleh itu, dalam proses mempromosikan pembangunan AI, gabungan model besar dan model kecil tidak dapat dielakkan. Memandangkan ambang penyelidikan dan pembangunan untuk model besar adalah sangat tinggi, pada masa hadapan yang boleh dilihat, model kecil yang tersedia dari segi ekonomi dan mampu melakukan serangan yang tepat akan menjadi kuasa utama dalam memikul tugas penting pelaksanaan AI berskala besar.

Malah sesetengah saintis yang sedang mengkaji model besar dengan jelas memberitahu Leifeng.com-AI Technology Review bahawa walaupun model besar boleh melaksanakan banyak tugas pada masa yang sama, "Sekarang apabila bercakap tentang kecerdasan buatan am Masih terlalu awal untuk risikan.” Model besar mungkin merupakan cara penting untuk mencapai matlamat utama, tetapi yang ideal masih jauh, dan AI mesti terlebih dahulu memenuhi keadaan semasa.

3 Adakah model AI perlu menjadi lebih besar dan lebih besar?

Malah, sebagai tindak balas kepada fenomena model AI yang semakin besar, sesetengah penyelidik dalam akademik dan industri telah menyedari kelebihan dan kekurangannya dalam pelaksanaan, dan telah membangunkan langkah balas secara aktif.

Jika kita ingin bercakap tentang jenis teknologi pencerahan yang telah memberi orang ramai tentang perubahan dalam masyarakat, maka antara perkara penting yang pasti akan dibincangkan ialah: bagaimana untuk menurunkan ambang produk teknologi (secara teknikal dan dari segi kos), hanya dengan membenarkan lebih ramai orang menikmati faedah teknologi ini pengaruhnya dapat diperluaskan.

Bertukar kepada model besar, konflik teras ialah cara meningkatkan kelajuan latihannya, mengurangkan kos latihan atau mencadangkan seni bina baharu. Jika kita melihat kepada penggunaan sumber pengkomputeran sahaja, dilema model besar sebenarnya tidak menonjol. Keputusan latihan terkini penanda aras MLPerf yang dikeluarkan oleh Open Engineering Alliance MLCommons pada akhir Jun tahun ini menunjukkan bahawa kelajuan latihan sistem pembelajaran mesin tahun ini hampir dua kali ganda berbanding tahun lepas, yang telah melebihi Undang-undang Moore (dua kali ganda setiap 18 -24 bulan).

Malah, dengan lelaran pelbagai pelayan dan kemunculan kaedah baharu seperti pengkomputeran awan, pengkomputeran telah dipercepatkan dan penggunaan tenaga telah dikurangkan. Sebagai contoh, GPT-3 telah dilancarkan hanya dua tahun yang lalu, dan kini pengiraan Meta berdasarkan model OPT yang dibangunkannya telah dikurangkan kepada 1/7 daripada jumlah pada tahun 2020. Di samping itu, artikel terbaru menunjukkan BERT model besar, yang memerlukan beribu-ribu GPU untuk dilatih pada 2018, kini boleh dilatih pada satu kad dalam masa 24 jam, dan boleh dilatih dengan mudah di makmal biasa.

Hambatan untuk mendapatkan kuasa pengkomputeran tidak lagi wujud, satu-satunya halangan ialah kos pemerolehan.

Selain bergantung semata-mata pada kuasa pengkomputeran, dalam beberapa tahun kebelakangan ini, beberapa penyelidik juga berharap untuk mencari cara lain untuk mencapai "ketersediaan ekonomi" model besar berdasarkan semata-mata pada ciri-ciri model dan algoritma itu sendiri.

Salah satu cara ialah "pengurangan dimensi" berpusatkan data.

Baru-baru ini, DeepMind mempunyai karya ("Melatih Model Bahasa Besar Pengiraan-Optimal") yang berjaya meneroka dan mendapati bahawa, dengan jumlah pengiraan yang sama, data latihan model dijadikan lebih besar dan bukannya nombor daripada parameter model Zum masuk untuk mendapatkan hasil yang lebih baik daripada hanya mengezum masuk pada model.

Dalam kajian DeepMind ini, Chinchilla, model 70 bilion parameter yang memanfaatkan sepenuhnya data, mengatasi 175 bilion parameter GPT-3 dan 2800 dalam penilaian siri tugasan hiliran dengan berbilion parameter. Lan Zhenzhong menjelaskan bahawa sebab mengapa Chinchilla boleh menang adalah kerana ia mengembangkan dan menggandakan data semasa latihan, dan kemudian mengiranya sekali sahaja.

Cara lain ialah bergantung pada inovasi dalam algoritma dan seni bina kepada model besar yang "ringan".

Zhou Ming, bekas naib presiden Microsoft Research Asia dan pengasas terkini Lanzhou Technology, ialah pengikut lagu ini.

Sebagai seorang usahawan, idea Zhou Ming adalah sangat "kewajipan", iaitu untuk menjimatkan wang. Beliau menegaskan bahawa banyak syarikat besar kini mengejar model besar Pertama, mereka berebut untuk menjadi yang pertama, mereka juga ingin menyatakan keupayaan pengkomputeran mereka, terutamanya keupayaan perkhidmatan awan. Sebagai sebuah syarikat kecil yang baru dilahirkan, Lanzhou Technology mempunyai impian untuk menggunakan AI untuk mencipta nilai, tetapi ia tidak mempunyai keupayaan awan yang kuat dan tidak mempunyai wang yang mencukupi untuk membakar pada mulanya dan menyaring pengetahuan , menukar model besar kepada "model ringan" untuk digunakan oleh pelanggan.

Model ringan "Mencius" yang dilancarkan pada Julai tahun lepas membuktikan kebolehlaksanaan idea ini. "Mencius" hanya mempunyai 1 bilion parameter, tetapi prestasinya pada senarai penilaian pemahaman bahasa Cina CLUE mengatasi model besar seperti BERTSG dan Pangu dengan tahap parameter puluhan malah ratusan bilion (jadual di bawah). Konsensus dalam bidang ini adalah bahawa di bawah seni bina yang sama, semakin besar bilangan parameter model, semakin baik prestasinya. Walau bagaimanapun, kepintaran "Mencius" terletak pada inovasi seni bina.

Dalam bidang akademik, tidak lama dahulu, Profesor Ma Yi dari Universiti California, Berkeley, Shen Xiangyang, dan Cao Ying bersama-sama menerbitkan satu kajian ( "On the Principles of Parsimony and Self-Consistency for the Emergence of Intelligence") secara teorinya menganalisis sebab teknikal mengapa model besar menjadi lebih besar dan lebih besar, iaitu, rangkaian saraf dalam pada dasarnya adalah sistem "gelung terbuka", iaitu, Latihan model diskriminatif yang digunakan untuk pengelasan dan model generatif yang digunakan untuk pensampelan atau main semula dipisahkan dalam kebanyakan kes, mengakibatkan latihan parameter yang tidak cekap, dan satu-satunya cara untuk meningkatkan prestasi model adalah bergantung pada parameter timbunan dan timbunan. kuasa pengkomputeran.

Oleh sebab ini, kaedah "reformasi" yang mereka cadangkan adalah lebih teliti, iaitu menggabungkan model diskriminatif dan model generatif untuk membentuk sistem gelung tertutup "mampat" yang lengkap, supaya model AI Ia boleh belajar secara bebas, menjadi lebih cekap dan stabil, dan mempunyai kebolehsuaian dan responsif yang lebih kuat apabila menghadapi masalah baharu yang mungkin timbul dalam persekitaran baharu. Dalam erti kata lain, jika penyelidik dalam bidang AI boleh membangunkan model di sepanjang laluan ini, magnitud parameter model akan dikurangkan dengan banyak, kembali ke laluan "kecil dan cantik", dan keupayaan model besar untuk "menyelesaikan yang tidak diketahui. masalah" juga boleh dicapai .

Dari segi mencapai ketersediaan ekonomi, malah terdapat suara yang menyokong penggunaan AutoML atau AutoAI untuk menyelesaikan kesukaran latihan model, menurunkan ambang penyelidikan algoritma AI dan membenarkan jurutera algoritma atau Pengamal bukan AI secara fleksibel boleh mencipta model satu fungsi mengikut keperluan mereka sendiri, membentuk model kecil yang tidak terkira Satu percikan boleh mencetuskan api padang rumput.

Suara ini datang dari perspektif "permintaan" dan menentang pintu tertutup.

Sebagai contoh, algoritma visual digunakan untuk pengecaman, pengesanan dan kedudukan Antaranya, keperluan untuk mengenal pasti asap dan bunga api adalah berbeza, jadi ia menyediakan platform atau alat untuk membenarkan mereka masuk perlukan Algoritma visual untuk pengecaman asap dan pengecaman bunga api masing-masing boleh dijana dengan cepat, dengan ketepatan yang lebih tinggi, dan tidak perlu meneruskan "kesejagatan" atau "pengertian" merentas senario. Pada masa ini, model besar yang mahir dalam semua aspek piano, catur, kaligrafi dan lukisan boleh dibahagikan kepada model kecil yang tidak terkira banyaknya yang mahir dalam piano, catur, kaligrafi dan lukisan, yang juga boleh menyelesaikan masalah.

4 Tulis di penghujung

dan kembali kepada kisah kipas elektrik meniup pinggan sabun yang kosong.

Apabila ia datang untuk menyelesaikan masalah dunia sebenar dengan teknologi AI, model besar dan model kecil adalah seperti penyelesaian automasi posdoc dan kipas elektrik pekerja kecil Walaupun yang pertama kelihatan berlebihan dan menyusahkan apabila menyelesaikan masalah kecil, kesannya juga tidak sepantas kipas elektrik, tetapi hampir tiada siapa yang akan menafikan nilai yang diberikan oleh posdoc dan pasukan mereka, apatah lagi "menghapuskan" mereka. Sebaliknya, kita juga boleh menamakan beratus-ratus sebab untuk menekankan rasionaliti penyelidikan dan pembangunan teknologi.

Tetapi dalam banyak kes, penyelidik teknikal sering mengabaikan kebijaksanaan pekerja kecil dalam menyelesaikan masalah: bermula daripada masalah sebenar dan bukannya menghadkan diri mereka kepada kelebihan teknologi. Dari perspektif ini, penyelidikan ke atas model besar mempunyai nilai yang wujud untuk memimpin sempadan, tetapi matlamat "boleh digunakan secara ekonomi" untuk pengurangan kos dan peningkatan kecekapan juga mesti dipertimbangkan.

Berbalik kepada penyelidikan itu sendiri, Lan Zhenzhong berkata walaupun terdapat banyak keputusan pada model besar, terdapat sangat sedikit sumber terbuka dan penyelidik biasa mempunyai akses terhad, yang amat dikesali.

Memandangkan model besar bukan sumber terbuka, pengguna biasa tidak boleh menilai kepraktisan model besar dari perspektif permintaan. Malah, kami sebelum ini telah menjalankan eksperimen ke atas beberapa model besar sumber terbuka dan mendapati bahawa prestasi model bahasa besar dalam memahami etika dan emosi sosial adalah amat tidak stabil.

Oleh kerana mereka tidak terbuka kepada orang ramai, pengenalan model besar mereka sendiri oleh pengeluar utama juga kekal pada penunjuk akademik, yang mewujudkan dilema serupa dengan Schrödinger: anda tidak pernah tahu kotaknya Tidak ada cara untuk menilai sama ada ia benar atau salah berdasarkan apa yang ada di dalamnya. Akhir sekali, saya berharap model AI yang besar benar-benar dapat memberi manfaat kepada lebih ramai orang.

Atas ialah kandungan terperinci Peminat dan Fikiran tentang Syarikat Besar Membelanjakan Wang untuk Mengejar Model AI Besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI